STAR: modelo AI de mejora de la sincronización espacial para aumentar la nitidez de la resolución de vídeo

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 55.8K 00

Introducción general

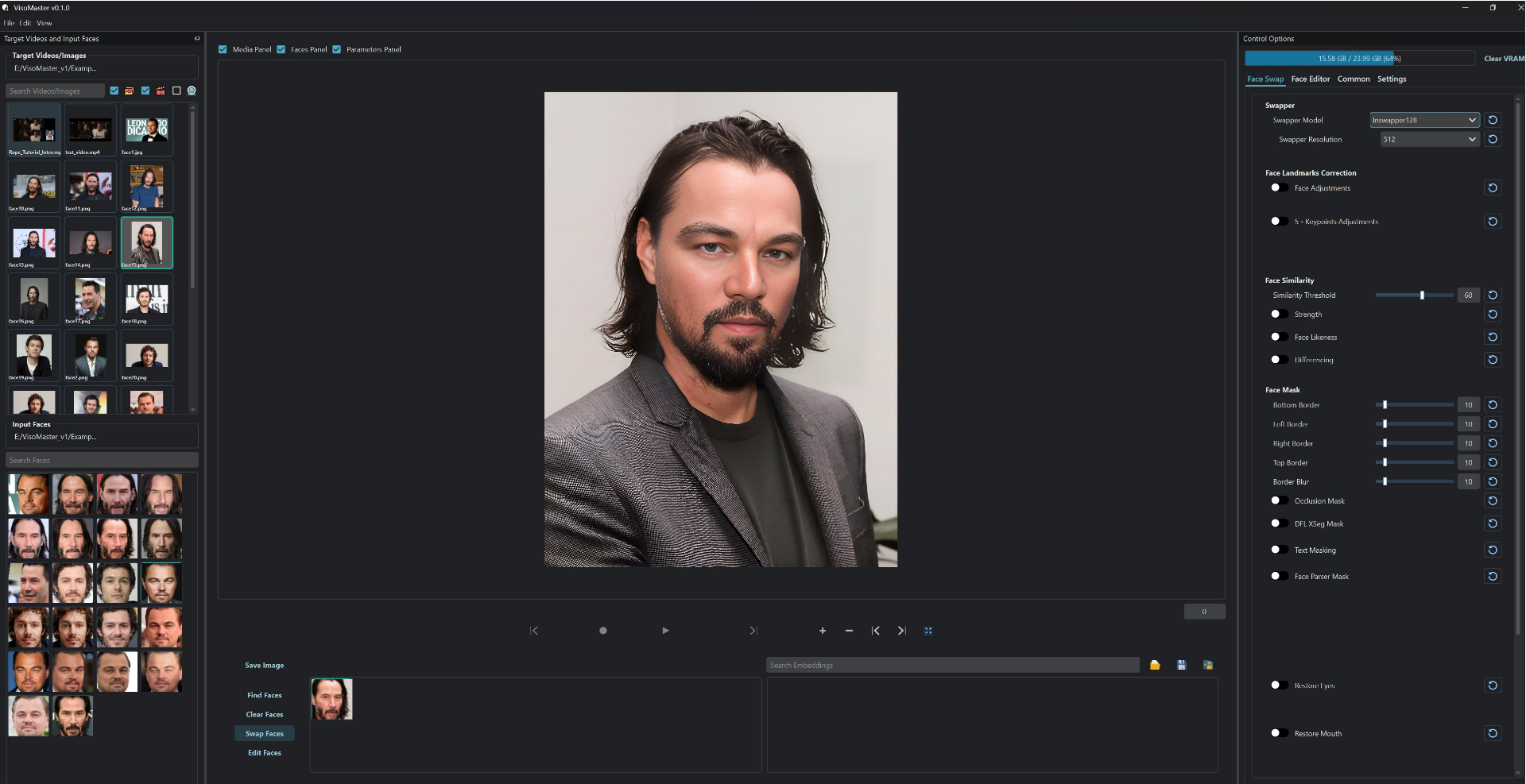

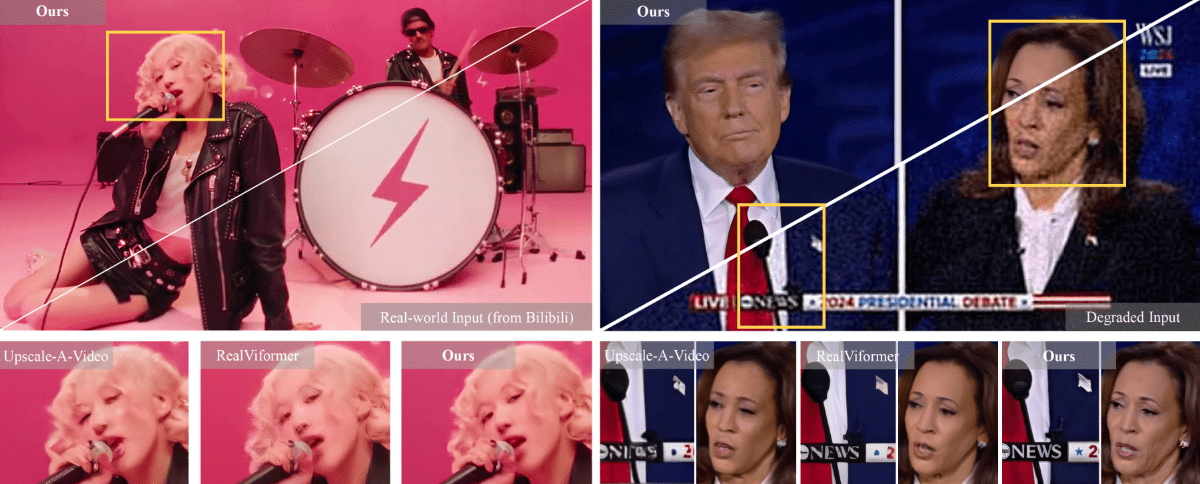

STAR (Spatial-Temporal Augmentation with Text-to-Video Models) es un innovador marco de superresolución de vídeo desarrollado conjuntamente por la Universidad de Nanjing, ByteDance y la Universidad del Suroeste. El proyecto se dedica a resolver problemas clave en el procesamiento de la superresolución de vídeo en el mundo real, y consigue una mejora de alta calidad de los fotogramas de vídeo combinando el conocimiento a priori de los modelos de difusión de texto a vídeo (T2V). La característica distintiva del modelo STAR radica en su capacidad para mantener simultáneamente la fidelidad de los detalles espaciales y la coherencia temporal, lo que suele ser difícil de conciliar con los enfoques tradicionales basados en GAN. El proyecto ofrece dos versiones de implementación: un modelo de procesamiento de reducción de calidad ligera y pesada basado en I2VGen-XL, y un modelo de procesamiento de reducción de calidad pesada basado en CogVideoX-5B, capaz de adaptarse a las necesidades de mejora de vídeo en distintos escenarios.

Lista de funciones

- Admite la reconstrucción de superresolución para muchos tipos de procesamiento de degradación de vídeo (ligero y pesado)

- Generación automatizada de palabras clave, compatibilidad con la generación de descripciones de vídeo mediante herramientas como Pllava.

- Puesta a disposición de una plataforma de demostración en línea (HuggingFace Spaces)

- Admite procesamiento de entrada de vídeo con resolución 720x480

- Código de inferencia completo y modelos preentrenados

- Integración del módulo de mejora de la información local (LIEM) para mejorar la calidad de la reconstrucción detallada de la pantalla.

- Admite el procesamiento de vídeo por lotes

- Ofrece opciones flexibles de ponderación de modelos

Utilizar la ayuda

1. Configuración medioambiental

En primer lugar, es necesario configurar el entorno de ejecución de la siguiente manera:

- Clonar el repositorio de código:

git clone https://github.com/NJU-PCALab/STAR.git

cd STAR

- Crea y activa el entorno conda:

conda create -n star python=3.10

conda activate star

pip install -r requirements.txt

sudo apt-get update && apt-get install ffmpeg libsm6 libxext6 -y

2. Selección y descarga de modelos

STAR ofrece dos versiones del modelo:

- Modelo basado en I2VGen-XL:

- light_deg.pt: para el procesamiento de vídeo con degradación lumínica

- heavy_deg.pt: para el tratamiento de vídeo muy degradado

- Modelo basado en CogVideoX-5B:

- Diseñado específicamente para tratar vídeos muy degradados

- Sólo admite entradas con resolución 720x480

Descargue los pesos de modelo apropiados de HuggingFace y colóquelos en la carpetapretrained_weight/Catálogo.

3. Flujo de tratamiento de vídeo

- Preparar los datos de las pruebas:

- Coloque el vídeo que desea procesar en el

input/video/directorio (en el disco duro del ordenador) - Preparación de la palabra clave (tres opciones):

- palabra no solicitada

- Generado automáticamente con Pllava

- Redactar manualmente las descripciones de los vídeos

- Coloque el vídeo que desea procesar en el

- Configure los parámetros de procesamiento:

- modificaciones

video_super_resolution/scripts/inference_sr.shLa configuración de la ruta en el- ruta_carpeta_vídeo: ruta del vídeo de entrada

- txt_file_path: ruta del archivo prompt

- model_path: ruta del peso del modelo

- save_dir: ruta de salida

- modificaciones

- Iniciar el razonamiento:

bash video_super_resolution/scripts/inference_sr.sh

Nota: Si se encuentra con un problema de desbordamiento de memoria (OOM), puede añadir un nuevo archivo en la carpetainference_sr.shrango medio menor (en música)frame_lengthParámetros.

4. Configuración especial del modelo CogVideoX-5B

Si utiliza el modelo CogVideoX-5B, se requieren pasos adicionales:

- Cree un entorno dedicado:

conda create -n star_cog python=3.10

conda activate star_cog

cd cogvideox-based/sat

pip install -r requirements.txt

- Descargar dependencias adicionales:

- Necesidad de descargar VAE y T5 Encoder

- actualización

cogvideox-based/sat/configs/cogvideox_5b/cogvideox_5b_infer_sr.yamlLa configuración de la ruta en el - Sustitución del archivo transformer.py

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...