SPO: Optimización de la palabra clave para el autocontrol

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 43.5K 00

resúmenes

Unas instrucciones bien diseñadas son esenciales para mejorar las capacidades de razonamiento de los modelos de lenguaje de gran tamaño (LLM) y, al mismo tiempo, adaptar sus resultados a los requisitos de las tareas de distintos dominios. Sin embargo, el diseño manual de sugerencias requiere experiencia y experimentación iterativa. Los métodos de optimización de sugerencias existentes pretenden automatizar este proceso, pero dependen en gran medida de referencias externas como respuestas reales o comentarios humanos, lo que limita su aplicación en escenarios reales en los que estos datos no están disponibles o son costosos de obtener. Para hacer frente a este problema, proponemos la optimización autosupervisada de indicaciones (SPO, Self-Supervised Prompt Optimisation), un marco eficiente para descubrir indicaciones eficaces tanto para tareas cerradas como abiertas sin necesidad de referencias externas. Inspirándonos en la observación de que la calidad de las pistas se refleja directamente en los resultados del LLM y que el LLM puede evaluar eficientemente el grado de adherencia a los requisitos de la tarea, derivamos señales de evaluación y optimización únicamente a partir de comparaciones de resultados. En concreto, SPO selecciona las claves superiores mediante comparaciones de salida por pares evaluadas por el evaluador LLM y, a continuación, alinea las salidas con los requisitos de la tarea mediante el optimizador LLM. Extensos experimentos han demostrado que SPO supera a los métodos de optimización de pistas más avanzados y, al mismo tiempo, cuesta mucho menos (por ejemplo, sólo 1,11 TP3T frente a los 5,61 TP3T de los métodos existentes) y requiere menos muestras (por ejemplo, sólo tres muestras). El código está disponible en https://github.com/geekan/MetaGPT获取.

Código demo completo: https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. Introducción

A medida que los grandes modelos lingüísticos (LLM) siguen evolucionando, es esencial que las instrucciones estén bien diseñadas para maximizar su eficacia.capacidad de razonamiento (Wei et al., 2022; Zheng et al., 2024; Deng et al., 2023), así como garantizar la coherencia con los diversos requisitos de la misión (Hong et al., 2024b; Liu et al., 2024a; Zhang et al., 2024b; Hong et al., 2024a), se han vuelto críticas. Sin embargo, la creación de señales eficaces suele requerir amplios experimentos de ensayo y error y un profundo conocimiento específico de la tarea.

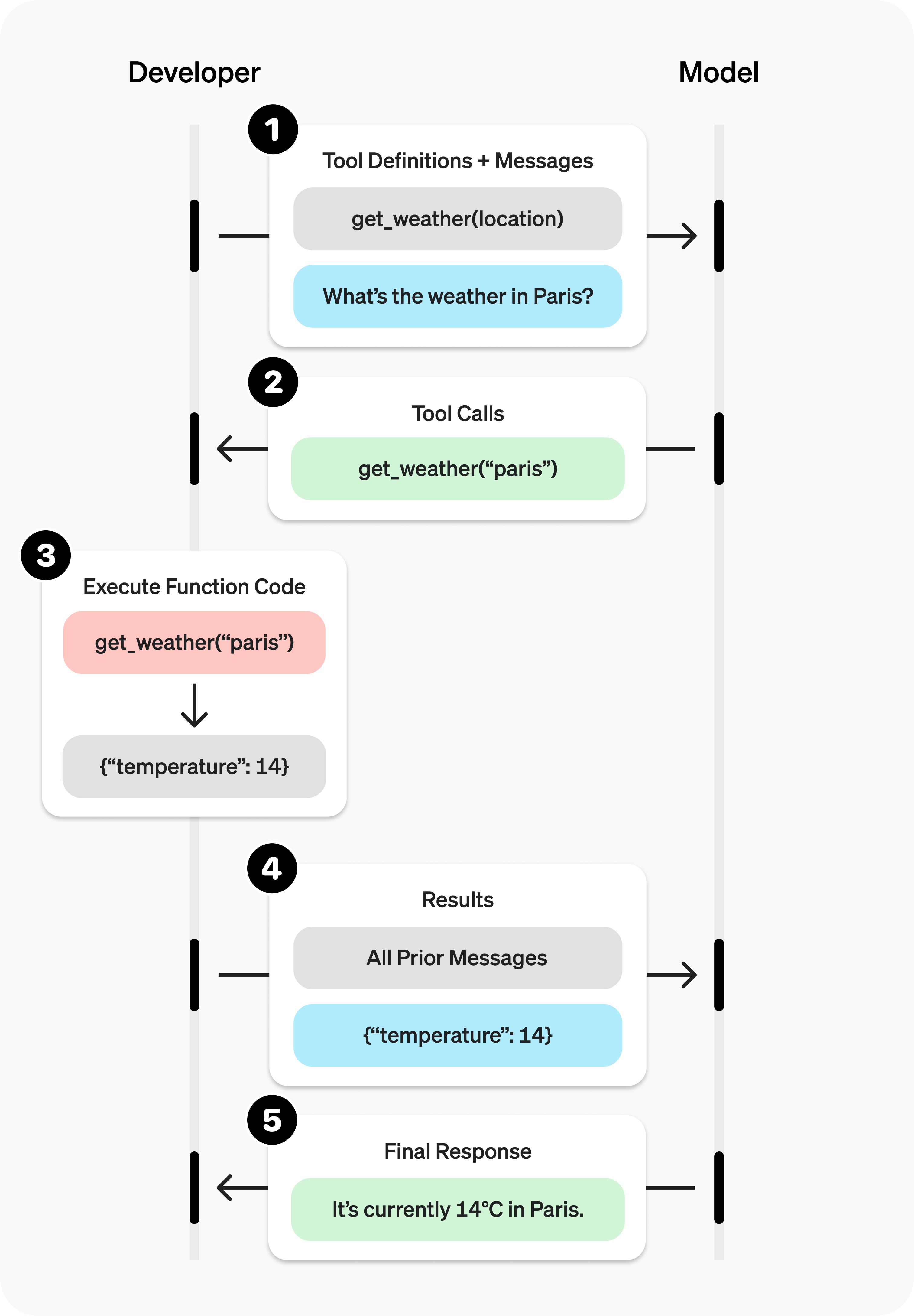

Para hacer frente a este reto, los investigadores han explorado métodos de optimización de avisos (OP) que utilizan las capacidades propias de los LLM para mejorar automáticamente los avisos. Como se muestra en la Figura 1(a), estos métodos suelen implicar un proceso iterativo de optimización, ejecución y evaluación de pistas. Las opciones de diseño de estos componentes afectan significativamente a la eficacia y eficiencia de la optimización. Los métodos existentes se han desarrollado en términos de mecanismos de evaluación numérica (Wang et al., 2024e; Yang et al., 2024a; Fernando et al., 2024) y estrategias de optimización de "gradiente" textual (Wang et al., 2024c; Yuksekgonul et al. al., 2024). Gracias a estas innovaciones, los métodos de OP han mejorado el rendimiento de las tareas al tiempo que han reducido el esfuerzo manual (Pryzant et al., 2023; Zhang et al., 2024a; Zhou et al., 2024).

A pesar de su potencial, los métodos de OP existentes se enfrentan a importantes retos en escenarios reales, como se describe a continuación. En primer lugar, los enfoques actualesLa ley suele basarse en gran medida en referencias externas para su evaluación. Los métodos que utilizan respuestas auténticas para la evaluación (Yang et al., 2024a; Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023) requieren grandes cantidades de datos anotados para evaluar la calidad de las pistas, pero en muchas aplicaciones del mundo real, especialmente en tareas abiertas, a menudo no se dispone de este tipo de respuestas estándar. respuestas estándar no suelen estar disponibles. Del mismo modo, los métodos manuales (Chen et al., 2024; Lin et al., 2024) requieren una evaluación manual o reglas diseñadas manualmente para generar comentarios, lo que requiere mucho tiempo y es contradictorio con el objetivo de la automatización. En segundo lugar, los métodos existentes suelen requerir la evaluación de un gran número de muestras para obtener una retroalimentación fiable, lo que se traduce en una importante sobrecarga computacional (Wang et al., 2024e; Fernando et al., 2024).

En el centro de estos retos se encuentra la falta de métodos fiables, eficientes y sin referencias para evaluar la calidad de las pistas. El análisis del comportamiento de los LLM revela dos puntos clave en los que se basa nuestro enfoque. En primer lugar, la calidad de los indicios se refleja de forma inherente en los resultados del modelo, como demuestra la forma en que las rutas de inferencia escalonadas pueden demostrar el éxito de los indicios de pensamiento en cadena (Wei et al., 2022; Deng et al., 2023). En segundo lugar, una amplia investigación sobre los LLM como jueces ha demostrado que son eficaces a la hora de evaluar hasta qué punto el resultado sigue los requisitos de la tarea (Zheng et al., 2023; Li et al., 2024b). Estas observaciones sugieren que la optimización de pistas sin referenciación es factible mediante el uso de LLM para evaluar la capacidad inherente de las salidas que reflejan de forma natural la calidad de la pista.

Inspirándonos en estas ideas, proponemos un marco eficiente que genera señales de evaluación y optimización únicamente a partir de los resultados del LLM, de forma similar a como el aprendizaje autosupervisado obtiene señales de entrenamiento a partir de los datos. Denominamos a este enfoque optimización rápida autosupervisada (SPO). Como se muestra en la Figura 1, SPO introduce varios mecanismos innovadores basados en el ciclo básico optimizar-ejecutar-evaluar:

- Resultado como referencia para la evaluación por paresEn el corazón de SPO se encuentra el uso de comparaciones por pares para evaluar la calidad relativa de los resultados de diferentes pistas. Este mecanismo de evaluación explota la capacidad inherente del LLM para comprender los requisitos de la tarea y validar la eficacia de la optimización sin una referencia externa.

- Salida como guía de optimizaciónSPO optimiza las pistas a través de la comprensión del LLM de una solución mejor que el mejor resultado actual. Este proceso alinea de forma natural las modificaciones de las pistas con la comprensión del modelo de la mejor solución de la tarea, en lugar de depender de señales de optimización explícitas.

dedicar. A continuación se enumeran nuestras principales contribuciones:

- Marco de optimización autosupervisada de pistas. Presentamos SPO, un novedoso marco que utiliza comparaciones por pares de resultados LLM para guiar la optimización de pistas sin referencias externas.

- Optimización de la relación coste-eficaciaSPO optimiza los avisos con una mínima sobrecarga computacional (0,15 dólares por conjunto de datos) y requisitos de muestreo (3 muestras), lo que reduce significativamente los requisitos de recursos.

- Evaluación exhaustiva. Como se muestra en la Fig. 2, SPO sólo requiere entre 1,11 TP3T y 5,61 TP3T del coste de los métodos existentes, manteniendo un rendimiento excelente tanto en tareas cerradas como abiertas.

2. Preliminares

2.1 Definición del problema

El objetivo de la optimización de instrucciones es mejorar automáticamente la validez de una instrucción para una tarea determinada. Formalmente, sea T = (Q, Gt) denota una tarea donde Q denota el problema de entrada y Gt es un dato de referencia opcional. El objetivo es generar un indicador específico de la tarea Pt* para maximizar el rendimiento en la tarea T . Este objetivo de optimización puede expresarse formalmente como:

Pt = arg maxPt∈P* ET∼D[ϕevalúe(ϕexe(Q, Pt))], (1)

donde P denota el espacio de todas las indicaciones posibles. Como se muestra en la Fig. 1, este proceso de optimización suele implicar tres funciones básicas: (1) la función de optimización (ϕop): genera un aviso modificado basado en los avisos candidatos; (2) la función de ejecución (ϕexe): las pistas modificadas se utilizan con el LLM para generar la salida O, incluyendo la ruta de inferencia y la respuesta final; (3) la función de evaluación (ϕevalúe): evalúa la calidad de O y proporciona retroalimentación F para guiar la optimización posterior, mejorando iterativamente la pista candidata.

Entre estas funciones, la función de evaluación desempeña un papel clave, ya que su resultado (feedback F) guía la evaluación y la mejora de la señal. Analizaremos el marco de evaluación para la optimización de pistas en la sección 2.2.

2.2 Marcos de evaluación en la optimización de pistas

En esta sección se ofrece una visión general de nuestro marco de evaluación de la optimización de las instrucciones, que abarca tres componentes clave: fuentes de evaluación, métodos de evaluación y tipos de retroalimentación, como se muestra en la Figura 3. Por último, presentamos el marco de evaluación que hemos elegido para los SPO. Por último, presentamos el marco de evaluación que hemos elegido para los SPO.

Fuentes de evaluación. Como se muestra en la Figura 3(a), se dispone de dos fuentes principales de evaluación: la salida generada por el LLM y las respuestas auténticas específicas de la tarea. Estas fuentes constituyen la base para evaluar el rendimiento de los alumnos.

Metodología de evaluación. Los métodos de evaluación definen cómo se valoran las fuentes de evaluación y los costes asociados. Tres métodos comúnmente utilizados son (1) La evaluación comparativa se basa en métricas predefinidas (Suzgun et al., 2023; Rein et al., 2023) o reglas (Chen et al., 2024). (2) LLM como juez (Zheng et al., 2023) utilizando la capacidad de LLM para comprender y evaluar los resultados de acuerdo con los requisitos de la tarea. (3) Retroalimentación manual (Lin et al., 2024) proporciona la evaluación más exhaustiva evaluando directamente el resultado de forma manual.

Aunque la retroalimentación manual proporciona la evaluación más exhaustiva al captar las preferencias humanas y las necesidades específicas de cada tarea, incurre en costes más elevados que los enfoques de evaluación comparativa o de LLM como juez, lo que crea un equilibrio entre la calidad de la evaluación y la viabilidad.

Tipo de respuesta. La retroalimentación generada por los métodos de evaluación suele adoptar tres formas:(1) La retroalimentación numérica proporciona métricas cuantitativas del rendimiento en todo el conjunto de datos. Sin embargo, requiere un gran número de muestras para garantizar la estabilidad de la evaluación y puede ignorar detalles específicos de cada caso (Zhang et al., 2024a). (2) La retroalimentación textual proporciona una guía rica y específica para cada caso analizando y proporcionando sugerencias que generan directamente señales de optimización (Yuksekgonul et al., 2024). (3) Los comentarios de clasificación o selección (Liu et al., 2024b) establecen una clasificación de calidad relativa entre los resultados mediante una clasificación completa o comparaciones por pares, proporcionando una dirección de optimización explícita sin necesidad de métricas de calidad absolutas.

Marco de evaluación. Partiendo de las fuentes, los métodos y los tipos de feedback analizados anteriormente, los marcos de evaluación determinan cómo se comparan y evalúan las fuentes en el contexto de la optimización de pistas. Específicamente, derivamos dos marcos de evaluación para generar retroalimentación F para la optimización de pistas:

(1) Salida frente a respuesta verdadera (OvG): combinando la salida O con la respuesta verdadera GT Haga comparaciones para generar comentarios:

fOvG(Oi, Gi) = φevalúe(φexe(Qi, Tpi), G**i**)

Aunque este enfoque permite una evaluación directa de la calidad mediante referencias externas, requiere respuestas verdaderas claramente definidas y, por tanto, no es adecuado para tareas abiertas en las que no hay respuestas verdaderas o en las que definir respuestas verdaderas es poco práctico.

(2) Salida a salida (OvO): cuando no se dispone de una respuesta verdadera, se recurre a la comparación directa de resultados. La idea central de la OvO es que la comparación de resultados generados a partir de diferentes pistas puede proporcionar señales valiosas sobre su calidad relativa, incluso en ausencia de una respuesta verdadera perfecta. Este enfoque elimina la dependencia de referencias externas y es especialmente útil para tareas abiertas con múltiples respuestas válidas. Puede expresarse formalmente como

fOvO(O1, ... , Ok) = φevalúe({φexe(Qi, Pti)}ki=1)

Una vez presentados los marcos de evaluación OvG y OvO, destacamos que OvO es un método fundamental para la optimización autosupervisada de señales (SPO). Al comparar los resultados generados a partir de diferentes pistas, OvO proporciona información valiosa sobre su calidad relativa sin depender de referencias externas. Este enfoque es coherente con nuestro objetivo de generar información a partir de los propios resultados, facilitando así la optimización iterativa tanto para tareas cerradas como abiertas.

3. Optimización de los consejos de autocontrol

En esta sección, primero esbozamos nuestro planteamiento (Sección 3.1) y luego analizamos su eficacia (Sección 3.2).

3.1 Panorama general del SPO

Uno de los principales retos de la optimización sin referencias es cómo construir señales de evaluación y optimización eficaces. Proponemos la optimización auto-supervisada (SPO), un marco simple pero eficaz para la optimización sin referencias que conserva el ciclo básico de optimizar-ejecutar-evaluar, utilizando sólo los resultados del modelo como fuente de evaluación y guía de optimización.

Como se muestra en el Algoritmo 1, SPO funciona a través de tres componentes clave y las pistas correspondientes se muestran en el Apéndice A.1:

- Funciones de optimización (φop): genera un nuevo aviso analizando el mejor aviso actual y su correspondiente salida.

- función ejecutiva (φexe): aplica las indicaciones generadas para obtener la salida.

- Función de evaluación (φevalúe): utilizar LLM para comparar las salidas y determinar la mejor pista por comparación de pares.

Este proceso iterativo comienza con una plantilla básica de instrucciones (por ejemplo, Chain Thinking (Wei et al., 2022)) y un pequeño conjunto de preguntas extraídas del conjunto de datos. En cada iteración, SPO genera nuevas instrucciones, las ejecuta y evalúa por pares los resultados para determinar si se ajustan a los requisitos de la tarea.

La asociación de este indicio con un mejor resultado se selecciona como el mejor candidato para la siguiente iteración. El proceso continúa hasta que se alcanza un número máximo predeterminado de iteraciones.

3.2 Comprender la eficacia de los SPO

El fundamento teórico de SPO se basa en dos observaciones clave:

En primer lugar, la salida de los LLM es rica en información cualitativa que refleja directamente la validez de la pista, como demuestra el hecho de que las rutas de razonamiento paso a paso puedan demostrar el éxito de las pistas de pensamiento en cadena (Wei et al., 2022). En segundo lugar, los LLM muestran una comprensión de la tarea similar a la humana, lo que les permite evaluar la calidad de la respuesta e identificar soluciones superiores basadas en los requisitos de la tarea. Estas capacidades complementarias permiten a los SPO realizar la evaluación y optimización de pistas sin referencias externas. Estos dos aspectos de la explotación de los resultados del modelo se combinan para lograr una optimización eficaz de las indicaciones:

como guía de optimización. En el caso de φop En términos de diseño, a diferencia de otros métodos que introducen una optimización explícita de las señales (Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023), φop La optimización se basa directamente en las señales y sus correspondientes resultados. Las señales de optimización se derivan de la capacidad inherente del LLM para evaluar la calidad de los resultados, mientras que el comportamiento de optimización se guía por su comprensión de lo que constituye una solución mejor. Así, incluso en ausencia de señales de optimización explícitas, la optimización de SPO dirige esencialmente las pistas hacia la comprensión óptima de la tarea por parte de la LLM.

como referencia para la evaluación por pares. Acerca de φevalúe al permitir que el modelo de evaluación realice una selección por pares, explotamos de forma eficaz la comprensión de las preferencias inherentes a la tarea por parte del modelo de evaluación. Esta señal interna puede obtenerse mediante simples comparaciones por pares de los resultados, evitando la necesidad de un gran número de muestras para garantizar la estabilidad de la puntuación, que a menudo es necesaria para los métodos de retroalimentación de puntuación.

Aunque mitigamos los posibles sesgos mediante cuatro rondas de evaluaciones aleatorias, estos sesgos no pueden eliminarse por completo (Zhou et al., 2024). Sin embargo, estos sesgos no afectan a la tendencia general de optimización, ya que la retroalimentación de las evaluaciones solo se utiliza como referencia para la siguiente ronda de optimización. El proceso de optimización global se alinea de forma natural con la comprensión de la tarea del modelo de optimización, y el mecanismo de evaluación solo se utiliza para validar la eficacia de cada iteración.

4. Experimentos

4.1 Montaje experimental

conjunto de datos. Evaluamos SPO en un conjunto diverso de tareas, incluidas tareas cerradas y abiertas, para valorar plenamente su eficacia.

Para la tarea cerrada, utilizamos cinco puntos de referencia establecidos:

- GPQA (Rein et al., 2023)

- AGIEval-MATH (Zhong et al., 2024)

- MENTIROSO (Wang, 2017)

- WSC (Levesque et al., 2012)

- BBH-navigate (Suzgun et al., 2023)

Para WSC, LIAR y BBH-Navigate, seguimos a Yan et al. (2024) y muestreamos partes del conjunto de datos original como conjunto de prueba. Para GPQA, utilizamos el subconjunto más difícil GPQA-Diamond como conjunto de pruebas, mientras que para AGIEval-Math, utilizamos problemas de nivel 5 como conjunto de pruebas. Para las tareas abiertas, seleccionamos tareas de escritura, juegos de rol y humanidades de MT-Bench (Zheng et al., 2023). Dado el tamaño limitado del conjunto de datos, construimos manualmente tres conjuntos de validación para estas tareas. En el apéndice A.3 se ofrece una descripción detallada de los conjuntos de datos y los procedimientos para construir los conjuntos de validación y prueba.

línea de base (en levantamiento geodésico). Evaluamos SPO en tareas cerradas para dos clases de métodos: (1) métodos tradicionales de prompting, incluyendo io (llamadas directas LLM), chainthink (Wei et al., 2022), rewording (Deng et al., 2023), y fallback abstraction (Zheng et al., 2024); y (2) métodos automáticos de optimización de prompting, incluyendo APE ( Zhou et al., 2023), OPRO (Yang et al., 2024a), PromptAgent (Wang et al., 2024e), PromptBreeder (Fernando et al., 2024) y TextGrad (Yuksekgonul et al., 2024), cuya evaluación se basa en un conjunto de algoritmos, como APE (Deng et al., 2023) y fallback abstraction (Zheng et al., 2024); y (2) métodos de optimización automática de avisos, entre los que se incluyen APE ( 2024), cuyos ajustes del marco de evaluación se detallan en la Tabla 2.

Para la tarea abierta en MT-Bench (Zheng et al., 2023), utilizamos GPT-4o para comparar la salida generada por SPO con la generada directamente por el modelo.

4.2 Resultados experimentales y análisis

Principales conclusiones del mandato cerrado. Como se muestra en la Tabla 1, los avisos optimizados con SPO superan a todos los métodos de avisos tradicionales en promedio, superando la línea de base óptima en 1,9. Al mismo tiempo, su rendimiento es comparable al de los métodos de optimización de avisos que se basan en respuestas veraces en la mayoría de los conjuntos de datos, y alcanza resultados óptimos en los conjuntos de datos GPQA y BBH-navigate. En concreto, la ventaja media de SPO sobre otros métodos de optimización sugiere que su método de evaluación por pares es capaz de generar señales de optimización más eficientes que otros métodos que se basan en referencias externas. Además, para validar la eficacia de nuestro método en distintos modelos de optimización, realizamos experimentos utilizando GPT-4o como modelo de optimización y obtuvimos un rendimiento medio de 66,3. Aunque es ligeramente inferior a los resultados obtenidos utilizando Claude-3-5-Sonnet como modelo de optimización, sigue siendo el tercer mejor rendimiento entre todos los métodos comparados.

análisis de costes. En la Tabla 1 se ofrece una comparación exhaustiva del coste de optimización y el rendimiento de SPO (utilizando Claude-3.5-Sonnet y GPT-4o como modelos de optimización) con otros métodos de optimización. Al tiempo que mantiene un rendimiento comparable con otros métodos de optimización de pistas que se basan en respuestas reales, SPO sólo requiere un coste de optimización de 1,11 TP3T a 5,61 TP3T, con un coste de optimización medio por conjunto de datos de $0.15. Esta importante reducción de la carga computacional, combinada con su falta de dependencia de las respuestas reales, hace que SPO resulte muy atractivo para las aplicaciones del mundo real.

Tabla 3. Comparación del rendimiento de BBH-navigate: métodos de cueing (IO y COT) y SPO utilizando diferentes modelos de evaluación (filas) y ejecución (columnas). El modelo de optimización es Claude-3.5-Sonnet.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| Claude-3.5-Sonnet | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

Estudios de ablación. Para evaluar la transferibilidad de SPO a través de diferentes modelos de optimización, evaluación y ejecución, realizamos experimentos de ablación en el conjunto de datos BBH-Navigate. Los resultados experimentales de las Tablas 3 y 4 muestran que SPO ofrece un rendimiento sólido en distintos modelos. En particular, el mejor rendimiento (97,8) se obtuvo utilizando GPT-4o-mini como modelo de optimización, ejecución y evaluación. En cuanto a la ejecución, SPO mejoró eficazmente el rendimiento del modelo más débil al aumentar Claude-3-Haiku de 62,2 a 89,7, lo que demuestra la capacidad de SPO para aplicarse al modelo más débil y amplía aún más su potencial para aplicaciones realistas.

Tabla 4. Comparación del rendimiento de BBH-navigate en diferentes modelos de optimización (filas) y modelos de ejecución (columnas). El modelo de evaluación es GPT-4o-mini.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| Claude-3.5-Sonnet | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

Realizamos un estudio de ablación para investigar el efecto del tamaño de la muestra en el rendimiento del SPO utilizando el conjunto de datos BBH-Navigate, como se muestra en la Figura 5. Las curvas de rendimiento de los tres modelos de optimización muestran un patrón similar. Las curvas de rendimiento de los tres modelos de optimización muestran un patrón similar: el rendimiento mejora inicialmente a medida que aumenta el tamaño de la muestra, pero finalmente se nivela o disminuye. Este fenómeno puede atribuirse a dos factores: unas muestras insuficientes conducen a un ajuste excesivo en la optimización de pistas, mientras que un número excesivo de muestras no sólo aumenta el coste computacional, sino que también conduce a un contexto más largo para evaluar el modelo, lo que puede reducir la calidad de la evaluación. Basándonos en experimentos exhaustivos, determinamos que un tamaño de muestra de 3 lograba el mejor equilibrio entre rentabilidad y rendimiento.

Principales conclusiones del mandato abiertoPara validar la capacidad de SPO en tareas abiertas, seleccionamos tres categorías del MT-Bench para evaluar. Para validar la capacidad de SPO en tareas abiertas, seleccionamos tres categorías del MT-Bench para evaluar: "Escritura", "Juego de rol" y "Humanidades ". Utilizamos Claude-3.5-Sonnet como modelo de optimización, Gpt-4o-mini como modelo de evaluación, y seleccionamos Claude-3.5-Sonnet, DeepSeek-V3 y GPT-4omini como modelos de ejecución para cinco iteraciones. Posteriormente, siguiendo el método de evaluación de (Zheng et al., 2023), utilizamos GPT-4o para comparar las salidas del Modelo A y el Modelo B por pares, como se muestra en la Fig. 6. Los resultados experimentales, mostrados en la Fig. 6, indican que SPO mejora significativamente el rendimiento del modelo bajo todas las configuraciones del modelo. Cabe destacar que los modelos más pequeños que utilizan pistas de optimización (por ejemplo, GPT-4omini) suelen superar a los modelos más grandes en la mayoría de los casos.

4.3 Casos prácticos

Mostramos los resultados de optimización para la tarea abierta adicional sin el conjunto de datos, así como la trayectoria de optimización de SPO, en el Apéndice A.4. También proporcionamos las pistas óptimas encontradas por SPO en las cinco tareas cerradas en el Material Suplementario. Dado que las aplicaciones del mundo real a menudo se enfrentan al problema de los conjuntos de datos limitados, evaluamos el rendimiento de SPO en tareas sin puntos de referencia tradicionales. Los resultados experimentales combinados con la rentabilidad de SPO demuestran su valor práctico en escenarios del mundo real. En concreto, mostramos los resultados de optimización tras 10 iteraciones utilizando Claude-3.5-Sonnet como modelo de optimización, GPT-4o-mini como modelo de evaluación y Llama3-8B como modelo de ejecución, cubriendo las cuatro tareas de diseño de anuncios, contenido de redes sociales, escritura de poesía moderna y explicación conceptual. Además, en el Apéndice A.4.1 ofrecemos un análisis exhaustivo de la trayectoria de optimización de SPO en el conjunto de datos BBH-navigate, mostrando ejemplos exitosos y fallidos para proporcionar una visión más profunda del proceso de optimización.

5. Trabajos relacionados

5.1 Ingeniería del taco

La investigación sobre métodos eficaces de incitación se ha desarrollado en dos direcciones principales. La primera se centra en técnicas de estímulo independientes de la tarea que mejoran la generalizabilidad de los LLM. Algunos ejemplos notables son el pensamiento en cadena (Wei et al., 2022; Kojima et al., 2022), que mejora el razonamiento en una amplia gama de tareas; técnicas para mejorar el razonamiento de una sola vez (Deng et al., 2023; Zheng et al., 2024; Wang et al., 2024d); y para la especificación del formato de salida (Zhang et al., 2024a; He et al., 2024; Tam et al., 2024). Estas técnicas proporcionan importantes semillas de optimización para los estudios de optimización de autocue a través de la percepción humana y un amplio desarrollo experimental.

La segunda dirección aborda las claves específicas del dominio, y los investigadores han desarrollado nuevos enfoques para la generación de códigos (Hong et al., 2024b; Ridnik et al., 2024; Shen et al., 2024a), el análisis de datos (Hong et al., 2024a; Liu et al., 2024a; Li et al., 2024a), la formulación de preguntas ( Wu et al., 2024b; Zhu et al., 2024; Yang et al., 2024b), la toma de decisiones (Zhang et al., 2024b; Wang et al., 2024a) y otras áreas (Guo et al., 2024b; Ye et al., 2024; Shen et al., 2024b). ) han desarrollado técnicas especializadas. Sin embargo, a medida que la aplicación de los LLM se extiende a escenarios cada vez más complejos del mundo real, resulta poco práctico crear manualmente claves eficaces para cada dominio (Zhang et al., 2024a). Este reto ha motivado la investigación en la optimización de claves, cuyo objetivo es desarrollar sistemáticamente claves eficaces para dominios específicos en lugar de descubrir principios generales para la creación de claves.

5.2 Optimización de las señales

En la optimización rápida (OP), el diseño del marco de evaluación es crucial, ya que determina la eficacia y la eficiencia computacional de la optimización. La evolución de los mecanismos de evaluación en la OP ha pasado de la simple recopilación de información de evaluación a la generación de señales de optimización complejas (Chang et al., 2024). Los métodos de OP existentes pueden clasificarse en función de sus fuentes y mecanismos de evaluación.

El enfoque más común se basa en respuestas auténticas como fuente de evaluación, utilizando evaluaciones numéricas basadas en puntos de referencia (Zhou et al., 2023; Guo et al., 2024a; Yang et al., 2024a; Fernando et al., 2024; Wang et al., 2024e; Khattab et al. ). Aunque estos métodos han tenido éxito en tareas específicas, suelen requerir un gran número de iteraciones y muestras para garantizar la estabilidad de la evaluación, lo que se traduce en una importante sobrecarga computacional.

Para reducir los requisitos de muestras, algunos métodos (Yan et al., 2024; Yuksekgonul et al., 2024; Wu et al., 2024a; Wang et al., 2024c; Pryzant et al., 2023; Li et al., 2025) utilizan LLM como jueces (Zheng et al. ..., 2023) para generar comentarios textuales detallados. Aunque este enfoque proporciona señales de evaluación más ricas y requiere menos muestras, sigue dependiendo de datos de respuestas reales, lo que limita su aplicación a tareas abiertas en las que pueden no existir respuestas de referencia.

Los enfoques alternativos se centran en las preferencias humanas, a través de reglas de evaluación diseñadas manualmente o comentarios humanos directos (Chen et al., 2024; Lin et al., 2024). Aunque estos enfoques pueden ser eficaces para tareas abiertas, su necesidad de una amplia participación humana contradice el objetivo de la automatización. Mientras tanto, algunos investigadores han explorado diferentes criterios de evaluación, como la propuesta de Zhang et al. (2024c) de evaluar la validez de las pistas a través de la coherencia de los resultados. Sin embargo, este enfoque se enfrenta a un reto fundamental: la relación no lineal entre consistencia y validez suele dar lugar a señales de evaluación deficientes.

A diferencia de estos métodos, SPO introduce un nuevo paradigma de evaluación que elimina la dependencia de referencias externas al tiempo que mantiene la eficiencia. Al utilizar los resultados del modelo únicamente mediante comparaciones por pares, SPO permite una evaluación robusta sin necesidad de respuestas reales, retroalimentación humana o muestreos exhaustivos, lo que lo hace especialmente adecuado para aplicaciones realistas.

6. Conclusión

Este artículo aborda un reto fundamental en la optimización guiada: la dependencia de referencias externas, que limita las aplicaciones realistas. Introducimos la optimización auto-supervisada (Self-Supervised Prompt Optimisation, SPO), un marco que supera esta dependencia a la vez que implementa un marco en el que cada conjunto de datos es sólo... $0.15 SPO se inspira en el aprendizaje autosupervisado para construir de forma innovadora señales de evaluación y optimización mediante comparaciones por pares de los resultados de los modelos, lo que permite una optimización sin referencias y sin comprometer la eficacia.

Nuestra exhaustiva evaluación muestra que SPO supera a los métodos más avanzados existentes tanto en tareas cerradas como abiertas, logrando resultados de vanguardia a un coste de sólo 1,11 TP3T frente a los 5,61 TP3T de los métodos existentes. El éxito en pruebas de referencia estándar y en diversas aplicaciones del mundo real valida la eficacia y la capacidad de generalización de SPO. Al reducir significativamente los requisitos de recursos y la complejidad operativa, SPO representa un avance significativo para hacer que la optimización de la señalización sea accesible y práctica en aplicaciones del mundo real, con el potencial de acelerar la adopción de tecnologías LLM en una amplia gama de dominios.

Declaración de impacto

El SPO ofrece avances significativos en la ingeniería de claves para los LLM, aportando ventajas como la democratización del acceso, la reducción de costes y la mejora del rendimiento en una amplia gama de tareas. Sin embargo, también plantea riesgos, como la posible amplificación de los sesgos, el uso de generación de contenidos nocivos y la dependencia excesiva de los LLM.

A. Apéndice

A.1 Consejos detallados para los OPP

En esta sección, mostramos meta-consejos para la iteración. Tenga en cuenta que aquí sólo hemos utilizado los consejos más sencillos y directos. Todavía se pueden mejorar optimizando los siguientes meta-consejos para dominios específicos.

Consejos para optimizar la funcionalidad

Esta plantilla de avisos guía a los LLM en la mejora iterativa de los avisos existentes mediante un análisis XML estructurado. Para ello, es necesario identificar los puntos débiles de los avisos de referencia, sugerir cambios y generar versiones optimizadas. La plantilla hace hincapié en las mejoras graduales, manteniendo al mismo tiempo la coherencia de los requisitos.

Consejos para evaluar funciones

La plantilla de evaluación utiliza el análisis comparativo para evaluar la calidad de una respuesta. Requiere un análisis razonado en formato XML de los puntos fuertes y débiles de dos respuestas (A/B), seguido de una elección clara.

A.2. Plantilla detallada para el inicio de una iteración

Este archivo YAML muestra nuestra configuración inicial para iterar sobre la tarea BBH-navigate. Configurando un simple prompt y requisito inicial, junto con tres preguntas específicas, se puede realizar una optimización iterativa. Es importante señalar que el contenido que se muestra aquí es el contenido completo del archivo; el contenido de la sección de respuestas no es la respuesta real, sino que sirve como referencia para el proceso de pensamiento y el formato de salida correcto.

A.3 Detalles del experimento

A.3.1 Detalles de la tarea y los datos

MENTIROSO

LIAR (Wang, 2017) es un conjunto de datos de detección de noticias falsas en inglés que contiene 4000 declaraciones, cada una acompañada de información contextual y etiquetas de mentira. En nuestros experimentos, seguimos el método de Yan et al. (2024) y muestreamos partes del conjunto de datos original como conjunto de prueba.

BBH-Navegar

BBH-Navigate (Suzgun et al., 2023) es una tarea del conjunto de datos BIG-bench Hard, un subconjunto del conjunto de datos BIG Bench. Esta tarea se centra en el razonamiento de navegación y requiere que el modelo determine si un agente vuelve a su punto de partida después de seguir una serie de pasos de navegación. En nuestros experimentos, utilizamos un muestreo aleatorio (semilla = 42) para obtener 200/25/25 divisiones de prueba/entrenamiento/validación.

Tabla A1. tamaño del conjunto de datos y partición de datos

| Nombre del conjunto de datos | prueba (maquinaria, etc.) | Formación y validación |

|---|---|---|

| MENTIROSO | 461 | 3681 |

| BBH-Navegar | 200 | 50 |

| CSM | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| MT-bench | 80 | 0 |

CSM

El Winograd Schema Challenge (WSC) (Levesque et al., 2012) es una prueba de referencia diseñada para evaluar la capacidad de un sistema para realizar razonamientos de sentido común analizando referencias a pronombres en contexto. En nuestros experimentos, seguimos a Yan et al. (2024) y tomamos muestras del conjunto de datos original como conjunto de pruebas.

AGIEval-MATH

AGIEval-MATH (Zhong et al., 2024) es un subconjunto de la referencia AGIEval centrado en tareas de resolución de problemas matemáticos. Incluye una variedad de problemas matemáticos diseñados para evaluar el razonamiento y las habilidades computacionales. En nuestros experimentos, utilizamos problemas de nivel 5 como conjunto de prueba y problemas de nivel 4 como conjunto de entrenamiento y validación.

GPQA

GPQA (Rein et al., 2023) es un conjunto de datos diseñado para evaluar el rendimiento de los modelos lingüísticos en preguntas de posgrado de diversas disciplinas, como la biología, la física y la química. En nuestros experimentos, utilizamos el subconjunto GPQA-Diamond como conjunto de prueba mientras construimos nuestros conjuntos de entrenamiento y validación a partir de problemas que sólo existen en GPQA-main (es decir, los que existen en GPQA-main pero no en GPQA-Diamond).

MT-bench

MT-bench (Zheng et al., 2023) es una prueba comparativa multitarea diseñada para evaluar la capacidad de generalización de los modelos lingüísticos en diversas tareas, como la categorización de textos, el resumen y las preguntas y respuestas. En nuestros experimentos, seleccionamos tareas de escritura, juegos de rol y humanidades de MT-Bench. Estas preguntas de validación se incluyen en el Material complementario.

A.3.2 Configuración

En nuestros experimentos, hemos configurado diferentes marcos de optimización para mantener sus costes de optimización lo más coherentes posible. Por lo general, estos marcos permiten establecer una serie de parámetros para ajustar el coste de optimización, incluido el número de iteraciones y el número de pistas generadas por iteración.

APE

APE utiliza un proceso de optimización iterativo de tres rondas, en el que los 101 mejores tacosTP3T (ratio = 0,1) de la reserva actual se seleccionan como tacos de élite en cada ronda. Para mantener la diversidad y el tamaño de la reserva de pistas, se utiliza el muestreo de variantes para mutar estas pistas de élite y mantener el número total de pistas en 50. Siguiendo la configuración del artículo original (Zhou et al., 2023), el proceso de optimización no incluye resultados de ejecución específicos de la muestra para guiar la optimización de los tacos LLM. En su lugar, las puntuaciones de rendimiento se obtienen evaluando las claves en todo el conjunto de entrenamiento.

OPRO

OPRO utiliza un proceso de optimización iterativo de 10 rondas que genera 10 pistas candidatas por ronda. OPRO evalúa el rendimiento de las pistas en el conjunto completo de datos de entrenamiento y filtra en función de las puntuaciones de la evaluación. OPRO no mantiene un conjunto de pistas de tamaño fijo, sino que genera nuevas candidatas directamente en función de la mejor pista actual en cada ronda. La dirección de optimización se guía por la evaluación del rendimiento en los datos de entrenamiento completos.

PromptAgent

Salvo en el caso del conjunto de datos Mentiroso, en el que muestreamos 150 datos tanto en el conjunto de entrenamiento como en el de validación, los demás conjuntos de datos siguen los tamaños especificados en la Tabla A1.PromptAgent utiliza el marco de búsqueda en árbol Monte Carlo (MCTS) para optimizar las indicaciones. Comienza con una pista inicial y genera nuevas candidatas basándose en la retroalimentación del error del modelo. El proceso está guiado por el uso de evaluaciones de referencia en un conjunto de entrenamiento muestreado para identificar caminos de alto rendimiento para mejorar el rendimiento de la tarea. Los parámetros clave del MCTS incluyen una anchura de expansión de 3, un límite de profundidad de 8 y 12 iteraciones.

PromptBreeder

En nuestra aplicación de PromptBreeder, hemos configurado el sistema para que utilice 5 pistas variantes y 5 estilos de pensamiento para la inicialización. El proceso evolutivo se ejecuta durante 20 generaciones, y cada generación realiza 20 evaluaciones sobre un ejemplo de entrenamiento muestreado aleatoriamente. El modelo de optimización por defecto es Claude-3.5-Sonnet y el modelo de ejecución GPT-4o-mini.

TextGrad

TextGrad utiliza un proceso de optimización de tres épocas, con tres pasos por época (epoch_{-3}, steps_{-3}), para realizar el descenso estocástico de gradiente utilizando tamaños de lote de tres. En cada paso, TextGrad genera gradientes a través de la retroalimentación del optimizador LLM (Claude-3.5-Sonnet) para actualizar las claves del sistema. El marco mantiene un mecanismo de reducción basado en la validación: si la pista actualizada funciona peor en el conjunto de validación que en la iteración anterior, la actualización se rechaza y la pista vuelve a su estado anterior. El proceso de optimización se guía por la evaluación de las claves utilizando Claude-3.5-Sonnet como LLM de evaluación, mientras que la ejecución de la tarea real utiliza GPT-4o-mini como LLM de ejecución.

SPO

SPO optimiza realizando 10 iteraciones por tarea, con 3 preguntas (sin respuestas) seleccionadas aleatoriamente del conjunto de datos pre-particionado Train&Validate para cada iteración. El modelo de optimización predeterminado es Claude-3.5-Sonnet, el modelo de evaluación predeterminado es GPT-4o-mini, y el modelo de ejecución predeterminado es GPT-4o-mini. Cabe destacar que SPO consigue una optimización eficaz utilizando sólo preguntas sin respuestas reales, lo que valida sus capacidades.

A.3.3 Indicaciones básicas

En esta sección se presentan los indicadores de referencia utilizados para la comparación. Tenga en cuenta que para todos los esfuerzos de optimización de pistas que requieren una iteración inicial de pistas, siempre proporcionamos las pistas COT que se muestran a continuación.

Asegúrate de que la respuesta termina con el siguiente formato: respuesta.

A.3.4. Consejos para optimizar el SPO

En esta sección, mostramos las pistas de optimización que obtuvimos en nuestros experimentos principales, en los que Claude-3.5-Sonnet sirvió como modelo de optimización y GPT-4o-mini como modelo de evaluación y ejecución.

Consejos GPQA

Siga las directrices que se indican a continuación para responder a las preguntas de forma eficiente y eficaz:

- Lea atentamente toda la pregunta, identificando toda la información relevante y los conceptos clave.

- Seleccionar el método de resolución de problemas más adecuado en función del tipo de problema.

- Siga los pasos que se indican a continuación para solucionar el problema:

a. Declaraciones de fórmulas, principios o supuestos pertinentes

b. Mostrar todos los cálculos o análisis conceptuales necesarios

c. Evaluar todas las opciones de respuesta, explicando por qué la opción incorrecta es incorrecta (si procede). - Organice su respuesta de acuerdo con la siguiente estructura:

[Análisis]

Breve exposición del tema principal y los mensajes clave (2-3 frases como máximo)

[Solución]

- Presentación paso a paso de su trabajo, incluidos todos los cálculos y razonamientos pertinentes.

- Ofrecer explicaciones claras y lógicas sobre cuestiones conceptuales

[Conclusión]

Exponga la respuesta final en una frase clara

- Explique brevemente por qué esta respuesta es correcta y las demás son incorrectas (si procede)

Adapta esta estructura a los distintos tipos de problemas, dando prioridad a la claridad y la sencillez. Asegúrate de que tu respuesta aborda todos los aspectos del problema y demuestra un proceso claro de resolución del mismo.

BBH-Navegar Consejos

Siga los pasos que se indican a continuación para analizar las instrucciones dadas:

- Indique las condiciones iniciales:

- Punto de partida: (0, 0)

- Sentido inicial: eje x positivo (salvo indicación contraria)

- Utiliza el sistema de coordenadas:

- eje x: izquierda (-) y derecha (+)

- eje y: hacia atrás (-) y hacia delante (+)

- Analice cada paso:

- En el caso de instrucciones vagas (por ejemplo, "dé X pasos" sin dirección), asuma el movimiento hacia delante.

- Actualizar las coordenadas después de cada movimiento

- Explique brevemente las suposiciones realizadas

- Tras analizar todos los pasos:

- Resuma el movimiento total en cada dirección

- Declarar la posición final

- Compara la posición final con el punto de partida:

- Calcular la distancia desde (0, 0)

- Proporcione un razonamiento sucinto etiquetado "Razonamiento:"

- Explicar los movimientos clave y su efecto en la posición

- Razone sus conclusiones

- Indique su respuesta final, etiquetada como "Respuesta final:"

Finalice su respuesta en el siguiente formato XML: [sí o no].

Asegúrese de que sus análisis se adaptan a todos los tipos de problemas, tratando tanto las instrucciones específicas como las vagas.

Consejos LIAR

Analice detenidamente los enunciados dados y siga los pasos que se indican a continuación para cada pregunta:

- Considera la afirmación, los antecedentes del orador (si los tiene) y el contexto.

- Investiga y cita hechos y cifras relevantes relacionados con la afirmación.

- Evalúa la validez de la afirmación a la luz de las pruebas disponibles.

- Considere la posible parcialidad o motivación del orador.

Para cada afirmación, organice su análisis de acuerdo con la siguiente estructura:

Comprobación de hechos: [Hecho clave 1 con fuentes] [Hecho clave 2 con fuentes] [Añade más si es necesario] Análisis: [Proporciona un breve análisis de la validez de la afirmación] Puntuación: [Utiliza la siguiente escala].

Incertidumbre: [baja/media/alta - basada en la calidad y cantidad de las pruebas disponibles] Resumen: [conclusión de una frase sobre la validez de la afirmación].

Si no hay información suficiente para tomar una decisión, indique y explique claramente qué información adicional se necesita.

Finalizar cada análisis con una etiqueta XML: [sí o no].

Tras analizar todas las afirmaciones, haz un resumen general de tus conclusiones.

Asegúrate de que tu respuesta es objetiva, se basa en información verificable y cita las fuentes de todos los datos clave utilizados en el análisis.

AGIEval-MATH Consejos

- Identificar rápidamente la información clave

- Diseñar la estrategia de solución más rápida

- Realizar el menor número de cálculos

- Vuelva a comprobar sus respuestas

Reglas:

Utilice atajos y estimaciones siempre que sea posible

Omitir la explicación detallada

Omitir unidades en la respuesta final

- Presente siempre la respuesta final de la siguiente forma: \boxed{}

Priorizar la rapidez y la precisión. Gestionar el tiempo con eficacia. Esforzarse por encontrar la solución eficaz más breve. Compruebe el formato de la respuesta antes de enviarla. Si encuentra dificultades, prefiera hacer conjeturas antes que perder demasiado tiempo.

A.4 Casos prácticos

A.4.1 Optimización de trayectorias

Mostramos la trayectoria de optimización de pistas de GPT-4o-mini en el conjunto de datos BBH-navigate, donde sirve como modelo de optimización, modelo de evaluación y modelo de ejecución. Esto incluye el éxito de cada iteración en relación con la mejor pista del momento y el contenido de la pista correspondiente.

Iteración 0 - Éxito

Por favor, piense paso a paso. Asegúrese de que la respuesta termina con el siguiente formato: [Sí o No].

Iteración 1 - Fracaso

Analice las siguientes preguntas paso a paso para asegurarse de que su razonamiento es claro. Al final de su análisis, proporcione la respuesta final en el formato XML especificado: (Sí o No).

Pregunta: [inserte aquí la pregunta]

Iteración 2 - Fracaso

Analice paso a paso las instrucciones dadas y resuma claramente su razonamiento. Asegúrese de que la respuesta termina en el siguiente formato XML: (sí o no).

Iteración 3 - Fracaso

Analice detenidamente los pasos indicados y anote cada acción. Asegúrese de que su razonamiento es claro y lógico. Termine con el siguiente formato XML: (Sí o No).

Iteración 4 - Éxito

Plantee la pregunta con un razonamiento claro y lógico que la descomponga en pasos. Antes de dar su respuesta final, resuma claramente sus conclusiones utilizando el siguiente formato XML: [Sí o No]. Por ejemplo, si la pregunta es sobre si se vuelve o no al punto de partida tras una serie de acciones, describa cada acción en detalle, actualice su posición en consecuencia y concluya si ha vuelto o no al punto de partida.

Respuesta final: [Sí o No]

Iteración 5 - Éxito

Analiza a fondo el problema desglosándolo paso a paso. Describe claramente cada movimiento o acción, actualizando tu posición o estado en consecuencia. Por último, resuma sus conclusiones para determinar si ha vuelto al punto de partida o ha logrado el resultado previsto. Por último, presenta claramente la respuesta utilizando el siguiente formato XML: [Sí o No]. Por ejemplo, si se le pregunta si ha vuelto al punto de partida tras una serie de acciones, registre claramente cada acción, siga su posición y especifique si ha vuelto al punto de partida.

Respuesta final: [Sí o No]

Iteración 6 - Éxito

Analiza el problema metódicamente y divídelo en pasos claros y consecutivos. Defina el punto de partida y la dirección de cada acción, actualizando la posición después de cada paso en consecuencia. Por último, resuma el recorrido e indique claramente si la posición final vuelve al punto de partida o consigue el resultado deseado. Utilice el siguiente formato XML para presentar claramente la respuesta final: [sí o no]. Por ejemplo, si se le pregunta si ha vuelto al punto de partida tras una serie de acciones, registre claramente cada paso, siga su posición y especifique si ha vuelto al punto de partida.

Respuesta final: [Sí o No]

Iteración 7 - Fracaso

Evalúe el problema paso a paso, describiendo claramente cada acción y siguiendo la posición resultante. Al final de su análisis, resuma el recorrido e indique si la posición final vuelve al punto de partida o cumple los criterios previstos. Asegúrese de que la respuesta final se presenta claramente en el siguiente formato XML: [Sí o No]. Por ejemplo, si se le pregunta si ha vuelto al punto de partida tras una serie de acciones, deberá registrar sucintamente cada paso, seguir su posición e indicar si ha vuelto al punto de partida.

Respuesta final: [Sí o No]

Iteración 8 - Éxito

Analiza el problema metódicamente y divídelo en acciones concisas. Empiece con una posición definida y haga un seguimiento del impacto de cada paso en su posición. Tras detallar cada acción, resuma el recorrido global e indique claramente si la posición final vuelve al punto de partida o alcanza el resultado deseado. Utilice el siguiente formato XML para presentar claramente la respuesta final: sí o no. Por ejemplo, si se le pregunta si ha vuelto al punto de partida tras una serie de acciones, documente claramente cada paso, haga un seguimiento preciso de su posición y especifique el resultado.

Respuesta final: [Sí o No]

Iteración 9 - Fracaso

Comience por describir sistemáticamente sus movimientos. Partiendo de una posición definida, detalle cada paso que da, incluyendo la dirección y la distancia recorrida. Al finalizar el movimiento, resuma el recorrido global e indique claramente si su posición final le devuelve al punto de partida o consigue el resultado deseado. Asegúrate de presentar tus acciones junto con tu respuesta final en el siguiente formato XML: sí o no. Por ejemplo, si se le pregunta si ha vuelto al punto de partida tras una serie de maniobras, deberá registrar cada paso, seguir con precisión su posición y especificar el resultado.

Respuesta final: [Sí o No]

Iteración 10 - Éxito

Analice detenidamente las instrucciones de movimiento proporcionadas y registre claramente cada paso. Empiece por definir su posición inicial y siga sistemáticamente sus movimientos, actualizando su posición después de cada paso. Una vez completada la acción, resuma su recorrido y determine si su posición final es coherente con su punto de partida o logra el resultado deseado. Utiliza el siguiente formato XML para indicar claramente tu respuesta final: sí o no. Por ejemplo, si la pregunta se refiere a si una serie de acciones vuelven al punto de partida, deberá esbozar metódicamente cada paso, seguir con precisión su posición y llegar a un resultado.

Respuesta final: [Sí o No]

El recuadro de éxito/fracaso muestra el proceso de optimización por parte de SPO de la pista de navegación BBH a través de 10 iteraciones. Las versiones con éxito (verde) mejoran progresivamente la pista para provocar un mejor proceso de pensamiento, mientras que los intentos fallidos (rojo) pueden conducir a un pensamiento excesivamente simplificado o redundante debido a pistas subóptimas. Esta trayectoria muestra el mecanismo de mejora por ensayo y error del sistema.

Consejos para optimizar la funcionalidad

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

cuestiones

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

solución

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

Tras completar todos los pasos, acabamos de vuelta en el punto de partida.

Por lo tanto, la respuesta es:

sea

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

Los titulares de anuncios preoptimizados son genéricos, por ejemplo, "Alerta de Black Friday: ¡no te pierdas las ofertas tecnológicas en la tienda!". que carecían de especificidad y profundidad creativa y no destacaban las características del público objetivo ni la personalidad de la marca. Titulares optimizados como "Desbloquea el futuro: las mejores ofertas tecnológicas hasta 50%" son más atractivos, ya que utilizan "desbloquea el futuro" para enfatizar la innovación tecnológica y lo combinan con descuentos para estimular la curiosidad y resaltar el valor, lo que está más en consonancia con la marca. El uso de "desbloquea el futuro" para destacar la innovación tecnológica, combinado con el mensaje de descuento, no sólo estimula la curiosidad, sino que también destaca el valor, lo que se ajusta más a las necesidades psicológicas de los amantes de la tecnología.

Iteración de plantillas en el conjunto de datos BBH-navigate

Contenido de las redes sociales

Rendimiento antes de la optimización

llamar la atención sobre algo = """Crear tweets convincentes.""""

solución = """Tweets. "¡Buenos días, amantes del café! Regalamos un vale para una taza de nuestra especialidad de café a las 10 primeras personas que compartan en los comentarios cómo les gusta más el café.# Café # Adicción al café # Poder matutino"

Este tuit está diseñado para captar la atención del público de varias maneras:

- llamada a la acciónLos tuits pedían a los seguidores que compartieran cómo les gusta más el café, animándoles a participar e interactuar con la marca.

- incentivosLa promesa de café gratis es un gran incentivo para que la gente participe en los tuits y comparta ideas.

- pestaña (de una ventana) (informática)El uso de hashtags relevantes como # Coffee, # Coffee Addiction y # Morning Power ayuda a llegar a un público más amplio y a atraer a nuevos seguidores.

- Contacto personalizadoEl tweet empieza con un amistoso "Buenos días" y se refiere al público como "amantes del café", lo que le da un aire más personal e íntimo.

Al responder a este tuit, las marcas de café pueden entablar un diálogo con sus seguidores, recabar opiniones y crear un sentimiento de comunidad en torno a la marca.""""

Rendimiento optimizado

llamar la atención sobre algo = """Crea contenidos atractivos para las redes sociales basados en un tema o una marca determinados. Siga las directrices que se indican a continuación:

- Identifique el público objetivo y la plataforma (si se especifica).

- Indique el objetivo principal del contenido (por ejemplo, visibilidad, compromiso, promoción).

| 3. Seleccione el formato de contenido adecuado (por ejemplo, texto, imágenes, vídeo). | |

| 4. Desarrollar un ángulo o concepto único relacionado con las tendencias actuales. | |

| 5. Cree un titular pegadizo o una declaración de apertura (máximo 10 palabras). | |

| 6. Elabore contenidos concisos y adecuados a la plataforma (50-100 palabras). | |

| 7. Incluya 2-3 etiquetas relevantes. | |

| 8. Añada una llamada a la acción clara. | |

| 9. Sugiera un elemento visual o de mejora. | |

| Proporcione un contenido para las redes sociales basado en estas directrices y adaptado a un tema o una marca determinados. | |

| Céntrese en la creación de contenidos auténticos y relevantes que resuenen entre su público objetivo y se ajusten a las tendencias actuales de las redes sociales. Si no se indican requisitos específicos, haga suposiciones razonables y explique sus opciones."""" | |

| Pregunta = "Crear un tweet de compromiso para una marca de café" | |

| Respuesta = | |

| **Público objetivo:** Amantes del café, jóvenes (18-35 años) | |

| **Plataforma:** Twitter | |

| **Objetivo principal:** Participación | |

| **Formato del contenido:** Texto | |

| **Perspectiva única:** Compartir un momento conmovedor con el que los amantes del café puedan identificarse. | |

| **Titular pegadizo:** "Cuando el café es el único adulto en la habitación" | |

| **Contenido:** "¿Quién no ha tenido mañanas en las que el café es lo único que mantiene todo en orden? Comparte tus historias matutinas más caóticas y lamentémonos # El café salva el día # El poder de la mañana" | |

| **Etiquetado:** # El café salva el día # Motivación matutina | |

| **Llamamiento a la acción:** ¡Comparte tus propias historias de mañanas desordenadas en los comentarios! | |

| **ELEMENTOS VISUALES:** Un interesante modal o GIF de una persona rodeada de caos con una taza de café en el centro. | |

| El tuit pretendía captar la atención de los amantes del café compartiendo un momento conmovedor con el que muchos pudieran identificarse. El uso del humor y de un tono desenfadado facilitó la conexión con el público. Los hashtags # Coffee Saves the Day y # Morning Power fueron populares y relevantes, lo que aumentó la visibilidad del tuit. | |

| La llamada a la acción anima a los usuarios a compartir sus propias historias, fomentando así el sentido de comunidad y estimulando la participación. | |

| II | |

Los tweets preoptimizados utilizan regalos como cebo con un contenido directo que carece de resonancia emocional, como "¡Buenos días, amantes del café! Regalamos una taza de...". . Los tweets optimizados se hicieron más relevantes e interactivos mediante la expresión humorística "cuando el café es el único adulto en la habitación", integrando sutilmente el café en escenarios de la vida cotidiana, por ejemplo, "¿Quién no ha tenido una de esas mañanas en las que el café es lo único que mantiene las cosas en marcha? " Consigue estimular el compromiso del usuario y la conexión emocional.

Plantilla de iteración en el conjunto de datos BBH-navigate:

Antes de la optimización del rendimiento

llamar la atención sobre algo = """Crear poesía en el estilo y formato solicitados.""""

cuestiones = "Escribe un soneto moderno sobre el cambio climático"

solución = """En los cielos ardientes, vemos advertencias sobre el aumento de las temperaturas, una antigua leyenda del planeta, víctima de nuestro control sin sentido, a medida que las emisiones de carbono se extienden como una plaga.

El hielo polar, un trono frágil que se derrite El océano, en ascenso, amenaza con expiar la codicia humana, una deuda que no podemos pagar Con el cambio climático, se desata una crisis

Pero seguimos dudando, adictos al torbellino de la negación Mientras los científicos lloran y rezan angustiados Para actuar rápido, antes de que sea demasiado tarde Para salvar al planeta de nuestras imprudentes maneras

Sin embargo, aún tenemos la esperanza de que, con amor y fuerza humana, se invierta la marea y se traiga una nueva luz""".

Rendimiento optimizado

llamar la atención sobre algo = """Crear poesía que traspase los límites tradicionales y rompa las expectativas convencionales sigue las siguientes pautas mejoradas:

- Deconstruir y reimaginar la forma poética solicitada, ampliando sus límites estructurales pero manteniendo su esencia.

- Aborde el tema desde una perspectiva totalmente inesperada, por ejemplo, desde el punto de vista de un objeto inanimado, un concepto abstracto o una entidad microscópica.

- Se utilizan imágenes surrealistas y vanguardistas para cuestionar la percepción de la realidad por parte del lector, sin dejar de transmitir la verdad emocional que subyace en el tema.

- Integre elementos poco convencionales como la notación matemática, los símbolos científicos o los lenguajes de programación para crear un paisaje lingüístico único.

- Experimente con la tipografía, los saltos de línea y los espacios en blanco para crear una poesía visual que potencie la exploración del tema.

- Una experiencia sensorial fluida que combina los diferentes sentidos de forma sorprendente para evocar una fuerte respuesta emocional.

- Con un final que es a la vez desorientador y esclarecedor, deja en el lector una profunda sensación de transformación.

Antes de escribir, imagine la manera más radical de abordar el tema y la forma poética. El objetivo es crear una pieza que desafíe la definición de poesía sin dejar de resonar emocionalmente a un nivel profundo.

La poesía se proporciona sólo en su respuesta y no contiene ninguna explicación o análisis adicional.""""

cuestiones = "Escribe un soneto moderno sobre el cambio climático"

solución = """En susurros fractales, el pulso de la tierra late lentamente Mientras manchas oscuras de carbono se filtran en la nieve Un cálculo de desesperación, las ecuaciones crecen En decadencia exponencial, la tristeza del futuro

La danza termodinámica de la vida se despliega mientras la fría mano de la entropía aprieta el corazón del planeta El cielo, antes azul, es ahora una pesada masa de partículas que bloquea la luz del sol

En este inquietante crepúsculo, las sombras persisten El fantasma de un glaciar susurra: "Este es mi hogar" Un réquiem por el hielo, los recuerdos se almacenan En ecos congelados, explorando el pasado.

Sin embargo, en este paisaje desolado, queda una chispa

Un salto cuántico de esperanza que sostiene el amor".

El soneto preoptimizado, aunque pulcramente estructurado, carece de novedad en el uso de imágenes tradicionales como "aumento de la temperatura" y "deshielo". El poema optimizado introduce conceptos científicos como "susurros fractales" y "entropía termodinámica", por ejemplo: "En susurros fractales, el pulso de la tierra late lentamente" y "La danza termodinámica de la vida se despliega", utilizando metáforas interdisciplinares para dar al tema climático una reflexión filosófica más profunda, realzando la profundidad artística e intelectual del poema.

Plantilla de iteración en el conjunto de datos BBH-navigate:

Explicaciones conceptuales

Antes de la optimización del rendimiento

llamar la atención sobre algo = """Explicar conceptos complejos en términos sencillos.""""

cuestiones = "Explicación de las vacunas de ARNm mediante una analogía culinaria"

solución ="""Imagina que eres un maestro de la cocina y estás preparando un plato delicioso para tus invitados. Tienes todos los ingredientes, pero tienes que asegurarte de que están en el orden y la combinación adecuados para crear los sabores y texturas perfectos.

En el mundo de las vacunas de ARNm, el "plato" es la respuesta del sistema inmunitario a un virus o enfermedad concretos. Los "ingredientes" son instrucciones genéticas (ARNm) que indican al organismo cómo fabricar proteínas específicas, que luego se utilizan para desencadenar una respuesta inmunitaria.

Funciona de la siguiente manera:

Selección de recetasLas vacunas de ARNm son como elegir un libro de recetas. Se elige una secuencia específica de ARNm que corresponde a la proteína que se quiere fabricar, que es la clave para desencadenar una respuesta inmunitaria contra un virus o una enfermedad concretos.

2. Ingredientes PreparaciónEl ARNm se prepara en el laboratorio, igual que se mide la cantidad correcta de cada ingrediente (aminoácido) para fabricar una proteína.

3. entregasEl ARNm se introduce en el organismo del mismo modo que se añaden ingredientes a un plato. En este caso, el ARNm se empaqueta en una minúscula partícula llamada nanopartícula lipídica (NPL), que le ayuda a llegar a las células del organismo.

4. Cocina celularUna vez que el ARNm llega a la célula, es como añadir ingredientes a una olla. La célula lee las instrucciones del ARNm y empieza a fabricar una proteína específica. A continuación, esta proteína se muestra en la superficie de la célula como una bandera para advertir al sistema inmunitario de la presencia de un invasor extraño.

- respuesta inmunitariaEl sistema inmunitario reacciona ante las proteínas, produciendo anticuerpos y activando las células inmunitarias, del mismo modo que un chef reacciona ante un aroma delicioso para dar los toques finales a un plato. El sistema inmunitario recuerda entonces cómo reaccionar ante esa proteína concreta, de modo que si vuelve a encontrarla en el futuro, puede montar rápidamente una defensa.

En resumen, las vacunas de ARNm son como recetas para el sistema inmunitario. Proporcionan al organismo instrucciones genéticas para fabricar proteínas específicas, lo que desencadena una respuesta inmunitaria y ayuda a proteger contra la enfermedad.""""

Rendimiento optimizado

llamar la atención sobre algo = """Explicar conceptos complejos en términos sencillos.""""

cuestiones = "Explicación de las vacunas de ARNm mediante una analogía culinaria"

solución = """definaUna vacuna de ARNm es una vacuna que utiliza un tipo de material genético llamado ARN mensajero (ARNm) para enseñar a nuestras células a combatir la enfermedad.

analógicoImagínese que es un maestro de la cocina y quiere crear una nueva receta para un plato delicioso. No enviaría a su jefe de cocina a la tienda a comprar todos los ingredientes y luego le dejaría que se las arreglara solo para preparar el plato. En lugar de eso, le daría una receta con los pasos exactos a seguir. Del mismo modo, las vacunas de ARNm funcionan proporcionando a nuestras células una receta -ARNm- que contiene instrucciones para fabricar proteínas específicas que ayudan a nuestro sistema inmunitario a combatir las enfermedades.

Componentes clave::

- ARNmUna receta con instrucciones para fabricar una proteína específica. Piense en ella como un modelo a seguir por sus células.

- citoplasmaLos sous chefs de nuestro cuerpo reciben la receta del ARNm y la utilizan para fabricar proteínas.

- hidratos de carbono: el último plato producido por nuestras células, que ayuda a nuestro sistema inmunitario a reconocer y combatir las enfermedades.

relatar (una historia o información)Cuando recibimos una vacuna de ARNm, nuestras células recogen la receta (ARNm) y la utilizan para fabricar una proteína específica. Esta proteína desencadena entonces una respuesta inmunitaria que enseña a nuestro organismo a reconocer y combatir la enfermedad. Es como si nuestras células siguieran una receta para crear un plato delicioso que nos ayuda a mantenernos sanos.

Elementos interactivosEl secreto del éxito: ¿Se te ocurre alguna vez en la que hayas recibido una receta de alguien y hayas tenido que seguirla para crear un plato? ¿Cómo te hizo sentir? Imagina que tus células reciben una receta de una vacuna de ARNm y la utilizan para fabricar proteínas que ayudan a combatir enfermedades. ¿Cómo te sentirías?

rendimiento visualDiagrama simple que muestra la molécula de ARNm, la célula que recibe el ARNm y la proteína que se produce.

limitacionesLas vacunas de ARNm siguen siendo una tecnología relativamente nueva y se necesita más investigación para comprender sus efectos a largo plazo y sus posibles efectos secundarios.

llegar a un veredictoLas vacunas de ARNm cambian las reglas del juego en la lucha contra las enfermedades. Al proporcionar a nuestras células una receta, podemos enseñar a nuestro sistema inmunitario a reconocer y combatir las enfermedades de forma más eficaz. ¿Qué futuro cree que les espera a las vacunas de ARNm?"""

Las explicaciones preoptimizadas, aunque utilizan analogías culinarias, son largas y carecen de enfoque, por ejemplo: "Imagina que eres un maestro cocinero...". . La versión optimizada simplifica los conceptos complejos en pasos fáciles de entender utilizando metáforas básicas como "tarjetas de recetas", por ejemplo, "las secuencias de ARNm son como un conjunto de instrucciones que le dicen al cuerpo cómo fabricar una proteína específica", y utilizando El uso de roles de "chef-sous-chef" hace que las explicaciones sean más vívidas e intuitivas, ayudando a los lectores a captar rápidamente los puntos clave.

Plantillas iterativas en el conjunto de datos BBH-navigate Sugerencia: | Explique conceptos complejos en términos sencillos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...