Despliegue privado de DeepSeek + Dify: creación de un sistema local de asistente de inteligencia artificial seguro y controlable

Tutoriales prácticos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 62.6K 00

esbozado

DeepSeek es un innovador modelo de big language de código abierto que aporta una experiencia revolucionaria a las interacciones de diálogo de IA con su avanzada arquitectura algorítmica y sus capacidades de encadenamiento reflexivo. Con el despliegue privado, tiene pleno control sobre la seguridad de los datos y la seguridad de uso. También puede ajustar con flexibilidad el esquema de despliegue e implantar un cómodo sistema personalizado.

Dify Como la misma plataforma de desarrollo de aplicaciones de IA de código abierto, ofrece una solución completa de despliegue privado. Al integrar a la perfección los servicios DeepSeek desplegados localmente en la plataforma Dify, las organizaciones pueden crear potentes aplicaciones de IA dentro de un entorno de servidor local al tiempo que garantizan la privacidad de los datos.

A continuación se enumeran las ventajas de la opción de despliegue privado:

- rendimiento superior : Proporcionar una experiencia de interacción de diálogo comparable a los modelos de negocio

- aislamiento ambiental Funcionamiento totalmente offline, lo que elimina el riesgo de fuga de datos.

- Controlabilidad de los datos Control total de los activos de datos para cumplir los requisitos de conformidad.

preposicionamiento

Entorno de hardware:

- CPU >= 2 núcleos

- Memoria de vídeo/RAM ≥ 16 GiB (recomendado)

Entorno de software:

- Docker

- Docker Compose

- Ollama

- Edición comunitaria de Dify

Inicio del despliegue

1. Instalación de Ollama

Ollama es un cliente de gestión de grandes modelos multiplataforma (MacOS, Windows, Linux) diseñado para desplegar sin problemas grandes modelos lingüísticos (LLM) como DeepSeek, Llama, Mistral, etc. Ollama permite desplegar grandes modelos con un solo clic, y todos los datos de uso se almacenan localmente en la máquina, lo que proporciona una total privacidad de los datos. y seguridad.

Visite el sitio web de Ollama y siga las instrucciones para descargar e instalar el cliente Ollama. Tras la instalación, ejecute ollama -v mostrará el número de versión.

➜~ollama-v

ollamaversionis0.5.5

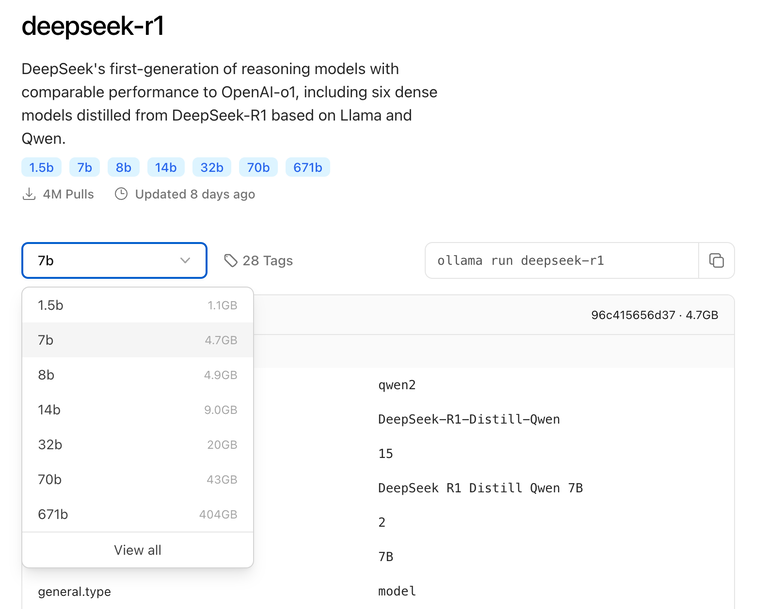

Seleccione el modelo de tamaño de DeepSeek adecuado para la implantación en función de la configuración real del entorno. Se recomienda el modelo de tamaño 7B para la instalación inicial.

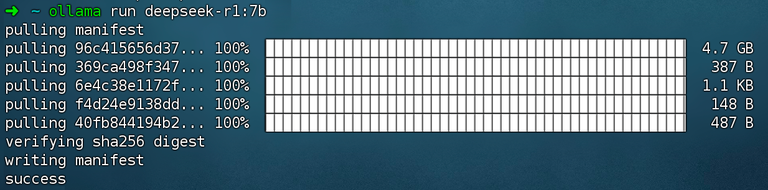

Ejecutar comando ollama run deepseek-r1:7b montaje DeepSeek R1 Modelos.

2. Instale Dify Community Edition

Visite la dirección del proyecto GitHub de Dify y ejecute los siguientes comandos para completar el repositorio de código y el proceso de instalación.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Después de ejecutar el comando, debería ver el estado y la asignación de puertos de todos los contenedores. Para obtener instrucciones detalladas, consulte Despliegue de Docker Compose.

Dify Community Edition utiliza el puerto 80 por defecto. http://your_server_ip Accede a tu plataforma privatizada de Dify.

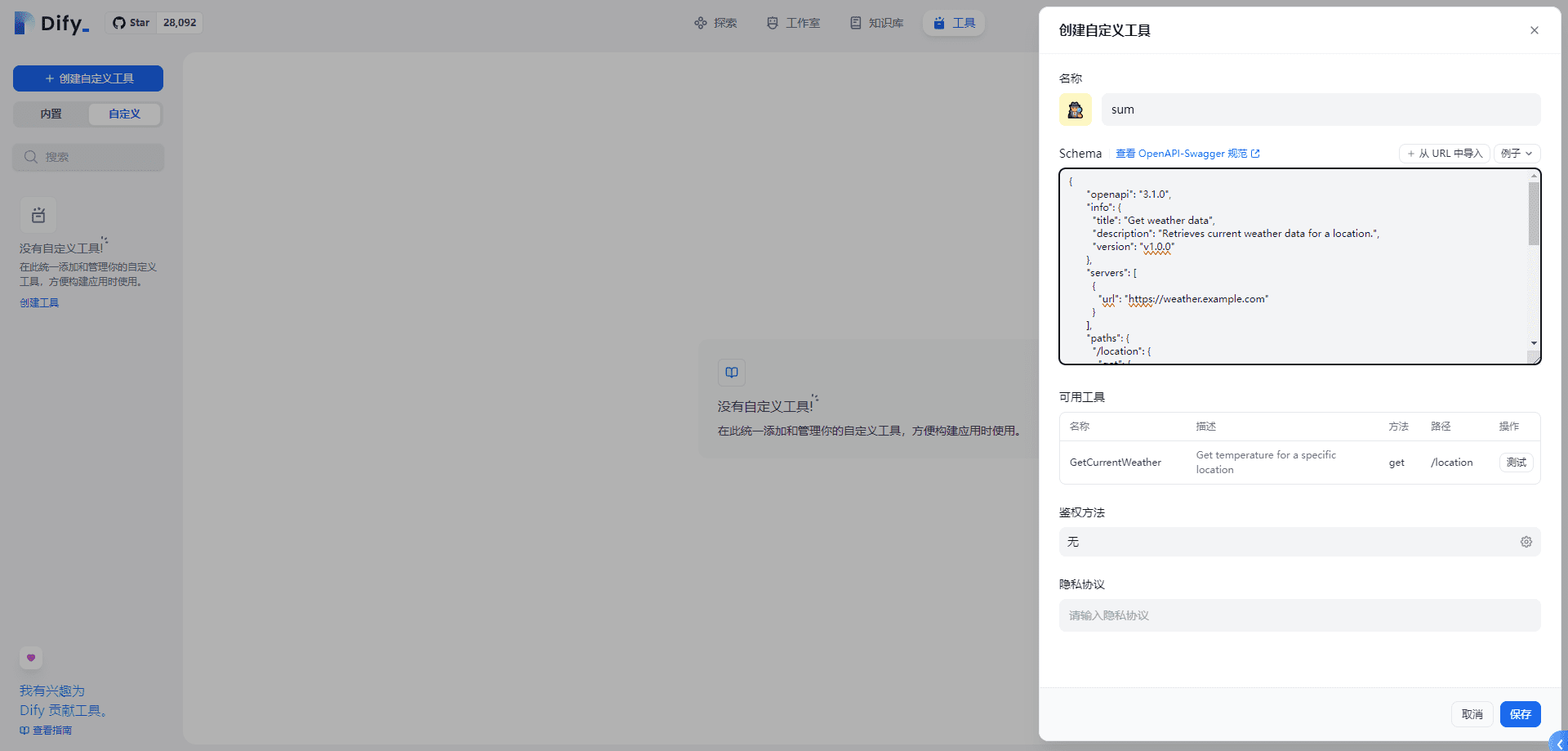

3. Conexión de DeepSeek a Dify

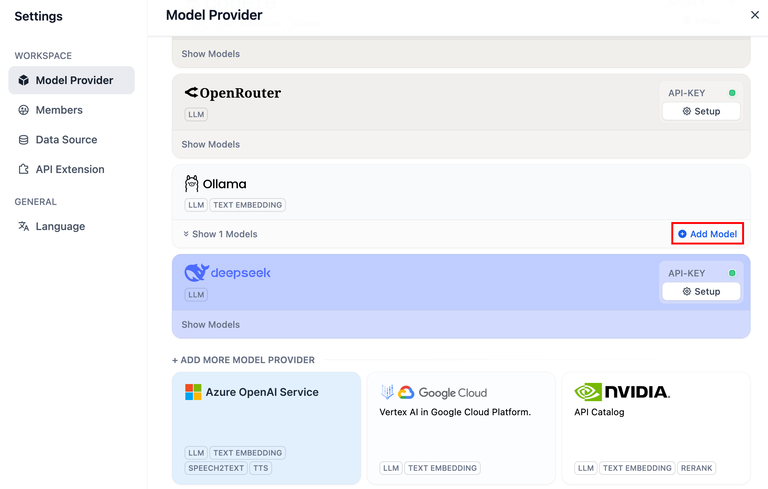

Haga clic en la esquina superior derecha de la plataforma Dify Avatar → Configuración → Proveedor de modelos. Seleccione Ollama y pulse Añadir modelo.

DeepSeek dentro del proveedor de modelos corresponde al servicio API en línea; los modelos DeepSeek desplegados localmente corresponden al cliente Ollama. Asegúrese de que el cliente Ollama ha desplegado correctamente el modelo DeepSeek, tal y como se detalla en las instrucciones de despliegue anteriores.

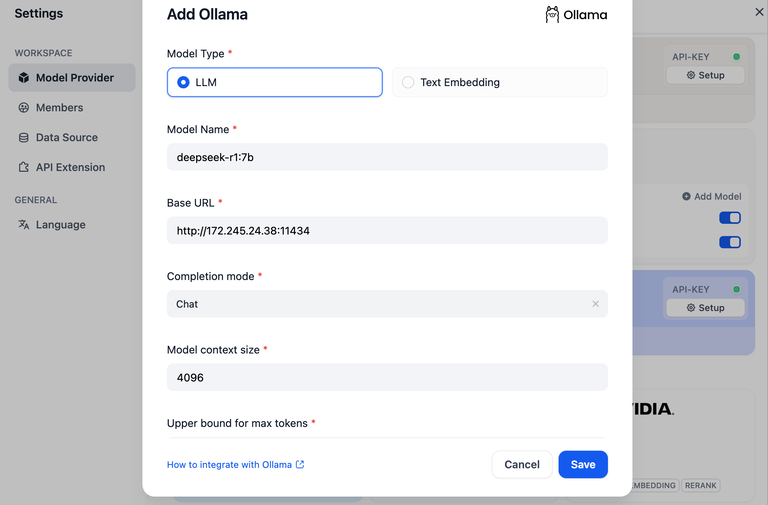

Seleccione el tipo de modelo LLM.

- Nombre del modelo, introduzca el nombre del modelo desplegado. El modelo desplegado arriba es deepseek-r1 7b, por lo tanto rellene el campo

deepseek-r1:7b - URL base, la dirección donde se ejecuta el cliente Ollama, normalmente

http://your_server_ip:11434. En caso de problemas de conexión, lea enproblemas comunes. - Las demás opciones se mantienen en sus valores por defecto. En función del Descripción del modelo DeepSeekLa longitud máxima generada es de 32.768 tokens.

Creación de aplicaciones de IA

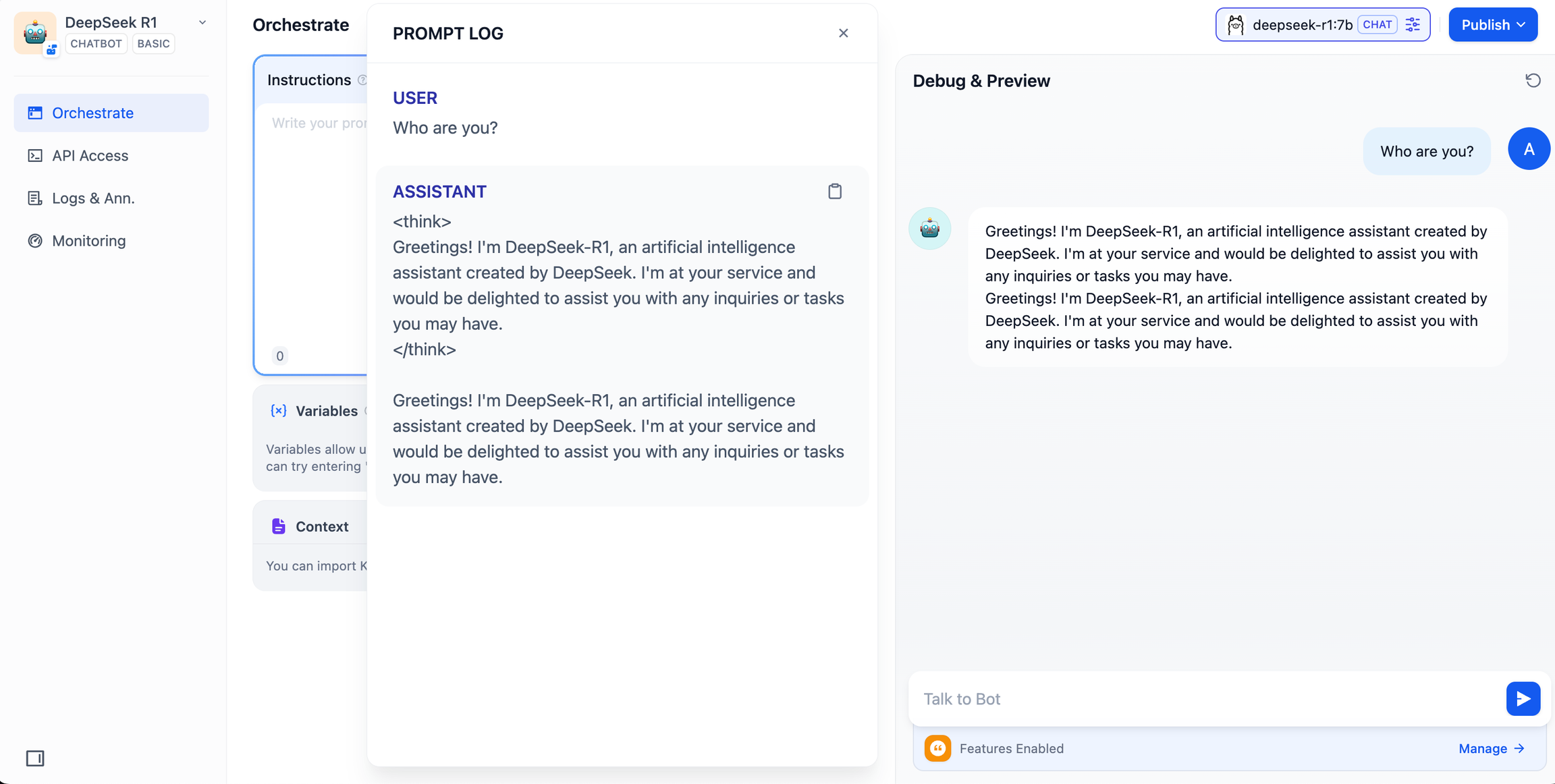

DeepSeek AI Chatbot (aplicación sencilla)

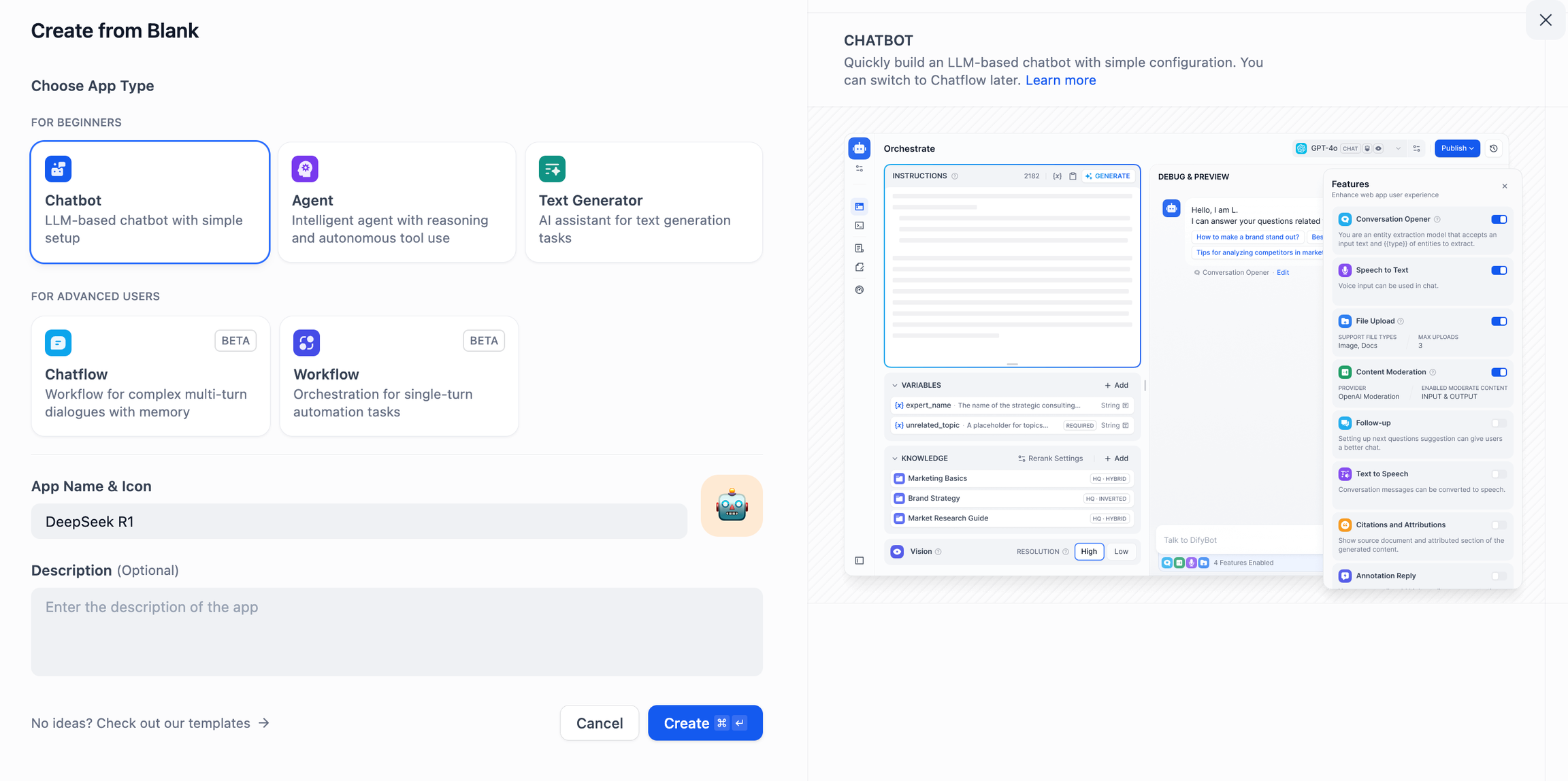

- Toca "Crear una aplicación en blanco" en el lado izquierdo de la página principal de la plataforma Dify, selecciona el tipo de aplicación "Asistente de Chat" y nómbrala simplemente.

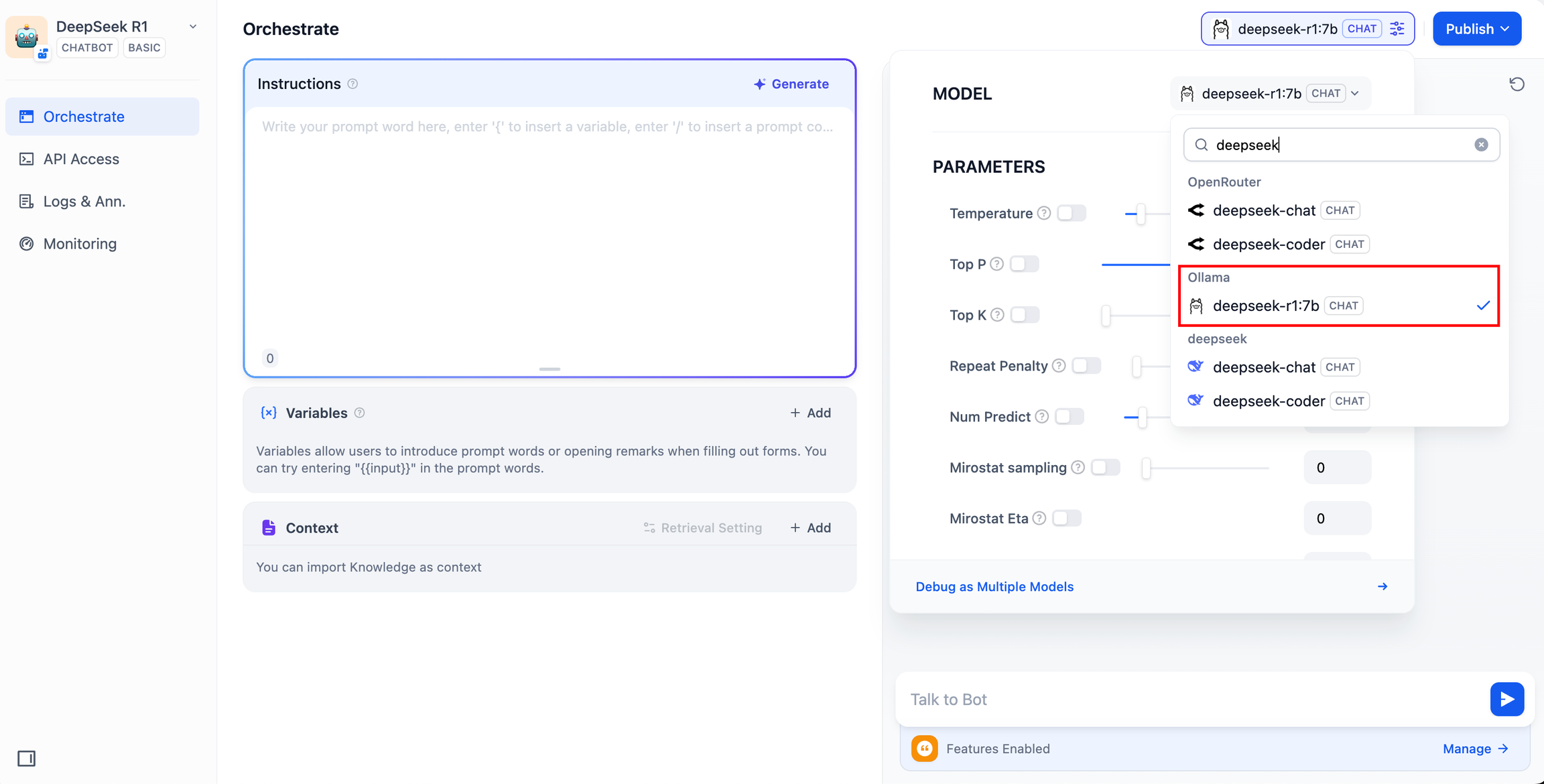

- En la esquina superior derecha, en Tipo de aplicación, seleccione el framework Ollama dentro de la sección

deepseek-r1:7bModelos.

- Compruebe que la aplicación AI funciona introduciendo contenido en el cuadro de diálogo de vista previa. La generación de una respuesta significa que la construcción de la aplicación AI se ha completado.

- Pulsa el botón Publicar en la parte superior derecha de la aplicación para obtener un enlace a la aplicación de IA y compartirla con otros o incrustarla en otro sitio web.

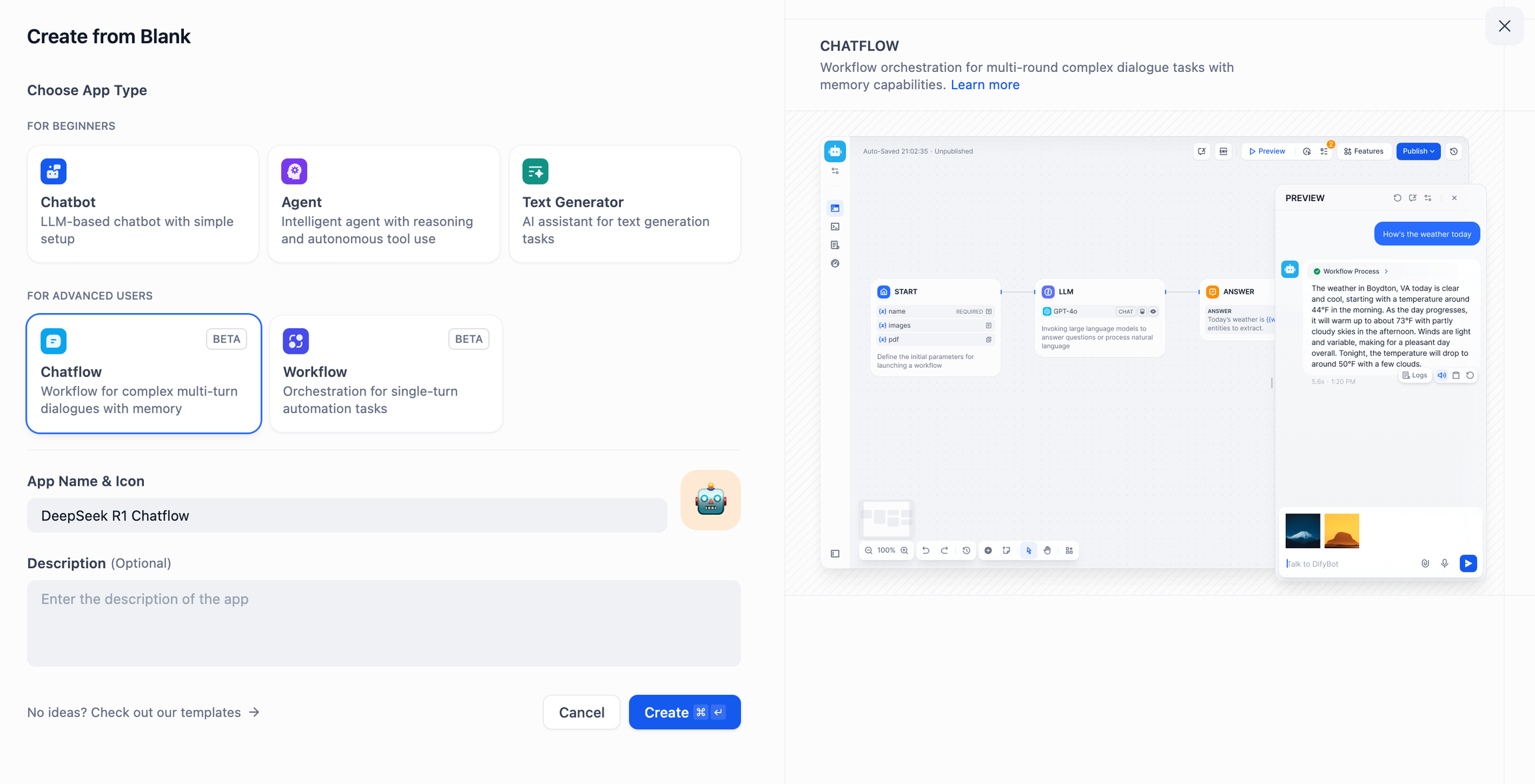

DeepSeek AI Chatflow / Workflow (aplicaciones avanzadas)

Chatflow / Flujo de trabajo Apps puede ayudarle a crear aplicaciones de IA con funcionalidades más complejas, como la capacidad de tener reconocimiento de documentos, reconocimiento de imágenes, reconocimiento de voz, etc. Para obtener instrucciones detalladas, consulteDocumentación del flujo de trabajo.

- Pulse "Crear una aplicación en blanco" en el lado izquierdo de la página principal de la plataforma Dify, seleccione una aplicación de tipo "Chatflow" o "Workflow" y nómbrela simplemente.

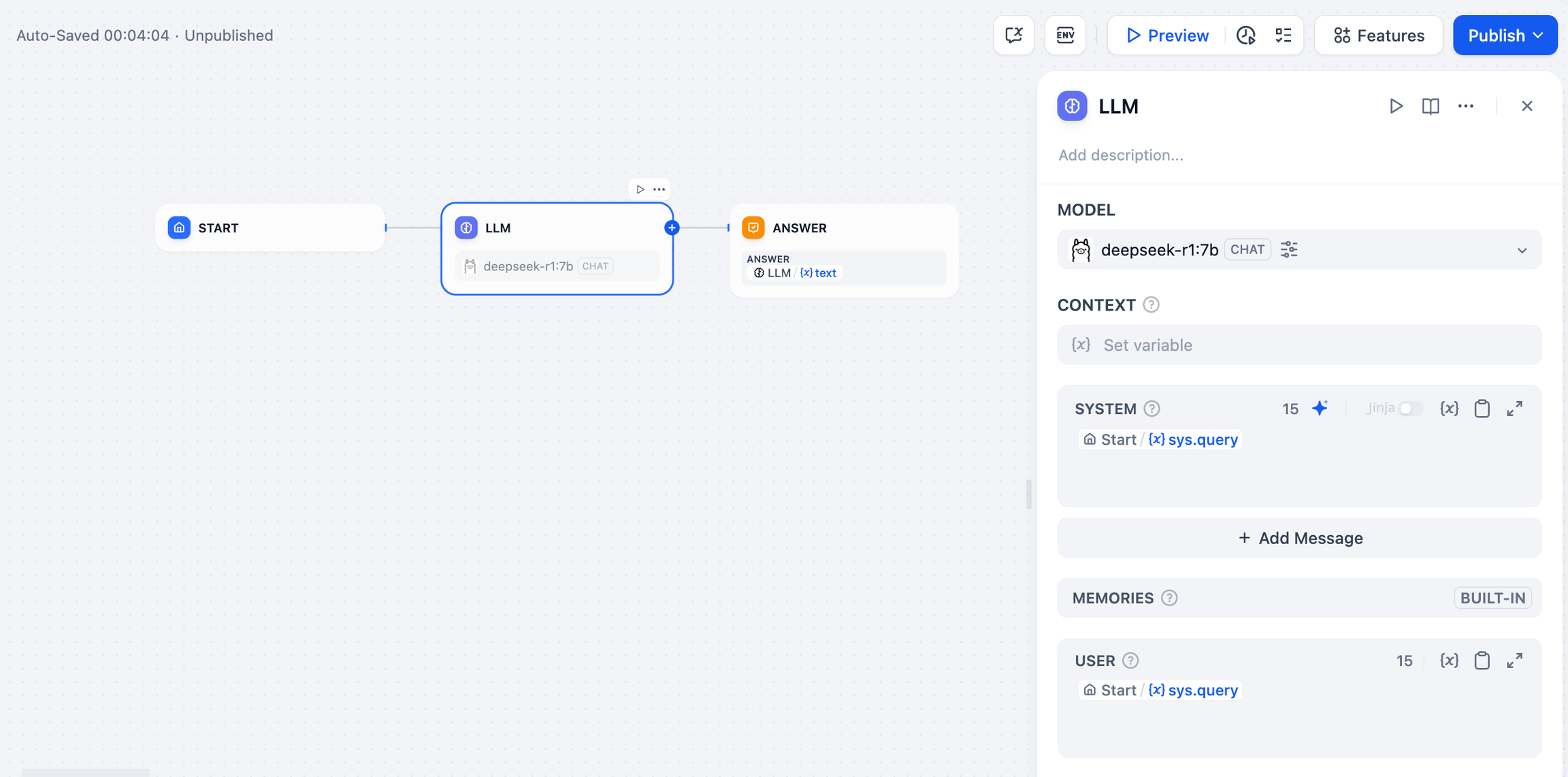

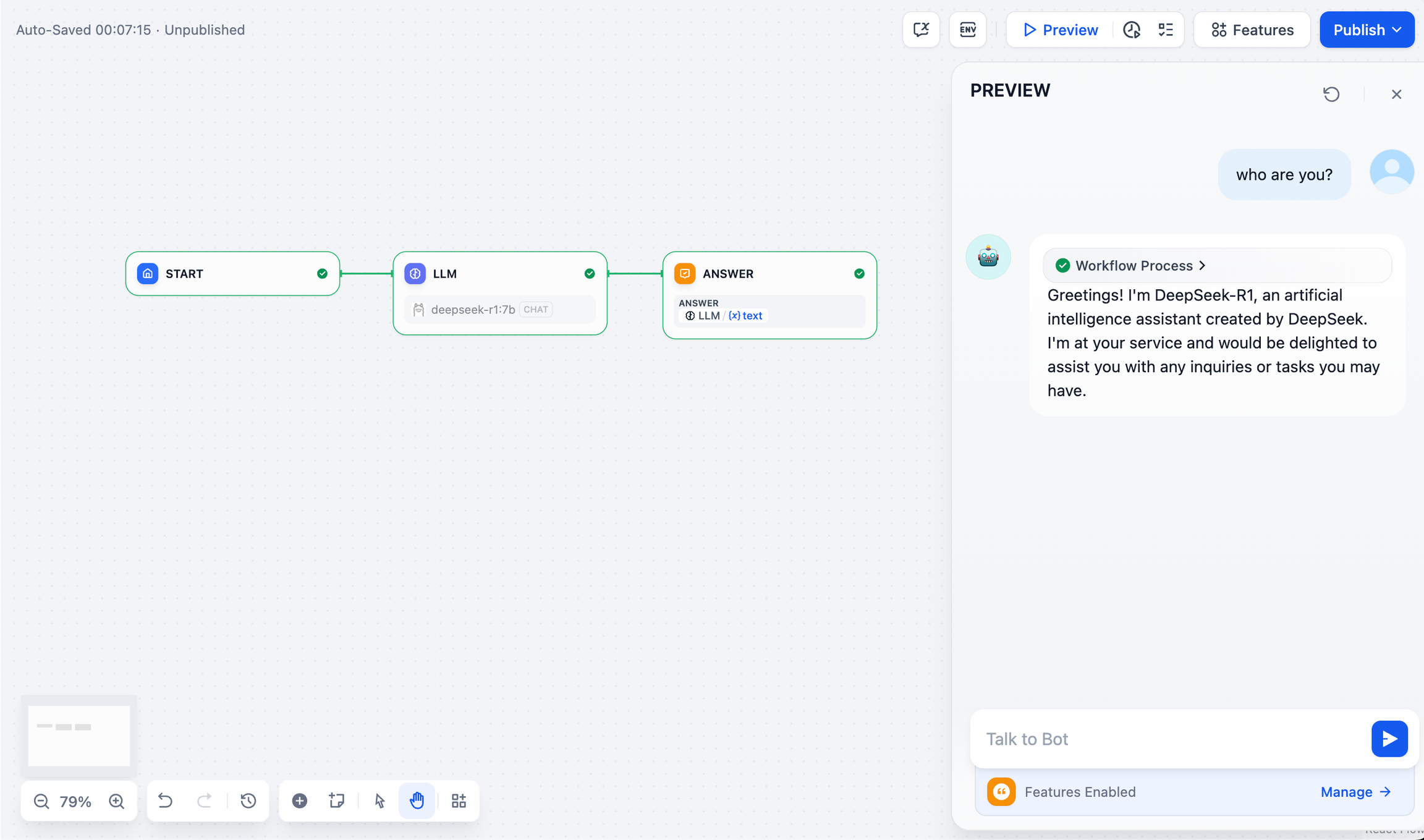

- Para añadir un nodo LLM, seleccione el marco Ollama en la sección

deepseek-r1:7by añada la palabra de aviso del sistema dentro del{{#sys.query#}}para conectar el nodo de inicio.

- Añada el nodo final para completar la configuración. Puede introducir contenido en el cuadro de vista previa para realizar pruebas. La generación de una respuesta significa que la construcción de la aplicación AI está completa.

problemas comunes

1. Errores de conexión durante el despliegue de Docker

Los siguientes errores pueden ser encontrados al desplegar Dify y Ollama con Docker:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

Causa del error Este error se produce porque el servicio Ollama no está accesible en el contenedor Docker. localhost suele apuntar al propio contenedor, no al host o a otro contenedor. Para resolver este problema, debe exponer el servicio Ollama a la red.

Método de configuración del entorno macOS:

Si Ollama se ejecuta como una aplicación de macOS, es necesario establecer las variables de entorno mediante launchctl:

- Esto se consigue llamando a la función

launchctl setenvConfiguración de variables de entorno:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Reinicie la aplicación Ollama.

- Si los pasos anteriores no funcionan, puede utilizar el siguiente método:

El problema es que dentro de docker, debe conectarse a la host.docker.internalpara acceder al host del docker, así que configure la directiva localhost Sustituir por host.docker.internal El servicio está listo para entrar en vigor:

http://host.docker.internal:11434

Método de configuración del entorno Linux:

Si Ollama se ejecuta como un servicio systemd, debe utilizar el comando systemctl Configuración de variables de entorno:

- Esto se consigue llamando a la función

systemctl edit ollama.serviceEdita el servicio systemd. Esto abrirá un editor. - Para cada variable de entorno, el

[Service]Añada una línea debajo de la secciónEnvironment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- Guardar y salir.

- carga pesada (en un camión)

systemdy reiniciar Ollama:

systemctldaemon-reload

systemctlrestartollama

Método de configuración del entorno Windows:

En Windows, Ollama hereda las variables de entorno del usuario y del sistema.

- En primer lugar, haga clic en Ollama en la barra de tareas para salir del programa.

- Editar las variables de entorno del sistema desde el panel de control

- Edite o cree nuevas variables para su cuenta de usuario, tales como

OLLAMA_HOSTyOLLAMA_MODELSetc. - Haga clic en OK / Aplicar para guardar

- Ejecutar en una nueva ventana de terminal

ollama

2. ¿Cómo puedo cambiar la dirección y el número de puerto del servicio Ollama?

Ollama Encuadernación por defecto 127.0.0.1 puerto 11434, al que puede acceder a través de la dirección OLLAMA_HOST Las variables de entorno modifican la dirección de enlace.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...