Una mirada en profundidad a Titanes: el camino hacia la convergencia de la memoria a largo plazo y la modelización eficiente de secuencias

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 38.1K 00

Titanes: Aprender a memorizar a la hora del examen Original: https://arxiv.org/pdf/2501.00663v1

Titans Architecture Aplicación no oficial: https://github.com/lucidrains/titans-pytorch

Uno, Antecedentes y motivación: las limitaciones del transformador y la inspiración de la memoria humana

1. Limitaciones de Transformer: un cuello de botella en el tratamiento de secuencias largas

Transformador Desde su introducción, el modelo ha podido contribuir de forma significativa al desarrollo del modelo gracias a su potenteMecanismo de autoatenciónque ha supuesto un avance revolucionario en áreas como el procesamiento del lenguaje natural y la visión por ordenador. Sin embargo, a medida que aumenta la complejidad de la tarea, Transformer expone gradualmente algunos problemas críticos cuando se trata de secuencias largas:

- La alta complejidad computacional limita la escalabilidad del modelo :.

- El mecanismo de autoatención requiere el cálculo de cada ficha similitud con todas las demás fichas de la secuencia, con una complejidad temporal y espacial de O(N²)que N es la longitud de la secuencia.

- Esto significa que el cálculo y el consumo de memoria crecen en pasos cuadrados cuando aumenta la longitud de la secuencia, lo que limita gravemente la capacidad del modelo para manejar secuencias largas; por ejemplo, Transformer suele estar fuera de su alcance cuando se enfrenta a tareas como textos largos, comprensión de vídeos o predicción de series temporales a largo plazo.

Figura 1: Proceso de cálculo del mecanismo de autoatención.

- Ventana contextual limitada para captar las dependencias a larga distancia :.

- Para aliviar la carga computacional, los Transformers suelen utilizar una ventana contextual de longitud fija (por ejemplo, 512 o 1024), lo que significa que el modelo sólo puede centrarse en la información dentro de la ventana actual.

- Sin embargo, muchas tareas del mundo real requieren modelos capaces de captar dependencias en escalas temporales más largas, como la comprensión de información contextual en textos o diálogos largos, la integración de información de distintos momentos en vídeos y la realización de predicciones utilizando tendencias y patrones a largo plazo en datos históricos.

2. El compromiso del transformador lineal: eficiencia frente a rendimiento

Para resolver el cuello de botella computacional de Transformer, los investigadores propusieron elTransformador linealLas principales mejoras son:

- Sustitución de softmax por una función kernel. La sustitución del cálculo softmax en el mecanismo de autoatención por una función kernel reduce la complejidad computacional a O(N).

- Razonamiento paralelizable. El proceso computacional del Transformador Lineal puede representarse como una forma cíclica, lo que permite un razonamiento más eficiente.

Sin embargo, el transformador lineal también tiene algunas limitaciones:

- Degradación del rendimiento.

- El truco del núcleo degrada el modelo a una red recurrente lineal en la que los datos se comprimen en un estado de valor matricial, lo que da como resultado un rendimiento inferior al del Transformer estándar.

- Este tipo de compresión es difícil de captar eficazmente las dependencias no lineales complejas.

- Problemas de gestión de memoria.

- El transformador lineal comprime los datos históricos en una matriz de tamaño fijo, pero cuando se trata de contextos muy largos, esta compresión da lugar a undesbordamiento de memoriaque afecta al rendimiento del modelo.

Figura 2: Proceso de actualización de la memoria del transformador lineal.

3. Inspiración del sistema de memoria humano: creación de mecanismos más sólidos para la memoria a largo plazo

Para superar estos retos, los autores empezaron porsistema de memoria humanaInspirándose en la

- La relación entre memoria y aprendizaje: la

- La tesis se basa en las definiciones de memoria y aprendizaje de la literatura neuropsicológica, considerando la memoria como una actualización neuronal inducida por un input, y definiendo el aprendizaje como el proceso de adquisición de recuerdos eficaces y útiles dado un objetivo.

- Esto significa queEl aprendizaje eficaz no puede lograrse sin un mecanismo de memoria sólido.

- La naturaleza multinivel de la memoria humana: la

- El sistema de memoria humano no es una estructura única, sino que consta de múltiples subsistemas, como la memoria a corto plazo, la memoria de trabajo y la memoria a largo plazo, cada uno de los cuales tiene funciones y estructuras organizativas diferentes y es capaz de operar de forma independiente.

- Esta naturaleza multicapa permite a los seres humanos almacenar, recuperar y gestionar la información con eficacia.

- Deficiencias de los modelos existentes.

- Las arquitecturas de redes neuronales existentes (desde las redes de Hopfield hasta las LSTM y las Transformers) tienen dificultades para manejar la generalización, la extrapolación de longitudes y la inferencia, capacidades que son críticas para muchas tareas complejas del mundo real.

- Estas arquitecturas, aunque se inspiraban en el cerebro humano, carecían de la capacidad dememoria efímeramodelización eficaz de laNaturaleza multinivel del sistema de memoriaLa simulación.

Dos, Innovación central: módulo de memoria neuronal a largo plazo y arquitectura de titanes

A partir de estas reflexiones, los autores proponen las siguientes innovaciones:

1. Módulo de memoria neuronal a largo plazo

(1) Concepto de diseño.

- Mecanismos de aprendizaje metacontextual.

- El módulo está diseñado como unmetamodelo, aprendiendo a memorizar/almacenar datos en sus parámetros durante las pruebas.

- este tipo deAprendizaje en líneapermite al modelo adaptar dinámicamente su memoria a la entrada actual, en lugar de basarse en memorias fijadas durante el preentrenamiento.

- Actualización de la memoria por sorpresa : La

- Los autores se basan en el mecanismo de la memoria humana según el cual "los acontecimientos sorprendentes tienen más probabilidades de ser recordados", y proponen un método basado engrado de sorpresaEl mecanismo de actualización de la memoria.

- grado de sorpresaCalculando la red neuronal en relación con la entradagradientepara medir, cuanto mayor sea el gradiente, más se diferencian los datos de entrada de los históricos y más dignos de ser recordados.

- Este método es eficaz para captar la información clave de los datos y almacenarla en la memoria a largo plazo.

- En cambio, el transformador lineal sólo puede realizar transformaciones lineales basadas en los datos de entrada actuales, lo que dificulta la captura eficaz de las dependencias de largo alcance.

Figura 3: Mecanismo de actualización de memoria basado en la sorpresa.

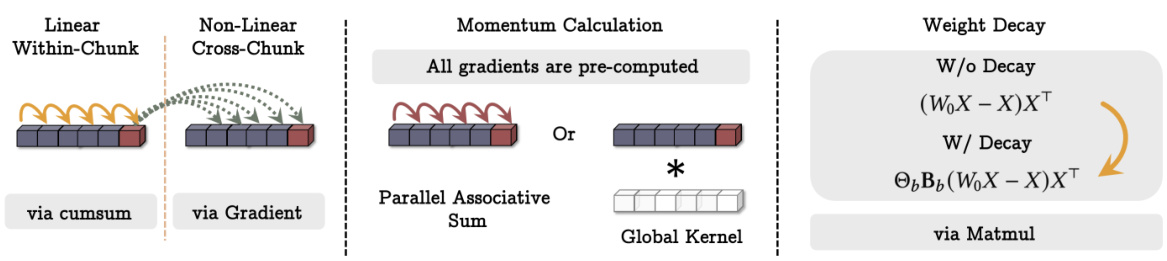

(2) Tecnologías clave.

- Mecanismos de impulso.

- Para evitar que el modelo se vea influido en exceso por un único acontecimiento sorprendente, los autores introdujeron la variablemecanismo de impulsoteniendo en cuenta la sorpresa de momentos pasados.

- Esto significa que el modelo tiene en cuenta la sorpresa tanto de las entradas actuales como de las históricas, lo que conduce a actualizaciones de memoria más suaves.

- Mecanismos de atenuación.

- Para evitar el desbordamiento de memoria, los autores también introdujeron la funciónmecanismo de desintegraciónMediante eldisminución de pesoforma de olvidar gradualmente la información sin importancia.

- El mecanismo puede verse como unmecanismo de compuertaque puede borrar selectivamente las memorias según sea necesario.

- Los autores señalan que este mecanismo de decaimiento es una generalización del mecanismo de olvido en los modelos recurrentes modernos y es equivalente a la optimización de redes metaneuronales bajo descenso de gradiente de pequeños lotes, impulso y decaimiento de peso.

(3) Estructuras de memoria.

- En contraste con el modelo tradicional de memoria lineal, los autores utilizaron unPerceptrón multicapa (MLP) como módulo de memoria.

- MLP tiene una representación no lineal más fuerte y puede almacenar y recuperar información compleja de forma más eficiente.

- En cambio, los Transformadores lineales sólo pueden utilizar estados con valores matriciales para almacenar información, lo que dificulta la captura de relaciones no lineales complejas.

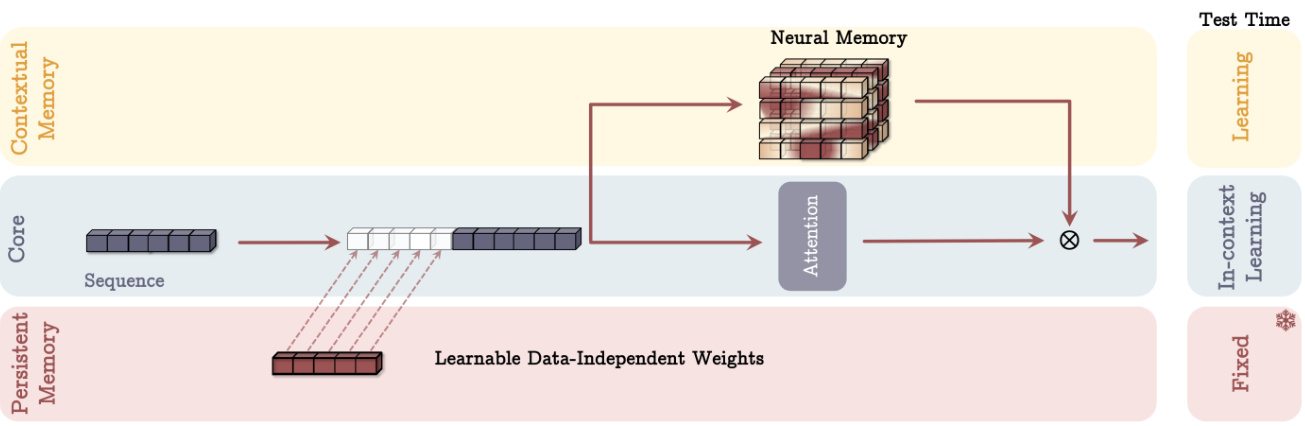

2. Arquitectura de titanes: integración de la memoria a largo y corto plazo

Tras diseñar el módulo de memoria neuronal a largo plazo, los autores siguieron pensando en cómo integrarlo eficazmente en una arquitectura de aprendizaje profundo y propusieron la arquitectura Titans con las siguientes características clave:

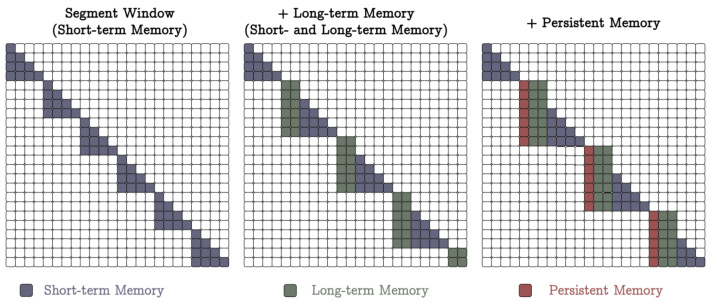

(1) Tres supercabezas trabajando en tándem.

- Núcleo.

- Constituida por la memoria a corto plazo, es responsable del proceso principal de tratamiento de datos.

- utilizarMecanismos de atención para ventanas de tamaño finitocomo la Atención en Ventana Deslizante (SWA) o la Atención Plenamente Conectada (FCA).

- La memoria a corto plazo puede considerarse comomemoria a corto plazoque se utiliza para capturar las dependencias en el contexto actual.

- Memoria a largo plazo.

- Responsable de almacenar/recordar información del pasado remoto.

- Se utiliza el módulo de memoria neural a largo plazo descrito anteriormente.

- La memoria a largo plazo puede considerarse comomemoria efímeraque se utiliza para almacenar y recuperar información a largo plazo.

- Memoria persistente.

- es un conjunto de parámetros aprendibles pero independientes de los datos que codifican el conocimiento a priori sobre la tarea.

- Similar a los parámetros de la capa totalmente conectada en Transformer, pero con una funcionalidad diferente.

- La memoria persistente puede considerarse comometamemoriaque se utiliza para almacenar conocimientos relacionados con la tarea, como reglas gramaticales, conocimientos de sentido común, etc.

Figura 4: Diagrama esquemático de la arquitectura de los Titanes (variante MAC).

(2) Tres tipos diferentes de integración.

- La memoria como contexto (MAC).

- Conectar memorias largas y persistentes a secuencias de entrada como información adicional al contexto actual.

- Los mecanismos atencionales determinan qué información debe almacenarse en la memoria a largo plazo.

- En el momento de la prueba, los parámetros de memoria persistente se mantuvieron fijos y el módulo de atención se ponderó para el aprendizaje contextual, mientras que el módulo de memoria a largo plazo siguió aprendiendo/recordando información.

- Este diseño permite al modelo utilizar con flexibilidad la información de la memoria a largo plazo en función de la entrada actual.

- La memoria como puerta (MAG).

- Utilización de la atención de ventana deslizante como memoria a corto plazo y de módulos de memoria neuronal como memoria a largo plazo.

- Combinación de ambos mediante mecanismos de compuerta, por ejemplo, normalizando los dos mediante pesos vectoriales aprendibles y aplicando a continuación una función de activación no lineal.

- Este diseño puede considerarse una arquitectura multicabezal en la que los distintos cabezales se estructuran de forma diferente.

Figura 5: Diferentes variantes de la arquitectura de Titanes (MAC y MAG). - Memoria como capa (MAL).

- El uso del módulo de memoria neuronal como capa de una red neuronal profunda comprime la información contextual pasada y presente antes que el módulo de atención.

- Este diseño es el más común en la literatura, por ejemplo el modelo H3.

(3) Puntos fuertes.

- Gestión de memoria más flexible.

- Al utilizar los módulos de memoria como ramas contextuales o activadas, la arquitectura de los Titanes es capaz de utilizar dinámicamente la información de la memoria a largo plazo en función de la entrada actual.

- Esto proporciona más flexibilidad que el enfoque tradicional de utilizar módulos de memoria como capas.

- Expresión más fuerte.

- La sinergia de las tres supercabezas permite a la arquitectura de los Titanes procesar datos secuenciales largos con mayor eficacia e integrar las ventajas de la memoria a corto plazo, la memoria a largo plazo y la memoria persistente.

- Escalabilidad.

- En comparación con Transformer, la arquitectura Titans presenta una mejor escalabilidad cuando se trata de secuencias largas y es capaz de mantener un alto rendimiento en una ventana de contexto más amplia.

Tres, Resultados y análisis experimentales: validación de la arquitectura de los Titanes

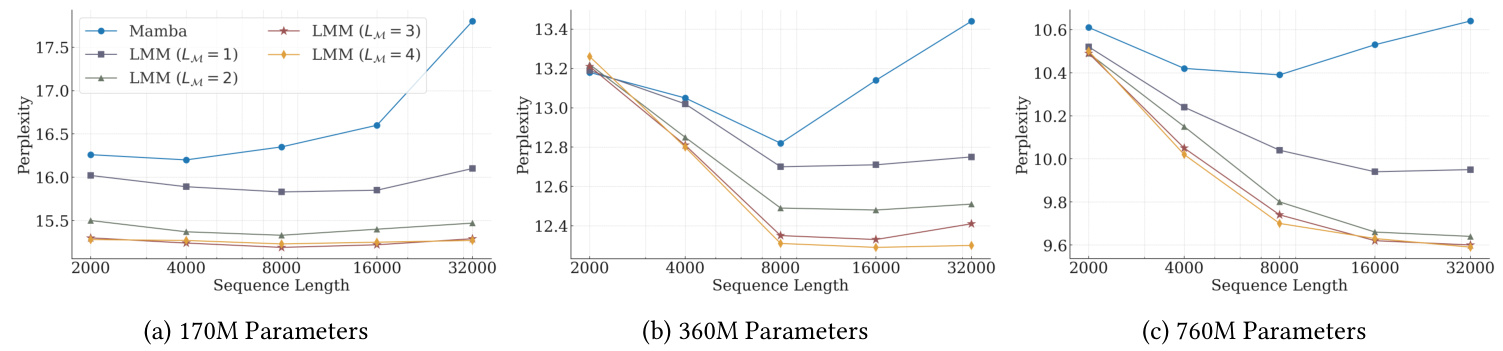

Los autores realizaron amplios experimentos con varias tareas para evaluar el rendimiento de la arquitectura Titans y sus variantes:

1. Modelización lingüística y razonamiento de sentido común.

- Montaje experimental.

- Se utilizaron tres modelos de Titanes de diferentes tamaños (340M, 400M, 760M parámetros), así como varios modelos de referencia, incluidos Transformer++, RetNet, GLA, Mamba, Mamba2, DeltaNet, TTT y Gated DeltaNet.

- Como datos de entrenamiento se utilizó el conjunto de datos FineWeb-Edu.

- Principales resultados.

- En el modelo no mixto, el módulo de memoria neuronal a largo plazo obtuvo el mejor rendimiento tanto en la métrica de perplejidad como en la de precisión.

- Las tres variantes de Titans (MAC, MAG, MAL) superaron a Samba (Mamba + atención) y Gated DeltaNet-H2 (Gated DeltaNet + atención).

- MAC obtiene mejores resultados cuando se trata de dependencias de largo alcance, mientras que tanto MAG como MAC superan a la variante MAL.

Figura 6: Comparación del rendimiento de los Titanes con el modelo de referencia en las tareas de modelización del lenguaje y razonamiento basado en el sentido común.

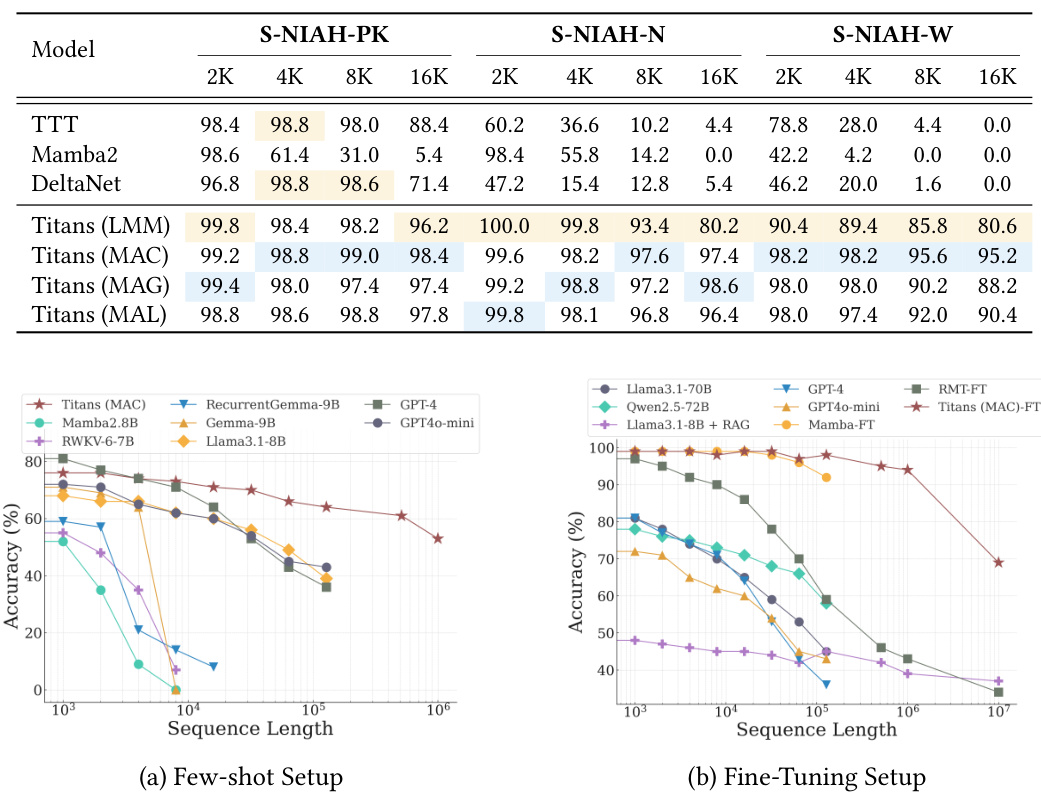

2. Misión "Aguja en el pajar".

- Montaje experimental.

- Utilizando la tarea Single NIAH (S-NIAH) de la evaluación comparativa RULER, se evaluó la capacidad de recuperación del modelo en secuencias de 2K, 4K, 8K y 16K de longitud.

- Principales resultados.

- El módulo de memoria neuronal a largo plazo obtuvo los mejores resultados en las tres tareas.

- Las variantes Titans también obtuvieron buenos resultados, siendo la variante MAC la que obtuvo mejores resultados.

3. Evaluación comparativa de BABILong.

- Montaje experimental.

- La tarea requiere que el modelo razone sobre información factual distribuida en documentos extremadamente largos.

- Hay ajustes de menos muestras y de ajuste fino.

- Principales resultados.

- En la configuración de menos muestras, Titans supera a todas las líneas de base, incluidos los modelos con mayor número de parámetros, como GPT-4 y GPT4o-mini.

- Titans también supera a todos los modelos en ajustes finos, incluso a modelos muy grandes como GPT-4.

- En comparación con los modelos de memoria basados en transformadores (RMT), los Titanes presentan un mejor rendimiento, debido principalmente a su gran capacidad de memoria.

Figura 7: Comparación del rendimiento de Titans con el modelo básico en la prueba de referencia BABILong.

4. Previsión de series temporales.

- Montaje experimental.

- Utilizando el marco Simba, el módulo Mamba se sustituyó por un módulo neural de memoria a largo plazo.

- Evaluado en conjuntos de datos de referencia ETT, ECL, Traffic y Weather.

- Principales resultados.

- El módulo de memoria neuronal a largo plazo supera todas las líneas de base, incluidas las arquitecturas Mamba, Linear Model y Transformer.

5. Modelización del ADN.

- Montaje experimental.

- Evaluar el rendimiento de los modelos preentrenados en tareas posteriores en GenomicsBenchmarks.

- Principales resultados.

- Titans (LMM) es competitivo en diferentes tareas genómicas posteriores y está a la altura de los métodos más avanzados.

6. Análisis de eficiencia.

- Principales resultados.

- El módulo de memoria neuronal a largo plazo es ligeramente más lento de entrenar en comparación con otros modelos recurrentes, debido principalmente a su memoria más profunda y a un proceso de transformación más complejo, así como al núcleo altamente optimizado implementado en Mamba2.

- Titans (MAL) es más rápido que la línea de base, así como el módulo de memoria, debido principalmente al uso del núcleo altamente optimizado de FlashAttention.

7. Estudios de ablación.

- Principales resultados.

- Todos los componentes del diseño de la memoria neuronal contribuyen positivamente al rendimiento, siendo el decaimiento del peso, el impulso, la convolución y la memoria persistente los que más contribuyen.

- El diseño arquitectónico también tiene un impacto significativo en el rendimiento, ya que MAC y MAG obtienen resultados muy parecidos en las tareas de modelado del lenguaje y razonamiento basado en el sentido común, mientras que MAC obtiene mejores resultados en las tareas de contexto largo.

Cuatro, Puntos innovadores y puntos fuertes de la tesis

- Se propone un novedoso módulo neural de memoria a largo plazo: el

- Se basa en elementos clave de los mecanismos de la memoria humana, como la sorpresa, el impulso y el olvido, para lograr una actualización y almacenamiento de la memoria más eficaces.

- Se utiliza una red neuronal profunda como módulo de memoria para dotar al modelo de una mayor capacidad expresiva.

- La arquitectura de los Titanes se diseñó para combinar la memoria a largo y a corto plazo.

- Se proponen tres enfoques de integración diferentes, que ofrecen opciones flexibles para distintos escenarios de aplicación.

- La sinergia de las tres supercabezas, Núcleo, Memoria a Largo Plazo y Memoria Persistente, permite al modelo procesar datos secuenciales largos con mayor eficacia.

- Sobresale en múltiples tareas.

- Ya sea para el modelado del lenguaje, el razonamiento basado en el sentido común, la predicción de series temporales o el modelado del ADN, la arquitectura Titans demuestra un gran rendimiento que supera a los modelos Transformer y de bucle lineal existentes.

- Escalable.

- La capacidad de mantener un alto rendimiento en una ventana de contexto más amplia abre la posibilidad de procesar secuencias muy largas.

Cinco, perspectivas de futuro

Aunque la arquitectura de los Titanes ha dado resultados impresionantes en varios frentes, aún quedan las siguientes direcciones que merecen una mayor exploración.

- Exploración de arquitecturas de módulos de memoria más complejas: la

- Por ejemplo, introduciendo estructuras de memoria jerárquicas o combinando módulos de memoria con otros modelos como las redes neuronales gráficas.

- Desarrollo de mecanismos más eficaces de actualización y almacenamiento de la memoria.

- Por ejemplo, se utilizan técnicas de sparsificación o de cuantificación para reducir el consumo de memoria y los costes computacionales.

- Aplicar la arquitectura de los Titanes a una gama más amplia de ámbitos.

- Algunos ejemplos son la comprensión de vídeos, el control de robots, los sistemas de recomendación, etc.

- Explorar estrategias de formación más eficaces.

- Por ejemplo, introduciendo algoritmos de optimización más avanzados o utilizando el metaaprendizaje para acelerar la formación de modelos.

- Investigando la interpretabilidad de la arquitectura de los Titanes.

- Una comprensión más profunda de cómo los titanes almacenan y utilizan la información de la memoria a largo plazo podría aportar nuevas ideas para construir sistemas de IA más potentes.

Seis, resúmenes

La contribución central de este documento es:

- Se propone un nuevo módulo neural de memoria a largo plazoEl diseño se inspira en el sistema de memoria humano e incorpora conceptos clave del aprendizaje profundo, como el descenso de gradiente, el impulso y el decaimiento del peso.

- Construyó la arquitectura de los Titanesque combina orgánicamente la memoria a largo y a corto plazo, y explora tres métodos de integración diferentes, que ofrecen opciones flexibles para distintos escenarios de aplicación.

- El rendimiento superior de Titans se ha verificado mediante rigurosos experimentos.que funciona bien en múltiples tareas, especialmente cuando se trata de tareas de contexto largo, demostrando una gran escalabilidad y una mayor precisión.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...