n8n Self-hosted AI Starter Kit: una plantilla de código abierto para crear rápidamente un entorno local de IA

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 77.9K 00

Introducción general

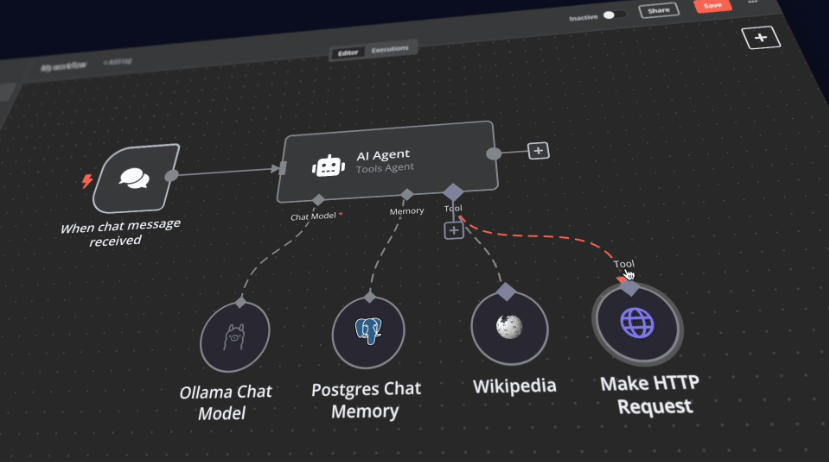

El n8n Self-Hosted AI Starter Kit es una plantilla Docker Compose de código abierto diseñada para inicializar rápidamente un completo entorno local de IA y desarrollo de bajo código. Creado por el equipo de n8n, el paquete combina la plataforma autoalojada n8n con una gama de productos y componentes de IA compatibles para ayudar a los usuarios a crear rápidamente flujos de trabajo de IA autoalojados. La suite incluye la plataforma de bajo código n8n, la plataforma LLM multiplataforma Ollama, almacenamiento vectorial de alto rendimiento Qdrant y una base de datos PostgreSQL para una variedad de escenarios de aplicación de IA como agentes inteligentes, resumen de documentos, chatbots inteligentes y análisis de documentos financieros privados.

Lista de funciones

- n8n plataforma de bajo códigoMás de 400 componentes de IA integrados y avanzados para facilitar la creación rápida de flujos de trabajo.

- Plataforma Ollama: Plataforma LLM multiplataforma con soporte para instalar y ejecutar el LLM nativo más reciente.

- Almacenamiento vectorial Qdrant: Almacenamiento vectorial de alto rendimiento de código abierto con una API completa.

- Base de datos PostgreSQL: Base de datos fiable para manejar grandes cantidades de datos.

- Agentes inteligentes: Agentes de IA para programar reuniones y tareas.

- resumen del documento: Resuma de forma segura los documentos PDF de la empresa y evite la fuga de datos.

- Chatbots inteligentes: Bots inteligentes de Slack que mejoran las comunicaciones de la empresa y las operaciones de TI.

- Análisis de documentos financieros privadosAnálisis privado de documentos financieros al menor coste posible.

Utilizar la ayuda

Proceso de instalación

- almacén de clones::

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

- Ejecución de n8n con Docker Compose::

- Para usuarios de GPU Nvidia:

docker compose --profile gpu-nvidia upNota: Si no has utilizado antes una GPU Nvidia con Docker, sigue las instrucciones de Ollama Docker.

- Para usuarios de Mac/Apple Silicon:

- Opción 1: Se ejecuta íntegramente en la CPU:

docker compose --profile cpu up - Opción 2: Ejecute Ollama en su Mac y conéctese a la instancia n8n:

docker compose upA continuación, cambie las credenciales de Ollama, utilizando

http://host.docker.internal:11434/Como anfitrión.

- Opción 1: Se ejecuta íntegramente en la CPU:

- Para otros usuarios:

docker compose --profile cpu up

- Para usuarios de GPU Nvidia:

Normas de uso

- Inicio n8n::

- entrevistas

http://localhost:5678entra en la interfaz n8n. - Inicia sesión con tu cuenta predeterminada o crea una nueva.

- entrevistas

- Creación de flujos de trabajo::

- En la interfaz del n8n, haga clic en "Nuevo flujo de trabajo".

- Arrastre el nodo deseado del menú de la izquierda al área de trabajo.

- Configure los parámetros y las conexiones de cada nodo.

- Ejecución de flujos de trabajo::

- Una vez completada la configuración, haga clic en el botón Ejecutar para ejecutar el flujo de trabajo.

- Ver los resultados y registros de la ejecución del flujo de trabajo.

Inicio y uso rápidos

En el corazón del Self-Hosted AI Starter Kit hay un archivo Docker Compose con ajustes de red y almacenamiento preconfigurados, lo que reduce la necesidad de instalaciones adicionales. Una vez completados los pasos de instalación, solo tiene que seguir los pasos que se indican a continuación para empezar:

- Abra http://localhost:5678/设置n8n. Esta operación sólo debe realizarse una vez.

- Abra el flujo de trabajo incluido: http://localhost:5678/workflow/srOnR8PAY3u4RSwb.

- opciónFlujo de trabajo de pruebasComience a ejecutar el flujo de trabajo.

- Si es la primera vez que ejecuta este flujo de trabajo, es posible que tenga que esperar hasta que se complete la descarga de Llama 3.2 en Ollama. Puede comprobar el progreso en los registros de la consola Docker.

No dude en hacerlo visitando http://localhost:5678/来打开n8n.

Con su instancia n8n, tendrá acceso a más de 400 integraciones, así como a un conjunto de nodos de IA básicos y avanzados, como los nodos de agente de IA, clasificador de texto y extractor de información. Asegúrese de que el tiempo de ejecución local utiliza el nodo Ollama como modelo de lenguaje y Qdrant como almacén de vectores.

"tenga en cuentaEste kit de inicio está diseñado para ayudarle a empezar con flujos de trabajo de IA autoalojados. Aunque no está totalmente optimizado para entornos de producción, combina potentes componentes que colaboran a la perfección, lo que lo hace ideal para proyectos de prueba de concepto. Puede personalizarlo para adaptarlo a sus necesidades.

"

Instrucciones de actualización

Para la configuración de la GPU Nvidia:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

Para usuarios de Mac / Apple Silicon

docker compose pull

docker compose create && docker compose up

Para configuraciones sin GPU:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...