¿Cómo crear un chatbot con el tutorial de la función Chatbox de DeepSeek?

Conocimientos básicos y preparación de las funciones de Chatbox

La funcionalidad Chatbox proporcionada por la plataforma DeepSeek es esencialmente un sistema de llamada a la interfaz API, donde el usuario necesita interactuar con el modelo a través de la API. Antes de crear un chatbot es necesario realizar un trabajo de preparación:

- Despliegue local de OllanaVer tutorial detallado a continuación

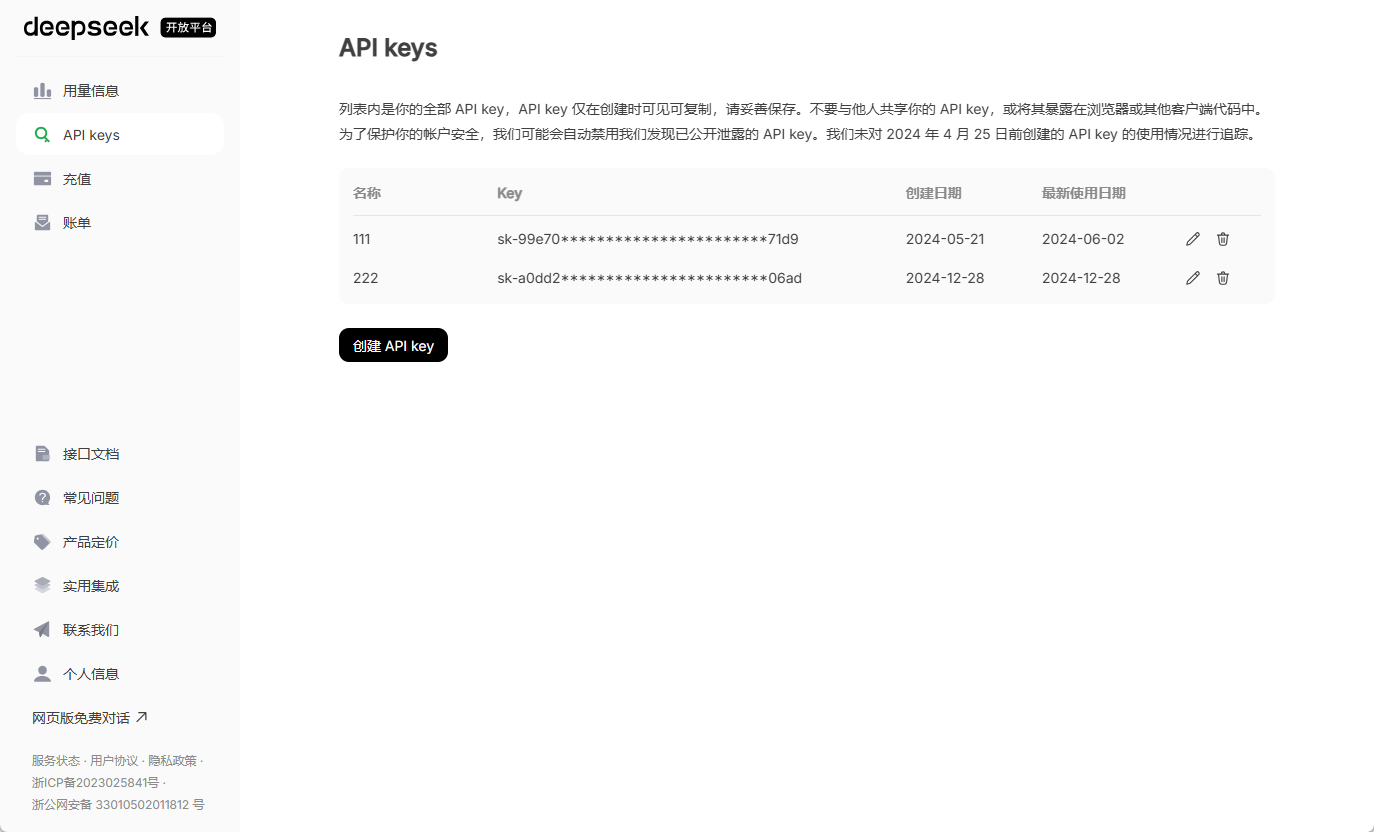

- Obtenga la clave API oficial: Visite el sitio web oficial de DeepSeek para crear una cuenta y pasar la autenticación de empresa (los desarrolladores individuales eligen el tipo individual), en la consola "gestión de vales"El módulo genera una clave de API propietaria, normalmente con el formato ds-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx.

Para crear un chatbot utilizando la función ChatBox de DeepSeek, siga los pasos que se indican a continuación para combinar la implantación local con la configuración de la interfaz para una interacción eficaz:

I. Construcción del entorno básico

- Instalación del marco Ollama

Ollama es un marco ligero para ejecutar modelos nativos de IA, compatible con modelos de código abierto como DeepSeek.- Visita la web oficial de Ollama y elige el paquete de instalación según tu sistema (Windows elige .exe, Mac elige .dmg).

- Una vez finalizada la instalación, escriba en el terminal

ollama listVerifique el éxito, si se muestra la lista de modelos (por ejemplo, llama3) entonces la instalación se ha completado.

- Implantación del modelo DeepSeek

- Seleccione la versión del modelo en función de la configuración del hardware:

- equipos de bajo perfil: Selección

1.5Btal vez8BVersión paramétrica (requiere 2 GB o más de memoria de vídeo). - Equipos de alto rendimiento: Recomendaciones

16Bo superior (requiere 16 GB o más de memoria de vídeo).

- equipos de bajo perfil: Selección

- Ejecute el comando en el terminal para descargar el modelo:

ollama run deepseek-r1:8b # 替换数字为所选参数版本La primera ejecución requiere la descarga de aproximadamente 5 GB de archivos de modelos, por lo que se necesita una red estable.

- Seleccione la versión del modelo en función de la configuración del hardware:

Configuración de la interfaz ChatBox

- Instalación de la herramienta ChatBox

- Visita la página oficial de ChatBox y descarga el paquete de instalación para el sistema correspondiente (Windows, Mac o Linux).

- Ejecute el software tras la instalación y acceda a la interfaz de configuración.

- Conexión de Ollama con el modelo DeepSeek

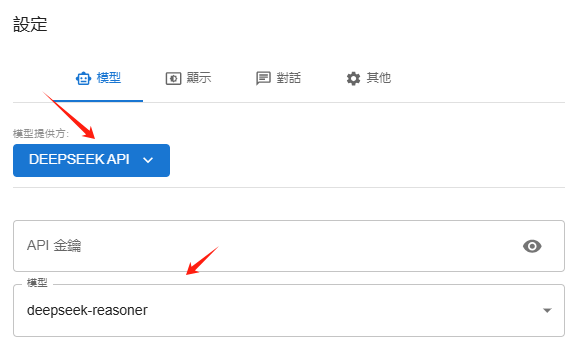

- Seleccione "Proveedor de modelos" en el ChatBox. API OLLAMA.

- Introduzca la dirección API por defecto

http://localhost:11434(Si no se rellena automáticamente, introdúzcalo manualmente). - Seleccione la versión instalada de DeepSeek en el menú desplegable "Modelo" (p. ej.

deepseek-r1:8b).

- Pruebas funcionales

- Vuelve a la interfaz principal, introduce una pregunta (por ejemplo, "Escribe una felicitación de Año Nuevo"), ChatBox generará una respuesta a través del modelo local, permitiendo un diálogo independiente de la red.

- Configuración de Ollama

- Configuración de la API oficial de DeepSeek

III. Ampliación de las funciones avanzadas

- Interacción multimodal e integración de bases de conocimiento

- utilizar Ayuda de página y otros complementos del navegador que añaden capacidades de búsqueda en red al modelo local y permiten acceder a información en tiempo real de motores específicos.

- Al cargar documentos como PDF, TXT, etc. en la base de conocimientos, el modelo puede combinarse con datos locales para generar respuestas más precisas (es necesario configurar modelos integrados como BERT).

- Recomendaciones para optimizar el rendimiento

- adaptación de hardwareSi la latencia del diálogo es alta, reduce la versión de los parámetros del modelo o actualiza la tarjeta gráfica (se recomienda RTX 4080 o superior).

- PrivacidadLa implantación local evita la carga de datos y es adecuada para el tratamiento de información sensible.

IV. Soluciones a problemas comunes

- Fallo en la descarga del modeloComprueba tu conexión a Internet y desactiva el cortafuegos o el antivirus.

- ChatBox no respondeConfirme que se ha iniciado el servicio Ollama (en el terminal, escriba

ollama serve). - memoria de vídeo insuficiente: Pruebe con modelos más pequeños o aumente la memoria virtual.

Un chatbot DeepSeek localizado y de alta privacidad puede construirse rápidamente siguiendo los pasos anteriores. Para una mayor personalización (por ejemplo, integración web), consulte el tutorial de desarrollo de la API.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...