¿Cuáles son los requisitos mínimos de hardware si se implanta el modelo deepseek localmente?

Análisis de los requisitos de hardware para la implantación local de modelos DeepSeek

- Análisis de los principales elementos de hardware

Los requisitos de hardware para la implantación de modelos dependen de tres dimensiones principales:

- nivel de parámetrosEl sistema de memoria de los modelos 7B/67B varía enormemente. DeepSeek R1 671B Tutorial de despliegue local: basado en Ollama y cuantificación dinámica

- modo de inferenciaFP16/INT8: la cuantificación reduce el espacio ocupado por la memoria gráfica 40-60%

- Escenarios de uso: La diferencia de consumo de recursos entre el razonamiento conversacional y el razonamiento por lotes puede ser de 5 a 10 veces.

2. Ejemplo de configuración típica (en términos de precisión FP16)

Para los que no entiendan FP16 pueden leer:Qué es la cuantificación de modelos: explicación de los tipos de datos FP32, FP16, INT8, INT4por lo que hay relativamente muchas más versiones optimizadas, por ejemplo:Requiere sólo 14 GB de RAM para ejecutar DeepSeek-Coder V3/R1 (Q4_K_M quantised) localmente.

| tamaño del modelo | Requisitos mínimos de memoria de vídeo | Tarjetas gráficas recomendadas | CPU alternativa |

|---|---|---|---|

| 7B | 14 GB | RTX3090 | 64 GB DDR4 + conjunto de instrucciones AVX512 |

| 20B | 40 GB | A100-40G | Se necesitan marcos de razonamiento distribuidos |

| 67B | 134 GB | 8 x A100 | No se recomiendan las soluciones basadas únicamente en la CPU |

💡 Fórmula de cálculo de la memoria de visualización: número de parámetros × 2 bytes (FP16) × 1,2 (factor de seguridad).

3. Técnicas clave de optimización

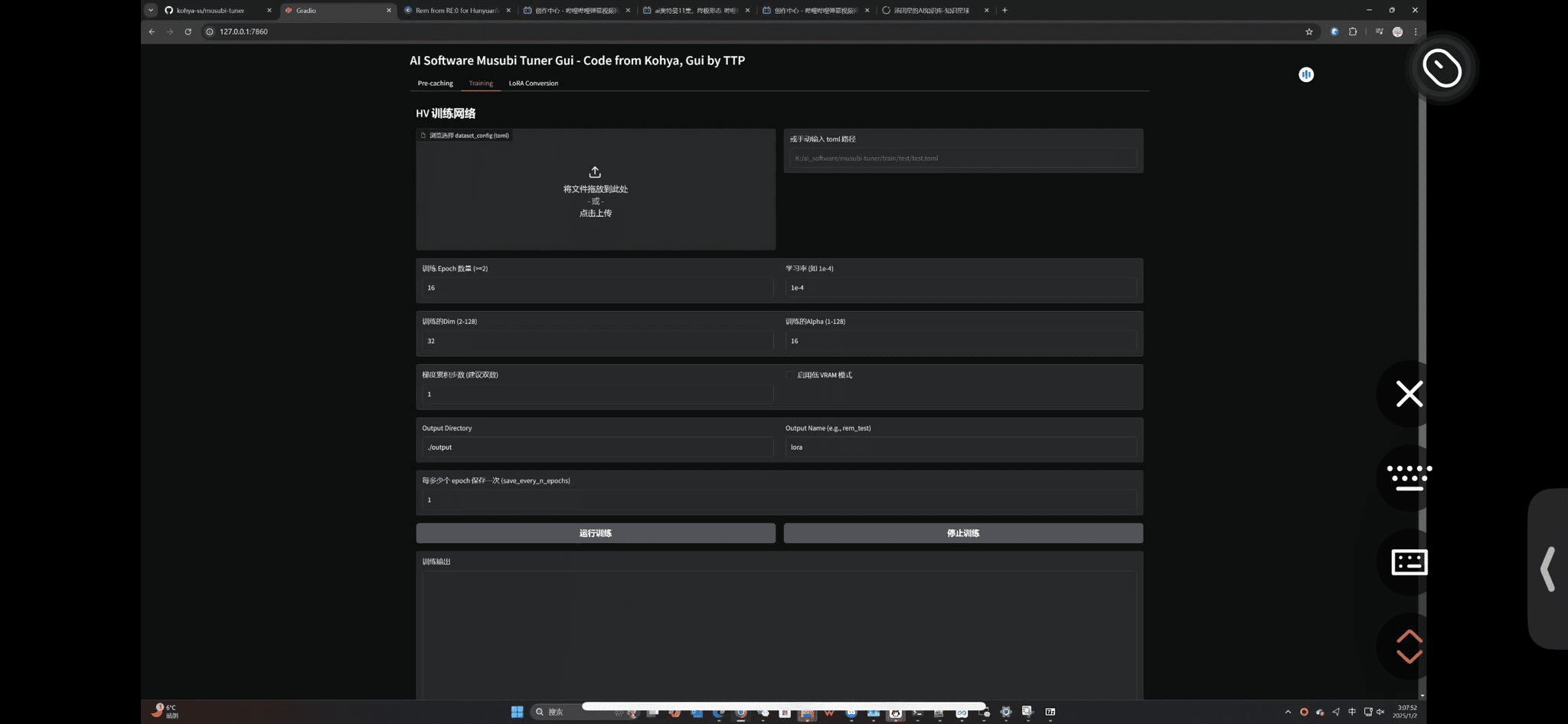

# 量化技术示例(伪代码)

model = load_model("deepseek-7b")

quantized_model = apply_quantization(model, precision='int8') # 显存降低40%

- Tecnología de compresión de memoria VGA::

- Marco vLLM: Mejora del rendimiento 20% mediante el mecanismo PageAttention

- FlashAtención-2Reducción de la huella de memoria de vídeo del 30%

- Cuantificación AWQ: Reducción de la memoria 50% manteniendo la precisión 97%

4. Comparación de casos reales de implantación

| evento deportivo | RTX3060(12G) | RTX4090(24G) | A100 (80G) |

|---|---|---|---|

| DeepSeek-7B | Necesidad de cuantificar el despliegue | soporte nativo | Soporte multiinstancia |

| velocidad de razonamiento | 8 fichas/s | 24 fichas/s | 50+ fichas/s |

| Contexto máximo | 2K fichas | 8.000 fichas | 32K fichas |

5. Requisitos de almacenamiento y del sistema

- espacio en disco::

- Modelo base: número de parámetros × 2 (por ejemplo, 7B requiere 14 GB)

- Paquete de despliegue completo: se recomiendan 50 GB de espacio

- sistema operativo::

- Ubuntu 20.04+ (recomendado)

- Windows requiere compatibilidad con WSL2

- dependencia del software::

- CUDA 11.7+

- PyTorch 2.0+

Lecturas recomendadas

Implantación privada sin GPU locales DeepSeek-R1 32B

Recomendaciones prácticasPara desarrolladores individuales, la configuración RTX3090 + 64 GB de memoria puede satisfacer el modelo 7B sin problemas. Para el despliegue a nivel empresarial, se recomienda utilizar el clúster A100/H100 con marcos de optimización como vLLM para lograr una inferencia eficiente. El despliegue cuantitativo debe prestar atención al impacto de la pérdida de precisión en el negocio, y se recomienda realizar pruebas y validaciones rigurosas.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...