¿Para qué sirve marcar OpenRouter Transforms en Roo Cline?

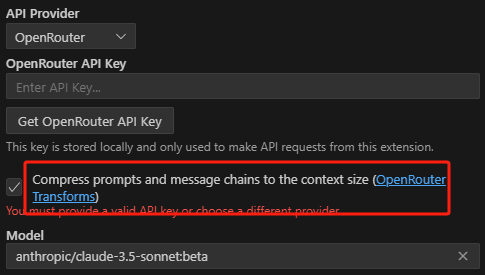

Open Roo Cline Al establecer el modelo de proveedor de servicios en OpenRouter, verá la siguiente configuración:

Le guiará en lo que son las transformaciones OpenRouter. Explicación sencilla: cuando se encuentre con un contexto demasiado largo, le ayudará a eliminar la parte central antes de enviarlo al modelo.

Explicado detalladamente a continuación OpenRouter y el papel de las transformadas intermedias.

Antecedentes del problema: limitaciones de la longitud del contexto del modelo

En primer lugar, hay que entender un concepto:Modelo Contexto Longitud Límite.

- Los grandes modelos lingüísticos (LLM) no disponen de una memoria ilimitada de diálogos anteriores cuando procesan texto.

- Cada modelo tiene una longitud máxima de contexto (entendida como ventana de "memoria") más allá de la cual el modelo no puede recordar entradas anteriores.

- Por ejemplo, un modelo puede tener 8k fichas (que son unas 6000 palabras) en contexto. Si introduce más de 8.000 tokens de texto, es posible que el modelo olvide la primera parte del texto, lo que dará lugar a una respuesta de menor calidad.

La solución de OpenRouter: transformaciones

Para resolver este problema, OpenRouter proporciona un parámetro de transformaciones que permite preprocesar los avisos enviados al modelo para el propósito principal:

- Maneja los mensajes que están fuera de contexto: Si sus avisos (incluido el historial de diálogos) son demasiado largos para la longitud del contexto del modelo, OpenRouter puede comprimir o truncar los avisos para que se ajusten a las restricciones del modelo mediante el parámetro transformaciones.

- Manejo personalizado de los tacos: transforms no sólo se ocupa de los límites de longitud, sino que en el futuro puede ofrecer más funciones para trabajar con sugerencias, por ejemplo:

- Alertas automáticas de traducción

- Añadir instrucciones específicas

conversión medio-fuera

middle-out es la única transformación disponible actualmente en transforms:Comprima o elimine los mensajes en medio del aviso para ajustarse al límite de longitud de contexto del modelo.

Concretamente, funciona de la siguiente manera:

- Detecta la longitud excesiva: middle-out comprueba si la longitud total de su mensaje (o lista de mensajes) supera la longitud contextual del modelo.

- Comprimir la sección central: Si se sobrepasa, middle-out comprimirá o borrará preferentemente el mensaje de la parte central del prompt. Esto se basa en la observación de que LLM tiende a prestar más atención al principio y al final y menos a la parte central cuando procesa texto. Por tanto, sacrificar la parte central del mensaje suele garantizar la calidad de la respuesta del modelo.

- Conserva la cabeza y la cola: El middle-out intentará mantener en la medida de lo posible las partes inicial y final del prompt, ya que esta parte suele contener información importante como:

- instrucción primordial

- Aportaciones recientes de los usuarios

- Reducir el número de mensajes: Además de comprimir la longitud, middle-out también reduce el número de mensajes en la lista de mensajes, porque algunos modelos (como AntrópicoClaude) También hay un límite en el número de mensajes.

Comportamiento por defecto y desactivación del middle-out

- Activado por defecto: Si utiliza un endpoint OpenRouter con una longitud de contexto menor o igual a 8k, la conversión middle-out está activada por defecto. Es decir, si la solicitud supera la longitud del contexto, OpenRouter la comprimirá automáticamente.

- Desactivado explícitamente: Si no desea que OpenRouter comprima automáticamente sus peticiones, puede establecer transforms: [] en el cuerpo de la petición para indicar que no se utilicen transformaciones.

Cuándo utilizar middle-out

- La historia del diálogo es demasiado larga: Cuando se tienen varias rondas de diálogo, con una historia acumulada que puede superar la duración contextual del modelo, el middle-out puede ayudar a mantener la coherencia del diálogo.

- Modelo de menor longitud de contexto: Cuando se utiliza un modelo con una longitud de contexto pequeña, la opción "middle-out" permite introducir un texto más largo sin que el modelo "olvide" la entrada anterior.

- Evita la pérdida de información: Aunque el middle-out elimina parte de la información intermedia, está diseñado con el objetivo de maximizar la retención de información importante y minimizar el impacto de la pérdida de información.

Cuándo no utilizar middle-out

- Manipulación personalizada: Si desea tener un control total sobre cómo se gestionan los avisos, o utilizar un algoritmo de compresión personalizado, puede optar por no utilizar middle-out y gestionar usted mismo la longitud de los avisos.

- Se requiere un contexto completo: Hay algunos escenarios en los que puede ser necesario el contexto completo, y eliminar la información del medio causaría serios problemas, por lo que puede no ser apropiado utilizar middle-out en este punto.

resúmenes

El objetivo principal de las transformaciones y el middle-out es:

- Simplificar la gestión de las indicaciones de longitud fuera de contextoEl hecho de evitar la gestión manual y el truncamiento de las indicaciones permite al modelo manejar textos e historias de diálogo más largos.

- Mejora de la experiencia del usuario: Especialmente para modelos con longitudes de contexto pequeñas, lo que facilita que los usuarios aprovechen las capacidades del modelo.

- Optimizar la calidad de las respuestas de los modelosEl objetivo es retener la mayor cantidad posible de información importante dentro de un contexto limitado para reducir el olvido del modelo.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...