ReAct: razonamiento y acción en un gran modelo lingüístico

Original: https://arxiv.org/pdf/2210.03629.pdf

¿No entiende cómo funciona y se aplica ReAct incluso después de leerlo? Consulte elAplicación práctica de la lógica ReAct" con ejemplos prácticos.

resúmenes

Aunque los modelos lingüísticos a gran escala (llm) han demostrado un rendimiento impresionante en tareas de comprensión lingüística y toma de decisiones interactiva, sus capacidades de razonamiento (por ejemplo, las pistas de la cadena de pensamiento) y de acción (por ejemplo, la generación de planes de acción) se han estudiado en gran medida como temas separados. Este artículo explora el uso de llm para generar trayectorias de razonamiento y acciones específicas de una tarea de forma intercalada, lo que permite una mayor sinergia entre ambas: las trayectorias de razonamiento ayudan al modelo a generalizar, seguir y actualizar planes de acción, así como a tratar excepciones, mientras que las acciones le permiten interactuar con fuentes externas (por ejemplo, bases de conocimiento o entornos) y recopilar información adicional. El método ReAct propuesto se aplica a un conjunto diverso de tareas lingüísticas y de toma de decisiones, y se demuestra su eficacia sobre una base de referencia del estado del arte, además de mejorar la interpretabilidad humana y la fiabilidad. En concreto, en la respuesta a preguntas (HotpotQA) y la verificación de hechos (Fever), ReAct supera las ilusiones y los problemas de propagación de errores que prevalecen en el razonamiento de cadena de pensamiento interactuando con una sencilla API de Wikipedia y generando trayectorias de resolución de tareas similares a las humanas que son más fáciles de interpretar que las líneas de base sin trayectorias de razonamiento. Además, en dos pruebas comparativas de toma de decisiones interactivas (ALFWorld y WebShop), ReAct supera a los enfoques de imitación y aprendizaje por refuerzo con una tasa de éxito absoluta del 34% y el 10%, respectivamente, al tiempo que requiere sólo uno o dos ejemplos contextuales.

1 Introducción

Una característica única de la inteligencia humana es la capacidad de combinar a la perfección las acciones orientadas a la tarea con el razonamiento verbal, que se cree que desempeña un papel importante en la cognición humana, contribuyendo a la autorregulación o la formulación de estrategias, así como al mantenimiento de la memoria de trabajo. Tomando como ejemplo la preparación de un plato en la cocina, entre dos acciones concretas, podemos utilizar el razonamiento verbal para seguir el progreso ("Ahora que todo está picado, debo calentar la cacerola con agua"), para hacer frente a anomalías o ajustar el plan según la situación ("No tengo sal, entonces voy a utilizar salsa de soja y pimienta en su lugar"), y para darnos cuenta de cuándo se está preparando un plato ("No tengo sal, entonces voy a utilizar salsa de soja y pimienta en su lugar"). en su lugar"), y darse cuenta de cuándo se necesita información externa ("¿Cómo preparo la masa? Haré una búsqueda en Internet"). También podemos pasar a la acción (abrir un recetario para leer una receta, abrir la nevera, comprobar los ingredientes) para apoyar el razonamiento y responder a preguntas ("¿Qué puedo cocinar ahora mismo?") . Esta estrecha sinergia entre "acción" y "razonamiento" permite a los humanos aprender nuevas tareas con rapidez y tomar decisiones o razonamientos sólidos en entornos desconocidos o ante la incertidumbre de la información.

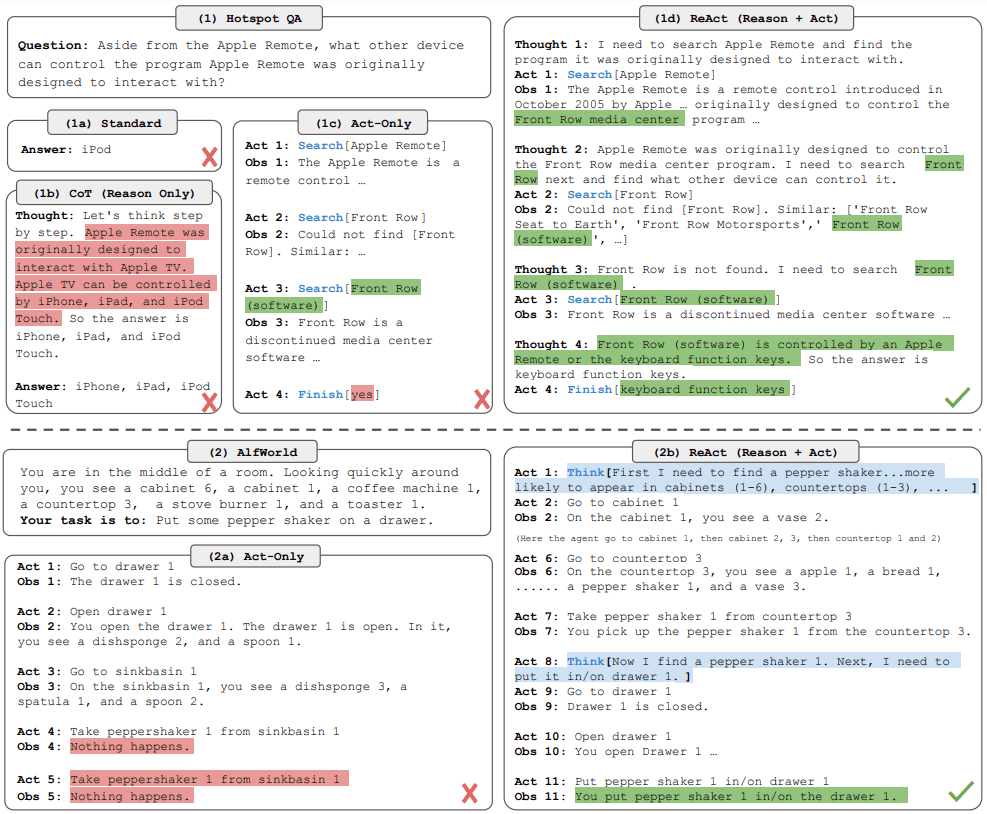

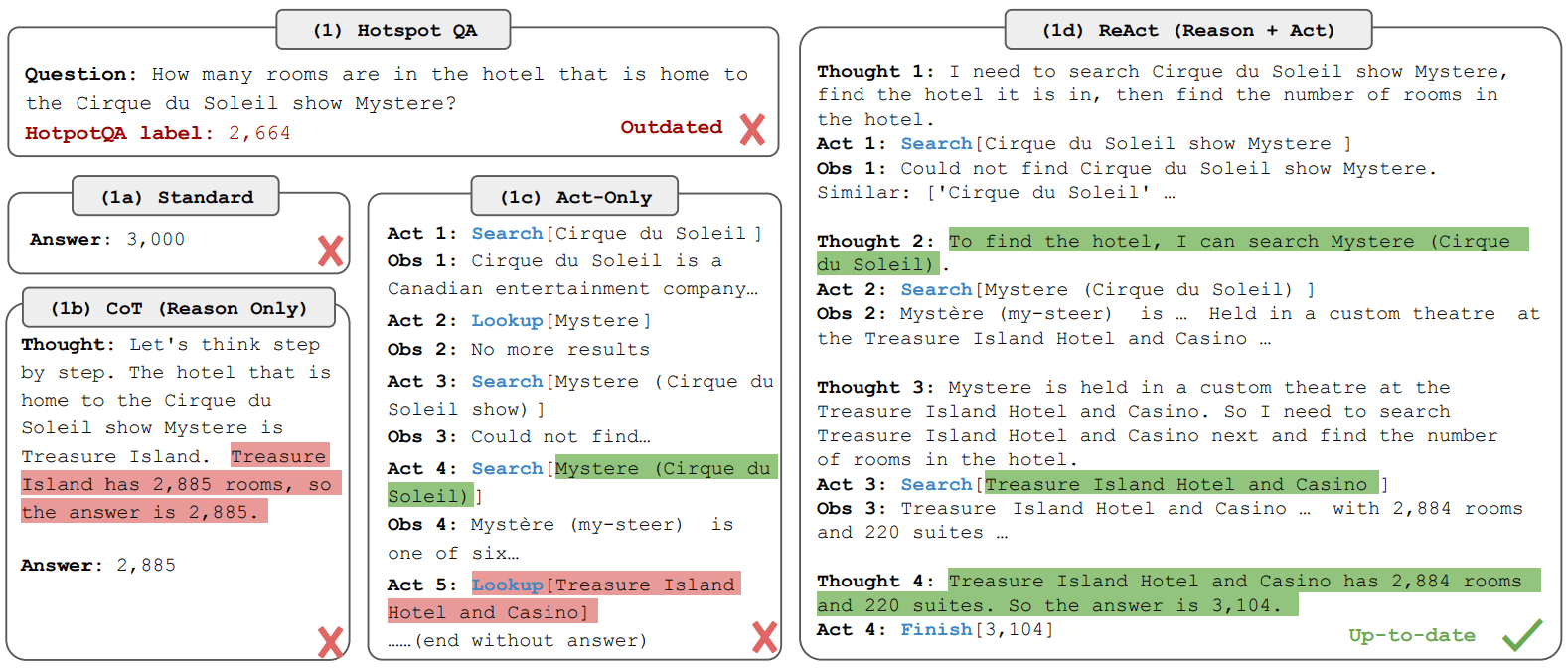

Resultados recientes han insinuado la posibilidad de combinar el razonamiento verbal con la toma de decisiones interactiva en sistemas autónomos. Por un lado, los Large Language Models (LLM) guiados adecuadamente han demostrado la capacidad de realizar varios pasos de razonamiento en tareas aritméticas, de sentido común y de razonamiento simbólico. Sin embargo, este razonamiento "en cadena" es una caja negra estática, en la que el modelo utiliza su representación interna para generar pensamiento y no se basa en el mundo externo, lo que limita su capacidad de razonar reactivamente o de actualizar conocimientos. Esto puede dar lugar a ilusiones fácticas y a la propagación de errores en el proceso de razonamiento (figura 1(1b)). Por otro lado, trabajos recientes han explorado el uso de modelos lingüísticos preentrenados para la planificación y la acción en entornos interactivos, centrándose en la predicción de la acción a través de priors lingüísticos. Estos enfoques suelen convertir las observaciones multimodales en texto, utilizan modelos lingüísticos para generar acciones o planes específicos del dominio y, a continuación, utilizan controladores para seleccionarlos o ejecutarlos. Sin embargo, no utilizan modelos lingüísticos para razonar de forma abstracta sobre objetivos de alto nivel o para mantener la memoria de trabajo en apoyo de las acciones, con la excepción de Huang et al. (2022b), que realizaron una forma limitada de razonamiento verbal para reiterar hechos espaciales sobre el estado actual. Más allá de esta simple tarea encarnada que interactúa con varios bloques de construcción, no se ha investigado cómo el razonamiento y la acción pueden combinarse de forma sinérgica para resolver tareas generales, y si dicha combinación puede proporcionar beneficios sistemáticos sobre el razonamiento o la acción por separado.

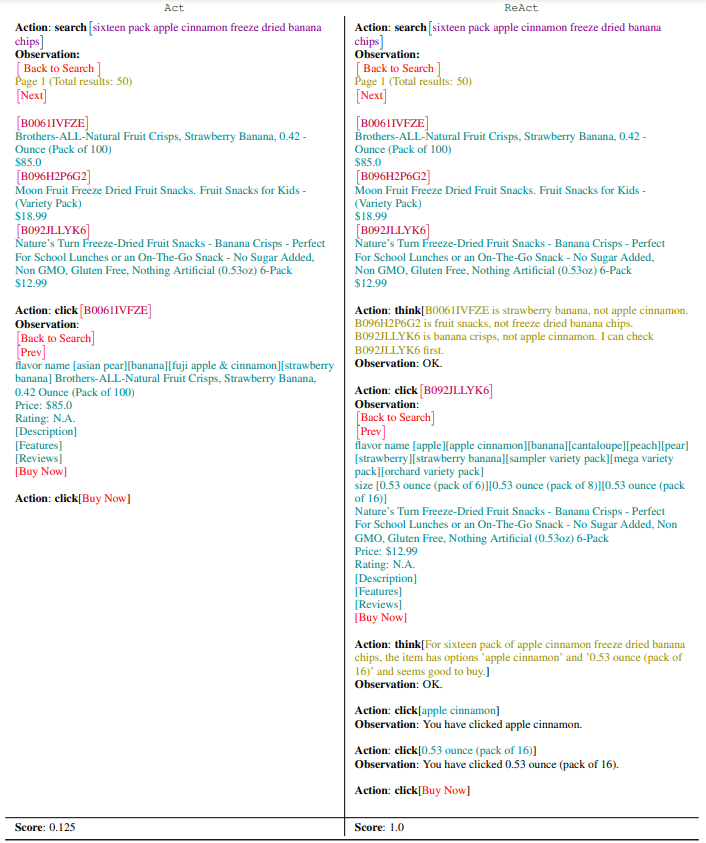

Figura 1: (1) Comparación de cuatro métodos de sugerencia, (a) sugerencia estándar, (b) cadena de pensamiento (CoT, solo razonamiento), (c) solo acción y (d) ReAct (razonamiento + acción), para resolver un problema HotpotQA (Yang et al., 2018). (2) Una comparación de (a) los enfoques de insinuación de solo acción y (b) ReAct para resolver un juego AlfWorld (Shridhar et al., 2020b). En ambos dominios, omitimos los ejemplos contextuales de las indicaciones y solo mostramos las trayectorias de resolución de problemas generadas por el modelo (acción, pensamiento) y el entorno (observación).

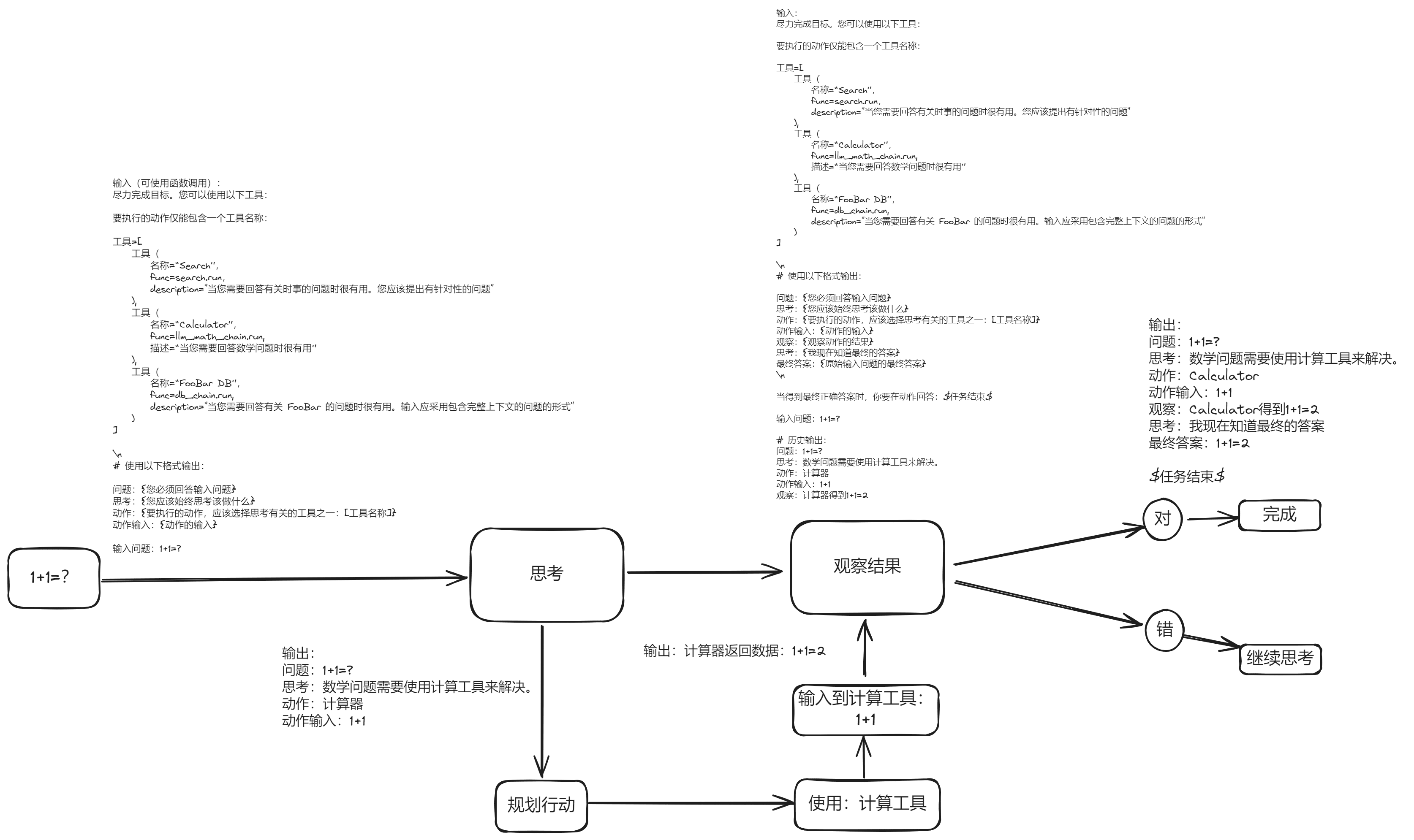

este documento presentaReActReAct, un paradigma generalizado para combinar el razonamiento y la acción con modelos lingüísticos para resolver una variedad de tareas de razonamiento lingüístico y toma de decisiones (Fig. 1).ReAct pide a llm que genere trazas de razonamiento verbal y acciones relevantes para la tarea de forma transversal, lo que permite al modelo realizar un razonamiento dinámico para crear, mantener y adaptar planes de acción de alto nivel (acción razonada), a la vez que interactúa con entornos externos (por ejemplo, Wikipedia) para incorporar información adicional al razonamiento (razonamiento por acción).

Este artículo evalúa empíricamente ReAct y los modelos de referencia más avanzados en cuatro pruebas diferentes: cuestionarios, comprobación de hechos, juegos de texto y navegación web. Para HotPotQA y Fever, ReAct supera a los modelos comunes de generación de acciones y compite con Chain-of-Thought Reasoning (CoT) accediendo a la API de Wikipedia, donde los modelos pueden interactuar. En general, el mejor enfoque es una combinación de ReAct y CoT, que permite utilizar tanto el conocimiento interno como la información obtenida externamente en el proceso de razonamiento. En ALFWorld y WebShop, dos o incluso una indicación ReAct pueden superar el uso de 103 ∼ 105Los métodos de aprendizaje por imitación o refuerzo entrenados en instancias de la tarea dieron lugar a aumentos absolutos de las tasas de éxito del 34% y el 10%, respectivamente. La importancia del razonamiento disperso y generalizado en la toma de decisiones queda demostrada al mostrar una ventaja consistente sobre una línea de base controlada de sólo acción. Además de la aplicabilidad general y el aumento del rendimiento, la combinación de razonamiento y acción contribuye a la interpretabilidad, fiabilidad y capacidad de diagnóstico del modelo en todos los ámbitos, ya que los humanos pueden distinguir fácilmente entre la información derivada del conocimiento interno del modelo y la del entorno externo, así como examinar las trayectorias de inferencia para comprender los fundamentos de la toma de decisiones de las acciones del modelo.

En resumen, nuestras principales aportaciones son las siguientes.

(1) Proponer ReAct, un nuevo paradigma basado en pistas para el razonamiento y la acción colaborativos en el modelado del lenguaje para resolver tareas generales.

(2) Se han llevado a cabo experimentos exhaustivos en diferentes puntos de referencia para demostrar las ventajas de ReAct frente a enfoques anteriores de inferencia o generación de acciones por sí solos en un entorno de aprendizaje sin muestras; la

(3) proponer ablación y análisis sistemáticos para comprender la importancia de la acción en las tareas de razonamiento, y del razonamiento en las tareas de interacción.

(4) Se analizan las limitaciones de ReAct en el entorno con claves (es decir, soporte limitado para la inferencia y el comportamiento) y se llevan a cabo experimentos preliminares de ajuste fino que muestran el potencial de mejora de ReAct con datos de entrenamiento adicionales. La ampliación de ReAct para entrenar y manipular tareas adicionales y su combinación con paradigmas complementarios como el aprendizaje por refuerzo podrían liberar aún más el potencial de los grandes modelos lingüísticos.

2 REACT: razonamiento colaborativo + acción

Consideremos la configuración general de un cuerpo inteligente que interactúa con su entorno para resolver una tarea. En el paso de tiempotOn, el agente recibe una observación del entornoot ∈ O, y según alguna estrategiaπ(at|ct) Realizar una operaciónat ∈ A, dondect = (o1,a1,--- ,ot-1,at-1,ot) es el contexto del agente. Al asignarct →7 atEl aprendizaje de estrategias puede resultar complicado cuando son muy implícitas y requieren una gran cantidad de cálculos. Por ejemplo, el agente mostrado en la Fig. 1 (1c) es incapaz de generar la acción final correcta (Acto 4) para completar la tarea QA porque requiere un razonamiento complejo sobre el contexto de la trayectoria (Pregunta, Acto 1-3, Obs 1-3). De forma similar, el agente mostrado en la Fig. 1 (2a) es incapaz de entender a partir del contexto que el fregadero 1 no contiene el pimentero 1, y por tanto sigue produciendo comportamientos alucinatorios.

La idea de ReAct es sencilla: ampliamos el espacio de acción de un cuerpo inteligente a Aˆ = A ∪ L, donde L es el espacio lingüístico. Una acción en el espacio lingüísticoaˆt ∈ L, que denominaremos traza de pensamiento o razonamiento, no afecta al entorno externo y, por tanto, no da lugar a retroalimentación observacional. En cambio, un pensamientoaˆtIntenta componer información útil razonando sobre el contexto actualcty actualizar el contextoct+1 = (ct,aˆt) para apoyar futuros razonamientos o acciones. Como se muestra en la Figura 1, puede haber varios tipos de ideas útiles, como: desglosar los objetivos de la tarea y crear un plan de acción (2b, Acto 1; 1d, Pensamiento 1), inyectar conocimientos de sentido común relevantes para la resolución de la tarea (2b, Pensamiento 1), extraer partes importantes de las observaciones (1d, Pensamientos 2,4), hacer un seguimiento del progreso y transportar el plan de acción (2b, Pensamiento 8), tratar las excepciones y ajustar el plan de acción ( 1d, pensamiento 3), etc.

Sin embargo, dado que el espacio lingüístico L es infinito, el aprendizaje en este espacio de acción aumentado es difícil y requiere fuertes priores lingüísticos. En este artículo, nos centramos en un gran modelo lingüístico congelado, PaLM-540B (Chowdhery et al., 2022), en este contexto.[1]Los ejemplos contextuales con menos muestras se indicaron para generar acciones específicas del dominio y pensamientos lingüísticos de forma libre para la solución de la tarea (Fig. 1 (1d), (2b)). Los ejemplos de cada contexto son trayectorias de acciones humanas, pensamientos y observaciones del entorno utilizadas para resolver instancias de tareas (véase el Apéndice C). Para las tareas en las que el razonamiento es primordial (Fig. 1(1)), generamos pensamientos y acciones alternativamente, de modo que la trayectoria de solución de la tarea consta de múltiples pasos de pensamiento-acción-observación. En cambio, para las tareas de toma de decisiones que pueden implicar un gran número de acciones (Fig. 1(2)), los pensamientos sólo tienen que aparecer de forma dispersa en las posiciones más relevantes de la trayectoria, por lo que dejamos que el modelo lingüístico decida por sí mismo la aparición asíncrona de pensamientos y acciones.

Debido a la integración de las capacidades de toma de decisiones y razonamiento en un gran modelo lingüístico, ReAct tiene varias características únicas.

A) Intuitivo y fácil de diseñar:Diseñar instrucciones ReAct es fácil porque los anotadores humanos simplemente expresan sus pensamientos en palabras sobre sus acciones. En este documento no se utilizan opciones específicas de formato, diseños de pensamiento en voz alta ni ejemplos. En las secciones 3 y 4 se describe detalladamente el diseño de las instrucciones para cada tarea.

B) Universal y flexible:Gracias a la flexibilidad del espacio de pensamiento y al formato pensar-actuar-generar, ReAct es adecuado para diversas tareas con diferentes espacios de acción y necesidades de razonamiento, entre las que se incluyen la garantía de calidad, la comprobación de hechos, los juegos de texto y la navegación web.

C) Rendimiento potente y robusto:ReAct demuestra una fuerte generalización cuando aprende de uno a seis ejemplos contextuales, superando sistemáticamente la línea de base de razonamiento o acción en todos los dominios. También mostramos beneficios adicionales al permitir el ajuste fino en la Sección 3, y la solidez del rendimiento de ReAct a la selección de pistas en la Sección 4.

D) Alineados con los humanos y controlables:ReAct promete un proceso secuencial interpretable de toma de decisiones y razonamiento en el que los humanos pueden comprobar fácilmente el razonamiento y la corrección de los hechos. Además, como se muestra en la Figura 5 de la Sección 4, los humanos también pueden controlar o corregir el comportamiento del cuerpo inteligente pensando en la edición.

3 Tareas de razonamiento intensivas en conocimiento

Empezando por las tareas de razonamiento intensivas en conocimiento, como el cuestionario multisalto y la comprobación de hechos. Como se muestra en la Figura 1 (1d), al interactuar con la API de Wikipedia, ReAct es capaz de recuperar información para apoyar el razonamiento y también utilizar el razonamiento para determinar qué recuperar a continuación, lo que demuestra la sinergia del razonamiento y la acción.

3.1 Ajustes

Dominios Consideramos dos conjuntos de datos que suponen un reto para la recuperación y la inferencia del conocimiento: (1) HotPotQA , una prueba comparativa de respuesta a preguntas de varios saltos que requiere la inferencia sobre dos o más artículos de Wikipedia, y (2) FEVER , una prueba comparativa de comprobación de hechos en la que cada afirmación se etiqueta como APOYA, REFUTA o NO HAY ENOUGH INFO, dependiendo de si existe un artículo de Wikipedia para validar la afirmación. En este trabajo, utilizamos una configuración de sólo problema en ambas tareas, donde el modelo sólo recibe el problema/afirmación como entrada y no tiene acceso a los pasajes de apoyo y tiene que confiar en su conocimiento interno o recuperar conocimiento interactuando con el entorno externo para apoyar el razonamiento.

Espacio de acción Hemos diseñado una sencilla API web de Wikipedia que contiene tres tipos de operaciones para facilitar la recuperación interactiva de información:

(1) buscar algo [Entidad], que devuelve las 5 primeras frases de la página wiki de la entidad correspondiente si existe, en caso contrario sugiere las 5 primeras entidades similares del buscador Wikipedia.

(2) localice [cadena], que devolverá la siguiente frase de la página que contenga la cadena, simulando la función Ctrl+F de un navegador.

(3) cumplir [respuesta], completa la tarea actual con la respuesta. En la mayoría de los casos, el espacio de acción sólo puede recuperar una pequeña parte de un párrafo basándose en el nombre exacto del párrafo, mucho menos que los recuperadores léxicos o neuronales más avanzados. El objetivo es simular cómo interactúan los humanos con Wikipedia y forzar al modelo a recuperar mediante razonamiento explícito en el lenguaje.

3.2 Metodología

ReAct Prompting Aplicado a HotpotQA y Fever, seleccionamos aleatoriamente 6 y 3 casos del conjunto de entrenamiento y escribimos manualmente trayectorias en formato ReAct para utilizarlas como muestras submuestreadas en las indicaciones. Al igual que en la Fig. 1 (d), cada trayectoria consta de varios pasos de pensamiento-acción-observación (es decir, pensamiento denso) en los que se utilizan pensamientos de forma libre para diversos fines. En concreto, utilizamos una combinación de pensamientos para descomponer el problema ("tengo que buscar x, encontrar y, y luego encontrar z"), extraer información de las observaciones de Wikipedia ("x empezó en 1844", "el pasaje no dice x"), aplicar el sentido común ("x no es y, así que z debe ser ......") o razonamiento aritmético ("1844 < 1989"), dirigir la reconstrucción de la búsqueda (""Quizá pueda buscar/encontrar x""), y sintetizar la respuesta final (" "...... Así que la respuesta es x"). Para más detalles, véase el Apéndice C.

Líneas de base Eliminamos sistemáticamente las trayectorias ReAct para construir múltiples pistas de referencia (en el formato de la Fig. 1 (1a-1c)).

(a)Aviso estándar/Aviso estándar(Estándar), eliminando todos los pensamientos, acciones y observaciones de la trayectoria ReAct.

(b)Inducción a la cadena de pensamiento / Chain-of-thought prompting(CoT), que elimina acciones y observaciones y sólo sirve como línea de base para el razonamiento. Se estableció una línea de base autoconsistente (CoT-SC) mediante el muestreo de trayectorias con una temperatura de descodificación CoT de 0,7 durante la inferencia y utilizando la mayoría de las respuestas, lo que mejoró el rendimiento de forma consistente con respecto a la CoT.

(c)Sólo actuación(Act), que extrae ideas de la trayectoria ReAct, es aproximadamente análoga a la forma en que WebGPT interactúa con Internet para responder preguntas, aunque opera en un espacio de tareas y acciones diferente y utiliza la imitación y el aprendizaje por refuerzo en lugar de indicaciones.

Combinar conocimientos internos y externos / Combinar conocimientos internos y externos Como detallaremos en la sección 3.3, observamos queReAct demostró un proceso de resolución de problemas más factual y fundamentado, mientras que CoT fue más preciso a la hora de formular una estructura de razonamiento, pero era propenso a las alucinaciones.Por lo tanto, proponemos fusionar ReAct y CoT-SC y dejar que el modelo decida cuándo cambiar al otro método basándose en la siguiente heurística.

a) ReAct→CoT-SCSe han establecido 7 y 5 pasos para HotpotQA y FEVER, respectivamente, porque se ha comprobado que un mayor número de pasos no mejora el rendimiento de ReAct.

b) CoT-SC→ReAct:: CuandonLa mayoría de las respuestas de la muestra CoT-SC aparecen menos den/En 2 ocasiones (es decir, es posible que los conocimientos internos no puedan respaldar con seguridad la tarea), vuelva a ReAct.

Puesta a punto/Financiación Debido a los retos que supone etiquetar manualmente trayectorias y acciones de inferencia a escala, este trabajo considera un enfoque de autoayuda similar al de Zelikman et al. (2022), que utiliza 3000 trayectorias con respuestas correctas generadas por ReAct (también utilizadas en otras líneas de base) para afinar un modelo de lenguaje más pequeño (PaLM-8/62B) para descodificar trayectorias condicionadas a preguntas/afirmaciones de entrada (todos los pensamientos, acciones y observaciones). Para más información, véase el Apéndice B.1.

3.3 Resultados y observaciones

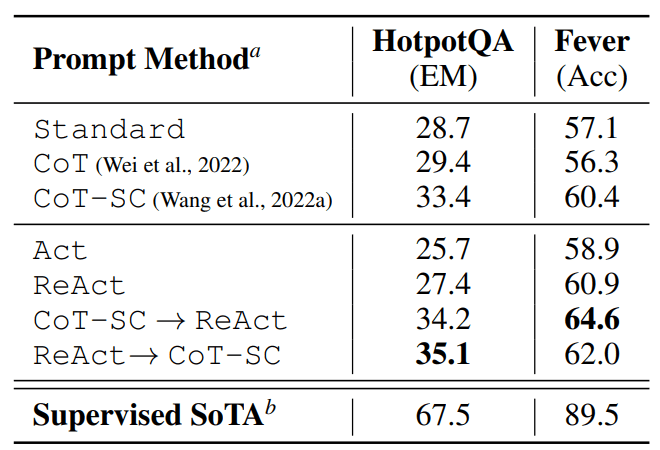

En general, ReAct supera a Act/ReAct supera a Act sistemáticamente La tabla 1 muestra los resultados de HotpotQA y Fever utilizando PaLM-540B como modelo base y diferentes métodos de guía. Observamos que ReAct supera a Act en ambas tareas, lo que demuestra el valor del razonamiento para guiar las acciones, especialmente a la hora de sintetizar las respuestas finales, como se muestra en la Figura 1 (1c-d). El resultado de ajuste fino 3 también confirma las ventajas de las trazas de inferencia para una acción más informada.

Tabla 1: Resultados del PaLM-540B en HotpotQA y Fever.

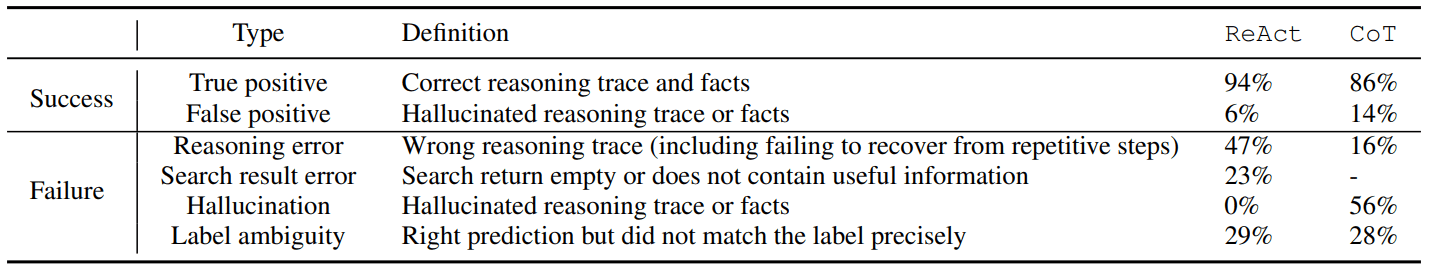

ReAct vs. CoT Por otra parte, ReAct supera a CoT en Fiebre (60,9 frente a 56,3) y queda ligeramente por detrás de CoT en HotpotQA (27,4 frente a 29,4). Es posible que las diferencias sean mínimas en las declaraciones de fervor a favor y en contra (véase el Apéndice D.1), por lo que es fundamental tomar medidas para obtener conocimientos precisos y actualizados. Para entender mejor las diferencias de comportamiento entre ReAct y CoT en HotpotQA, tomamos muestras aleatorias de 50 trayectorias con respuestas correctas e incorrectas (juicios EM) de ReAct y CoT (200 ejemplos en total), respectivamente, y etiquetamos manualmente sus patrones de éxito y fracaso en la Tabla 2. A continuación se exponen algunas observaciones clave.

Tabla 2: Tipos de modos de éxito y fracaso para ReAct y CoT en HotpotQA, y sus porcentajes en ejemplos seleccionados al azar de estudios con humanos.

A) Las alucinaciones son un grave problema para los TdT, en modo de éxito conduce a una tasa de falsas alarmas mucho mayor que ReAct (14% frente a 6%) y constituye su principal modo de fallo (56%). En cambio, la trayectoria de resolución de problemas de ReAct es más relevante, basada en hechos y creíble gracias a su capacidad para acceder a una base de conocimientos externa.

B) Aunque la intercalación de los pasos de razonamiento, acción y observación aumenta la practicidad y credibilidad de ReAct, esta restricción estructural también reduce su flexibilidad a la hora de formular los pasos de razonamiento.Observamos que ReAct tiene un patrón de error frecuente específico, en el que el modelo regenera pensamientos y acciones anteriores, que clasificamos como parte del "error de razonamiento" porque el modelo no consigue razonar adecuadamente sobre la siguiente acción y salta fuera del bucle.

C) Para ReAct, es fundamental recuperar con éxito los conocimientos informativos a través de la búsqueda.Las búsquedas no informativas representaron 23% de los casos de error, desbaratando el razonamiento del modelo y dificultando la recuperación y el reencuadre de las ideas. Puede que se trate de un compromiso esperado entre factualidad y flexibilidad, que nos inspiró para proponer una estrategia que combina ambos enfoques.

En el apéndice E.1 se ofrecen ejemplos de cada modo de éxito y fracaso. También hemos observado que algunas preguntas de HotpotQA pueden contener etiquetas de respuesta obsoletas; véase un ejemplo en la figura 4.

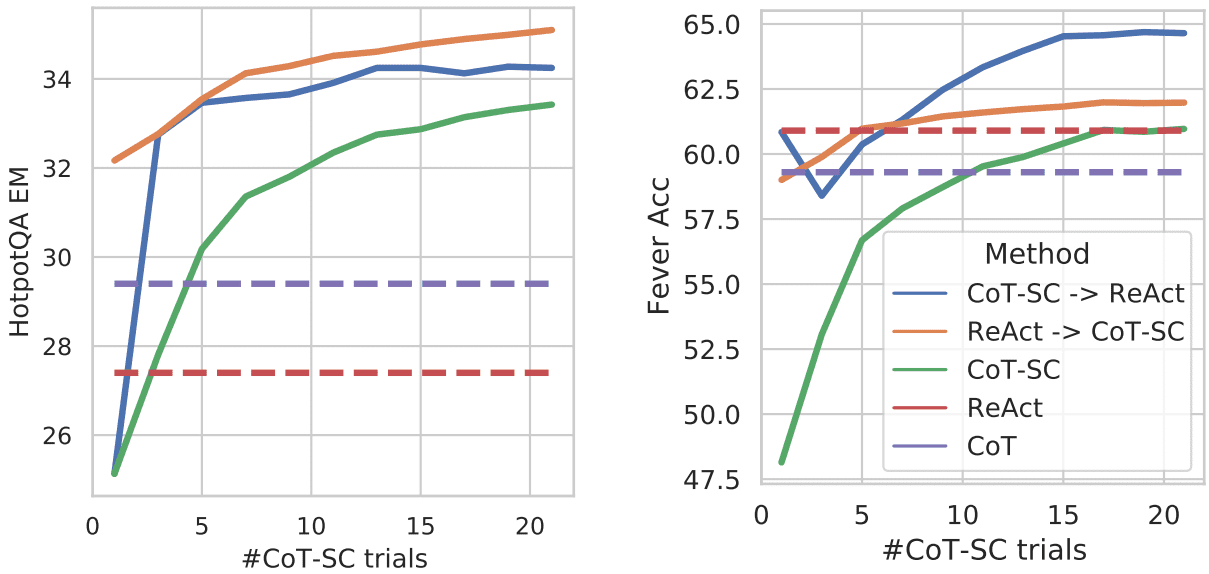

ReAct + CoT-SC obtuvieron los mejores resultados a la hora de incitar a los LLM.Como se muestra en la Tabla 1, los mejores métodos de cueing en HotpotQA y Fever fueron ReAct → CoT-SC y CoT-SC → ReAct, respectivamente.Además, la Figura 2 demuestra el rendimiento de los diferentes métodos cuando se utilizan diferentes números de muestras de CoT-SC. Aunque los dos métodos ReAct + CoT-SC tienen ventajas en sus respectivas tareas, ambos superan de forma significativa y consistente a CoT-SC utilizando sólo 3-5 muestras en un número variable de muestras, un resultado que demuestra el valor de combinar adecuadamente el conocimiento interno al modelo con el conocimiento externo a la tarea de razonamiento.

Figura 2: Resultados puntuales de PaLM-540B presentados según el número de muestras CoT-SC utilizadas.

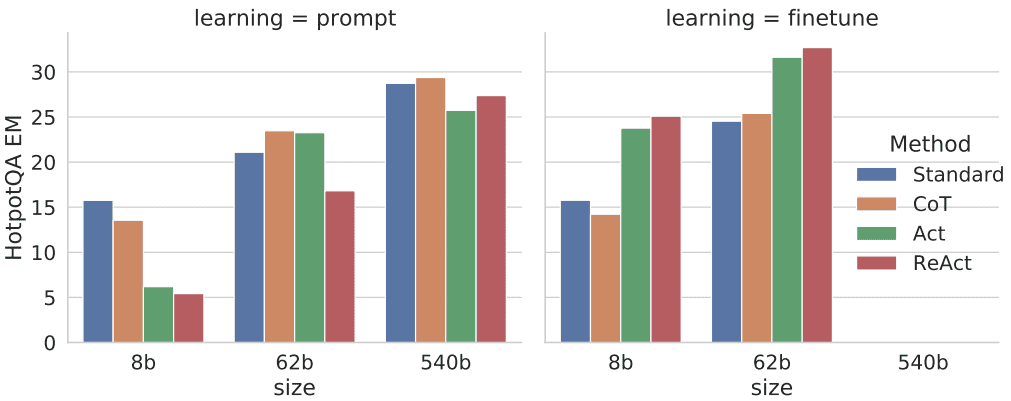

El rendimiento de ReAct es óptimo en términos de ajuste.La figura 3 muestra los efectos ampliados de la indicación/ajuste fino para los cuatro métodos (Estándar, CoT, Act, ReAct) en HotpotQA. En PaLM-8/62B, el método ReAct fue el peor de los cuatro debido a la dificultad de aprender a razonar y actuar a partir de escenarios. Sin embargo, cuando se ajustó con sólo 3.000 ejemplos, ReAct se convirtió en el mejor de los cuatro métodos, con ReAct ajustado en PaLM-8B superando a todos los métodos de razonamiento de PaLM-62B y ReAct ajustado en PaLM-62B superando a todos los métodos de razonamiento de 540B. En PaLM8/62B, por el contrario, el ajuste fino de Standard o CoT fue significativamente peor que el ajuste fino de ReAct o Act, ya que el primero enseña principalmente al modelo a memorizar hechos de conocimiento (posiblemente ficticios), mientras que el segundo enseña al modelo a (razonar y) actuar para obtener información de Wikipedia, que es una habilidad de razonamiento de conocimiento más general. Dado que todos los métodos de señalización siguen estando significativamente por debajo del estado del arte específico del dominio (Tabla 1), creemos que el perfeccionamiento con más datos escritos por humanos puede ser una mejor manera de dar rienda suelta a las capacidades de ReAct.

Figura 3: Resultados ampliados de la señalización y el ajuste de HotPotQA mediante ReAct (nuestro método) y líneas de base.

4 Tareas decisorias

También probamos ReAct en dos tareas interactivas de toma de decisiones basadas en el lenguaje, ALFWorld y WebShop, ambas con entornos complejos que requieren que las inteligencias actúen durante largos periodos de tiempo con escasas recompensas, lo que exige que las inteligencias razonen eficazmente para actuar y explorar.

ALFWorld ALFWorld (Figura 1(2)) es un juego sintético basado en texto diseñado para alinearse con el punto de referencia encarnado ALFRED. Consta de 6 tipos de tareas en las que las inteligencias deben navegar a través de acciones textuales (por ejemplo, ir a la mesa de café1 , recoger el archivo2 , utilizar la lámpara del escritorio1 ) e interactuar con una familia simulada para alcanzar objetivos de alto nivel (por ejemplo, comprobar el archivo que hay bajo la lámpara del escritorio). Una instancia de tarea puede tener más de 50 ubicaciones y requerir más de 50 pasos de estrategia experta para resolverse, lo que supone un reto para las inteligencias a la hora de planificar y seguir submetas, así como explorar sistemáticamente (por ejemplo, comprobar todas las mesas una por una para encontrar la lámpara del escritorio). En concreto, uno de los retos incorporados en ALFWorld es la necesidad de determinar las ubicaciones probables de objetos domésticos comunes (por ejemplo, una lámpara de mesa probablemente esté en una mesa, estantería o cómoda), lo que hace que este escenario sea ideal para que LLM aproveche su conocimiento de sentido común preentrenado. Para dar pistas a ReAct, anotamos aleatoriamente tres trayectorias en el conjunto de entrenamiento para cada tipo de tarea, cada una de ellas formada por ideas dispersas que (1) descomponen el objetivo, (2) rastrean la finalización del subobjetivo, (3) determinan el siguiente subobjetivo y (4) encuentran la ubicación del objeto y qué hacer con él mediante razonamiento de sentido común. En el Apéndice C.4 se muestran las pistas utilizadas para ALFWorld. Siguiendo el enfoque de Shridhar et al., evaluamos 134 juegos de evaluación no vistos en un entorno de tareas específico. Para mayor solidez, construimos 6 pistas para cada tipo de tarea a través de cada permutación de cada una de nuestras 3 trayectorias anotadas.Las pistas Act se construyeron utilizando las mismas trayectorias, pero sin ideas - puesto que las instancias de tareas se seleccionaron aleatoriamente del conjunto de entrenamiento, no estaban sesgadas hacia ReAct ni hacia Act, lo que proporcionaba una comparación justa y controlada. Act, lo que proporciona una comparación justa y controlada para probar la importancia de las ideas dispersas. Como referencia, utilizamos BUTLER, una inteligencia de aprendizaje por imitación entrenada con 105 trayectorias de expertos para cada tipo de tarea.

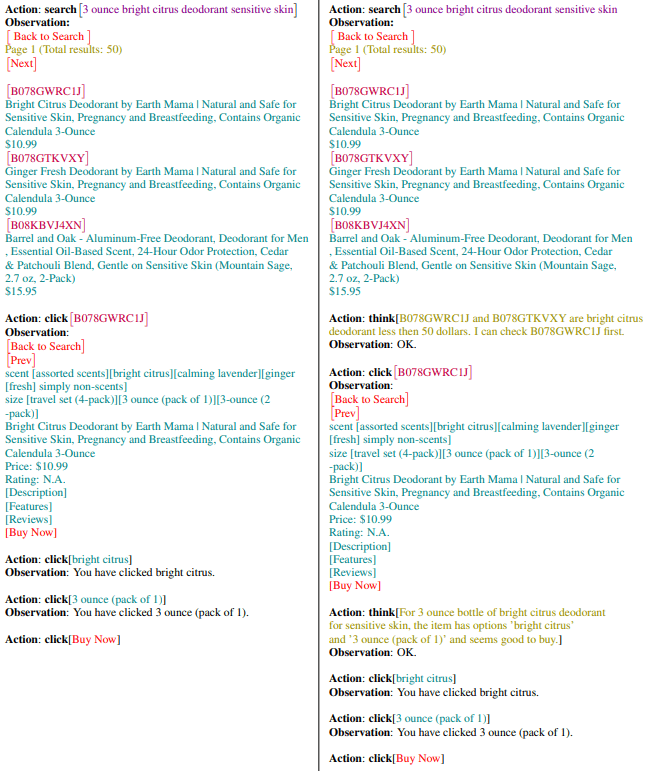

Tienda web ¿Puede ReAct interactuar también con entornos lingüísticos ruidosos del mundo real para aplicaciones prácticas? Estudiamos WebShop, un entorno web de compras en línea propuesto recientemente con 1,18 millones de productos del mundo real y 12.000 instrucciones humanas. A diferencia de ALFWorld, Webshop contiene una gran cantidad de texto estructurado y no estructurado (por ejemplo, títulos, descripciones y opciones de productos rastreados desde Amazon) y pide a las inteligencias que interactúen con él basándose en órdenes de usuario (por ejemplo, "Busco una mesilla de noche con cajones. Debe tener un acabado en níquel y costar menos de 140 dólares") a través de interacciones web (p. ej., buscar "mesilla de noche con cajones" y seleccionar botones como "Color: níquel blanco moderno" o "Volver a la búsqueda", seleccionar botones como "Color: Modern Nickel White" o "Volver") para comprar el producto. Esta tarea se evaluó mediante la puntuación media (porcentaje de atributos requeridos cubiertos por el producto seleccionado, promediado en todos los episodios) y la tasa de éxito (porcentaje de episodios en los que el producto seleccionado cumplía todos los requisitos) en 500 instrucciones de prueba. Desarrollamos instrucciones Act que incluían acciones de búsqueda, selección de productos, elección de opciones y compra, mientras que las instrucciones ReAct razonaban adicionalmente para determinar qué explorar, cuándo comprar y qué opciones de productos eran relevantes para las instrucciones. Véanse ejemplos de instrucciones en la Tabla 6 y predicciones del modelo en la Tabla 10 del Apéndice. Lo comparamos con un enfoque de aprendizaje por imitación entrenado con 1.012 trayectorias anotadas personalmente y con un enfoque adicional de aprendizaje por imitación + refuerzo (IL + RL) entrenado con 1.587 instrucciones de entrenamiento.

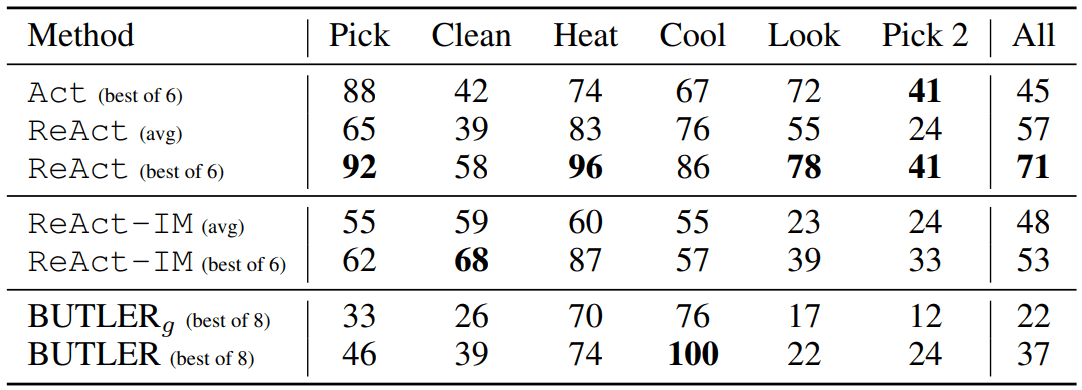

al final ReAct supera a Act tanto en la plataforma ALFWorld (Tabla 3) como en Webshop (Tabla 4). En ALFWorld, el experimento ReAct con mejores resultados alcanza una tasa media de éxito de 711 TP3T, que supera ampliamente a los mejores experimentos de Act (451 TP3T) y BUTLER (371 TP3T). De hecho, el experimento ReAct con peores resultados (481 TP3T) también superó a los mejores experimentos de ambos métodos. Además, la ventaja de ReAct sobre Act persistió a lo largo de los seis experimentos controlados, con ganancias relativas de rendimiento que oscilaron entre 331 TP3T y 901 TP3T, con una media de 621 TP3T. Desde una perspectiva cualitativa, descubrimos que Act no descomponía correctamente el objetivo en subobjetivos más pequeños o perdía de vista el estado actual del entorno en ausencia de cualquier pensamiento. En el Apéndice D.2.1 y el Apéndice D.2.2 se muestran ejemplos de trayectorias en las que se comparan ReAct y Act.

Tabla 3: Tasas de éxito específicas de la tarea AlfWorld (%). Los resultados de BUTLER y BUTLERg proceden de Shridhar et al. 2020b Tabla 4. Todos los métodos utilizan decodificación codiciosa, excepto BUTLER, que utiliza búsqueda por haz.

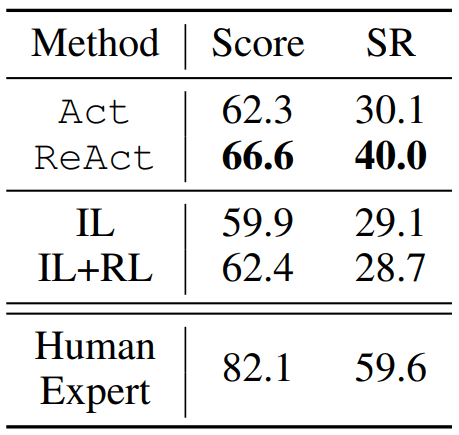

Tabla 4: Puntuaciones y tasas de éxito (TS) en Webshop. Datos de IL/IL+RL tomados de Yao et al. (2022).

En Webshop, las sugerencias únicas de Act han podido ir de la mano de los métodos IL e IL+RL. Con el razonamiento disperso adicional, ReAct consigue un rendimiento significativamente mejor, con una mejora absoluta de 10% sobre la mejor tasa de éxito anterior. Al examinar los ejemplos, observamos que ReAct tiene más probabilidades de salvar la distancia entre las observaciones ruidosas y las acciones razonando para identificar los productos y las opciones que son relevantes para la instrucción (por ejemplo, "Para el taburete 'taburete para ahorrar espacio en el salón', el artículo tiene un tamaño ' 39x18x18inch' y 'azul' opciones que parece que merece la pena comprar"). . Sin embargo, los métodos existentes siguen teniendo un rendimiento muy inferior al de los humanos expertos (Tabla 4), que realizan una exploración del producto y una reconstrucción de la consulta significativamente mayores, lo que sigue siendo un reto para los métodos basados en pistas.

Sobre el valor del razonamiento interno frente a la retroalimentación externa Hasta donde sabemos, ReAct es la primera demostración de LLM aplicado a un sistema de bucle cerrado que combina razonamiento y acción en un entorno interactivo. Quizá el trabajo anterior más cercano sea Internal Monologue (IM), de Huang et al. (2022b), en el que las acciones de los agentes encarnados están dirigidas por el epónimo "monólogo interno".Sin embargo, el "monólogo interno" de la MI se limita a observar el estado del entorno y las tareas que el agente debe cumplir para satisfacer los objetivos.En cambio, el seguimiento de la inferencia de decisión en ReAct es flexible y disperso, lo que permite inducir diversos tipos de inferencia para diferentes tareas (véase la Sección 2).

Para demostrar la diferencia entre ReAct e IM, y para enfatizar la importancia del razonamiento interno frente a las simples respuestas a la retroalimentación externa, realizamos experimentos de ablación utilizando un patrón de pensamiento consistente en retroalimentación externa densa al estilo IM. Como se muestra en la Tabla 3, ReAct superó ampliamente a las indicaciones de estilo MI (ReAct-MI) (71% frente a 53% para el éxito global), con ventajas consistentes en cinco de las seis tareas. Cualitativamente, observamos que ReAct-IM cometía errores con frecuencia a la hora de determinar cuándo se habían completado los subobjetivos o cuál debía ser el siguiente subobjetivo debido a la falta de descomposición de objetivos de alto nivel. Además, muchas de las trayectorias de ReAct-IM también experimentaron dificultades a la hora de determinar dónde podían estar situados los elementos en el entorno de ALFWorld debido a la falta de razonamiento de sentido común.

Ambas deficiencias pueden solucionarse con el paradigma ReAct. Encontrará más información sobre ReAct-IM en el Apéndice B.2. En el Apéndice C.4 encontrará ejemplos de sugerencias para ReAct-IM y en el Apéndice D.2.3, ejemplos de trayectorias.

5 Trabajos relacionados

Un modelo lingüístico de razonamiento Quizá el trabajo más conocido sobre razonamiento con modelos de lenguaje extensos (LLM) sea Chain-of-Thought (CoT), que reveló la capacidad de los LLM para formular sus propios "procesos de pensamiento" para resolver problemas. Desde entonces, se han llevado a cabo varios trabajos de seguimiento, entre los que se incluyen la estimulación mínima para tareas complejas, la CoT de disparo cero y el razonamiento autoconsistente. Recientemente, (Madaan & Yazdanbakhsh, 2022) investigaron sistemáticamente la construcción y estructura de los CoTs y observaron que la presencia de símbolos, esquemas y texto es crítica para la efectividad de los CoTs.

Otros trabajos se han extendido a arquitecturas de razonamiento más complejas que van más allá de las simples pistas. Por ejemplo, Selection-Inference divide el proceso de inferencia en pasos de "selección" e "inferencia", y STaR guía el proceso de inferencia ajustando el modelo en función de la inferencia correcta generada por el propio modelo. Proceso de razonamiento. El razonamiento fiel descompone el razonamiento multipaso en tres pasos, cada uno de los cuales es ejecutado por un LM dedicado. Enfoques similares, como Scratchpad, también demuestran mejoras en problemas computacionales de varios pasos mediante el ajuste fino del LM en pasos computacionales intermedios.

A diferencia de estos enfoques, ReAct realiza algo más que razonamientos aislados y fijos e integra las acciones del modelo y sus correspondientes observaciones en un flujo de entrada coherente, de modo que el modelo pueda razonar con mayor precisión y resolver tareas que van más allá del razonamiento (por ejemplo, la toma de decisiones interactiva).

Utilización de modelos lingüísticos para la toma de decisiones. Las capacidades de los LLM potentes les permiten realizar tareas que van más allá de la generación de lenguaje, y cada vez es más popular utilizar los LLM como modelo de estrategia para la toma de decisiones, especialmente en entornos interactivos.WebGPT utiliza LLM para interactuar con navegadores web, navegar por páginas web e inferir respuestas a preguntas complejas a partir de ELI5 . En cambio, WebGPT no modela explícitamente los procesos de pensamiento y razonamiento, sino que se basa en la costosa retroalimentación humana para el aprendizaje por refuerzo. En el modelado de diálogos, sistemas como BlenderBot y Sparrow y sistemas de diálogo orientados a tareas como SimpleTOD también entrenan LM para tomar decisiones sobre llamadas a API. A diferencia de ReAct, no tienen en cuenta explícitamente el proceso de inferencia y se basan en costosos conjuntos de datos y conjuntos de comentarios humanos para el aprendizaje de políticas. En cambio, ReAct aprende la política de forma más barata, ya que el proceso de toma de decisiones sólo requiere lenguaje para describir el proceso de razonamiento.

Los modelos lingüísticos (LLM) también se aplican cada vez más a la planificación y la toma de decisiones en entornos interactivos y corporales. En este sentido, los más relevantes para ReAct son probablemente SayCan yMonólogo interiorEn SayCan, se pide a los LLM que predigan directamente las posibles acciones del robot, que luego son reordenadas por un modelo de disponibilidad basado en el entorno visual para hacer la predicción final. En SayCan, se pide a los LLM que predigan directamente las posibles acciones del robot, que luego son reordenadas por un modelo de disponibilidad basado en el entorno visual para hacer la predicción final.Monólogo interior se mejora aún más con la adición del famoso "monólogo interior", que se implementa como retroalimentación inyectada desde el entorno. retroalimentación del entorno. Por lo que sabemos, Inner Monologue es el primer trabajo que demuestra un sistema de bucle cerrado de este tipo, y ReAct se basa en él. Sin embargo, afirmamos que Inner Monologue no contiene realmente pensamiento interno, como se explica en la sección 4. También señalamos que el uso del lenguaje como entrada semánticamente rica en los procesos interactivos de toma de decisiones ha demostrado su eficacia en otros entornos. Cada vez está más claro que, con los LLM, el lenguaje como mecanismo cognitivo fundamental desempeñará un papel clave en la interacción y la toma de decisiones. Además, los avances en los LLM han inspirado el desarrollo de agentes versátiles y de propósito general como Reed et al.

6 Conclusiones

Presentamos ReAct, un método sencillo pero eficaz para coordinar el razonamiento y la acción en grandes modelos lingüísticos. A través de un conjunto variado de experimentos sobre tareas de respuesta a preguntas de varios saltos, comprobación de hechos y toma de decisiones interactiva, demostramos que ReAct conduce a un rendimiento superior con rutas de decisión analizables. A pesar de la simplicidad de nuestro enfoque, las tareas complejas en grandes espacios de acción requieren más ejemplos para aprender bien, lo que puede superar fácilmente los límites de longitud de entrada en el aprendizaje contextual. Hemos probado el enfoque ajustado en HotpotQA y los resultados iniciales son alentadores, pero se espera que el aprendizaje con más anotaciones humanas de alta calidad mejore aún más el rendimiento. Permitir que ReAct se amplíe en el entrenamiento multitarea, combinado con paradigmas complementarios como el aprendizaje por refuerzo, puede dar lugar a agentes más potentes que liberen el potencial de los LLM para más aplicaciones.

A Conclusiones adicionales

A.1 Experimento GPT-3

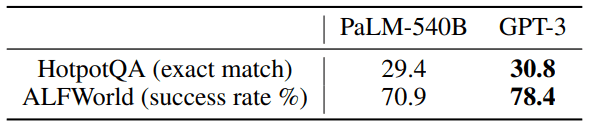

Tabla 5: Comparación de los resultados de las preguntas ReAct utilizando PaLM-540B con GPT-3 (text-davinci-002, descodificación codiciosa). En HotpotQA, seleccionamos aleatoriamente un subconjunto de 500 preguntas de validación. En ALFWorld, utilizamos las 134 instancias no vistas de la tarea de verificación con el mejor conjunto de pistas seleccionadas según PaLM-540B.

Realizamos experimentos adicionales con GPT-3 (Brown et al., 2020) para confirmar la generalidad del rendimiento de ReAct cue en diferentes modelos de lenguaje de gran tamaño. Como se muestra en la Tabla 5, GPT-3 (text-davinci-002, decodificación codiciosa) supera sistemáticamente a PaLM-540B en HotpotQA y ALFWorld, posiblemente porque ha sido ajustado para seguir instrucciones humanas. Esto sugiere que la pista ReAct es eficaz en diferentes tareas para diferentes modelos de lenguaje de gran tamaño. El código de estos experimentos puede consultarse en https://react-lm.github.io/.

A.2 ReAct para adquirir conocimientos actualizados sobre HotpotQA

Figura 4: Otro ejemplo de pregunta de un concurso de preguntas calientes en el que las etiquetas originales están desfasadas. Solo ReAct fue capaz de obtener las respuestas más actualizadas mediante interacciones web reales unidas al razonamiento.

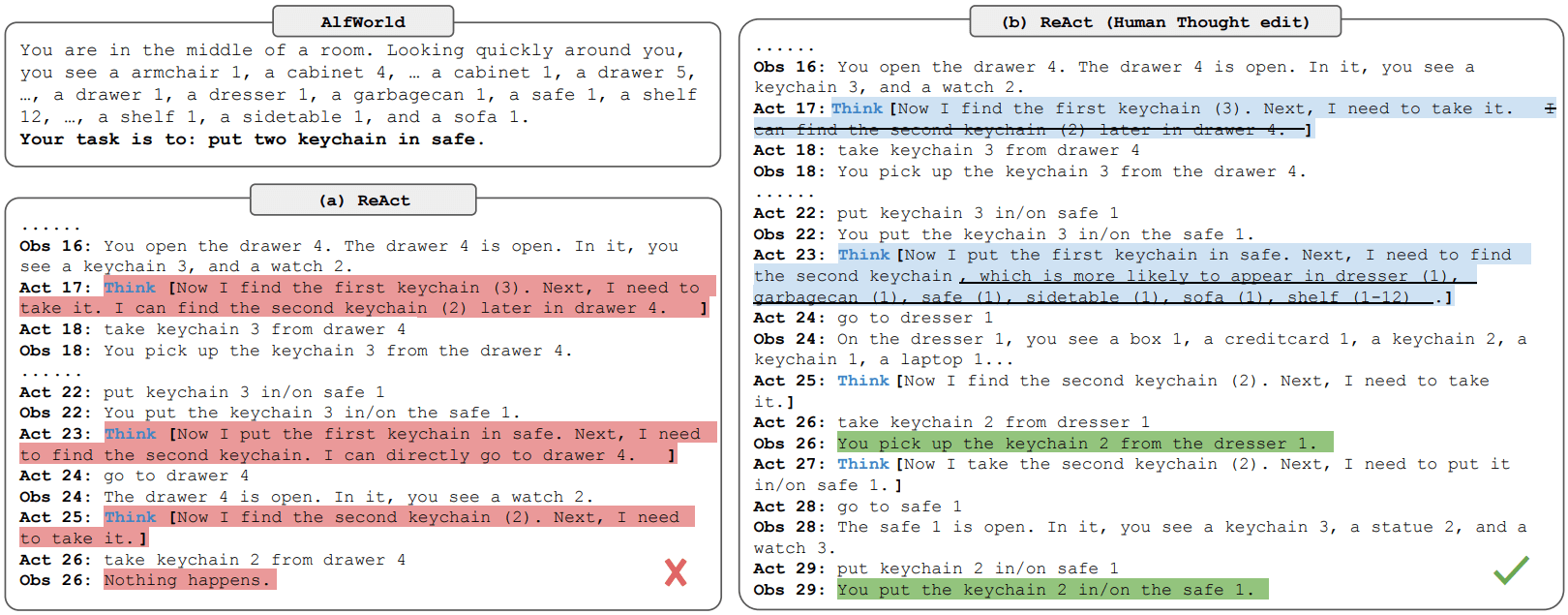

A.3 Correcciones de comportamiento para la implicación humana en el ciclo en ALFWorld

También exploramos las interacciones del bucle de compromiso humano con ReAct que permitían a los humanos inspeccionar y editar las trazas de razonamiento de ReAct. La Figura 5 muestra que simplemente eliminando una frase alucinatoria en el Acto 17 y añadiendo unas pocas pistas en el Acto 23, se puede hacer que ReAct cambie significativamente su comportamiento, se alinee con estas ediciones del pensamiento humano y complete con éxito la tarea. Desde el punto de vista humano, resolver una tarea de este tipo resulta mucho más sencillo, ya que se pasa de introducir docenas de acciones a editar sólo unos pocos pensamientos, lo que permite un nuevo tipo de colaboración hombre-máquina. Observamos que la edición de políticas de este tipo es difícil para Act y los enfoques de RL anteriores, porque los humanos no pueden cambiar los parámetros del modelo y cambiar unas pocas acciones puede no modificar el resto del comportamiento del modelo. Este paradigma también va más allá del diálogo humano para actualizar objetivos o subobjetivos, como se describe en Huang et al. (2022b): mientras que la edición de ideas de ReAct puede hacer todo esto, también puede modificar cualquiera de las creencias internas del modelo, estilos de razonamiento o soporte de espacio de pensamiento flexible para resolver mejor la tarea. Creemos que esta es una dirección apasionante para la alineación humana y dejamos una investigación más sistemática como trabajo futuro.

Figura 5: Ejemplos de correcciones de comportamiento HCI utilizando ReAct en AlfWorld. (a) La trayectoria ReAct falla debido al pensamiento alucinatorio (comportamiento 17). (b) Simplemente editando las dos mentes (comportamientos 17, 23) por un humano, la trayectoria ReAct produce la trayectoria de razonamiento deseada y la acción con éxito.

B Detalles experimentales

B.1 Detalles de ajuste del cuestionario Hot Topics

Para todos los ajustes finos, utilizamos un tamaño de lote de 64. En el PaLM-8B, realizamos 4.000 pasos de ajuste fino para los métodos ReAct y Act, y 2.000 pasos de ajuste fino para los métodos Standard y CoT. En el PaLM-62B, realizamos un ajuste fino de 4.000 pasos para los métodos ReAct y Act y de 1.000 pasos para los métodos Standard y CoT. Comprobamos que los métodos ReAct y Act suelen beneficiarse de más pasos de entrenamiento (y más datos de entrenamiento), mientras que los métodos estándar y CoT empiezan a degradarse poco después del ajuste fino.

B.2 Detalles del estilo instantáneo ALFWORLD

Para los experimentos de ablación de estilo inmediato, se volvieron a anotar las mismas trayectorias de expertos utilizadas en ReAct, y estas trayectorias contenían internamente un denso pensamiento de retroalimentación externa que limitaba a ReAct-IM a considerar únicamente (1) la descomposición del objetivo actual y (2) el subobjetivo actual que debe completarse. En concreto, ReAct-IM carece de (1) el pensamiento que determina cuándo se ha completado un subobjetivo (2) el pensamiento que determina cuál debería ser el siguiente subobjetivo (3) el pensamiento que induce al LLM a referirse a su conocimiento interno preentrenado para identificar las posibles ubicaciones de los elementos en el entorno.

C PROMPTS

C.1 Cuestionario sobre temas candentes

Consejos de preguntas y respuestas

| Original | |

| Pregunta | Respuesta |

| ¿Cuál es el rango de elevación de la zona a la que se extiende el sector oriental de la orogenia del Colorado? | 1.800 a 7.000 pies |

| El músico y escritor satírico Allie Goertz escribió una canción sobre "Los Simpson". carácter ¿A quién puso Matt Groening el nombre de Nixon? | Richard Nixon |

| ¿Qué documental trata sobre grupos de rock finlandeses, Adam Clayton Powell o The Saimaa Gesture? | El gesto Saimaa |

| ¿Qué profesión tienen en común Nicholas Ray y Elia Kazan? | Director, guionista, actor |

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Revista Arthur |

| ¿Son conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Sí |

| Original | |

| cuestiones | solución |

| ¿Cuál es el rango de elevación de la extensión oriental de la orogenia del Colorado? | De 1.800 a 7.000 pies. |

| El músico y escritor satírico Allie Goertz escribió una canción sobre el personaje de Los Simpson Milhouse, de Matt Groening, que debe su nombre a ¿qué hombre de Nixon? | Richard Nixon. |

| ¿Qué es el documental sobre la banda de rock finlandesa Adam Clayton Powell o las acciones de Saimaa? | Operación Saïmaa |

| ¿Qué carreras tienen en común Nicholas Ray y Elia Kazan? | Director, guionista, actor |

| ¿Qué revista se fundó antes, Arthur's Magazine o First for Women? | Revista Arthur |

| ¿Son conocidos Pavel Urizon y Leonid Levin por el mismo tipo de trabajo? | sea |

| Actuar | ||

| Pregunta | Acción | Observación |

| ¿Cuál es el rango de elevación de la zona a la que se extiende el sector oriental de la orogenia del Colorado? | Buscar [Colorado orogeny] | La orogenia del Colorado fue un episodio de construcción de montañas (una orogenia) en Colorado y sus alrededores. |

| Búsqueda [sector oriental] | (Resultado 1 / i) El sector oriental se extiende hasta las Altas Llanuras y se denomina orogenia de las Llanuras Centrales. | |

| Buscar [High Plains] | Las Altas Llanuras hacen referencia a una de las dos regiones terrestres diferenciadas. | |

| Buscar[High Plains (Estados Unidos)] | Las Altas Llanuras son una subregión de las Grandes Llanuras. De este a oeste, las Altas Llanuras se elevan entre 550 y 2.130 m (1.800 y 7.000 pies). [3] | |

| Acabado | [1.800 a 7.000 pies] | |

| El músico y escritor satírico Allie Goertz escribió una canción sobre el personaje Milhouse de "Los Simpson", al que Matt Groening puso el nombre de ¿quién? | Buscar [Milhouse] | Milhouse Mussolini Van Houten es un personaje recurrente de la serie de televisión animada de Fox Los simpsons al que pone voz Pamela Hayden y que fue creado por Matt Los Simpson, interpretado por Pamela Hayden y creado por Matt Groening. |

| Búsqueda | (Resultado 1 / l) Milhouse debe su nombre al presidente estadounidense Richard Nixon, cuyo segundo nombre era Milhous. | |

| Acabado | [Richard Nixon] | |

| ¿Qué documental trata sobre grupos de rock finlandeses, Adam clayton Powell o The Saimaa Gesture? | Buscar [Adam clayton Powell] | No se ha encontrado [Adam clayton Powell]. Similares: ['Adam Clayton Powel III', 'Seventh Avenue (Manhattan)', 'Adam clayton Powell Jr. State office Building', 'Isabel Washington Powell', 'Adam Clayton Powell (film)', 'Adam Clayton Powell (film)']. Powell', 'Adam Clayton Powell (película)', 'Giancarlo Esposito']. |

| Buscar [Adam clayton Powell (película)] | Adam Clayton Powell es un documental estadounidense de 1989 dirigido por Richard Kilberg sobre el ascenso y la caída del influyente político afroamericano Adam Clayton Powell Jr.[3][4], que posteriormente se emitió como parte de la serie de televisión The American Experience. La película trata sobre el ascenso y la caída del influyente político afroamericano Adam Clayton Powell Jr.[3][4] Más tarde se emitió como parte de la serie de PB The American Experience. | |

| Acabado | [El gesto Saimaa] | |

| ¿Qué profesión tienen en común Nicholas Ray y Elia Kazan? | Buscar [Nicholas Ray] | Nicholas Ray (nacido Raymond Nicholas Kienzle Jr., ) 7 de agosto de 1911 - 16 de junio de 1979) fue un director de cine, guionista y actor estadounidense, conocido sobre todo por la película de 1955 Rebelde sin causa. película de 1955 Rebelde sin causa. |

| Buscar [Elia Kazan] | Elia Kazan fue un director de cine y teatro, productor, guionista y actor estadounidense. | |

| Finish [director, guionista, actor] | ||

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Buscar [Arthur's Magazine] | Arthur's Magazine (1844-1846) fue una revista literaria estadounidense publicada en Filadelfia en el siglo XIX. |

| Buscar [First for Women] | First for Women es una revista femenina publicada por Bauer Media Group en EE.UU.[1] La revista se fundó en 1989. | |

| Finish [Arthur's Magazine] | ||

| ¿Eran conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Buscar [Pavel Urysohn] | Pavel Samuilovich Urysohn (3 de febrero de 1898 - 17 de agosto de 1924) fue un matemático soviético conocido sobre todo por sus contribuciones a la teoría de dimensiones. |

| Buscar [Leonid Levin] | Leonid Anatolievich Levin es un matemático soviético-estadounidense y ordenador científico. | |

| Terminar[sí] | ||

| Actuar | ||

| cuestiones | movimiento | atención |

| ¿Cuál es el rango de elevación de la zona en la que se extiende la sección oriental de la orogenia del Colorado? | Buscar [Colorado Mountain Building Campaign] | La orogenia del Colorado es un movimiento de construcción de montañas (orogenia) que tuvo lugar en Colorado y sus alrededores. |

| Encontrar [Sector Este] | (Resultados 1 / i) La sección oriental se extiende hasta las Altas Llanuras y se conoce como orogenia de las Llanuras Centrales. | |

| Buscar [High Plains] | Las Altas Llanuras se refieren a una de dos zonas distintas: | |

| Búsqueda [High Plains (USA)] | Las Altas Llanuras son una subregión de las Grandes Llanuras. De este a oeste, la elevación de las Altas Llanuras se eleva desde unos 550 metros (1.800 pies) hasta 2.130 metros (7.000 pies)[3]. [3] | |

| cumplir | [1.800 a 7.000 pies] | |

| El músico y escritor satírico Allie Goertz escribió una canción sobre Milhouse, el personaje de Los Simpson, ¿a quién dio nombre Matt Groening? | Buscar [Milhouse] | Milhouse Mussolini Van Houten es un personaje residente de la serie de televisión animada de Fox Los Simpson, al que pone voz Pamela Hayden y que fue creado por Matt Groening. |

| Buscar [fuente con nombre] | (Resultados 1 / l) Milhouse debe su nombre a Richard Nixon, Presidente de los Estados Unidos, cuyo segundo nombre era Milhous. | |

| cumplir | [Richard Nixon] | |

| ¿Qué documental trata sobre un grupo de rock finlandés, Adam Clayton Powell o The Saimaa Gesture? | Buscar [Adam Clayton Powell] | No se encontró [Adam Clayton Powell]. Similares: ['Adam Clayton Powel III', 'Seventh Avenue (Manhattan)', 'Adam clayton Powell Jr. State Office Building', 'Isabel Washington Powell', 'Adam Powell', 'Adam Clayton Powell (película)', 'Giancarlo Esposito']. |

| Búsqueda [Adam Clayton Powell (película)] | Adam Clayton Powell es un documental estadounidense de 1989 dirigido por Richard Kilberg. La película sigue el ascenso y la caída del influyente político afroamericano Adam Clayton Powell Jr. [3] [4] Posteriormente se emitió como parte de la serie de PBS The American Experience. | |

| cumplir | [El gesto Saimaa] | |

| ¿Qué carreras tienen en común Nicholas Ray y Elia Kazan? | Buscar [Nicholas Ray] | Nicholas Ray (de nombre real Raymond Nicholas Kienzle Jr.,) 7 de agosto de 1911 - 16 de junio de 1979) fue un director de cine, guionista y actor estadounidense, conocido sobre todo por la película de 1955 Rebelde sin causa. |

| Buscar [Elia Kazan] | Elia Kazan es un director de cine y teatro, productor, guionista y actriz estadounidense. | |

| Terminado [director, guionista, actor] | ||

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Buscar en [Arthur's Magazine]. | Arthur's Magazine (1844-1846) fue una revista literaria estadounidense publicada en Filadelfia (Estados Unidos) en el siglo XIX. |

| Buscar [First for Women] | First for Women es una revista femenina publicada en Estados Unidos por Bauer Media Group[1]. Fue fundada en 1989. [1] La revista se lanzó en 1989. | |

| Finish [Arthur's Magazine] | ||

| ¿Son conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Buscar [Pavel Urysohn] | Pavel Samuilovich Urysohn (3 de febrero de 1898 - 17 de agosto de 1924) fue un matemático soviético conocido por sus contribuciones a la teoría dimensional de números. |

| Buscar [Leonid Levin] | Leonid Anatolievich Levin fue un matemático e informático soviético-estadounidense. | |

| Completado [sí] | ||

| CoT | ||

| Pregunta | Pensamiento | Respuesta |

| ¿Cuál es el rango de elevación de la zona a la que se extiende el sector oriental de la orogenia del Colorado? | Pensemos paso a paso. El sector oriental de la orogenia del Colorado se extiende hasta las Altas Llanuras. Las Altas Llanuras se elevan entre 1.800 y 7.000 pies, por lo que la respuesta es de 1.800 a 7.000 pies. Las Altas Llanuras se elevan entre 1.800 y 7.000 pies, por lo que la respuesta es de 1.800 a 7.000 pies. | 1.800 a 7.000 pies |

| El músico y escritor satírico Allie Goertz escribió una canción sobre el personaje Milhouse de "Los Simpson", al que Matt Groening puso el nombre de ¿quién? | Milhouse debe su nombre al presidente estadounidense Richard Nixon, así que la respuesta es Richard Nixon. | Richard Nixon |

| ¿Qué documental trata sobre grupos de rock finlandeses, Adam Clayton Powell o The Saimaa Gesture? | Pensemos paso a paso. Adam Clayton Powell (película) es un documental sobre un político afroamericano, no sobre grupos de rock finlandeses. Adam Clayton Powell (película) es un documental sobre un político afroamericano, no sobre grupos de rock finlandeses. | El gesto Saimaa |

| ¿Qué profesión tienen en común Nicholas Ray y Elia Kazan? | Las profesiones de Nicholas Ray son director, guionista y actor. Las profesiones de Elia Kazan son director, productor, guionista y actor. Las profesiones de Elia Kazan son director, productor y actor. | director, guionista, actor |

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Pensemos paso a paso. Arthur's Magazine se fundó en 1844. First for Women se fundó en 1989. 1844 (Arthur's Magazine) < 1989 (First for Women), por lo que Arthur's Magazine empezó primero. | Revista Arthur |

| ¿Eran conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Pensemos paso a paso. Pavel Urysohn es matemático. Leonid Levin es matemático e informático. Así que Pavel Urysohn y Leonid Levin tienen el mismo tipo de trabajo. | Sí |

| CoT | ||

| cuestiones | proceso de reflexión | solución |

| ¿Cuál es el rango de elevación de la zona en la que se extiende la sección oriental de la orogenia del Colorado? | Veámoslo paso a paso. La sección oriental de la orogenia del Colorado se extiende hasta las Altas Llanuras. La elevación de las Altas Llanuras se eleva desde unos 1.800 pies hasta 7.000 pies, por lo que la respuesta es de 1.800 a 7.000 pies. | De 1.800 a 7.000 pies. |

| El músico y escritor satírico Allie Goertz escribió una canción sobre Milhouse, el personaje de Los Simpson, ¿a quién dio nombre Matt Groening? | Veámoslo paso a paso.Milhouse lleva el nombre de Richard Nixon, Presidente de Estados Unidos, así que la respuesta es Richard Nixon. | Richard Nixon. |

| ¿Es el documental sobre la banda de rock finlandesa Adam Clayton Powell o El gesto de Semaja? | Considerémoslo paso a paso. Adam Clayton Powell (película) es un documental sobre un político afroamericano, no sobre un grupo de rock finlandés. Por tanto, un documental sobre una banda de rock finlandesa sería El gesto de Semaja. | El gesto de Semaya |

| ¿Qué carreras tienen en común Nicholas Ray e Ilya Kazan? | Veámoslo paso a paso. La profesión de Nicholas Ray es director, guionista y actor. La profesión de Ilya Kazan es director, productor, guionista y actor. Así pues, Nicholas Ray e Ilya Kazan comparten la profesión de director, guionista y actor. | Director, guionista, actor |

| ¿Fue primero Arthur's Magazine o First for Women? | Veámoslo paso a paso. Arthur's Magazine se fundó en 1844. First for Women se fundó en 1989. 1844 (Arthur's Magazine) < 1989 (First for Women), por lo que Arthur's Magazine se fundó primero. | Revista Arthur |

| ¿Son conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Veámoslo paso a paso.Pavel Urysohn es matemático.Leonid Levin es matemático e informático. Así que Pavel Urysohn y Leonid Levin tienen el mismo tipo de trabajo. | sea |

| ReAct | |||

| Pregunta | Pensamiento | Acción | Observación |

| ¿Cuál es el rango de elevación de la zona a la que se extiende el sector oriental de la orogenia del Colorado? | Necesito buscar orogenia del Colorado, encontrar la zona a la que se extiende el sector oriental de la orogenia del Colorado y, a continuación, encontrar el rango de elevación de la zona. | Buscar [Colorado orogeny] | La orogenia del Colorado fue un episodio de construcción de montañas (anorogenia) en Colorado y sus alrededores. |

| No menciona el sector oriental, así que tengo que buscarlo. | Búsqueda [sector oriental] | (Resultado 1 / 1) El sector oriental se extiende hasta las Altas Llanuras y se denomina orogenia de las Llanuras Centrales. | |

| El sector oriental de la orogenia del Colorado se extiende hasta las Altas Llanuras. Así que tengo que buscar en las Altas Llanuras y encontrar su rango de elevación. | Buscar [High Plains] | Las Llanuras Altas hacen referencia a una de las dos regiones terrestres siguientes | |

| En su lugar, tengo que buscar High Plains (Estados Unidos). | Buscar[High Plains (Estados Unidos)] | Las Altas Llanuras son una subregión de las Grandes Llanuras. De este a oeste, las Altas Llanuras se elevan entre 550 y 2.130 m (1.800 y 7.000 pies). [3] | |

| Las Altas Llanuras se elevan desde unos 1.800 a 7.000 pies, por lo que la respuesta es de 1.800 a 7.000 pies. | Final [1.800 a 7.000 pies] | ||

| El músico y escritor satírico Allie Goertz escribió una canción sobre el personaje Milhouse de "Los Simpson", al que Matt Groening puso el nombre de ¿quién? | La pregunta se simplifica a "Milhouse, el personaje de Los Simpson, se llama así por quién". Sólo tengo que buscar Milhouse y encontrar por quién se llama. | Buscar [Milhouse] | Milhouse Mussolini Van Houten es un personaje recurrente de la serie de televisión animada de Fox Los Simpson, al que pone voz Pamela Hayden y que fue creado por Matt Groening. Los Simpson, con voz de Pamela Hayden y creado por Matt Groening. |

| El párrafo no dice a quién debe su nombre Milhouse, quizá pueda buscar "named after". | Búsqueda | (Resultado 1 / 1) Milhouse debe su nombre al presidente estadounidense Richard Nixon, cuyo segundo nombre era Milhous. | |

| Milhouse debe su nombre al presidente estadounidense Richard Nixon, así que la respuesta es Richard Nixon. | Finish [Richard Nixon] | ||

| ¿Qué documental trata sobre grupos de rock finlandeses, Adam Clayton Powell o The Saimaa Gesture? | Tengo que buscar Adam Clayton Powell y The Saimaa Gesture, y encontrar qué documental trata sobre grupos de rock finlandeses. | Buscar [Adam Clayton Powell] | No se ha encontrado [Adam Clayton Powell]. Similares: ['Adam Clayton Powell III', 'Seventh Avenue (Manhattan)', 'Adam Clayton Powell Jr. Clayton Powell Jr. State Office Building', 'Isabel Washington Powell', 'Adam Powell Adam Clayton Powell (película)', 'Giancarlo Esposito']. |

| Para encontrar el documental, puedo buscar Adam Clayton Powell (película). | Búsqueda [Adam Clayton Powell (película)] | Adam Clayton Powell es una película documental estadounidense de 1989 dirigida por Richard Kilberg. La película trata sobre el ascenso y la caída del influyente político afroamericano Adam Clayton Powell Jr.[3][4] Más tarde se emitió como parte de la serie de PBS The American Experience. La película trata sobre el ascenso y la caída del influyente político afroamericano Adam Clayton Powell Jr.[3][4] Más tarde se emitió como parte de la serie de PBS The American Experience. | |

| Adam Clayton Powell (película) es un documental sobre un político afroamericano, no sobre grupos de rock finlandeses, por lo que el documental sobre grupos de rock finlandeses debe ser The Saimaa Gesture. Así que el documental sobre grupos de rock finlandeses debe ser "El gesto Saimaa". | Terminar [El gesto Saimaa] | ||

| ¿Qué profesión tienen en común Nicholas Ray y Elia Kazan? | Tengo que buscar Nicholas Ray y Elia Kazan, encontrar sus profesiones y luego encontrar la profesión que tienen en común. | Buscar [Nicholas Ray] | Nicholas Ray (nacido Raymond Nicholas Kienzle Jr., 7 de agosto de 1911 - 16 de junio de 1979) fue un director de cine, guionista y actor estadounidense, conocido sobre todo por la película de 1955 Rebelde sin causa. película de 1955 Rebelde sin causa. |

| Las profesiones de Nicholas Ray son director, guionista y actor. Ahora tengo que buscar las profesiones de Elia Kazan. | Buscar [Elia Kazan] | Elia Kazan fue un director de cine y teatro, productor, guionista y actor estadounidense. | |

| Las profesiones de Elia Kazan son director, productor, guionista y actor. Así que las profesiones que Nicholas Ray y Elia Kazan tienen en común son director, guionista y actor. | Finish [director, guionista, actor] | ||

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Tengo que buscar en Arthur's Magazine y First for Women, y encontrar cuál empezó primero. | Buscar [Arthur's Magazine] | Arthur's Magazine (1844-1846) fue una revista literaria estadounidense publicada en Filadelfia en el siglo XIX. |

| Arthur's Magazine empezó a publicarse en 1844. Ahora tengo que buscar en First for Women. | Buscar [First for Women] | First for Women es una revista femenina publicada por Bauer Media Group en EE.UU.[1] La revista se fundó en 1989. | |

| First for Women se fundó en 1989. 1844 (Arthur's Magazine) < 1989 (First for Women), por lo que Arthur's Magazine se fundó primero. . | Finish [Arthur's Magazine] | ||

| ¿Eran conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Tengo que buscar a Pavel Urysohn y Leonid Levin, encontrar sus tipos de trabajo y averiguar si son lo mismo. | Buscar [Pavel Urysohn] | Pavel Samuilovich Urysohn (3 de febrero de 1898 - 17 de agosto de 1924) fue un matemático soviético conocido sobre todo por sus contribuciones a la teoría de dimensiones. |

| Pavel Urysohn es matemático. Tengo que buscar a Leonid Levin a continuación y encontrar su tipo de trabajo. | Buscar [Leonid Levin] | Leonid Anatolievich Levin es un matemático e informático soviético-estadounidense. | |

| Leonid Levin es matemático e informático, por lo que Pavel Urysohn y Leonid Levin tienen el mismo tipo de trabajo. | Terminar[sí] | ||

ReAct | ||

| cuestiones | reflexiones | actuar |

| ¿Cuál es el rango de elevación de la región en la que se extiende la sección oriental del cinturón orogénico del Colorado? | Necesito buscar en el cinturón orogénico del Colorado, encontrar la zona a la que se extiende la sección oriental y, a continuación, encontrar el rango de elevación de esa zona. | Búsqueda [Colorado orogenic belt] |

| No se menciona la sección oriental. Así que tengo que buscar la sección oriental. | Encontrar [Sector Este] | |

| La sección oriental del cinturón orogénico del Colorado se extiende hasta las Altas Llanuras. Así que tengo que buscar en las Altas Llanuras y encontrar su rango de elevación. | Buscar [High Plains] | |

| La elevación de las Altas Llanuras se eleva desde unos 1.800 pies hasta 7.000 pies, por lo que la respuesta es de 1.800 pies a 7.000 pies. | Finalización [1800 pies a 7000 pies] | |

| El músico y escritor satírico Allie Goertz escribió una canción sobre el personaje Milhouse de "Los Simpson", ¿a quién dio el nombre Matt Groening? | La pregunta se simplifica a quién debe su nombre el personaje Milhouse de "Los Simpson". Sólo tengo que buscar Milhouse y averiguar a quién debe su nombre. | Buscar [Milhouse] |

| El párrafo no dice a quién debe su nombre Milhouse, así que quizá pueda buscar "named after...". Lleva el nombre de". | Buscar [nombre de... Nombre] | |

| Milhouse debe su nombre al presidente de EE.UU. Richard Nixon, así que la respuesta es Richard Nixon. | Terminado [Richard Nixon] | |

| ¿El documental trata sobre el grupo de rock finlandés Adam Clayton Powell o sobre El gesto de Saimaa? | Tengo que buscar Adam Clayton Powell y The Saimaa Gesture y averiguar qué documental trata sobre un grupo de rock finlandés. | Buscar [Adam Clayton Powell] |

| Para encontrar el documental, buscaría Adam Clayton Powell (película). | Buscar [Adam Clayton Powell (película)] | |

| Adam Clayton Powell (película) es un documental sobre un político afroamericano, no sobre un grupo de rock finlandés. Así que un documental sobre una banda de rock finlandesa tendría que ser The Saimaa Gesture. | Terminar [El gesto Saimaa] | |

| ¿Qué carreras tienen en común Nicholas Ray y Elia Kazan? | Tengo que buscar Nicholas Ray y Elia Kazan, encontrar sus ocupaciones y luego averiguar qué ocupaciones tienen en común. | Buscar [Nicholas Ray] |

| La ocupación de Nicholas Ray era director, guionista y actor. Ahora tengo que buscar a Elia Kazan y encontrar su profesión. | Buscar [Elia Kazan] | |

| La profesión de Elia Kazan es director, productor, guionista y actor. Así pues, Nicholas Ray y Elia Kazan comparten la misma profesión de director, guionista y actor. | Finalización [director, guionista, actor] | |

| ¿Qué revista empezó primero, Arthur's Magazine o First for Women? | Tengo que buscar Arthur's Magazine y First for Women y averiguar cuál empezó primero. | Buscar en [Arthur's Magazine]. |

| Arthur's Magazine se fundó en 1844. Ahora tengo que buscar First for Women. | Buscar [First for Women] | |

| First for Women se fundó en 1989. 1844 (Arthur's Magazine) < 1989 (First for Women), por lo que Arthur's Magazine se fundó primero. | Finish [Arthur's Magazine] | |

| ¿Son conocidos Pavel Urysohn y Leonid Levin por el mismo tipo de trabajo? | Tengo que buscar a Pavel Urysohn y Leonid Levin para saber qué tipo de trabajo hacen y averiguar si son lo mismo. | Buscar [Pavel Urysohn] |

| Pavel Urysohn es matemático. Ahora tengo que buscar a Leonid Levin y averiguar a qué se dedica. | Buscar [Leonid Levin] | |

| Leonid Levin es matemático e informático. Así que Pavel Urysohn y Leonid Levin tienen el mismo tipo de trabajo. | Completado [sí] | |

C.2 Extracción de hechos y conjunto de datos de validación/FEVER

Fiebre Prompts

| Original | |

| Pregunta: Determine si hay observaciones que APOYEN o REFUTEN una alegación, o si NO HAY INFORMACIÓN SUFICIENTE. | |

| Reclamación | Respuesta |

| Nikolaj Coster-Waldau trabajó con la Fox Broadcasting Company. | APOYA |

| Stranger Things está ambientada en Bloomington, Indiana. | REFUTA |

| Beautiful alcanzó el número dos en el Billboard Hot 100 en 2003. | INFORMACIÓN INSUFICIENTE |

| Original | |

| Problema: determinar si hay observaciones que apoyen o refuten la afirmación, o si la información es insuficiente. | |

| representaciones | solución |

| Nikolaj Coster-Waldau ha trabajado con Fox Broadcasting Co. | adyuvante |

| Stranger Things está ambientada en Bloomington, Indiana. | retorta |

| La canción "Beautiful" alcanzó el número dos de la lista Billboard Hot 100 en 2003. | Información insuficiente |

| Actuar | ||

| Pregunta: Determine si hay observaciones que APOYEN o REFUTEN una alegación, o si NO HAY INFORMACIÓN SUFICIENTE. | ||

| Reclamación | Acción | Observación |

| Nikolaj Coster-waldau trabajó con la Fox Broadcasting Company. | Buscar [Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (nacido el 27 de julio de 1970) es un actor y productor danés. Se graduó en la Escuela Nacional Danesa de Artes Escénicas de Copenhague en 1993,[1] y obtuvo su primer papel en Dinamarca con la película Nightwatch (1994). Copenhague en 1993,[1] y obtuvo su primer papel en Dinamarca con la película Nightwatch (1994). Interpretó a Jaime Lannister en la serie fantástica de HBO Juego de tronos, por la que recibió dos nominaciones a los premios Primetime Emmy como Actor Actor de reparto en una serie dramática. Coster-Waldau ha aparecido en numerosas películas en su Dinamarca natal y en Escandinavia, como Headhunters (2011) y Mil veces buenas noches (2013). . En Estados Unidos, su primer papel en el cine fue en la película bélica Black Hawk derribado (2001), en la que interpretó a Gary Gordon, condecorado con la Medalla de Honor[2]. A continuación, interpretó a un detective en la efímera serie de televisión de la Fox New York City. En Estados Unidos, su primer papel en el cine fue en la película bélica Black Hawk derribado (2001), en la que interpretó a Gary Gordon, condecorado con la Medalla de Honor.[2] Posteriormente, interpretó a un detective en la serie de televisión de corta duración de la Fox New Amsterdam (2008), y apareció en la película para televisión de la Fox Virtuality (2009), originalmente concebida como un piloto. |

| Finish[APOYA] | ||

| Stranger Things está ambientada en Bloomington, Indiana. | Buscar [Stranger Things] | Stranger Things es una serie de televisión estadounidense de ciencia ficción y terror creada por los hermanos Duffer. Ambientada en la década de 1980, principalmente en el Ambientada en la década de 1980, principalmente en la ciudad ficticia de Hawkins, Indiana, la serie se centra en una serie de misterios y eventos sobrenaturales que ocurren alrededor de la ciudad y su impacto en un conjunto de personajes infantiles y adultos. conjunto de personajes infantiles y adultos. |

| Finish [REFUTA] | ||

| Beautiful alcanzó el número dos en el Billboard Hot 100 en 2003. | Buscar [Beautiful] | No se pudo encontrar [Beautiful]. Similares: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (película) Beautiful (canción de Christina Aguilera)', 'Life Is Beautiful']. |

| Buscar [Beautiful (canción de Christina Aguilera) | "Beautiful" es una canción grabada por la cantante estadounidense Christina Aguilera para su cuarto álbum de estudio, Stripped (2002). | |

| Búsqueda [Billboard Hot 100] | (Resultado 1 / 3) La canción alcanzó el número dos en el Billboard Hot 100 en Estados Unidos, donde fue certificada Oro por 500.000 unidades vendidas. | |

| Finalizar [NO HAY INFORMACIÓN SUFICIENTE] | ||

| Actuar | ||

| Problema: Determinar si una observación apoya o refuta una afirmación o si la información es insuficiente. | ||

| representaciones | actuar | atención |

| Nikolaj Coster-waldau ha trabajado con Fox Broadcasting Company. | Buscar [Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (nacido el 27 de julio de 1970) es un actor y productor danés. Se graduó en la Academia Nacional Danesa de Artes Escénicas de Copenhague en 1993,[1] y consiguió su primer papel en Dinamarca con la película Night Watch (1994). Recibió dos nominaciones a los premios Primetime Emmy al mejor actor de reparto en una serie dramática por su interpretación de Jaime Lannister en la serie fantástica de HBO Juego de tronos.Coster-Waldau ha aparecido en numerosas películas en su país natal, Dinamarca, y en Escandinavia, como Headhunters (2011) y Mil veces buenas noches (2013). En Estados Unidos, su primer papel en el cine fue el de Gary Gordon, galardonado con la Medalla de Honor, en la película bélica Black Hawk derribado (2001).[2] También interpretó a un detective en la serie de televisión de corta duración de Fox New Amsterdam (2008) y apareció en la película para televisión de Fox Virtua Fighter (2009), que en un principio iba a ser un episodio piloto. |

| Hecho [apoyado] | ||

| Stranger Things está ambientada en Bloomington, Indiana. | Buscar [Stranger Things] | Stranger Things es una serie estadounidense de ciencia ficción y terror creada por los hermanos Duff. Ambientada en la década de 1980, los episodios tienen lugar principalmente en la ciudad ficticia de Hawkins, Indiana, y giran en torno a una serie de acontecimientos misteriosos y sobrenaturales que ocurren en la ciudad y sus efectos en un grupo de niños y personajes adultos. |

| Hecho [Refutación] | ||

| Beautiful" alcanzó el número dos en la lista Billboard Hot 100 en 2003. | Buscar [Beautiful] | No se ha encontrado [Beautiful]. Similares: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (film) Beautiful (canción de Christina Aguilera)', 'Life Is Beautiful']. |

| Buscar [Beautiful (canción de Christina Aguilera)] | "Beautiful" es una canción grabada por la cantante estadounidense Christina Aguilera para su cuarto álbum de estudio Stripped, publicado en 2002. | |

| Buscar [Billboard Hot 100] | (Resultados 1 / 3) La canción alcanzó el número dos de la lista Billboard Hot 100 en Estados Unidos y fue certificada como disco de oro con 500.000 unidades vendidas. | |

| Completado [información insuficiente] | ||

| CoT | ||

| Pregunta: Determine si hay observaciones que APOYEN o REFUTEN una alegación, o si NO HAY INFORMACIÓN SUFICIENTE. | ||

| Reclamación | Pensamiento | Respuesta |

| Nikolaj Coster-Waldau trabajó con la Fox Broadcasting Company. | Nikolaj William Coster-Waldau apareció en 2009 en el telefilme de Fox Virtuality, por lo que ha trabajado con la Fox Broadcasting Company. | APOYA |

| Stranger Things está ambientada en Bloomington, Indiana. | Stranger Things está en la ciudad ficticia de Hawkins, Indiana, no en Bloomington, Indiana. | REFUTA |

| Beautiful alcanzó el número dos en el Billboard Hot 100 en 2003. | La canción alcanzó el número dos en el Billboard Hot 100 en Estados Unidos, pero no estoy seguro de si fue en 2003. | INFORMACIÓN INSUFICIENTE |

| COT | ||

| Problema: determinar si hay observaciones que apoyen o refuten una afirmación, o si la información es insuficiente. | ||

| mirador | reflexiones | solución |

| Nikolaj Coster-Waldau ha trabajado con Fox Broadcasting Co. | Nikolai William Coster-Waldau protagonizó en 2009 el telefilme de Fox Virtual Life, por lo que ha trabajado con la Fox Broadcasting Company. | adyuvante |

| Stranger Things tiene lugar en Bloomington, Indiana. | Stranger Things tiene lugar en la ciudad ficticia de Hawkins, Indiana, no en Bloomington, Indiana. | retorta |

| La canción "Beautiful" alcanzó el número dos de la lista Billboard Hot 100 en 2003. | La canción alcanzó el número dos en el Billboard Hot 100, pero no se sabe con certeza si fue en 2003. | Información insuficiente |

| ReAct | |||

| Pregunta: Determine si hay observaciones que APOYEN o REFUTEN una alegación, o si NO HAY INFORMACIÓN SUFICIENTE. | |||

| Reclamación | Pensamiento | Acción | Observación |

| Nikolaj Coster-Waldau trabajó con la Fox Broadcasting Company. | Tengo que buscar a Nikolaj Coster-Waldau y averiguar si ha trabajado con la Fox Broadcasting Company. | Buscar [Nikolaj Coster-Waldau] | Nikolaj William Coster-Waldau (nacido el 27 de julio de 1970) es un actor y productor danés. Se graduó en la Escuela Nacional Danesa de Artes Escénicas de Copenhague en 1993,[1] y obtuvo su primer papel en Dinamarca con la película Nightwatch (1994). Copenhague en 1993,[1] y obtuvo su primer papel en Dinamarca con la película Nightwatch (1994). Interpretó a Jaime Lannister en la serie fantástica de HBO Juego de tronos, por la que recibió dos nominaciones a los premios Primetime Emmy como Actor Actor de reparto en una serie dramática. Coster-Waldau ha aparecido en numerosas películas en su Dinamarca natal y en Escandinavia, como Headhunters (2011) y Mil veces buenas noches (2013). . En Estados Unidos, su primer papel en el cine fue en la película bélica Black Hawk derribado (2001), en la que interpretó a Gary Gordon, condecorado con la Medalla de Honor[2]. A continuación, interpretó a un detective en la efímera serie de televisión de la Fox New York City. En Estados Unidos, su primer papel en el cine fue en la película bélica Black Hawk derribado (2001), en la que interpretó a Gary Gordon, condecorado con la Medalla de Honor.[2] Posteriormente, interpretó a un detective en la serie de televisión de corta duración de la Fox New Amsterdam (2008), y apareció en la película para televisión de la Fox Virtuality (2009), originalmente concebida como un piloto. |

| Como "apareció en el telefilme de Fox de 2009 Virtuality", debería haber trabajado con la Fox Broadcasting Company. | Finish[APOYA] | ||

| Stranger Things está ambientada en Bloomington, Indiana. | Debería buscar Stranger Things, y ver si está ambientada en Bloomington, Indiana. | Buscar [Stranger Things] | Stranger Things es una serie de televisión estadounidense de ciencia ficción y terror creada por los hermanos Duffer. Ambientada en la década de 1980, principalmente en el Ambientada en la década de 1980, principalmente en la ciudad ficticia de Hawkins, Indiana, la serie se centra en una serie de misterios y eventos sobrenaturales que ocurren alrededor de la ciudad y su impacto en un conjunto de personajes infantiles y adultos. conjunto de personajes infantiles y adultos. |

| La observación dice que está ambientada en un "pueblo ficticio de Hawkins, Indiana", por lo que no está ambientada en Bloomington. | Finish [REFUTA] | ||

| Beautiful alcanzó el número dos en el Billboard Hot 100 en 2003. | Tengo que buscar la canción Beautiful y averiguar si alcanzó el número dos en el Billboard Hot 100 en 2003. | Buscar [Beautiful] | No se pudo encontrar [Beautiful]. Similares: ['Beautiful', 'Beautiful, Beautiful', 'A Beautiful Mind (película) Beautiful (canción de Christina Aguilera)', 'Life Is Beautiful']. |

| Según las sugerencias, debería buscar "Beautiful (canción de Christina Aguilera)" para encontrar la canción. | Buscar [Beautiful (canción de Christina Aguilera)] | "Beautiful" es una canción grabada por la cantante estadounidense Christina Aguilera para su cuarto álbum de estudio, Stripped (2002). | |

| No menciona Billboard, así que tengo que buscar "Billboard Hot 100" para saber si alcanzó el número dos en él en 2003. | Búsqueda [Billboard Hot 100] | (Resultado 1 / 3) La canción alcanzó el número dos en el Billboard Hot 100 en Estados Unidos, donde fue certificada Oro por 500.000 unidades vendidas. | |