Qwen2.5-Coder Full Series: Potente, versátil y práctico.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 48.8K 00

breve

En la actualidad, nos complace ofrecer en código abierto la potente, diversa y útil familia de modelos Qwen2.5-Coder, y nos comprometemos a seguir avanzando en el desarrollo de las Open CodeLLM.

- formidableQwen2.5-Coder-32B-Instruct se convierte en el actual modelo de código abierto para SOTA, con capacidades de código que empatan con GPT-4o, demostrando capacidades de código fuertes y completas, así como buenas capacidades de propósito general y matemáticas.

- colectorQwen2.5-Coder ha cubierto los seis tamaños principales de modelos para satisfacer las necesidades de los distintos desarrolladores: el mes pasado pusimos en código abierto los tamaños de 1,5B y 7B, y esta vez ponemos en código abierto los tamaños de 0,5B, 3B, 14B y 32B.

- pragmáticaExploramos la utilidad de Qwen2.5-Coder en escenarios tanto de Asistente de Código como de Artefactos, y utilizamos algunos ejemplos para demostrar el potencial de Qwen2.5-Coder en escenarios del mundo real.

Potente: capacidad de código hasta el modelo de código abierto SOTA

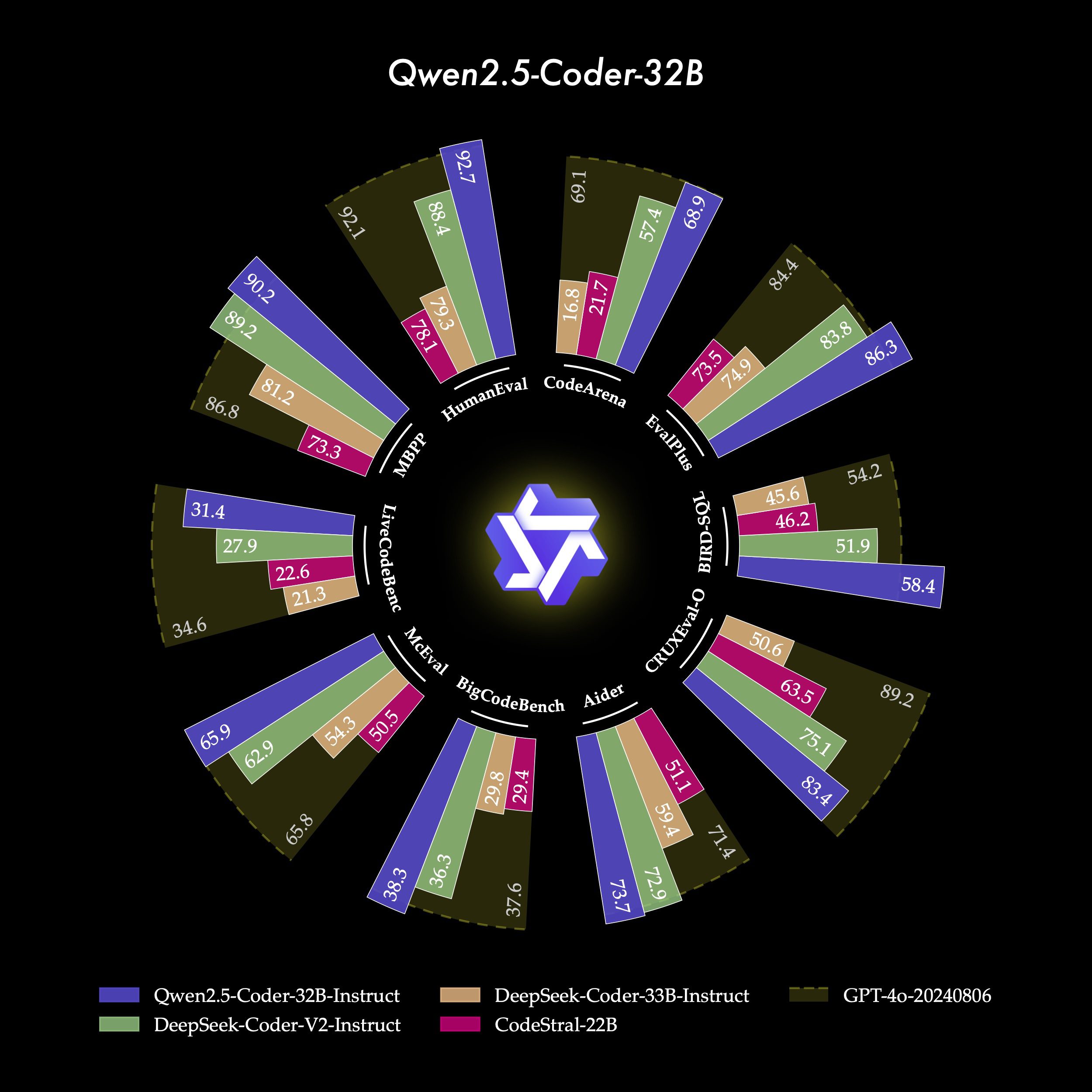

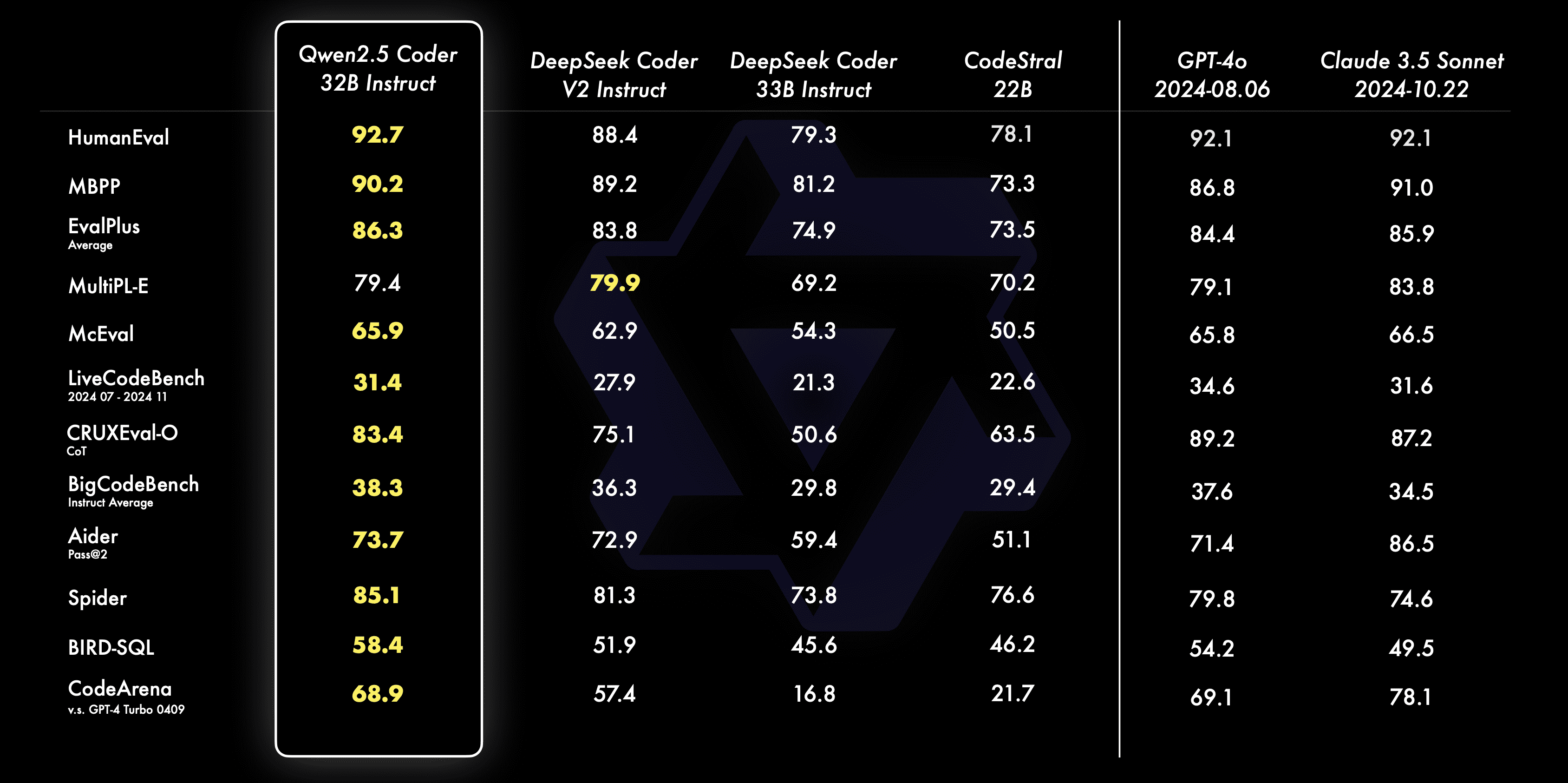

- generación de códigoQwen2.5-Coder-32B-Instruct, el modelo insignia de este código abierto, ha logrado el mejor rendimiento entre los modelos de código abierto en varias pruebas comparativas populares de generación de código (por ejemplo, EvalPlus, LiveCodeBench y BigCodeBench), y ha alcanzado un rendimiento competitivo con GPT-4o.

- Correcciones de códigoQwen2.5-Coder-32B-Instruct puede ayudar a los usuarios a corregir errores en su código y hacer que la programación sea más eficiente.Aider es un popular punto de referencia para la corrección de código, y Qwen2.5-Coder-32B-Instruct alcanza una puntuación de 73,7, que es comparable a GPT en Aider. Qwen2.5-Coder-32B-Instruct obtuvo una puntuación de 73,7 en Aider y su rendimiento fue comparable al de GPT-4o.

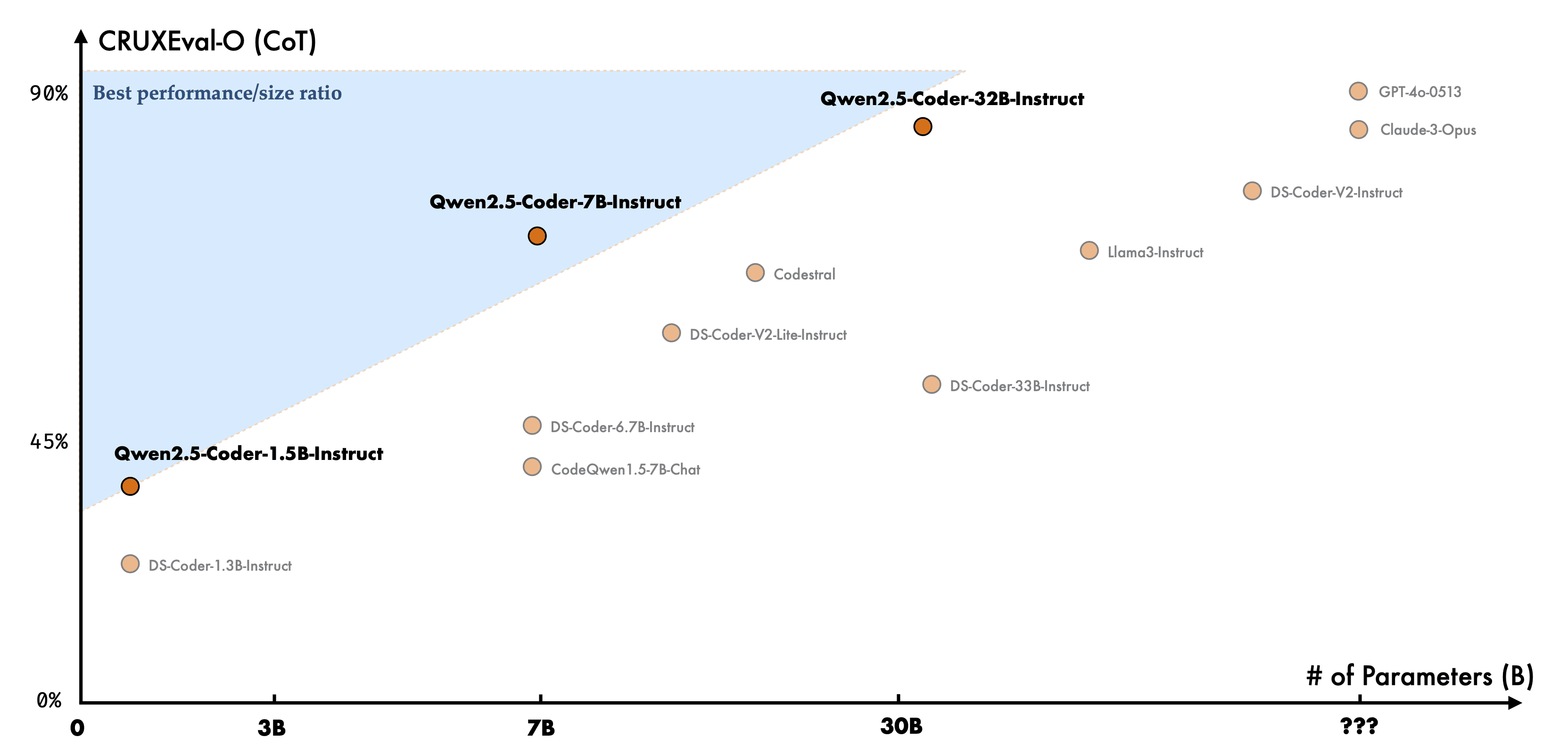

- razonamiento codificadoLa inferencia de código se refiere a la capacidad de un modelo para aprender el proceso de ejecución de código y predecir con precisión las entradas y salidas del modelo. Qwen2.5-Coder-7B-Instruct, publicado el mes pasado, ya demostró un buen rendimiento en capacidad de razonamiento de código, y el modelo 32B va aún más allá.

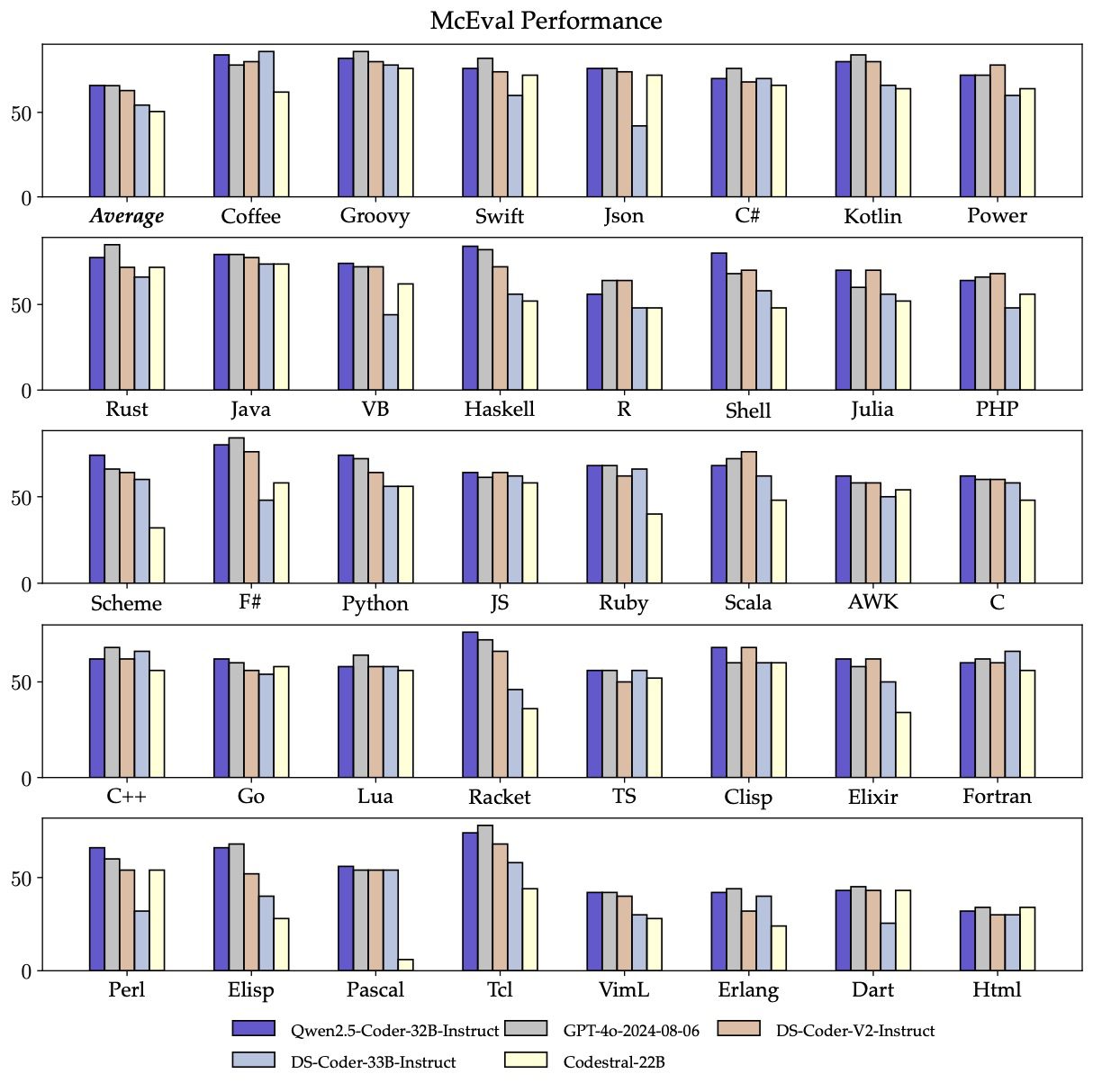

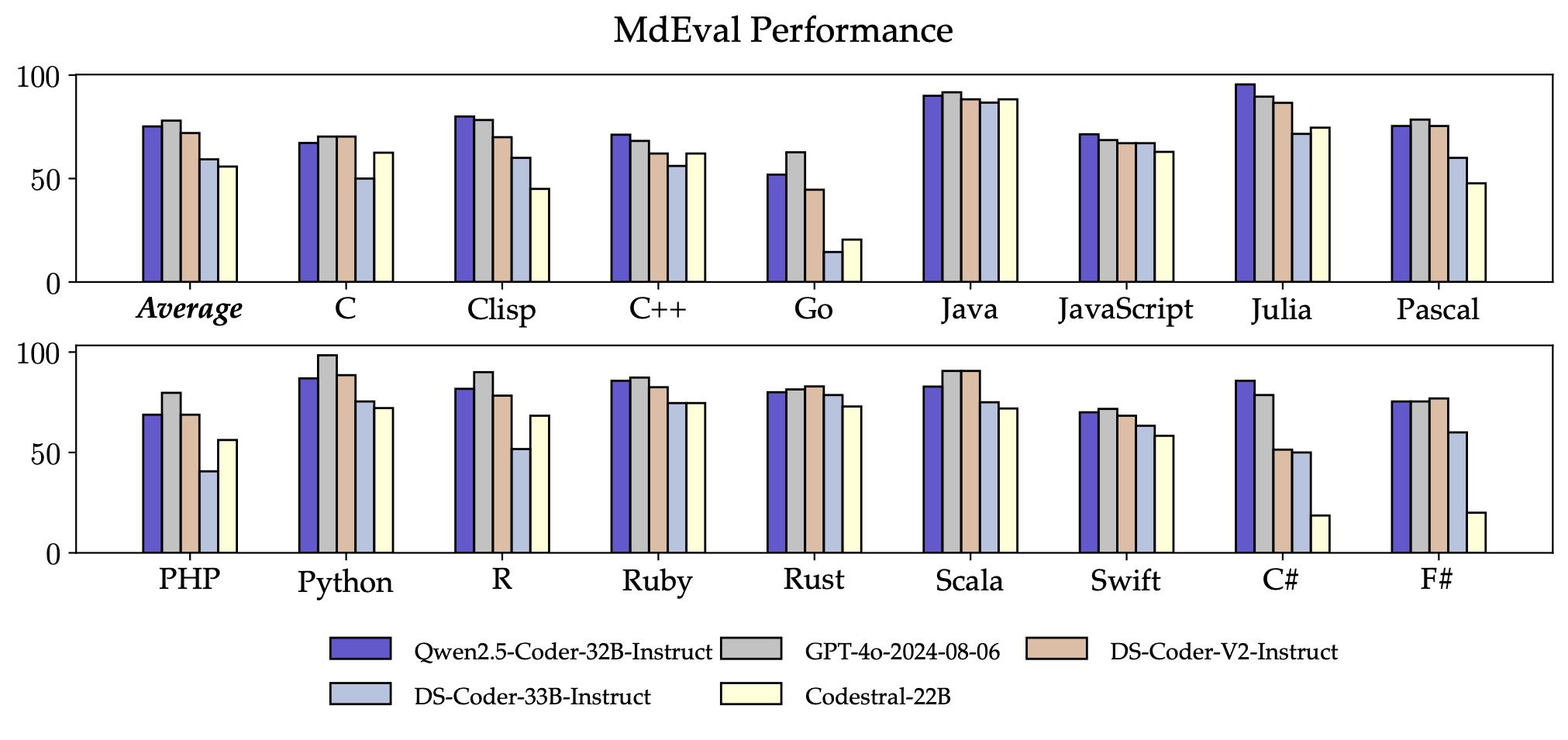

- multilingüeQwen2.5-Coder-32B-Instruct tiene un buen rendimiento en más de 40 lenguajes de programación, alcanzando una puntuación de 65,9 en McEval, con un rendimiento impresionante en Haskell, Racket, etc., gracias a nuestra exclusiva limpieza y racionamiento de datos en la fase de preentrenamiento.

Además, la capacidad de fijación de código en múltiples lenguajes de programación de Qwen2.5-Coder-32B-Instruct también es sorprendente, lo que ayudará a los usuarios a entender y modificar sus lenguajes de programación familiares, y aliviará en gran medida el coste de aprendizaje de lenguajes desconocidos.

Qwen2.5-Coder-32B-Instruct obtuvo una puntuación de 75,2 en MdEval, la más alta entre todos los modelos de código abierto.

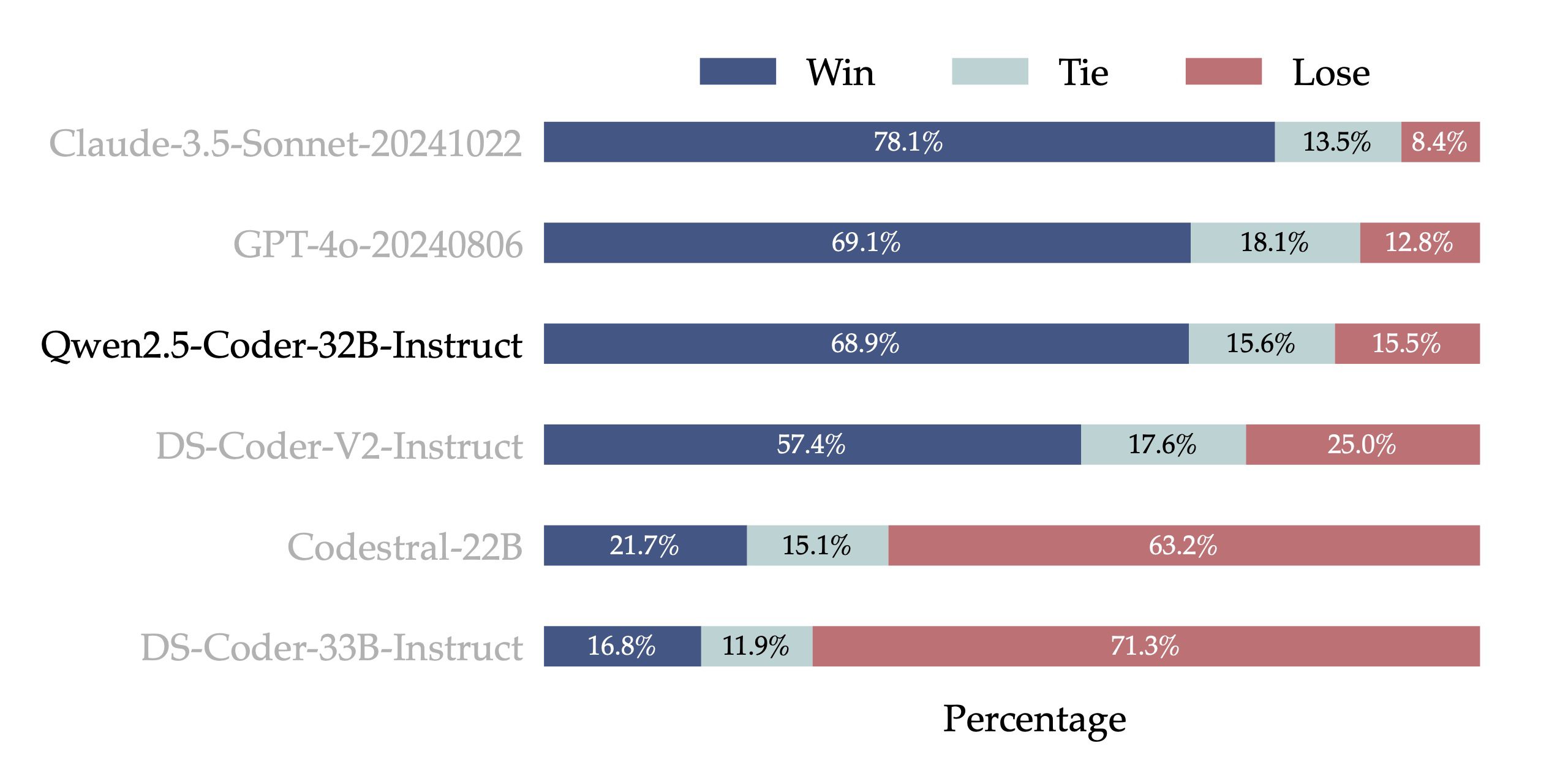

- Alineación de preferencias humanasCode Arena: Para probar el rendimiento de la alineación de Qwen2.5-Coder-32B-Instruct en las preferencias humanas, construimos Code Arena (similar a Arena Hard), un benchmark de evaluación de preferencias de código a partir de anotaciones internas. Utilizamos GPT-4o como modelo de evaluación para la alineación de preferencias, con una evaluación de "victoria de A frente a B", es decir, el porcentaje en el que la puntuación del modelo A supera a la del modelo B en el conjunto de instancias de prueba. Los resultados de la siguiente figura muestran la ventaja de Qwen2.5-Coder-32B-Instruct en la alineación de preferencias.

Versatilidad: gran variedad de tamaños de modelos

La familia de modelos de código abierto Qwen2.5-Coder consta de seis tamaños: 0,5B, 1,5B, 3B, 7B, 14B y 32B, que no sólo satisfacen las necesidades de los desarrolladores en diferentes escenarios de recursos, sino que también proporcionan un buen terreno de experimentación para la comunidad investigadora. La siguiente tabla muestra la información detallada del modelo:

| Modelos | Parámetros | Parámetros no Emb | Capas | Cabezales (KV) | Empalme | Contexto Longitud | Licencia |

|---|---|---|---|---|---|---|---|

| Qwen2.5-Codificador-0.5B | 0.49B | 0.36B | 24 | 14 / 2 | Sí | 32K | Apache 2.0 |

| Qwen2.5-Codificador-1.5B | 1.54B | 1.31B | 28 | 12 / 2 | Sí | 32K | Apache 2.0 |

| Qwen2.5-Codificador-3B | 3.09B | 2.77B | 36 | 16 / 2 | Sí | 32K | Investigación Qwen |

| Qwen2.5-Codificador-7B | 7.61B | 6.53B | 28 | 28 / 4 | No | 128K | Apache 2.0 |

| Qwen2.5-Codificador-14B | 14.7B | 13.1B | 48 | 40 / 8 | No | 128K | Apache 2.0 |

| Qwen2.5-Codificador-32B | 32.5B | 31.0B | 64 | 40 / 8 | No | 128K | Apache 2.0 |

Siempre hemos creído Ley de escalado Filosofía. Evaluamos el rendimiento de modelos Qwen2.5-Coder de diferentes tamaños en todos los conjuntos de datos para comprobar la eficacia de Scaling on Code LLMs.

Para cada tamaño, tenemos modelos Base e Instruct de código abierto, donde el modelo Base sirve de base para que los desarrolladores ajusten sus modelos, y el modelo Instruct es el modelo de alineación oficial disponible para el chat directo.

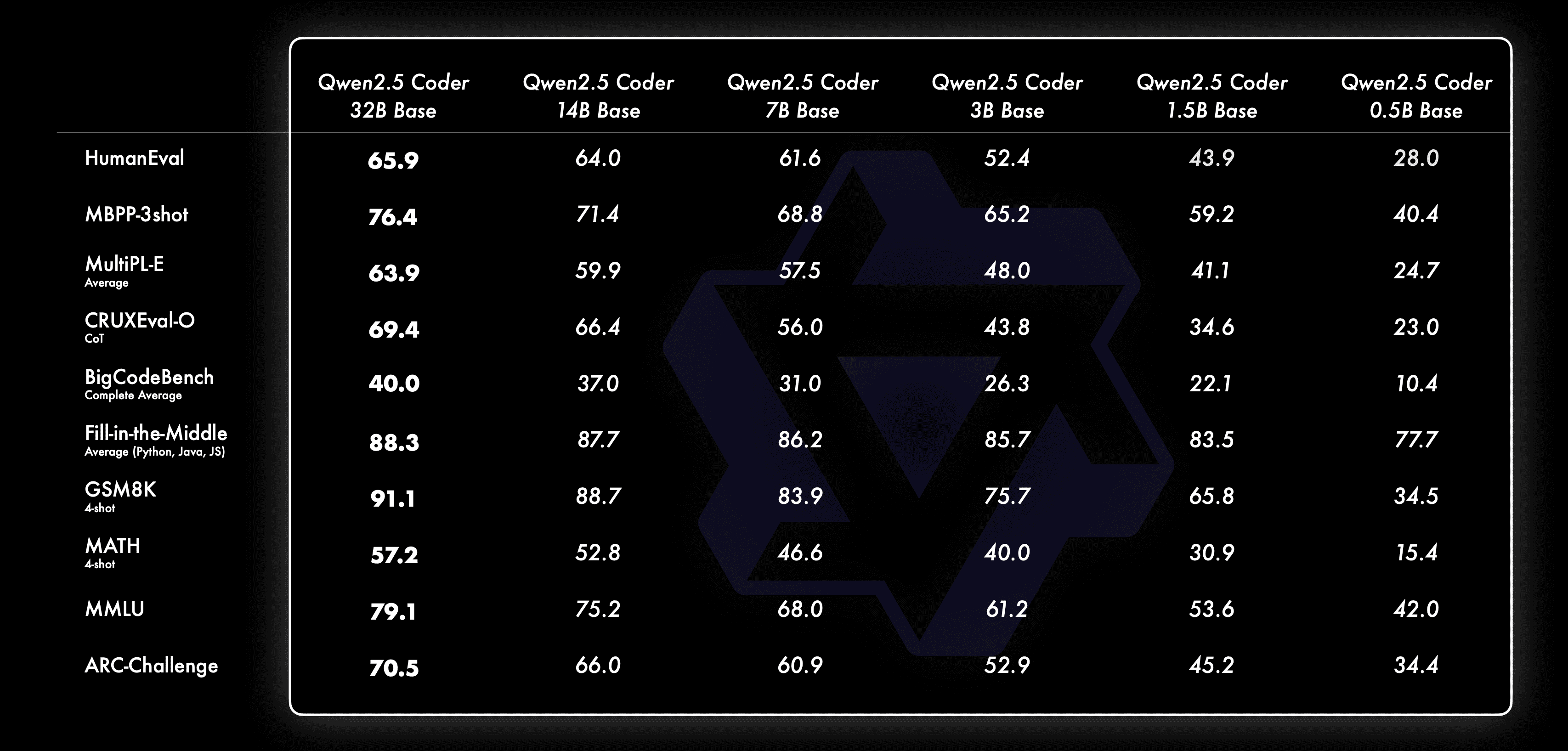

He aquí cómo se comporta el modelo Base con diferentes tamaños:

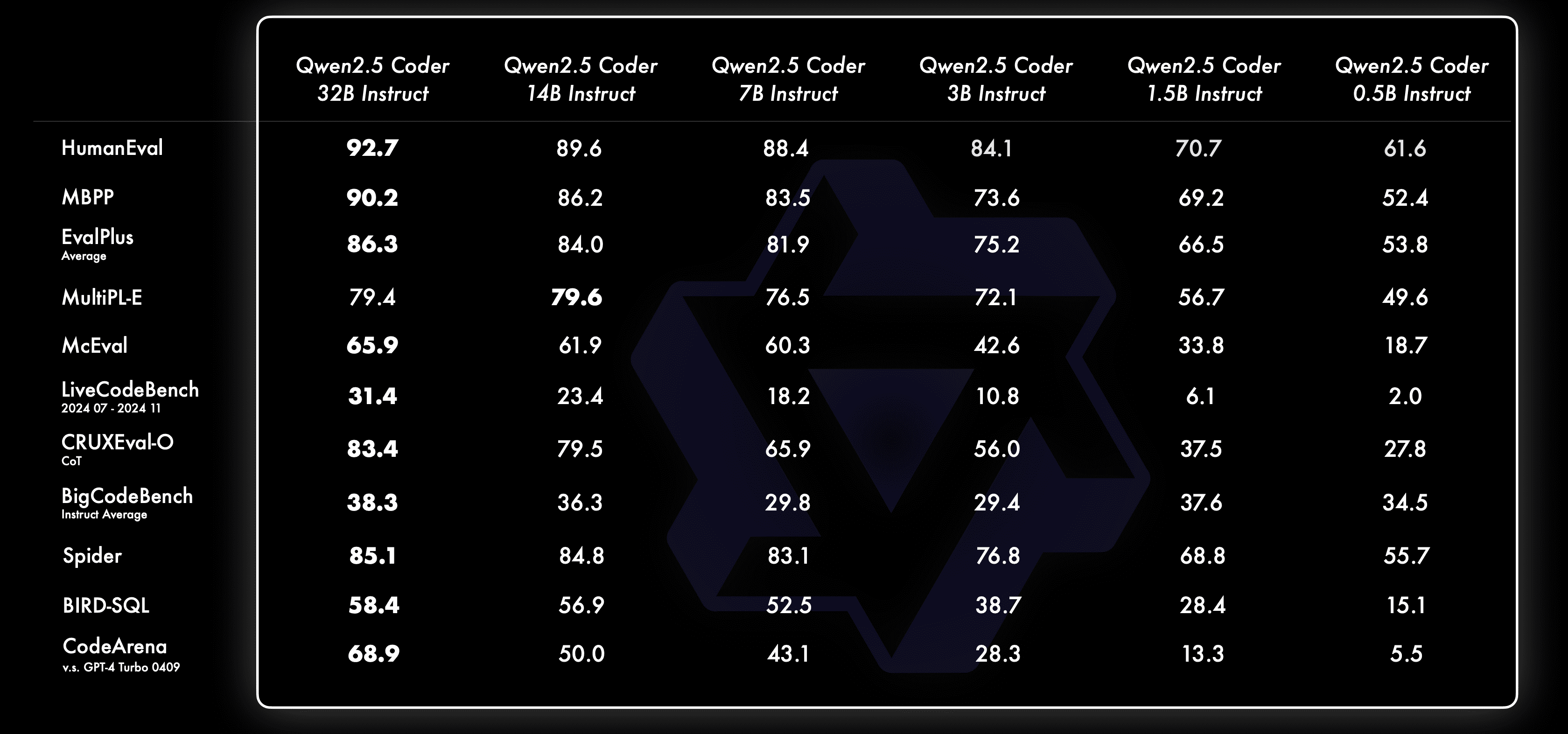

He aquí cómo se comporta el modelo Instruct con distintos tamaños:

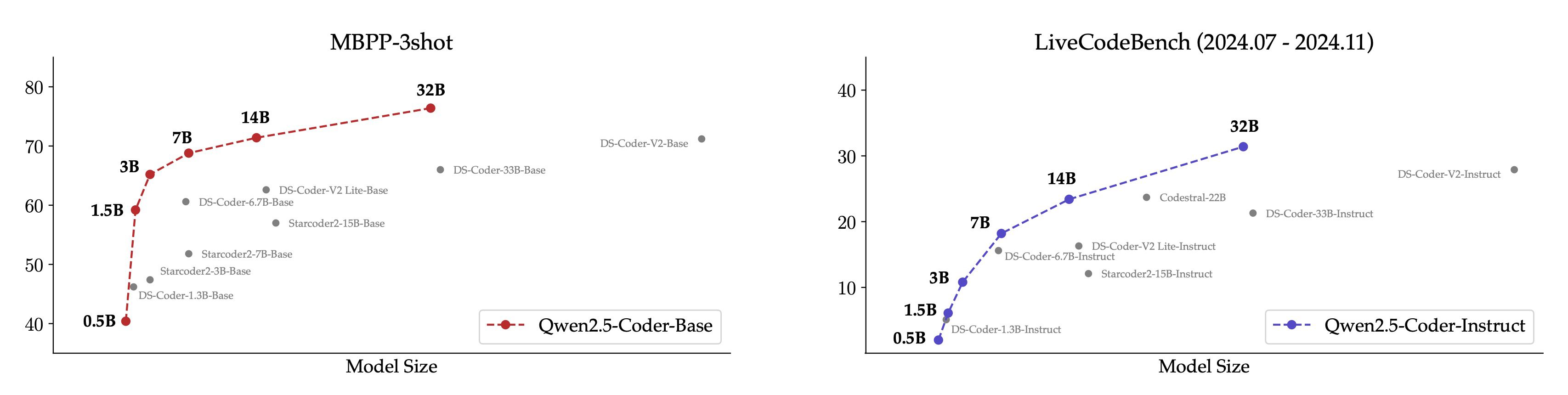

Para que resulte más intuitivo, mostramos una comparación entre distintos tamaños del modelo Qwen2.5-Coder y otros modelos de código abierto en el conjunto de datos principal.

- Para el modelo base, elegimos MBPP-3shot como índice de evaluación, y nuestros exhaustivos experimentos demuestran que MBPP-3shot es más adecuado para evaluar el modelo base y puede correlacionarse bien con el efecto real del modelo.

- Para el modelo Instruct, elegimos temas de LiveCodeBench de los últimos 4 meses (2024.07 - 2024.11) para su evaluación, y estos temas publicados recientemente que probablemente no se filtren en el conjunto de entrenamiento reflejan la capacidad OOD del modelo.

La esperada correlación positiva entre el tamaño del modelo y su eficacia, así como el hecho de que Qwen2.5-Coder consiguiera el rendimiento SOTA en todos los tamaños, nos anima a seguir explorando modelos Coder más grandes.

Práctica: Conoce a Cursor y los artefactos

Un Coder práctico ha sido siempre nuestra visión. Para ello, hemos explorado la aplicación práctica del modelo Qwen2.5-Coder en el contexto de los asistentes de código y los artefactos.

Qwen2.5-Coder 🤝 Cursor

Los asistentes de código inteligentes ya se utilizan ampliamente, pero actualmente se basan sobre todo en modelos de código cerrado, y esperamos que la aparición de Qwen2.5-Coder proporcione a los desarrolladores una alternativa amigable y potente.

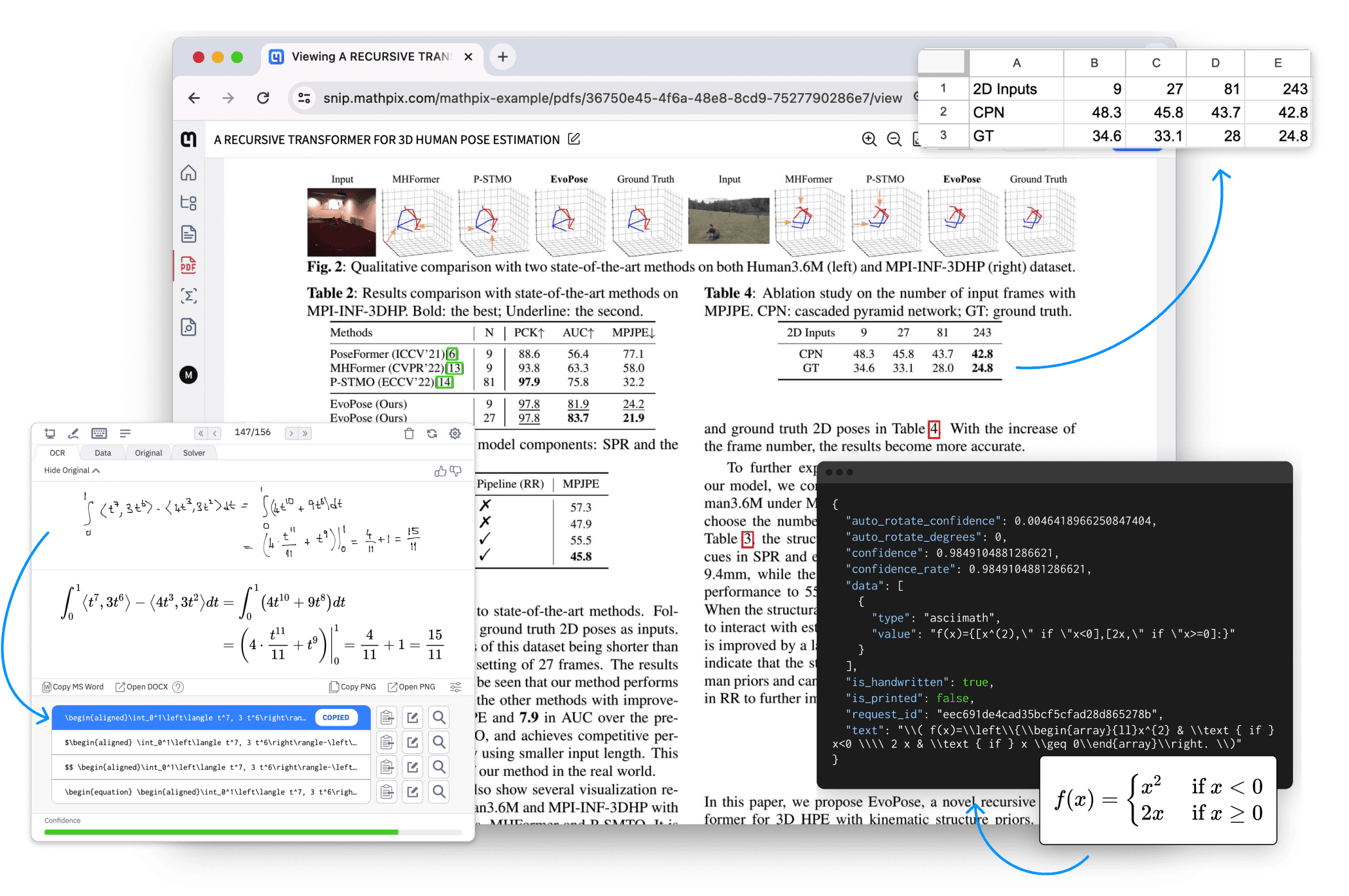

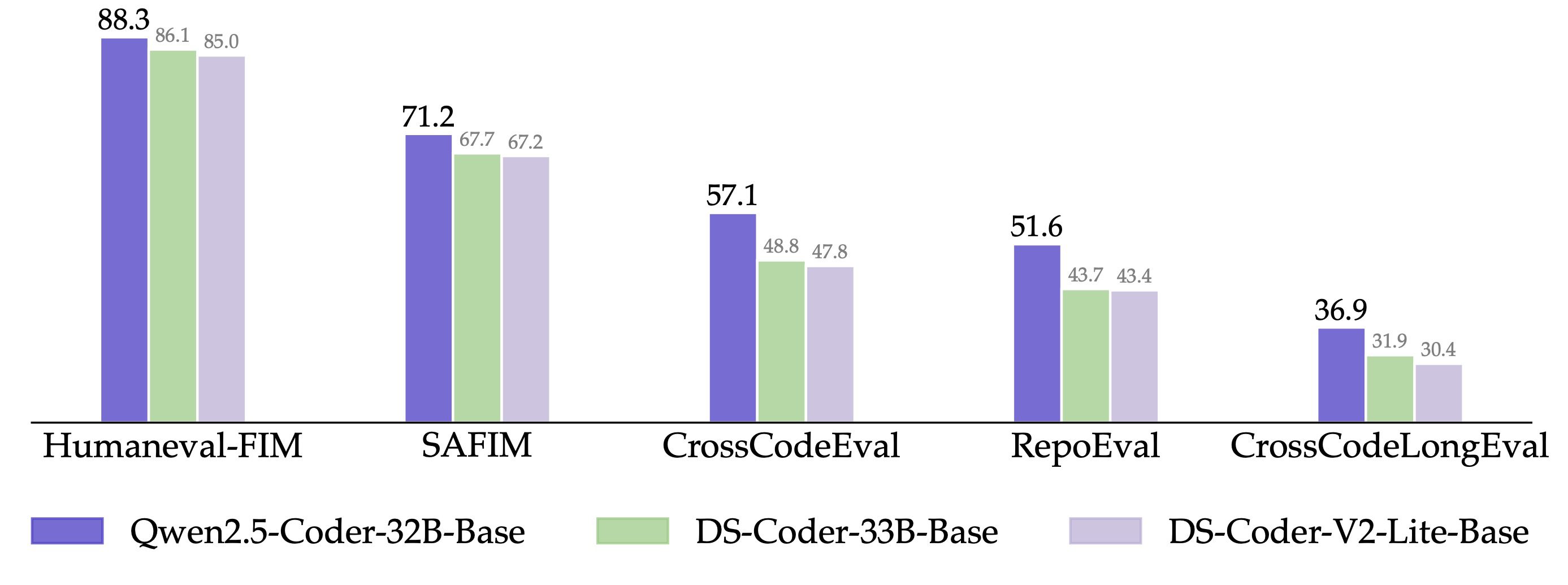

Además, Qwen2.5-Coder-32B ha demostrado una gran capacidad de compleción de código en el modelo preentrenado y ha logrado un rendimiento SOTA en cinco conjuntos de evaluación, incluidos Humaneval-Infilling, CrossCodeEval, CrossCodeLongEval, RepoEval y SAFIM.

Para mantener una comparación justa, controlamos la longitud máxima de la secuencia en 8k y utilizamos el modo Fill-in-the-Middle para las pruebas. En los 4 conjuntos de revisión de CrossCodeEval, CrossCodeLongEval, RepoEval y Humaneval-Infilling, evaluamos si el contenido generado es absolutamente igual a las etiquetas reales (Exact Match); y en SAFIM, utilizamos la tasa de éxito de ejecución de 1 vez (Pass@1) para la evaluación.

Qwen2.5-Coder 🤝 Artefactos

Artifacts es una de las aplicaciones más importantes para la generación de código que ayuda a los usuarios a crear algo apto para la visualización, y elegimos la aplicación Abrir WebUI Explora el potencial de Qwen2.5-Coder en escenarios de Artefactos, aquí tienes algunos ejemplos concretos:

Pronto pondremos en línea el modo de código en el sitio web oficial de Tongyi https://tongyi.aliyun.com, que admite todo tipo de aplicaciones de visualización, como sitios web generados con una sola frase, minijuegos y gráficos de datos. Te invitamos a probarlo.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...