Recuperación de propuestas.

Base de conocimientos de IAPublicado hace 2 años Círculo de intercambio de inteligencia artificial 35.4K 00

Original: TheRecuperación X densa: ¿qué granularidad de recuperación debemos utilizar?En

Nota: Este método es adecuado para un número reducido de modelos, como la serie OPENAI, la serie Claude, Mixtral, Yi, qwen, etc.

resúmenes

En las tareas de Procesamiento del Lenguaje Natural (PLN) de dominio abierto, la recuperación densa se ha convertido en un método importante para adquirir conocimiento contextual o del mundo relevante. Cuando utilizamos recuperadores densos aprendidos para recuperar corpus en el momento de la inferencia, una opción de diseño que a menudo se pasa por alto es la unidad de recuperación, es decir, la granularidad con la que se indexa el corpus, por ejemplo, documentos, párrafos o frases. Hemos comprobado que la elección de la unidad de recuperación afecta significativamente al rendimiento de la recuperación y de las tareas posteriores. En contraste con el enfoque tradicional que utiliza párrafos u oraciones, introducimos una nueva unidad de recuperación, las proposiciones, para una recuperación intensiva. Las proposiciones se definen como expresiones atómicas en el texto, cada una de las cuales encierra un hecho único y se presenta en un formato de lenguaje natural conciso y autocontenido. Comparamos empíricamente distintas granularidades de recuperación. Nuestros resultados muestran que la recuperación basada en proposiciones supera con creces a los enfoques tradicionales basados en párrafos u oraciones en la recuperación densa. Además, la recuperación por proposiciones mejora el rendimiento de las tareas posteriores de respuesta a preguntas (QA), ya que el texto recuperado contiene de forma más compacta la información relevante para la pregunta, reduciendo la necesidad de tokens de entrada largos y minimizando la inclusión de información irrelevante.

1 Introducción

Los recuperadores densos son una clase de técnicas utilizadas para acceder a fuentes externas de información para tareas intensivas en conocimiento. Antes de poder utilizar un recuperador denso aprendido para recuperar información de un corpus, una decisión de diseño importante que debemos tomar es la unidad de recuperación, es decir, la granularidad con la que segmentamos e indexamos el corpus recuperado en nuestro razonamiento. En la práctica, la elección de las unidades de recuperación, por ejemplo, documentos, trozos de longitud fija de párrafos o frases, etc., suele estar predeterminada en función de cómo se instanció o entrenó el modelo de recuperación densa.

En este artículo, exploramos una cuestión de investigación que se ha descuidado en el razonamiento de recuperación densa: ¿con qué granularidad de recuperación deberíamos segmentar e indexar el corpus recuperado? Descubrimos que elegir la granularidad de recuperación adecuada en el momento del razonamiento puede ser una estrategia sencilla pero eficaz para mejorar el rendimiento de los recuperadores densos tanto para la recuperación como para las tareas posteriores.

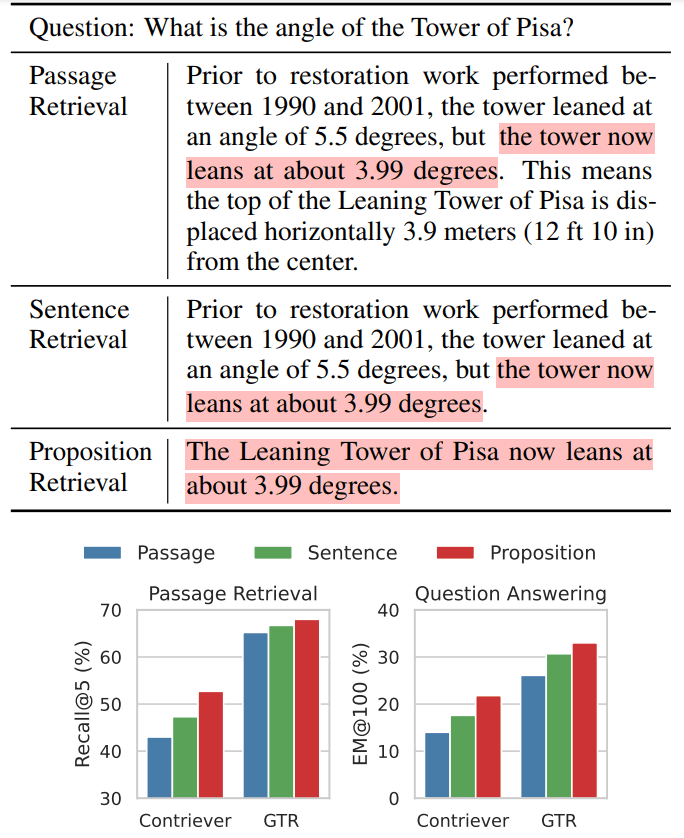

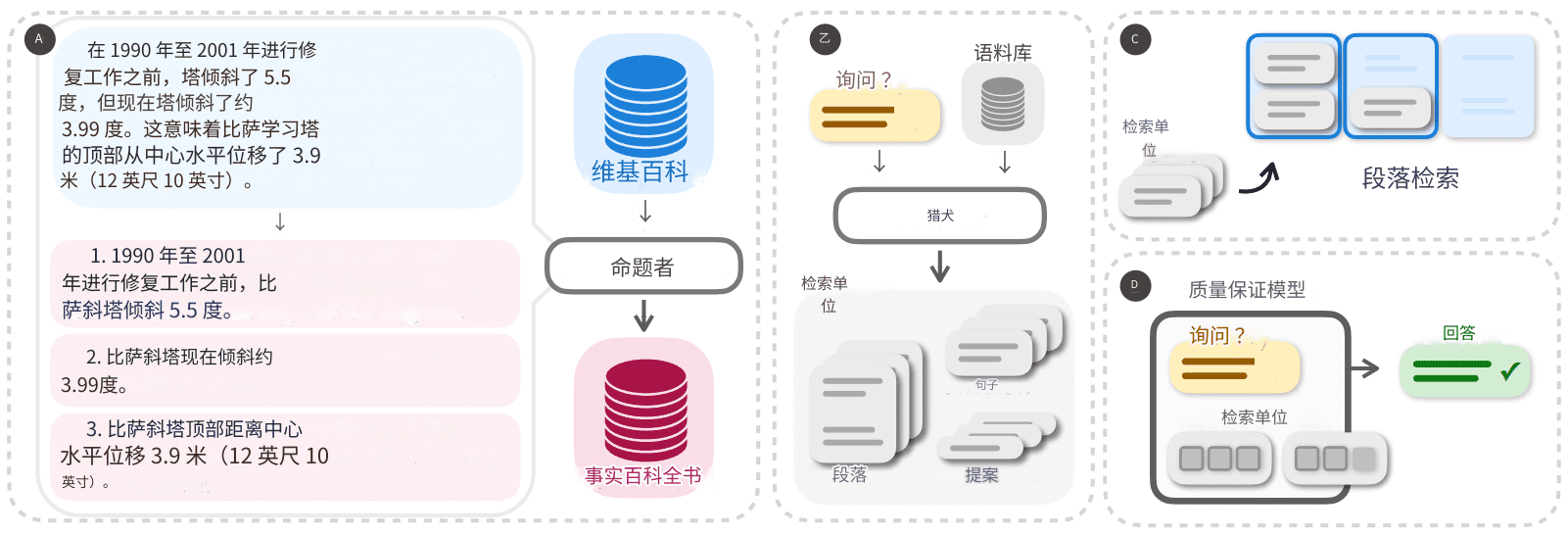

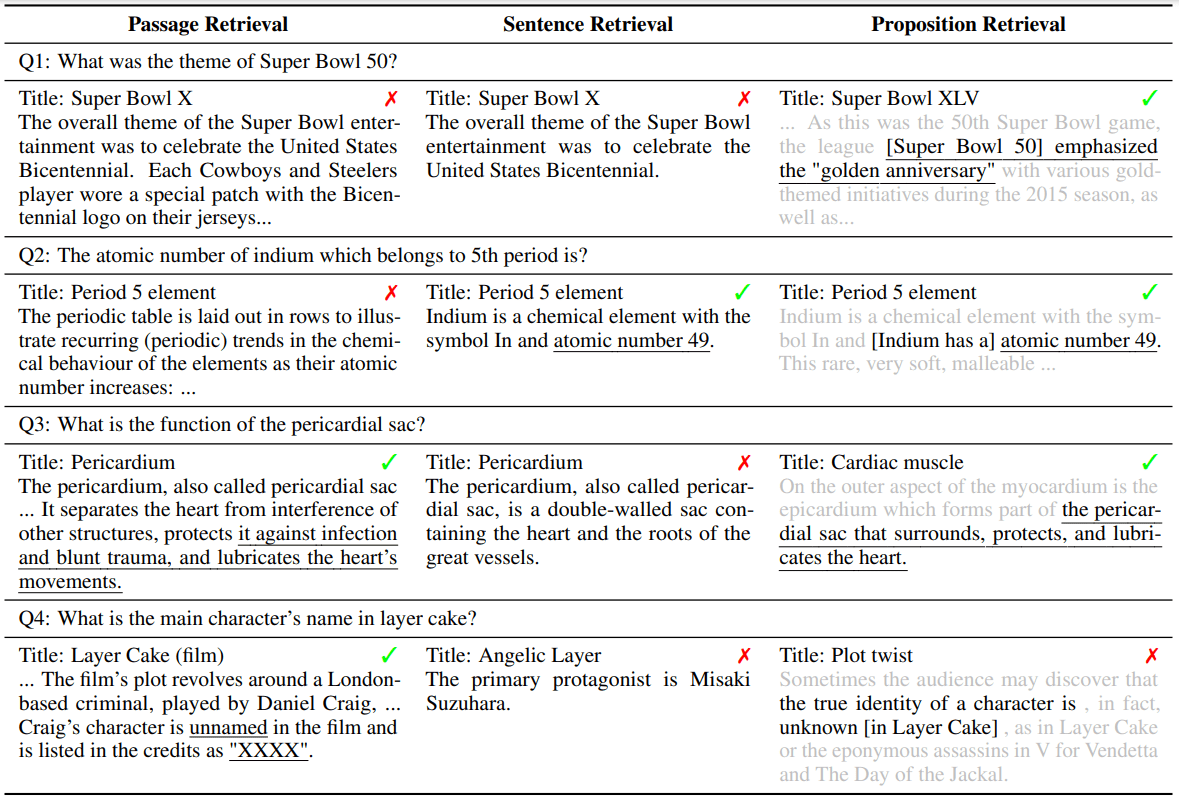

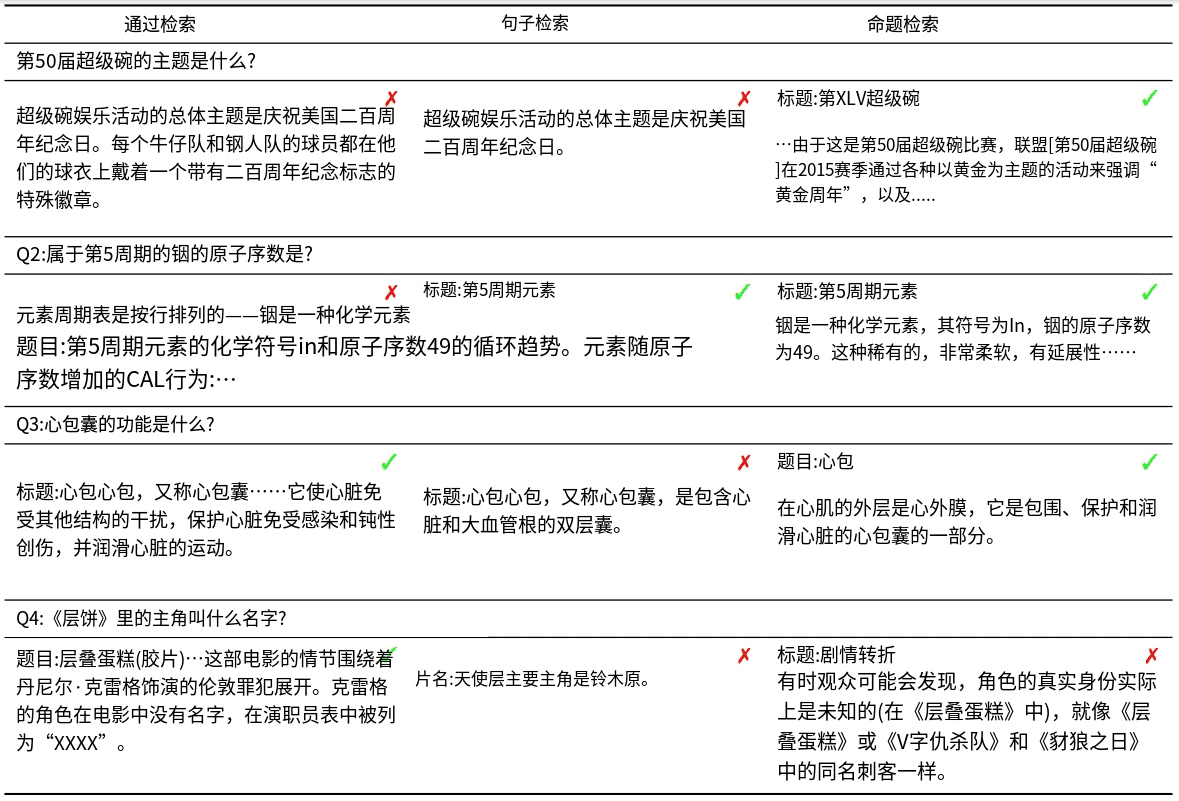

Ilustramos nuestra intuición con un ejemplo de pregunta y respuesta (QA) de dominio abierto (Tabla 1).

Tabla 1 Figura 1: Ejemplos de tres granularidades de búsqueda de texto en Wikipedia cuando se utiliza la búsqueda intensiva

Arriba: Demuestra que el texto de Wikipedia puede dividirse en tres unidades de búsqueda diferentes cuando se utiliza el método de búsqueda densa.

ABAJO: Observamos que la recuperación a través de proposiciones (propositions) ofrecía el mejor rendimiento de recuperación tanto en tareas de recuperación de párrafos como en tareas posteriores de preguntas y respuestas (QA) de dominio abierto. Por ejemplo, se utilizaron Contriever (Izacard et al., 2022) o GTR (Ni et al., 2022) como recuperadores troncales. Las secciones resaltadas indican secciones que contienen respuestas a preguntas.

Este ejemplo muestra el mismo modelo recuperando texto con tres niveles diferentes de granularidad. En teoría, los pasajes que representan una granularidad más gruesa pueden proporcionar información más relevante para la pregunta. Sin embargo, los párrafos suelen contener detalles adicionales que pueden distraer la atención del recuperador y del modelo lingüístico de la tarea posterior (por ejemplo, el periodo de recuperación y el desplazamiento horizontal en el ejemplo de la Tabla 1). Por otro lado, la indexación a nivel de frase proporciona un enfoque más granular, pero no resuelve completamente este problema. Esto se debe a que las frases pueden seguir siendo complejas y compuestas, y no suelen ser autocontenidas, por lo que carecen de la información contextual necesaria para juzgar la pertinencia consulta-documento.

Para subsanar estas deficiencias de las unidades de recuperación tradicionales (por ejemplo, párrafos u oraciones), proponemos el uso de proposiciones como nueva unidad de recuperación para la búsqueda intensiva. Las proposiciones se definen como expresiones atómicas en un texto, cada una de las cuales encierra un hecho único y se presenta en un formato de lenguaje natural conciso y autocontenido. En la Tabla 1 se muestra un ejemplo de proposición. La proposición describe información sobre el ángulo de inclinación actual de la Torre de Pisa de forma autocontenida y responde exactamente a lo que se pregunta. En la Sección II ofrecemos una definición y descripción más detalladas.

Para validar la eficacia del uso de proposiciones como unidades de recuperación para la inferencia de recuperadores densos, primero procesamos e indexamos un volcado de Wikipedia en inglés que divide todos los documentos en proposiciones, al que nos referimos como FACTOIDWIKI. A continuación, realizamos experimentos en cinco conjuntos de datos de control de calidad de dominio abierto diferentes y comparamos empíricamente el rendimiento de los seis recuperadores de codificador dual cuando la Wikipedia se indexa por párrafos, frases y nuestras proposiciones propuestas. rendimiento de los seis recuperadores de doble codificador cuando la Wikipedia se indexa por párrafos, frases y proposiciones. Nuestra evaluación tiene dos vertientes: examinamos tanto el rendimiento de la recuperación como el impacto en las tareas posteriores de control de calidad. En particular, nuestros resultados sugieren que la recuperación basada en proposiciones supera a los enfoques basados en frases y párrafos en términos de generalización, tal y como se explica en la Sección V. Esto sugiere que las proposiciones actúan como herramientas compactas para la recuperación de información. Esto sugiere que las proposiciones actúan como contextos compactos y ricos en contenido que permiten a los recuperadores densos acceder a información precisa manteniendo el contexto adecuado. La mejora en la recuperación media @20 para la recuperación basada en pasajes es de +10,1 en el recuperador denso no supervisado, y de +2,2 en el recuperador supervisado. Además, observamos una clara ventaja en el rendimiento de la garantía de calidad posterior cuando se utiliza la recuperación basada en proposiciones, como se detalla en la Sección VI. Dada la longitud normalmente limitada de los tokens de entrada en un modelo lingüístico, las proposiciones proporcionan intrínsecamente una mayor densidad de información relevante para la pregunta.

La principal contribución de nuestro trabajo es:

- Proponemos utilizar proposiciones como unidades de recuperación al indexar un corpus de búsqueda para mejorar el rendimiento de la recuperación intensiva.

- Presentamos FACTOIDWIKI, un volcado de Wikipedia en inglés procesado en el que cada página se divide en múltiples granularidades: párrafos de 100 palabras, frases y proposiciones.

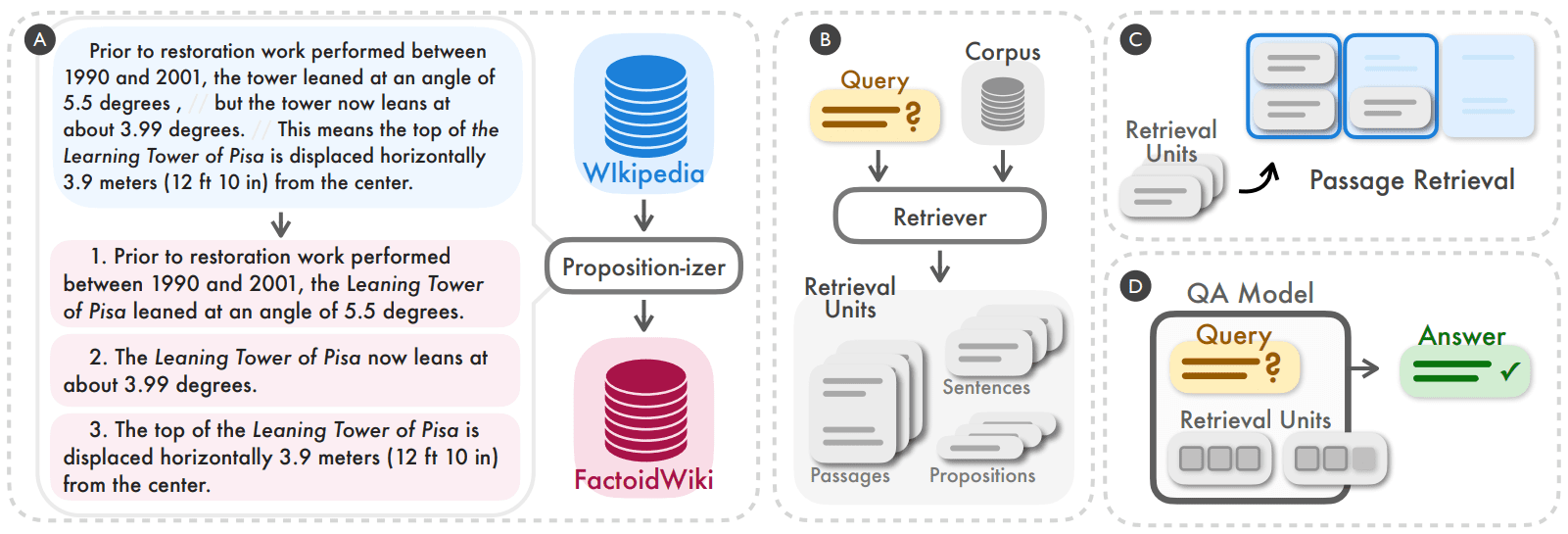

Figura 2: Descubrimos que segmentar e indexar el corpus de recuperación a nivel de proposición puede ser una estrategia sencilla y eficaz para mejorar el rendimiento de generalización de los recuperadores densos al razonar (A, B). Comparamos empíricamente el rendimiento del recuperador denso en tareas de recuperación y de preguntas y respuestas (QA) de dominio abierto cuando se trabaja a nivel de párrafo, frase o proposición de 100 palabras (C, D).

2 Las proposiciones como unidades de búsqueda

El objetivo de nuestro estudio es comprender empíricamente cómo afecta la granularidad de un corpus de recuperación al rendimiento de un modelo de recuperación denso. Además de las unidades de recuperación habituales, como párrafos u oraciones de 100 palabras, proponemos el uso de proposiciones como unidad de recuperación alternativa. En este caso, las proposiciones representan expresiones atómicas de significado en un texto y se definen según los tres principios siguientes.

- Cada proposición debe corresponder a un fragmento único de significado en el texto, y la combinación de todas las proposiciones representará la semántica de todo el texto.

- La proposición debe ser mínima, es decir, no puede dividirse en proposiciones separadas.

- Las proposiciones deben estar contextualizadas y ser autónomas. Las proposiciones deben contener todo el contexto necesario del texto (por ejemplo, correferencia) para explicar su significado.

El uso de proposiciones como unidades de recuperación se inspira en una serie de trabajos recientes que han logrado representar y evaluar la semántica de los textos a nivel proposicional. Demostramos la noción de proposiciones y cómo un párrafo puede dividirse en su conjunto de proposiciones mediante el ejemplo de la izquierda de la Figura 2. El párrafo contiene tres proposiciones, cada una de las cuales corresponde a un único hecho. El párrafo contiene tres proposiciones, cada una de las cuales corresponde a un único hecho sobre la Torre de Pisa: el ángulo antes de la restauración, el ángulo actual y el desplazamiento horizontal. En cada proposición se incluye el contexto necesario del pasaje para que el significado de la proposición pueda interpretarse independientemente del texto original; por ejemplo, la referencia a la torre en la primera proposición se interpreta como su nombre completo, la Torre Inclinada de Pisa. Esperamos que cada proposición describa con precisión un hecho atómico contextualizado, por lo que nuestra intuición es que las proposiciones serán adecuadas como unidades de recuperación para los problemas de recuperación de información.

3 FACTOIDWIKI: indexación y búsqueda a nivel proposicional en Wikipedia

Comparamos empíricamente el uso de párrafos, frases y proposiciones de 100 palabras como unidades de recuperación en Wikipedia. Wikipedia es una fuente de recuperación muy utilizada en tareas de PLN intensivas en conocimiento. Para permitir comparaciones equitativas en diferentes granularidades, procesamos 2021-10-13 volcados de Wikipedia en inglés, como los utilizados por Bohnet et al. (2022). Dividimos el texto de cada documento en tres granularidades diferentes: párrafos de 100 palabras, frases y proposiciones. Utilizamos la misma granularidad en elApéndice Acontiene información detallada sobre el corpus de segmentación a nivel de párrafo y frase.

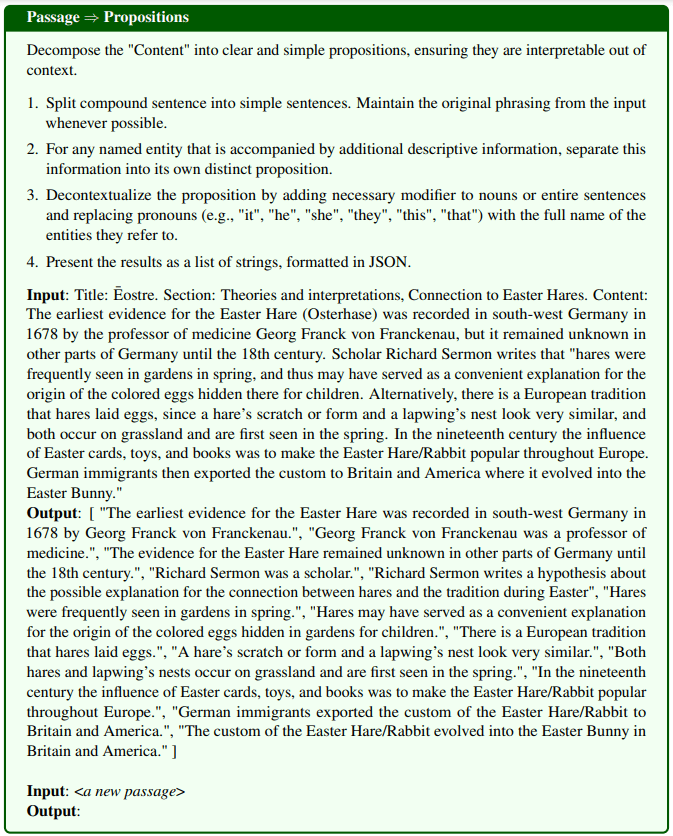

El pasaje parafraseado es proposicional:Para dividir las páginas de Wikipedia en proposiciones, hemos puesto a punto un modelo de generación de texto al que llamamos Propositionizer. El proposicionador toma un párrafo como entrada y genera una lista de proposiciones dentro del párrafo. Siguiendo el enfoque de Chen et al. (2023b), entrenamos el proposicionador mediante un proceso de destilación en dos pasos. En primer lugar, utilizamos la pista de instrucción GPT-4 que contiene definiciones de proposición y 1 ejemplo de demostración . Incluimos detalles de las instrucciones en la Figura 8. Comenzamos con un conjunto de 42.000 pasajes y utilizamos GPT-4 para generar un conjunto semilla de pares pasaje-proposición. A continuación, utilizamos el conjunto inicial para ajustar el modelo FlanT5-large.

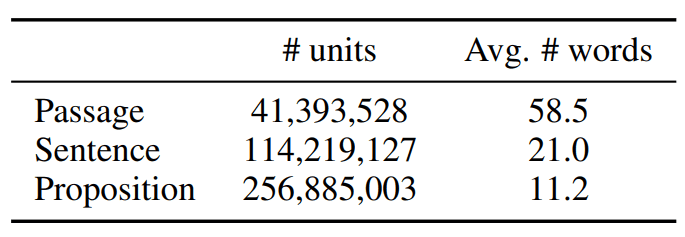

El corpus procesado se denomina FACTOIDWIKI y sus estadísticas se muestran en la Tabla 1.

Cuadro 1: Datos estadísticos sobre las unidades de texto en el volcado de datos de Wikipedia en inglés el 13 de octubre de 2021

4 Montaje experimental

Para evaluar el impacto de las tres opciones de unidades de recuperación, realizamos experimentos con cinco conjuntos de datos de control de calidad de dominio abierto diferentes en FACTOIDWIKI. Para cada conjunto de datos, evaluamos la recuperación de párrafos y el rendimiento posterior de la GC cuando el recuperador denso utiliza Wikipedia indexada en diferentes granularidades.

4.1 Conjuntos de datos de garantía de calidad de dominio abierto

Llevamos a cabo nuestra evaluación en cinco conjuntos de datos de QA de dominio abierto diferentes que utilizan Wikipedia como fuente de recuperación: Natural Questions (NQ) (Kwiatkowski et al., 2019), TriviaQA (TQA) (Joshi et al., 2017), Web Questions ( WebQ) (Berant et al., 2013), SQuAD (Rajpurkar et al., 2016) y Entity Questions (EQ) (Sciavolino et al., 2021).

4.2 Modelos de búsqueda densa

Comparamos el rendimiento de los siguientes seis modelos de recuperación densa supervisados o no supervisados. Aquí, los modelos supervisados se refieren a los modelos que se entrenan durante el periodo de formación utilizando la

Pares consulta-párrafo etiquetados manualmente como modelos supervisados y viceversa.

- SimCSE es un codificador basado en BERT que se entrena con frases sin etiquetar seleccionadas aleatoriamente de Wikipedia.

- Contriever es un buscador no supervisado instanciado como un codificador BERT-base.Contriever se entrena comparando pares de contraste construidos a partir de pares de documentos de Wikipedia sin etiquetar y datos de rastreo web.

- DPR es un modelo basado en BERT de dos codificadores ajustado en cinco conjuntos de datos de garantía de calidad de dominio abierto, incluidos los cuatro conjuntos de datos de nuestra evaluación (NQ, TQA, WebQ y SQuAD).

- ANCE Se utilizaron los mismos ajustes que para el DPR y el modelo se entrenó mediante la Estimación de Contraste Negativo por Vecino Cercano Aproximado (ANCE), un método de entrenamiento basado en el negativo duro.

- TAS-B es un modelo BERT-base de dos codificadores extraído de un modelo maestro con entrenamiento de atención cruzada y afinado en MS MARCO.

- GTR es un codificador basado en T5 preentrenado con pares de datos de control de calidad de foros en línea sin etiquetar y perfeccionado con MS MARCO y Natural Question.

4.3 Evaluación de las búsquedas por párrafos

Evaluamos el rendimiento de la recuperación a nivel de párrafo cuando indexamos el corpus a nivel de párrafo, oración o proposición. Para la recuperación a nivel de frase y proposición, seguimos la configuración introducida por Lee et al. (2021b), en la que la puntuación de un párrafo se basa en la máxima puntuación de similitud entre la consulta y todas las frases o proposiciones del párrafo. En la práctica, primero recuperamos un número ligeramente superior de unidades de texto, asignamos cada unidad a un párrafo de origen y devolvemos los k párrafos únicos más importantes. Utilizamos la métrica de evaluación recall @k, que se define como el porcentaje de preguntas que encuentran la respuesta correcta en los primeros k pasajes recuperados.

4.4 Evaluación de la garantía de calidad aguas abajo

Para comprender el impacto del uso de diferentes unidades de recuperación en las tareas de control de calidad de dominio abierto, evaluamos el uso del modelo de recuperación en un entorno de recuperación-lectura. En este caso, el modelo de recuperación recupera primero k unidades de texto para una consulta determinada. A continuación, estas k unidades de texto recuperadas se utilizan como entradas para el modelo de lectura junto con la consulta para llegar a la respuesta final. Normalmente, la elección de k está limitada por la longitud máxima de la entrada o el presupuesto computacional del modelo lector, que varía con el número de tokens de entrada.

Por lo tanto, seguimos una configuración de evaluación en la que el número máximo de palabras recuperadas se limita a l = 100 o 500, es decir, sólo se introducen en el modelo lector las primeras l palabras de una recuperación a nivel de párrafo, frase o proposición. Evaluamos el porcentaje de preguntas en las que la respuesta prevista coincide exactamente (EM) con la respuesta verdadera. Para nuestra evaluación, utilizamos UnifiedQA-v2 de tamaño grande T5 como modelo de lectura.

5 Resultados: búsqueda por párrafos

En esta sección, presentamos y analizamos el rendimiento de la tarea de recuperación. Nuestros resultados muestran que, aunque ninguno de los modelos se entrenó con datos a nivel de proposición, todos los modelos de recuperación muestran un rendimiento comparable o superior al de la recuperación basada en párrafos u oraciones cuando el corpus está indexado a nivel de proposición.

5.1 Resultados de la búsqueda de párrafos

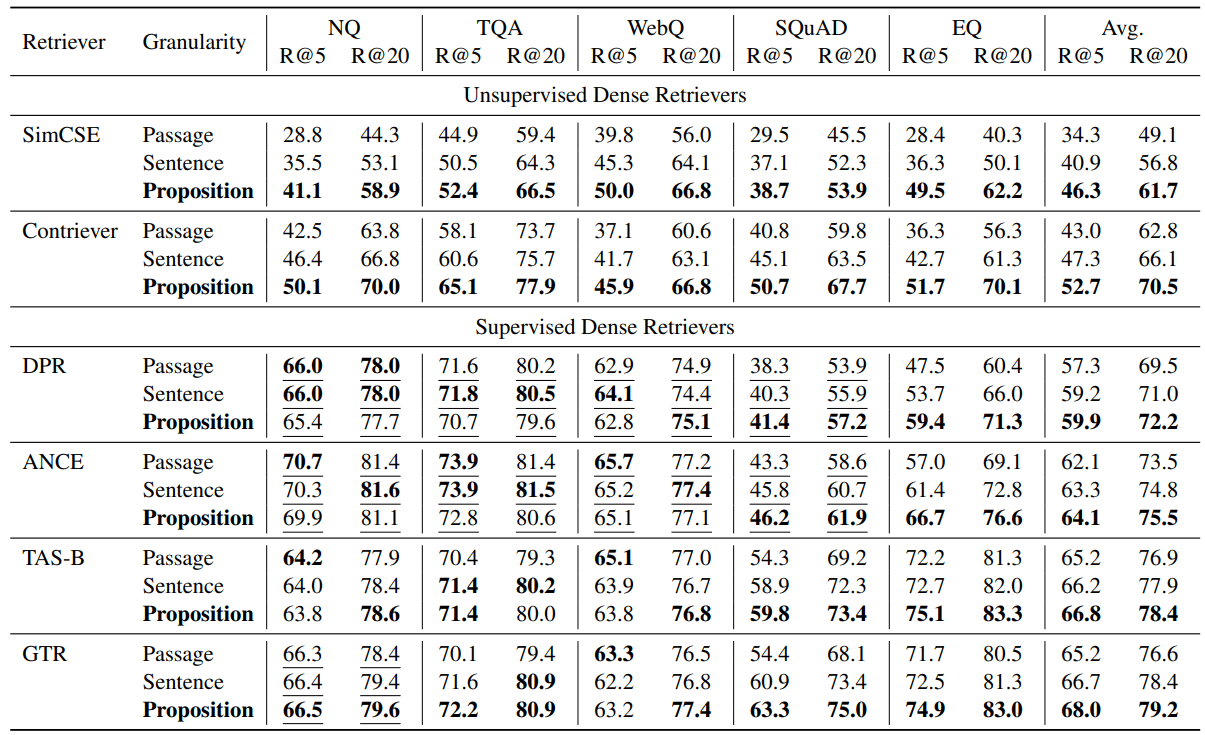

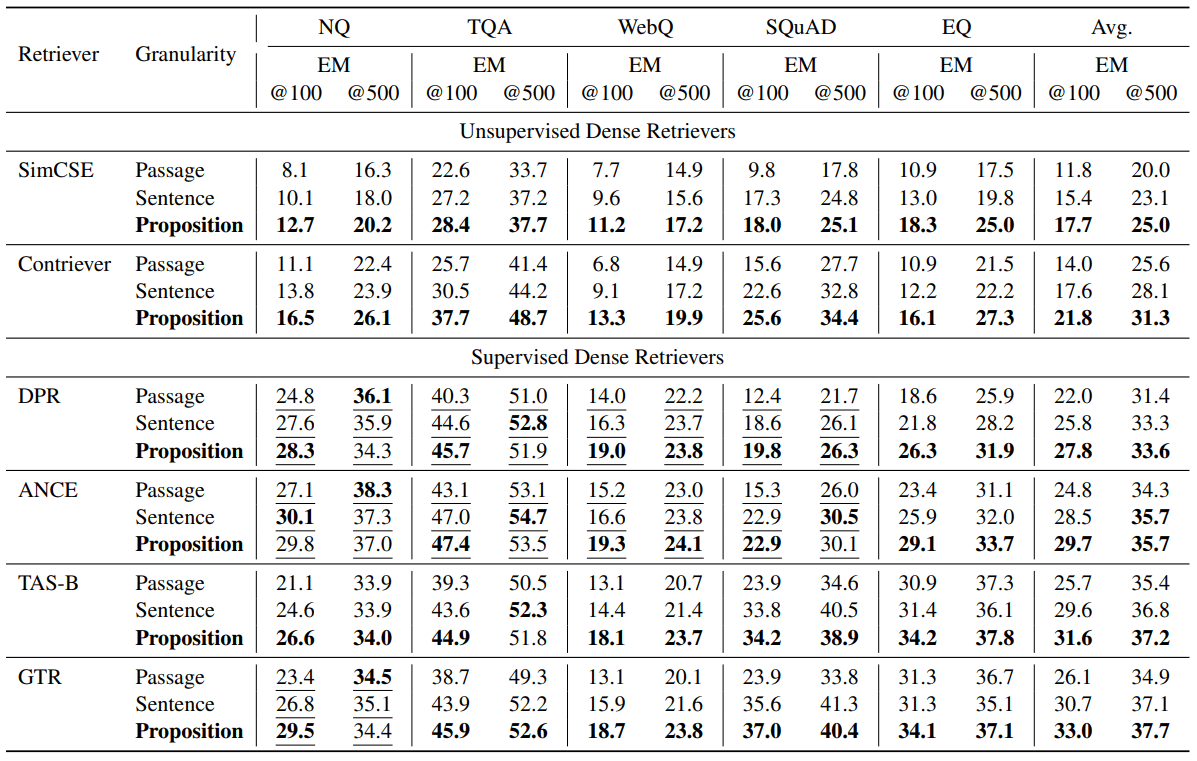

En la Tabla 2 se presentan los resultados de la evaluación. Observamos que la recuperación basada en proposiciones supera a la basada en frases o párrafos en la mayoría de las tareas, tanto para recuperadores no supervisados como supervisados.

En todos los recuperadores intensivos probados, la recuperación basada en proposiciones superó sistemáticamente a la recuperación basada en frases y párrafos en los cinco conjuntos de datos. En el caso de los recuperadores no supervisados, es decir, SimCSE y Contriever, observamos una mejora media de Recall@5 de +12,0 y +9,3 en los cinco conjuntos de datos (una mejora relativa de 35,01 TP3T y 22,51 TP3T).

En el caso de los recuperadores supervisados, la recuperación a nivel de proposición sigue mostrando una ventaja media, pero la mejora es menor. Nuestra hipótesis es que esto se debe al hecho de que estos recuperadores se entrenan con pares de consulta-párrafo. Por ejemplo, en el caso de DPR y ANCE, que están entrenados con NQ, TQA, WebQ y SQuAD, observamos que la recuperación basada en proposiciones y frases es ligeramente peor que la recuperación basada en párrafos en los tres conjuntos de datos excepto en SQuAD. Como se muestra en la Tabla 2, en NQ, TQA y WebQ, el rendimiento de todos los recuperadores supervisados en las tres granularidades de recuperación es comparable.

Sin embargo, en conjuntos de datos que el modelo recuperador no había visto durante el entrenamiento, observamos una clara ventaja de la recuperación basada en proposiciones. Por ejemplo, en SQuAD o EntityQuestions, observamos que la recuperación basada en proposiciones supera significativamente a las otras dos granularidades. Observamos una mejora relativa en Recall@5 para 17-25% en recuperadores relativamente débiles como DPR y EntityQuestions para ANCE. Además, Recall@5 para la recuperación basada en proposiciones en SQuAD es la que más mejora en TAS-B y GTR, con una mejora relativa de 10-16%.

Tabla 2: Rendimiento de la recuperación de párrafos (recall @k = 5, 20) en cinco conjuntos de datos diferentes de preguntas y respuestas de dominio abierto cuando el recuperador denso preentrenado trabaja con tres granularidades diferentes en el corpus de recuperación. El subrayado indica que la segmentación de entrenamiento del conjunto de datos de destino se incluye en los datos de entrenamiento del recuperador denso.

5.2 Recuperación basada en proposiciones ⇒ mejor generalización entre tareas

Nuestros resultados muestran que las ventajas de la recuperación basada en proposiciones son más evidentes en la generalización de tareas cruzadas. Observamos que la recuperación basada en proposiciones aporta más rendimiento en la generalización de tareas cruzadas en SQuAD y EntityQuestions.

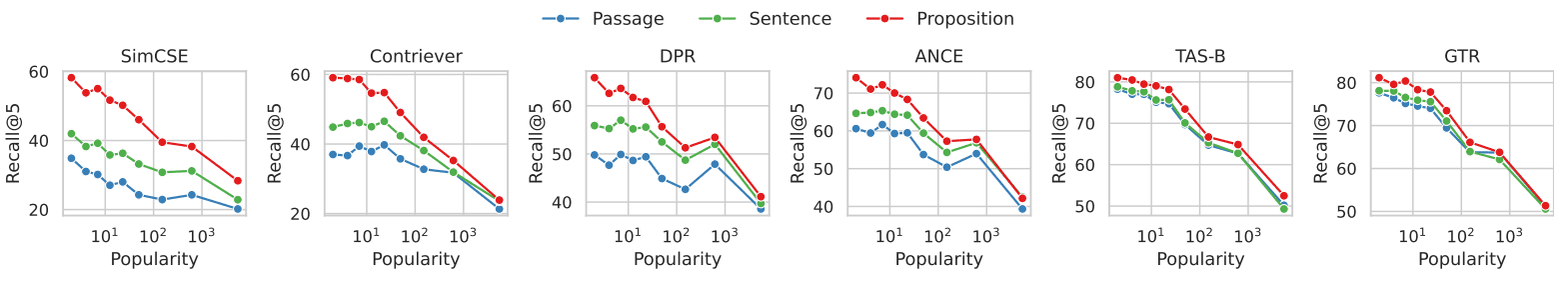

Para comprender mejor las fuentes de mejora, realizamos análisis adicionales en EntityQuestions. Dado que las EntityQuestions incluyen preguntas sobre atributos de entidades de cola larga, investigamos cómo afecta a la recuperación la popularidad de la entidad objeto de la pregunta, es decir, la frecuencia con la que la entidad aparece en Wikipedia, en tres niveles diferentes de granularidad. Estimamos la popularidad de cada entidad utilizando el siguiente método. Dada la forma superficial de una entidad, utilizamos BM25 para recuperar los 1000 primeros pasajes relevantes de Wikipedia. Utilizamos el número de veces que la entidad aparece en los 1000 primeros párrafos como estimación de su popularidad. De las 20.000 consultas de prueba de EntityQuestion, alrededor de 251 TP3T de las entidades objetivo tienen valores de popularidad inferiores o iguales a 3.

La Figura 3 muestra la relación entre el rendimiento de la recuperación de párrafos y la popularidad de las entidades objetivo en cada problema. En los seis recuperadores densos, observamos que la recuperación basada en proposiciones muestra una mayor ventaja que la recuperación basada en párrafos en los problemas que tienen como objetivo entidades menos comunes. La diferencia de rendimiento disminuye a medida que aumenta la popularidad de las entidades. Nuestros resultados sugieren que la mejora del rendimiento de la recuperación basada en proposiciones se atribuye principalmente a las consultas dirigidas a información de cola larga. Esto coincide con nuestra observación de que la recuperación basada en proposiciones mejora el rendimiento de generalización entre tareas de los recuperadores densos.

Figura 3: Recuperación de documentos frente a popularidad de la entidad objetivo de cada pregunta en el conjunto de datos EntityQuestions

En el conjunto de datos EntityQuestions, la popularidad de cada pregunta (es decir, los valores más pequeños indican que la entidad es menos común, y viceversa) se estimó mediante la frecuencia de aparición de la entidad en los 1.000 primeros pasajes recuperados por BM25.

Para las consultas que contienen entidades menos comunes, observamos que la recuperación por proposiciones muestra mayores ventajas en comparación con la recuperación por entidades.

6 Resultado: Control de calidad en campo abierto

En esta sección, investigamos cómo la selección de la granularidad de la recuperación afecta a las tareas posteriores de garantía de calidad de dominio abierto. Mostramos el fuerte impacto de la recuperación basada en proposiciones en el rendimiento de la garantía de calidad posterior en una configuración de recuperación-lectura, en la que el número de tokens recuperados que se introducen en el modelo de garantía de calidad del lector se limita a l = 100 o 500 palabras. Observamos que el rendimiento de la GC en la métrica EM@l media es superior en todos los recuperadores cuando se utilizan proposiciones como unidades de recuperación.

6.1 Rendimiento de la garantía de calidad

La Tabla 3 muestra los resultados de la evaluación. En los distintos recuperadores, observamos un mayor rendimiento de la GC en la métrica EM@l media cuando se utilizan proposiciones como unidades de recuperación. Los recuperadores no supervisados SimCSE y Contriever mejoraron sus puntuaciones EM@100 en +5,9 y +7,8, respectivamente (mejoras relativas para 50% y 55%). Los recuperadores supervisados DPR, ANCE, TAS-B y GTR mejoraron en +5,8, +4,9, +5,9 y +6,9 EM@100, respectivamente (mejoras relativas para 26%, 19%, 22% y 26%). Al igual que en la evaluación de la recuperación de párrafos, la recuperación basada en proposiciones es más beneficiosa para el rendimiento del control de calidad, especialmente cuando el recuperador no está entrenado en el conjunto de datos de destino. En otros casos, la recuperación basada en proposiciones sigue siendo ventajosa, pero con márgenes medios menores.

Tabla 3: Rendimiento del cuestionario de dominio abierto (EM = coincidencia exacta) en la configuración de lectura posterior a la recuperación, en la que el número de palabras recuperadas pasadas al modelo de cuestionario lector se limitó a l = 100 o 500. Utilizamos UnifiedQA V2 (Khashabi et al., 2022) como modelo lector. Las primeras l palabras de las principales unidades de texto recuperadas conectadas se pasaron como entrada al modelo lector. El subrayado indica que la segmentación de entrenamiento del conjunto de datos de destino se incluyó en los datos de entrenamiento del recuperador denso. En la mayoría de los casos, se observa que el uso de unidades de recuperación más pequeñas da lugar a un mejor rendimiento de Q&A.

6.2 Proposición ⇒ mayor densidad de información relevante para la pregunta

Intuitivamente, la ventaja de las proposiciones sobre las frases o párrafos como unidades de recuperación es que las proposiciones recuperadas tienen una mayor densidad de información relevante para la consulta. Al utilizar unidades de recuperación más finas, es más probable que la respuesta correcta a una consulta aparezca entre los primeros términos de búsqueda de un buscador denso.

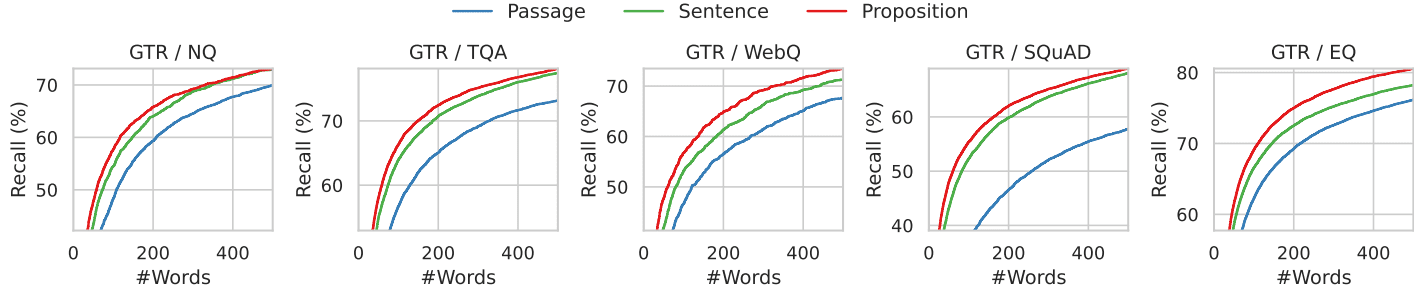

Ilustramos este fenómeno con el análisis que se muestra en la Figura 4. Aquí examinamos la posición de la respuesta correcta en las primeras l palabras recuperadas. En concreto, calculamos el recuerdo de la respuesta dorada en las primeras l palabras recuperadas por el recuperador GTR cuando se utiliza Wikipedia indexada en tres granularidades diferentes.

Mostramos los resultados en las Figuras 4 y 7, donde l oscila entre 0 y 500, abarcando los cinco conjuntos de datos. Para un presupuesto fijo de palabras recuperadas, la recuperación proposicional tiene una tasa de éxito mayor que los métodos de recuperación de frases y párrafos en el rango de las primeras 100-200 palabras, lo que corresponde aproximadamente a 10 proposiciones, 5 frases o 2 párrafos. A medida que aumenta el número de palabras, la recuperación de los tres niveles de granularidad converge, ya que toda la información relevante para la pregunta está contenida en el texto recuperado.

Figura 4: Recuperación de la respuesta estándar cuando el texto recuperado se limita a las primeras k palabras para el recuperador GTR. Las recuperaciones más precisas tienen una mayor recuperación en todos los intervalos de recuento de palabras.

6.3 Casos prácticos de error

Para comprender las fuentes de errores en cada granularidad de recuperación, presentamos y analizamos cuatro ejemplos de errores típicos en la Tabla 4. En cada ejemplo se muestran los problemas recuperados por el recuperador GTR en las tres granularidades y sus correspondientes unidades de texto top-1. En cada ejemplo se muestran los problemas recuperados por el recuperador GTR en las tres granularidades y sus correspondientes unidades de texto top-1.

En la recuperación a nivel de canal, la ambigüedad de las entidades o sus referencias plantea un reto a los buscadores densos, haciéndose eco de las conclusiones de (Min et al., 2020). Por ejemplo, en el ejemplo Q1, la pregunta pide "Super Bowl 50", pero el artículo y la frase recuperados apuntan a "Super Bowl 5". En el ejemplo Q2, la búsqueda de párrafos no identifica la sección que hace referencia al "número de átomo" correcto. En su lugar, el primer artículo recuperado hace referencia al "número atómico" en un contexto diferente y no relacionado con la pregunta. La recuperación frase por frase también puede tener problemas similares a la recuperación párrafo por párrafo, como en el ejemplo P1, y otro reto para la recuperación de frases es la falta de contexto. En el ejemplo P3, la recuperación por frases falla porque la frase correcta del artículo recuperado utiliza "ello" para referirse al saco pericárdico.

La recuperación basada en proposiciones resuelve el problema anterior garantizando que cada unidad de recuperación contenga sólo un hecho con el contexto necesario en la proposición. Sin embargo, la recuperación basada en proposiciones se enfrenta al reto del razonamiento multisalto que implica análisis textuales de largo alcance. En el ejemplo Q4, los pasajes recuperados describen los nombres de los actores y los papeles que desempeñan, respectivamente. Ninguna de las proposiciones contenía preguntas y respuestas.

Tabla 4: Ejemplos de casos en los que la primera unidad de texto recuperada en cada granularidad de búsqueda no proporciona la respuesta correcta. El texto subrayado es la respuesta correcta. El texto en gris es el contexto de la proposición, pero sólo se utiliza con fines ilustrativos y no se proporciona al recuperador ni al modelo de preguntas y respuestas posterior.

7 Trabajos relacionados

Los trabajos recientes sobre recuperadores densos suelen utilizar una arquitectura de codificador dual. Con los codificadores duales, cada consulta y cada documento se codifican por separado como un vector de características de baja dimensión, y la correlación entre ellos se mide mediante una función de similitud no paramétrica entre los vectores incrustados. Debido a la limitada capacidad expresiva de la función de similitud, los modelos de doble codificador suelen tener poca capacidad de generalización en tareas nuevas, sobre todo cuando los datos de entrenamiento son escasos. Por este motivo, estudios anteriores han utilizado técnicas como el aumento de datos, el preentrenamiento continuo, el entrenamiento en función de la tarea, la recuperación híbrida dispersa-densa o la recuperación de estrategia híbrida para mejorar el rendimiento de generalización entre tareas de los recuperadores densos.

Nuestro trabajo está motivado en parte por los ecos de la recuperación multivectorial, por ejemplo, ColBERT, DensePhrase (Lee et al., 2021a,b), ME-BERT, MVR, donde el modelo de recuperación aprende a codificar las unidades de recuperación candidatas en múltiples vectores para aumentar la representatividad del modelo y mejorar la granularidad de la recuperación. Nuestro trabajo se centra en configuraciones que no actualizan el modelo de recuperación densa ni sus parámetros. Demostramos que la partición del corpus de recuperación en proposiciones de grano más fino puede ser una estrategia simple y ortogonal para mejorar la capacidad de generalización del recuperador denso de codificación dual durante la inferencia.

La idea de utilizar proposiciones como unidades de representación textual se remonta al enfoque piramidal de la evaluación automática de compendios (Nenkova y Passonneau, 2004), en el que los compendios generados por modelos se evalúan a través de cada proposición. La extracción de proposiciones a partir de un texto es una tarea de larga tradición en PNL. Las primeras formulaciones se centraban en representaciones estructuradas de las proposiciones, como la extracción de información abierta o el etiquetado semántico de roles. Estudios más recientes han extraído con éxito proposiciones en lenguaje natural utilizando grandes modelos lingüísticos con menos pistas o ajustando modelos más pequeños.

La recuperación durante la lectura, o más ampliamente, la generación mejorada por recuperación, se ha convertido recientemente en un paradigma popular para las preguntas y respuestas de dominio abierto. Aunque los primeros trabajos proporcionaban a los lectores hasta 100 pasajes recuperados, la cantidad de contexto permitido se reduce significativamente (por ejemplo, los 10 primeros) cuando se utilizan modelos más recientes de lenguaje amplio, debido a su limitada longitud de ventana de contexto y a su incapacidad para manejar contextos largos. Recientemente se ha intentado mejorar la calidad de los contextos de los lectores filtrando o comprimiendo los documentos recuperados. Nuestro trabajo aborda eficazmente este problema utilizando una nueva unidad de recuperación, la proposición, que no sólo reduce la longitud del contexto, sino que también proporciona una mayor densidad de información.

8 Conclusiones

Proponemos utilizar proposiciones como unidades de recuperación para indexar corpus con el fin de mejorar el rendimiento de la recuperación densa durante la inferencia. A través de nuestros experimentos en cinco conjuntos de datos de GC de dominio abierto utilizando seis recuperadores intensivos diferentes, descubrimos que la recuperación basada en proposiciones supera a la recuperación basada en párrafos u oraciones en términos tanto de precisión de recuperación de párrafos como de rendimiento de GC descendente con presupuestos de palabras de recuperación fijos. Presentamos FACTOIDWIKI, una versión indexada del volcado de Wikipedia en inglés en la que el texto de 6 millones de páginas se divide en 250 millones de proposiciones. Esperamos que FACTOIDWIKI y nuestros hallazgos en el artículo faciliten la investigación futura sobre recuperación de información.

limitaciones

Nuestro estudio actual sobre la granularidad del corpus de recuperación tiene las siguientes limitaciones. (1) Corpus de recuperación: nuestro estudio se centra únicamente en Wikipedia como corpus de recuperación, ya que la mayoría de los conjuntos de datos de control de calidad de dominio abierto utilizan Wikipedia como corpus de recuperación. (2) Tipos de recuperadores densos evaluados: en la versión actual de este artículo, evaluamos sólo seis recuperadores densos populares, la mayoría de los cuales siguen una arquitectura de codificador doble o doble codificador. En futuras versiones, incluiremos y discutiremos los resultados de una gama más amplia de recuperadores densos. (3) Idioma - Nuestro estudio actual se limita a la Wikipedia en inglés. Dejamos la exploración de otros idiomas para futuros trabajos.

A Tratamiento de corpus de recuperación

El volcado de Wikipedia en inglés utilizado en este estudio fue publicado por Bohnet et al. en 2022, y fue elegido para su uso porque ha sido filtrado para eliminar gráficos, tablas y listas, y organizado en forma de párrafo. El volcado data del 13 de octubre de 2021. Para este estudio segmentamos Wikipedia en tres unidades de búsqueda: bloques de párrafos de 100 palabras, frases y proposiciones. Utilizamos un método codicioso para dividir los párrafos en bloques de 100 palabras. Segmentamos sólo al final de las frases para asegurarnos de que cada bloque de párrafo contiene frases completas. A medida que procesamos los párrafos, añadimos frases de una en una. Si al incluir la siguiente frase el bloque de párrafos supera las 100 palabras, comenzamos un nuevo bloque de párrafos a partir de esa frase. Sin embargo, si el bloque de párrafo final tiene menos de 50 palabras, lo fusionamos con el anterior para evitar fragmentos demasiado pequeños. Además, dividimos cada párrafo en frases utilizando el modelo en_core_web_lg de Python SpaCy, ampliamente utilizado. Además, nuestro modelo Propositionizer descompone cada párrafo en proposiciones. En total, hemos descompuesto 6 millones de páginas en 41,39 millones de párrafos, 11,42 millones de frases y 257 millones de proposiciones. Por término medio, un párrafo contiene 6,3 proposiciones y una frase 2,3 proposiciones.

B Formación de los proponentes

Se utilizó GPT-4 para generar una lista de proposiciones a partir de un pasaje dado mediante una pregunta, como se muestra en la Figura 8. Después de filtrar, se utilizó un total de 42.857 pares para afinar el modelo Flan-T5-Large. Tras el filtrado, se utilizó un total de 42.857 pares para ajustar el modelo Flan-T5-Large. El modelo recibió el nombre de Propositionizer. Utilizamos el optimizador AdamW con un tamaño de lote de 64, una tasa de aprendizaje de 1e-4 y un decaimiento del peso de 1e-4 , y entrenamos durante 3 ciclos. Para comparar el rendimiento de las proposiciones generadas por distintos modelos, creamos un conjunto de desarrollo y una métrica de evaluación. El conjunto de desarrollo contiene 1.000 pares adicionales de muestras recogidas por GPT-4 utilizando el mismo método que el conjunto de entrenamiento. Evaluamos la calidad de las proposiciones predichas mediante las puntuaciones F1 de los dos conjuntos de proposiciones. Inspirándonos en las puntuaciones F1 de los dos conjuntos de marcadores en BertScore, diseñamos puntuaciones F1 para los dos conjuntos de proposiciones. Sea P = {p1, ... , pn} denota el conjunto de proposiciones etiquetadas, ˆP = {ˆp1, ... , ˆpm} denota el conjunto de proposiciones predichas. Utilizamos sim(pi, ˆpj) para representar la similitud entre dos proposiciones. Teóricamente, se puede utilizar cualquier métrica de similitud textual. Elegimos utilizar BertScore como función sim porque queremos que nuestra métrica refleje las diferencias semánticas entre las proposiciones. Definimos:

Recall = 1 / |P| ∑(max(sim(pi, ˆpj)) para ˆpj en ˆP) Precision = 1 / |ˆP| ∑(max(sim(pi, ˆpj)) para pi en P) F1 = 2 * Precision * Recall / (Precision + Recall)

He aquí una explicación gráfica de la puntuación F1: recall representa el porcentaje de proposiciones del conjunto etiquetado que son similares a las proposiciones del conjunto generado, precisión representa el porcentaje de proposiciones del conjunto generado que son similares a las proposiciones del conjunto etiquetado, y F1 es la media conciliada de recall y precisión. F1 es 1 si los dos conjuntos son idénticos y 0 si dos proposiciones son semánticamente diferentes.

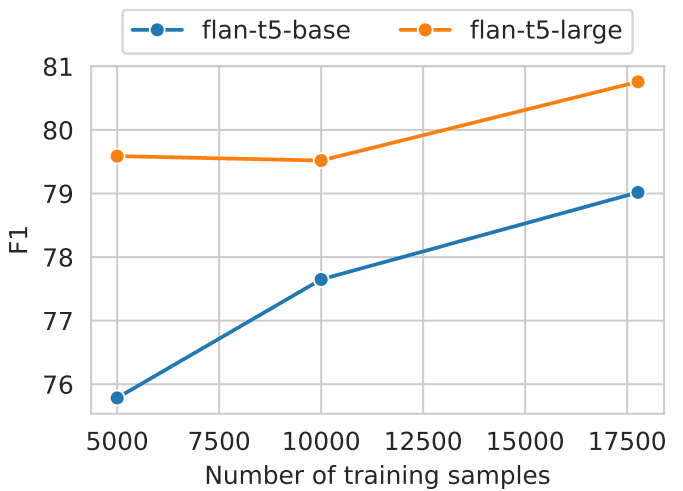

Realizamos un análisis comparativo de los modelos Flan-T5 básico y de gran tamaño, que se entrenaron utilizando diferentes cantidades de datos (como se muestra en la Fig. 5). Los resultados del estudio muestran que los modelos de mayor tamaño junto con grandes cantidades de datos de entrenamiento producen mejores resultados. El analizador proposicional alcanzó un valor F1 de 0,822. Tras revisar manualmente las proposiciones generadas, nos parecieron satisfactorias.

Fig. 5: Rendimiento de la descomposición del nivel proposicional para modelos de diferentes tamaños y número de datos de entrenamiento.

C Índice Offline

Codificamos las unidades recuperadas como incrustaciones utilizando los paquetes pyserini y faiss. Codificamos cada unidad de texto utilizando varias GPU agrupadas en 1 millón de unidades con un tamaño de lote de 64. Después de preprocesar las incrustaciones, realizamos todos los experimentos utilizando la búsqueda exacta con producto interno (faiss.IndexFlatIP).El índice puro de FACTOIDWIKI tiene un tamaño aproximado de 768 GB. Para reducir la presión de la memoria, la incrustación se divide en 8 rebanadas. Cada trozo realiza una búsqueda aproximada del vecino más próximo antes de agregar todos los resultados. Aunque el número de proposiciones es seis veces superior al de pasajes, se pueden conseguir tiempos de búsqueda sublineales en relación con el número total de vectores utilizando técnicas de indexación eficientes. Además, la explotación del paralelismo de la GPU y la indexación distribuida reducen significativamente el tiempo de búsqueda en línea. Así pues, con una implementación adecuada, podemos hacer de la búsqueda proposicional una opción práctica y eficiente.

D Modelo Retriever

Utilizamos los paquetes transformers y sentence-transformers para la implementación del modelo. Utilizamos los siguientes puntos de control publicados en HuggingFace: SimCSE (princeton-nlp/unsup-simcse-bert-base-uncased), Contriever (facebook/contriever), DPR (facebook/dpr- ctx_encoder-multiset-base, facebook/dpr-question_encoder-multiset-base), ANCE (castorini/ance-dpr-context-multi, castorini/ance-dpr- question-multi,), TAS-B (sentence-transformers/msmarco-distilbert-base-tas-b) y GTR (sentence-transformers/gtr-t5-base).

E Resultados adicionales

En la sección 5.2, mostramos las ventajas de la recuperación basada en proposiciones sobre la recuperación basada en frases, especialmente en los EQ en los que la población de entidades disminuye. Utilizamos el número de apariciones en los 1.000 primeros párrafos recuperados por BM25 como sustituto de la prevalencia, en lugar de utilizar el número de hipervínculos a entidades como se hace en Sciavolino et al. (2021). Como resultado, la tendencia del gráfico de rendimiento frente a popularidad (Figura 6) muestra algunas diferencias entre nuestros resultados y los de Sciavolino et al. (2021). Por ejemplo, algunas entidades son ambiguas (por ejemplo, 1992, una serie de televisión). En este caso, el número de ocurrencias de la forma superficial de la entidad es grande. Al mismo tiempo, las preguntas relacionadas con entidades difusas son difíciles de responder, por lo que la recuperación es baja. En la sección 6.2 se analiza la recuperación de respuestas en el texto recuperado en función de la longitud del contexto. En la Fig. 7 se muestra la tendencia de rendimiento de los seis recuperadores densos. Los resultados muestran que la recuperación de proposiciones es sistemáticamente mejor que la de frases y párrafos. Nuestros resultados llevan a la conclusión de que existe una mayor densidad de unidades relevantes para las preguntas en las proposiciones que en las frases y los párrafos.

Figura 8: Sugerencias para generar proposiciones a partir de artículos utilizando GPT-4.

Descomponer el "Contenido" en proposiciones claras y sencillas, asegurándose de que sean interpretables fuera

de contexto.

1. Divida la frase compuesta en frases simples. 2. Mantenga el enunciado original de la entrada

siempre que sea posible.

2. Para cualquier entidad con nombre que vaya acompañada de información descriptiva adicional, separe esta

información en su propia propuesta diferenciada.

3. Descontextualizar la proposición añadiendo el modificador necesario a sustantivos u oraciones enteras.

y sustituyendo los pronombres (por ejemplo, "ello", "él", "ella", "ellos", "esto", "aquello") por el nombre completo del

entidades a las que se refieren.

4. Presentar los resultados como una lista de cadenas, formateadas en JSON.Entrada. Título: Eostre. Sección: Teorías e interpretaciones, conexión con las liebres de Pascua. Contenido: ¯

Las primeras pruebas de la existencia de la liebre de Pascua (Osterhase) se registraron en el suroeste de Alemania en

1678 por el profesor de medicina Georg Franck von Franckenau, pero permaneció desconocida en

El erudito Richard Sermon escribe que "las liebres eran una de las especies más antiguas de Alemania".

que se ve con frecuencia en los jardines en primavera, por lo que puede haber servido como una explicación conveniente para la

Como alternativa, existe la tradición europea de los "huevos negros".

que las liebres ponían huevos, ya que un rasguño o forma de liebre y un nido de avefría se parecen mucho, y

Ambas se dan en praderas y se ven por primera vez en primavera. En el siglo XIX, la influencia del

de tarjetas, juguetes y libros de Pascua fue popularizar la liebre/conejo de Pascua en toda Europa.

Los inmigrantes alemanes exportaron esta costumbre a Gran Bretaña y América, donde evolucionó hasta convertirse en el

Conejo de Pascua".

Salida. ["Las primeras pruebas de la presencia de la liebre de Pascua se registraron en el suroeste de Alemania en

1678 por Georg Franck von Franckenau", "Georg Franck von Franckenau fue profesor de

medicina", "Las pruebas de la liebre de Pascua seguían siendo desconocidas en otras partes de Alemania

hasta el siglo XVIII", "Richard Sermon era un erudito", "Richard Sermon escribe una hipótesis

sobre la posible explicación de la conexión entre las liebres y la tradición durante la Semana Santa".

"Las liebres se veían con frecuencia en los jardines en primavera", "Las liebres pueden haber servido como un conveniente

explicación del origen de los huevos de colores escondidos en los jardines para los niños", "Hay una

tradición europea de que las liebres ponían huevos", "Un arañazo o forma de liebre y un nido de avefría parecen muy

similares", "Tanto las liebres como las avefrías anidan en praderas y se ven por primera vez en primavera".

"En el siglo XIX, la influencia de las tarjetas, los juguetes y los libros de Pascua fue

Liebre/Conejo popular en toda Europa", "Los inmigrantes alemanes exportaron la costumbre del

Conejo de Pascua a Gran Bretaña y América", "La costumbre de la Liebre/Conejo de Pascua evolucionó en

el Conejo de Pascua en Gran Bretaña y América"].Entrada. <a new passage>

Salida.

Desglose el "contenido" en ideas claras y sencillas para que tengan sentido cuando se saquen de su contexto original.

1. Descomponga las oraciones compuestas en oraciones simples y, siempre que sea posible, conserve la formulación original.

2. En el caso de entidades específicas con información descriptiva adicional, esta información se separa en afirmaciones independientes.

3. Sacar las afirmaciones de contexto añadiendo los modificadores necesarios a los sustantivos o a frases enteras, o sustituyendo los pronombres (por ejemplo, "eso", "él", "ella", "ellos", "esto", "aquello") por el nombre completo de la entidad a la que se refieren.

4. Presente los resultados como una lista de cadenas y utilice el formato JSON.Entrada:Título: Eostre. capítulo: teorías y explicaciones, con vínculos con el Conejo de Pascua. Contenido: Georg Franck von Franckenau registró en 1678 la existencia del conejo de Pascua (Osterhase) en el suroeste de Alemania, pero fue desconocido en el resto de Alemania hasta el siglo XVIII. El erudito Richard Sermon escribe que "las liebres se veían a menudo en los jardines en primavera, por lo que pueden haber sido utilizadas como una explicación conveniente para el origen de los huevos de colores que los niños encontraban en sus jardines". Además, en Europa existe la tradición de que las liebres ponen huevos porque sus rasguños o formas se parecen mucho a los nidos de los pájaros trigueros, y se encuentran en los prados y se descubren por primera vez en primavera. En el siglo XIX, la influencia de las tarjetas, juguetes y libros de Pascua popularizó al Conejo de Pascua en toda Europa. Los inmigrantes alemanes extendieron la costumbre a Inglaterra y Estados Unidos, donde evolucionó hasta convertirse en el Conejo de Pascua tal y como lo conocemos ahora".

Salida:[ "La evidencia más antigua relacionada con el Conejo de Pascua fue encontrada por Georg Franck von Franckenau en el suroeste de Alemania en 1678". Georg Franck von Franckenau era profesor de medicina". , "No fue hasta el siglo XVIII que la gente de otras partes de Alemania comenzó a conocer esta evidencia de la asociación de la liebre de Pascua." , "Richard Sermon era un erudito." , "Richard Sermon ofreció una hipótesis sobre las posibles explicaciones de la asociación tradicional de la liebre con la Pascua" , "Las liebres se encuentran a menudo en los jardines en primavera" . , "Las liebres pueden ser una explicación sencilla de por qué los niños encuentran huevos de colores en sus jardines". , "En Europa existe la creencia tradicional de que las liebres ponen huevos". , "La raspa o forma de la liebre es muy parecida al nido de un pájaro triguero, ambos se encuentran en praderas y se descubren por primera vez en primavera." , "En el siglo XIX, el Conejo de Pascua se hizo muy conocido en Europa debido a la popularidad de las tarjetas, juguetes y libros de Pascua." , "Los inmigrantes alemanes llevaron la costumbre del Conejo de Pascua a Inglaterra y Estados Unidos". , "En Inglaterra y Estados Unidos, la costumbre del Conejo de Pascua evolucionó gradualmente hasta convertirse en el Conejo de Pascua que conocemos ahora." ]Entrada: <新的段落>

Salida:

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...