par_scrape: una herramienta de rastreo para la extracción inteligente de datos web

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 50.2K 00

Introducción general

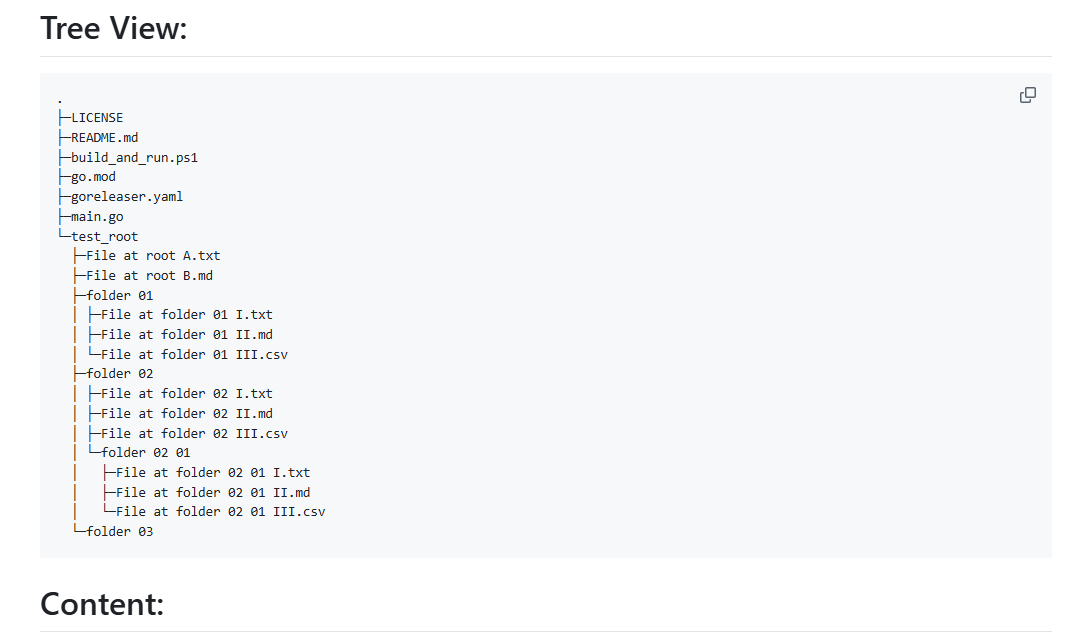

par_scrape es un rastreador web de código abierto basado en Python, lanzado en GitHub por el desarrollador Paul Robello, diseñado para ayudar a los usuarios a extraer datos de páginas web de forma inteligente. Integra dos potentes tecnologías de automatización de navegadores, Selenium y Playwright, y las combina con capacidades de procesamiento de IA para soportar el rastreo de datos desde simples páginas estáticas hasta complejos sitios web dinámicos. Ya se trate de extraer precios, títulos u otra información estructurada, par_scrape completa rápidamente la tarea especificando campos y emite los resultados como Markdown, JSON o CSV. Proyecto para desarrolladores, analistas de datos o usuarios que deseen automatizar la recopilación de información en la Web , fácil de instalar y de características flexibles , popular en la comunidad de código abierto .

Lista de funciones

- Extracción inteligente de datosAnálisis de contenidos web mediante modelos de IA (como OpenAI o Anthropic) para extraer con precisión los campos especificados por el usuario.

- Doble soporte de orugasEl sitio web es compatible con las tecnologías Selenium y Playwright, que pueden adaptarse a distintas arquitecturas de sitios web.

- Múltiples formatos de salida: Los resultados de la captura pueden exportarse a Markdown, JSON, CSV o Excel para facilitar su posterior procesamiento.

- Captura de campos personalizadosLos usuarios pueden especificar los campos que desean extraer, como el título, la descripción, el precio, etc., para satisfacer necesidades personalizadas.

- captura paralelaSoporte de rastreo multihilo para mejorar la eficacia de la recopilación de datos a gran escala.

- Mecanismo de espera: Proporciona una variedad de métodos de espera de carga de páginas (por ejemplo, pausa, espera de selector) para garantizar el éxito del rastreo de contenido dinámico.

- Selección del modelo de IASoporte para múltiples proveedores de IA (por ejemplo, OpenAI, Anthropic, XAI) para una adaptación flexible a diferentes tareas.

- Optimización de la cachéFunción de caché de sugerencias integrada para reducir el coste de las solicitudes repetidas y mejorar la eficacia.

Utilizar la ayuda

Proceso de instalación

Para utilizar par_scrape, primero debe completar los siguientes pasos de instalación para asegurarse de que su entorno está bien preparado. A continuación encontrará una guía de instalación detallada:

1. Preparación medioambiental

- Versión PythonAsegúrese de que Python 3.11 o posterior está instalado en su sistema utilizando el comando

python --versionCompruébalo. - Herramientas Git: Se utiliza para clonar código de GitHub; si no está instalado, se puede acceder a él a través de la función

sudo apt install git(Linux) o el sitio web oficial para descargar e instalar. - Herramientas UV: Se recomienda utilizar UV para gestionar las dependencias, el comando de instalación es:

- Linux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh - Ventanas:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

- Linux/Mac:

2. Clonación de proyectos

Clona el proyecto par_scrape localmente introduciendo el siguiente comando en el terminal:

git clone https://github.com/paulrobello/par_scrape.git

cd par_scrape

3. Instalación de dependencias

Utilice UV para instalar las dependencias del proyecto:

uv sync

O instalar directamente desde PyPI:

uv tool install par_scrape

# 或使用 pipx

pipx install par_scrape

4. Instalación del dramaturgo (opcional)

Si elige Playwright como rastreador, deberá instalar y configurar su navegador adicionalmente:

uv tool install playwright

playwright install chromium

5. Configurar la clave API

par_scrape soporta múltiples proveedores de AI, es necesario configurar la clave correspondiente en la variable de entorno. Edite ~/.par_scrape.env añada lo siguiente (seleccione lo que desee):

OPENAI_API_KEY=your_openai_key

ANTHROPIC_API_KEY=your_anthropic_key

XAI_API_KEY=your_xai_key

O establezca la variable de entorno antes de ejecutar el comando:

export OPENAI_API_KEY=your_openai_key

Utilización

Una vez completada la instalación puede ejecutar par_scrape desde la línea de comandos, aquí tiene el procedimiento detallado:

Ejemplo de uso básico

Supongamos que desea extraer el título, la descripción y el precio de la página de precios de OpenAI:

par_scrape --url "https://openai.com/api/pricing/" -f "Title" -f "Description" -f "Price" --model gpt-4o-mini --display-output md

--urlDirección de la página web de destino.-fEspecifique el campo de extracción, que puede utilizarse varias veces.--modelSeleccione el modelo de IA (por ejemplo, gpt-4o-mini).--display-outputFormato de salida (md, json, csv, etc.).

Función destacada Operación

- Cambio de herramientas de rastreo

Playwright se utiliza por defecto, si desea utilizar Selenium, puede añadir parámetros:par_scrape --url "https://example.com" -f "Title" --scraper selenium - captura paralela

Establezca el número máximo de peticiones paralelas para mejorar la eficiencia:par_scrape --url "https://example.com" -f "Data" --scrape-max-parallel 5 - Página dinámica en espera

Para el contenido cargado dinámicamente, se pueden establecer tipos de espera y selectores:par_scrape --url "https://example.com" -f "Content" --wait-type selector --wait-selector ".dynamic-content"Los tipos de espera admitidos son

noneypauseysleepyidleyselectorresponder cantandotext. - Ruta de salida personalizada

Guarda los resultados en la carpeta especificada:par_scrape --url "https://example.com" -f "Title" --output-folder ./my_data

Detalles del proceso operativo

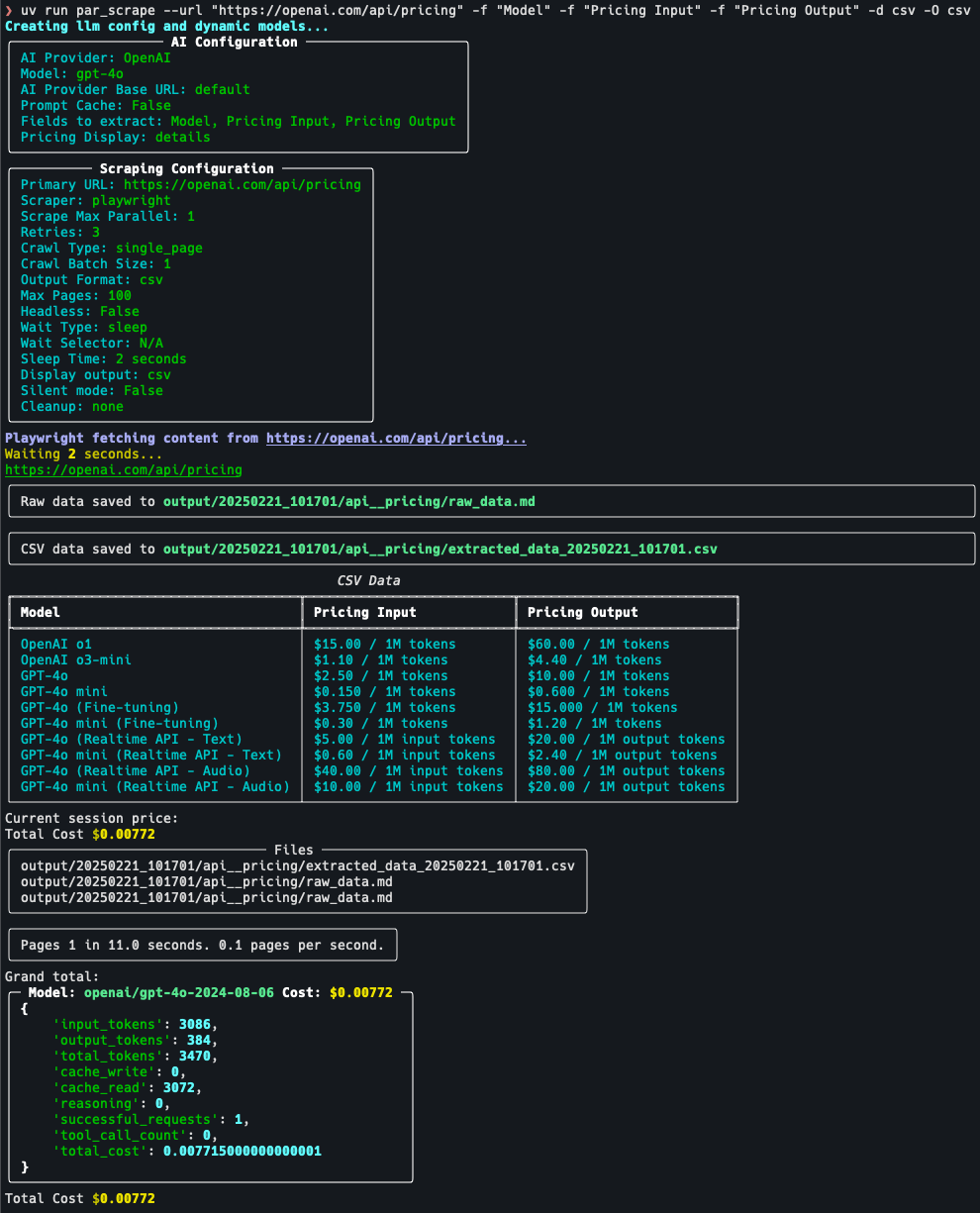

Por ejemplo, la página de precios del rastreo:

- fijación de objetivos: Vaya a https://openai.com/api/pricing/ y confirme que necesita extraer el "Modelo", "Pricing Input" y " Pricing Output".

- Ejecutar comando::

par_scrape --url "https://openai.com/api/pricing/" -f "Model" -f "Pricing Input" -f "Pricing Output" --model gpt-4o-mini --display-output json - Ver resultados: Una vez ejecutado el comando, el terminal muestra los datos en formato JSON o los guarda en el archivo de salida predeterminado.

- Parámetros de ajuste: Si los datos están incompletos, prueba a añadir

--retries 5(número de reintentos) o ajustes--sleep-time 5(Tiempo de espera).

advertencia

- Clave APIAsegúrese de que la clave es válida; de lo contrario, la función de extracción de IA no estará disponible.

- Restricciones del sitio web: Algunos sitios pueden tener un mecanismo anti-crawl y se recomienda utilizar la opción

--headless(modo sin cabeza) o para ajustar la frecuencia de agarre. - Uso de la cachéSi rastrea la misma página varias veces, puede activar la opción

--prompt-cacheCostes reducidos.

Con los pasos anteriores, los usuarios pueden iniciarse rápidamente con par_scrape y completar fácilmente las tareas de extracción de datos de páginas web.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...