Inventario de marcos LLM similares a Ollama: múltiples opciones para grandes modelos desplegados localmente

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 69.4K 00

La aparición del framework Ollama ha atraído sin duda mucha atención en el campo de la Inteligencia Artificial y los Grandes Modelos Lingüísticos (LLM). Este marco de código abierto se centra en simplificar el despliegue y el funcionamiento de los LLM a nivel local, lo que facilita que más desarrolladores experimenten el atractivo de los LLM. Sin embargo, si observamos el mercado, Ollama no está sola, y han surgido muchas otras herramientas del mismo tipo que, en conjunto, ofrecen a los desarrolladores opciones más diversificadas. En este artículo, examinaremos en profundidad algunas de las herramientas que trabajan con Ollama Es de esperar que varias herramientas marco de grandes modelos como éstas ayuden a los lectores a comprender mejor el ecosistema tecnológico en este ámbito y a encontrar la herramienta más adecuada para ellos.

Introducción al marco Ollama

Ollama está diseñado para simplificar la implantación y el funcionamiento de grandes modelos lingüísticos (LLM) en entornos locales. Es compatible con una amplia gama de los principales LLM, como Llama 2, Code Llama, Mistral, Gemma, etc., y permite a los usuarios personalizar y crear sus propios modelos en función de sus necesidades. ChatGPT La interfaz de chat permite a los usuarios interactuar directamente con el modelo sin necesidad de desarrollo adicional. Además, el código limpio de Ollama y su bajo uso de recursos en tiempo de ejecución lo hacen ideal para ejecutarse en un ordenador local.

Herramientas similares a Ollama

Introducción a vLLM

vLLM Vectorised Large Language Model Serving System (VLLM) es un eficiente motor de inferencia y servicio de grandes modelos adaptado a LLM. vLLM mejora significativamente el rendimiento de la inferencia LLM a través de la innovadora tecnología PagedAttention, el procesamiento continuo por lotes, la optimización del núcleo CUDA y el soporte de inferencia distribuida. rendimiento de razonamiento gracias a la innovadora tecnología PagedAttention, el procesamiento continuo por lotes, la optimización del núcleo CUDA y el soporte de razonamiento distribuido.

especificidades

vLLM vLLM admite una gran variedad de formatos de modelos, como PyTorch, TensorFlow, etc., lo que facilita a los usuarios la elección flexible en función de sus necesidades. Al mismo tiempo, vLLM también tiene un motor de inferencia de alto rendimiento que admite la inferencia en línea y la inferencia por lotes, y es capaz de responder rápidamente a un gran número de solicitudes simultáneas, y sigue funcionando bien en escenarios de alta carga.

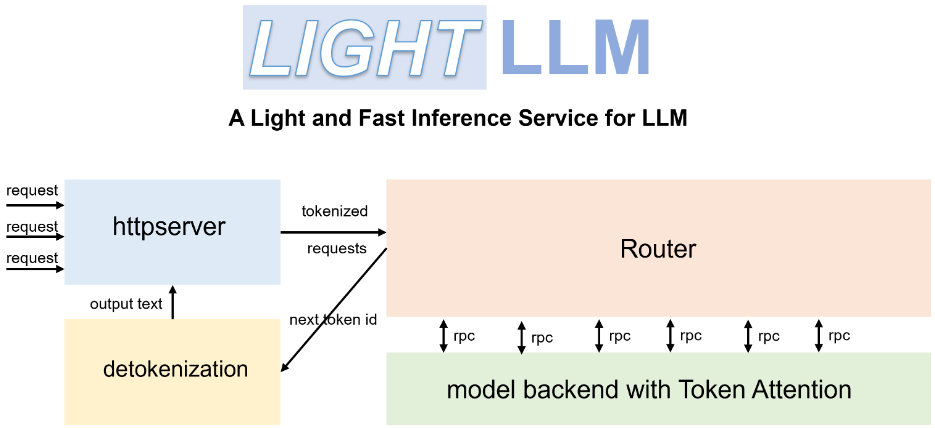

Introducción a LightLLM

LightLLM es un marco de razonamiento y servicio LLM ligero y de alto rendimiento basado en Python. Aprovecha los puntos fuertes de varias implementaciones de código abierto como FasterTransformer, TGI, vLLM y FlashAttention, y proporciona a los usuarios un nuevo modelo de servicio LLM.

especificidades

LightLLM La exclusiva arquitectura de tres procesos desacopla los tres pasos principales de tokenización, inferencia de modelos y detokenización, y los ejecuta en paralelo a través de un mecanismo de colaboración asíncrono. Este diseño mejora significativamente la utilización de la GPU y reduce la latencia causada por la transmisión de datos, lo que mejora eficazmente la eficiencia de la inferencia. Además, LightLLM admite la operación Nopad no-fill, que puede gestionar solicitudes con grandes diferencias de longitud de forma más eficiente y evitar el llenado no válido, mejorando así la utilización de los recursos.

Introducción a llama.cpp

llama.cpp es un motor de inferencia LLM desarrollado en C y C++. Está optimizado para el chip de silicio de Apple y es capaz de ejecutar eficazmente el modelo Llama 2 de Meta en dispositivos Apple.

especificidades

El objetivo principal de llama.cpp es implementar la inferencia LLM en una amplia gama de plataformas de hardware, proporcionando el máximo rendimiento con una configuración mínima. Para mejorar aún más el rendimiento, llama.cpp proporciona una variedad de opciones de cuantificación, como la cuantificación de enteros de 1,5 bits, 2 bits, 3 bits, 4 bits, 5 bits, 6 bits y 8 bits, diseñadas para acelerar la inferencia y reducir la huella de memoria. Además, llama.cpp admite la inferencia mixta CPU/GPU, lo que aumenta aún más la flexibilidad y la eficacia de la inferencia.

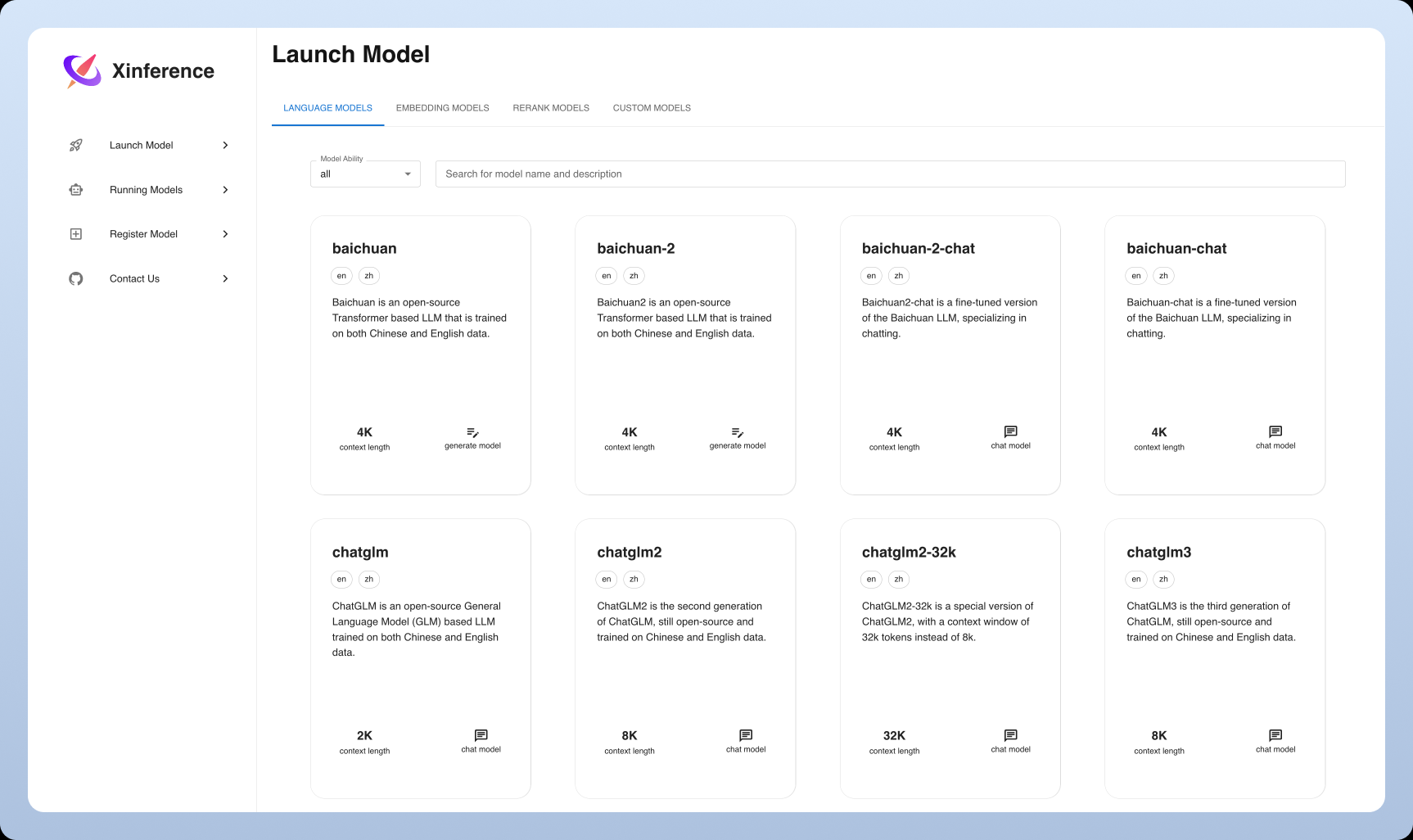

Introducción a Xinference

Xinferencia es un marco emergente de inferencia de propósito general que soporta no sólo LLM, sino también modelos en una variedad de modalidades, incluyendo imagen y habla. Su objetivo es reducir el umbral de despliegue y uso de modelos, proporcionar una interfaz unificada y una experiencia de usuario amigable.

especificidades

Xinferencia Lo más destacado de Xinference es su amplio soporte para modelos multimodales, que permite a los usuarios desplegar y experimentar fácilmente diferentes tipos de modelos en la misma plataforma. Al mismo tiempo, Xinference se centra en la facilidad de uso, proporcionando una variedad de métodos de interacción como Web UI, cliente Python, etc., y apoyando la gestión unificada y la expansión flexible de los modelos.

Comparación y análisis de herramientas

Instalación y despliegue

Ollama. El proceso de instalación es extremadamente sencillo, Ollama proporciona una guía de instalación clara y concisa y es compatible con los principales sistemas operativos. Los usuarios pueden poner en marcha fácilmente modelos lingüísticos de gran tamaño con unas pocas y sencillas operaciones de línea de comandos.

vLLM. En cambio, la instalación de vLLM es algo más complicada, ya que requiere que el usuariode antemanoConfigurar el entorno Python e instalar un conjunto de bibliotecas de dependencias. Sin embargo, una vez desplegado, el eficiente rendimiento de inferencia de vLLM dará a los usuarios un impulso significativo, especialmente en escenarios de rendimiento crítico.

LightLLM. El proceso de instalación de LightLLM es relativamente sencillo, y se proporcionan guías detalladas de instalación y configuración para ayudar a los usuarios a empezar rápidamente. Los usuarios pueden elegir de forma flexible el formato de modelo adecuado para el despliegue en función de sus propias necesidades.

llama.cpp. El despliegue de llama.cpp requiere un cierto nivel de conocimientos técnicos, y el usuario necesita tener lainoportunoConfigurar el entorno de desarrollo C Sin embargo, para los entusiastas de la tecnología y los desarrolladores, una vez configurado, el motor de inferencia de alto rendimiento de llama.cpp proporciona la experiencia de usuario definitiva, con un profundo control sobre cada aspecto de la inferencia de modelos.

Xinferencia. Xinference también es relativamente fácil de instalar y desplegar, ya que proporciona imágenes Docker y paquetes Python para que los usuarios configuren rápidamente sus entornos. Al mismo tiempo, Xinference también proporciona una interfaz Web UI completa, que reduce el umbral de uso.

Compatibilidad de modelos

Ollama. En términos de soporte de modelos, Ollama muestra una buena apertura, soportando muchos modelos de código abierto incluyendo Llama 2, Code Llama, etc., y permitiendo a los usuarios subir modelos personalizados. Además, Ollama proporciona una biblioteca de modelos preconstruidos para que los usuarios puedan empezar rápidamente con varios modelos.

vLLM. vLLM destaca en la compatibilidad de formatos de modelos, ya que admite PyTorch, TensorFlow y muchos otros formatos de modelos importantes.factible El usuario максимально la selección flexible del modelo. Cabe mencionar que vLLM también admite la inferencia distribuida, que puede aprovechar al máximo la potencia aritmética de varias GPU para ejecutar modelos en paralelo, lo que mejora aún más la eficiencia de la inferencia.

LightLLM. LightLLM también tiene una excelente compatibilidad de formatos de modelo, ya que admite una gran variedad de formatos de modelo de uso común. Al mismo tiempo, LightLLM proporciona ricas API y herramientas para facilitar una personalización en profundidad y satisfacer las necesidades de una gama más amplia de usuarios.especialLa necesidad de escenarios de aplicación.

llama.cpp. llama.cpp se centra en la optimización del modelo Llama para la inferencia extrema, pero también admite otros modelos. Su eficiente motor de inferencia permite a llama.cpp mantener un rendimiento excelente cuando se trata de grandes conjuntos de datos.

Xinferencia. Uno de los aspectos más destacados de Xinference es su soporte de modelos, que no sólo admite varios LLM, sino también modelos de generación de imágenes como Stable Diffusion, y Susurro y otros modelos del habla, lo que demuestra una gran compatibilidad de los modelos multimodales y ofrece a los usuarios un espacio de aplicación más amplio.

Rendimiento y optimización

Ollama. Ollama es conocida por su limpia API y su eficiente rendimiento de inferencia, pero puede haber cuellos de botella de rendimiento en escenarios con un gran número de peticiones concurrentes. Ollama sigue siendo una buena opción para los usuarios que buscan facilidad de uso y rapidez de despliegue.

vLLM. vLLM está diseñado para ofrecer un rendimiento extremo. Mejora significativamente el rendimiento del razonamiento LLM a través de técnicas como PagedAttention, especialmente cuando se trata de un gran número de solicitudes concurrentes, y es capaz de satisfacer escenarios de aplicación con estrictos requisitos de rendimiento del servicio.

LightLLM. LightLLM también dedica un gran esfuerzo a la optimización del rendimiento. Gracias a su exclusiva arquitectura de tres procesos y al mecanismo de colaboración asíncrona, LightLLM mejora eficazmente la utilización de la GPU y la velocidad de inferencia. Además, LightLLM admite la operación Nopad no-fill, que mejora aún más la utilización de los recursos. Contribuye al rendimiento general.

llama.cpp. llama.cpp también destaca en términos de rendimiento. No sólo tiene un motor de inferencia eficiente, sino que también ofrece una variedad de opciones de cuantificación que permiten flexibilidad entre la velocidad de inferencia y el uso de memoria.equilibrioEl razonamiento de llama.cpp se basa en el razonamiento híbrido CPU/GPU. Además, llama.cpp también soporta la inferencia mixta CPU/GPU, lo que mejora aún más la flexibilidad y la eficiencia de la inferencia, permitiendo a los usuarios realizar lamejor (atleta, película, etc.)Configuración.

Xinferencia. Xinference también se ha optimizado para mejorar el rendimiento, con el apoyo de técnicas como la cuantificación y la poda de modelos para mejorar la eficacia de la inferencia y reducir el consumo de recursos. Además, Xinference también se optimiza iterativamente para mejorar el rendimiento de la inferencia de modelos multimodales.

Resumen y perspectivas

Las herramientas similares a Ollama tienen sus propias características y ventajas, y los usuarios pueden elegir el marco adecuado según los escenarios de aplicación y las necesidades reales. Con el continuo desarrollo de la inteligencia artificial y la tecnología de modelado lingüístico a gran escala, estas herramientas seguirán mejorando y actualizándose, proporcionando a los usuarios soluciones más eficaces y cómodas. De cara al futuro, estas herramientas desempeñarán un papel más importante en el procesamiento del lenguaje natural, la atención al cliente inteligente, la generación de textos y otros campos, promoviendo aún más el desarrollo y la aplicación de la tecnología de inteligencia artificial, y en última instanciarealizar Una hermosa visión de la Inteligencia Artificial para todos.

Recomendaciones y sugerencias

Ollama puede ser una buena opción para usuarios principiantes e individuales. Ollama proporciona una API sencilla y una interfaz de usuario amigable, que permite a los usuarios interactuar con los modelos directamente sin desarrollo adicional. Además, Ollama soporta una amplia gama de modelos de código abierto, lo que facilita a los usuarios empezar rápidamente y probar varios escenarios de aplicación, y experimentar rápidamente la diversión de desplegar LLM localmente.

Para los usuarios empresariales que necesitan gestionar solicitudes altamente concurrentes, vLLM puede ser una mejor opción. El eficiente rendimiento de razonamiento y el soporte de razonamiento distribuido de vLLM pueden satisfacer las demandas de escenarios altamente concurrentes y proporcionar a los usuarios una solución más estable y fiable para garantizar la continuidad del negocio.Estabilidad y continuidad.

LightLLM y llama.cpp son más adecuadas para usuarios con cierta base técnica para el desarrollo a medida y la optimización en profundidad. Estas dos herramientas proporcionan a los desarrolladores una mayor flexibilidad y un mayor control sobre el subyacente admisible El usuario es responsable delespecificación Cree aplicaciones LLM más personalizadas y de alto rendimiento.

Xinference también es una opción para quienes desean experimentar con modelos multimodales y buscan una experiencia "lista para usar". Xinference reduce las barreras para utilizar modelos multimodales, permitiendo a los usuarios experimentar la potencia de una amplia gama de modelos de IA en una única plataforma.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...