OpenAI-o3 e ideas de Monte-Carlo

Base de conocimientos de IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 36.4K 00

o3 está aquí para compartir algunas ideas personales. Acerca de Test-time Ley de escalado progreso, mucho más rápido de lo que pensábamos. Pero yo diría que el camino es en realidad un poco enrevesado: es la forma que tiene OpenAI de tomar una curva en su búsqueda de la AGI.

Aprendizaje intensivo y pensamiento abreviado

¿Por qué? Veámoslo con dos ejemplos.

El primer ejemplo procede del aprendizaje por refuerzo. En la RL, el factor de descuento desempeña un papel fundamental, lo que implica que la recompensa obtenida disminuirá gradualmente cuanto más avancen los pasos de la toma de decisiones. Por tanto, el objetivo del aprendizaje por refuerzo suele ser maximizar las recompensas en el menor tiempo y con el menor número de pasos posibles. En el núcleo de esta estrategia, se hace hincapié en los "atajos", es decir, en obtener la recompensa lo antes posible.

El segundo ejemplo es el proceso de ajuste de grandes modelos. Un modelo preentrenado que no ha sido ajustado suele carecer de dirección o control claros. Cuando preguntamos al modelo "¿Dónde está la capital de China?" puede que primero diga "Buena pregunta" y luego se salga por la tangente antes de dar finalmente la respuesta "Pekín". Sin embargo, cuando se hace la misma pregunta a un modelo afinado, la respuesta es directa y clara: "Pekín".

Este modelo afinado demuestra una forma de obtener atajos mediante estrategias de optimización -semejantes al viaje evolutivo de los seres humanos-, buscando siempre el menor consumo de energía y el camino más corto.

¿Por qué razonar?

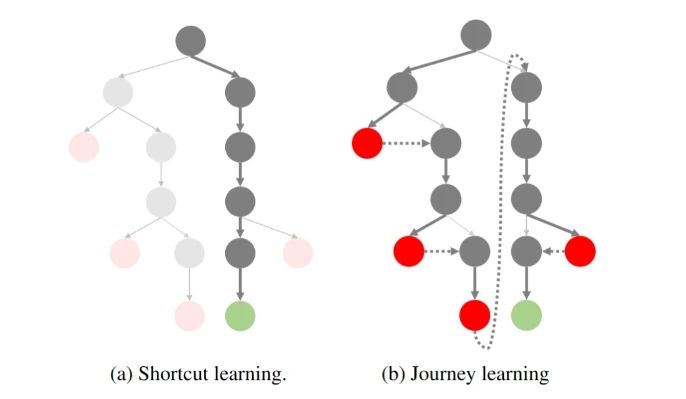

Si visualiza el proceso de muestreo de Razonamiento como un árbol:

Viaje a la replicación O1: Parte 1

A la izquierda está el aprendizaje por atajos que hemos perseguido en el pasado: el menor número de pasos para llegar al resultado correcto. A la derecha está el paradigma "reflexivo, retrospectivo" representado por OpenAI o1.

Sabemos que mientras o1 realiza una búsqueda, el modelo está constantemente reflexionando y retrocediendo, y este proceso suele ir acompañado de sobrecargas adicionales. El problema es que, ¿quién quiere gastar tiempo y dinero en una búsqueda compleja si el modelo puede dar realmente la respuesta correcta una y otra vez? OpenAI no es estúpido, ¡y todos sabemos que los atajos son mejores!

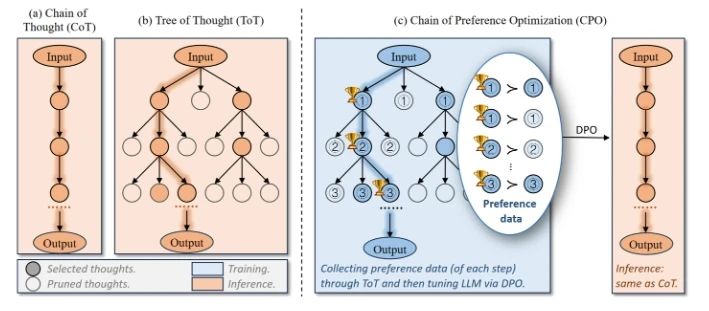

Cuanto más difícil es el problema, más amplio es el árbol potencial de ideas, más espacio de búsqueda hay en cada paso y menos probable es que un atajo conduzca a la respuesta correcta. Entonces, ¿qué hacer? Una forma intuitiva de pensar en ello es optar por la poda. Cortar de antemano los nodos del árbol que tienen pocas probabilidades de llegar al punto final, comprimiendo el espacio de búsqueda y volviendo a convertir el árbol en uno estrecho. Esto es lo que intentan hacer muchos de los esfuerzos actuales, por ejemplo:

Optimización de la cadena de preferencias (CPO)

La optimización de la cadena de preferencias consiste en construir de forma natural los datos de preferencias a partir del árbol de pensamiento y, a continuación, utilizar la OPD para optimizarlos, de modo que el modelo tenga una mayor probabilidad de seleccionar el nodo del árbol que llegará al punto final.

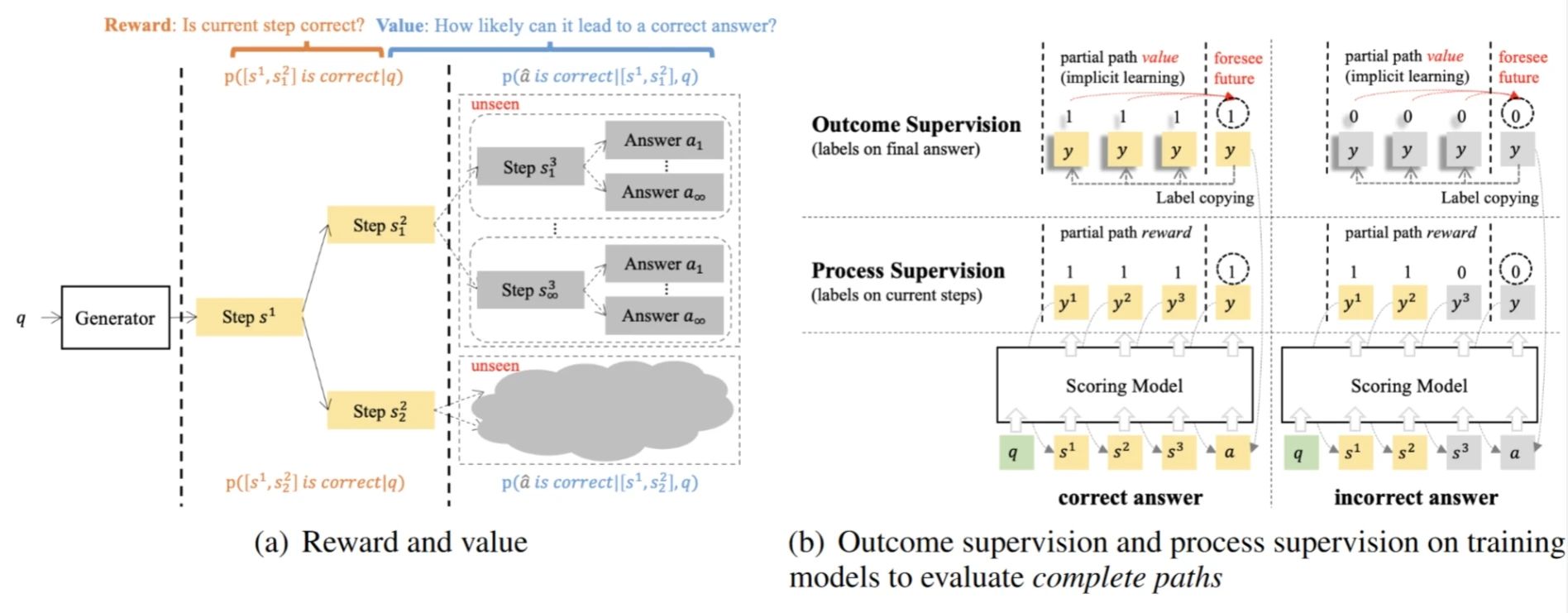

Modelos de valor supervisados por resultados (OVM)

Outcome-supervised Value Models es la modelización del razonamiento como un proceso MDP, donde la probabilidad de llegar a la respuesta correcta en el paso actual (Valor) se utiliza para guiar la optimización de la estrategia.

¿Por qué OpenAI decidió romper con los atajos tradicionales?

Volviendo a o1, ¿por qué decidió romper con la idea del atajo tradicional y optar por el "desvío" de la búsqueda en el árbol?

Si en el pasado hemos tendido a explotar las capacidades básicas de los modelos (Exploit), cabría suponer que los modelos GPT-4 existentes han sido capaces de satisfacer la mayoría de las necesidades de diálogo y razonamiento simple. Y estas tareas se pueden muestrear bien, evaluar las preferencias y optimizar de forma iterativa.

Pero esta perspectiva ignora la necesidad de tareas más complejas -como el razonamiento matemático (AIME, Frontier Math), la generación de código (SWE-Bench, CodeForce), etc.-, que a menudo son difíciles de recompensar a corto plazo. -sus recompensas son muy escasas, y las recompensas sólo se hacen patentes cuando finalmente se alcanza la respuesta correcta.

En consecuencia, el aprendizaje tradicional por atajos ya no es adecuado para abordar este tipo de tareas complejas: ¿cómo se puede hablar de optimizar la probabilidad de que el modelo elija el camino correcto cuando ni siquiera se puede muestrear un camino correcto?

Volviendo a la "idea de Monte-Carlo" del título de este artículo, podemos ver que en realidad se trata de lo mismo: el núcleo del enfoque de Monte-Carlo para el aprendizaje por refuerzo reside en estimar el valor de una política muestreándola varias veces y optimizando así el modelo. Sin embargo, este enfoque tiene una limitación natural: si las políticas muestreadas no pueden muestrear los caminos óptimos, la optimización del modelo siempre acabará en un óptimo local. Por eso optamos por estrategias más exploratorias en MC Learning.

Por ello, OpenAI optó por romper las escalas del aprendizaje por refuerzo alejándose de la mentalidad tradicional de atajo para pasar a la exploración por refuerzo (Explore).

o1 Avances: de la exploración a la optimización

En este contexto, OpenAI propuso el paradigma o1. Este cambio permite al modelo empezar a obtener recompensas dispersas de forma gradual cuando se enfrenta a tareas complejas. Y a través de estas recompensas, la estrategia puede optimizarse continuamente. Aunque este proceso de exploración pueda parecer engorroso e ineficiente, sienta las bases para una mayor optimización del modelo.

Entonces, ¿de dónde viene el o1? Recientemente también han aparecido muchos trabajos para replicar o1, ¿qué están haciendo? Si la política de comportamiento utilizada para la exploración es el enfoque On-Policy, se está muestreando con el modelo actual (por ejemplo, GPT-4o), que sigue siendo demasiado ineficiente.

Así que los chicos eligieron por unanimidad el método Off-Policy:

OpenAI gasta mucho dinero en contratar estudiantes de doctorado para anotar los datos de Long CoT; ¿No hay dinero? ¿Qué podemos hacer si no tenemos dinero? Entonces podemos colaborar con humanos y máquinas para anotar los datos (destilar manualmente o1), y reducir los requisitos para los anotadores; ¿Ni siquiera tenemos dinero para encontrar anotadores? Entonces tenemos que destilar R1 / QwQ, o pensar en otras formas (Crítica, PRM, etc.). También me gustaría recordar a los grandes fabricantes y laboratorios que reproducen activamente el o1 que no olviden que el objetivo último de la exploración sigue siendo la optimización.

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

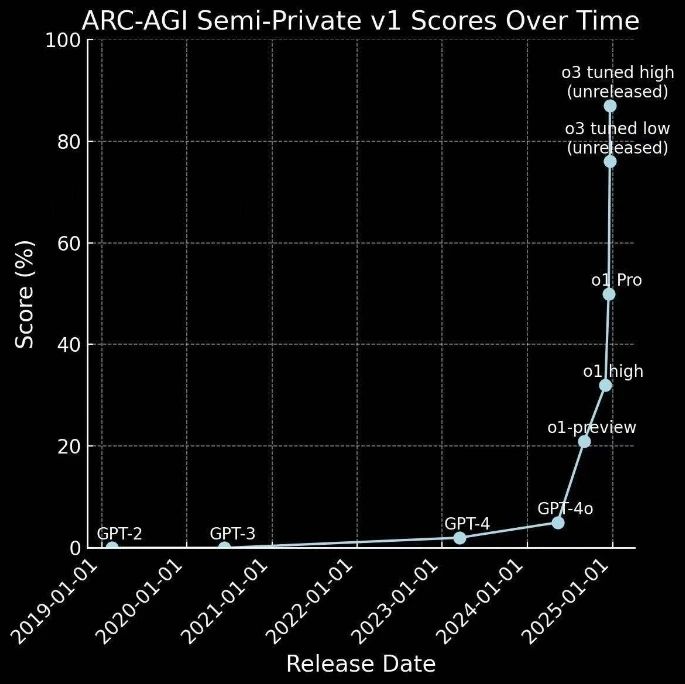

Evolución rápida de o1 a o3

El o1 acaba de salir hace unos meses y aquí llega el o3.

De hecho, esto se aparta de la conjetura anterior: si GPT-4 representa una progresión de 0 a 1 -es decir, de tareas sencillas a la obtención de recompensas-, entonces o1 representa un salto de 1 a 10 -explorando tareas complejas y obteniendo raras recompensas raras, proporcionando una cantidad sin precedentes de datos de alta calidad para una mayor optimización de la estrategia.

Por tanto, ha avanzado más rápido de lo que nadie esperaba:

Esto no es sólo una aplicación exitosa de la estrategia de exploración, sino también un paso importante para la tecnología de IA hacia la AGI.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...