Introducción al macromodelo OpenAI o1-mini

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 37.2K 00

Fomento de técnicas de razonamiento rentables.

Hemos lanzado OpenAI o1-mini, un modelo de inferencia rentable. o1-mini destaca en STEM, especialmente en matemáticas y programación, con un rendimiento casi tan bueno como el OpenAI o1 rendimiento comparable en pruebas de referencia como AIME y Codeforces. Prevemos que o1-mini se convertirá en una opción más rápida y asequible para escenarios de aplicación que requieran razonamiento pero no dependan de un amplio conocimiento del mundo.

Hoy ofrecemos el OpenAI o1-preview para 80% más barato que el OpenAI o1-preview. usuarios de la API de nivel 5 (se abre en una ventana nueva) Lanzamiento de o1-mini. Los usuarios de ChatGPT Plus, Team, Enterprise y Edu pueden utilizar o1-mini como alternativa a o1-preview, disfrutando de mayores límites de uso y menor latencia, ver [Velocidad del modelo.

Optimizado para el razonamiento STEM

Los grandes modelos lingüísticos como o1 suelen preentrenarse en conjuntos de datos textuales a gran escala. A pesar de su amplio conocimiento del mundo, estos modelos de gran capacidad pueden resultar caros y lentos en aplicaciones del mundo real. En cambio, o1-mini es un modelo pequeño optimizado específicamente para la inferencia STEM durante la fase de preentrenamiento. Tras ser entrenado utilizando el mismo proceso de aprendizaje por refuerzo (RL) de alto volumen computacional que o1, o1-mini obtiene resultados comparables en muchas tareas prácticas de razonamiento, a la vez que resulta significativamente más rentable.

En pruebas comparativas que requieren inteligencia y razonamiento, o1-mini supera a o1-preview y a o1. Sin embargo, o1-mini obtiene resultados mediocres en tareas que requieren conocimientos factuales no relacionados con las TME, véase [Limitaciones].

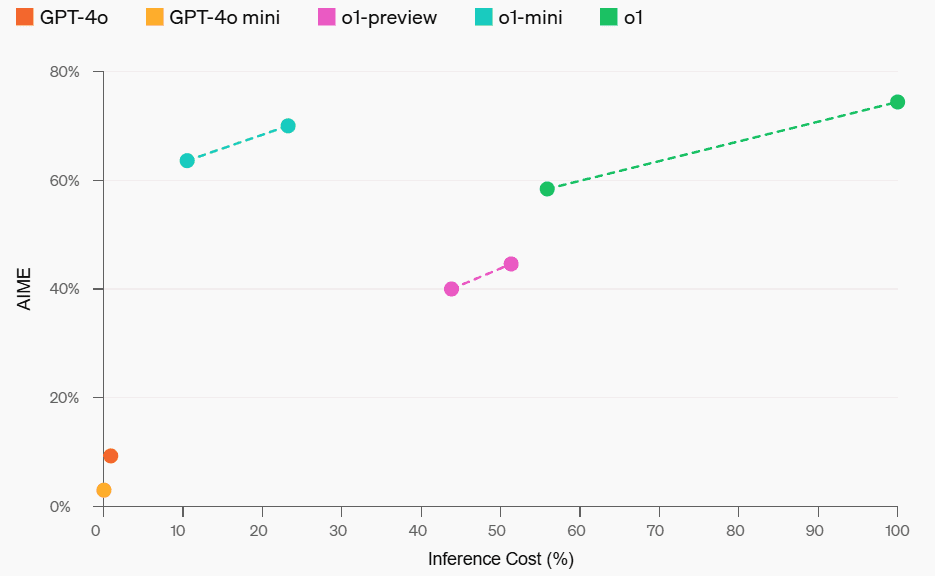

Rendimiento matemático y costes de razonamiento

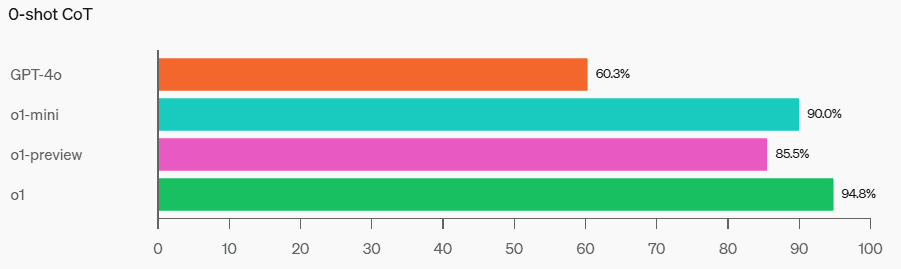

Matemáticas: En el Concurso de Matemáticas AIME de Secundaria, el o1-mini (70,0%) rindió tan bien como el o1 (74,4%) -y significativamente más barato- y mejor que el o1-preview ( 44,6%). Las puntuaciones de o1-mini (unas 15 de cada 11 preguntas contestadas correctamente) lo sitúan aproximadamente entre los 500 mejores estudiantes de secundaria de Estados Unidos.

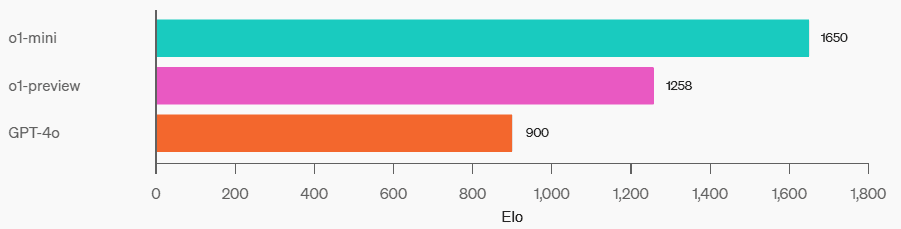

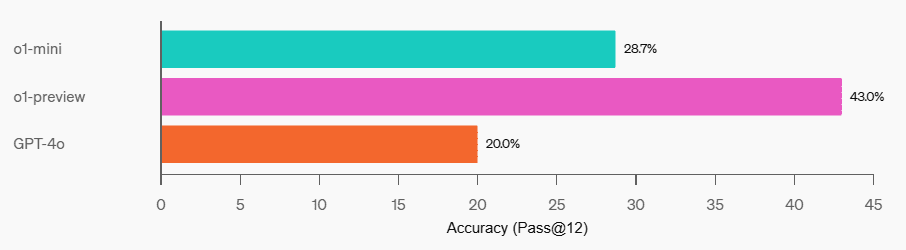

Programación: En el sitio web de la competición Codeforces, o1-mini tiene una puntuación Elo de 1650, comparable a la de o1 (1673) y superior a la de o1-preview (1258). Esta puntuación Elo sitúa a o1-mini en el percentil 86 de los mejores programadores de la plataforma Codeforces. o1-mini también obtuvo muy buenos resultados en las pruebas de programación HumanEval y en los desafíos de captura la bandera (CTF) de ciberseguridad de nivel de secundaria.

Codeforces

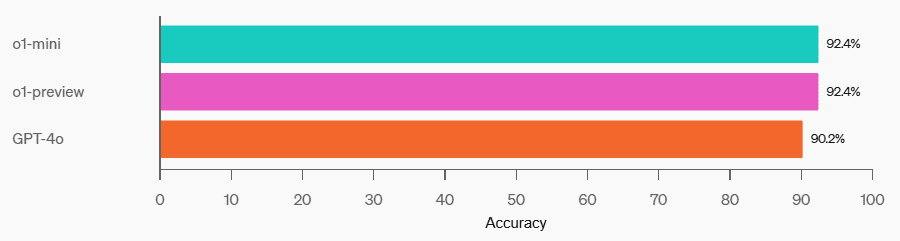

HumanEval

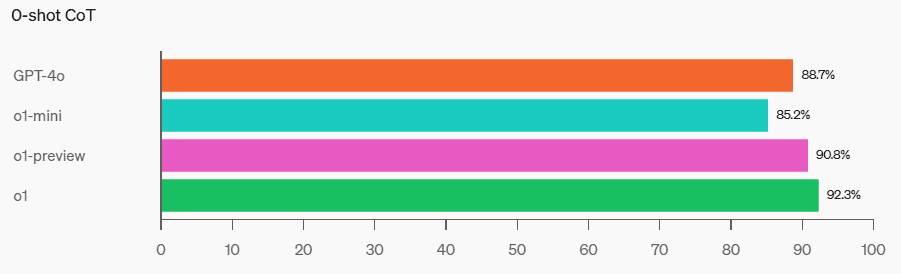

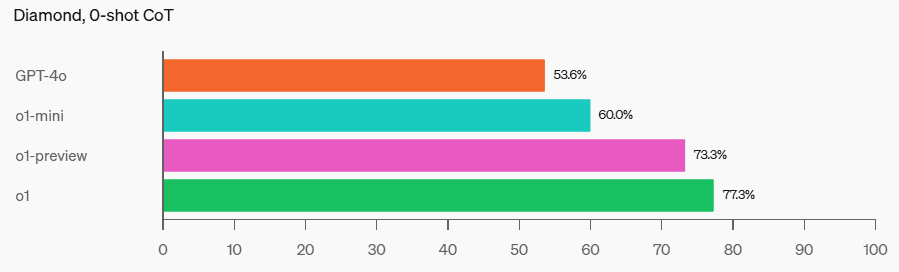

Ciberseguridad CTF

STEM: En algunas pruebas académicas que requieren razonamiento, como el GPQA (ciencias) y el MATH-500, el o1-mini supera al GPT-4o. El o1-mini no rinde tan bien como el GPT-4o en la tarea MMLU y queda por detrás del o1-preview en el GPQA porque carece de amplios conocimientos del mundo.

MMLU

GPQA

MATH-500

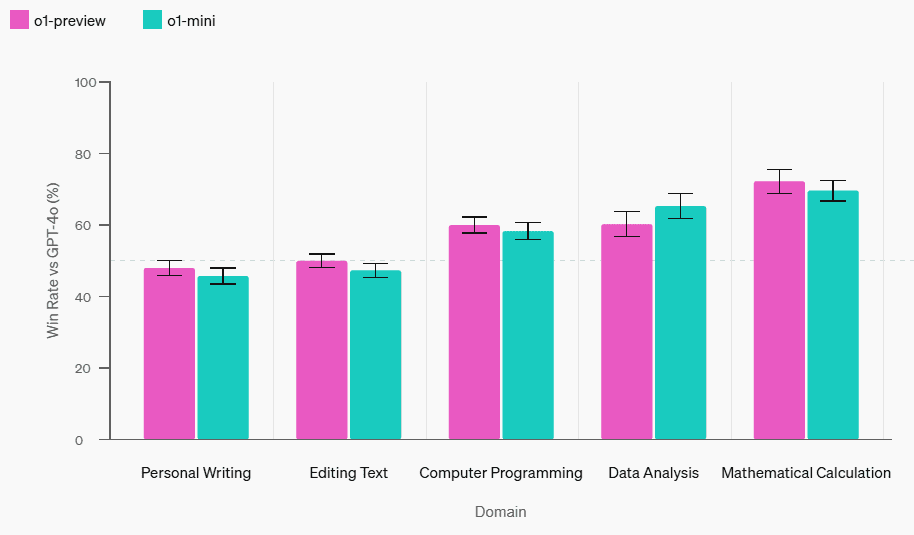

Evaluación de las preferencias humanas: Pedimos a los evaluadores que compararan o1-mini con GPT-4o en rompecabezas abiertos de diversos ámbitos, utilizando la misma metodología que en [o1-preview comparado con GPT-4o](https://openai.com/index/learning-to-reason-with-llms/). Al igual que en o1-preview, o1-mini es más popular que GPT-4o en dominios que requieren razonamiento, pero menos popular que GPT-4o en dominios centrados en el lenguaje.

Evaluación de las preferencias humanas frente a chatgpt-4o-latest

velocidad del modelo

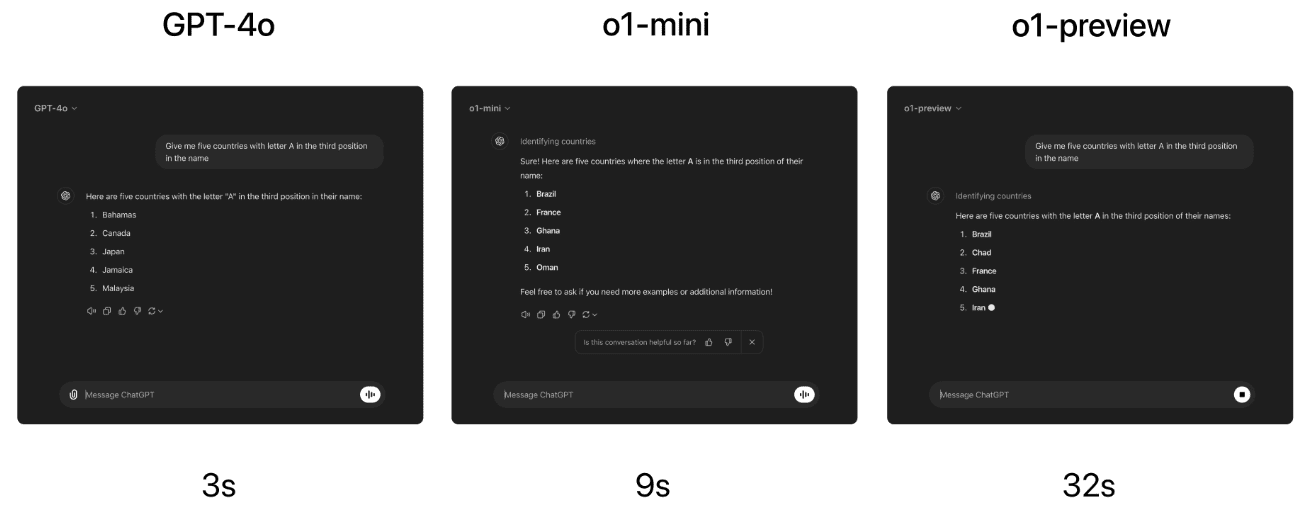

Como ejemplo concreto, comparamos las respuestas de GPT-4o, o1-mini y o1-preview en un problema de razonamiento léxico. Mientras que GPT-4o dio una respuesta incorrecta, tanto o1-mini como o1-preview dieron la respuesta correcta, y o1-mini respondió entre 3 y 5 veces más rápido.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...