Open-LLM-VTuber: un compañero virtual de IA animada en Live2D para la interacción por voz en tiempo real.

Últimos recursos sobre IAPublicado hace 10 meses Círculo de intercambio de inteligencia artificial 133.7K 00

Introducción general

Open-LLM-VTuber es un proyecto de código abierto que permite a los usuarios interactuar con grandes modelos lingüísticos (LLM) a través del habla y el texto, e incorpora la tecnología Live2D para presentar personajes virtuales dinámicos. Es compatible con Windows, macOS y Linux, se ejecuta completamente sin conexión y tiene modos de cliente web y de escritorio. Los usuarios pueden utilizarlo como novia virtual, mascota o asistente de escritorio, creando un compañero de IA personalizado mediante la personalización de su aspecto, personalidad y voz. El proyecto comenzó como una réplica del ancla virtual de IA de código cerrado "neuro-sama" y ha evolucionado hasta convertirse en una plataforma rica en funciones que admite múltiples modelos lingüísticos, reconocimiento de voz, conversión de texto a voz y percepción visual. La versión actual se ha refactorizado con la v1.0.0 y está en desarrollo activo, con más funciones que se añadirán en el futuro.

Lista de funciones

- interacción por voz: Compatible con el diálogo de voz manos libres, los usuarios pueden interrumpir la IA en cualquier momento para una comunicación fluida.

- Animación Live2DAvatares dinámicos incorporados que generan expresiones y acciones basadas en el contenido del diálogo.

- Soporte multiplataformaCompatible con Windows, macOS y Linux, admite GPU y CPU NVIDIA y no NVIDIA.

- operación offlineTodas las funciones pueden ejecutarse sin red para garantizar la privacidad y la seguridad.

- Modo Mascota de sobremesa: Se admiten el fondo transparente, la parte superior global y la penetración del ratón, y los caracteres pueden arrastrarse a cualquier posición de la pantalla.

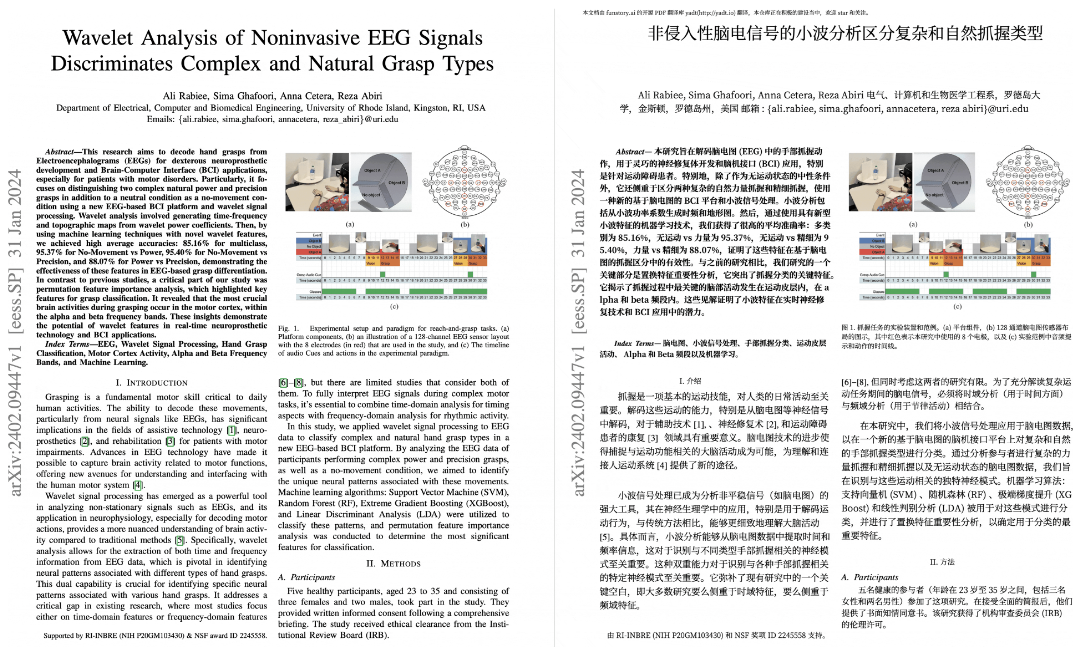

- percepción visual: Interacción de vídeo con IA a través de la cámara o el reconocimiento del contenido de la pantalla.

- Compatibilidad con varios modelosCompatible con una amplia gama de LLM como Ollama, OpenAI, Claude, Mistral y otros módulos de voz como sherpa-onnx y Whisper.

- Personalización de personajes: Se pueden importar modelos Live2D para ajustar el carácter y la voz.

- retroalimentación táctilHaz clic o arrastra al personaje para activar una respuesta interactiva.

- Mantenimiento de registros de chat: Soporte para cambiar los diálogos históricos y conservar el contenido interactivo.

Utilizar la ayuda

Proceso de instalación

Open-LLM-VTuber necesita ser desplegado localmente, aquí están los pasos detallados:

1. Condiciones previas

- software: Compatible con ordenadores Windows, macOS o Linux con GPU NVIDIA recomendadas (puede ejecutarse sin GPU).

- hardwareInstala Git, Python 3.10+ y uv (la herramienta de gestión de paquetes recomendada).

- reticulación: El despliegue inicial requiere una conexión a Internet para descargar la dependencia, se recomienda que los usuarios chinos utilicen la aceleración por proxy.

2. Descarga del código

- Clona el proyecto a través del terminal:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive cd Open-LLM-VTuber

- O descargue el último archivo ZIP de GitHub Release y extráigalo.

- Nota: Si no se utiliza

--recursiveNecesario para funcionargit submodule update --initObtener el submódulo front-end.

3. Instalación de dependencias

- Instalar uv:

- Windows (PowerShell):

irm https://astral.sh/uv/install.ps1 | iex - macOS/Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

- Windows (PowerShell):

- Ejecutar en el directorio del proyecto:

uv syncInstala automáticamente FastAPI, onnxruntime y otras dependencias.

4. Entorno de configuración

- La primera ejecución genera un archivo de configuración:

uv run run_server.py - Editar el archivo generado

conf.yamlConfigure lo siguiente:- LLM: Seleccione el modelo (por ejemplo Ollama (para la API llama3 u OpenAI, es necesario rellenar la clave).

- ASRMódulo de reconocimiento de voz (por ejemplo, sherpa-onnx).

- TTSMódulos de conversión de texto a voz (por ejemplo, Edge TTS).

- Ejemplo:

llm: provider: ollama model: llama3 asr: provider: sherpa-onnx tts: provider: edge-tts

5. Activación de los servicios

- Corriendo:

uv run run_server.py - entrevistas

http://localhost:8000Utiliza la versión web o descarga el cliente de escritorio para ejecutarlo.

6. Cliente de escritorio (opcional)

- Descargar desde GitHub Release

open-llm-vtuber-electron(.exe para Windows, .dmg para macOS). - Inicie el cliente y asegúrese de que el servicio back-end se está ejecutando para experimentar el modo pet de escritorio.

7. Actualización y desinstalación

- actualizacióndespués de v1.0.0

uv run update.pyActualizaciones, las versiones anteriores deben volver a desplegarse con la documentación más reciente. - desinstalaciónBorrar la carpeta del proyecto

MODELSCOPE_CACHEtal vezHF_HOMELos archivos del modelo en el modelo, desinstalar herramientas como uv.

Función Flujo de operaciones

interacción por voz

- Activar vozHaga clic en el icono "Micrófono" de la página web o del cliente.

- diálogos: Habla directamente y la IA responde en tiempo real; pulsa el botón "interrumpir" para interrumpir a la IA.

- optimización: en

conf.yamlAjuste los módulos ASR y TTS para mejorar el reconocimiento y la pronunciación.

Personalización de personajes

- Modelo de importación: Coloca el archivo .moc3 en la carpeta

frontend/live2d_modelsCatálogo. - Ajuste de la personalidad:: Editorial

conf.yaml(utilizado como expresión nominal)promptComo una "tierna hermana mayor". - Personalización del sonido: Graba muestras utilizando herramientas como GPTSoVITS para generar voces únicas.

Modo Mascota de sobremesa

- Modo abierto: En el cliente, seleccione "Mascotas de escritorio", marque "Fondo transparente" y "Arriba".

- imagen en movimientoArrastre a cualquier posición de la pantalla.

- interactividadToca un personaje para activar la retroalimentación táctil y ver un monólogo interior o un cambio de expresión.

percepción visual

- Activar la cámaraHaga clic en "Video Chat" para autorizar el acceso.

- reconocimiento en pantalla: Selecciona "Screen Sense" para que la IA analice el contenido de la pantalla.

- ejemplo típicoPregunte "qué hay en la pantalla" y la IA describirá la imagen.

advertencia

- navegador (software): Se recomienda Chrome, otros navegadores pueden afectar a la visualización de Live2D.

- actuacionesAceleración de GPU : la aceleración de GPU requiere controladores correctamente configurados y puede funcionar más lentamente en la CPU.

- licenciaEl modelo de muestra integrado en Live2D está sujeto a una licencia independiente. Para uso comercial, póngase en contacto con Live2D Inc.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...