OneCAT - Modelo multimodal de código abierto para Meituan y la Universidad Jiaotong de Shanghai

Últimos recursos sobre IAPublicado hace 6 meses Círculo de intercambio de inteligencia artificial 34.3K 00

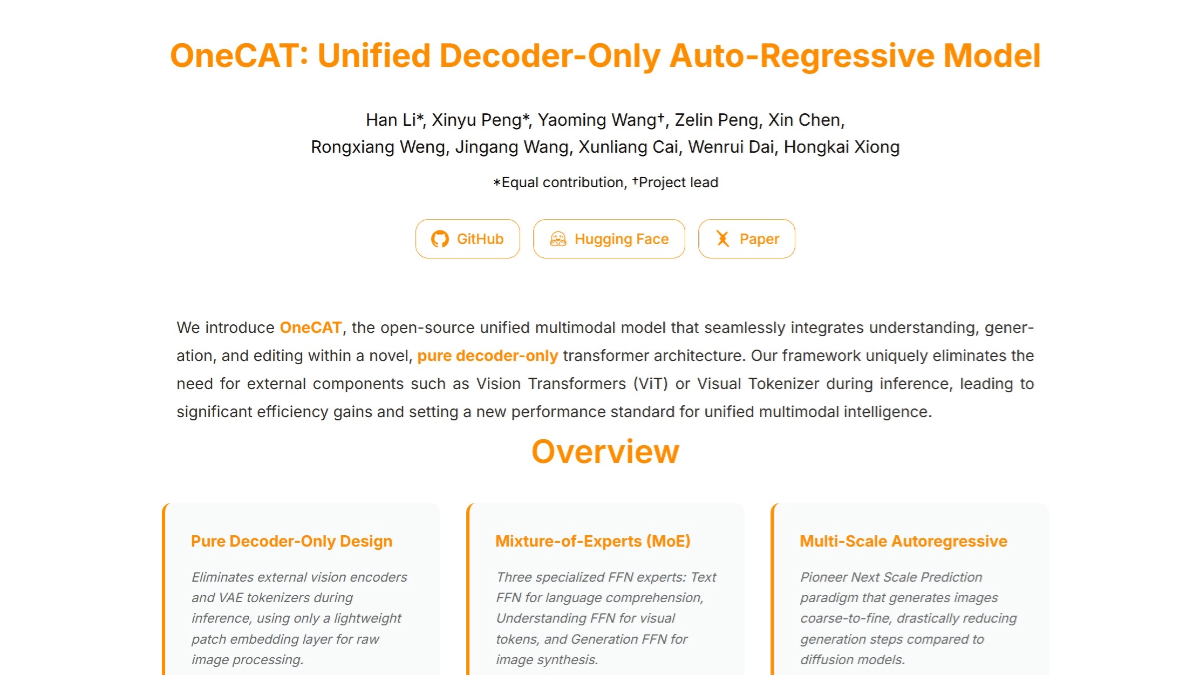

Qué es OneCAT

OneCAT es un nuevo modelo multimodal unificado lanzado por Meituan en colaboración con la Universidad Jiaotong de Shanghai, que adopta una arquitectura de descodificador puro y puede integrar a la perfección funciones de comprensión multimodal, generación de texto a imagen y edición de imágenes. El modelo abandona el diseño de los modelos multimodales tradicionales, que dependen de codificadores y desambiguadores visuales externos, y logra un procesamiento multimodal eficiente mediante una arquitectura de mezcla de expertos (MoE) específica para cada modalidad y un mecanismo autorregresivo multiescala.Los principales puntos fuertes de OneCAT residen en su arquitectura concisa y en la mejora significativa de la eficiencia de la inferencia, especialmente cuando se trata de entradas y salidas de imágenes de alta resolución. Además, mejora la capacidad de generación visual y la alineación intermodal mediante adaptadores innovadores que tienen en cuenta la escala y mecanismos de atención multifuncional multimodal. OneCAT ha demostrado un excelente rendimiento en múltiples pruebas comparativas de comprensión multimodal, generación de texto a imagen y edición de imágenes, estableciendo un nuevo estándar para el desarrollo de la inteligencia multimodal unificada.

Características de OneCAT

- Procesamiento multimodal eficazLa arquitectura de descodificación pura, que elimina la necesidad de codificadores visuales externos o divisores de palabras, simplifica significativamente la estructura del modelo y reduce la sobrecarga computacional, especialmente cuando se procesan entradas de alta resolución.

- Potentes funciones generativasEl mecanismo multiescala autorregresivo puede generar gradualmente imágenes de alta calidad de gruesas a finas, lo que resulta adecuado para tareas de generación de texto a imagen y de edición de imágenes con excelentes resultados de generación.

- Edición flexible de imágenes: Admite la edición de imágenes basada en comandos con ajustes locales y globales precisos de las imágenes basados en comandos del usuario, lo que permite potentes capacidades de generación condicional sin modificaciones adicionales de la arquitectura.

- Capacidad de alineación intermodalMejora de la alineación entre diferentes modalidades y del rendimiento del modelo en tareas multimodales mediante estructuras de Mezcla de Expertos (MoE) específicas de cada modalidad y capas de atención y QKV compartidas.

- Resolución dinámicaSoporte nativo para resolución dinámica, capaz de adaptarse a diferentes tamaños de entradas, mejorando la flexibilidad y aplicabilidad del modelo.

Principales ventajas de OneCAT

- Arquitectura sencilla y eficazEl uso de una arquitectura de decodificación pura sin necesidad de un codificador visual externo o un desambiguador simplifica significativamente la estructura del modelo y reduce la carga computacional, especialmente cuando se trata de entradas de alta resolución, con un aumento significativo de la eficiencia de la inferencia.

- Gran capacidad de fusión multimodalLa estructura de mezcla de expertos (Mixing of Experts, MoE) específica de cada modalidad permite procesar a la perfección texto, imágenes y otros datos multimodales para lograr funciones eficientes de comprensión, generación y edición multimodal, lo que mejora la profundidad y la eficiencia de la fusión de información entre modalidades.

- Excelente rendimiento de generaciónLa innovadora introducción de un mecanismo autorregresivo visual multiescala para generar imágenes de forma incremental de grueso a fino reduce drásticamente el número de pasos de descodificación al tiempo que mantiene unos resultados visuales de alta calidad, y demuestra un sólido rendimiento en tareas de generación de texto a imagen y de edición de imágenes.

- Fuerte adhesión al mandoFunciones: Demuestra una excelente adherencia a los comandos en tareas de generación y edición multimodal, comprende y ejecuta con precisión los comandos del usuario y genera contenidos de imagen conformes que mejoran la experiencia del usuario.

- Resolución dinámicaEl apoyo nativo a la resolución dinámica y la capacidad de adaptarse a entradas de diferentes tamaños mejoran la flexibilidad y la aplicabilidad del modelo a una amplia gama de escenarios de aplicación.

¿Cuál es la página web oficial de OneCAT?

- Página web del proyecto:: https://onecat-ai.github.io/

- Repositorio Github:: https://github.com/onecat-ai/onecat

- Biblioteca de modelos HuggingFace:: https://huggingface.co/onecat-ai/OneCAT-3B

- Documento técnico arXiv:: https://arxiv.org/pdf/2509.03498

A quién va dirigido OneCAT

- Investigadores en inteligencia artificialOneCAT, como novedoso modelo multimodal, ofrece a los investigadores nuevas vías de investigación y plataformas experimentales que pueden utilizarse para explorar tecnologías punteras de comprensión, generación y edición multimodal.

- Científicos e ingenieros de datosOneCAT: En los proyectos que necesitan tratar datos multimodales, OneCAT puede ayudarles a implementar rápidamente funciones como la generación de texto a imagen, la edición de imágenes, etc., y mejorar la eficacia del desarrollo.

- Diseñadores y artistas creativosOneCAT genera imágenes de alta calidad a partir de descripciones textuales, proporcionando inspiración y material para el diseño creativo y la creación artística, ayudándoles a materializar rápidamente ideas creativas.

- educador: En el campo de la educación, OneCAT puede generar imágenes relacionadas con el contenido de la enseñanza, ayudar a los alumnos a comprender y recordar mejor los conocimientos y enriquecer los recursos didácticos.

- Creadores de contenidos y profesionales de los medios de comunicaciónOneCAT : OneCAT puede utilizarse para generar y editar contenidos de imagen que ayuden en la creación de anuncios, vídeos, contenidos para redes sociales y mucho más, mejorando la eficacia y la calidad de la creación de contenidos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...