Ollama+LangGraph Asistente local de generación de informes de investigación académica

Últimos recursos sobre IAActualizado hace 12 meses Círculo de intercambio de inteligencia artificial 51.2K 00

Introducción general

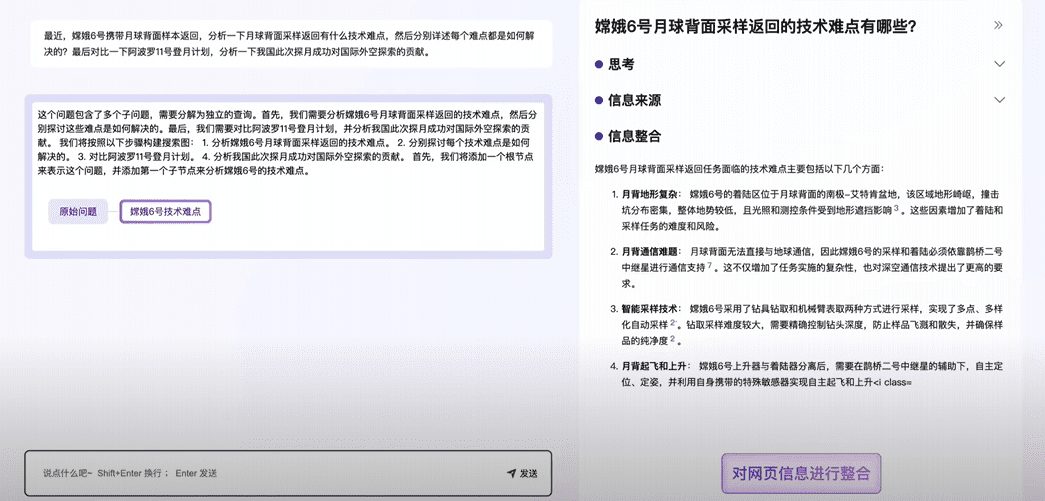

Ollama Deep Researcher es un asistente de investigación web y generación de informes totalmente nativo desarrollado por el equipo de LangChain. Utiliza un Large Language Model (LLM) arbitrario alojado en Ollama para permitir a los usuarios introducir un tema de investigación y, a continuación, generar automáticamente consultas de búsqueda web, recopilar información, resumir el contenido y generar informes Markdown con fuentes. Todo el proceso se realiza sin necesidad de conexión a Internet para llamar a un modelo externo, protegiendo la privacidad y sin coste adicional. Es compatible con DuckDuckGo, Tavily o Perplejidad y otras herramientas de búsqueda , el usuario puede personalizar el número de ciclos de investigación , adecuado para usuarios que necesitan una investigación en profundidad y generar informes estructurados . Fácil de instalar, de código abierto y gratuito.

Lista de funciones

- modelo lingüístico operativo local (LOLM): Utiliza LLM nativo a través de Ollama sin APIs externas.

- Generación automática de consultas de búsqueda: Genera términos de búsqueda web precisos basados en los temas de los usuarios.

- Recopilación de información web: Admite búsquedas en DuckDuckGo (por defecto), Tavily o Perplexity.

- Resumen y optimización de contenidos: Analizar los resultados de la búsqueda, identificar las deficiencias y mejorar el resumen.

- Generar informes MarkdownInforme estructurado con todas las citas de las fuentes.

- Personalizar la profundidad de la investigaciónEl usuario puede establecer el número de ciclos y controlar el nivel de detalle del estudio.

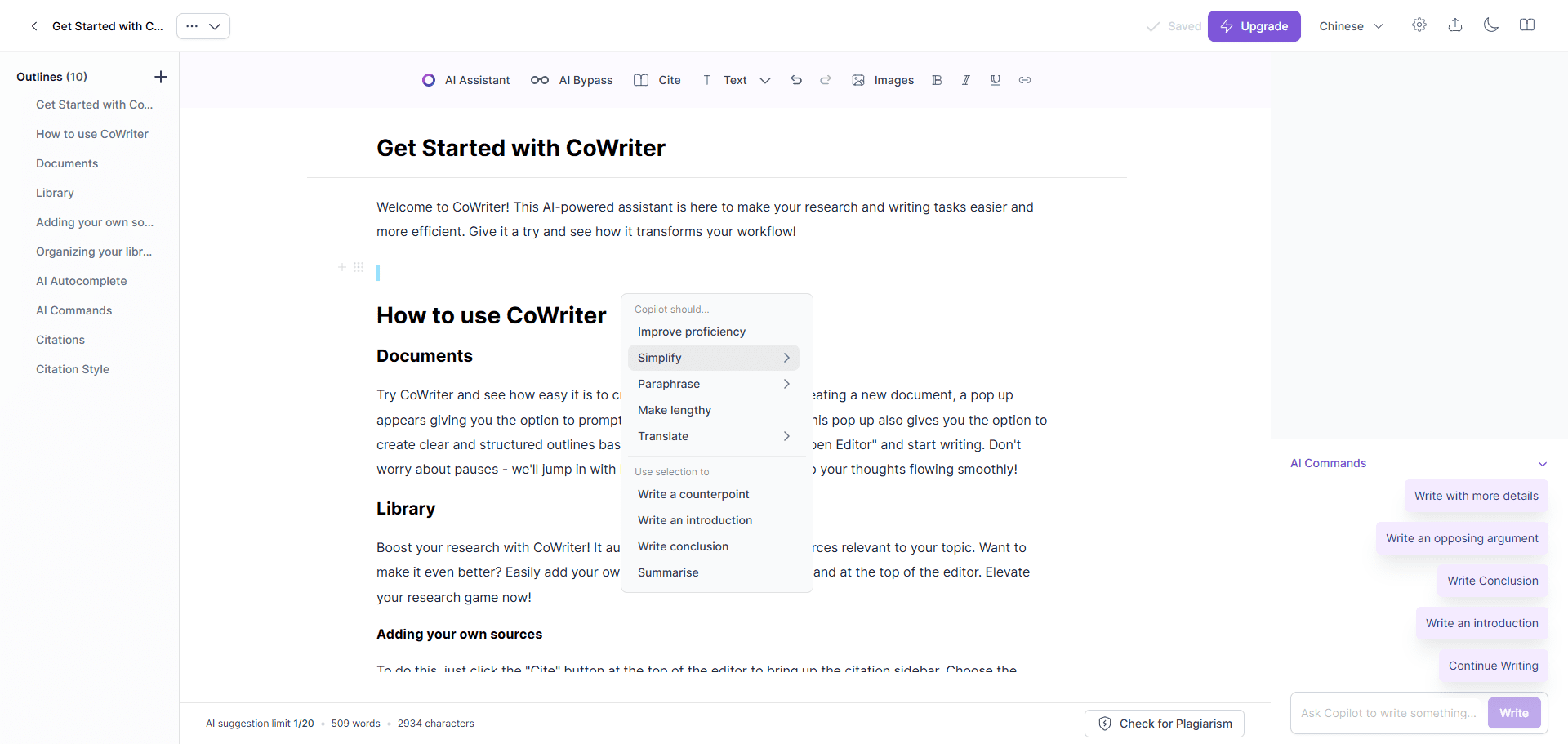

- Visualización de flujos de trabajo: a través de LangGraph Studio Visualiza cada paso de la operación.

- Compatibilidad con varios modelos: Compatible DeepSeek R1, Llama 3.2 y otros modelos.

Utilizar la ayuda

Proceso de instalación

Ollama Deep Researcher requiere soporte de entorno local. A continuación se detallan los pasos para usuarios de Mac y Windows.

Usuarios de Mac

- Instalar Ollama

- Visite el sitio web de Ollama para descargar la versión para Mac del instalador.

- Tras la instalación, ejecute el terminal

ollama --versionComprueba la versión.

- modelo pull

- Introdúcelo en el terminal:

ollama pull deepseek-r1:8bDescargar Modelos recomendados. - También disponible

ollama pull llama3.2.

- Introdúcelo en el terminal:

- proyecto de clonación

- Ejecute el siguiente comando:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- Ejecute el siguiente comando:

- Creación de un entorno virtual (recomendado)

- Asegúrate de que Python 3.9+ está instalado. Ejecútalo:

python -m venv .venv source .venv/bin/activate

- Asegúrate de que Python 3.9+ está instalado. Ejecútalo:

- Instalar dependencias e iniciar

- Entrada:

curl -LsSf https://astral.sh/uv/install.sh | sh uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev - Cuando se inicia, el navegador abre LangGraph Studio (por defecto).

http://127.0.0.1:2024).

- Entrada:

Usuario de Windows

- Instalar Ollama

- Descargue la versión para Windows desde el sitio web de Ollama.

- Tras la instalación, la línea de comandos se ejecuta

ollama --versionValidación.

- modelo pull

- Entrada:

ollama pull deepseek-r1:8b.

- Entrada:

- proyecto de clonación

- Corriendo:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- Corriendo:

- Creación de un entorno virtual

- Instala Python 3.11 (con la opción "Añadir a PATH" marcada) y ejecútalo:

python -m venv .venv .venv\Scripts\Activate.ps1

- Instala Python 3.11 (con la opción "Añadir a PATH" marcada) y ejecútalo:

- Instalar dependencias e iniciar

- Entrada:

pip install -e . pip install -U "langgraph-cli[inmem]" langgraph dev - acceso posterior al lanzamiento

http://127.0.0.1:2024.

- Entrada:

Herramienta de búsqueda de configuraciones (opcional)

- DuckDuckGo se utiliza por defecto y no se requiere clave API.

- si Tavily o Perplejidad:

- haga una copia de

.env.exampledebido a.env. - compilador

.envañade la llave:TAVILY_API_KEY=your_tavily_key PERPLEXITY_API_KEY=your_perplexity_key - Configuración opcional:

OLLAMA_BASE_URL(Por defecto)http://localhost:11434).MAX_WEB_RESEARCH_LOOPS(por defecto 3).

- haga una copia de

Cómo utilizarlo

- Abrir LangGraph Studio

- Después de iniciar el servicio, acceda a

http://127.0.0.1:2024. - La interfaz está dividida en columnas izquierda y derecha: configuración a la izquierda, y entrada y resultados a la derecha.

- Después de iniciar el servicio, acceda a

- Parámetros de configuración

- Herramientas de búsquedaElige entre DuckDuckGo, Tavily o Perplexity.

- modelizaciónIntroduzca el nombre del modelo descargado (p. ej.

deepseek-r1:8b). - Número de ciclos: Establece la profundidad de estudio, por defecto 3 veces.

- Guarda la configuración.

- Introduzca un tema

- Introduzca un tema de investigación, como "El futuro del aprendizaje automático", en el cuadro de entrada de la derecha.

- Haga clic en "Ejecutar" para iniciar el estudio.

- Ver el proceso y los resultados

- Studio muestra cada paso: generación de consultas, búsquedas, resúmenes, etc.

- Una vez terminado, el informe Markdown se guarda en el estado gráfico de la carpeta del proyecto.

Función destacada Operación

- Ajustar la profundidad de la investigación

- Cambio en la configuración

MAX_WEB_RESEARCH_LOOPSSi el número de veces se fija en 5, los resultados serán más completos pero llevarán más tiempo.

- Cambio en la configuración

- Alternar herramienta de búsqueda

- DuckDuckGo Gratuito pero con resultados limitados, Tavily Más detallado (requiere clave). Reinicia el servicio después de cambiar.

- Comprobación de compatibilidad de modelos

- Si se notifica un error (por ejemplo

KeyError: 'query'), lo que indica que el modelo no admite la salida JSON. Cambiar a DeepSeek R1 (8B) o Llama 3.2.

- Si se notifica un error (por ejemplo

advertencia

- requisitos de hardware: se necesitan 8 GB de memoria para el modelo 8B y 16 GB para el 13B.

- Compatibilidad con navegadoresSe recomienda Firefox, Safari puede tener advertencias de seguridad.

- detección de erroresSi te quedas atascado, comprueba los registros del terminal, puede que necesites actualizar dependencias o cambiar modelos.

escenario de aplicación

- investigación académica

- Descripción de la escenaLos estudiantes teclean "métodos de optimización de redes neuronales" y la herramienta busca y genera un informe con citas, lo que ahorra tiempo en la búsqueda de información.

- Análisis del sector

- Descripción de la escenaAI Market Trends to 2025", una herramienta que ofrece un resumen detallado para ayudar en la toma de decisiones.

- Aprendizaje técnico

- Descripción de la escenaLos desarrolladores introducen "Programación asíncrona en Python" y la herramienta genera un informe tutorial para facilitar el autoaprendizaje.

CONTROL DE CALIDAD

- ¿Tengo que trabajar en red?

- El modelo local no requiere conexión a Internet, pero la búsqueda en la web sí. Si no está conectado, solo se pueden utilizar los datos existentes.

- ¿Es compatible con el chino?

- Soporte. Introduzca un tema en chino y la herramienta generará resultados en chino, pero el efecto varía en función de la herramienta de búsqueda.

- ¿Puede modificarse el informe?

- Los archivos Markdown pueden editarse directamente.

- ¿Qué debo hacer si obtengo un error JSON?

- Esto significa que el modelo no soporta salida estructurada. Vuelva a intentarlo con DeepSeek R1 (8B) o Llama 3.2.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...