Explicación de los principales términos técnicos que debe conocer sobre los GAR

Base de conocimientos de IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 44.1K 00

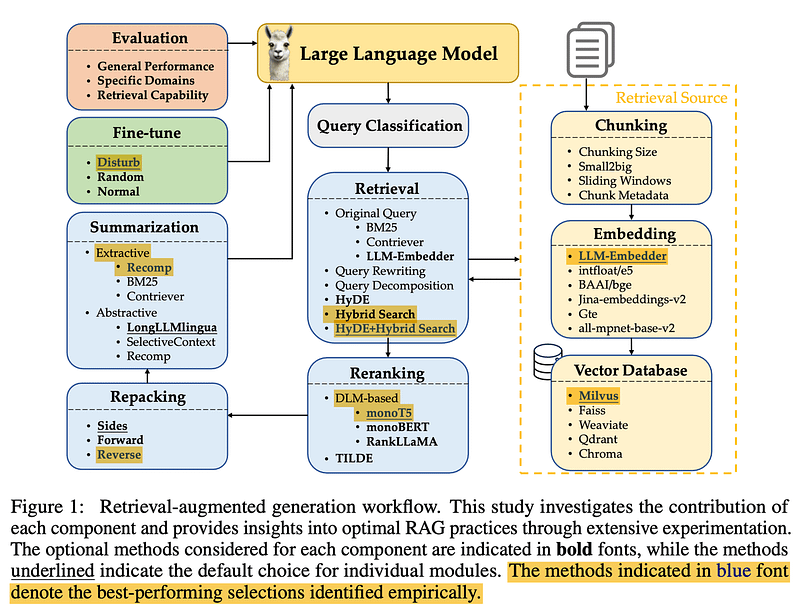

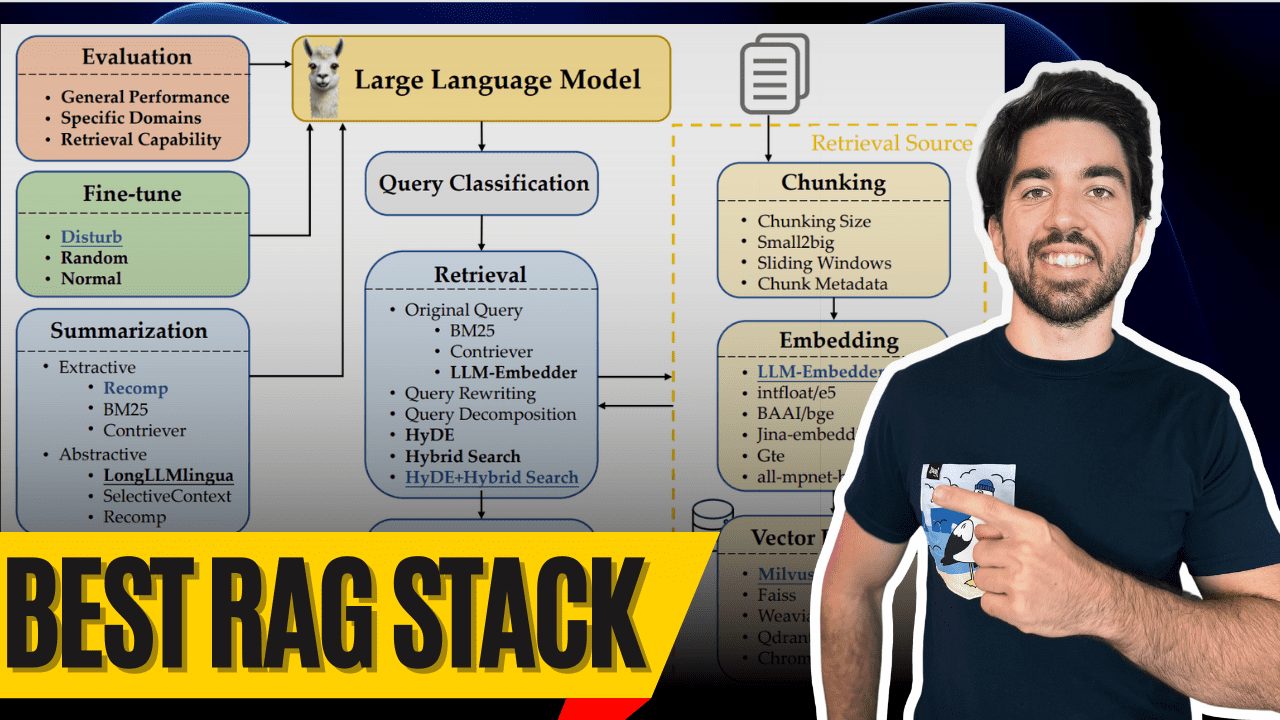

Buenos días a todos. Soy Louis-Francois, cofundador y CTO de Towards AI, y hoy vamos a sumergirnos en la que probablemente sea la mejor pila de Generación de Recuperación-Aumentada (RAG) disponible hoy en día - gracias a la gran investigación de Wang et al. (2024). Esta investigación ofrece una gran oportunidad para construir RAG El sistema proporciona información valiosa, y yo estoy aquí para desvelar los misterios.

Entonces, ¿qué hace que un sistema RAG sea realmente de primera categoría? Sus componentes, por supuesto. Echemos un vistazo a los mejores componentes y a su funcionamiento para que usted también pueda construir un sistema GAR de primera categoría, con un huevo multimodal al final.

Clasificación de las consultas

Clasificación de consultas

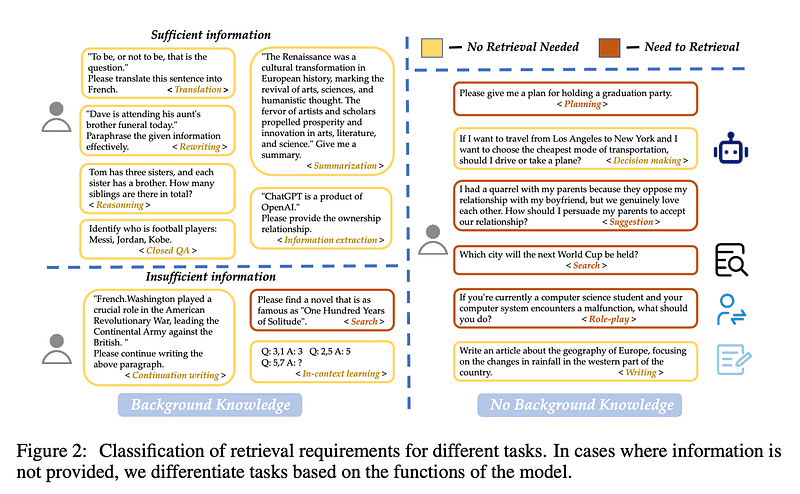

Empecemos por el Clasificación de las consultas Empezar. No es necesario recuperar todas las consultas, porque a veces el gran modelo lingüístico ya conoce la respuesta. Por ejemplo, si preguntas "¿Quién es Lionel Messi?" el gran modelo lingüístico ya será capaz de responderle, ¡sin necesidad de recuperarlo!

Wang et al. crearon 15 categorías de tareas para determinar si una consulta proporciona suficiente información o necesita ser recuperada. Entrenaron a un clasificador binario para diferenciar entre tareas, con tareas etiquetadas como "suficientes" que no necesitan ser recuperadas y tareas etiquetadas como "insuficientes" que necesitan ser recuperadas. En esta imagen, el amarillo significa que no es necesario recuperar ningún documento y el rojo, que es necesario recuperar algunos.

fragmentación

Agrupar

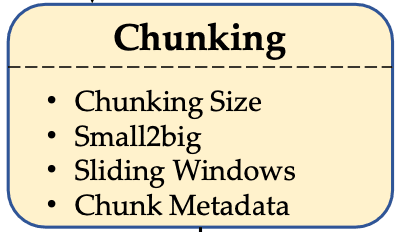

Siguiente. fragmentación. El reto consiste en encontrar el tamaño de trozo óptimo para tus datos. ¿Demasiado largo? Añadirás ruido y costes innecesarios. ¿Demasiado corto? Perderá información contextual.

Wang et al. descubrieron que los tamaños de los trozos de 256 a 512 ficha Entre funciona mejor. Pero recuerda que depende del tipo de datos, ¡así que asegúrate de hacer tu evaluación! CONSEJO PROFESIONAL: Utilice la función small2big(empiece con trozos pequeños al buscar, y luego utilice trozos más grandes al generar), o pruebe la función ventana corredera para solapar fichas entre trozos.

Metadatos y búsqueda híbrida

Metadatos y búsqueda híbrida

¡Utilice sus metadatos! Añade títulos, palabras clave e incluso preguntas hipotéticas. A continuación, trabaje con el Búsqueda híbridaque combina la búsqueda vectorial (para la concordancia semántica) con la clásica BM25 búsqueda de palabras clave, su sistema tendrá un rendimiento brillante.

HyDE (generación de pseudo-documentos para mejorar la búsqueda) es genial y da mejores resultados, pero es extremadamente ineficiente. Quédate por ahora con la búsqueda híbrida: equilibra mejor el rendimiento y es especialmente buena para crear prototipos.

Modelos de incrustación

Modelo de incrustación

Seleccionar el Modelos de incrustación Es como encontrar el par de zapatos adecuado. No te pondrías unas botas de fútbol para jugar al tenis. LLM-Embedder El mejor ajuste en este estudio: un buen equilibrio entre rendimiento y tamaño. Ni demasiado grande ni demasiado pequeño, lo justo.

Tenga en cuenta que sólo probaron el modelo de código abierto, por lo que la Cohere y los modelos de OpenAI no se consideran. De lo contrario, Cohere es probablemente su mejor opción.

base de datos vectorial

Base de datos vectorial

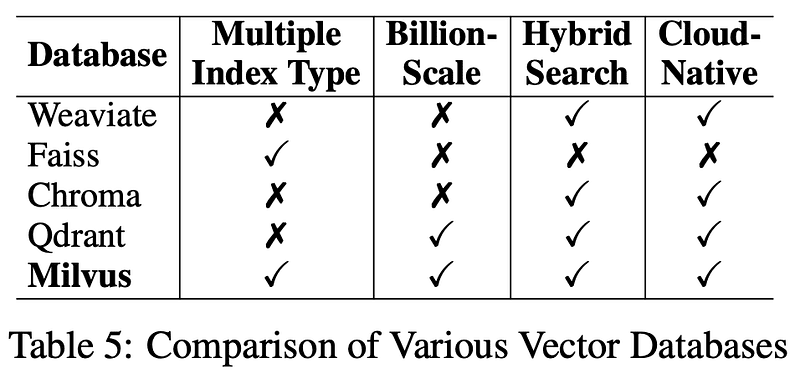

Ahora a la base de datos. Para un uso a largo plazo, laMilvus es su base de datos vectorial preferida. Es de código abierto, fiable y una excelente opción para mantener su sistema de recuperación funcionando sin problemas. También he proporcionado enlaces en la descripción de abajo.

Conversión de consultas

Transformación de consultas

Antes de recuperar, debe conversiones consulta del usuario Ya sea a través del Reescritura de consultas para mejorar la claridad, o Descomposición de consultas Descomponer problemas complejos en otros más pequeños y recuperar cada subproblema, o incluso generar pseudodocumentos (p. ej. HyDE realizadas) y utilizarlas en el proceso de recuperación - este paso es fundamental para mejorar la precisión. Ten en cuenta que un mayor número de conversiones aumentará la latencia, especialmente con HyDE.

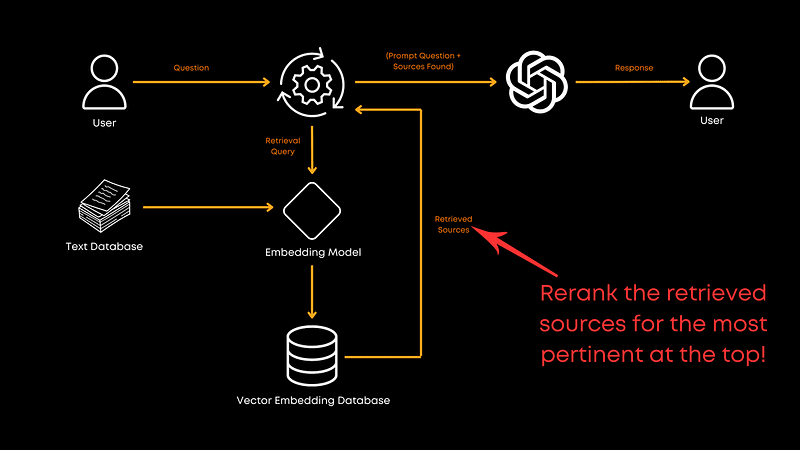

reordenación

Nueva clasificación

Ahora hablemos. reordenación. Una vez recuperados los documentos, hay que asegurarse de que los más relevantes están arriba, y ahí es donde entra en juego la reordenación.

En este estudio.monoT5 es la mejor opción entre rendimiento y eficiencia. Afina el modelo T5, reordenando los documentos en función de su relevancia para la consulta, garantizando que las mejores coincidencias aparezcan en primer lugar.RankLLaMA Mejor rendimiento general, pero TILDEv2 La velocidad más rápida. Si te interesa, el periódico tiene más información al respecto.

Reempaquetado de documentos

Reempaquetado de documentos

Después de reordenar, necesita hacer algunas Reempaquetado de documentos Wang et al. recomiendan utilizar el método "inverso", es decir, ordenar los documentos en orden ascendente de relevancia. Liu et al. (2024) Este enfoque de colocar la información relevante al principio o al final mejoró el rendimiento. El reempaquetado optimiza la forma en que se presenta la información al modelo de lenguaje amplio tras el proceso de reordenación para ayudar al modelo a comprender mejor el orden en que se proporciona la información, en lugar de basarse únicamente en un orden teórico de relevancia.

resúmenes

Resumen

A continuación, antes de llamar al modelo de lenguaje grande, es necesario pasar el archivo resúmenes para eliminar la información redundante. Los mensajes largos enviados a grandes modelos lingüísticos son costosos y a menudo innecesarios. Resumir puede ayudar a eliminar información redundante o innecesaria y, por tanto, a reducir costes.

Puede utilizar algo como Recomp Herramientas como ésta realizan compresión extractiva para seleccionar frases útiles, o compresión generativa para consolidar información de múltiples documentos. Sin embargo, si su prioridad es la velocidad, puede considerar saltarse este paso.

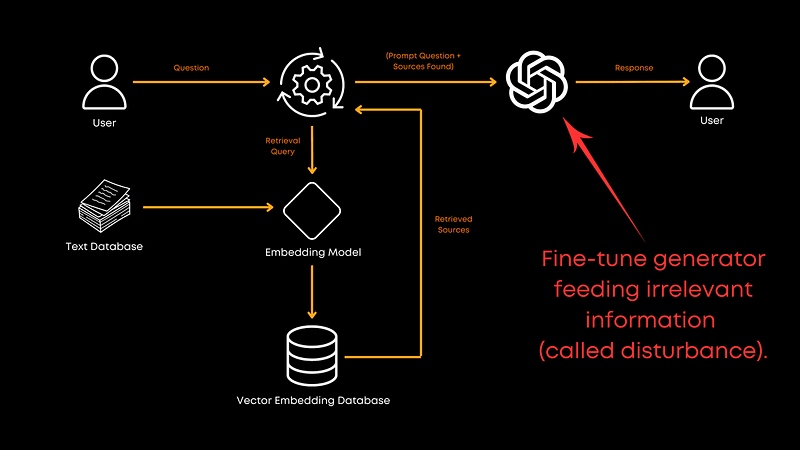

Generador de ajuste

Puesta a punto del generador

Por último, ¿es conveniente facilitar una lista de los nombres que utiliza para la generando ¿Preparar el modelo Big Language? Por supuesto que sí. El ajuste fino con una mezcla de datos de documentos correlacionados y aleatorios mejora la capacidad del generador para manejar información irrelevante. Esto hace que el modelo sea más robusto y ayuda a proporcionar mejores respuestas globales. Aunque en el artículo no se indica la proporción exacta, los resultados son bastante claros: ¡el ajuste fino merece la pena! Por supuesto, también depende del ámbito específico.

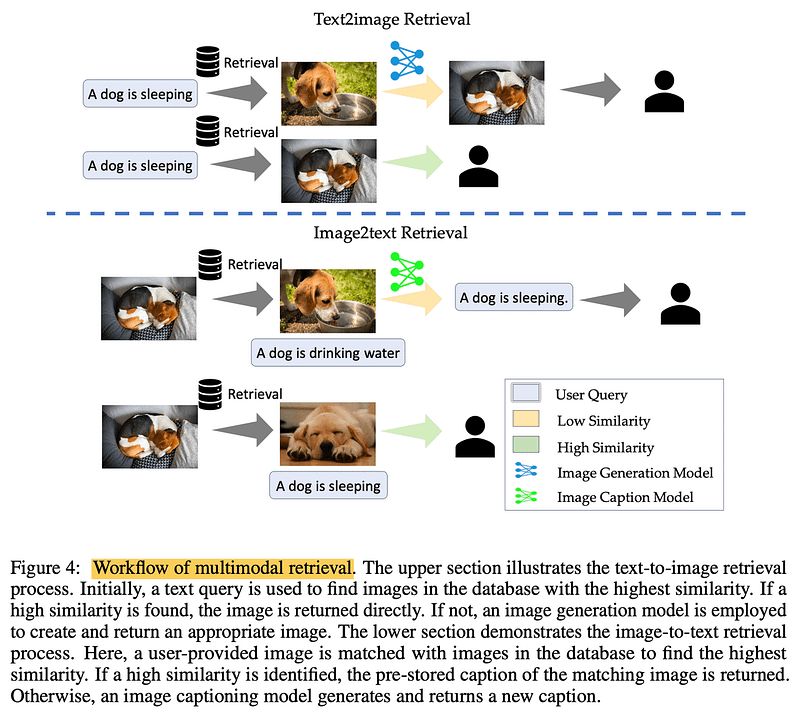

multimodal

Multimodalidades

¿Al procesar imágenes? Realización multimodal Recuperación. En las tareas de conversión de texto en imagen, la consulta de la base de datos en busca de imágenes similares puede acelerar el proceso. En las tareas de imagen a texto, el cotejo de imágenes similares puede recuperar descripciones precisas y preexistentes. La clave está en la información real y verificada.

llegar a un veredicto

En resumen, este artículo de Wang et al. nos proporciona un sólido modelo para construir sistemas GAR eficientes. Hay que tener en cuenta, sin embargo, que se trata de un solo artículo y que no cubre todos los aspectos del proceso GAR. Por ejemplo, el artículo no explora el entrenamiento conjunto de recuperadores y generadores, lo que podría abrir más posibilidades. Tampoco profundiza en las técnicas de fragmentación (chunking), que no se han investigado por cuestiones de coste, pero que merece la pena explorar.

Recomiendo encarecidamente consultar el artículo completo para obtener más información.

Como siempre, gracias por leernos. Si te ha resultado útil este desglose o tienes algún comentario, házmelo saber en la sección de comentarios y ¡hasta la próxima!

bibliografía

Construir LLM para la producción. https://amzn.to/4bqYU9b

Wang y otros, 2024 (Referencia de la tesis). https://arxiv.org/abs/2407.01219

LLM-Embedder (Modelos de incrustación). https://github.com/FlagOpen/FlagEmbedding/tree/master/FlagEmbedding/llm_embedder

Milvus (base de datos vectorial): https://milvus.io/

Liu y otros, 2024 (reempaquetado de documentos). https://arxiv.org/abs/2307.03172

Recomp (herramienta de síntesis). https://github.com/carriex/recomp

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...