MoshiVis: un modelo de código abierto para el diálogo oral y la comprensión de imágenes en tiempo real

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 48.6K 00

Introducción general

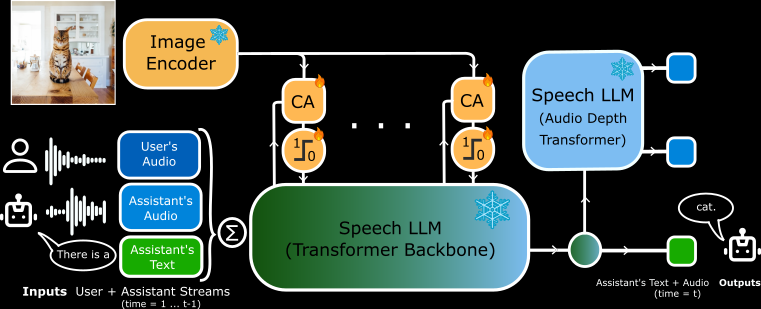

MoshiVis es un proyecto de código abierto desarrollado por Kyutai Labs y alojado en GitHub. Se basa en el modelo de voz a texto Moshi (7B parámetros), con cerca de 206 millones de nuevos parámetros de adaptación y un codificador visual PaliGemma2 congelado (400M parámetros), que permite al modelo discutir el contenido de la imagen con el usuario en tiempo real utilizando el habla.Las características principales de MoshiVis son baja latencia, diálogos naturales y capacidades de comprensión de imágenes. Es compatible con los backends PyTorch, Rust y MLX, y los usuarios pueden descargar gratuitamente el código y los pesos del modelo para ejecutarlos en sus dispositivos locales. El proyecto está dirigido a desarrolladores e investigadores, y es adecuado para explorar las interacciones de la IA o desarrollar nuevas aplicaciones.

Lista de funciones

- Soporta entrada y salida de voz en tiempo real, el modelo responde rápidamente después de que el usuario hable.

- Capacidad para analizar el contenido de una imagen y describir los detalles de la misma mediante el habla o el texto.

- Los backends PyTorch, Rust y MLX están disponibles para diferentes hardware.

- Código y pesos de los modelos abiertos, lo que permite a los usuarios modificarlos libremente.

- Diseño de baja latencia para escenarios de diálogo en tiempo real.

- Admite formatos de cuantificación (por ejemplo, 4 bits, 8 bits) para optimizar la memoria y el rendimiento.

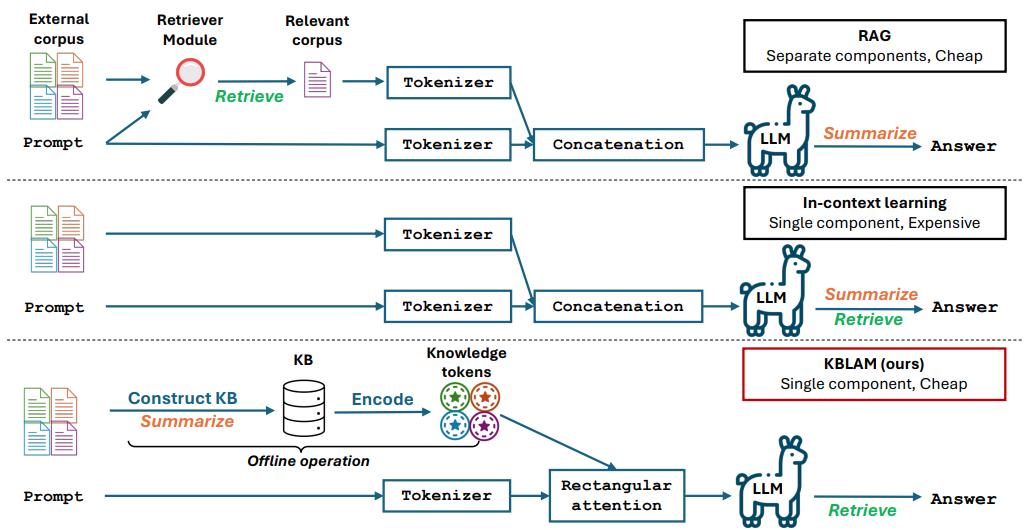

- Mecanismo trans-atento integrado que fusiona la información visual y verbal.

Utilizar la ayuda

MoshiVis requiere algunos conocimientos técnicos para su instalación y uso. Se facilitan instrucciones oficiales detalladas, y a continuación se ofrece una guía completa de instalación y funcionamiento.

Proceso de instalación

MoshiVis admite tres ejecuciones de backend, lo que permite a los usuarios elegir la versión adecuada para su dispositivo. Los requisitos mínimos son Python 3.10+ y suficiente RAM (se recomienda una GPU de 24 GB para la versión PyTorch, y la versión MLX es apta para Mac).

Instalación de PyTorch Backend

- Instale la dependencia:

pip install -U moshi

- Descargue los pesos del modelo e inicie el servicio:

cd kyuteye_pt

python -m moshi.server --hf-repo kyutai/moshika-vis-pytorch-bf16 --port 8088

- entrevistas

https://localhost:8088Accede a la interfaz web. - Si se ejecuta de forma remota, es necesario reenviar el puerto mediante SSH:

ssh -L 8088:localhost:8088 user@remote

Instalación de Rust Backend

- Instale la cadena de herramientas Rust (mediante

rustup(Acceso). - Configure la compatibilidad con la GPU (Metal para Mac, CUDA para NVIDIA).

- Ejecuta el servicio:

cd kyuteye_rs

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis.json standalone --vis

- Una vez que vea "standalone worker listening", visite la página

https://localhost:8088. - Versión cuantificada opcional:

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis-q8.json standalone --vis

Instalación de MLX Backend (recomendado para Mac)

- Instale la dependencia MLX:

pip install -U moshi_mlx

- Servicio de puesta en marcha (admite varios formatos de cuantificación)

cd kyuteye_mlx

python -m moshi_mlx.server # 默认 BF16

python -m moshi_mlx.server -q 4 # 4 位量化

python -m moshi_mlx.server -q 8 # 8 位量化

- entrevistas

http://localhost:8008Utiliza la interfaz web.

Instalación del front-end

- Descargue el cliente preconstruido:

pip install fire rich huggingface_hub

python scripts/get_static_client.py

- Generar un certificado SSL (para HTTPS):

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout key.pem -out cert.pem

- El back-end proporciona una interfaz web por defecto, sin necesidad de operaciones adicionales.

Funciones principales

diálogo de voz en tiempo real (RTV)

- moverDespués de iniciar el servicio, abra la interfaz web (

https://localhost:8088tal vezhttp://localhost:8008). Haz clic en el icono del micrófono para empezar a hablar. - ejemplo típico: Di "Hola" y la modelo responderá con una voz femenina (Moshika) "Hola, ¿en qué puedo ayudarle?". .

- punto: Latencia tan baja como milisegundos para garantizar los privilegios del micrófono.

- adaptarLa versión Rust soporta una interfaz de línea de comandos:

cd kyuteye_rs

cargo run --bin moshi-cli -r -- tui --host localhost

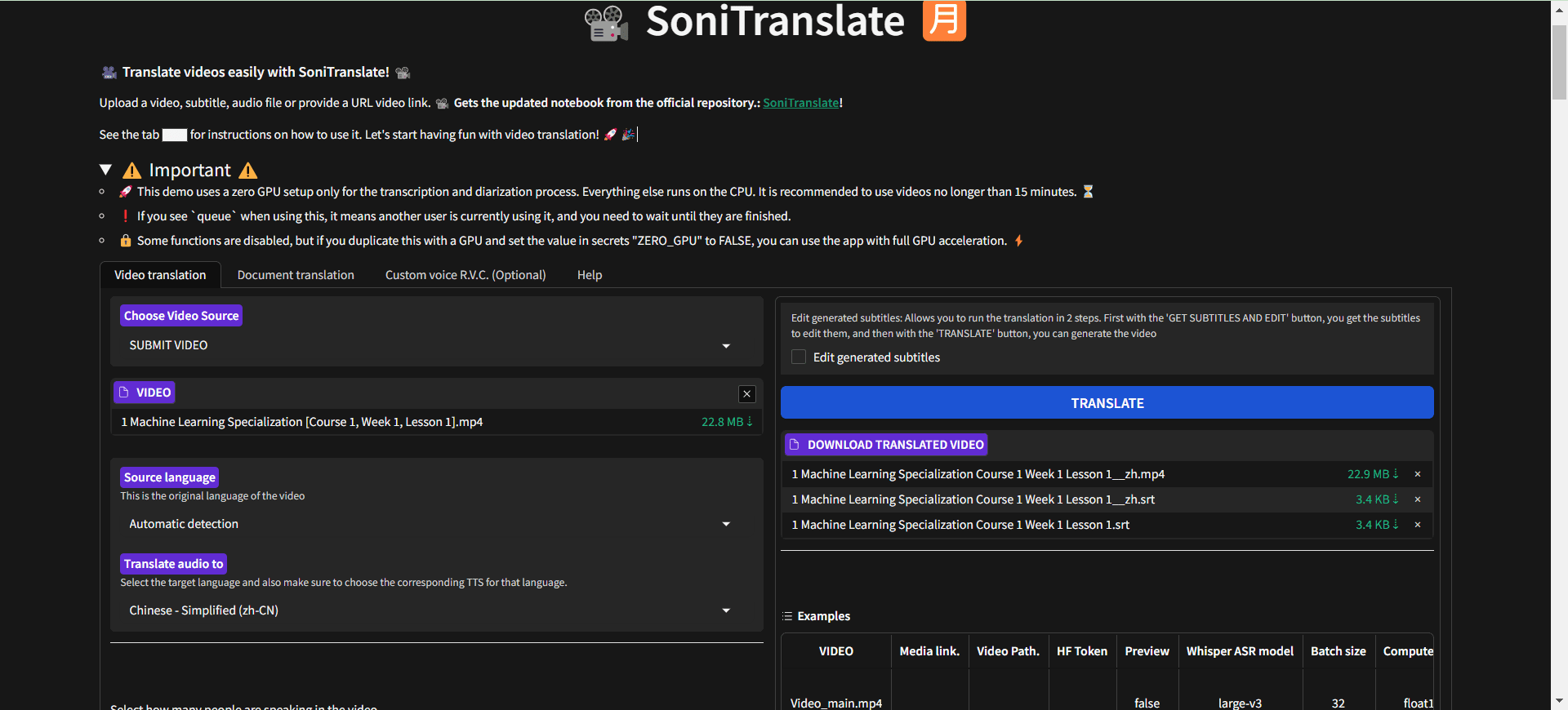

comprensión gráfica

- moverCarga una imagen en la interfaz web o especifica una ruta con una línea de comandos:

python -m moshi_mlx.server -q 8 --image path/to/image.jpg

- plataformaSúbelo y di: "¿Qué es esto?". El modelo lo describirá fonéticamente, por ejemplo: "Es una foto de un cielo azul con nubes blancas".

- caracterización: Basado en el codificador PaliGemma2, reconoce objetos, colores y escenas.

Personalización de modelos

- moverDescarga otros pesos de Hugging Face (p. ej.

kyutai/moshika-vis-mlx-bf16), sustituya la ruta en el archivo de configuración. - plataformaModificación

configs/moshika-vis.yamltal vezconfig-moshika-vis.jsonreinicie el servicio. - utilice: Ajusta el estilo de voz u optimiza el rendimiento.

Procedimiento operativo completo

- Seleccione Backend: Elige PyTorch (GPU), Rust (multiplataforma) o MLX (Mac) en función de tu dispositivo.

- entorno de instalaciónInstale las dependencias y modelos según el comando anterior.

- Inicio de los serviciosEjecuta el backend y espera a que el servicio esté listo.

- Interfaz de conexión: Acceda al puerto especificado con su navegador.

- Voz de pruebaDiga frases sencillas y compruebe las respuestas.

- Imágenes de prueba: Sube fotos y haz preguntas por voz.

- Ajustes de optimizaciónAjuste de los parámetros de cuantificación (

-q 4tal vez-q 8) o el número de puerto.

advertencia

- HTTPS requiere un certificado SSL, de lo contrario los navegadores pueden restringir el acceso a los micrófonos.

- La cuantificación no es compatible con PyTorch y requiere una GPU de alto rendimiento.

- La versión Rust tarda en compilarse, así que ten paciencia cuando la ejecutes por primera vez.

- Versión MLX probada estable en M3 MacBook Pro, recomendada para usuarios de Mac.

escenario de aplicación

- Apoyo educativo

Los estudiantes suben imágenes de libros de texto y MoshiVis explica el contenido mediante audio, por ejemplo: "Este es un diagrama de una estructura celular, que muestra el núcleo y las mitocondrias". - Ayuda a la accesibilidad

Los usuarios con discapacidad visual subían a diario fotos de modelos que describían "esto es una estantería de supermercado llena de leche y pan". - experimento de desarrollo

Los desarrolladores lo utilizan para crear asistentes de voz que se integran en dispositivos inteligentes para interactuar con la imagen.

CONTROL DE CALIDAD

- ¿MoshiVis puede utilizarse sin conexión?

Sí. Una vez instaladas, todas las funciones se ejecutan localmente sin necesidad de conexión a Internet. - ¿Admite Voice varios idiomas?

Actualmente admite principalmente diálogos y descripciones en inglés, con funciones limitadas en otros idiomas. - ¿Funcionará un ordenador de perfil bajo?

La versión MLX se ejecuta en un Mac normal, y la versión PyTorch requiere 24 GB de memoria en la GPU.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...