Evaluación del uso de modelos de inferencia en los sistemas modulares GAR

Base de conocimientos de IAActualizado hace 8 meses Círculo de intercambio de inteligencia artificial 40.7K 00

En este artículo, presentamos el trabajo reciente de Kapa.ai sobre el sistema de Generación de Recuperación-Aumentada (RAG) de OpenAI en el contexto de la o3-mini Informe resumido de la exploración del modelo etimológico de razonamiento.

Kapa.ai es un asistente de IA basado en un modelo lingüístico a gran escala (LLM) que RAG El proceso se integra con la base de conocimientos para poder responder a las preguntas técnicas de los usuarios y procesar las órdenes de trabajo de asistencia técnica.

Construir y mantener un sistema GAR estable y versátil no es tarea fácil. Son muchos los parámetros y ajustes que afectan a la calidad del resultado final, y existen complejas interacciones entre estos factores:

- Plantillas de palabras clave

- Tamaño del contexto

- Extensión de la consulta

- trozo

- reorder

- ¡Un momento!

Cuando se realizan ajustes en un sistema GAR, especialmente al integrar nuevos modelos, es esencial revisar y optimizar estos parámetros para mantener un buen rendimiento. Sin embargo, esta tarea no sólo requiere mucho tiempo, sino también una gran experiencia para hacerla bien.

se parecen a DeepSeek-R1 Los nuevos modelos de razonamiento, como el o3-mini de OpenAI, han logrado resultados impresionantes gracias a las instrucciones integradas de cadena de pensamiento (CoT) para "pensar" en un problema, razonar paso a paso e incluso autocorregirse cuando es necesario. Al parecer, estos modelos obtienen mejores resultados en tareas complejas que requieren un razonamiento lógico y respuestas verificables. Lectura relacionada:DeepSeek R1 en RAG: Resumen de la experiencia práctica yYa están aquí los resultados de la generación de código a nivel de proyecto! o3/Claude 3.7 lidera la clasificación, R1 está en el nivel superior!

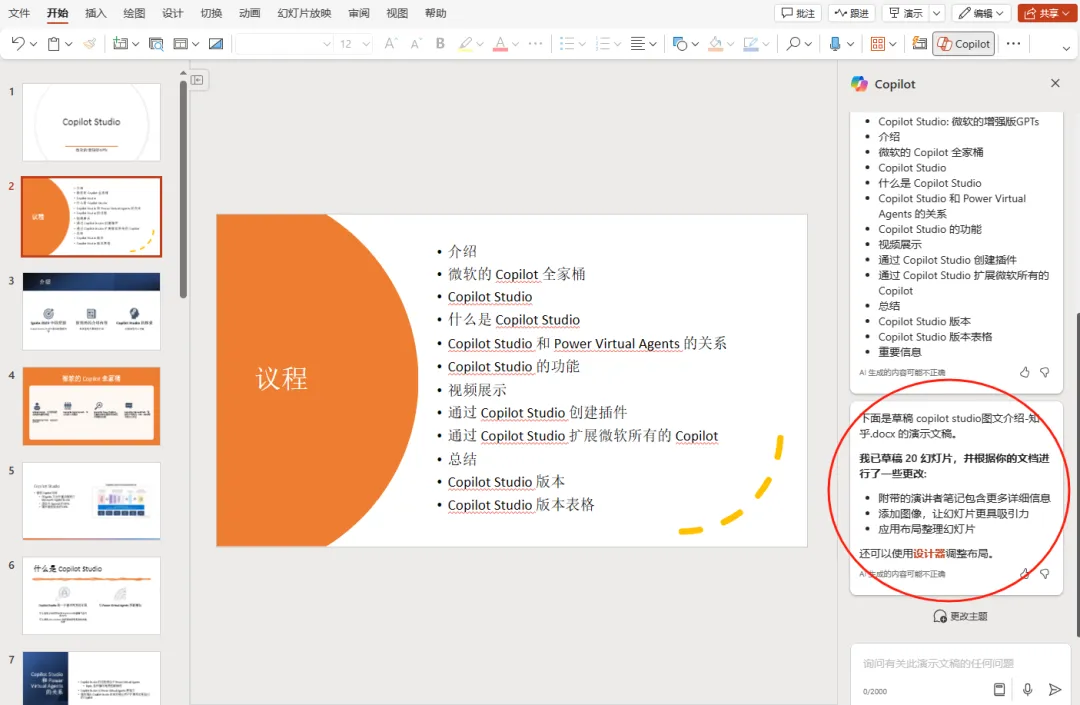

Por ello, Kapa.ai propone una idea: si los modelos de inferencia pueden descomponer problemas complejos y autocorregirse, ¿podrían aplicarse a los procesos GAR para gestionar tareas como la ampliación de consultas, la recuperación de documentos y la reordenación? Construyendo un conjunto de herramientas de recuperación de información y entregándoselo al modelo de inferencia, quizá sea posible construir un sistema más adaptable que reduzca la necesidad de ajustar manualmente los parámetros.

Este paradigma se denomina a veces Generación Modular de Recuperación-Aumentada (Modular RAG). En este artículo, compartimos los recientes resultados de la investigación de Kapa.ai en la refactorización del proceso RAG estándar en un proceso basado en un modelo de inferencia.

supongamos que...

El principal objetivo de Kapa.ai al explorar esta idea es simplificar el proceso RAG y reducir la dependencia del ajuste manual de los parámetros. Los componentes centrales del proceso RAG son la incrustación densa y la recuperación de documentos. Un proceso RAG típico de alto nivel es el siguiente:

- Recibir avisos de los usuarios.

- Preprocesamiento de consultas para mejorar la recuperación de información.

- Los documentos pertinentes se encuentran mediante búsquedas de similitudes en bases de datos vectoriales.

- Reordene los resultados y utilice los documentos más relevantes.

- Generar una respuesta.

Cada paso del proceso se optimiza mediante heurísticas como reglas de filtrado y ajustes de clasificación para priorizar los datos pertinentes. Estas optimizaciones definen el comportamiento del proceso, pero también limitan su adaptabilidad.

Para que el modelo de inferencia pueda utilizar los distintos componentes del proceso GAR, Kapa.ai tuvo que configurar el sistema de forma diferente. En lugar de definir una secuencia lineal de pasos, cada componente se trata como un módulo independiente al que el modelo puede llamar.

En esta arquitectura, en lugar de seguir un proceso fijo, los modelos con capacidad de razonamiento pueden controlar su propio flujo de trabajo con un mayor grado de dinamismo. Utilizando herramientas, los modelos pueden decidir cuándo y con qué frecuencia ejecutar búsquedas completas o simplificadas, y qué parámetros de búsqueda utilizar. Si tiene éxito, este enfoque tiene el potencial de sustituir a los marcos tradicionales de orquestación de GAR, como LangGraph.

Además, un sistema más modular ofrece algunas ventajas adicionales:

- Los módulos individuales pueden sustituirse o actualizarse sin necesidad de renovar por completo todo el proceso.

- Una separación de funciones más clara facilita la depuración y las pruebas.

- Se pueden probar y sustituir diferentes módulos (por ejemplo, recuperadores con diferentes incrustaciones) para comparar el rendimiento.

- Los módulos pueden ampliarse independientemente para distintas fuentes de datos.

- Podría permitir a Kapa.ai construir diferentes módulos personalizados para tareas o dominios específicos.

Por último, Kapa.ai también quiere explorar si este enfoque puede ayudar a "atajar" las consultas abusivas o fuera de tema de forma más eficaz. Los casos más difíciles suelen implicar ambigüedad, es decir, no está claro si la consulta es relevante para el producto. Las consultas abusivas suelen estar deliberadamente diseñadas para eludir la detección. Aunque los casos más sencillos ya pueden tratarse con eficacia, Kapa.ai espera que el modelo de inferencia ayude a identificar y salir antes de los problemas más complejos.

configuración de prueba

Para experimentar con este flujo de trabajo, Kapa.ai construyó un sistema RAG aislado que contenía los componentes necesarios, datos estáticos y una suite de evaluación con LLM como árbitro. En una configuración, Kapa.ai utilizó un proceso lineal fijo típico con optimizaciones codificadas incorporadas.

Para el proceso modular RAG, Kapa.ai utilizó el modelo o3-mini como modelo de inferencia y ejecutó varias configuraciones del proceso bajo diferentes políticas para evaluar qué enfoques funcionaban y cuáles no:

- Uso de herramientas: Kapa.ai intenta dar al modelo acceso completo a todas las herramientas y a todo el proceso, y también intenta limitar el uso de herramientas a una combinación de una sola herramienta con un proceso lineal fijo.

- Sugerencias y parametrización: Kapa.ai también experimentó con varios grados de preparametrización de las llamadas a las herramientas, en lugar de dejar que el modelo determinara sus propios parámetros.

En todas las pruebas realizadas por Kapa.ai, el número de llamadas a las herramientas se limitó a un máximo de 20: para cualquier consulta, el modelo sólo permite utilizar un máximo de 20 llamadas a las herramientas:

- Medio: Pasos más cortos de la CoT (Cadena de Pensamiento)

- Más alto: Pasos más largos del CdT con un razonamiento más detallado

En total, Kapa.ai realizó 58 evaluaciones de diferentes configuraciones modulares de GAR.

al final

Los resultados de los experimentos fueron desiguales. En algunas configuraciones, Kapa.ai observó algunas mejoras modestas, sobre todo en la generación de código y, hasta cierto punto, en la factorización. Sin embargo, métricas clave como la calidad de la recuperación de información y la extracción de conocimiento se mantuvieron prácticamente sin cambios en comparación con el flujo de trabajo tradicional de Kapa.ai ajustado manualmente.

Un problema recurrente a lo largo del proceso de pruebas es que el razonamiento de la cadena de pensamiento (CoT) añade latencia. Aunque un razonamiento más profundo permite al modelo descomponer consultas complejas y autocorregirse, esto se produce a costa del tiempo adicional que requieren las llamadas iterativas a las herramientas.

El mayor reto identificado por Kapa.ai es la "falacia de inferencia ≠ experiencia": el modelo de inferencia, a pesar de ser capaz de pensar paso a paso, carece de la experiencia a priori de utilizar una herramienta de recuperación. Incluso con pistas rigurosas, le costaba recuperar resultados de alta calidad y distinguir entre resultados buenos y malos. El modelo se mostraba a menudo indeciso a la hora de utilizar las herramientas proporcionadas por Kapa.ai, de forma similar a los experimentos que Kapa.ai llevó a cabo el año pasado con el modelo o1. Esto pone de manifiesto un problema más amplio: los modelos de inferencia son buenos en la resolución de problemas abstractos, pero optimizar el uso de herramientas sin formación previa sigue siendo un reto pendiente.

Principales resultados

- El experimento reveló una evidente "falacia de razonamiento ≠ experiencia": el modelo de razonamiento en sí no "entiende" la herramienta de recuperación. Entiende la función y el propósito de la herramienta, pero no sabe cómo utilizarla, mientras que los humanos poseen este conocimiento tácito después de utilizar la herramienta. A diferencia de los procesos tradicionales, en los que la experiencia se codifica en la heurística y la optimización, al modelo de razonamiento hay que enseñarle explícitamente a utilizar la herramienta con eficacia.

- Aunque el modelo o3-mini es capaz de manejar contextos más grandes, Kapa.ai observa que no proporciona una mejora significativa sobre modelos como 4o o Sonnet en términos de extracción de conocimiento. El simple aumento del tamaño del contexto no es la panacea para mejorar el rendimiento de la recuperación.

- El conjunto de datos de kapa.ai se centra en contenido técnico relevante para casos de uso del mundo real, más que en problemas de competición matemática o retos de codificación avanzados. El impacto de la fuerza de inferencia puede variar según el dominio y puede producir resultados diferentes para conjuntos de datos que contengan consultas más estructuradas o complejas desde el punto de vista computacional.

- Un área en la que el modelo destaca es en la generación de código, lo que sugiere que los modelos de inferencia pueden ser especialmente adecuados para dominios que requieren una salida estructurada y lógica en lugar de una mera recuperación.

- Los modelos de razonamiento no tienen conocimientos relacionados con las herramientas.

Razonamiento ≠ Falacia empírica

La conclusión clave de los experimentos es que el modelo de inferencia no posee de forma natural conocimientos específicos de la herramienta. A diferencia de los procesos RAG, que codifican la lógica de recuperación en pasos predefinidos, los modelos de inferencia procesan cada llamada de recuperación desde cero. Esto conduce a la ineficacia, la indecisión y el uso subóptimo de la herramienta.

Para mitigarlo, se pueden considerar varias estrategias posibles. Puede ser útil perfeccionar la estrategia de orientación, es decir, elaborar instrucciones específicas para cada herramienta de modo que el modelo reciba una orientación más explícita. El preentrenamiento o la puesta a punto de los modelos para el uso de herramientas también podría familiarizarlos con mecanismos de recuperación específicos.

Además, puede considerarse un enfoque híbrido, en el que la heurística predefinida se ocupa de determinadas tareas y los modelos de inferencia intervienen selectivamente cuando es necesario.

Estas ideas están aún en fase especulativa, pero apuntan maneras de salvar la distancia entre la capacidad de razonamiento y la aplicación real de las herramientas.

resúmenes

Aunque el GAR modular basado en la inferencia no mostró ventajas significativas sobre los procesos tradicionales en el contexto de los casos de uso de Kapa.ai, el experimento proporcionó valiosas ideas sobre su potencial y sus limitaciones. La flexibilidad de un enfoque modular sigue siendo atractiva. Puede mejorar la adaptabilidad, simplificar las actualizaciones y ajustarse dinámicamente a nuevos modelos o fuentes de datos.

De cara al futuro, hay una serie de tecnologías prometedoras que merecen seguir explorándose:

- Utilizar diferentes estrategias de señalización y preentrenamiento/ajuste para mejorar el modo en que el modelo comprende la herramienta de recuperación e interactúa con ella.

- Utilizar modelos de razonamiento estratégicamente en determinadas partes del proceso, por ejemplo, para casos de uso específicos o tareas como la respuesta a preguntas complejas o la generación de código, en lugar de orquestar todo el flujo de trabajo.

Por el momento, los modelos de razonamiento como o3-mini no han superado a los procesos tradicionales de GAR en tareas básicas de recuperación dentro de límites de tiempo razonables. A medida que avanzan los modelos y evolucionan las estrategias de uso de las herramientas, los sistemas modulares de GAR basados en el razonamiento pueden convertirse en una alternativa viable, sobre todo para dominios que requieren flujos de trabajo dinámicos y de lógica intensiva.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...