MiniMax-M1 - Modelo de inferencia de código abierto de MiniMax

Últimos recursos sobre IAPublicado hace 8 meses Círculo de intercambio de inteligencia artificial 39.4K 00

Qué es MiniMax-M1

MiniMax-M1 es un modelo de inferencia de código abierto del equipo MiniMax, basado en una combinación de la Arquitectura Experta Mixta (MoE) y el mecanismo Lightning Attention, con 456.000 millones de parámetros totales. El modelo admite 1 millón de ficha miniMax-M1 tiene una entrada de contexto largo y una salida de 80.000 tokens, lo que lo hace adecuado para documentos largos y tareas de razonamiento complejas. El modelo está disponible en versiones de presupuesto de razonamiento de 40.000 y 80.000 para optimizar los recursos computacionales y reducir los costes de razonamiento. miniMax-M1 supera a varios modelos de código abierto en tareas como la ingeniería de software, la comprensión de contextos largos y el uso de herramientas. La eficiente potencia computacional del modelo y sus sólidas capacidades de razonamiento lo convierten en una poderosa base para la próxima generación de agentes de modelado lingüístico.

Características principales de MiniMax-M1

- procesamiento de contexto largoPermite entradas de hasta 1 millón de tokens y salidas de 80.000 tokens, y puede procesar eficazmente documentos largos, informes extensos, trabajos académicos y otros contenidos textuales extensos, lo que resulta idóneo para tareas de razonamiento complejas.

- Razonamiento eficienteEl software de inferencia de la Comisión Europea: ofrece dos versiones de presupuesto de inferencia, 40K y 80K, para optimizar la asignación de recursos informáticos, reducir los costes de inferencia y mantener un alto rendimiento.

- Optimización de tareas multidisciplinares: destacan en tareas como el razonamiento matemático, la ingeniería de software, la comprensión contextual prolongada y el uso de herramientas.

- llamada de función: Soporta llamadas a funciones estructuradas, puede identificar y emitir parámetros de llamadas a funciones externas, fácil de interactuar con herramientas externas para mejorar la automatización y la eficiencia del trabajo.

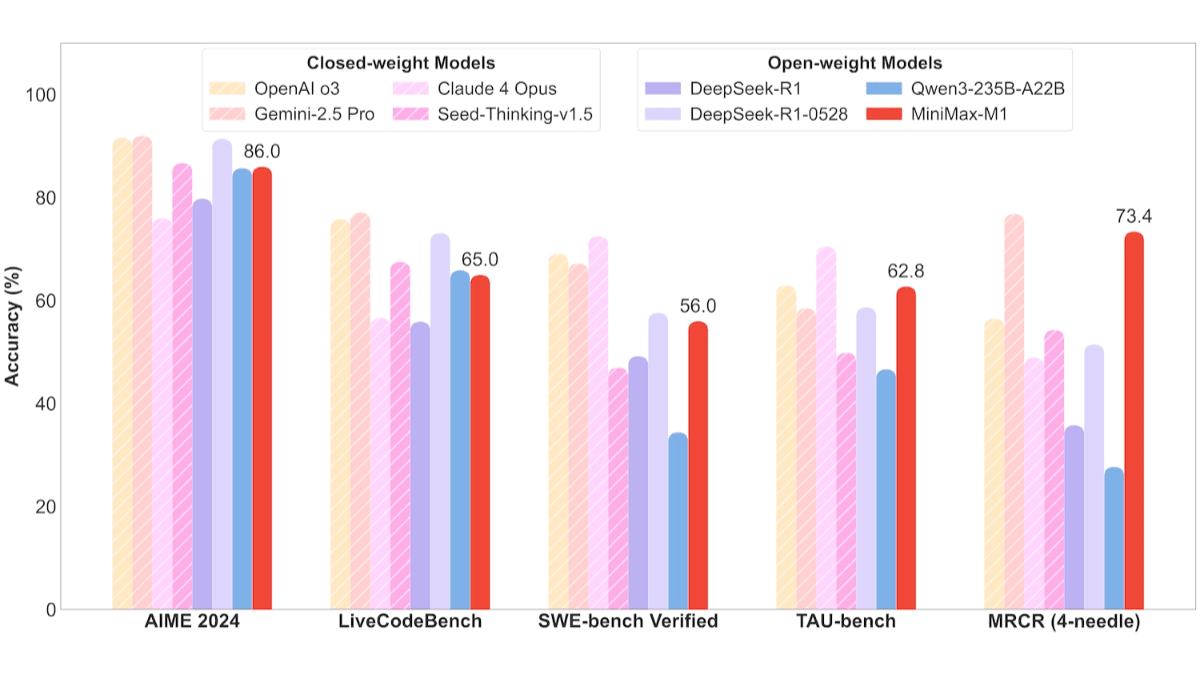

Rendimiento del MiniMax-M1

- Tareas de ingeniería de softwareEn la prueba SWE-bench, MiniMax-M1-40k y MiniMax-M1-80k alcanzaron 55,61 TP3T y 56,01 TP3T, respectivamente, lo que es ligeramente inferior a los 57,61 TP3T de DeepSeek-R1-0528 y supera con creces a otros modelos de código abierto.

- Tareas largas de comprensión contextualizadaMiniMax-M1, que se basa en millones de ventanas de contexto, destaca en tareas de comprensión de contexto de larga duración, superando a todos los modelos de código abierto en general, incluso a OpenAI o3 y Claude 4 Opus, y ocupando el segundo puesto mundial por detrás de Gemini 2.5 Pro.

- Escenarios de uso de las herramientasEn la prueba TAU-bench, MiniMax-M1-40k lideró a todos los modelos de código abierto, superando a Gemini-2.5 Pro.

Dirección del sitio web oficial de MiniMax-M1

- Repositorio GitHub::https://github.com/MiniMax-AI/MiniMax-M1

- Biblioteca de modelos HuggingFace::https://huggingface.co/collections/MiniMaxAI/minimax-m1

- Documentos técnicos::https://github.com/MiniMax-AI/MiniMax-M1/blob/main/MiniMax_M1_tech_report.pdf

Cómo utilizar MiniMax-M1

- Llamadas a la API::

- Visite el sitio web oficial: Visite MiniMax Sitio web oficialRegístrese y acceda a su cuenta.

- Obtener la clave APISolicite una clave API en el Centro Personal o en la página de desarrolladores.

- Uso de la APIInvocar el modelo basado en peticiones HTTP, de acuerdo con la documentación oficial de la API. Por ejemplo, envíe una solicitud utilizando la biblioteca de solicitudes de Python:

import requests

url = "https://api.minimax.cn/v1/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "MiniMax-M1",

"messages": [

{"role": "user", "content": "请生成一段关于人工智能的介绍。"}

]

}

response = requests.post(url, headers=headers, json=data)

print(response.json())- Uso de la cara abrazada::

- Instalación de la biblioteca Cara abrazada: Asegúrese de que las dependencias como los transformadores y la antorcha están instaladas.

pip install transformers torch- Modelos de cargaCarga un modelo MiniMax-M1 desde el Hub de Caras Abrazadas.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "MiniMaxAI/MiniMax-M1"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

input_text = "请生成一段关于人工智能的介绍。"

inputs = tokenizer(input_text, return_tensors="pt")

output = model.generate(**inputs, max_length=100)

print(tokenizer.decode(output[0], skip_special_tokens=True))- Uso en MiniMax APP o Web::

- Acceso a la Web: Conéctese al sitio web de MiniMax, introduzca una pregunta o tarea en la página y el modelo generará directamente la respuesta.

- DESCARGAR APPDescarga la APP MiniMax en tu teléfono móvil e interactúa con ella mediante operaciones similares.

Precios de MiniMax-M1

- Precio del coste de inferencia de llamadas API::

- 0-32k Longitud de entrada::

- coste de los insumos0,8 $/millón de fichas.

- coste de producción$8/millón de fichas.

- 32k-128k Longitud de entrada::

- coste de los insumos1,2 $/millón de fichas.

- coste de producción16 dólares por millón de fichas.

- 128k-1M Longitud de entrada::

- coste de los insumos2,4 $/millón de fichas.

- coste de producción24 dólares por millón de fichas.

- 0-32k Longitud de entrada::

- APP y Web::

- Uso gratuito: MiniMax APP y Web ofrecen acceso gratuito ilimitado, apto para usuarios generales y usuarios con formación no técnica.

Ventajas principales de MiniMax-M1

- capacidad de procesamiento de contextos largosAdmite entradas de hasta 1 millón de tokens y salidas de hasta 80.000 tokens, lo que lo hace adecuado para procesar documentos largos y tareas de razonamiento complejas.

- Eficacia de la inferencia: Proporcionar dos versiones de presupuesto de inferencia de 40K y 80K, combinadas con el mecanismo de atención relámpago para optimizar los recursos computacionales y reducir los costes de inferencia.

- Optimización de tareas multidisciplinares: destacan en tareas como la ingeniería de software, la comprensión del contexto a largo plazo, el razonamiento matemático y el uso de herramientas, adaptándose a diversos escenarios de aplicación.

- Arquitectura tecnológica avanzadaBasado en una arquitectura experta híbrida (MoE) y en el entrenamiento a gran escala del aprendizaje por refuerzo (RL) para mejorar la eficiencia computacional y el rendimiento del modelo.

- alta relación calidad-precioRendimiento: se aproxima a los modelos internacionales líderes, al tiempo que ofrece estrategias de precios flexibles, y la APP y la Web son gratuitas, lo que reduce la barrera de uso.

Personas a las que está destinado el MiniMax-M1

- desarrolladores: Los desarrolladores de software generan código de forma eficiente, optimizan la estructura del código, depuran programas o generan automáticamente documentación de código.

- Investigadores y universitariosProcesar artículos académicos extensos, realizar revisiones bibliográficas o análisis de datos complejos, utilizar modelos para organizar ideas rápidamente, generar informes y resumir conclusiones.

- creador de contenidosEl MiniMax-M1 ayuda a quienes necesitan crear contenidos de larga duración a generar ideas, escribir esbozos de historias, retocar textos o generar ficción de larga duración, entre otras cosas.

- escolares: por ofrecer soluciones claras y apoyo en la redacción.

- usuario empresarialLas empresas las integran en soluciones de automatización, como el servicio inteligente de atención al cliente, las herramientas de análisis de datos o la automatización de procesos empresariales.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...