Magic 1-For-1: proyecto de código abierto de generación eficiente de vídeo que pretende generar un vídeo de un minuto en menos de un minuto.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 55.5K 00

Introducción general

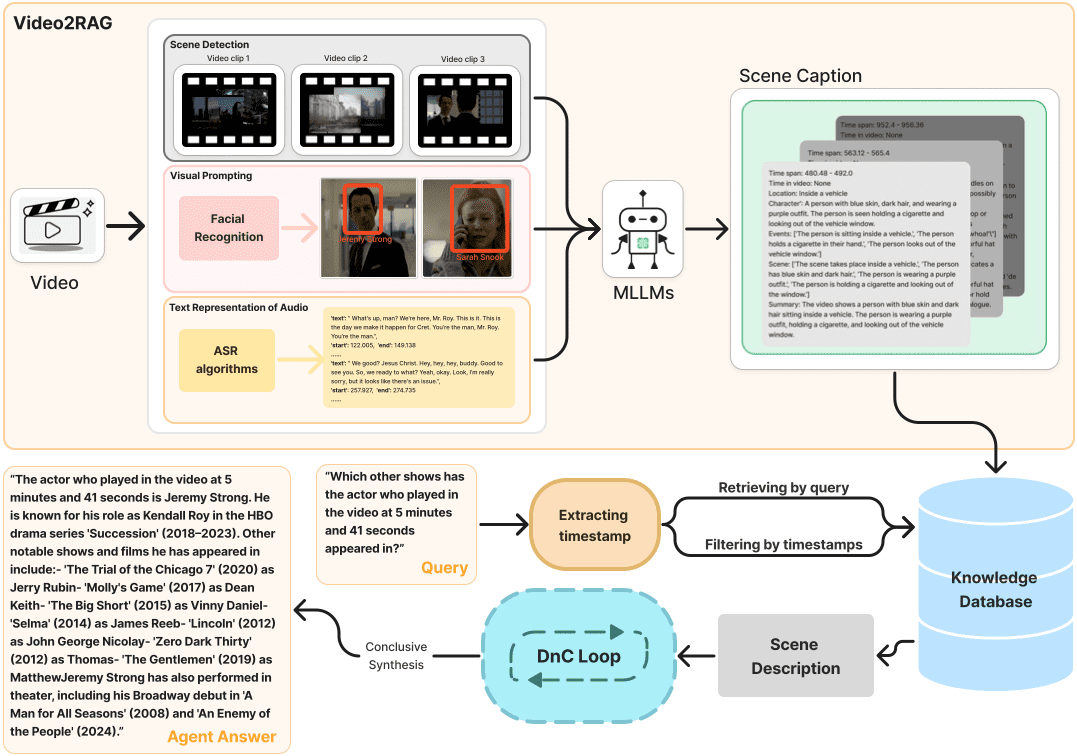

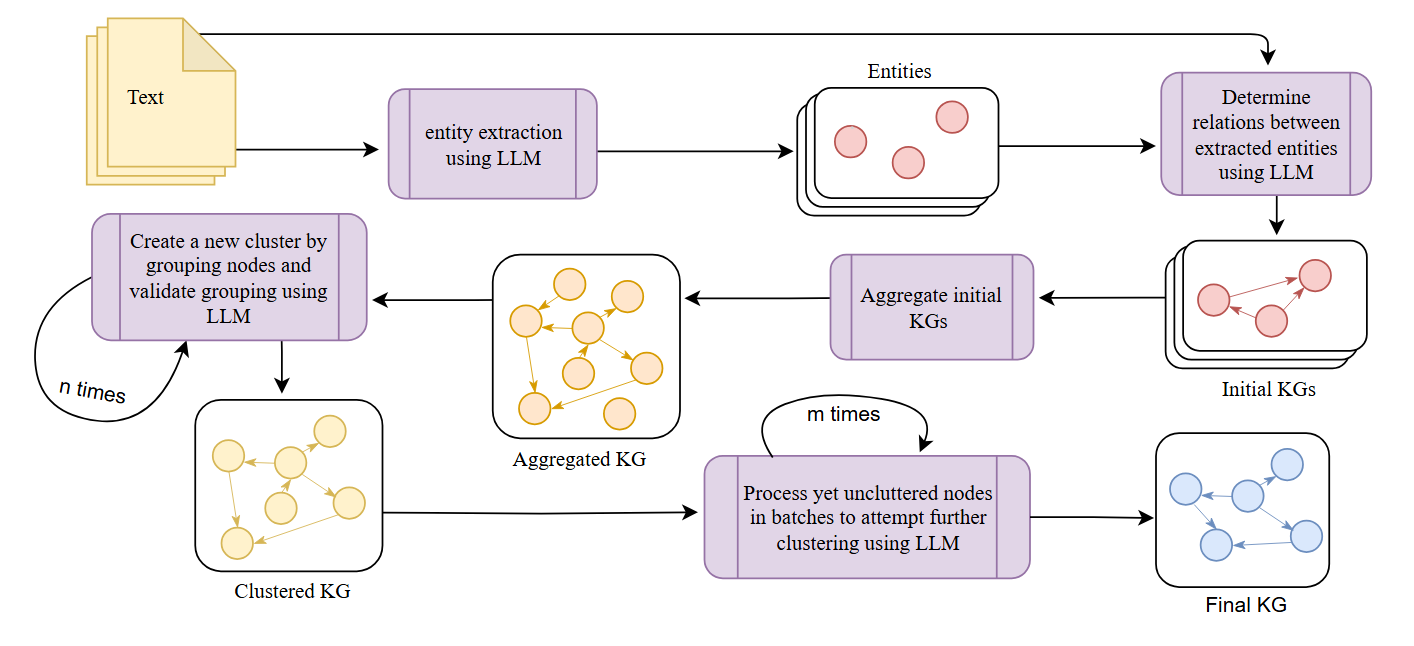

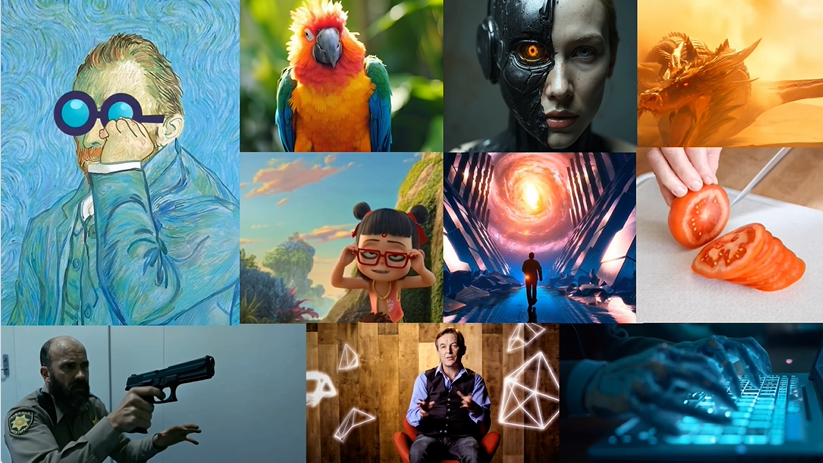

Magic 1-For-1 es un modelo eficiente de generación de vídeo diseñado para optimizar el uso de la memoria y reducir la latencia de la inferencia. El modelo descompone la tarea de generación de texto a vídeo en dos subtareas: generación de texto a imagen y generación de imagen a vídeo para un entrenamiento y una destilación más eficientes.Magic 1-For-1 puede generar videoclips de un minuto de alta calidad en menos de un minuto para escenarios en los que es necesario generar vídeos cortos con rapidez. El proyecto ha sido desarrollado por investigadores de la Universidad de Pekín, Hedra Inc. y Nvidia, y el código y los pesos del modelo están a disposición del público en GitHub.

Lista de funciones

- Generación de texto a imagen: convierte la descripción de texto introducida en una imagen.

- Generación de imagen a vídeo: Convierte las imágenes generadas en clips de vídeo.

- Uso eficiente de la memoria: optimiza el uso de la memoria en entornos de una sola GPU.

- Inferencia rápida: reducir la latencia de la inferencia para generar vídeos con rapidez.

- Descarga de los pesos del modelo: proporciona enlaces para descargar los pesos del modelo preentrenado.

- Configuración del entorno: proporciona una guía detallada de configuración del entorno e instalación de dependencias.

Utilizar la ayuda

Entorno

- Instala git-lfs:

sudo apt-get install git-lfs

- Se crea y activa el entorno Conda:

conda create -n video_infer python=3.9

conda activate video_infer

- Instale las dependencias del proyecto:

pip install -r requirements.txt

Descargar modelos de pesos

- Crear un directorio para almacenar los pesos pre-entrenados:

mkdir pretrained_weights

- Descargar Pesos mágicos 1 por 1:

wget -O pretrained_weights/magic_1_for_1_weights.pth <model_weights_url>

- Descargar el componente Cara de abrazo:

huggingface-cli download tencent/HunyuanVideo --local_dir pretrained_weights --local_dir_use_symlinks False

huggingface-cli download xtuner/llava-llama-3-8b-v1_1-transformers --local_dir pretrained_weights/text_encoder --local_dir_use_symlinks False

huggingface-cli download openai/clip-vit-large-patch14 --local_dir pretrained_weights/text_encoder_2 --local_dir_use_symlinks False

Generar vídeo

- Ejecute los siguientes comandos para la generación de texto e imagen a vídeo:

python test_ti2v.py --config configs/test/text_to_video/4_step_ti2v.yaml --quantization False

- O utilice el script proporcionado:

bash scripts/generate_video.sh

Flujo detallado de funcionamiento de las funciones

- Generación de texto a imagen: Introduzca una descripción textual y el modelo generará la imagen correspondiente.

- Generación de imagen a vídeoMódulo de generación de vídeo: introduzca las imágenes generadas en el módulo de generación de vídeo para generar clips de vídeo cortos.

- Uso eficiente de la memoria: Garantiza un funcionamiento eficiente incluso en entornos de una sola GPU optimizando el uso de la memoria.

- inferencia rápidaReducir el retardo de inferencia y lograr una generación rápida de vídeos para escenarios que requieren una generación rápida de vídeos cortos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...