Local Deep Research: una herramienta de gestión local para generar informes de investigación en profundidad.

Últimos recursos sobre IAPublicado hace 10 meses Círculo de intercambio de inteligencia artificial 63.8K 00

Introducción general

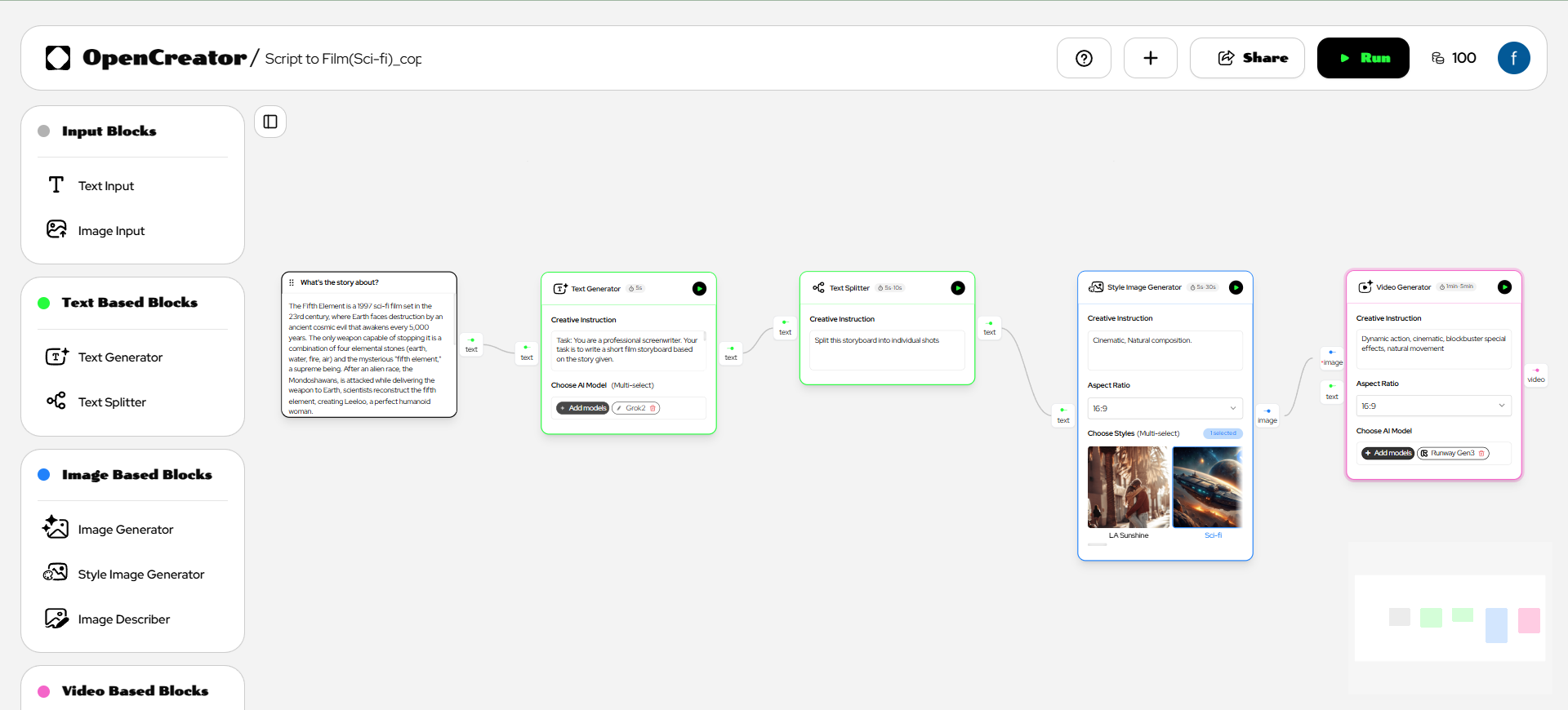

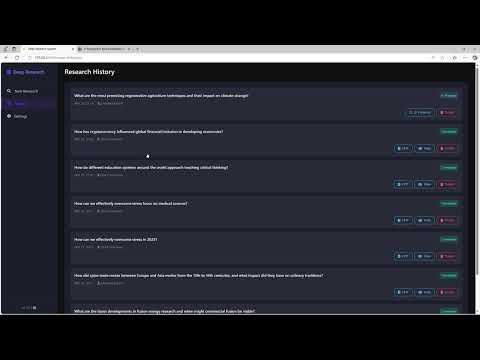

Local Deep Research es un asistente de investigación de IA de código abierto diseñado para ayudar a los usuarios a realizar investigaciones profundas y generar informes detallados sobre problemas complejos. Es compatible con el funcionamiento local, lo que permite a los usuarios completar tareas de investigación sin depender de servicios en la nube. La herramienta combina el modelado local de grandes lenguajes (LLM) con diversas funciones de búsqueda que abarcan fuentes como bases de datos académicas, Wikipedia, contenidos web y otras. Los usuarios pueden generar rápidamente informes completos con citas mediante una instalación y configuración sencillas. El proyecto hace hincapié en la protección de la privacidad y la flexibilidad y es adecuado para la investigación académica, la exploración tecnológica o la gestión personal del conocimiento.

Lista de funciones

- Admite modelos lingüísticos locales de gran tamaño para proteger la privacidad de los datos.

- Seleccione automáticamente las herramientas de búsqueda adecuadas, como Wikipedia, arXiv, PubMed, etc.

- Genere informes detallados con secciones y citas estructuradas.

- Ofrece una función de resumen rápido que genera respuestas breves en cuestión de segundos.

- Admite la búsqueda local de documentos, combinada con la búsqueda en la web para un análisis exhaustivo.

- Ofrece interfaz web e interfaz de línea de comandos para un funcionamiento flexible.

- Búsqueda multilingüe para usuarios de todo el mundo.

Utilizar la ayuda

Proceso de instalación

Local Deep Research requiere la instalación del entorno Python y las dependencias relacionadas. A continuación se detallan los pasos de instalación:

- almacén de clones

Ejecute el siguiente comando en el terminal para clonar el proyecto localmente:git clone https://github.com/LearningCircuit/local-deep-research.git cd local-deep-research

- Instalación de dependencias

Utilice las herramientas de gestión de paquetes de Python para instalar las bibliotecas necesarias:pip install -e .Si necesita funciones de automatización del navegador, instale Playwright:

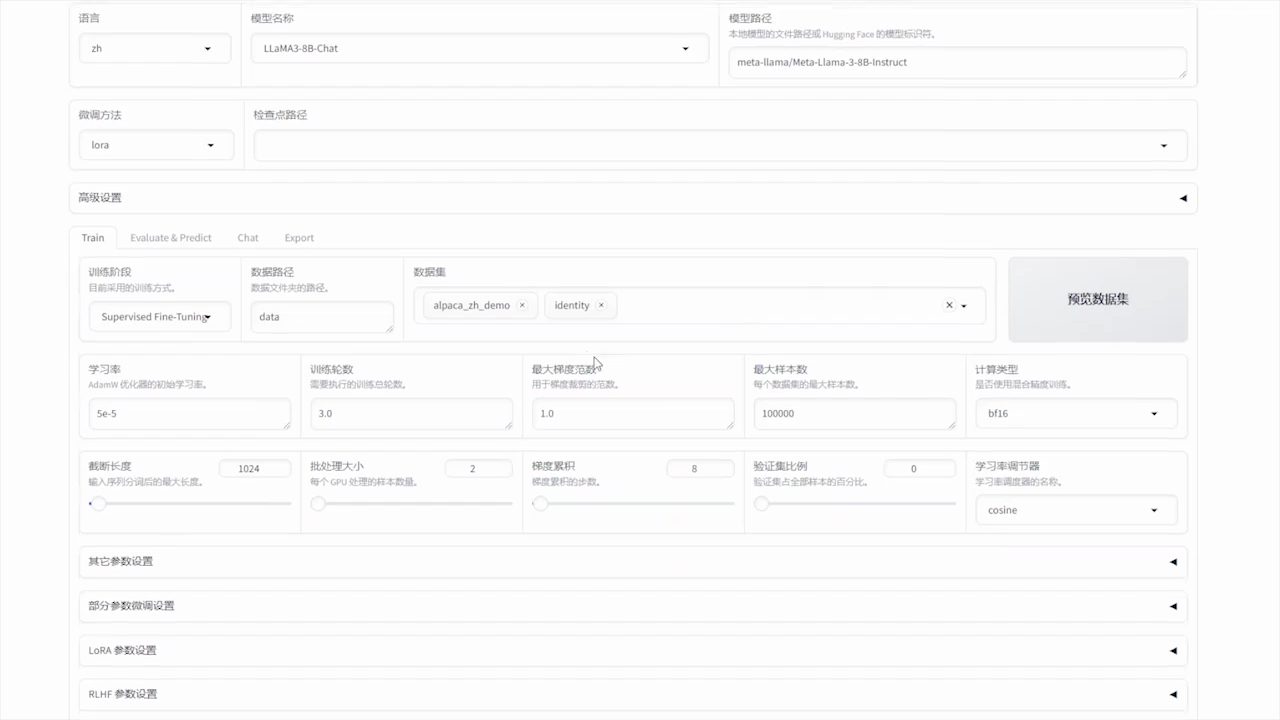

playwright install - Instalación de modelos locales (Ollama)

Local Deep Research apoya la adopción de Ollama Ejecute un modelo lingüístico local de gran tamaño. Visite https://ollama.ai para descargar e instalar Ollama y, a continuación, extraiga el modelo de recomendación:ollama pull gemma3:12bAsegúrese de que el servicio Ollama se ejecuta en segundo plano.

- Configuración de SearXNG (opcional)

Para obtener los mejores resultados de búsqueda, se recomienda autoalojar el servicio de búsqueda SearXNG. Ejecute el siguiente comando para iniciar SearXNG:docker pull searxng/searxng docker run -d -p 8080:8080 --name searxng searxng/searxngEn el directorio raíz del proyecto

.envpara configurar la dirección SearXNG:SEARXNG_INSTANCE=http://localhost:8080 SEARXNG_DELAY=2.0 - kit de inicio

- interfaz web: Ejecute el siguiente comando para iniciar la versión web, visite http://127.0.0.1:5000:

ldr-web - interfaz de línea de comandosEjecute el siguiente comando para iniciar la versión de línea de comandos:

ldr

- interfaz web: Ejecute el siguiente comando para iniciar la versión web, visite http://127.0.0.1:5000:

Funcionamiento de las funciones principales

1. Generación de un resumen rápido

La función Resumen Rápido está pensada para los usuarios que necesitan una respuesta rápida. Abra la interfaz web e introduzca una pregunta de investigación, como "Avances recientes en energía de fusión". Pulse el botón "Resumen rápido" y la herramienta le devolverá en unos segundos una breve respuesta con información clave y fuentes. Si utiliza la línea de comandos, ejecútela:

from local_deep_research import quick_summary

results = quick_summary(query="核聚变能源的最新进展", search_tool="auto", iterations=1, questions_per_iteration=2, max_results=30)

print(results["summary"])

Los resultados se mostrarán en forma de texto con un breve resumen y enlaces de referencia.

2. Generación de informes detallados

La función de informe detallado es adecuada para los usuarios que necesitan un análisis exhaustivo. Tras introducir una pregunta en la interfaz web, seleccione la opción "Generar informe". La herramienta realiza varias rondas de búsqueda y análisis y genera un informe en formato Markdown con un índice, capítulos y citas. El tiempo de generación del informe depende de la complejidad del problema y del número de rondas de búsqueda (2 por defecto). Ejemplo de funcionamiento de la línea de comandos:

from local_deep_research import generate_report

report = generate_report(query="核聚变能源的最新进展", search_tool="auto", iterations=2)

print(report)

Los informes generados se guardan localmente, normalmente en el directorio raíz del proyecto bajo la ruta examples Carpeta.

3. Recuperación local de documentos

Los usuarios pueden cargar documentos privados (por ejemplo, PDF, TXT) en una carpeta especificada para que sean analizados por la función de Generación Aumentada de Recuperación (RAG). Configure la ruta del documento:

DOC_PATH=/path/to/your/documents

Seleccione "Documentos locales" como fuente del informe en la interfaz web, y la herramienta generará un informe combinando documentos locales y búsqueda web. Funcionamiento en línea de comandos:

results = quick_summary(query="分析我的文档中的AI趋势", report_source="local")

4. Búsqueda multilingüe

La herramienta admite la búsqueda multilingüe de preguntas en otros idiomas. Introduzca una pregunta en chino o en otro idioma en la interfaz web y la herramienta adaptará automáticamente el buscador para devolver los resultados pertinentes. Por ejemplo, si escribe "últimos avances en computación cuántica", la herramienta buscará en fuentes tanto chinas como inglesas.

Parámetros de configuración

Los usuarios pueden modificar el config.py tal vez .env El archivo ajusta los parámetros:

search_tool: Seleccionar herramienta de búsqueda (por defecto)auto).iterations: Establece el número de rondas de estudio (por defecto 2).max_resultsNúmero máximo de resultados por ronda de búsqueda (por defecto 50).max_filtered_results: Número de resultados filtrados (por defecto 5).

advertencia

- Garantice una conexión estable a Internet para buscar recursos externos.

- El rendimiento del modelo local depende del hardware y se recomienda la aceleración por GPU.

- Actualice regularmente Ollama y el código del proyecto para incorporar las últimas funciones.

escenario de aplicación

- investigación académica

Estudiantes e investigadores pueden utilizar Local Deep Research para recopilar rápidamente información de artículos académicos y páginas web y generar informes citados. Por ejemplo, al investigar "Breakthroughs in Quantum Computing", la herramienta recupera los últimos artículos de arXiv y PubMed y genera un informe estructurado. - Exploración tecnológica

Los entusiastas de la tecnología pueden explorar tendencias tecnológicas emergentes como "Blockchain en la cadena de suministro". La herramienta combina documentación local y búsquedas en Internet para ofrecer análisis exhaustivos. - Gestión del conocimiento personal

Los usuarios pueden subir notas o documentos privados para organizar su base de conocimientos con información externa. Por ejemplo, un informe personal sobre "Predicciones de desarrollo de la IA para 2025".

CONTROL DE CALIDAD

- ¿Requiere la investigación local en profundidad la creación de redes?

El modelo local funciona sin conexión a Internet, pero las funciones de búsqueda (por ejemplo, Wikipedia, arXiv) requieren conexión a Internet. Los usuarios pueden optar por utilizar únicamente documentos locales. - ¿Qué grandes modelos lingüísticos son compatibles?

Los modelos alojados en Ollama son compatibles por defecto, como por ejemplogemma3:12b. Los usuarios pueden acceder a esta información a través deconfig.pyConfigurar otros modelos como vLLM o LMStudio. - ¿Cómo mejorar la calidad de los informes?

Aumentar las rondas de búsqueda (iterations) y el número de resultados (max_results), o utilizar un modelo más potente. Asegurarse de que el problema está claramente descrito también puede ayudar a mejorar la precisión. - ¿Son compatibles los sistemas Windows?

Sí, el proyecto proporciona un instalador de Windows de un solo clic para simplificar el proceso de configuración. Visite el repositorio de GitHub para descargarlo.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...