LM Speed: Pruebas rápidas de rendimiento de API de modelos grandes

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 52.2K 00

Introducción general

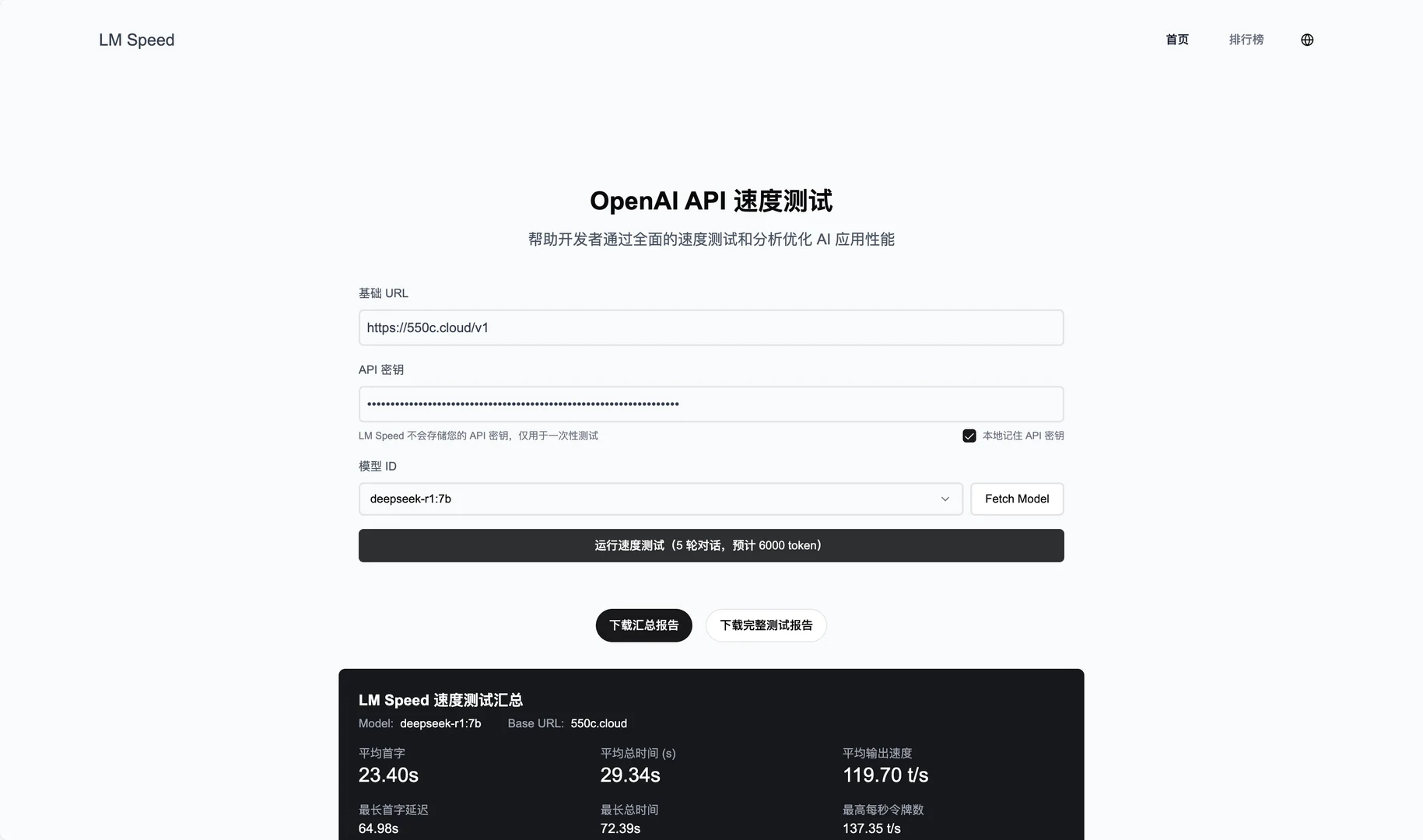

LM Speed es una herramienta diseñada específicamente para desarrolladores de IA y disponible como servicio en línea en lmspeed.net. Su función principal es probar y analizar el rendimiento de las API de modelos lingüísticos, ayudando a los usuarios a identificar rápidamente los cuellos de botella de velocidad y optimizar las estrategias de llamada. La herramienta es compatible con diversas interfaces, incluida la API OpenAI, y ofrece supervisión de datos en tiempo real e informes detallados sobre el rendimiento. Tanto si se trata de un desarrollador individual como de un equipo, LM Speed facilita la comparación del rendimiento de diferentes modelos y proveedores mediante gráficos de datos intuitivos y pruebas automatizadas.

Lista de funciones

- Supervisión del rendimiento en tiempo real: muestra datos multidimensionales como el procesamiento por segundo. ficha Número (TPoS).

- Evaluación exhaustiva del rendimiento: mida métricas básicas como la latencia del primer token, el tiempo de respuesta y mucho más.

- Visualización de datos: genere gráficos enriquecidos para visualizar las tendencias de rendimiento.

- Pruebas de resistencia automatizadas: cinco rondas consecutivas de pruebas para garantizar la fiabilidad de los datos.

- Generación de informes con un solo clic: crea automáticamente informes de pruebas profesionales, admite exportación y uso compartido.

- Prueba rápida de parámetros de URL: inicie la prueba directamente desde el enlace sin necesidad de introducir datos manualmente.

- Almacenamiento de datos históricos: registra los resultados de las pruebas y facilita el análisis de tendencias.

Utilizar la ayuda

Uso de servicios en línea

- Acceso al sitio web

Abra su navegador y vaya a https://lmspeed.net. - Parámetros de entrada

Rellene el formulario de la página con la siguiente información:baseUrlDirección del servicio API, por ejemplohttps://api.deepseek.com/v1.apiKeySu clave API.modelId: el ID del modelo que se va a probar, por ejemplo.free:QwQ-32B.

- prueba de arranque

Haga clic en el botón "Iniciar prueba" y el sistema ejecutará automáticamente cinco rondas de pruebas de estrés. Durante la prueba, verá actualizaciones de datos en tiempo real, incluidos los tiempos de TPoS y de respuesta. - Ver resultados

Una vez finalizada la prueba, la página muestra gráficos y métricas detallados, como la latencia del primer token y el rendimiento medio. Puedes hacer clic en el botón "Generar informe" para descargar el PDF o compartirlo con tu equipo. - Prueba rápida de parámetros URL

Si no desea introducirlo manualmente, puede iniciar la prueba directamente con un enlace. Ejemplo:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

Tras abrir el enlace, la prueba se inicia automáticamente. Nota: Por razones de seguridad, se recomienda no pasar la clave API directamente en la URL.

Despliegue local Proceso de instalación

- Preparar el entorno

Asegúrese de que su ordenador tiene instalados Git, Node.js (se recomienda v16 o superior), Docker y Docker Compose; si no es así, descárguelos e instálelos primero. - almacén de clones

Abra un terminal e introduzca el siguiente comando para descargar el código:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Despliegue de Docker

- establecer

docker-compose.ymlcopie el código suministrado oficialmente:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - Se ejecuta en el terminal:

docker-compose up -d - Una vez realizada la implantación, acceda a

http://localhost:8650Servicios de visualización.

- Despliegue manual

- Instale la dependencia:

npm install - Copiar y configurar variables de entorno:

cp .env.example .envcompilador

.envrellene la dirección de la base de datos y la configuración de la API. - Inicie el servicio:

npm run dev - entrevistas

http://localhost:3000.

Función destacada Operación

- seguimiento en tiempo real

Cuando se realizan pruebas en línea, la página muestra dinámicamente los cambios en el TPoS y el tiempo de respuesta. Puedes pasar el ratón por encima de los gráficos para ver los valores exactos. - prueba automatizada

Tras hacer clic en "Iniciar prueba", el sistema realiza automáticamente cinco rondas de pruebas. Los resultados de cada ronda se registran, y al final se generan el valor medio y el rango de fluctuación para ayudarle a juzgar la estabilidad de la API. - Exportación de informes

Una vez finalizada la prueba, haz clic en "Exportar informe" y selecciona el formato PDF. El informe contiene el entorno de prueba, las métricas de rendimiento y los gráficos, y es adecuado para compartirlo en equipo o archivarlo. - Análisis de datos históricos

El servicio en línea mantiene un registro de sus pruebas. Después de iniciar sesión, vaya a la página "Historial" para ver los resultados de pruebas anteriores y las tendencias de rendimiento.

advertencia

- Asegúrese de que la clave API es válida o la prueba fallará.

- Cuando se implante localmente, compruebe que el cortafuegos tiene puertos abiertos (por defecto 3000 u 8650).

- Si el gráfico se carga con lentitud, puede haber un problema de red, por lo que recomendamos actualizar la página y volver a intentarlo.

Con estos pasos, puede probar el rendimiento de la API de modelado lingüístico en línea o localmente con LM Speed. El funcionamiento es sencillo, los resultados son claros y resulta muy útil.

escenario de aplicación

- Los desarrolladores eligen los servicios API

Pruebas para desarrolladores con LM Speed DeepSeek y API como Silicon Flow para seleccionar el proveedor más adecuado para el proyecto. - Llamada al modelo de optimización de equipos

Los equipos de IA lo utilizan para supervisar el rendimiento de las API sometidas a cargas elevadas, ajustando las estrategias de llamada para mejorar la eficacia de las aplicaciones. - Los investigadores analizan las fluctuaciones de rendimiento

- Los investigadores estudiaron los cambios en el rendimiento del modelo en distintas condiciones mediante cinco rondas de pruebas y datos históricos para redactar el informe académico.

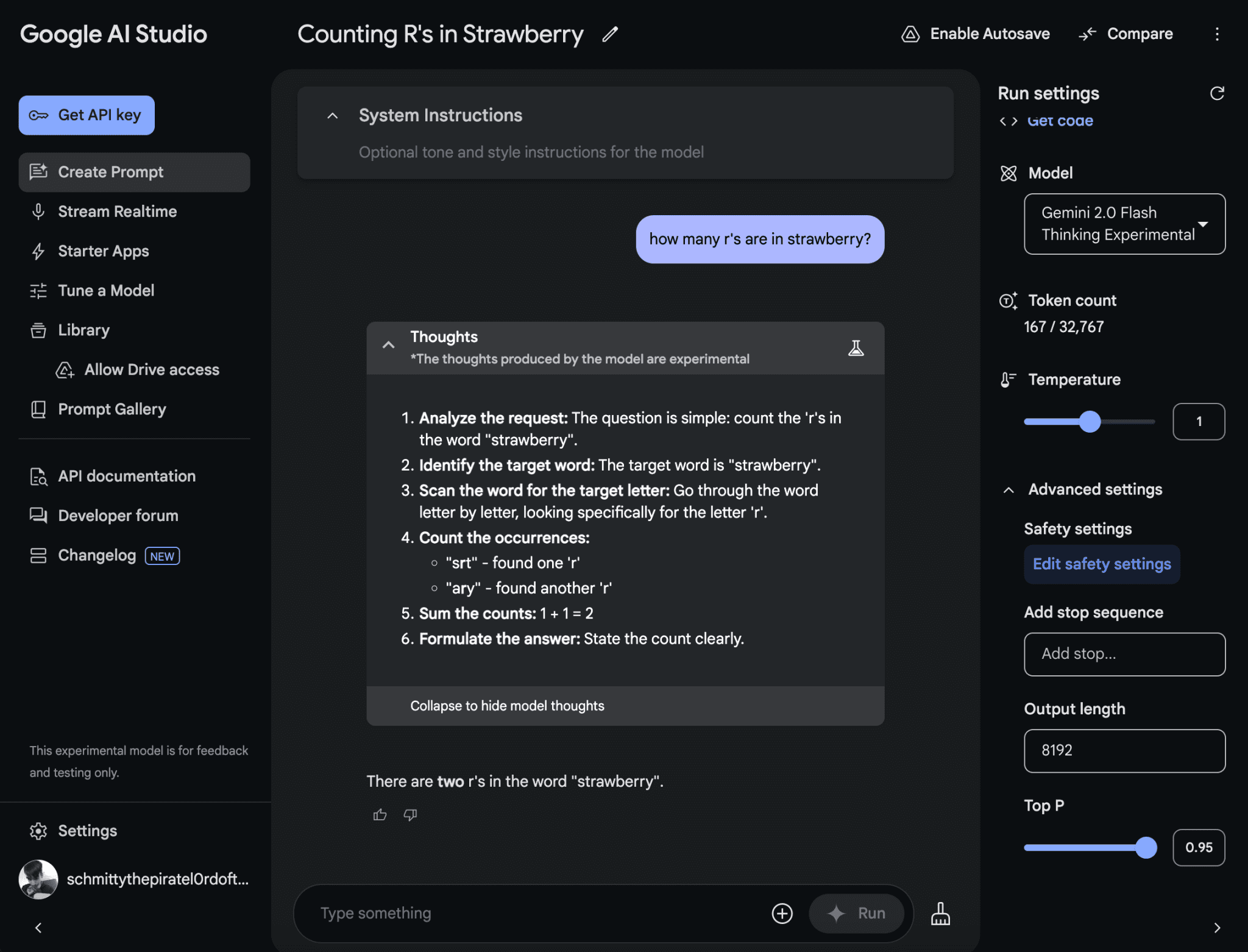

CONTROL DE CALIDAD

- ¿Qué API admite LM Speed?

Soporta principalmente APIs en formato OpenAI, como DeepSeek, Suanli, etc. Siempre que la API sea compatible con el SDK de OpenAI, se puede probar. - ¿Qué ocurre con los resultados inestables de las pruebas?

Compruebe que la conexión de red es estable o aumente el número de rondas de prueba (el código puede modificarse para la implantación local). Las grandes fluctuaciones en los resultados pueden ser un problema con el proveedor de la API. - ¿Tengo que pagar?

Los servicios en línea son actualmente gratuitos, pero su funcionalidad puede ser limitada. La implantación local es completamente gratuita y el código es abierto.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...