LLManager: una herramienta de gestión que combina la aprobación automatizada inteligente de procesos con auditorías humanas.

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 54.6K 00

Introducción general

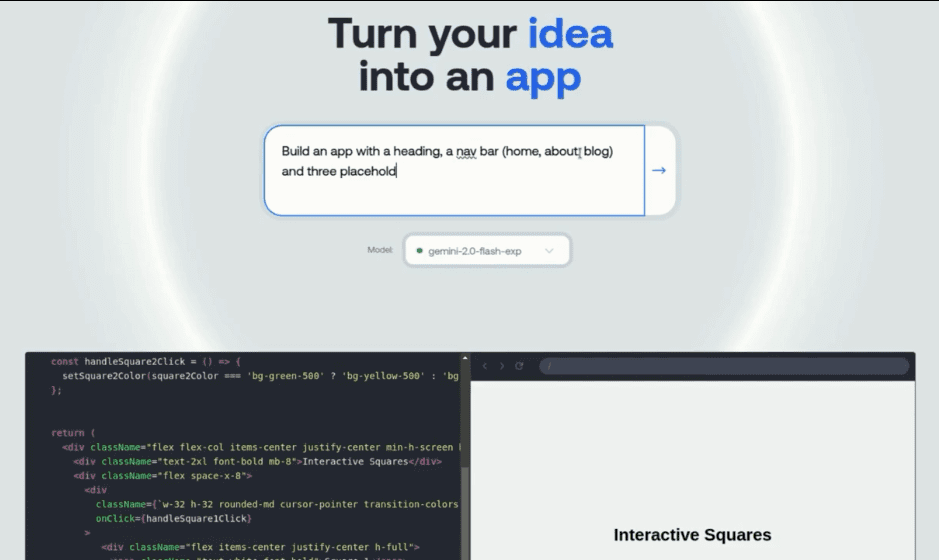

LLManager es una herramienta inteligente de código abierto para la gestión de aprobaciones basada en la tecnología LangChain. LangGraph Marco desarrollado para centrarse en la automatización del procesamiento de las solicitudes de aprobación, optimizando al mismo tiempo la toma de decisiones junto con la revisión humana. Aprende de las aprobaciones históricas mediante búsquedas semánticas, aprendizaje sin muestras y mecanismos de reflexión para mejorar la precisión de la aprobación. Los usuarios pueden utilizar el Buzón del agente LLManager, que visualiza y responde a solicitudes, admite criterios personalizados de aprobación y rechazo, y se adapta a múltiples modelos lingüísticos (por ejemplo, OpenAI, Anthropic), es adecuado para la aprobación de presupuestos empresariales, la gestión de proyectos y escenarios de revisión de cumplimiento, y el código está alojado en GitHub, lo que permite a los desarrolladores ampliar libremente la funcionalidad. La herramienta hace hincapié en la IA y la colaboración humana, equilibrando eficiencia y fiabilidad.

Lista de funciones

- Autorizaciones automatizadasGeneración automática de recomendaciones de aprobación basadas en criterios de aprobación y rechazo definidos por el usuario.

- Auditoría humanaGestión de aprobaciones: admite la aceptación, modificación o rechazo manual de las aprobaciones generadas por la IA para garantizar una toma de decisiones precisa.

- búsqueda semántica: extraen 10 muestras semánticamente similares de solicitudes históricas para mejorar la relevancia contextual de las aprobaciones.

- aprender con menos muestrasOptimizar la capacidad de decisión futura del modelo a partir de los datos históricos de homologación.

- Mecanismos de reflexión: Analizar los resultados de las aprobaciones modificadas y generar informes de reflexión para mejorar el rendimiento del modelo.

- Personalización de modelos: Soporte para modelos como OpenAI, Anthropic, etc., con soporte para la función de llamada a la herramienta.

- Buzón de entrada interactivo: Proporciona una interfaz intuitiva para ver, responder y gestionar las solicitudes de aprobación.

- Creación de señales dinámicas: Ajusta dinámicamente los avisos en función de las solicitudes para adaptarse a diversos escenarios de aprobación.

- Evaluación de principio a fin: Ejecute casos de prueba para verificar la fiabilidad y precisión del flujo de trabajo.

Utilizar la ayuda

Proceso de instalación

LLManager está basado en el proyecto de código abierto LangChain y LangGraph , necesita ser desplegado localmente . A continuación se detallan los pasos de instalación:

- Clonación del código base::

Ejecute el siguiente comando en el terminal para obtener el código LLManager:git clone https://github.com/langchain-ai/llmanager.git cd llmanager - Instalación de dependencias::

Asegúrese de que Python 3.11 o posterior y Node.js (para Yarn) están instalados en su sistema. Cree un entorno virtual e instale las dependencias:python3 -m venv venv source venv/bin/activate yarn installLas dependencias por defecto incluyen LangChain y el paquete de integración Anthropic/OpenAI. Se requieren instalaciones adicionales si se utilizan otros modelos (por ejemplo, Google GenAI):

yarn install @langchain/google-genai - Configuración de variables de entorno::

Copie el archivo de entorno de muestra y rellene la información necesaria:cp .env.example .envcompilador

.envañada la clave API de LangSmith y la clave Antrópico Clave API (si utiliza el modelo antrópico):LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"LangSmith se utiliza para rastreo y depuración y se recomienda habilitarlo.

- Iniciar el servidor de desarrollo::

Ejecute el siguiente comando para iniciar el servidor LangGraph:yarn devEl servidor se ejecuta por defecto en el

http://localhost:2024En entornos de producción, despliegue en un servidor en la nube y actualice la URL. En un entorno de producción, despliegue en un servidor en la nube y actualice la URL.

Utilización

El núcleo de LLManager es gestionar y responder a las solicitudes de aprobación a través de la Bandeja de Entrada del Agente. A continuación se detalla el flujo de operaciones:

- Realizar una evaluación de principio a fin::

- Ejecute el siguiente comando para generar un nuevo asistente de aprobación y ejecutar 25 casos de prueba:

yarn test:single evals/e2e.int.test.ts - El terminal emite el UUID del nuevo asistente, registrando este ID para la configuración de la Bandeja de Entrada del Agente.

- Si necesita reutilizar el mismo asistente, puede modificar la opción

evals/e2e.int.test.tsSi utiliza un ID de ayudante fijo, utilice el ID de ayudante fijo.

- Ejecute el siguiente comando para generar un nuevo asistente de aprobación y ejecutar 25 casos de prueba:

- Configuración de reglas de aprobación::

- existe

config.jsonEstablezca los criterios de aprobación y rechazo en ejemplo:{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - Cuando no se establecen reglas, LLManager aprende basándose en datos históricos, pero establecer reglas acelera la adaptación del modelo.

modelIdadyuvanteprovider/model_namecomo, por ejemploopenai/gpt-4otal vezanthropic/claude-3-5-sonnet-latest.

- existe

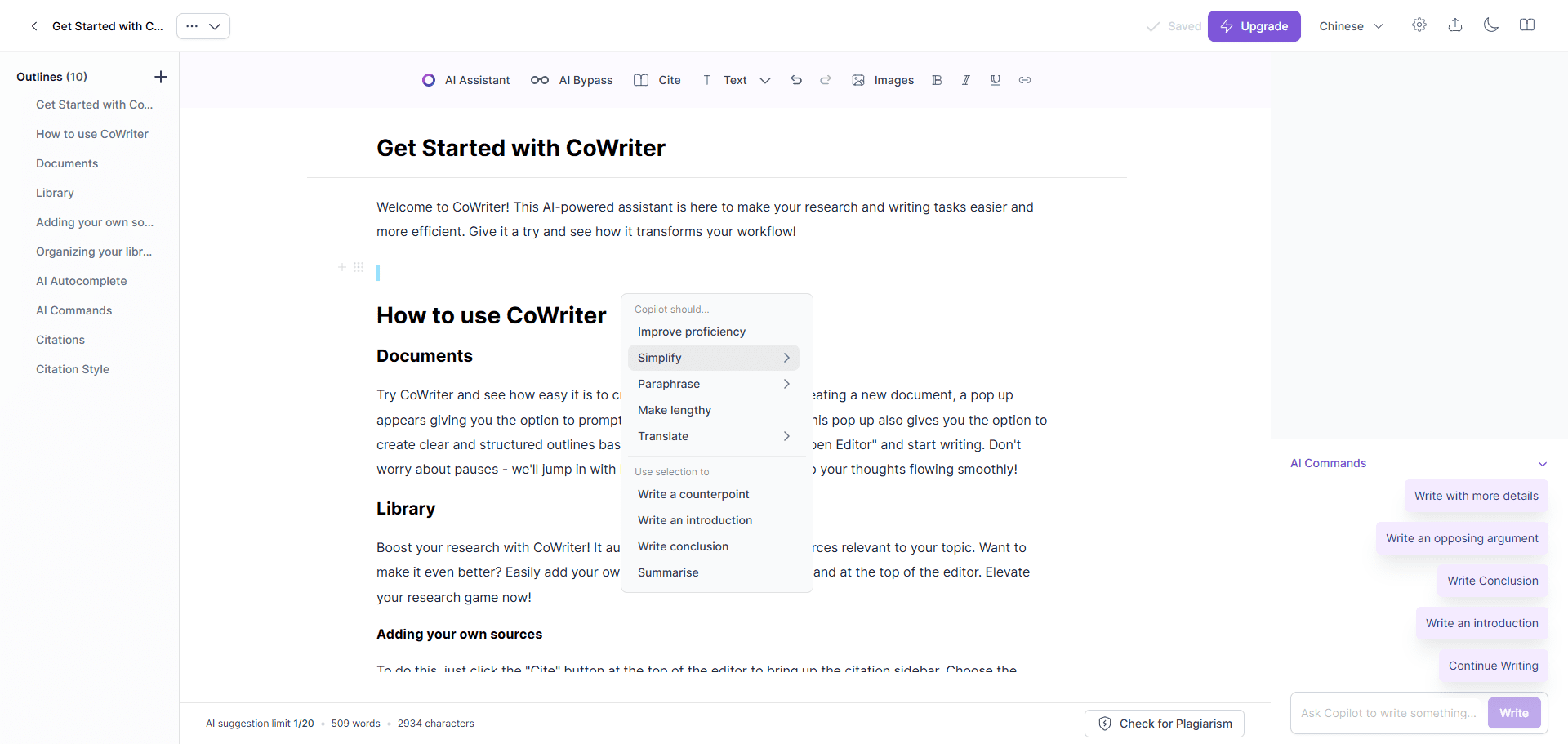

- Uso del buzón de entrada del agente::

- Vaya a dev.agentinbox.ai y haga clic en "Añadir bandeja de entrada".

- Introduzca la siguiente información:

- Asistente/Graph IDUUID generado por la evaluación de extremo a extremo.

- URL de implantación::

http://localhost:2024(entorno de desarrollo). - NombrePersonaliza el nombre, por ejemplo

LLManager.

- Actualice la bandeja de entrada después del envío para ver las solicitudes pendientes.

- Para cada solicitud, se muestra la Bandeja de Entrada del Agente:

- Recomendaciones de aprobación e informes de razonamiento generados por IA.

- Opciones de acción: Aceptar, Modificar (editar sugerencias o instrucciones) o Rechazar (indicar motivos).

- Las solicitudes modificadas o aceptadas se almacenan automáticamente en la biblioteca Less Sample Example para optimizar las aprobaciones posteriores.

- Ver y optimizar el historial de aprobaciones::

- En la Bandeja de entrada del agente, haga clic en Solicitudes procesadas para ver los detalles de aprobación, los informes de inferencia de IA y los registros de modificación manual.

- El sistema extrae solicitudes similares del historial como modelos de entrada contextual a través de la búsqueda semántica.

- La solicitud modificada activa el mecanismo de reflexión, que genera un informe de reflexión que se almacena en el repositorio de reflexión y se utiliza para mejorar el modelo.

Función destacada Operación

- búsqueda semánticaCuando llega una nueva solicitud, el sistema extrae 10 solicitudes semánticamente similares (incluido el contenido de la solicitud, la respuesta final y la descripción) del historial como contexto de consulta para mejorar la precisión de la aprobación.

- Mecanismos de reflexión::

- Si el manual sólo modifica la descripción (respuesta correcta pero razonamiento incorrecto), active la función

explanation_reflectionnodos para analizar los errores de razonamiento y generar nuevas reflexiones. - Si se modifican tanto la respuesta como la descripción, se activa

full_reflectionnodos, analizando los errores globales y generando reflexiones. - Los informes de reflexión se depositan en un banco de reflexión para optimizar el razonamiento posterior.

- Si el manual sólo modifica la descripción (respuesta correcta pero razonamiento incorrecto), active la función

- Creación de señales dinámicasAjusta dinámicamente los avisos en función del contenido de la solicitud y los datos históricos para garantizar que las aprobaciones se adaptan a diversos escenarios.

- Cambio de modelomodificando el

config.jsonha dado en el clavomodelIdcambiar a un modelo que admita llamadas a herramientas (p. ej.openai/gpt-4o), debe asegurarse de que está instalado el paquete de integración correspondiente.

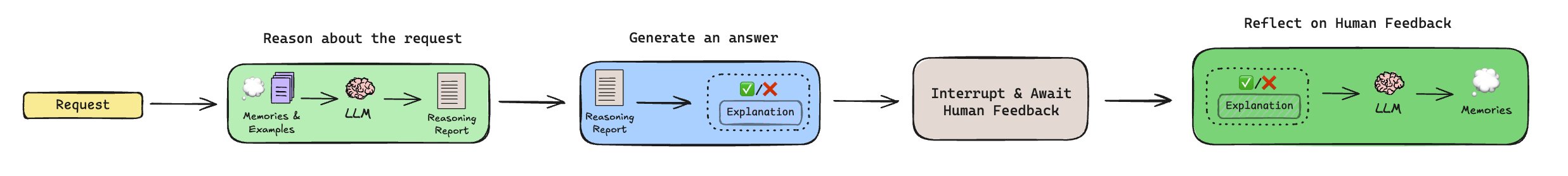

Explicación del flujo de trabajo

El proceso de aprobación de LLManager incluye los siguientes pasos:

- Razonamiento::

- Extracción de reflexiones históricas y ejemplos menores (a través de la búsqueda semántica).

- Genera un informe de razonamiento que analiza si la solicitud debe concederse, pero no toma la decisión final.

- Generar respuesta::

- Combine el informe de razonamiento y el contexto para generar una recomendación de aprobación final (aprobar o rechazar) y una descripción.

- Revisión Humana::

- Suspender el flujo de trabajo y esperar la revisión manual a través de la Bandeja de Entrada del Agente.

- Un humano puede aceptar, modificar o rechazar las sugerencias, y las modificaciones se depositan en la Biblioteca de ejemplos de muestras menores.

- Reflexión::

- Si se modifica la recomendación, se activa un mecanismo de reflexión para generar recomendaciones de mejora.

- Las solicitudes no modificadas omiten este paso.

advertencia

- Asegúrese de que la clave API de LangSmith es válida y de que tanto el entorno de desarrollo como el de producción disponen de redes estables.

- Los modelos no OpenAI/Anthropic requieren la instalación de paquetes de integración adicionales, consulte la documentación de LangChain.

- Los despliegues de producción requieren mover el servidor LangGraph a la nube y actualizar la URL de la Bandeja de entrada del agente.

escenario de aplicación

- Aprobación del presupuesto de la empresa

LLManager automatiza el procesamiento de las solicitudes de presupuesto de los empleados, generando recomendaciones basadas en reglas predefinidas (por ejemplo, límites presupuestarios, tipos de proyectos). El equipo financiero revisa, modifica o confirma los resultados a través de Agent Inbox, reduciendo las tareas repetitivas. - Asignación de tareas del proyecto

Los jefes de proyecto utilizan LLManager para aprobar las solicitudes de asignación de tareas. El sistema analiza las prioridades de las tareas y las necesidades de recursos para generar recomendaciones de asignación. El gestor revisa manualmente la solicitud para garantizar una asignación de tareas eficiente y razonable. - Revisión de la conformidad

LLManager comprueba la conformidad normativa de los documentos presentados y señala posibles problemas. El equipo de cumplimiento confirma o ajusta los resultados a través de Inbox, aumentando la eficiencia de la revisión. - Gestión de las solicitudes de los clientes

Los equipos de atención al cliente utilizan LLManager para aprobar los reembolsos o las solicitudes de servicio de los clientes. El sistema genera recomendaciones basadas en datos históricos, y el equipo las revisa manualmente para garantizar que las decisiones sean justas y coherentes.

CONTROL DE CALIDAD

- ¿Qué modelos admite LLManager?

Los modelos de soporte como OpenAI, Anthropic, etc., necesitan soportar la función de llamada a la herramienta. Los modelos no predeterminados requieren la instalación de paquetes de integración de LangChain, tales como@langchain/google-genai. - ¿Cómo puedo reutilizar el mismo asistente?

modificacionesevals/e2e.int.test.tsSi utiliza un ID de ayudante fijo o busca un ID existente antes de ejecutar una evaluación, evite generar un nuevo ayudante. - ¿Cómo se implanta en un entorno de producción?

Despliegue LangGraph en un servidor en la nube, actualice la URL de despliegue para la bandeja de entrada del agente y utilice LangSmith para supervisar el rendimiento del flujo de trabajo. - ¿Cómo personalizo mi flujo de trabajo?

Edite el subgrafo de razonamiento (para ajustar la lógica de generación de avisos) o el subgrafo de reflexión (para controlar las reglas de generación de reflexiones) para adaptarse a escenarios de aprobación específicos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...