llama.cpp: herramienta de inferencia eficiente, compatible con varios equipos, fácil de implementar la inferencia LLM

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 67K 00

Introducción general

llama.cpp es una biblioteca implementada en C/C++ puro diseñada para simplificar el proceso de inferencia de los modelos de lenguaje extensos (LLM). Es compatible con una amplia gama de plataformas de hardware, como Apple Silicon, GPUs NVIDIA y GPUs AMD, y proporciona varias opciones de cuantificación para aumentar la velocidad de inferencia y reducir el uso de memoria. El objetivo del proyecto es lograr una inferencia LLM de alto rendimiento con una configuración mínima tanto para entornos locales como en la nube.

Lista de funciones

- Compatible con múltiples plataformas de hardware, incluidas Apple Silicon, GPU NVIDIA y GPU AMD.

- Opciones de cuantificación de enteros de 1,5 a 8 bits

- Compatible con varios modelos LLM, como LLaMA, Mistral, Falcon, etc.

- Proporcionar una interfaz API REST para facilitar la integración

- Admite razonamientos mixtos CPU+GPU

- Proporcionar múltiples enlaces de lenguajes de programación, como Python, Go, Node.js, etc.

- Proporcionar diversas herramientas y soporte de infraestructura, como herramientas de transformación de modelos, equilibradores de carga, etc.

Utilizar la ayuda

Proceso de instalación

- Almacén de clonación:

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

- Compila el proyecto:

make

Normas de uso

transformación de modelos

llama.cpp proporciona una variedad de herramientas para convertir y cuantificar modelos para que se ejecuten eficientemente en hardware diferente. Por ejemplo, el modelo Cara abrazada puede convertirse al formato GGML mediante el siguiente comando:

python3 convert_hf_to_gguf.py --model <model_name>

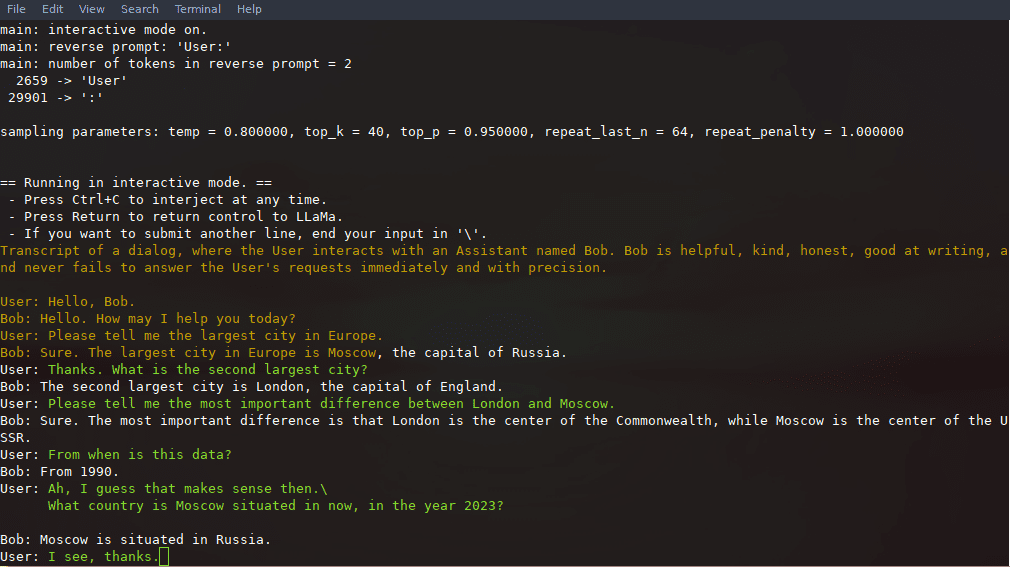

Ejemplo de razonamiento

Tras la compilación, puede utilizar los siguientes comandos para realizar el razonamiento:

./llama-cli -m models/llama-13b-v2/ggml-model-q4_0.gguf -p "你好,世界!"

Uso de la API REST

llama.cpp también proporciona un servidor HTTP compatible con la API de OpenAI que puede utilizarse para servicios locales de inferencia de modelos. Inicie el servidor:

./llama-server -m models/llama-13b-v2/ggml-model-q4_0.gguf --port 8080

A continuación, se puede acceder a la interfaz web básica a través de un navegador o utilizando la API para solicitudes de inferencia:

curl -X POST http://localhost:8080/v1/chat -d '{"prompt": "你好,世界!"}'

Flujo detallado de funcionamiento de las funciones

- Modelo de cargaEn primer lugar, debe descargar el archivo del modelo y colocarlo en el directorio especificado; a continuación, cargue el modelo mediante la herramienta de línea de comandos.

- Configuración del razonamientoLos parámetros relevantes para la inferencia, como la longitud del contexto, el tamaño del lote, etc., pueden establecerse mediante archivos de configuración o parámetros de línea de comandos.

- Integración API: A través de la interfaz REST API, llama.cpp puede integrarse en aplicaciones existentes para habilitar servicios de razonamiento automatizados.

- optimización del rendimientoEl uso de opciones de cuantificación y funciones de aceleración por hardware puede mejorar significativamente la velocidad y la eficacia de la inferencia.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...