Fábrica LLaMA: ajuste eficaz de más de cien macromodelos de código abierto, fácil personalización de modelos

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 58.3K 00

Introducción general

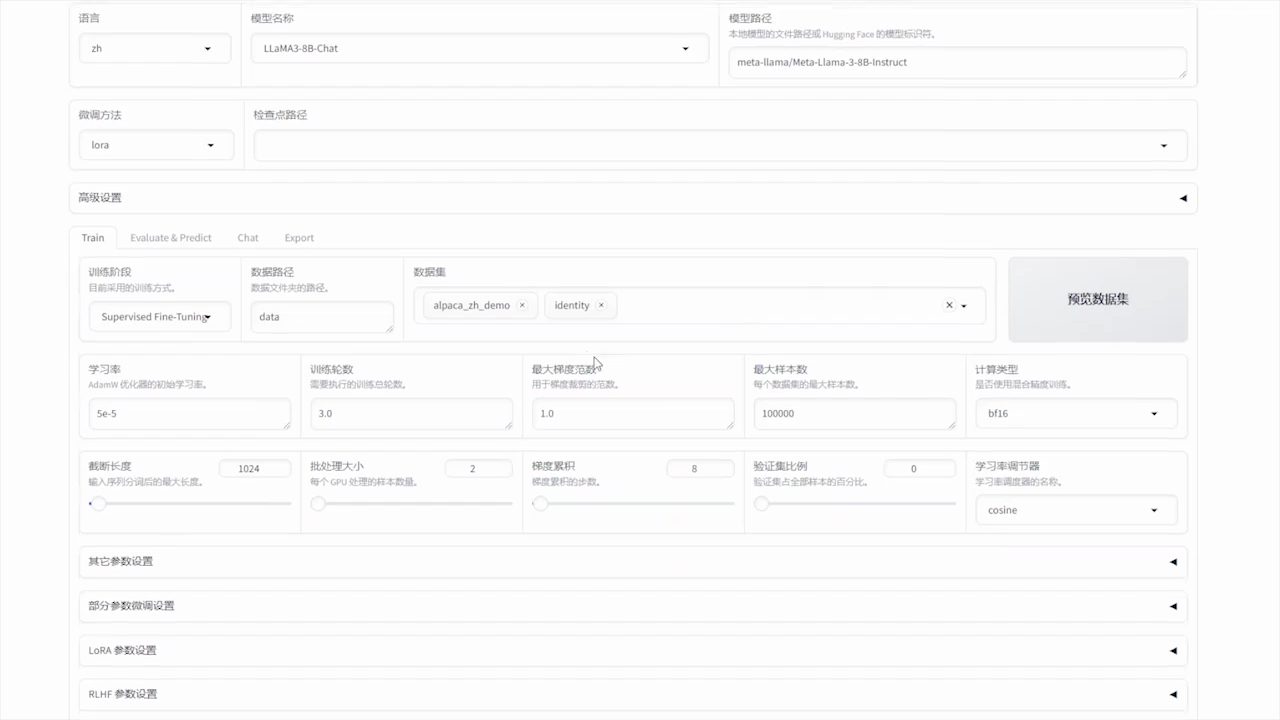

LLaMA-Factory es un marco de ajuste unificado y eficiente que permite la personalización flexible y el entrenamiento eficaz de más de 100 grandes modelos lingüísticos (LLM). La interfaz web integrada LLaMA Board permite a los usuarios ajustar modelos sin necesidad de escribir código. El marco integra diversos métodos de entrenamiento avanzados y consejos prácticos para mejorar significativamente la velocidad de entrenamiento y la utilización de la memoria de la GPU.

Lista de funciones

- Compatibilidad con varios modelosSoporte para LLaMA, LLaVA, Mistral, Qwen y otros modelos multilingües.

- Múltiples métodos de formación: Incluye recorte de volumen completo, recorte por congelación, LoRA, QLoRA, etc.

- algoritmo eficazIntegración de GaLore, BAdam, Adam-mini, DoRA y otros algoritmos avanzados.

- habilidad prácticaSoporte para FlashAttention-2, Unsloth, Liger Kernel y más.

- Seguimiento experimental: Proporciona herramientas de monitorización como LlamaBoard, TensorBoard, Wandb, MLflow, etc.

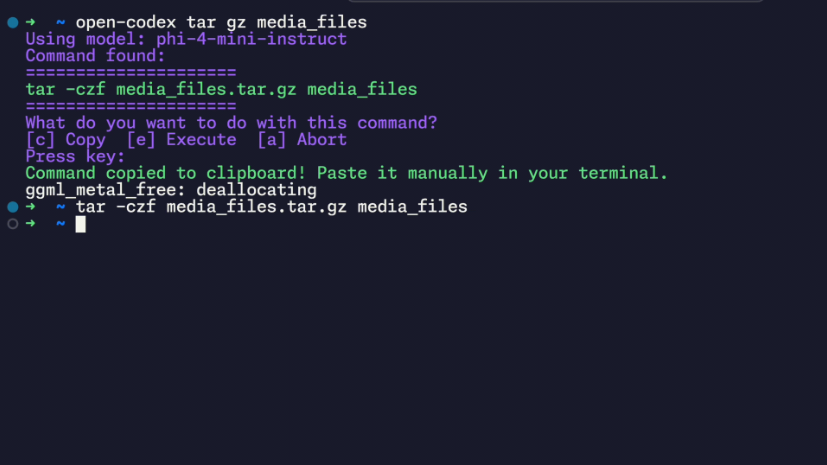

- inferencia rápidaProporciona API similares a OpenAI, Gradio UI e interfaces CLI.

- Soporte de conjuntos de datosSoporte para descargar modelos preentrenados y conjuntos de datos de HuggingFace, ModelScope y otras plataformas.

Utilizar la ayuda

Proceso de instalación

- Clona el código del proyecto:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

- Instale la dependencia:

pip install -e ".[torch,metrics]"

Las dependencias opcionales incluyen: torch, torch-npu, metrics, deepspeed, liger-kernel, bitsandbytes, y más.

Preparación de datos

consulte data/README.md Más información sobre el formato de archivo de los conjuntos de datos. Puede utilizar conjuntos de datos en el hub HuggingFace / ModelScope / Modelers, o cargar conjuntos de datos en su disco local.

Inicio rápido

Utilice los siguientes comandos para ejecutar LoRA para afinar, razonar y fusionar modelos Llama3-8B-Instruct:

llamafactory-cli train examples/train_lora/llama3_lora_sft.yaml

llamafactory-cli chat examples/inference/llama3_lora_sft.yaml

llamafactory-cli export examples/merge_lora/llama3_lora_sft.yaml

Para un uso más avanzado, consulte examples/README.md.

Uso de la interfaz gráfica de usuario de la tarjeta LLaMA

El ajuste fino se realiza a través de la interfaz gráfica de usuario de la placa LLaMA proporcionada por Gradio:

llamafactory-cli webui

Despliegue de Docker

Para usuarios de CUDA:

cd docker/docker-cuda/

docker compose up -d

docker compose exec llamafactory bash

Para usuarios de Ascend NPU:

cd docker/docker-npu/

docker compose up -d

docker compose exec llamafactory bash

Para usuarios de AMD ROCm:

cd docker/docker-rocm/

docker compose up -d

docker compose exec llamafactory bash

Despliegue de API

Utilizar API de tipo OpenAI y vLLM Razonamiento:

API_PORT=8000 llamafactory-cli api examples/inference/llama3_vllm.yaml

Visite esta página para consultar la documentación de la API.

Descargar modelos y conjuntos de datos

Si tiene problemas para descargar modelos y conjuntos de datos de Hugging Face, puede utilizar ModelScope:

export USE_MODELSCOPE_HUB=1

Entrene un modelo especificando el ID del modelo de ModelScope Hub, por ejemplo LLM-Research/Meta-Llama-3-8B-Instruct.

Registro de resultados experimentales con W&B

Para utilizar Pesas & Biases registra los resultados de sus experimentos con los siguientes parámetros en el archivo yaml:

wandb:

project: "your_project_name"

entity: "your_entity_name"

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...