Llama 3: una familia de modelos de IA versátil y de código abierto

Resúmenes.

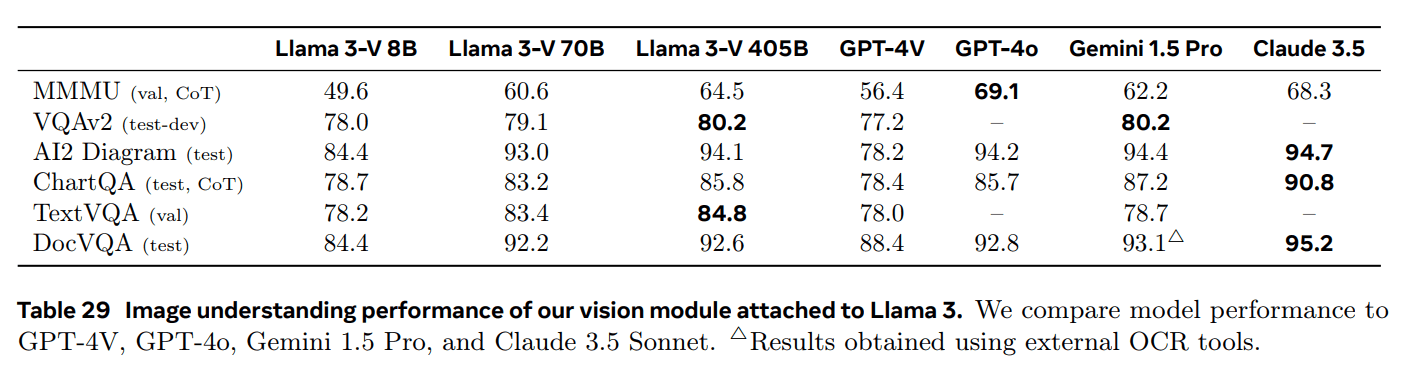

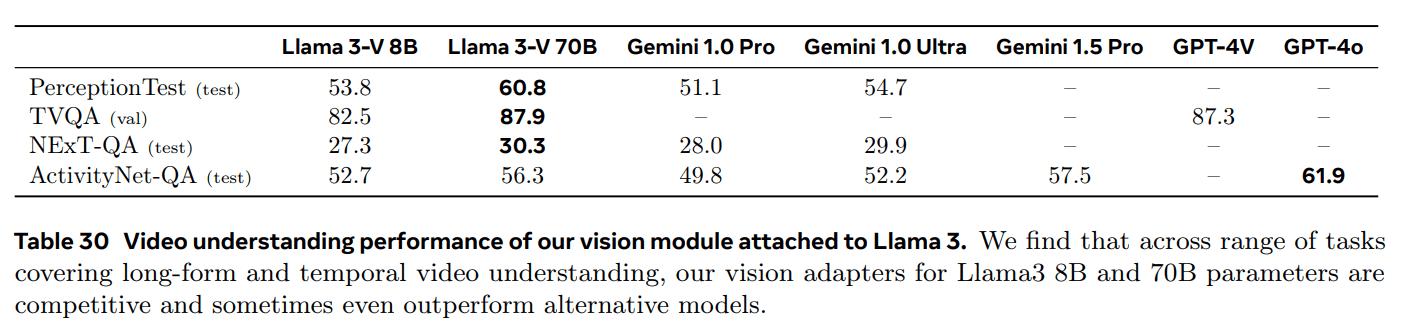

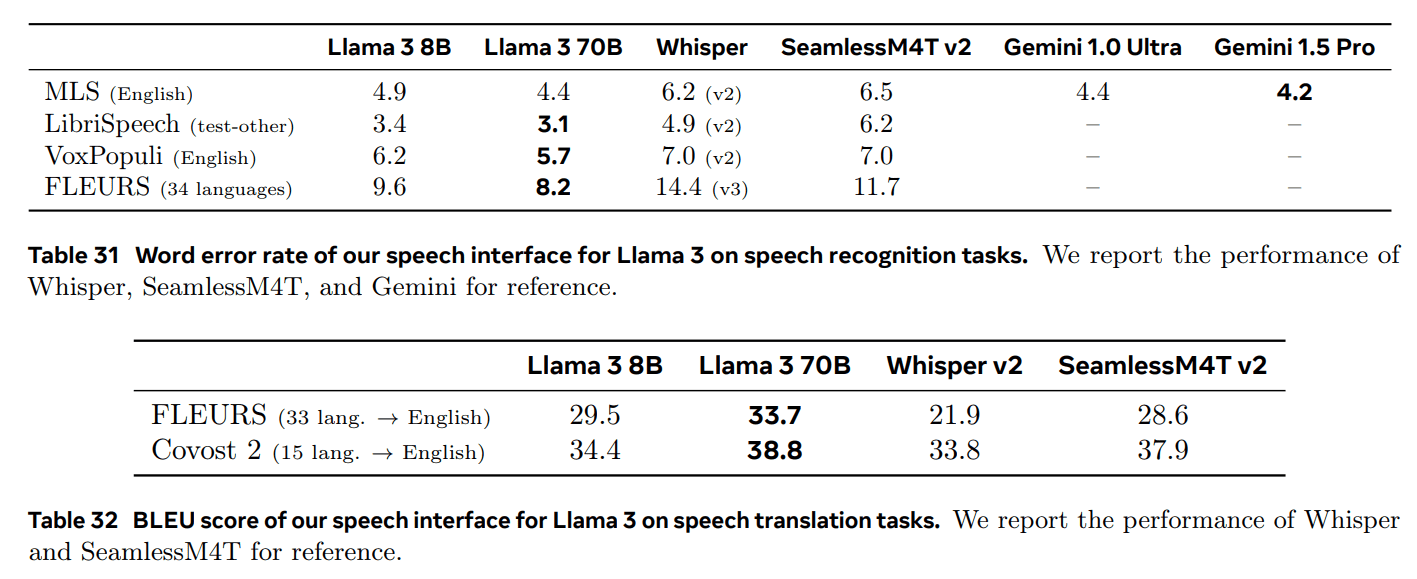

Este artículo presenta un nuevo conjunto de modelos base denominado Llama 3. Llama 3 es una comunidad de modelos lingüísticos que soporta de forma inherente el multilingüismo, la escritura de código, el razonamiento y el uso de herramientas. Nuestro modelo más grande es un transformador denso con 405.000 millones de parámetros y una ventana de contexto de hasta 128.000 tokens. Los resultados muestran que Llama 3 alcanza una calidad comparable a la de los principales modelos lingüísticos, como GPT-4, en muchas tareas. Ponemos a disposición del público Llama 3, que incluye modelos lingüísticos preentrenados y postentrenados de 405.000 millones de parámetros, así como el modelo Llama Guard 3 para la seguridad de entrada-salida. Este artículo también presenta resultados experimentales sobre la integración de características de imagen, vídeo y habla en Llama 3 mediante un enfoque combinatorio. Observamos que este enfoque es competitivo con los enfoques más avanzados para tareas de reconocimiento de imagen, vídeo y habla. Dado que estos modelos están aún en fase de desarrollo, no han sido ampliamente publicados.

Texto completo descargar pdf:

1722344341-Llama_3.1 paper: a versatile, open-source _AI_ model family (versión en chino)

1 Introducción

modelo básicoson modelos generales del lenguaje, la visión, el habla y otras modalidades diseñados para dar soporte a una amplia gama de tareas de IA. Constituyen la base de muchos sistemas modernos de IA.

El desarrollo de un modelo básico moderno se divide en dos etapas principales:

(1) Fase de preentrenamiento. Los modelos se entrenan con cantidades ingentes de datos, mediante tareas sencillas como la predicción de palabras o la generación de anotaciones gráficas;

(2) Fase posterior a la formación. Los modelos se afinan para seguir instrucciones, ajustarse a las preferencias humanas y mejorar capacidades específicas (por ejemplo, codificación y razonamiento).

Este artículo presenta un nuevo conjunto de modelos de base lingüística denominado Llama 3. La familia de modelos Llama 3 Herd soporta intrínsecamente el multilingüismo, la codificación, el razonamiento y el uso de herramientas. Nuestro modelo más grande es un Transformador denso con 405B parámetros, capaz de procesar información en ventanas de contexto de hasta 128K tokens.

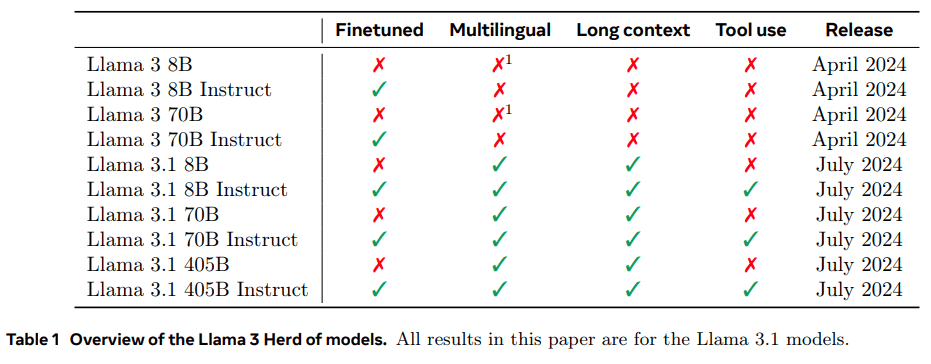

En la Tabla 1 se enumeran todos los miembros del rebaño. Todos los resultados presentados en este documento se basan en el modelo Llama 3.1 (Llama 3 para abreviar).

Creemos que las tres herramientas clave para desarrollar modelos base de alta calidad son los datos, la escala y la gestión de la complejidad. Nos esforzaremos por optimizar estas tres áreas durante nuestro proceso de desarrollo:

- Datos. Tanto la cantidad como la calidad de los datos que utilizamos en el preentrenamiento y el postentrenamiento mejoraron en comparación con las versiones anteriores de Llama (Touvron et al., 2023a, b). Estas mejoras incluyen el desarrollo de tuberías de preprocesamiento y curación más cuidadosas para los datos de preentrenamiento y el desarrollo de una garantía de calidad y un filtrado más rigurosos. de un preprocesamiento y una curación más cuidadosos de los datos de preentrenamiento y el desarrollo de una garantía de calidad y un filtrado más rigurosos. Llama 3 se preentrenó con un corpus de aproximadamente 15T de tokens multilingües, mientras que Llama 2 se preentrenó con 1,8T de tokens.

- Alcance. Hemos entrenado un modelo mayor que el anterior de Llama: nuestro modelo lingüístico estrella utiliza 3,8 × 1025 FLOPs para el preentrenamiento, casi 50 veces más que la versión más grande de Llama 2. En concreto, preentrenamos un modelo insignia con 405B parámetros entrenables en 15,6T tokens de texto. Como era de esperar, el

- Gestión de la complejidad. Las opciones de diseño que elegimos tenían por objeto maximizar la escalabilidad del proceso de desarrollo de modelos. Por ejemplo, elegimos un Transformador (Vaswani et al., 2017) con algunos ajustes menores, en lugar de utilizar un modelo de mezcla experto (Shazeer et al., 2017) para maximizar la estabilidad del entrenamiento. Del mismo modo, empleamos un posprocesador relativamente sencillo basado en el ajuste fino supervisado (SFT), el muestreo de rechazo (RS) y la optimización directa de preferencias (DPO; Rafailov et al. (2023)), en lugar de algoritmos de aprendizaje de refuerzo más complejos (Ouyang et al., 2022; Schulman et al., 2017), que suelen ser menos estables y difíciles de escalar.

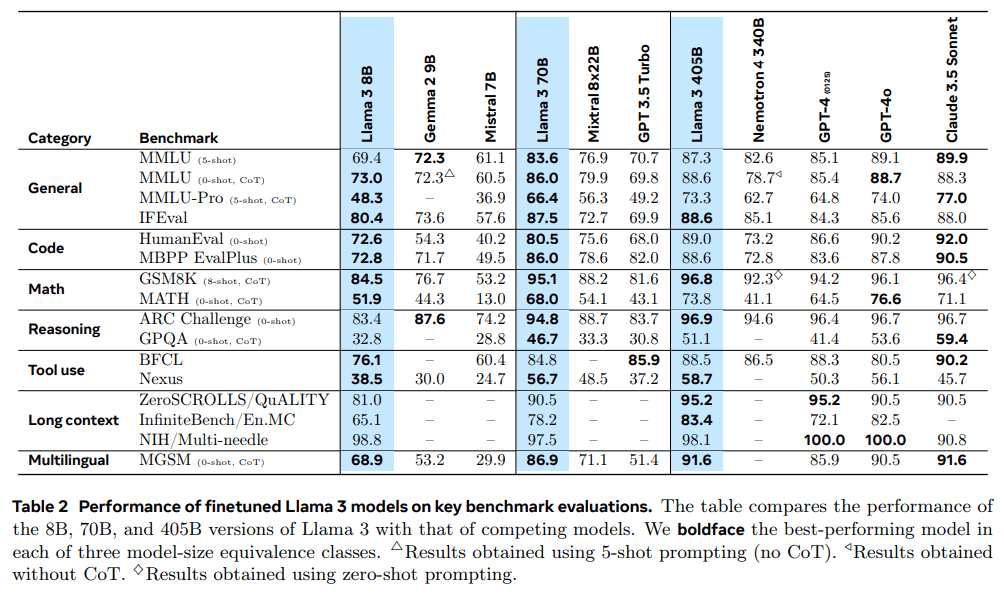

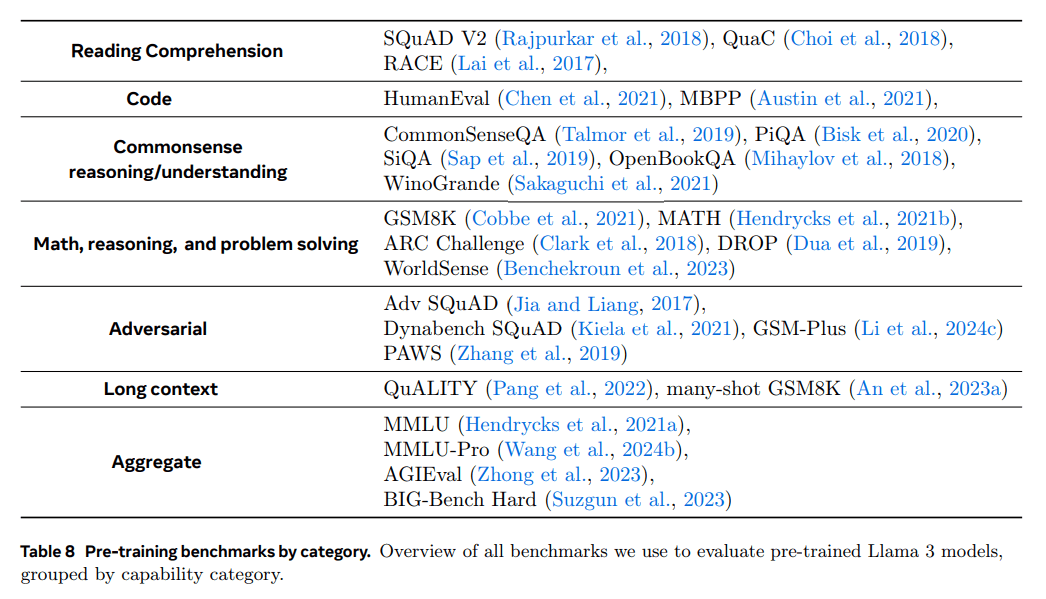

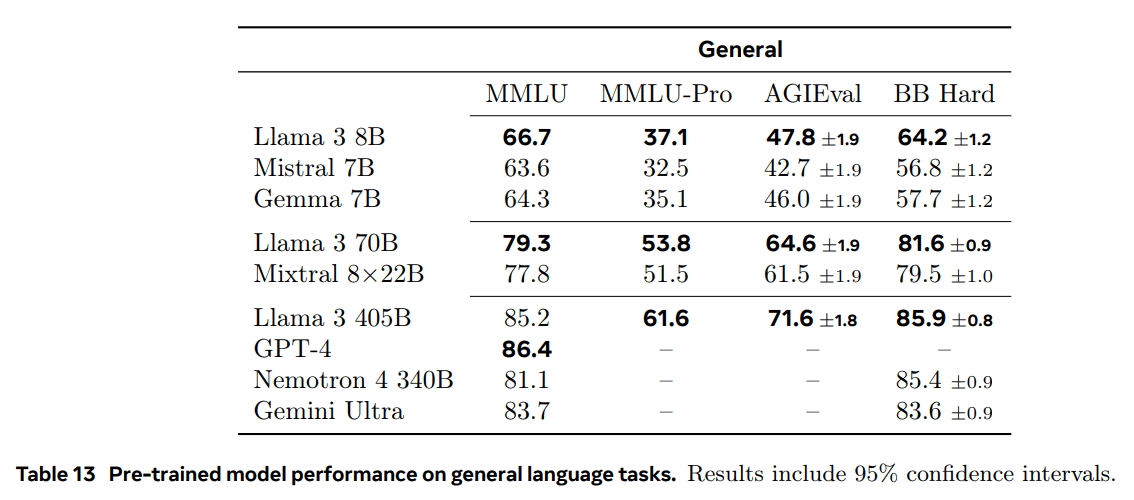

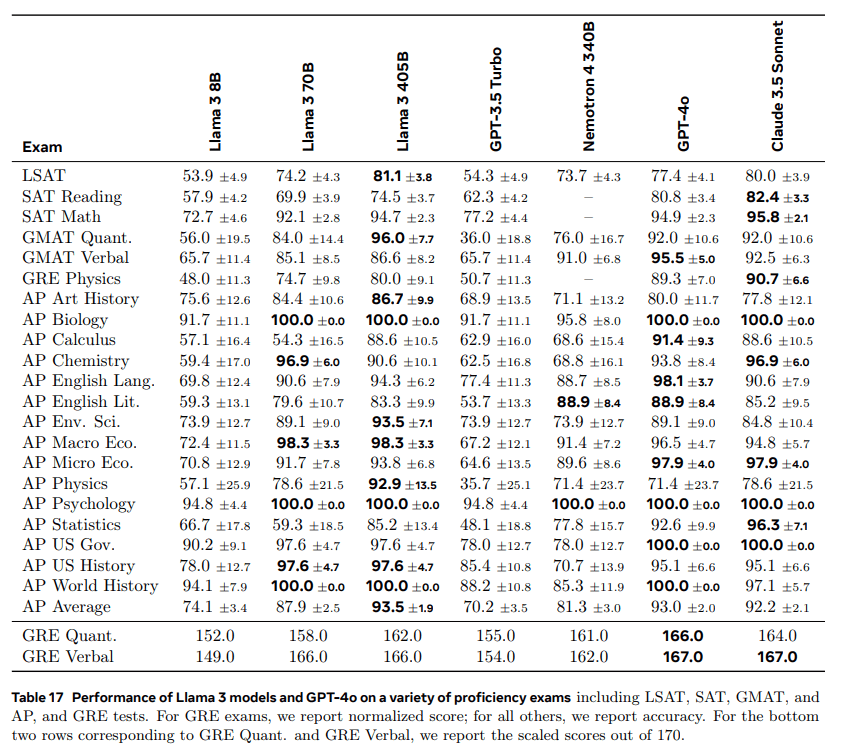

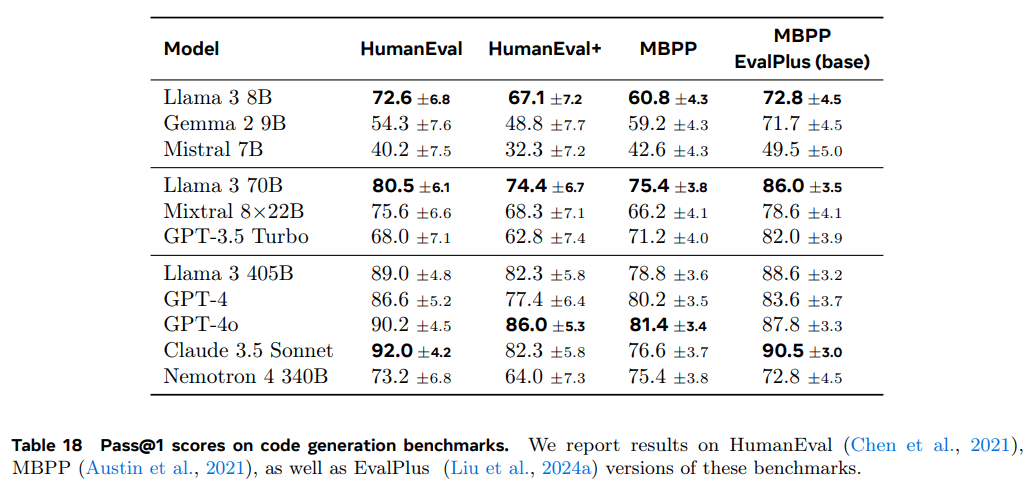

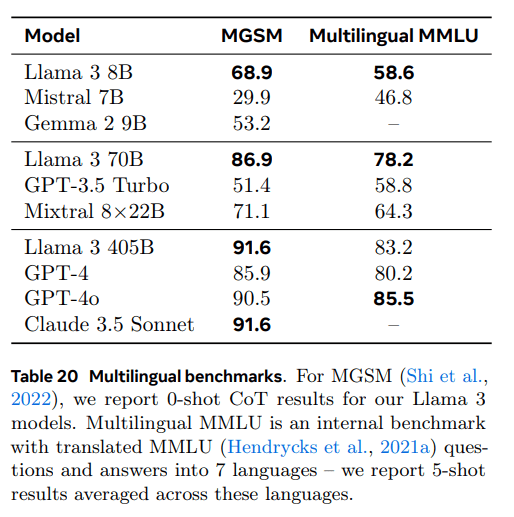

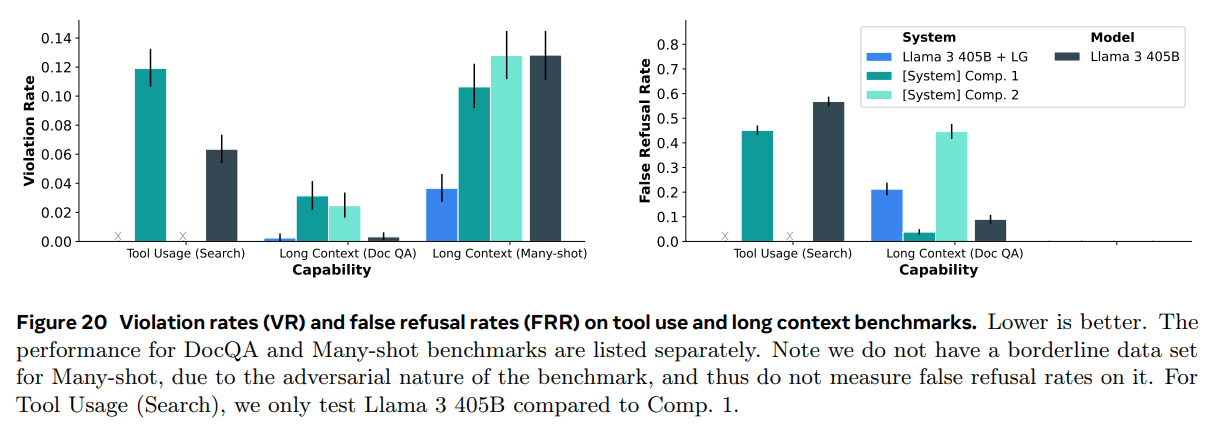

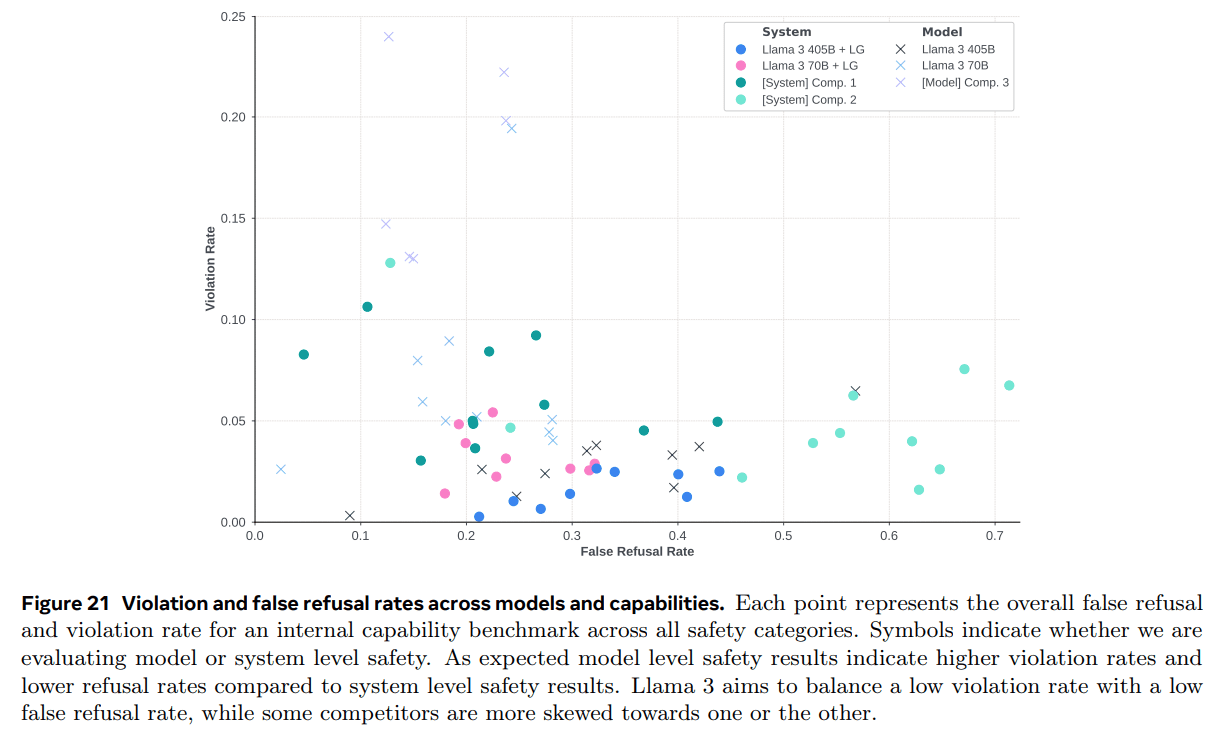

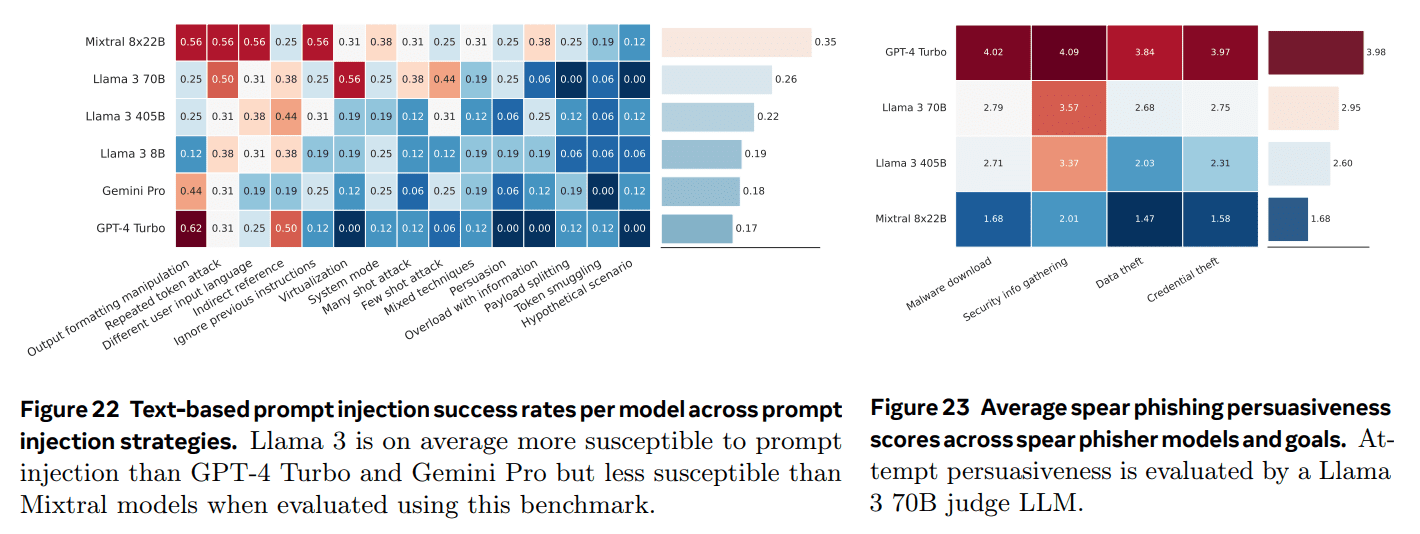

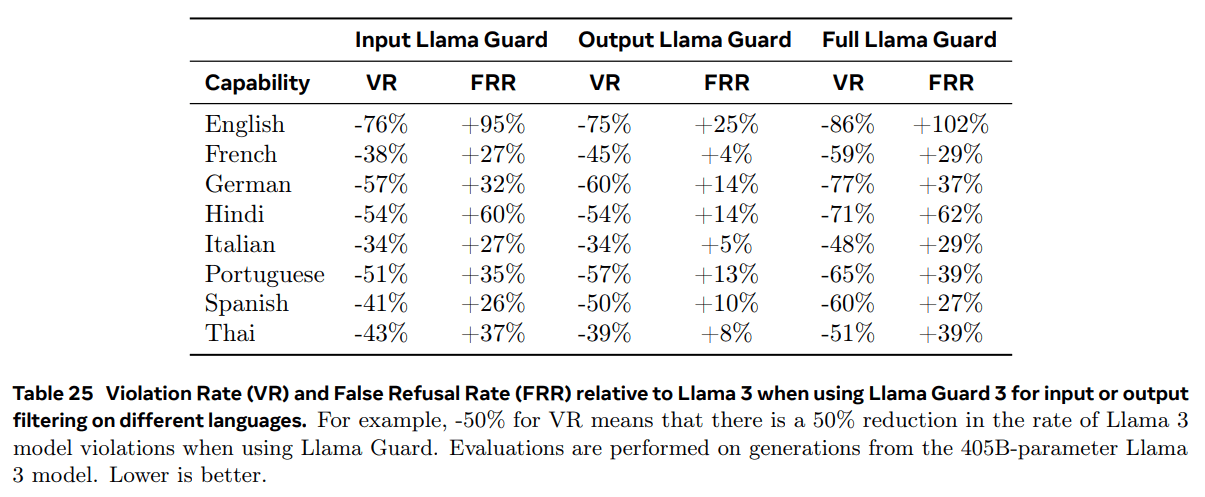

El resultado de nuestro trabajo es Llama 3: un multilingüe trilingüe con parámetros 8B, 70B y 405B.1de modelos lingüísticos. Hemos evaluado el rendimiento de Llama 3 en un gran número de conjuntos de datos de referencia que cubren una amplia gama de tareas de comprensión del lenguaje. Además, realizamos extensas evaluaciones manuales comparando Llama 3 con modelos de la competencia. La Tabla 2 muestra un resumen del rendimiento del modelo insignia Llama 3 en pruebas de referencia clave. Nuestras evaluaciones experimentales muestran que nuestro modelo insignia está a la par con los principales modelos lingüísticos como GPT-4 (OpenAI, 2023a) y cerca del estado de la técnica en una variedad de tareas. Nuestro modelo más pequeño es el mejor de su clase y supera a otros modelos con un número similar de parámetros (Bai et al., 2023; Jiang et al., 2023).Llama 3 también logra un mejor equilibrio entre utilidad e inocuidad que su predecesor (Touvron et al., 2023b). Analizamos la seguridad de Llama 3 en detalle en la sección 5.4.

Estamos publicando los tres modelos de Llama 3 bajo una versión actualizada de la Licencia Comunitaria de Llama 3; véase https://llama.meta.com. Esto incluye versiones pre-entrenadas y post-procesadas de nuestro modelo paramétrico de lenguaje 405B, así como una nueva versión del modelo Llama Guard (Inan et al., 2023) para la seguridad de entrada y salida. de entrada y salida. Esperamos que el lanzamiento público de un modelo emblemático inspire una ola de innovación en la comunidad investigadora y acelere el progreso hacia el desarrollo responsable de la Inteligencia Artificial (AGI).

Multilingüe: se refiere a la capacidad del modelo para comprender y generar texto en varios idiomas.

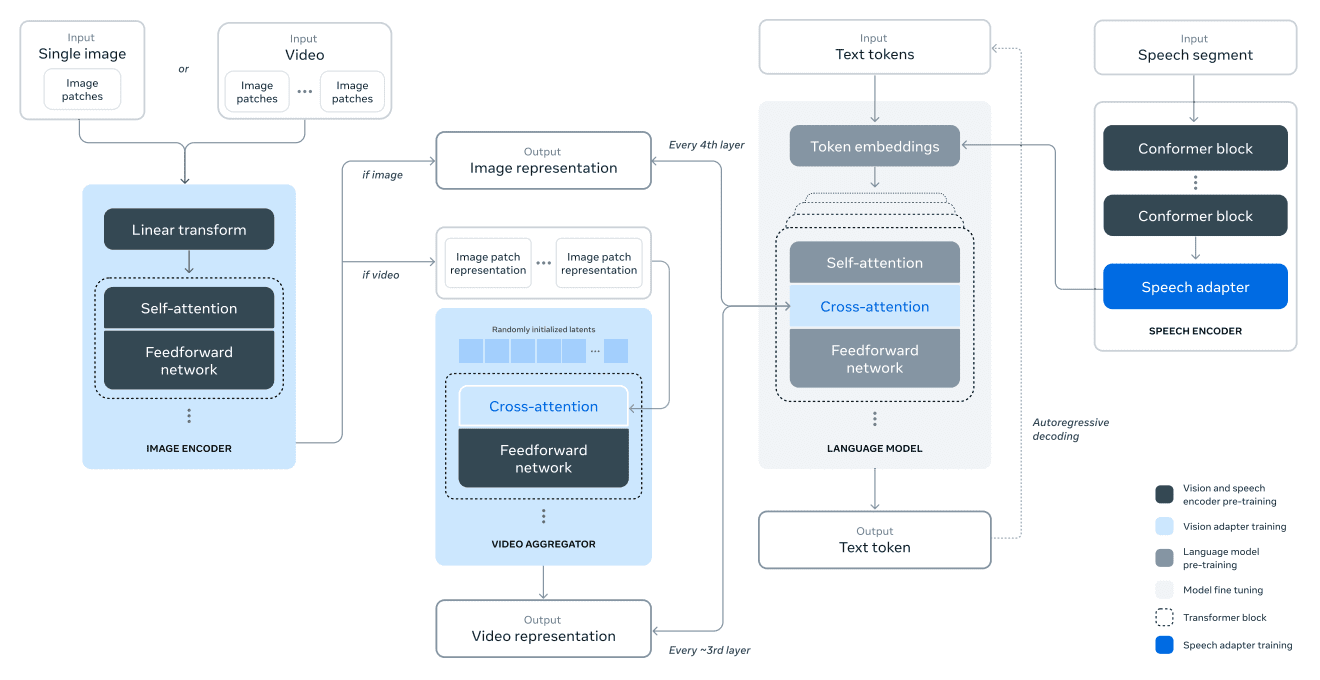

Durante el desarrollo de Llama 3, también hemos desarrollado extensiones multimodales del modelo para permitir el reconocimiento de imágenes, el reconocimiento de vídeo y la comprensión del habla. Estos modelos siguen en desarrollo y aún no están listos para su publicación. Además de los resultados de nuestro modelo lingüístico, este artículo presenta los resultados de nuestros experimentos iniciales con estos modelos multimodales.

Llama 3 8B y 70B se preentrenaron con datos multilingües, pero en aquel momento se utilizaban principalmente para el inglés.

2 Generalidades

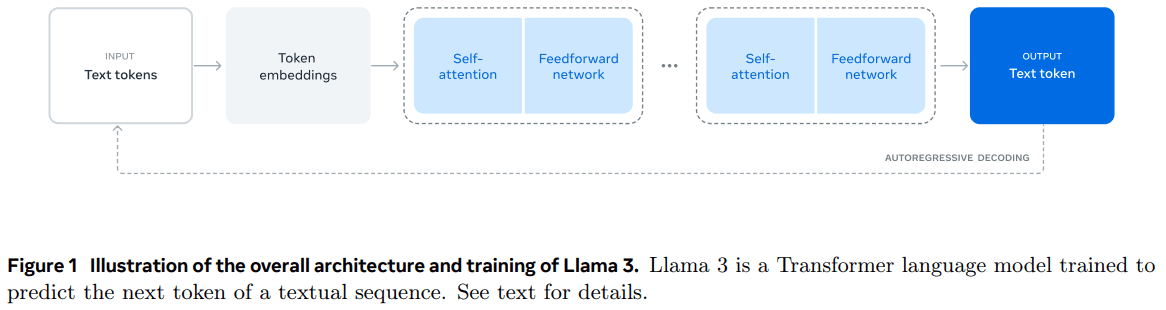

La arquitectura del modelo Llama 3 se muestra en la Figura 1. El desarrollo de nuestro modelo lingüístico Llama 3 se divide en dos fases principales:

- Preformación del modelo lingüístico.En primer lugar, convertimos un gran corpus de texto multilingüe en tokens discretos y preentrenamos un Modelo de Gran Lenguaje (LLM) en los datos resultantes para la siguiente predicción de tokens. En la fase de preentrenamiento del LLM, el modelo aprende la estructura de la lengua y adquiere una gran cantidad de conocimientos sobre el mundo a partir del texto que "lee". Para hacerlo de forma eficiente, el preentrenamiento se realiza a escala: preentrenamos un modelo con 405B parámetros en un modelo con 15,6T tokens, utilizando una ventana de contexto de 8K tokens. A esta fase de preentrenamiento estándar le sigue una fase de preentrenamiento continuado, que aumenta la ventana de contexto admitida a 128.000 tokens. Para más información, véase la sección 3.

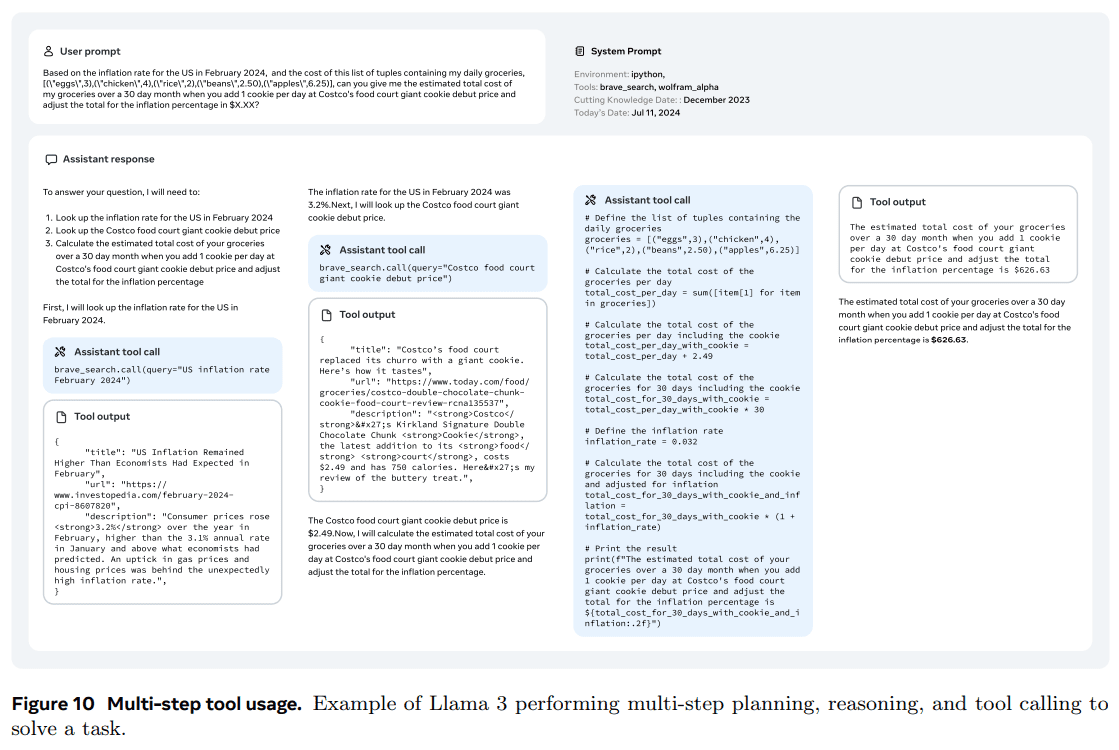

- Formación postmodelo.El modelo lingüístico preentrenado tiene un conocimiento profundo de la lengua, pero aún no ha seguido instrucciones ni se ha comportado como el asistente que esperamos que lo haga. Calibramos el modelo mediante comentarios humanos en varias rondas, cada una de las cuales incluía el ajuste fino supervisado (SFT) y la optimización directa de preferencias (DPO; Rafailov et al., 2024) sobre datos ajustados a las instrucciones. En esta fase de post-entrenamiento, también integramos nuevas características, como el uso de herramientas, y observamos mejoras significativas en áreas como la codificación y la inferencia. Para más información, véase la sección 4. Por último, en la fase de post-entrenamiento también se integran mitigaciones de seguridad en el modelo, cuyos detalles se describen en la Sección 5.4. Los modelos generados son muy funcionales. Son capaces de responder a preguntas en al menos ocho lenguajes, escribir código de alta calidad, resolver problemas de inferencia complejos y utilizar herramientas listas para usar o de forma cero-muestra.

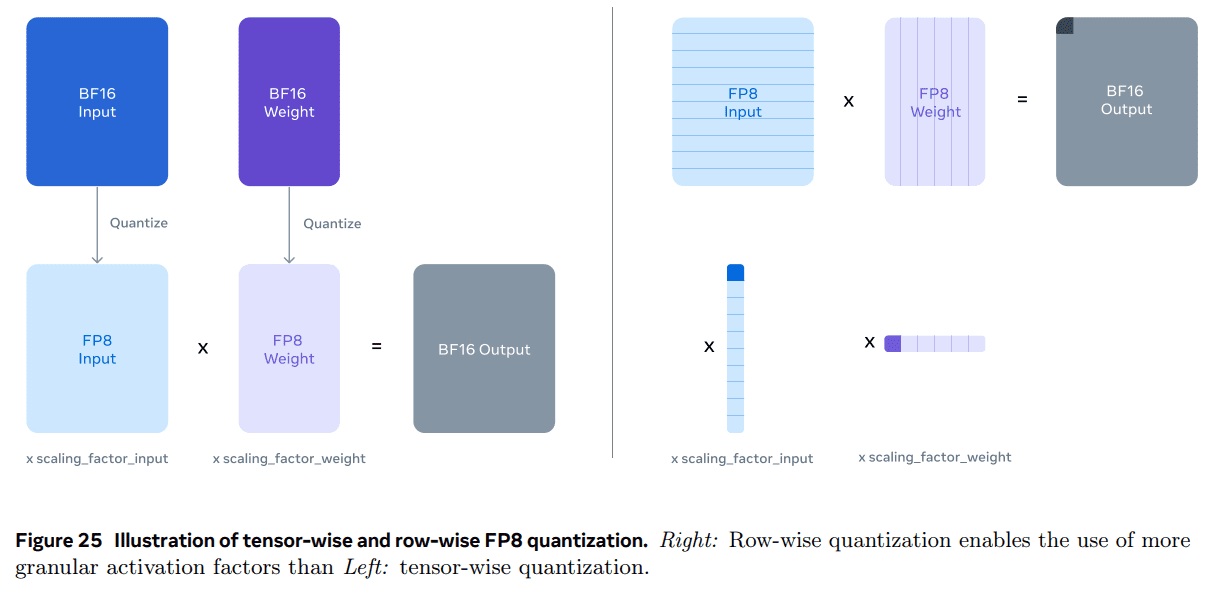

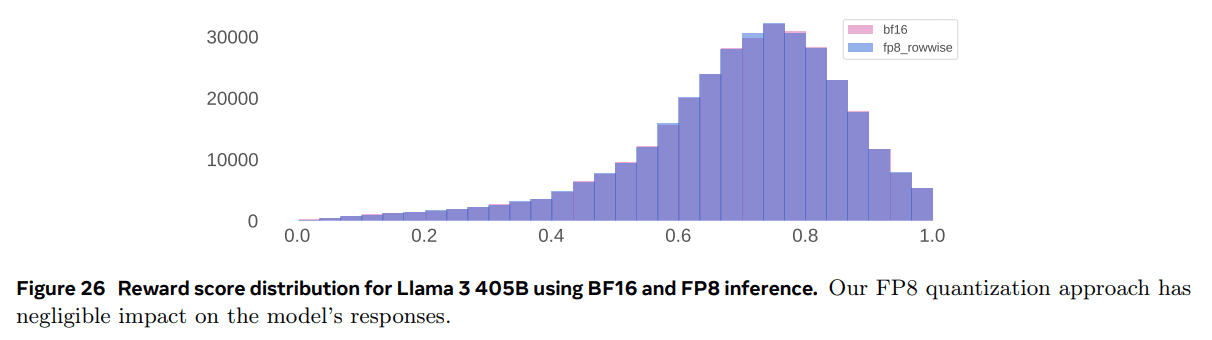

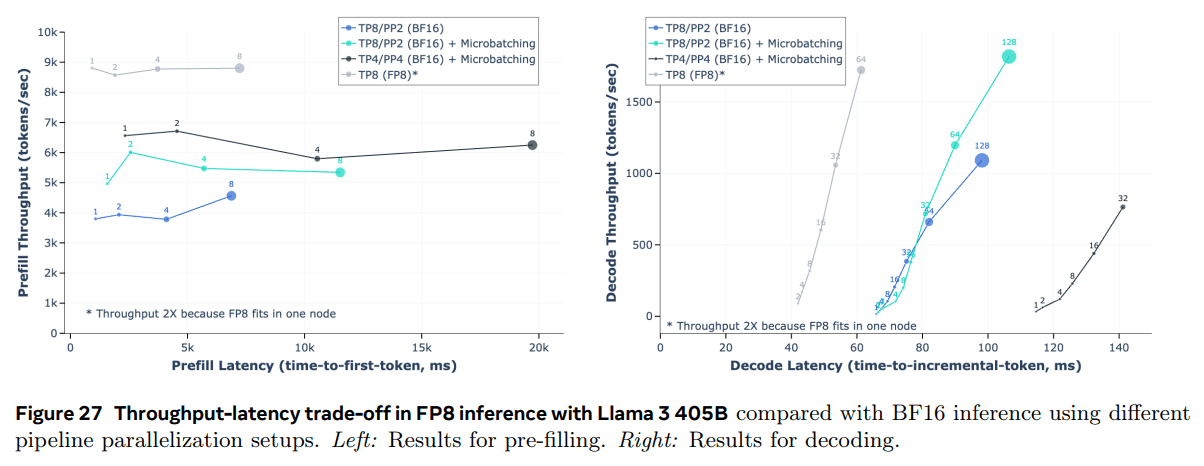

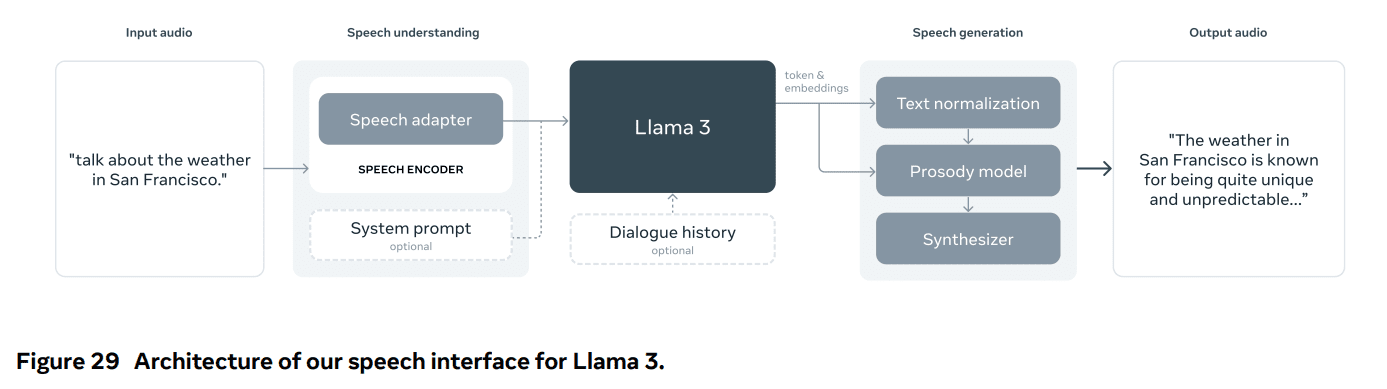

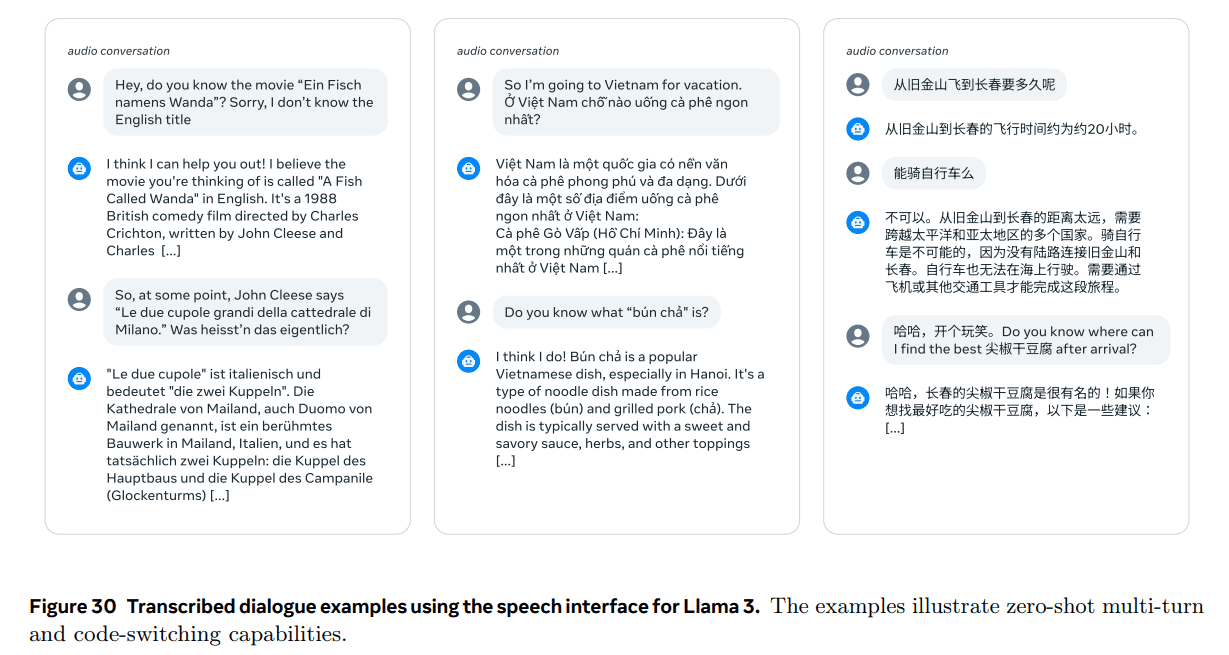

También realizamos experimentos para añadir capacidades de imagen, vídeo y voz a Llama 3 mediante un enfoque combinado. El enfoque que investigamos consta de tres fases adicionales que se muestran en la Figura 28:

- Preentrenamiento del codificador multimodal.Entrenamos codificadores distintos para la imagen y el habla. Entrenamos el codificador de imágenes con un gran número de pares imagen-texto. Esto permite al modelo aprender la relación entre el contenido visual y su descripción en lenguaje natural. Nuestro codificador de voz utiliza un método autosupervisado que enmascara una parte de la entrada de voz e intenta reconstruir la parte enmascarada mediante una representación discreta de marcadores. Así, el modelo aprende la estructura de la señal del habla. Para más información sobre los codificadores de imagen, véase la sección 7; para más información sobre los codificadores de voz, véase la sección 8.

- Formación de adaptadores visuales.Entrenamos un adaptador que integra un codificador de imágenes preentrenado con un modelo de lenguaje preentrenado. El adaptador consta de una serie de capas de atención cruzada que introducen la representación del codificador de imágenes en el modelo lingüístico. El adaptador se entrena con pares texto-imagen, lo que alinea la representación de la imagen con la del lenguaje. Durante el entrenamiento del adaptador, también actualizamos los parámetros del codificador de imágenes, pero intencionadamente no actualizamos los parámetros del modelo lingüístico. También entrenamos un adaptador de vídeo sobre el adaptador de imagen, utilizando datos emparejados de vídeo-texto. Esto permite al modelo agregar información entre fotogramas. Para más información, véase la sección 7.

- Por último, integramos el codificador del habla en el modelo mediante un adaptador que convierte la codificación del habla en una representación etiquetada que puede introducirse directamente en el modelo lingüístico ajustado. Durante la fase de ajuste supervisado, los parámetros del adaptador y del codificador se actualizan conjuntamente para lograr una comprensión del habla de alta calidad. No modificamos el modelo lingüístico durante el entrenamiento del adaptador de voz. También integramos un sistema de conversión de texto en voz. Para más detalles, véase la sección 8.

Nuestros experimentos multimodales han dado lugar a modelos que reconocen el contenido de imágenes y vídeos y admiten la interacción a través de una interfaz de voz. Estos modelos siguen en fase de desarrollo y aún no están listos para su lanzamiento.

3 Formación previa

El preentrenamiento de modelos lingüísticos implica los siguientes aspectos:

(1) Recopilación y filtrado de corpus de formación a gran escala;

(2) Desarrollo de arquitecturas de modelos y de las correspondientes leyes de escala para determinar el tamaño de los modelos;

(3) Desarrollo de técnicas para un preentrenamiento eficaz a gran escala;

(4) Desarrollo de un programa de formación previa. A continuación describiremos cada uno de estos componentes.

3.1 Datos de preentrenamiento

Creamos conjuntos de datos de preentrenamiento de modelos lingüísticos a partir de varias fuentes de datos que contienen conocimientos hasta finales de 2023. Aplicamos varios métodos de desduplicación y mecanismos de limpieza de datos a cada fuente de datos para obtener un etiquetado de alta calidad. Eliminamos los dominios que contenían grandes cantidades de información personal identificable (IPI), así como los dominios con contenido para adultos.

3.11 Depuración de datos web

La mayoría de los datos que utilizamos proceden de Internet, y a continuación describimos nuestro proceso de limpieza.

PII y filtrado de seguridad. Entre otras medidas, hemos implantado filtros diseñados para eliminar datos de sitios web que puedan contener contenidos inseguros o grandes cantidades de IPI, dominios clasificados como dañinos según diversas normas de seguridad de Meta y dominios conocidos por contener contenido para adultos.

Extracción y limpieza de textos. Procesamos el contenido HTML en bruto para extraer texto diverso y de alta calidad, y para ello utilizamos documentos web no truncados. Para ello, creamos un analizador sintáctico personalizado que extrae el contenido HTML y optimiza la precisión de la eliminación de plantillas y la recuperación de contenido. Hemos evaluado manualmente la calidad del analizador y lo hemos comparado con analizadores HTML de terceros optimizados para el contenido de artículos similares, y hemos comprobado que funciona bien. Tenemos cuidado con las páginas HTML que contienen contenido matemático y código para preservar la estructura de ese contenido. Conservamos el texto del atributo alt de la imagen porque el contenido matemático suele representarse como una imagen pre-renderizada en la que las matemáticas también se proporcionan en el atributo alt.

Descubrimos que Markdown era perjudicial para el rendimiento del modelo, que se había entrenado principalmente con datos web, en comparación con el texto sin formato, por lo que eliminamos todas las etiquetas Markdown.

Sin énfasis. Aplicamos múltiples rondas de desduplicación a nivel de URL, documento y línea:

- Desduplicación a nivel de URL. Realizamos la desduplicación a nivel de URL en todo el conjunto de datos. Para cada página correspondiente a una URL, conservamos la última versión.

- Desduplicación a nivel de documento. Realizamos una desduplicación global MinHash (Broder, 1997) en todo el conjunto de datos para eliminar los documentos casi duplicados.

- Desduplicación a nivel de fila. Realizamos una de-duplicación a nivel radical similar a ccNet (Wenzek et al., 2019). Eliminamos las filas que aparecen más de 6 veces en cada grupo que contiene 30 millones de documentos.

Aunque nuestros análisis cualitativos manuales sugieren que la deduplicación a nivel de línea elimina no sólo el contenido repetitivo residual de una variedad de sitios (por ejemplo, menús de navegación, advertencias sobre cookies), sino también texto frecuente de alta calidad, nuestras evaluaciones empíricas muestran mejoras significativas.

Filtrado heurístico. Se desarrollaron heurísticas para eliminar los documentos adicionales de baja calidad, los valores atípicos y los documentos con demasiadas repeticiones. Algunos ejemplos de heurísticas son:

- Utilizamos la cobertura de n-tuplas duplicadas (Rae et al., 2021) para eliminar las filas con contenido duplicado (por ejemplo, registros o mensajes de error). Estas filas pueden ser muy largas y únicas, por lo que no pueden filtrarse mediante la eliminación de duplicados de filas.

- Utilizamos un recuento de "palabras sucias" (Raffel et al., 2020) para filtrar los sitios para adultos que no están incluidos en la lista negra de dominios.

- Utilizamos la dispersión de Kullback-Leibler de la distribución de tokens para filtrar los documentos que contienen demasiados tokens anómalos en comparación con la distribución del corpus de entrenamiento.

Filtrado de calidad basado en modelos.

Además, hemos intentado utilizar varios clasificadores de calidad basados en modelos para seleccionar etiquetas de alta calidad. Estos métodos incluyen:

- Utilizando clasificadores rápidos como fasttext (Joulin et al., 2017), que están entrenados para reconocer si un texto dado será citado por Wikipedia (Touvron et al., 2023a).

- Se utilizó un clasificador modelo Roberta (Liu et al., 2019a) más intensivo computacionalmente, que se entrenó con las predicciones de Llama 2.

Para entrenar el clasificador de calidad basado en Llama 2, creamos un conjunto de documentos web limpios que describían los requisitos de calidad e instruimos al modelo de chat de Llama 2 para determinar si los documentos cumplían con estos requisitos. Para mayor eficiencia, utilizamos DistilRoberta (Sanh et al., 2019) para generar puntuaciones de calidad para cada documento. Evaluaremos experimentalmente la eficacia de varias configuraciones de filtrado de calidad.

Código y datos de inferencia.

De forma similar a DeepSeek-AI et al. (2024), construimos pipelines específicos de dominio para extraer páginas web que contienen código y páginas web relacionadas con las matemáticas. Específicamente, tanto los clasificadores de código como los de inferencia son modelos DistilledRoberta entrenados utilizando datos web anotados de Llama 2. A diferencia de los clasificadores de calidad genéricos mencionados anteriormente, realizamos un ajuste de pistas para dirigirnos a páginas web que contienen inferencias matemáticas, razonamiento en dominios STEM y código incrustado en lenguaje natural. Dado que las distribuciones de tokens del código y las matemáticas son muy diferentes de las del lenguaje natural, estas líneas implementan la extracción de HTML específica del dominio, características de texto personalizadas y heurística para el filtrado.

Datos multilingües.

Al igual que en el procesamiento de textos en inglés descrito anteriormente, aplicamos filtros para eliminar datos de sitios web que puedan contener información personal identificable (IPI) o contenidos inseguros. Nuestra línea de procesamiento de texto multilingüe presenta las siguientes características exclusivas:

- Utilizamos un modelo rápido de reconocimiento lingüístico basado en el texto para clasificar los documentos en 176 idiomas.

- Para cada idioma, realizamos una desduplicación de los datos a nivel de documento y a nivel de fila.

- Aplicamos una heurística específica para cada lengua y filtros basados en modelos para eliminar los documentos de baja calidad.

Además, utilizamos un clasificador multilingüe basado en Llama 2 para clasificar la calidad de los documentos multilingües y garantizar que se da prioridad a los contenidos de alta calidad. El número de tokens multilingües que utilizamos en el preentrenamiento se determina experimentalmente, y el rendimiento del modelo se equilibra en pruebas de referencia en inglés y multilingües.

3.12 Determinar la combinación de datos

为了获得高质量语言模型,必须谨慎确定预训练数据混合中不同数据源的比例。我们主要利用知识分类和尺度定律实验来确定这一数据混合。

知识分类。我们开发了一个分类器,用于对网页数据中包含的信息类型进行分类,以便更有效地确定数据组合。我们使用这个分类器对网页上过度代表的数据类别(例如艺术和娱乐)进行下采样。

为了确定最佳数据混合方案。我们进行规模定律实验,其中我们将多个小型模型训练于特定数据混合集上,并利用其预测大型模型在该混合集上的性能(参见第 3.2.1 节)。我们多次重复此过程,针对不同的数据混合集选择新的候选数据混合集。随后,我们在该候选数据混合集上训练一个更大的模型,并在多个关键基准测试上评估该模型的性能。

数据混合摘要。我们的最终数据混合包含大约 50% 的通用知识标记、25% 的数学和推理标记、17% 的代码标记以及 8% 的多语言标记。

3.13 Datos de recocido

Los resultados empíricos muestran que el recocido en una pequeña cantidad de datos de código y matemáticas de alta calidad (véase la sección 3.4.3) puede mejorar el rendimiento de los modelos preentrenados en pruebas de referencia clave. Al igual que en el estudio de Li et al. (2024b), recocemos utilizando un conjunto de datos mixto que contiene datos de alta calidad de dominios seleccionados. Nuestros datos recocidos no contienen ningún conjunto de entrenamiento de pruebas de referencia comúnmente utilizadas. Esto nos permite evaluar la verdadera capacidad de aprendizaje de pocas muestras y la generalización fuera del dominio de Llama 3.

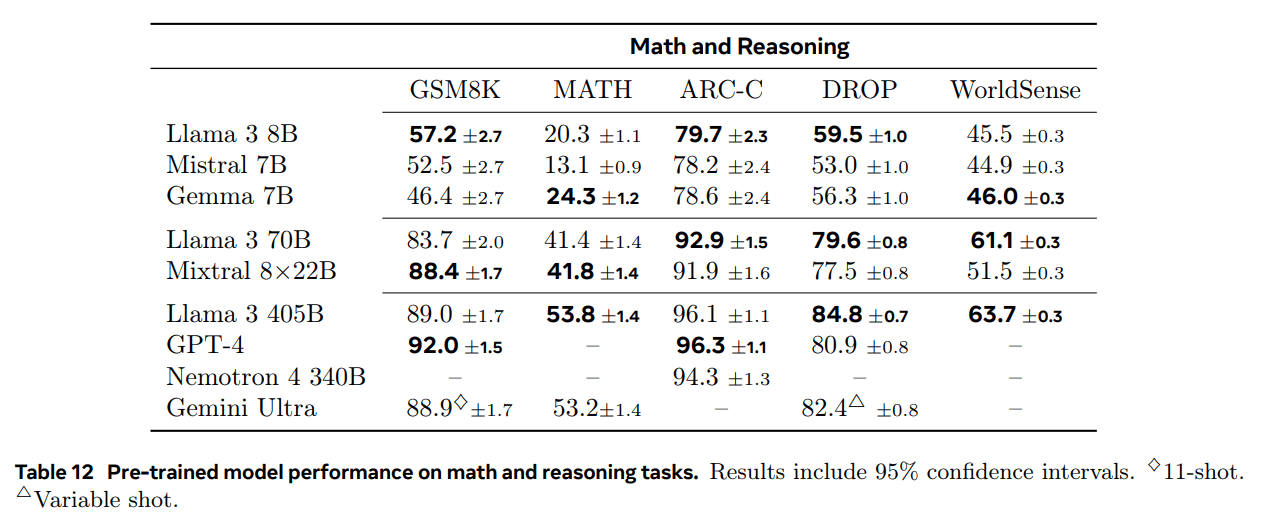

Siguiendo a OpenAI (2023a), evaluamos el efecto del recocido en los conjuntos de entrenamiento GSM8k (Cobbe et al., 2021) y MATH (Hendrycks et al., 2021b). Encontramos que el recocido mejora el rendimiento del modelo Llama 3 8B preentrenado en 24,0% y 6,4% en los conjuntos de validación GSM8k y MATH, respectivamente. Sin embargo, la mejora es insignificante para el modelo 405B, lo que sugiere que nuestro modelo insignia tiene fuertes capacidades de aprendizaje e inferencia contextual, y que no requiere muestras de entrenamiento específicas del dominio para lograr un rendimiento fuerte.

Utilice el recocido para evaluar la calidad de los datos.Al igual que Blakeney et al. (2024), encontramos que el recocido nos permite juzgar el valor de pequeños conjuntos de datos de dominios específicos. Medimos el valor de estos conjuntos de datos templando linealmente la tasa de aprendizaje del modelo Llama 3 8B, que ha sido entrenado con 50%, a 0 sobre 40.000 millones de tokens. En estos experimentos, asignamos ponderaciones 30% al nuevo conjunto de datos y las restantes 70% a la mezcla de datos por defecto. Es más eficiente utilizar el recocido para evaluar nuevas fuentes de datos que realizar experimentos de ley de escala en cada conjunto de datos pequeño.

3.2 Arquitectura del modelo

Llama 3 utiliza la arquitectura dense Transformer estándar (Vaswani et al., 2017). La arquitectura de su modelo no difiere significativamente de Llama y Llama 2 (Touvron et al., 2023a, b); nuestro aumento del rendimiento se debe principalmente a mejoras en la calidad y la diversidad de los datos, así como al aumento del tamaño del entrenamiento.

Hicimos un par de modificaciones menores:

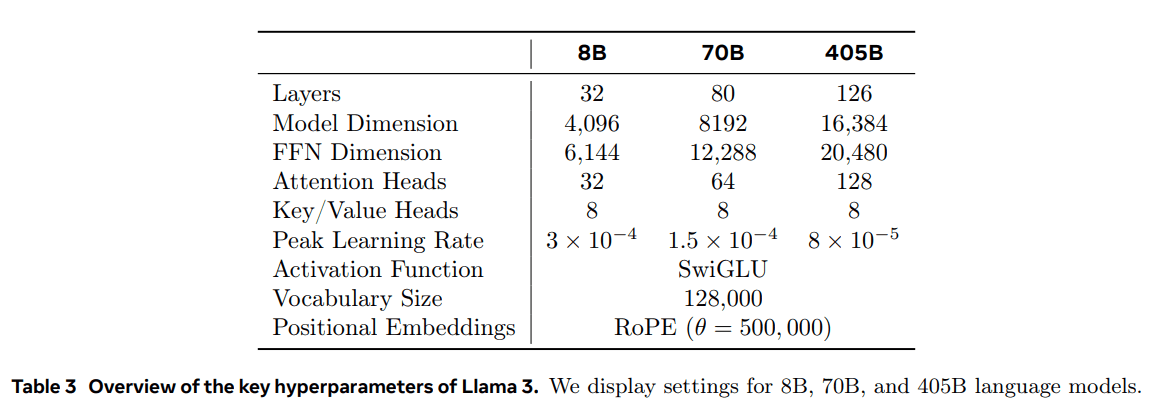

- Utilizamos Grouped Query Attention (GQA; Ainslie et al. (2023)), donde se utilizan 8 cabeceras de valores clave para aumentar la velocidad de inferencia y reducir el tamaño de la caché de valores clave durante la descodificación.

- Utilizamos una máscara de atención para evitar mecanismos de autoatención entre distintos documentos de la secuencia. Comprobamos que este cambio tiene un impacto limitado durante el preentrenamiento estándar, pero es importante durante el preentrenamiento continuo de secuencias muy largas.

- Utilizamos un vocabulario de 128.000 tokens. Nuestro vocabulario tokenizado combina los 100.000 tokens del vocabulario tiktoken3 con 28.000 tokens adicionales para soportar mejor las lenguas no inglesas. En comparación con el vocabulario de Llama 2, nuestro nuevo vocabulario mejora la compresión de las muestras de datos en inglés de 3,17 a 3,94 caracteres/token. Esto permite al modelo "leer" más texto con la misma cantidad de cálculo de entrenamiento. También hemos comprobado que la adición de 28.000 tokens de lenguas no inglesas específicas mejora la compresión y el rendimiento posterior, pero no afecta a la tokenización en inglés.

- Aumentamos el hiperparámetro de frecuencia base RoPE a 500.000. Esto nos permite soportar mejor contextos más largos; Xiong et al. (2023) muestran que este valor es válido para longitudes de contexto de hasta 32.768.

La Llama 3 405B utiliza una arquitectura con 126 capas, 16.384 dimensiones de representación de marcadores y 128 cabezas de atención; para más información, véase la Tabla 3. Esto da como resultado un tamaño de modelo que es aproximadamente óptimo desde el punto de vista computacional según nuestros datos y un presupuesto de entrenamiento de 3,8 × 10^25 FLOPs.

3.2.1 Leyes de escala

Utilizamos las leyes de escalado (Hoffmann et al., 2022; Kaplan et al., 2020) para determinar el tamaño óptimo del modelo insignia teniendo en cuenta nuestro presupuesto computacional previo al entrenamiento. Además de determinar el tamaño óptimo del modelo, la predicción del rendimiento del modelo insignia en tareas de referencia posteriores presenta retos importantes por las siguientes razones:

- Las leyes de escalado existentes suelen predecir sólo la pérdida de predicción de la siguiente marca, no un rendimiento de referencia específico.

- Las leyes de escalado pueden ser ruidosas y poco fiables porque se desarrollan a partir de ejecuciones de preentrenamiento con un presupuesto computacional reducido (Wei et al., 2022b).

Para hacer frente a estos retos, aplicamos un enfoque en dos fases para desarrollar leyes de escalado que predijeran con precisión el rendimiento de las pruebas comparativas posteriores:

- Primero establecemos la correlación entre los FLOPs de preentrenamiento y el cálculo de la log-verosimilitud negativa del mejor modelo en la tarea descendente.

- A continuación, correlacionamos la log-verosimilitud negativa en la tarea descendente con la precisión de la tarea utilizando el modelo de Leyes de Escalado y un modelo más antiguo previamente entrenado utilizando FLOPs computacionales más altos. En este paso, utilizamos exclusivamente la familia de modelos Llama 2.

Este enfoque nos permite predecir el rendimiento de la tarea posterior (para modelos óptimos desde el punto de vista computacional) basándonos en un número específico de FLOPs preentrenados. Utilizamos un enfoque similar para seleccionar nuestra combinación de datos de preentrenamiento (véase la sección 3.4).

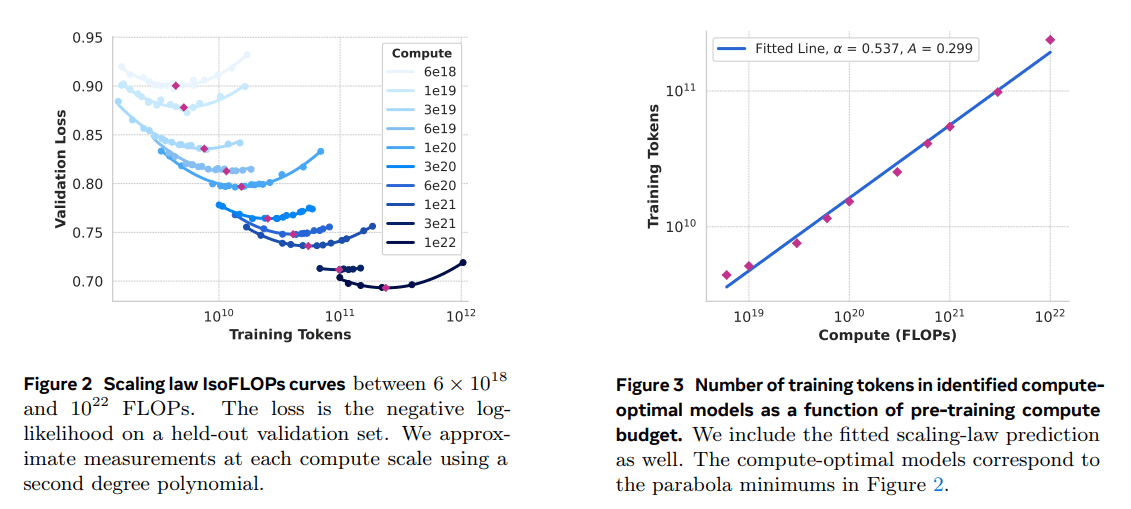

Escala Experimento de Derecho.En concreto, construimos leyes de escalado preentrenando modelos con presupuestos computacionales entre 6 × 10^18 FLOPs y 10^22 FLOPs. En cada presupuesto computacional, preentrenamos modelos con tamaños entre 40M y 16B parámetros y utilizamos una fracción del tamaño del modelo en cada presupuesto computacional. En estas ejecuciones de entrenamiento, utilizamos la programación de la tasa de aprendizaje coseno y el calentamiento lineal en 2.000 pasos de entrenamiento. La tasa de aprendizaje máxima se fijó entre 2 × 10^-4 y 4 × 10^-4 en función del tamaño del modelo. La caída del coseno se fijó en 0,1 veces el valor máximo. La caída del peso de cada paso se fijó en 0,1 veces la tasa de aprendizaje de ese paso. Utilizamos un tamaño de lote fijo para cada tamaño computacional, que oscilaba entre 250K y 4M.

Estos experimentos produjeron las curvas IsoFLOPs de la Figura 2. Las pérdidas de estas curvas se midieron en conjuntos de validación independientes. Ajustamos los valores de pérdida medidos utilizando un polinomio de segundo orden y determinamos el valor mínimo de cada parábola. Nos referimos al mínimo de la parábola como el modelo computacionalmente óptimo bajo el correspondiente presupuesto computacional preentrenado.

Utilizamos modelos computacionalmente óptimos identificados de este modo para predecir el número óptimo de fichas de entrenamiento para un presupuesto computacional determinado. Para ello, asumimos una relación de ley de potencia entre el presupuesto computacional C y el número óptimo de tokens de entrenamiento N (C):

N (C) = AC α .

Ajustamos A y α utilizando los datos de la Fig. 2. Encontramos (α, A) = (0,53, 0,29); el ajuste correspondiente se muestra en la Fig. 3. Extrapolando la ley de escala resultante a 3,8 × 10 25 FLOPs, se sugiere entrenar el modelo con 402B parámetros y utilizar 16,55T de fichas. La extrapolación de la ley de escala resultante a 3,8 × 10 25 FLOPs sugiere entrenar un modelo con 402B parámetros y utilizar 16,55T tokens.

Una observación importante es que la curva de IsoFLOPs se hace más plana alrededor del mínimo a medida que aumenta el presupuesto computacional. Esto implica que el rendimiento del modelo insignia es relativamente estable frente a pequeñas variaciones en el equilibrio entre el tamaño del modelo y los marcadores de entrenamiento. Basándonos en esta observación, finalmente decidimos entrenar un modelo insignia que contiene el parámetro 405B.

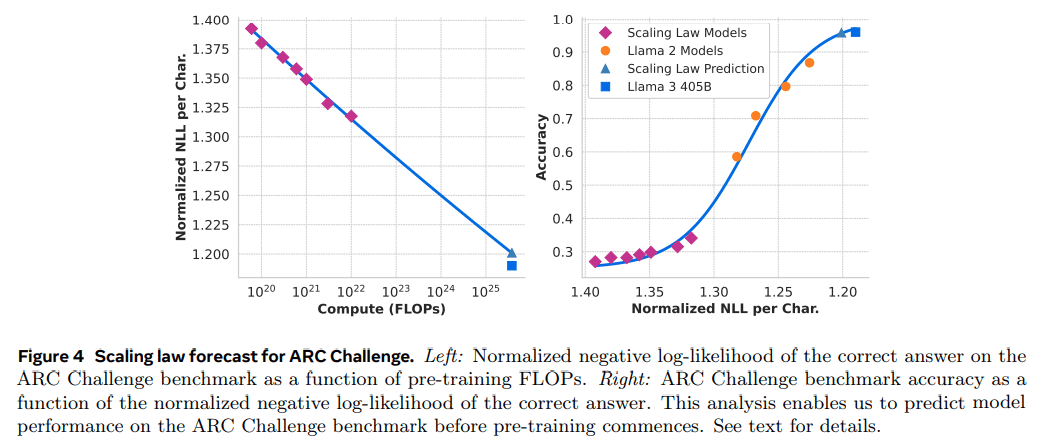

Predicción del rendimiento en tareas posteriores.Utilizamos el modelo computacionalmente óptimo generado para predecir el rendimiento del modelo insignia Llama 3 en el conjunto de datos de referencia. En primer lugar, relacionamos linealmente la log-verosimilitud negativa (normalizada) de la respuesta correcta en la prueba de referencia con los FLOPs de entrenamiento. Para este análisis, utilizamos únicamente el modelo de ley de escala entrenado hasta 10^22 FLOPs en la mezcla de datos anterior. A continuación, establecimos una relación en forma de S entre la verosimilitud logarítmica y la precisión utilizando el modelo de ley de escala y el modelo Llama 2, que se entrenó utilizando la mezcla de datos y el etiquetador Llama 2. (Mostramos los resultados de este experimento a continuación). (En la Figura 4 mostramos los resultados de este experimento en la prueba de referencia ARC Challenge). Encontramos que esta predicción de ley de escala en dos pasos (extrapolada a cuatro órdenes de magnitud) es bastante precisa: sólo subestima ligeramente el rendimiento final del modelo insignia Llama 3.

3.3 Infraestructura, expansión y eficiencia

Describimos el hardware y la infraestructura que soportan el preentrenamiento de Llama 3 405B y analizamos varias optimizaciones que mejoran la eficacia del entrenamiento.

3.3.1 Infraestructura de formación

Los modelos Llama 1 y Llama 2 fueron entrenados en el supercluster de investigación de IA de Meta (Lee y Sengupta, 2022). A medida que aumentamos la escala, el entrenamiento de Llama 3 se migró al clúster de producción de Meta (Lee et al., 2024). Esta configuración optimiza la fiabilidad a nivel de producción, que es fundamental a medida que ampliamos el entrenamiento.

Recursos informáticos: La Llama 3 405B entrena hasta 16.000 GPU H100, cada una de ellas con un TDP de 700 W y 80 GB de HBM3, utilizando la plataforma de servidor de IA Grand Teton de Meta (Matt Bowman, 2022). Cada servidor está equipado con ocho GPU y dos CPU; dentro del servidor, las ocho GPU están conectadas mediante NVLink. Los trabajos de entrenamiento se programan utilizando MAST (Choudhury et al., 2024), el programador de entrenamiento a escala global de Meta.

Almacenamiento: Tectonic (Pan et al., 2021), el sistema de archivos distribuido de propósito general de Meta, se utilizó para construir la arquitectura de almacenamiento para el preentrenamiento de Llama 3 (Battey y Gupta, 2024). Proporciona 240 PB de espacio de almacenamiento y consta de 7.500 servidores equipados con SSD que soportan un rendimiento sostenible de 2 TB/s y un rendimiento máximo de 7 TB/s. Uno de los principales retos es soportar las escrituras de puntos de control en ráfagas que saturan la estructura de almacenamiento en un corto periodo de tiempo. Los puntos de control guardan el estado del modelo por GPU, que oscila entre 1 MB y 4 GB por GPU, para su recuperación y depuración. Nuestro objetivo es minimizar el tiempo de pausa de la GPU durante los puntos de control y aumentar su frecuencia para reducir la cantidad de trabajo que se pierde tras la recuperación.

Trabajo en red: La Llama 3 405B utiliza una arquitectura RDMA sobre Ethernet convergente (RoCE) basada en los conmutadores de rack Arista 7800 y Minipack2 Open Compute Project (OCP). Los modelos más pequeños de la serie Llama 3 se entrenaron utilizando la red Nvidia Quantum2 Infiniband. Tanto los clusters RoCE como los Infiniband utilizan una conexión de enlace de 400 Gbps entre las GPU. A pesar de las diferencias en la tecnología de red subyacente de estos clusters, hemos ajustado ambos para que proporcionen un rendimiento equivalente a la hora de manejar estas grandes cargas de trabajo de entrenamiento. Profundizaremos más en nuestra red RoCE a medida que nos hagamos cargo de su diseño.

- Topología de red: Nuestro clúster de IA basado en RoCE contiene 24.000 GPU (nota 5) conectadas a través de una red Clos de tres niveles (Lee et al., 2024). En el nivel inferior, cada bastidor alberga 16 GPU, asignadas a dos servidores y conectadas a través de un único conmutador Minipack2 para la parte superior del bastidor (ToR). En el nivel intermedio, 192 de estos bastidores se conectan a través de conmutadores de clúster para formar un pod de 3.072 GPU con ancho de banda bidireccional completo, lo que garantiza que no haya sobresuscripción. En el nivel superior, ocho de estos Pods dentro del mismo edificio del centro de datos se conectan a través de switches de agregación para formar un cluster de 24.000 GPUs. Sin embargo, en lugar de mantener un ancho de banda bidireccional completo, las conexiones de red en la capa de agregación tienen una tasa de sobresuscripción de 1:7. Tanto nuestro enfoque paralelo al modelo (véase la Sección 3.3.2) como el programador de tareas de entrenamiento (Choudhury et al., 2024) están optimizados para ser conscientes de la topología de la red, con el objetivo de minimizar la comunicación de red entre Pods.

- Equilibrio de carga: El entrenamiento de grandes modelos lingüísticos genera un tráfico de red pesado que es difícil de equilibrar entre todas las rutas de red disponibles mediante métodos tradicionales como el enrutamiento Equal Cost Multipath (ECMP). Para resolver este problema, empleamos dos técnicas. En primer lugar, nuestra biblioteca de agregados crea 16 flujos de red entre dos GPU en lugar de uno, lo que reduce la cantidad de tráfico por flujo y proporciona más flujos para el equilibrio de la carga. En segundo lugar, nuestro protocolo ECMP mejorado (E-ECMP) equilibra eficazmente estos 16 flujos a través de diferentes rutas de red mediante el hash de otros campos del paquete de cabecera RoCE.

- Control de la congestión: Utilizamos conmutadores de búfer profundo (Gangidi et al., 2024) en la red troncal para acomodar la congestión transitoria y el almacenamiento en búfer causados por patrones de comunicación agregados. Esto ayuda a limitar el impacto de la congestión persistente y la contrapresión de la red causada por servidores lentos, que es común en la formación. Por último, un mejor equilibrio de la carga a través de E-ECMP reduce en gran medida la probabilidad de congestión. Gracias a estas optimizaciones, hemos conseguido hacer funcionar un cluster de 24.000 GPUs sin necesidad de recurrir a métodos tradicionales de control de la congestión como la notificación cuantificada de la congestión en el centro de datos (DCQCN).

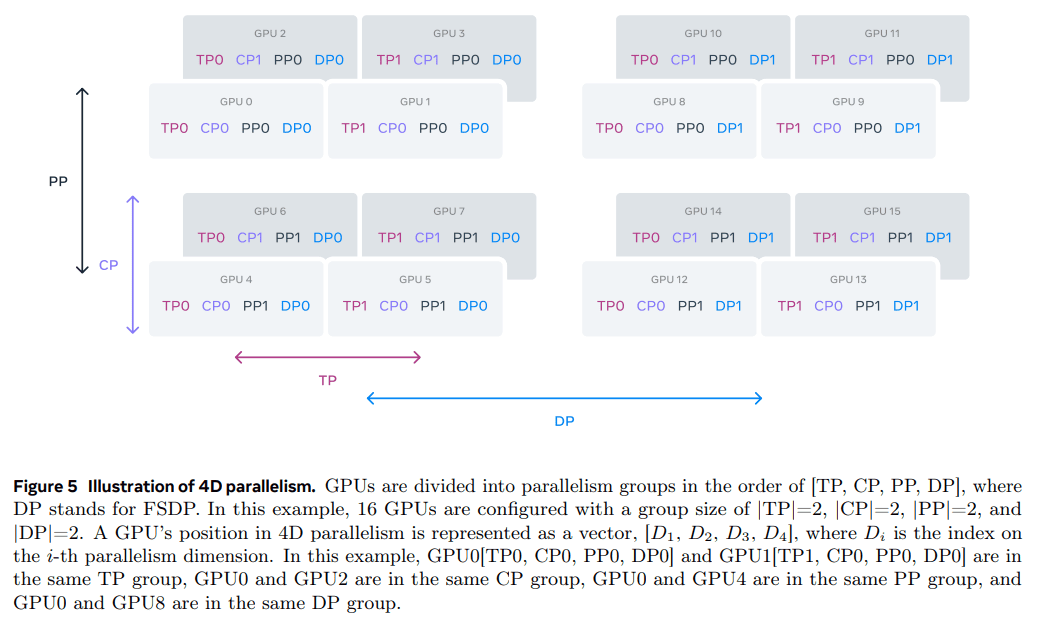

3.3.2 Paralelismo en la ampliación de modelos

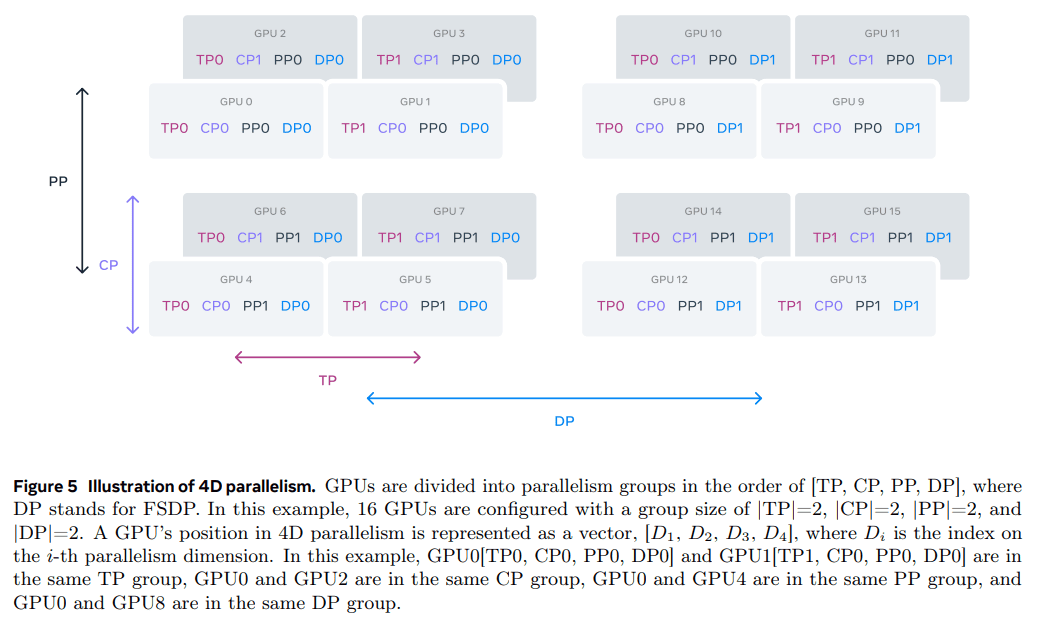

Para escalar el entrenamiento de nuestro modelo más grande, lo fragmentamos utilizando paralelismo 4D, un esquema que combina cuatro enfoques paralelos diferentes. Este enfoque distribuye eficazmente el cálculo entre varias GPU y garantiza que los parámetros del modelo, los estados del optimizador, los gradientes y los valores de activación de cada GPU se ajusten a su HBM. Nuestra implementación paralela 4D (como se muestra en et al. (2020); Ren et al. (2021); Zhao et al. (2023b)) trocea el modelo, el optimizador y el gradiente a la vez que implementa el paralelismo de datos, que procesa los datos en paralelo en múltiples GPUs y los sincroniza después de cada paso de entrenamiento. Usamos FSDP para cortar el estado del optimizador y el gradiente para Llama 3, pero para el corte del modelo no volvemos a cortar después del cálculo hacia delante para evitar la comunicación adicional de la colección completa durante el paso inverso.

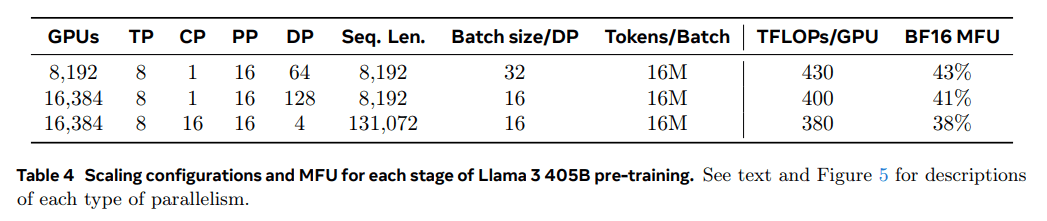

Utilización de la GPU.Ajustando cuidadosamente la configuración paralela, el hardware y el software, conseguimos una utilización de FLOPs del modelo BF16 (MFU; Chowdhery et al. (2023)) de 38-43%. Las configuraciones mostradas en la Tabla 4 indican que, en comparación con 43% en GPUs de 8K y DP=64, la caída de la MFU a 41% en GPUs de 16K y DP=128 se debe a la necesidad de reducir el tamaño del lote de cada grupo de DP para mantener constante el número de marcadores globales durante el entrenamiento. 41% se debe a la necesidad de reducir el tamaño del lote de cada grupo de AD para mantener constante el número de marcadores globales durante el entrenamiento.

Racionalizar las mejoras paralelas.Nos encontramos con varios retos en nuestra aplicación actual:

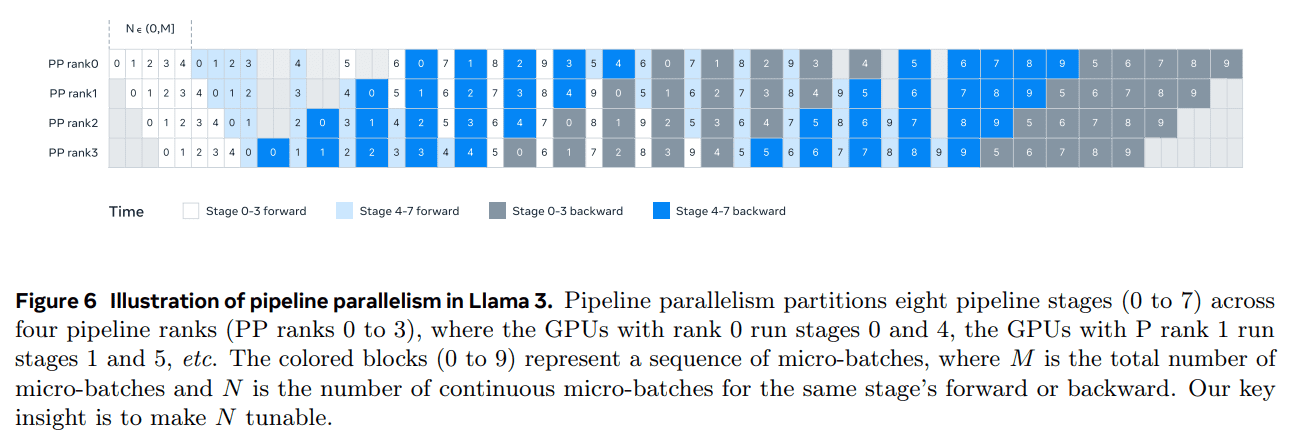

- Limitaciones del tamaño de los lotes.Las implementaciones actuales limitan el tamaño de lote admitido por GPU, exigiendo que sea divisible por el número de etapas del pipeline. En el ejemplo de la Fig. 6, el paralelismo de canalización para la programación depth-first (DFS) (Narayanan et al. (2021)) requiere N = PP = 4, mientras que la programación breadth-first (BFS; Lamy-Poirier (2023)) requiere N = M, donde M es el número total de microlotes y N es el número de microlotes consecutivos en la misma etapa en la dirección de avance o retroceso. Sin embargo, el preentrenamiento suele requerir flexibilidad en el dimensionamiento de los lotes.

- Desequilibrio de la memoria.Las implementaciones paralelas en paralelo existentes conducen a un consumo de recursos desequilibrado. La primera etapa consume más memoria debido a la incrustación y el calentamiento de microlotes.

- Los cálculos no están equilibrados. Después de la última capa del modelo, necesitamos calcular las salidas y las pérdidas, lo que convierte esta fase en un cuello de botella en términos de latencia de ejecución. donde Di es el índice de la i-ésima dimensión paralela. En este ejemplo, la GPU0[TP0, CP0, PP0, DP0] y la GPU1[TP1, CP0, PP0, DP0] están en el mismo grupo TP, la GPU0 y la GPU2 están en el mismo grupo CP, la GPU0 y la GPU4 están en el mismo grupo PP, y la GPU0 y la GPU8 están en el mismo grupo DP.

Para resolver estos problemas, modificamos el método de programación de canalizaciones, como se muestra en la figura 6, que permite un ajuste flexible de N, en este caso N = 5, lo que permite ejecutar cualquier número de microlotes en cada lote. Esto nos permite:

(1) Cuando exista un límite de tamaño de lote, ejecute menos microlotes que el número de etapas; o bien

(2) Ejecutar más microlotes para ocultar la comunicación entre pares y encontrar la mejor eficiencia de comunicación y memoria entre la programación por profundidad (DFS) y la programación por amplitud (BFS). Para equilibrar el pipeline, reducimos una capa Transformer de la primera y la última etapa, respectivamente. Esto significa que el primer bloque de modelo de la primera etapa sólo tiene la capa de incrustación, mientras que el último bloque de modelo de la última etapa sólo tiene la proyección de salida y el cálculo de pérdidas.

Para reducir las burbujas de canalización, utilizamos un enfoque de programación intercalada (Narayanan et al., 2021) en una jerarquía de canalización con V etapas de canalización. El ratio de burbuja global de la tubería es PP-1 V * M . Además, empleamos la comunicación asíncrona entre pares, que acelera significativamente el entrenamiento, especialmente en los casos en los que las máscaras de documentos introducen desequilibrios computacionales adicionales. Activamos TORCH_NCCL_AVOID_RECORD_STREAMS para reducir el uso de memoria de la comunicación asíncrona entre pares. Por último, para reducir los costes de memoria, basándonos en un análisis detallado de la asignación de memoria, liberamos de forma proactiva los tensores que no se utilizarán en futuros cálculos, incluidos los tensores de entrada y salida de cada etapa del pipeline. ** Con estas optimizaciones, somos capaces de realizar los 8K tensores sin el uso de puntos de control de activación, sin el uso de puntos de control de activación. ficha secuencias para el preentrenamiento de Llama 3.

La paralelización contextual se utiliza para secuencias largas. Aprovechamos la paralelización de contextos (CP) para mejorar la eficiencia de memoria al escalar las longitudes de contexto de Llama 3 y permitir el entrenamiento en secuencias muy largas de hasta 128K de longitud. En CP, hacemos una partición a través de las dimensiones de la secuencia, concretamente dividimos la secuencia de entrada en bloques 2 × CP de forma que cada nivel CP recibe dos bloques para un mejor equilibrio de la carga. El nivel CP i-ésimo recibe el bloque i-ésimo y (2 × CP -1 -i).

A diferencia de las implementaciones de CP existentes que solapan la comunicación y el cálculo en una estructura de anillo (Liu et al., 2023a), nuestra implementación de CP emplea un enfoque basado en la recopilación total que primero agrega globalmente el tensor clave-valor (K, V) y, a continuación, calcula las salidas atencionales de los bloques del tensor de consulta local (Q). Aunque la latencia de la comunicación all-gather está en la ruta crítica, adoptamos este enfoque por dos razones principales:

(1) Es más fácil y flexible admitir distintos tipos de máscaras de atención, como las máscaras de documentos, en la atención CP basada en la recopilación total;

(2) La latencia all-gather expuesta es pequeña porque el tensor K y V de la comunicación es mucho menor que el tensor Q, debido al uso de GQA (Ainslie et al., 2023). Como resultado, la complejidad temporal del cálculo de la atención es un orden de magnitud mayor que la del all-gather (O(S²) frente a O(S), donde S denota la longitud de la secuencia en la máscara causal completa), lo que hace que la sobrecarga del all-gather sea insignificante.

Configuración paralelizada sensible a la red.El orden de las dimensiones de paralelización [TP, CP, PP, DP] está optimizado para la comunicación de red. La capa más interna de la paralelización requiere el mayor ancho de banda de red y la menor latencia, por lo que normalmente se limita al mismo servidor. La capa más externa de la paralelización puede abarcar redes multisalto y debe ser capaz de tolerar una latencia de red más alta. Por lo tanto, basándonos en los requisitos de ancho de banda y latencia de la red, clasificamos las dimensiones de paralelización en el orden [TP, CP, PP, DP]. DP (es decir, FSDP) es la capa más externa de paralelización, ya que puede tolerar una latencia de red más larga mediante la precarga asíncrona de los pesos del modelo de corte y la reducción del gradiente. Determinar la configuración de paralelización óptima con la mínima sobrecarga de comunicación y evitando al mismo tiempo el desbordamiento de memoria de la GPU es todo un reto. Hemos desarrollado un estimador del consumo de memoria y una herramienta de proyección del rendimiento, que nos han ayudado a explorar varias configuraciones de paralelización y a predecir el rendimiento global del entrenamiento e identificar las lagunas de memoria de forma eficiente.

Estabilidad numérica.Comparando las pérdidas de entrenamiento entre diferentes configuraciones paralelas, solucionamos algunos problemas numéricos que afectan a la estabilidad del entrenamiento. Para garantizar la convergencia del entrenamiento, utilizamos la acumulación de gradientes FP32 durante el cálculo inverso de múltiples microlotes y reducimos los gradientes de dispersión utilizando FP32 entre los trabajadores de datos paralelos en FSDP. Para los tensores intermedios que se utilizan varias veces en los cálculos hacia delante, como las salidas del codificador visual, el gradiente inverso también se acumula en FP32.

3.3.3 Comunicaciones colectivas

La biblioteca de comunicación colectiva de Llama 3 se basa en una rama de la biblioteca NCCL de Nvidia llamada NCCLX. NCCLX mejora enormemente el rendimiento de NCCL, especialmente para redes de alta latencia. Recordemos que el orden de las dimensiones paralelas es [TP, CP, PP, DP], donde DP corresponde a FSDP, y que las dimensiones paralelas más externas, PP y DP, pueden comunicarse a través de una red multisalto con latencias de decenas de microsegundos. Las operaciones de comunicación colectiva all-gather y reduce-scatter del NCCL original se utilizan en FSDP, mientras que la comunicación punto a punto se utiliza para PP, que requiere fragmentación de datos y replicación de datos por etapas. Este enfoque conlleva algunas de las siguientes ineficiencias:

- Es necesario intercambiar un gran número de pequeños mensajes de control a través de la red para facilitar la transferencia de datos;

- Operaciones adicionales de copia de memoria;

- Utiliza ciclos adicionales de la GPU para la comunicación.

Para el entrenamiento de Llama 3, abordamos algunas de estas ineficiencias adaptando la fragmentación y las transferencias de datos a la latencia de nuestra red, que puede llegar a decenas de microsegundos en clústeres grandes. También permitimos que los mensajes de control pequeños pasen a través de nuestra red con mayor prioridad, evitando específicamente el bloqueo de la cabeza de cola en conmutadores de núcleo con búfer profundo.

Nuestro trabajo en curso para futuras versiones de Llama incluye cambios más profundos en NCCLX para abordar plenamente todos los problemas anteriores.

3.3.4 Fiabilidad y retos operativos

La complejidad y las posibles situaciones de fallo del entrenamiento en GPU de 16K superan las de los clusters de CPU más grandes con los que hemos trabajado. Además, la naturaleza sincrónica del entrenamiento lo hace menos tolerante a fallos: un solo fallo de la GPU puede obligar a reiniciar todo el trabajo. A pesar de estas dificultades, en el caso de Llama 3 conseguimos tiempos de entrenamiento efectivos superiores a 90% mientras realizábamos el mantenimiento automatizado del clúster (por ejemplo, actualizaciones del firmware y del kernel de Linux (Vigraham y Leonhardi, 2024)), lo que provocó al menos una interrupción del entrenamiento al día.

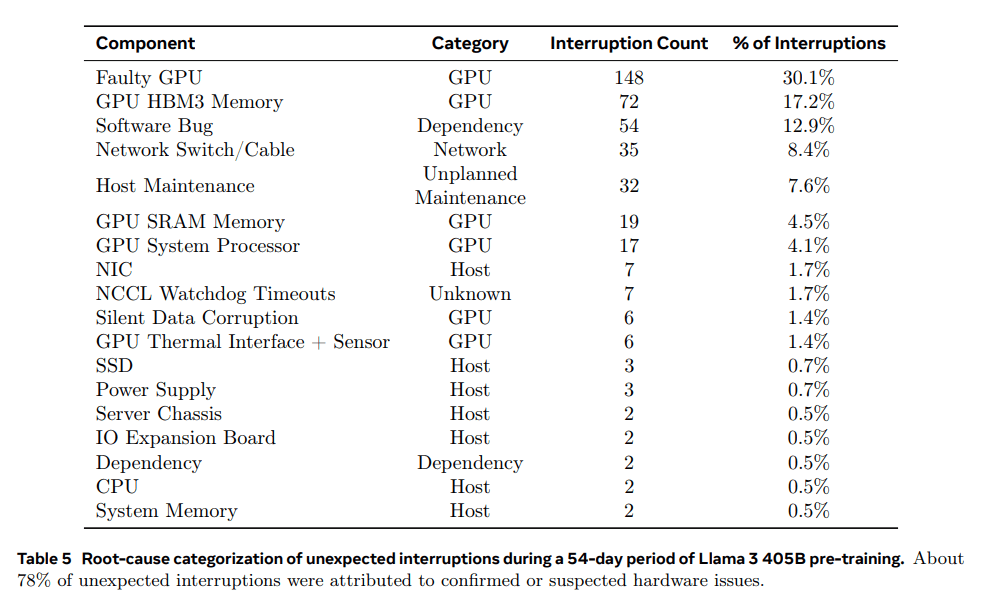

El tiempo efectivo de formación es la cantidad de tiempo dedicado a la formación efectiva durante el tiempo transcurrido. Durante la instantánea de 54 días previa al entrenamiento, experimentamos un total de 466 interrupciones operativas. De ellas, 47 fueron interrupciones planificadas debido a operaciones de mantenimiento automatizadas (por ejemplo, actualizaciones de firmware u operaciones iniciadas por el operador, como actualizaciones de configuración o de conjuntos de datos). Las 419 restantes fueron interrupciones imprevistas, que se clasifican en el Cuadro 5. Aproximadamente 78% de las interrupciones imprevistas se atribuyeron a problemas de hardware identificados, como fallos de la GPU o de componentes del host, o a presuntos problemas relacionados con el hardware, como corrupción silenciosa de datos y tareas de mantenimiento no planificadas de hosts individuales. A pesar del gran número de fallos, durante este periodo sólo fue necesario realizar tres intervenciones manuales importantes y el resto de problemas se resolvieron de forma automatizada.

Para mejorar el tiempo de formación efectivo, redujimos el tiempo de inicio y de comprobación de los trabajos, y desarrollamos herramientas para el diagnóstico rápido y la resolución de problemas. Hicimos un uso extensivo del registrador de vuelo NCCL integrado de PyTorch (Ansel et al., 2024), una función que captura metadatos colectivos y rastros de pila en un búfer de anillo, lo que nos permite diagnosticar rápidamente cuelgues y problemas de rendimiento a escala, especialmente en el caso de los aspectos de aspectos NCCLX. Gracias a él, podemos registrar eficazmente los eventos de comunicación y la duración de cada operación colectiva, y volcar automáticamente los datos de rastreo en caso de que se agote el tiempo de espera de un watchdog o un heartbeat de NCCLX. Con los cambios de configuración en línea (Tang et al., 2015), podemos habilitar de forma selectiva operaciones de rastreo y recopilación de metadatos más intensivas desde el punto de vista computacional sin necesidad de liberar código o reiniciar el trabajo. Los problemas de depuración en la formación a gran escala se complican por el uso mixto de NVLink y RoCE en nuestra red. Las transferencias de datos suelen realizarse a través de NVLink mediante operaciones de carga/almacenamiento emitidas por el núcleo CUDA, y el fallo de una GPU remota o de una conexión NVLink suele manifestarse como una operación de carga/almacenamiento bloqueada en el núcleo CUDA sin devolver un código de error explícito. PyTorch acceda al estado interno de NCCLX y rastree la información relevante. Aunque no es posible evitar por completo los bloqueos debidos a fallos de NVLink, nuestro sistema supervisa el estado de las bibliotecas de comunicación y agota automáticamente el tiempo de espera cuando se detectan dichos bloqueos. Además, NCCLX rastrea la actividad del núcleo y de la red para cada comunicación NCCLX y proporciona una instantánea del estado interno del colectivo NCCLX que está fallando, incluyendo las transferencias de datos completadas y no completadas entre todos los rangos. Analizamos estos datos para depurar los problemas de extensión de NCCLX.

A veces, los problemas de hardware pueden dar lugar a rezagados que siguen funcionando pero son lentos y difíciles de detectar. Incluso si sólo hay un rezagado, puede ralentizar miles de otras GPU, a menudo en forma de funcionamiento normal pero comunicación lenta. Hemos desarrollado herramientas para priorizar las comunicaciones potencialmente problemáticas de grupos de procesos seleccionados. Investigando sólo unos pocos sospechosos clave, a menudo somos capaces de identificar eficazmente a los rezagados.

Una observación interesante es el impacto de los factores ambientales en el rendimiento del entrenamiento a gran escala. En el caso de la Llama 3 405B, observamos fluctuaciones de rendimiento de 1-2% en función de la variación horaria. Esta fluctuación se debe a las altas temperaturas del mediodía, que afectan al escalado dinámico del voltaje y la frecuencia de la GPU. Durante el entrenamiento, decenas de miles de GPU pueden aumentar o disminuir simultáneamente el consumo de energía, por ejemplo, debido a que todas las GPU están esperando a que termine un punto de control o una comunicación colectiva, o a que se inicie o cierre un trabajo de entrenamiento completo. Cuando esto ocurre, pueden producirse fluctuaciones transitorias en el consumo de energía dentro del centro de datos del orden de decenas de megavatios, lo que pone a prueba los límites de la red eléctrica. Se trata de un reto constante a medida que ampliamos la formación para futuros modelos Llama aún mayores.

3.4 Programas de formación

La receta de preentrenamiento de la Llama 3 405B consta de tres etapas principales:

(1) preentrenamiento inicial, (2) preentrenamiento de contexto largo y (3) recocido. Cada una de estas tres etapas se describe a continuación. Utilizamos recetas similares para preentrenar los modelos 8B y 70B.

3.4.1 Formación previa inicial

Preentrenamos el modelo Llama 3 405B utilizando un esquema de tasa de aprendizaje coseno con una tasa de aprendizaje máxima de 8 × 10-⁵, calentada linealmente hasta 8.000 pasos, y decaída a 8 × 10-⁷ tras 1.200.000 pasos de entrenamiento. Para mejorar la estabilidad del entrenamiento, utilizamos un tamaño de lote más pequeño al principio del entrenamiento y posteriormente aumentamos el tamaño del lote para mejorar la eficiencia. En concreto, inicialmente tenemos un tamaño de lote de 4 millones de tokens y una longitud de secuencia de 4.096. Después de preentrenar 252 millones de tokens, duplicamos el tamaño de lote y la longitud de secuencia a 8 millones de secuencias y 8.192 tokens, respectivamente. Después de preentrenar 2,87 millones de tokens, volvemos a duplicar el tamaño de lote a 16 millones. Este método de entrenamiento es muy estable: se producen muy pocos picos de pérdida y no es necesario intervenir para corregir las desviaciones en el entrenamiento del modelo.

Ajuste de las combinaciones de datos. Durante el entrenamiento, realizamos varios ajustes en la combinación de datos del preentrenamiento para mejorar el rendimiento del modelo en tareas descendentes específicas. En concreto, aumentamos la proporción de datos no ingleses durante el preentrenamiento para mejorar el rendimiento multilingüe de Llama 3. También aumentamos la proporción de datos matemáticos para mejorar el razonamiento matemático del modelo, añadimos datos de redes más recientes en las últimas fases del preentrenamiento para actualizar los límites de conocimiento del modelo y redujimos la proporción de un subconjunto de datos que posteriormente se consideró de menor calidad.

3.4.2 Preentrenamiento en contexto largo

En la etapa final del preentrenamiento, entrenamos secuencias largas para soportar ventanas de contexto de hasta 128.000 tokens. No entrenamos secuencias largas antes porque el cálculo en la capa de autoatención crece cuadráticamente con la longitud de la secuencia. Aumentamos gradualmente la longitud del contexto y realizamos un preentrenamiento una vez que el modelo se ha adaptado correctamente a la mayor longitud del contexto. Evaluamos el éxito de la adaptación midiendo ambas cosas:

(1) Si se ha recuperado totalmente el rendimiento del modelo en las evaluaciones de contexto corto;

(2) Si el modelo puede resolver perfectamente la tarea "una aguja en un pajar" hasta esta longitud. En el preentrenamiento de Llama 3 405B, aumentamos progresivamente la longitud del contexto en seis etapas, empezando con una ventana de contexto inicial de 8.000 tokens y llegando finalmente a una ventana de contexto de 128.000 tokens. Esta larga fase de preentrenamiento del contexto utilizó aproximadamente 800.000 millones de tokens de entrenamiento.

3.4.3 Recocido

Durante el preentrenamiento de los últimos 40 millones de tokens, ajustamos la tasa de aprendizaje linealmente a 0, manteniendo una longitud de contexto de 128.000 tokens. Durante esta fase de templado, también ajustamos la mezcla de datos para aumentar el tamaño de la muestra de fuentes de datos de muy alta calidad; véase la sección 3.1.3. Por último, calculamos la media de los puntos de control del modelo (media de Polyak (1991)) durante el recocido para generar el modelo final preentrenado.

4 Formación de seguimiento

Generamos y alineamos los modelos de Llama 3 aplicando múltiples rondas de entrenamiento de seguimiento. Estos entrenamientos de seguimiento se basan en puntos de control preentrenados e incorporan comentarios humanos para la alineación de modelos (Ouyang et al., 2022; Rafailov et al., 2024). Cada ronda de entrenamiento de seguimiento consistió en un ajuste fino supervisado (SFT), seguido de una optimización directa de preferencias (DPO; Rafailov et al., 2024) utilizando ejemplos generados mediante anotación o síntesis manual. En las secciones 4.1 y 4.2, respectivamente, describimos nuestros métodos de datos y modelos de entrenamiento. Además, proporcionamos más detalles sobre las estrategias de cotejo de datos personalizadas en la Sección 4.3 para mejorar el modelo en términos de inferencia, capacidades de programación, factorización, soporte multilingüe, uso de herramientas, contextos largos y cumplimiento de instrucciones precisas.

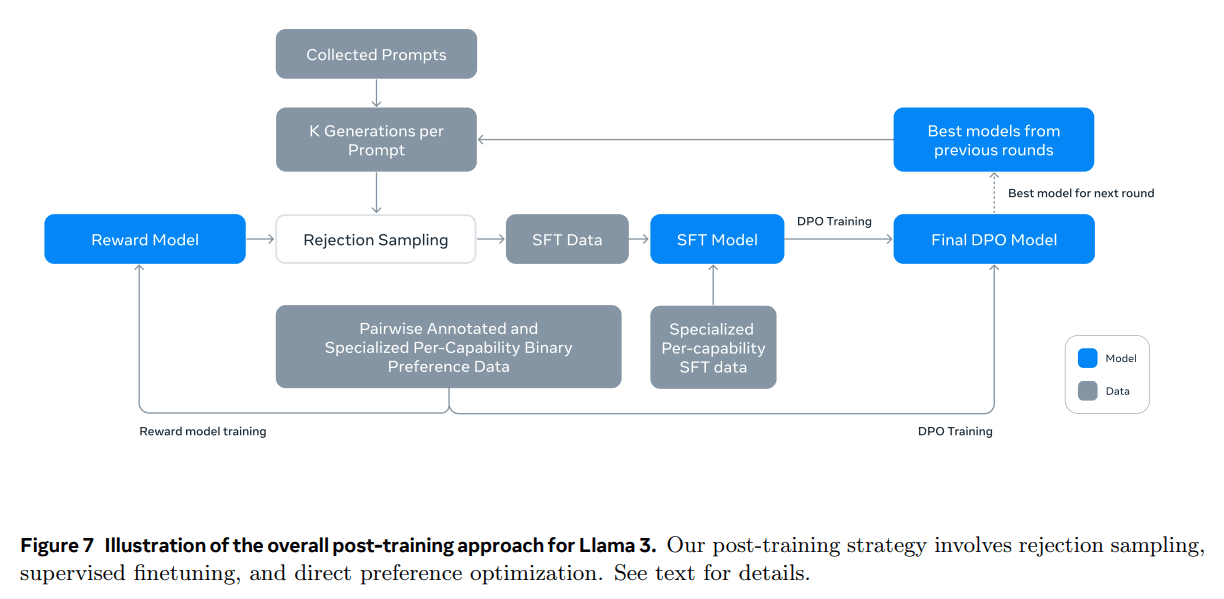

4.1 Modelización

La base de nuestra estrategia de post-entrenamiento es un modelo de recompensa y un modelo lingüístico. Primero entrenamos un modelo de recompensa sobre los puntos de control del preentrenamiento utilizando datos de preferencias etiquetados por humanos (véase el apartado 4.1.2). A continuación, ajustamos los puntos de control del preentrenamiento con un ajuste fino supervisado (SFT; véase el apartado 4.1.3) y los alineamos con los puntos de control mediante una optimización directa de las preferencias (DPO; véase el apartado 4.1.4). Este proceso se muestra en la figura 7. A menos que se indique lo contrario, nuestro proceso de modelado se aplica a la Llama 3 405B, a la que nos referiremos como Llama 3 405B para simplificar.

4.1.1 Formato del diálogo de chat

Para adaptar un Modelo de Lenguaje Extenso (LLM) a la interacción persona-ordenador, necesitamos definir un protocolo de diálogo por chat que permita al modelo entender órdenes humanas y realizar tareas de diálogo. En comparación con su predecesor, Llama 3 tiene nuevas características, como el uso de herramientas (Sección 4.3.5), que pueden requerir la generación de múltiples mensajes en una sola ronda de diálogo y su envío a diferentes lugares (por ejemplo, usuario, ipython). Para ello, hemos diseñado un nuevo protocolo de chat multimensaje que utiliza una serie de tokens especiales de cabecera y terminación. Los tokens de cabecera se utilizan para indicar el origen y el destino de cada mensaje en un diálogo. Del mismo modo, los marcadores de terminación indican cuándo es el turno del humano y de la IA para alternar la palabra.

4.1.2 Modelos de recompensa

Entrenamos un modelo de recompensa (MR) que cubre diferentes habilidades y lo construimos sobre puntos de control preentrenados. El objetivo del entrenamiento es el mismo que en Llama 2, pero eliminamos el término marginal en la función de pérdida porque observamos una mejora reducida a medida que aumenta el tamaño de los datos. Como en Llama 2, utilizamos todos los datos de preferencias para el modelado de recompensas tras filtrar las muestras con respuestas similares.

Además de los pares de preferencia de respuesta estándar (seleccionada, rechazada), la anotación crea una tercera "respuesta editada" para algunas pistas, en la que la respuesta seleccionada del par se edita de nuevo para mejorarla (véase el apartado 4.2.1). Así, cada muestra de clasificación de preferencias tiene dos o tres respuestas claramente clasificadas (editada > seleccionada > rechazada). Durante el entrenamiento, concatenamos las pistas y las respuestas múltiples en una fila y aleatorizamos las respuestas. Se trata de una aproximación al escenario estándar de cálculo de puntuaciones colocando las respuestas en filas separadas, pero en nuestros experimentos de ablación este enfoque mejora la eficacia del entrenamiento sin pérdida de precisión.

4.1.3 Ajuste de la supervisión

En primer lugar, se rechazan las señales humanas etiquetadas para el muestreo mediante el modelo de recompensa, cuya metodología detallada se describe en la sección 4.2. Combinamos estos datos muestreados de rechazo con otras fuentes de datos (incluidos datos sintéticos) para ajustar el modelo lingüístico preentrenado utilizando pérdidas de entropía cruzada estándar, con el objetivo de predecir las marcas de destino (al tiempo que se enmascaran las pérdidas de las marcas marcadas). Consulte la sección 4.2 para obtener más información sobre la combinación de datos. Aunque muchos de los objetivos de entrenamiento son generados por el modelo, nos referimos a esta fase como ajuste fino supervisado (SFT; Wei et al. 2022a; Sanh et al. 2022; Wang et al. 2022b).

Nuestro modelo máximo se ajusta con una tasa de aprendizaje de 1e-5 en 8,5K a 9K pasos. Estos hiperparámetros resultan adecuados para diferentes rondas y combinaciones de datos.

4.1.4 Optimización directa de las preferencias

Seguimos entrenando nuestros modelos SFT para la alineación de preferencias humanas mediante la Optimización Directa de Preferencias (OPD; Rafailov et al., 2024). En el entrenamiento, utilizamos principalmente los últimos lotes de datos de preferencias recopilados de los modelos con mejor rendimiento en la ronda anterior de alineación. Como resultado, nuestros datos de entrenamiento se ajustan mejor a la distribución de los modelos de estrategia optimizados en cada ronda. También exploramos algoritmos de estrategia como PPO (Schulman et al., 2017), pero descubrimos que DPO requiere menos computación y funciona mejor en modelos a gran escala, especialmente en puntos de referencia de cumplimiento de instrucciones como IFEval (Zhou et al., 2023).

Para Llama 3, utilizamos una tasa de aprendizaje de 1e-5 y fijamos el hiperparámetro β en 0,1. Además, aplicamos las siguientes modificaciones algorítmicas a la OPD:

- Enmascaramiento de los marcadores de formato en las pérdidas de RPD. Enmascaramos los marcadores de formato especiales (incluidos los marcadores de cabecera y terminación descritos en la sección 4.1.1) de las respuestas seleccionadas y rechazadas para estabilizar el entrenamiento de OPD. Observamos que la participación de estos marcadores en la pérdida puede dar lugar a un comportamiento no deseado del modelo, como la duplicación de la cola o la generación repentina de marcadores de terminación. Nuestra hipótesis es que esto se debe a la naturaleza contrastada de la pérdida de OPD: la presencia de marcadores comunes tanto en las respuestas seleccionadas como en las rechazadas puede conducir a objetivos de aprendizaje contradictorios, ya que el modelo necesita aumentar y disminuir simultáneamente la probabilidad de estos marcadores.

- Regularización mediante pérdidas NLL: la Añadimos un término de pérdida de log-verosimilitud negativa (NLL) adicional a las secuencias seleccionadas con un factor de escala de 0,2, similar al de Pang et al. (2024). Esto ayuda a estabilizar aún más el entrenamiento de OPD manteniendo el formato necesario para la generación y evitando que disminuya la log-verosimilitud de las respuestas seleccionadas (Pang et al., 2024; Pal et al., 2024).

4.1.5 Promedio de modelos

Por último, promediamos los modelos obtenidos en experimentos utilizando varias versiones de datos o hiperparámetros en cada etapa de MR, SFT o OPD (Izmailov et al. 2019; Wortsman et al. 2022; Li et al. 2022). Presentamos información estadística sobre los datos de preferencias humanas recopilados internamente y utilizados para el condicionamiento de Llama 3. Pedimos a los evaluadores que participaran en varias rondas de diálogo con el modelo y comparamos las respuestas de cada ronda. Durante el posprocesamiento, dividimos cada diálogo en varios ejemplos, cada uno de los cuales contenía una indicación (incluido el diálogo anterior, si estaba disponible) y una respuesta (por ejemplo, una respuesta seleccionada o rechazada).

4.1.6 Rondas de iteración

Siguiendo a Llama 2, aplicamos la metodología anterior durante seis rondas de iteraciones. En cada ronda, recopilamos nuevos datos de etiquetado y ajuste de preferencias (SFT) y muestreamos datos sintéticos del último modelo.

4.2 Datos posteriores a la formación

La composición de los datos posteriores al entrenamiento desempeña un papel crucial en la utilidad y el comportamiento del modelo lingüístico. En esta sección, analizamos nuestro procedimiento de anotación y recopilación de datos de preferencias (Sección 4.2.1), la composición de los datos SFT (Sección 4.2.2) y los métodos de control de calidad y limpieza de datos (Sección 4.2.3).

4.2.1 Preferencias

Nuestro proceso de etiquetado de datos de preferencias es similar al de Llama 2. Después de cada ronda, desplegamos múltiples modelos para la anotación y muestreamos dos respuestas de diferentes modelos para cada pista de usuario. Estos modelos pueden entrenarse utilizando diferentes esquemas de combinación y alineación de datos, lo que da lugar a diferentes capacidades (por ejemplo, experiencia en código) y a una mayor diversidad de datos. Pedimos a los anotadores que clasificaran las puntuaciones de preferencia en uno de cuatro niveles según su nivel de preferencia: significativamente mejor, mejor, ligeramente mejor o ligeramente mejor.

También hemos incluido un paso de edición después de la ordenación de preferencias para animar al anotador a refinar aún más la respuesta preferida. El anotador puede editar directamente la respuesta seleccionada o utilizar el modelo de pista de retroalimentación para refinar su propia respuesta. Como resultado, algunos datos de preferencias tienen tres respuestas ordenadas (Editar > Seleccionar > Rechazar).

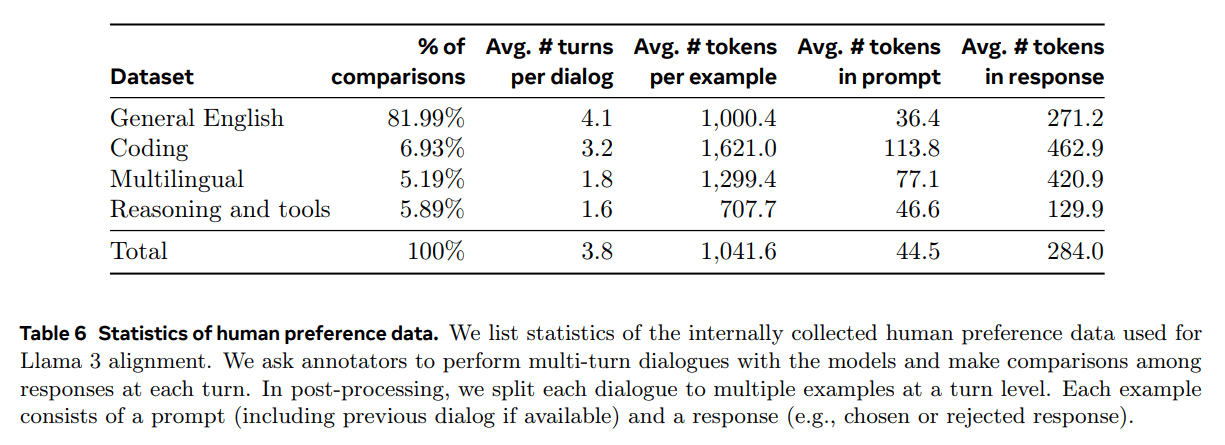

Las estadísticas de anotación de preferencias que utilizamos para el entrenamiento de Llama 3 se recogen en la Tabla 6. El inglés general abarca varias subcategorías, como las preguntas y respuestas basadas en el conocimiento o el seguimiento preciso de instrucciones, que quedan fuera del alcance de las habilidades específicas. En comparación con Llama 2, observamos un aumento de la longitud media de las preguntas y respuestas, lo que sugiere que estamos entrenando a Llama 3 en tareas más complejas. Además, implementamos un proceso de análisis de calidad y evaluación manual para evaluar de forma crítica los datos recopilados, lo que nos permitió perfeccionar las preguntas y proporcionar comentarios sistemáticos y procesables a los anotadores. Por ejemplo, a medida que Llama 3 mejore en cada ronda, aumentaremos la complejidad de las indicaciones para centrarnos en las áreas en las que el modelo se está quedando atrás.

En cada ronda de entrenamiento tardío, utilizamos todos los datos de preferencias disponibles en ese momento para el modelado de recompensas, y sólo los lotes más recientes de cada capacidad para el entrenamiento de OPD. Tanto para la modelización de recompensas como para la OPD, entrenamos con muestras etiquetadas como "respuesta de selección significativamente mejor o mejor" y descartamos las muestras con respuestas similares.

4.2.2 Datos SFT

Nuestros datos de ajuste proceden principalmente de las siguientes fuentes:

- Cuestiones de nuestra colección anotada manualmente y su rechazo a las respuestas de muestreo

- Datos sintéticos para capacidades específicas (véase la sección 4.3 para más detalles)

- Pequeña cantidad de datos etiquetados manualmente (véase la sección 4.3 para más detalles)

A medida que avanzábamos en nuestro ciclo de post-entrenamiento, desarrollamos variantes más potentes de Llama 3 y las utilizamos para recopilar conjuntos de datos más grandes para cubrir una amplia gama de capacidades complejas. En esta sección, analizamos los detalles del proceso de muestreo de rechazo y la composición general de la mezcla final de datos SFT.

Negativa a tomar muestras.En el muestreo de rechazo (RS), por cada pista que recogemos durante la anotación manual (Sección 4.2.1), muestreamos K salidas de la estrategia de modelado de chat más reciente (normalmente los mejores puntos de control de ejecución de la iteración de post-entrenamiento anterior, o los mejores puntos de control de ejecución para una competencia concreta) y utilizamos nuestro modelo de recompensa para seleccionar el mejor candidato, en línea con Bai et al. (2022). En etapas posteriores del post-entrenamiento, introducimos pistas del sistema para guiar las respuestas de las RS para que se ajusten a un tono, estilo o formato deseados, que pueden variar según las distintas capacidades.

Para mejorar la eficiencia del muestreo de rechazo, empleamos PagedAttention (Kwon et al., 2023).PagedAttention mejora la eficiencia de la memoria mediante la asignación dinámica de memoria caché clave-valor. Admite una longitud de salida arbitraria programando dinámicamente las solicitudes en función de la capacidad actual de la caché. Desafortunadamente, esto introduce el riesgo de swapping cuando la memoria se agota. Para eliminar esta sobrecarga de intercambio, definimos una longitud máxima de salida y sólo ejecutamos las peticiones si hay memoria suficiente para almacenar salidas de esa longitud. pagedAttention también nos permite compartir la página de caché de valor clave sugerida entre todas las salidas correspondientes. En conjunto, esto se tradujo en un aumento de más del doble en el rendimiento durante el muestreo de rechazo.

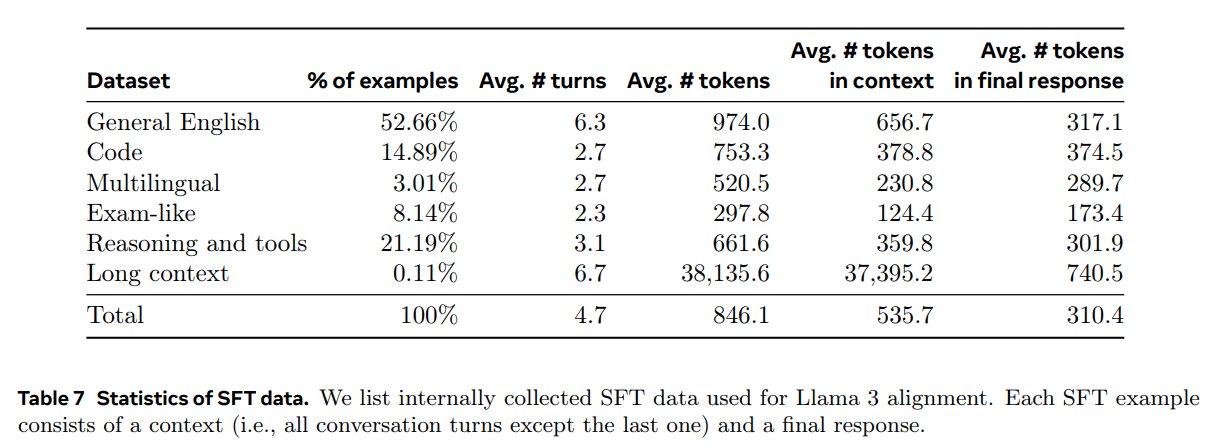

Composición de los datos agregados.La tabla 7 muestra las estadísticas de cada una de las categorías generales de datos de nuestra mezcla de "utilidad". Aunque los datos de SFT y los de preferencias contienen ámbitos que se solapan, su tratamiento es diferente, lo que da lugar a estadísticas de recuento distintas. En la sección 4.2.3 se describen las técnicas utilizadas para clasificar la materia, la complejidad y la calidad de nuestras muestras de datos. En cada ronda de post-entrenamiento, afinamos cuidadosamente nuestra combinación global de datos para ajustar el rendimiento en múltiples ejes para una amplia gama de puntos de referencia. Nuestra combinación final de datos se repetirá varias veces para determinadas fuentes de alta calidad y se reducirá para otras.

4.2.3 Tratamiento de datos y control de calidad

Teniendo en cuenta que la mayoría de nuestros datos de formación son generados por modelos, es necesario realizar una limpieza y un control de calidad minuciosos.

Depuración de datos: En las primeras fases, observamos muchos patrones no deseados en los datos, como el uso excesivo de emoticonos o signos de exclamación. Por ello, aplicamos una serie de estrategias de eliminación y modificación de datos basadas en reglas para filtrar o eliminar los datos problemáticos. Por ejemplo, para mitigar el problema de la entonación excesivamente apologética, identificábamos las frases demasiado utilizadas (por ejemplo, "lo siento" o "pido disculpas") y equilibrábamos cuidadosamente la proporción de tales muestras en el conjunto de datos.

Poda de datos: También aplicamos una serie de técnicas basadas en modelos para eliminar las muestras de entrenamiento de baja calidad y mejorar el rendimiento general del modelo:

- Clasificación por materias: Primero ajustamos Llama 3 8B para convertirlo en un clasificador de temas y razonamos sobre todos los datos para clasificarlos en categorías de grano grueso ("Razonamiento matemático") y categorías de grano fino ("Geometría y trigonometría").

- Índice de calidad: Utilizamos el modelo de recompensa y las señales basadas en Llama para obtener puntuaciones de calidad para cada muestra. Para las puntuaciones basadas en RM, consideramos los datos con puntuaciones en el cuartil más alto como de alta calidad. Para las puntuaciones basadas en Llama, pedimos a los puntos de control de Llama 3 que puntuaran los datos de inglés general en tres niveles (precisión, cumplimiento de las instrucciones y tono/presentación) y los datos de código en dos niveles (reconocimiento de errores e intención del usuario) y consideramos las muestras que recibieron las puntuaciones más altas como datos de alta calidad. Las puntuaciones basadas en RM y Llama tienen altos índices de conflicto, y descubrimos que la combinación de estas señales daba como resultado la mejor recuperación para el conjunto de pruebas internas. En última instancia, seleccionamos los ejemplos etiquetados como de alta calidad por los filtros basados en RM o en Llama.

- Grado de dificultad: Como también nos interesaba dar prioridad a los ejemplos de modelos más complejos, puntuamos los datos utilizando dos métricas de dificultad: la puntuación Instag (Lu et al., 2023) y la puntuación basada en Llama. Para Instag, pedimos a Llama 3 70B que realizara el etiquetado de intención en las pistas SFT, donde más intención implica mayor complejidad. También pedimos a Llama 3 que midiera la dificultad del diálogo en tres niveles (Liu et al., 2024c).

- Desenfatización semántica: Por último, realizamos la desduplicación semántica (Abbas et al., 2023; Liu et al., 2024c). En primer lugar, agrupamos los diálogos completos mediante RoBERTa (Liu et al., 2019b) y los clasificamos por puntuación de calidad × puntuación de dificultad en cada grupo. A continuación, realizamos una selección codiciosa iterando sobre todos los ejemplos ordenados, manteniendo solo aquellos cuya similitud coseno máxima con los ejemplos vistos en los clústeres hasta el momento es inferior a un umbral.

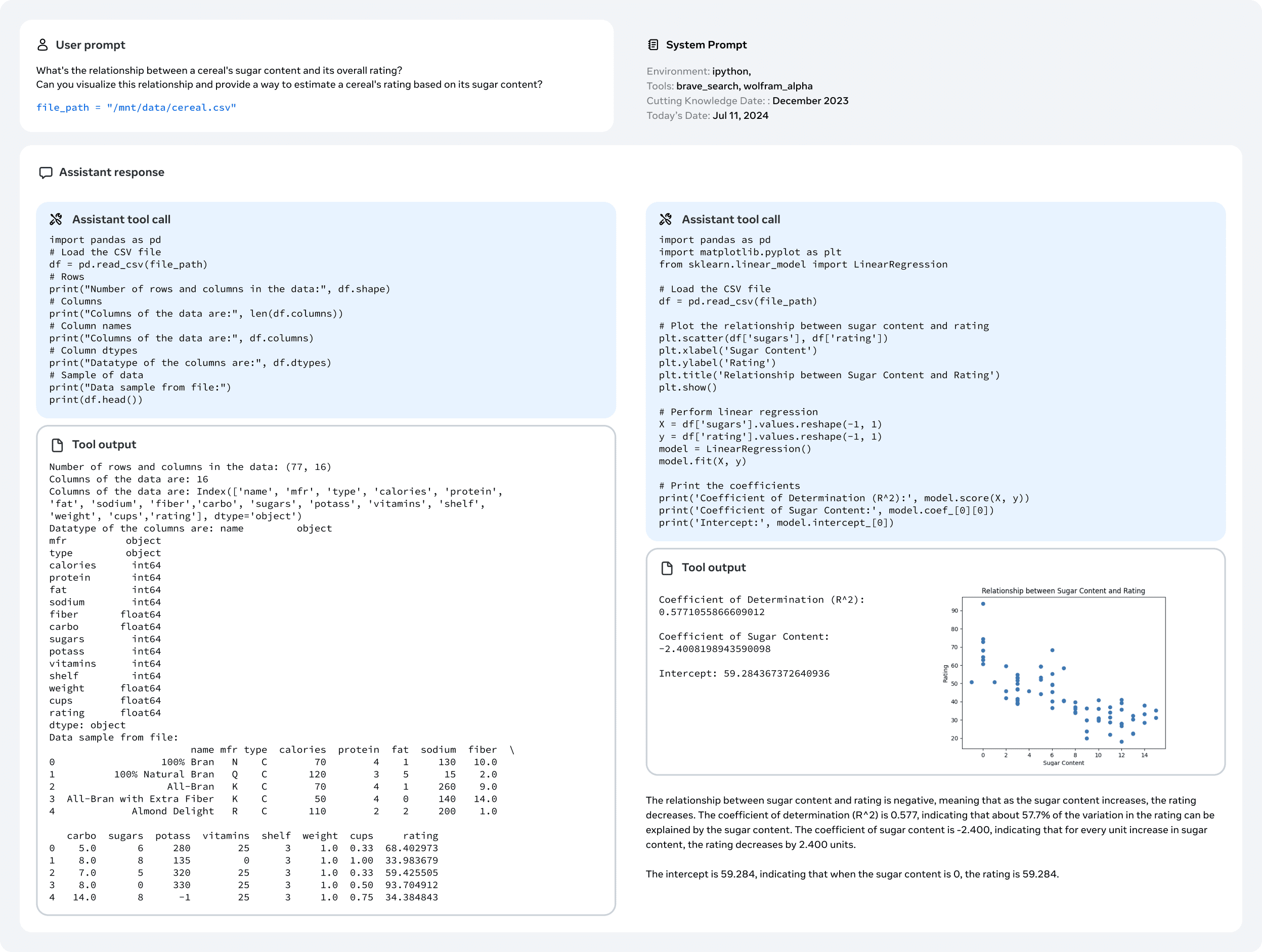

4.3 Capacidad

En particular, destacamos algunos de los esfuerzos realizados para mejorar competencias específicas, como el manejo de códigos (sección 4.3.1), el multilingüismo (sección 4.3.2), las habilidades matemáticas y de razonamiento (sección 4.3.3), la contextualización a largo plazo (sección 4.3.4), el uso de herramientas (sección 4.3.5), la facticidad (sección 4.3.6) y la controlabilidad (sección 4.3.7).

4.3.1 Código

desde (un tiempo) Copiloto y Codex (Chen et al., 2021), los LLM para código han recibido mucha atención. Los desarrolladores utilizan ahora ampliamente estos modelos para generar fragmentos de código, depurar, automatizar tareas y mejorar la calidad del código. Para Llama 3, nuestro objetivo es mejorar y evaluar las capacidades de generación, documentación, depuración y revisión de código para los siguientes lenguajes de programación prioritarios: Python, Java, JavaScript, C/C++, TypeScript, Rust, PHP, HTML/CSS, SQL y bash/shell.Aquí, presentamos los resultados obtenidos al la formación de expertos en código, la generación de datos sintéticos para SFT, el paso a formatos mejorados mediante avisos del sistema y la creación de filtros de calidad para eliminar las muestras malas de los datos de formación con el fin de mejorar estas funciones de codificación.

Formación especializada.Entrenamos a un experto en código y lo utilizamos en múltiples rondas de post-entrenamiento para recopilar anotaciones de código humano de alta calidad. Esto se consiguió desviando el preentrenamiento principal y continuando con el preentrenamiento en una mezcla de tokens de 1T que eran principalmente (>85%) datos de código. Se ha demostrado que el preentrenamiento continuado con datos de dominios específicos es eficaz para mejorar el rendimiento en dominios específicos (Gururangan et al., 2020). Seguimos una receta similar a la de CodeLlama (Rozière et al., 2023). En los últimos miles de pasos del entrenamiento, realizamos un ajuste fino del contexto largo (LCFT) en una mezcla de alta calidad de datos de código a nivel de repositorio, ampliando la longitud del contexto del experto a 16.000 tokens. Por último, seguimos una receta de modelado post-entrenamiento similar a la descrita en la sección 4.1 para alinear el modelo, pero utilizando una mezcla de datos SFT y DPO que son principalmente específicos del código. El modelo también se utiliza para el muestreo de rechazo de pistas de codificación (sección 4.2.2).

Generación de datos sintéticos.Durante el desarrollo, identificamos problemas clave en la generación de código, como la dificultad para seguir instrucciones, los errores de sintaxis del código, la generación de código incorrecto y la dificultad para corregir errores. Aunque las anotaciones humanas densas podrían resolver en teoría estos problemas, la generación de datos sintéticos ofrece un enfoque complementario que es más barato, se adapta mejor y no está limitado por el nivel de experiencia de los anotadores.

Por lo tanto, utilizamos Llama 3 y Code Expert para generar un gran número de diálogos SFT sintéticos. Describimos tres métodos de alto nivel para generar datos de código sintéticos. En total, utilizamos más de 2,7 millones de ejemplos sintéticos durante el SFT.

1. Generación de datos sintéticos: aplicación de la retroalimentación.Los modelos 8B y 70B muestran mejoras significativas de rendimiento con datos de entrenamiento generados por modelos más grandes y competentes. Sin embargo, nuestros experimentos preliminares muestran que entrenar sólo a Llama 3 405B con sus propios datos generados no ayuda (o incluso degrada el rendimiento). Para abordar esta limitación, introducimos la retroalimentación de la ejecución como fuente de verdad que permite al modelo aprender de sus errores y mantenerse en el buen camino. En concreto, generamos un conjunto de datos de aproximadamente un millón de diálogos de código sintético mediante el siguiente procedimiento:

- Generación de la descripción del problema:En primer lugar, generamos un amplio conjunto de descripciones de problemas de programación que abarcaban una gran variedad de temas (incluidas las distribuciones de cola larga). Para lograr esta diversidad, muestreamos aleatoriamente fragmentos de código de diversas fuentes y pedimos al modelo que generara problemas de programación basados en estos ejemplos. Esto nos permitió aprovechar una amplia gama de temas y crear un conjunto exhaustivo de descripciones de problemas (Wei et al., 2024).

- Generación de soluciones:A continuación, pedimos a Llama 3 que resolviera cada problema en el lenguaje de programación dado. Observamos que añadir buenas reglas de programación a las instrucciones mejoraba la calidad de las soluciones generadas. Además, nos pareció útil pedir al modelo que explicara su proceso de pensamiento con anotaciones.

- Análisis de corrección: Una vez generadas las soluciones, es fundamental reconocer que su corrección no está garantizada y que la inclusión de soluciones incorrectas en el conjunto de datos ajustado puede comprometer la calidad del modelo. Aunque no podemos garantizar una corrección completa, hemos desarrollado métodos para aproximarnos a ella. Para ello, tomamos el código fuente extraído de las soluciones generadas y aplicamos una combinación de técnicas de análisis estático y dinámico para comprobar su corrección:

- Análisis estático: Pasamos todo el código generado por un analizador sintáctico y herramientas de comprobación de código para garantizar la corrección sintáctica, detectar errores de sintaxis, uso de variables no inicializadas o funciones no importadas, problemas de estilo del código, errores tipográficos, etc.

- Generación y ejecución de pruebas unitarias: Para cada problema y solución, pedimos al modelo que genere pruebas unitarias y las ejecute con la solución en un entorno de contenedores, detectando errores de ejecución en tiempo de ejecución y algunos errores semánticos.

- Retroalimentación de errores y autocorrección iterativa: Cuando la solución falla en cualquier paso, pedimos al modelo que la modifique. El aviso contiene la descripción original del problema, la solución errónea y la información procedente del analizador sintáctico/herramienta de inspección de código/programa de pruebas (salida estándar, error estándar y código de retorno). Tras un fallo en la ejecución de una prueba unitaria, el modelo puede arreglar el código para que pase las pruebas existentes o modificar sus pruebas unitarias para que se ajusten al código generado. Sólo los diálogos que superan todas las comprobaciones se incluyen en el conjunto de datos final para el ajuste fino supervisado (SFT). En particular, observamos que aproximadamente 20% de las soluciones eran inicialmente incorrectas pero se autocorregían, lo que sugiere que el modelo aprendió de la retroalimentación de la ejecución y mejoró su rendimiento.

- Puesta a punto y mejora iterativa: El proceso de ajuste se realiza en varias rondas, cada una de las cuales se basa en la anterior. Después de cada ronda de ajuste, el modelo se mejora para generar datos sintéticos de mayor calidad para la siguiente ronda. Este proceso iterativo permite perfeccionar y mejorar el rendimiento del modelo.

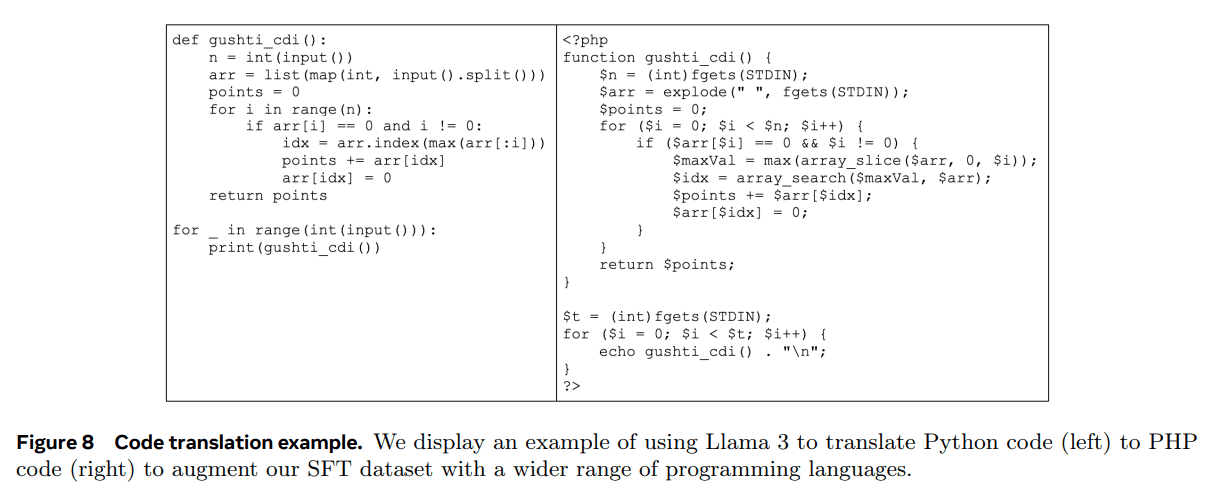

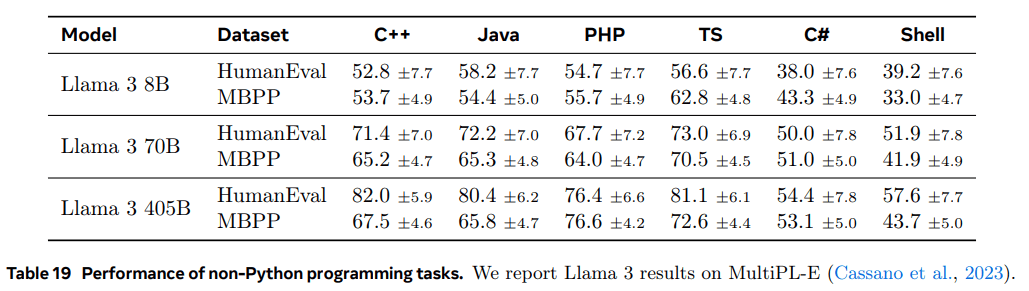

2. Generación de datos sintéticos: traducción de lenguajes de programación. Observamos una diferencia de rendimiento entre los principales lenguajes de programación (por ejemplo, Python/C++) y los menos comunes (por ejemplo, Typescript/PHP). Esto no es sorprendente, ya que disponemos de menos datos de entrenamiento para los lenguajes de programación menos comunes. Para mitigar esto, complementaremos los datos disponibles traduciendo datos de lenguajes de programación comunes a lenguajes menos comunes (similar a Chen et al. (2023) en el campo de la inferencia). Esto se consigue solicitando a Llama 3 y garantizando la calidad mediante el análisis sintáctico, la compilación y la ejecución. La Figura 8 muestra un ejemplo de código PHP sintético traducido desde Python. Esto mejora significativamente el rendimiento de los lenguajes menos comunes medido por el benchmark MultiPL-E (Cassano et al., 2023).