LiveTalking: sistema digital interactivo en tiempo real de código abierto que permite el diálogo síncrono por audio y vídeo.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 117.1K 01

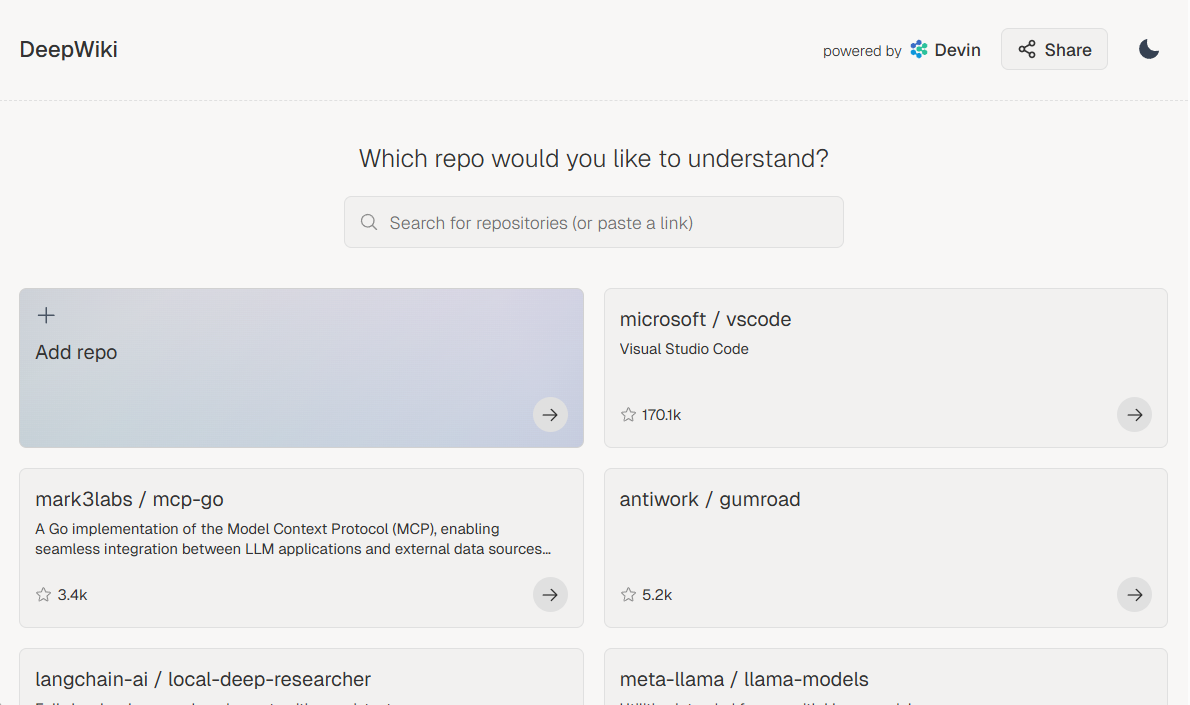

Introducción general

LiveTalking es un sistema humano digital interactivo en tiempo real de código abierto, dedicado a construir una solución humana digital en directo de alta calidad. El proyecto utiliza el protocolo de código abierto Apache 2.0 e integra una serie de tecnologías de vanguardia, como la renderización ER-NeRF, el procesamiento de flujos de audio y vídeo en tiempo real, la sincronización de labios, etc. El sistema es compatible con el renderizado y la interacción humana digital en tiempo real, y puede utilizarse para retransmisiones en directo, educación en línea, atención al cliente y muchos otros escenarios. LiveTalking presta especial atención al rendimiento en tiempo real y a la experiencia interactiva, y proporciona a los usuarios un completo marco de desarrollo humano digital mediante la integración de la tecnología AIGC. El proyecto se actualiza y mantiene continuamente, y está respaldado por una completa documentación, lo que lo convierte en una opción ideal para crear aplicaciones de persona digital.

Lista de funciones

- Admite múltiples modelos humanos digitales:ernerfymusetalkywav2lipyUltraligero-Digital-Humano

- Logre un diálogo simultáneo de audio y vídeo

- Clonación de sonidos

- Los pro-digital hablan y son interrumpidos

- Admite el empalme de vídeo de cuerpo entero

- Admite flujos RTMP y WebRTC push

- Soporte para programación de vídeos: reproduce vídeos personalizados cuando no estés hablando

- Admite múltiples concurrencias

Utilizar la ayuda

1.Proceso de instalación

- Requisitos medioambientales : Ubuntu 20.04, Python 3.10, Pytorch 1.12, CUDA 11.3

- Instalación de dependencias ::

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

Si no entrenas. ernerf no es necesario instalar las siguientes bibliotecas:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2. Inicio rápido

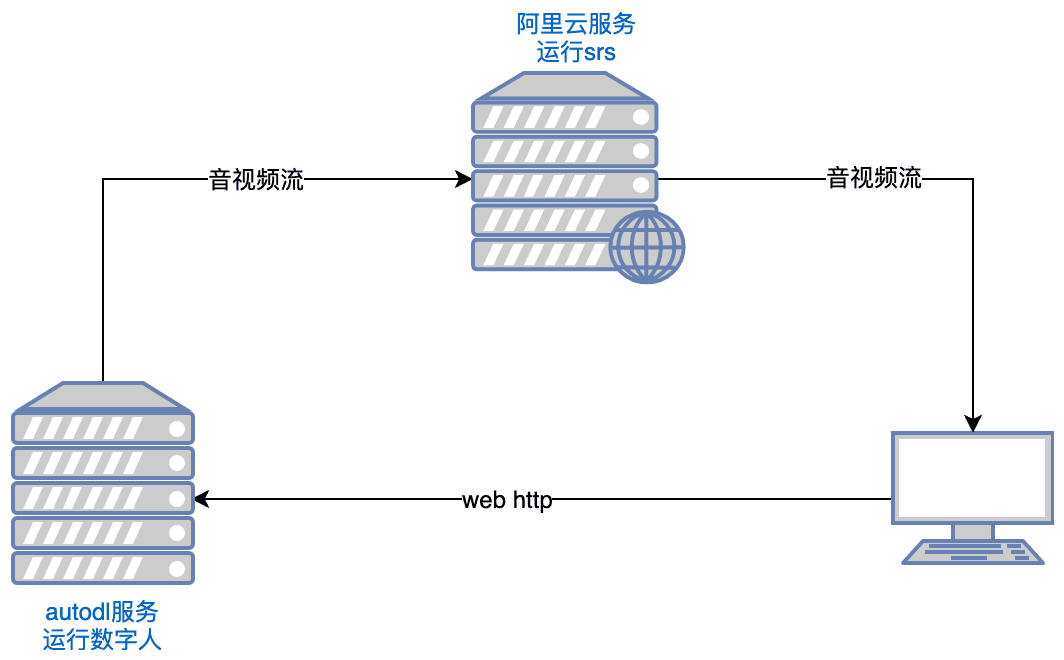

- Funcionamiento del SRS ::

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

Observaciones: El servidor necesita abrir los puertos tcp:8000,8010,1985; udp:8000

- Lanzamiento de Digital People ::

python app.py

Si no puedes acceder a Huggingface, ejecútalo antes de correr:

export HF_ENDPOINT=https://hf-mirror.com

Abrir con el navegador http://serverip:8010/rtcpushapi.htmlSi introduce algún texto en el cuadro de texto, envíelo y la persona digital emitirá el pasaje.

Más instrucciones de uso

- Docker en ejecución : No es necesaria la instalación previa, basta con ejecutarlo:

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

El código se encuentra en /root/metahuman-streamanterior git pull Extraiga el último código y ejecute el comando como en los pasos 2 y 3.

- Mirroring ::

- imagen autodl:tutorial de autodl

- espejos ucloud:Tutorial de ucloud

- problemas comunes Para configurar el entorno CUDA en Linux, consulte este artículo:artículo de referencia

3. Instrucciones de configuración

- Configuración del sistema

- Edite el archivo config.yaml para establecer los parámetros básicos

- Configuración de cámaras y dispositivos de audio

- Ajuste de los parámetros y trayectorias del modelo de IA

- Configurar los parámetros de la transmisión push en directo

- Preparación del modelo humano digital

- Importación de modelos 3D personalizados

- Se pueden utilizar modelos de ejemplo preconstruidos

- Admite la importación de modelos MetaHuman

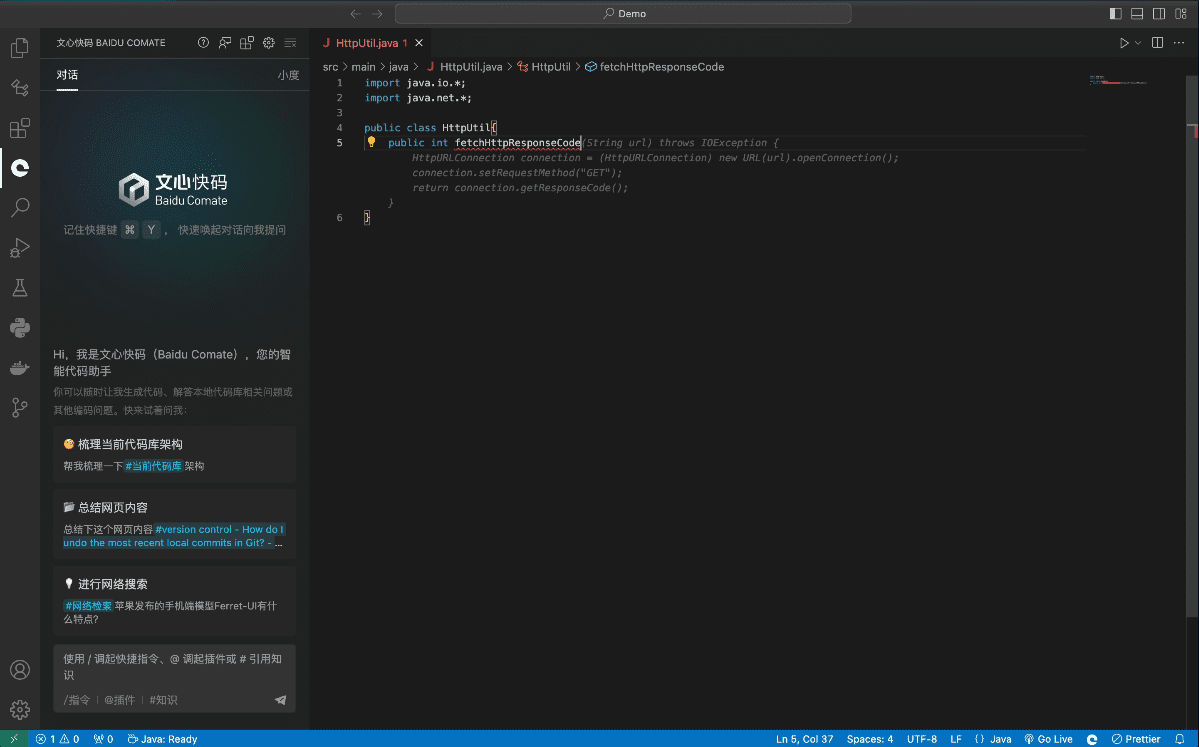

Funciones principales

- Diálogo sincrónico de audio y vídeo en tiempo real::

- Seleccione el modelo de digitalizador: Seleccione el modelo de digitalizador adecuado (por ejemplo, ernerf, musetalk, etc.) en la página de configuración.

- Selección del método de transmisión de audio/vídeo: Seleccione el método de transmisión de audio/vídeo adecuado (por ejemplo, WebRTC, RTMP, etc.) en función de los requisitos.

- Iniciar un diálogo: inicia la transmisión de audio/vídeo para conseguir un diálogo síncrono de audio/vídeo en tiempo real.

- Cambio de modelo humano digital::

- Entrar en la página de configuración: En la página de ejecución del proyecto, haga clic en el botón Configuración para entrar en la página de configuración.

- Seleccionar nuevo modelo: Selecciona un nuevo modelo de Digimon en la página Configuración y guarda los ajustes.

- Reiniciar proyecto: reinicia el proyecto para aplicar la nueva configuración del modelo.

- Ajuste de los parámetros de audio y vídeo::

- Entrar en la página de parametrización: En la página de ejecución del proyecto, haga clic en el botón de parametrización para entrar en la página de parametrización.

- Parámetros de ajuste: Ajuste los parámetros de audio y vídeo (como la resolución, la frecuencia de imagen, etc.) según sea necesario.

- Guardar y aplicar: Guarda los ajustes y aplica la nueva configuración de parámetros.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...