LHM: generación de modelos humanos 3D con movimiento a partir de una sola imagen

Últimos recursos sobre IAPublicado hace 12 meses Círculo de intercambio de inteligencia artificial 59.5K 00

Introducción general

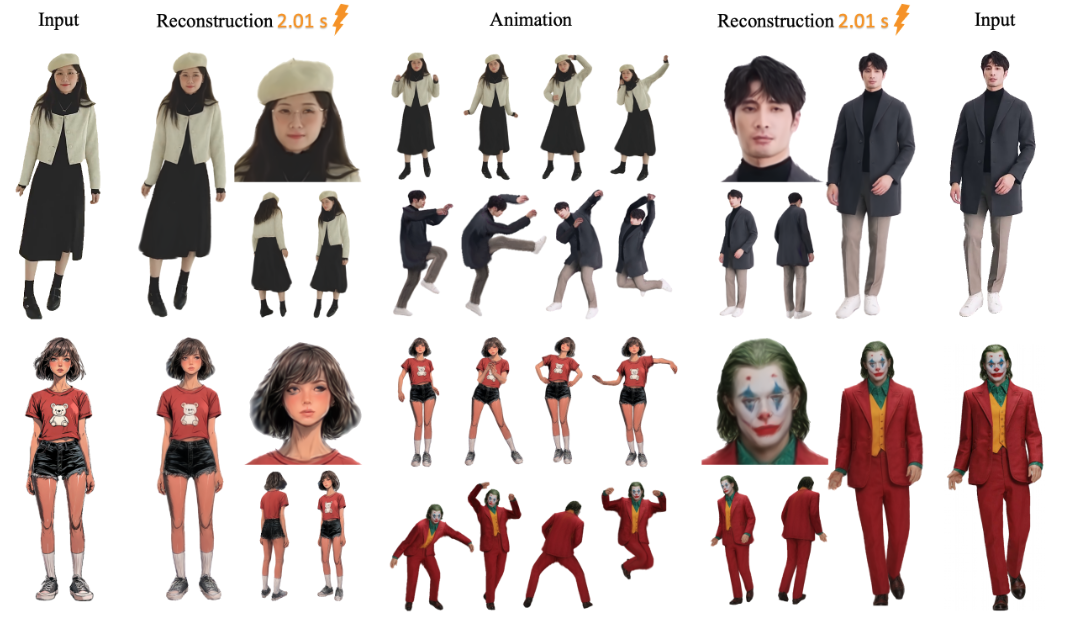

LHM (Large Animatable Human Reconstruction Model) es un proyecto de código abierto desarrollado por el equipo de aigc3d que permite generar rápidamente modelos humanos en 3D a partir de una sola imagen. LHM utiliza la tecnología 3D Gaussian Splatting para representar el cuerpo humano, combinada con una arquitectura de transformadores multimodal que conserva la textura de la ropa y los detalles geométricos. El proyecto, publicado por primera vez el 13 de marzo de 2025, proporciona modelos preentrenados y un código adecuado para la investigación o el desarrollo de aplicaciones digitales 3D relacionadas con el ser humano.

Lista de funciones

- Genere un maniquí 3D a partir de una sola imagen en cuestión de segundos.

- Permite la renderización en tiempo real y la visualización directa del modelo generado.

- Proporcionar la función de acción para ajustar la postura del cuerpo humano para generar vídeo dinámico.

- Salida de archivos de malla 3D (por ejemplo, en formato OBJ) para su posterior edición.

- Se incluyen modelos preentrenados (por ejemplo, LHM-0,5B y LHM-1B) que no necesitan entrenarse.

- Interfaz Gradio integrada con soporte de visualización local.

- Proporciona un canal de procesamiento de vídeo que puede extraer acciones del vídeo para aplicarlas a los modelos.

Utilizar la ayuda

El uso de LHM se divide en dos partes: instalación y funcionamiento. A continuación se detallan los pasos para ayudarte a empezar rápidamente.

Proceso de instalación

- Preparar el entorno

El sistema requiere Python 3.10 y CUDA (compatible con las versiones 11.8 o 12.1). Se recomienda una tarjeta gráfica NVIDIA, como una A100 o 4090, con al menos 16 GB de memoria de vídeo.- Compruebe la versión de Python:

python --version - Compruebe la versión CUDA:

nvcc --version

- Compruebe la versión de Python:

- almacén de clones

Introduzca el siguiente comando en el terminal para descargar el código LHM:git clone https://github.com/aigc3d/LHM.git cd LHM

- Instalación de dependencias

Ejecute el script correspondiente según su versión CUDA:- CUDA 11.8:

sh ./install_cu118.sh - CUDA 12.1:

sh ./install_cu121.sh

Si el script falla, instale las dependencias manualmente:

pip install -r requirements.txt - CUDA 11.8:

- Descargar modelos

El modelo se descargará automáticamente. Si desea descargarlo manualmente, utilice el siguiente comando:- Modelo LHM-0.5B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-0.5B.tar tar -xvf LHM-0.5B.tar - Modelo LHM-1B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-1B.tar tar -xvf LHM-1B.tar

Descárguelo y extráigalo al directorio raíz del proyecto.

- Modelo LHM-0.5B:

- Verificar la instalación

Ejecute los comandos de prueba para asegurarse de que el entorno es correcto:python app.pySi tiene éxito, se iniciará la interfaz de Gradio.

flujo de trabajo

Generar modelos 3D

- Preparar la imagen

Prepare una imagen clara que contenga todo el cuerpo humano y guárdela localmente, por ejemplo<path_to_image>/person.jpg. - Ejecución de scripts de inferencia

Introdúcelo en el terminal:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ ./output/<path_to_image>es la ruta a su imagen../output/es la carpeta de salida donde se guardan los resultados generados.

- Ver resultados

Tras generar el<output>La carpeta tendrá el archivo del modelo 3D y el vídeo renderizado. Puedes abrir los archivos de malla con software 3D (por ejemplo, Blender) o reproducir los vídeos directamente.

Añadir acción

- Secuencia de movimientos preparatorios

El proyecto proporciona archivos de acción de ejemplo, ubicados en el directorio<LHM根目录>/train_data/motion_video/mimo1/smplx_params. También puede utilizar su propio archivo de parámetros SMPL-X. - Ejecución de guiones de acción

Introduzca el siguiente comando:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ <path_to_motion>/smplx_params<path_to_motion>es la ruta del archivo de acción.

- Vista previa del vídeo de acción

La carpeta de salida genera un vídeo de acción, que puede reproducirse directamente.

Uso de la interfaz de Gradio

- Interfaz de lanzamiento

Se ejecuta en el terminal:python app.pySe abrirá el navegador

http://0.0.0.0:7860. - Subir una foto

Cargue una foto de su cuerpo en la interfaz y haga clic en "Enviar". - Obtener resultados

Al cabo de unos segundos, la interfaz mostrará la imagen renderizada y el vídeo de la acción, que pueden descargarse y visualizarse.

Exportación de mallas 3D

- Ejecutar el script de exportación

Entrada:bash ./inference_mesh.sh ./configs/inference/human-lrm-1B.yaml LHM-1B - Encuentra el archivo.

La carpeta de salida tendrá archivos de malla en formato OBJ, que se pueden editar con software 3D.

advertencia

- Las imágenes deben ser claras y los fondos sencillos funcionan mejor.

- El efecto de la acción depende de la calidad de la acción de entrada.

- Si no tienes suficiente memoria de vídeo, prueba el modelo LHM-0.5B.

escenario de aplicación

- desarrollo de juegos

Los desarrolladores pueden utilizar LHM para generar rápidamente modelos 3D de personajes a partir de fotos, ajustar las poses e importarlos al motor del juego, ahorrando tiempo de modelado. - producción de cine y televisión

Los equipos de cine y televisión pueden utilizar LHM para crear dobles digitales y generar vídeos de acción para su uso en escenas de efectos especiales, reduciendo así los costes de modelado manual. - presentador virtual (TV)

Los anfitriones pueden subir sus propias fotos para generar una imagen en 3D y luego añadir acciones para crear una imagen virtual personalizada. - Investigación educativa

Los investigadores pudieron probar algoritmos de reconstrucción 3D con LHM o demostrar el proceso de conversión de imágenes a modelos en el aula.

CONTROL DE CALIDAD

- ¿Qué formatos de imagen admite LHM?

Se admiten formatos comunes como JPG, PNG, se recomienda JPG y que el tamaño del archivo no supere los 10 MB. - ¿Cuánto se tarda en generar un modelo?

Alrededor de 0,2 segundos en tarjetas A100, 1-2 segundos en tarjetas 4090, varía ligeramente en función del hardware. - ¿Puedo entrenar yo mismo al modelo?

Es posible, pero no se facilitan oficialmente guiones de entrenamiento. Requiere preparar el conjunto de datos y afinar el código, apto para usuarios con experiencia. - ¿Se puede editar el modelo 3D de salida?

Puede. Tras exportar el archivo OBJ, edita la geometría y las texturas con Blender o Maya.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...