Lepton AI: plataforma de IA nativa en la nube que ofrece despliegue gratuito de modelos de IA a velocidad limitada por GPU

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 52.6K 00

Introducción general

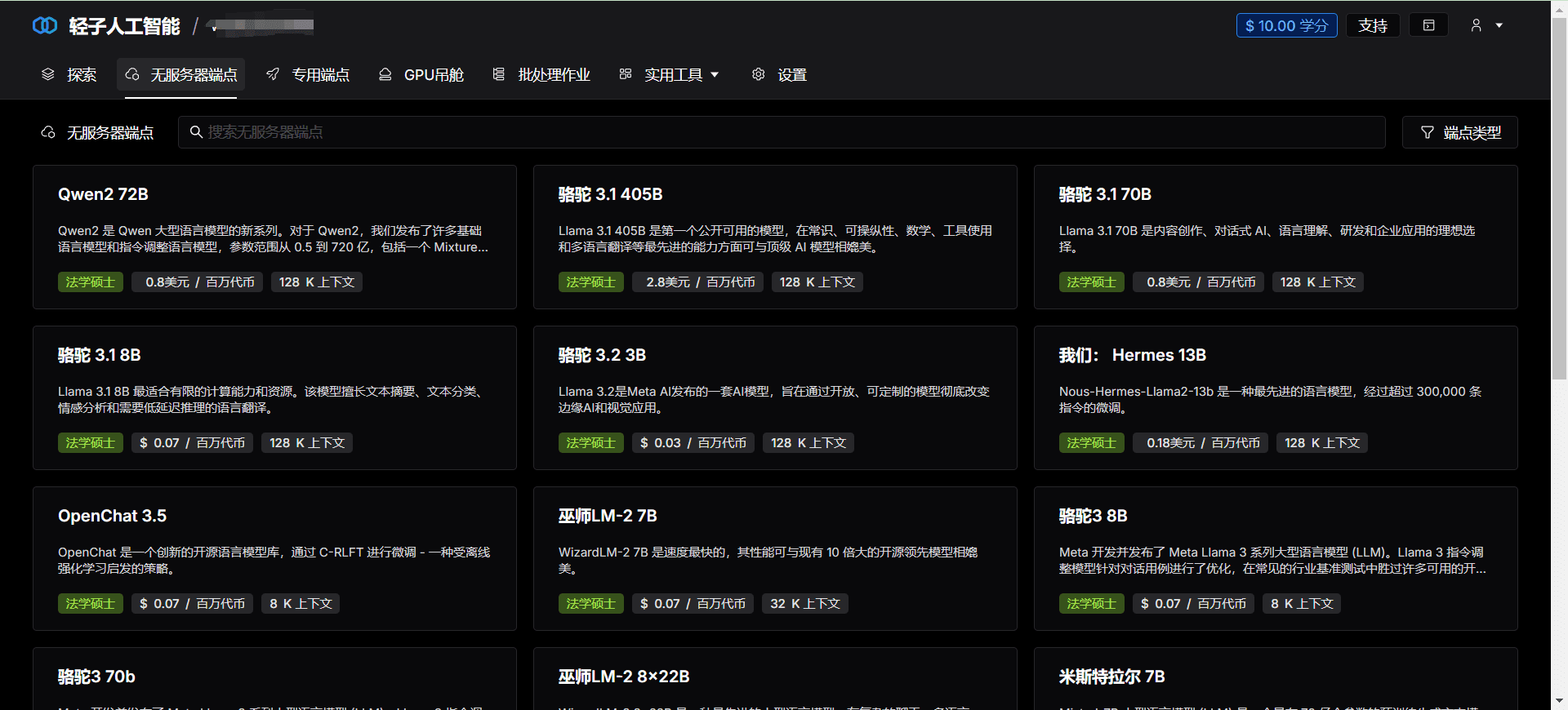

Lepton AI es una plataforma líder de IA nativa en la nube dedicada a proporcionar a desarrolladores y empresas soluciones de IA eficientes, fiables y fáciles de usar. A través de sus potentes capacidades de computación y su interfaz fácil de usar, Lepton AI ayuda a los usuarios a lograr un rápido aterrizaje y escalado en proyectos complejos de IA.

Lista de funciones

- Informática eficienteLa plataforma ofrece recursos informáticos de alto rendimiento para el entrenamiento y la inferencia de modelos de IA a gran escala.

- Experiencia nativa en la nubeLa tecnología de IA se integra a la perfección con la tecnología de computación en nube para simplificar el proceso de desarrollo e implantación de aplicaciones de IA.

- Infraestructura de GPUProporciona soporte de hardware de GPU de primer nivel para garantizar la ejecución eficiente de las tareas de IA.

- Despliegue rápidoSoporta desarrollo nativo en Python para un rápido despliegue de modelos sin tener que aprender contenedores o Kubernetes.

- API flexibleAPI: Proporciona una API sencilla y flexible que facilita la invocación de modelos de IA en cualquier aplicación.

- Expansión horizontalEscalado horizontal: admite el escalado horizontal para gestionar cargas de trabajo a gran escala.

Utilizar la ayuda

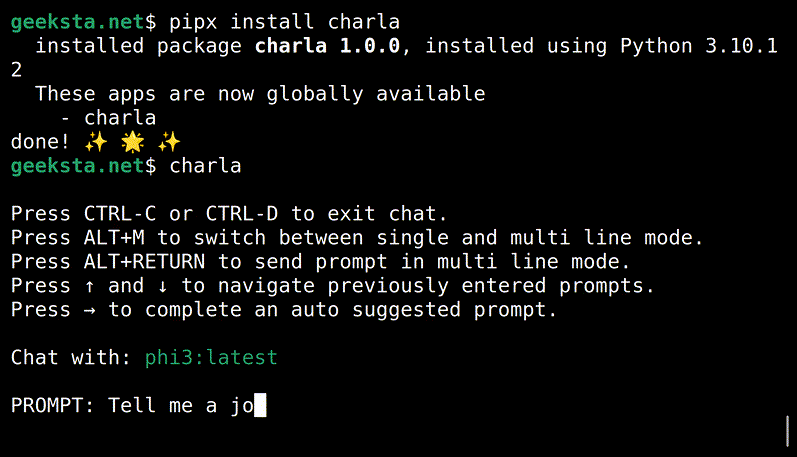

Instalación y uso

- Registrar una cuentaVisite el sitio web de Lepton AI, haga clic en el botón "Registrarse" y rellene la información pertinente para completar su inscripción.

- Crear un proyectoDespués de conectarse, vaya a "Panel de control", haga clic en "Crear proyecto", introduzca el nombre y la descripción del proyecto.

- Selección de recursos informáticosEn la configuración del proyecto, seleccione los recursos informáticos necesarios, incluidos el tipo y el número de GPU.

- Subir modeloEn "Gestión de modelos", haga clic en "Cargar modelo" y seleccione el archivo de modelo local que desea cargar.

- Entorno de configuraciónEn "Configuración del entorno", seleccione el entorno de ejecución y los paquetes de dependencias necesarios.

- modelo de despliegueHaga clic en "Desplegar", el sistema desplegará automáticamente el modelo y generará la interfaz API.

- Llamada a la APIEn "Documentación de la API", consulte la documentación de la interfaz de la API generada y utilice el modelo de llamada a la API proporcionado para razonar.

flujo de trabajo

- formación de modelosEl entrenamiento del modelo se realiza localmente con Python para garantizar que el modelo funciona como se espera.

- prueba de modelos: Realiza pruebas de modelos a nivel local para verificar la precisión y estabilidad del modelo.

- Subir modeloCarga de modelos entrenados en la plataforma Lepton AI para su despliegue en línea.

- Configuración del entornoConfigure el entorno de ejecución y los paquetes de dependencias de acuerdo con los requisitos del modelo para garantizar que éste se ejecuta correctamente.

- Llamada APIUtilizar la interfaz API generada para llamar al modelo de inferencia en la aplicación y obtener los resultados en tiempo real.

- Control y mantenimiento: En la página "Monitor", puede ver el estado de funcionamiento del modelo y los indicadores de rendimiento para realizar el mantenimiento y la optimización oportunos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...