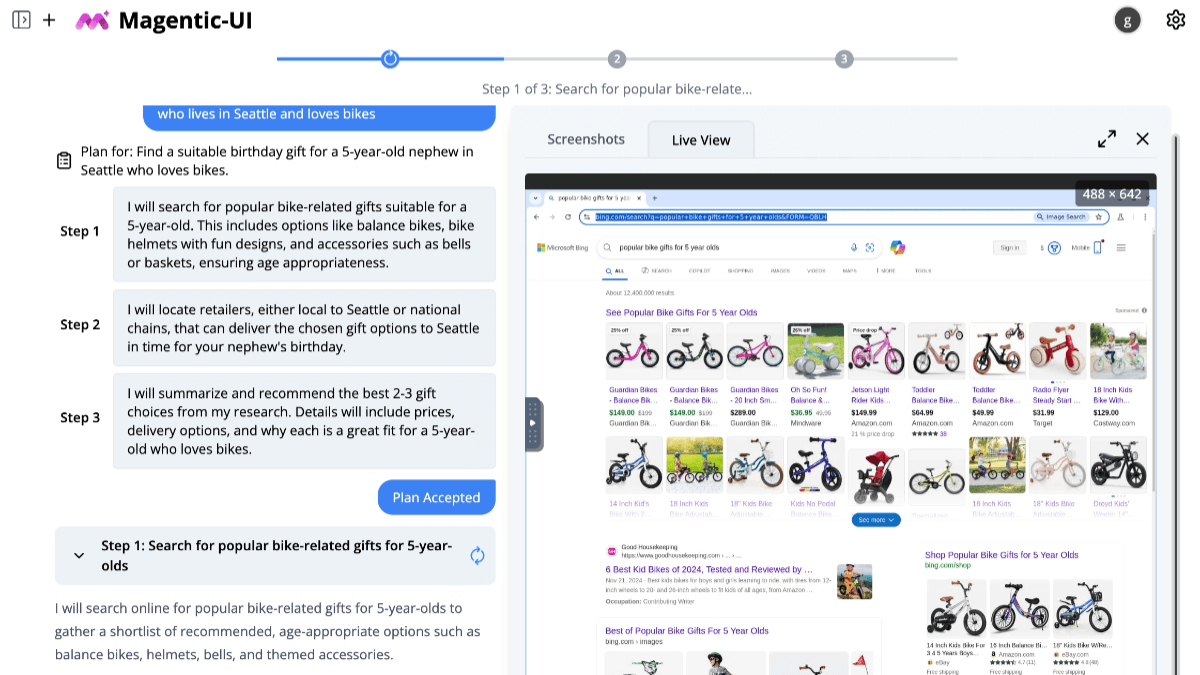

kun-lab: un cliente de diálogo nativo y ligero basado en Ollama

Últimos recursos sobre IAPublicado hace 10 meses Círculo de intercambio de inteligencia artificial 50.3K 00

Introducción general

kun-lab es un programa basado en la Ollama es una aplicación de diálogo de IA de código abierto centrada en ofrecer una experiencia de diálogo inteligente ligera, rápida y localizada. Es compatible con Windows, macOS y Linux (Windows es actualmente el objetivo principal) y no requiere ninguna configuración compleja para su uso. Los usuarios pueden mantener conversaciones fluidas de varias rondas con la IA, analizar documentos, identificar imágenes e incluso buscar respuestas en línea. Todos los datos se almacenan localmente por motivos de privacidad y seguridad. kun-lab también ofrece renderizado de código, plantillas de instrucciones y una interfaz multilingüe para desarrolladores, estudiantes o quienes necesiten una herramienta de IA eficiente.

Lista de funciones

- diálogo inteligente: Admite varias rondas de diálogo en tiempo real, respuesta fluida de la IA y búsqueda en red para obtener respuestas más completas.

- resolución de documentos: Cargar archivos PDF, DOC, PPT, TXT, AI Comprender el contenido y responder a las preguntas.

- reconocimiento de imágenes: Reconoce imágenes JPG, PNG, extrae texto o analiza escenas, admite el diálogo multirronda.

- gestión de modelos: Cambia fácilmente entre los modelos Ollama o Hugging Face, compatible con los formatos GGUF y safetensores.

- Plantillas de palabras clavePlantillas integradas y posibilidad de personalización para inspirar la creatividad de la IA.

- Renderizado de código: Resalte automáticamente varios códigos de lenguaje de programación para una presentación clara.

- Notas rápidasSoporta sintaxis Markdown, previsualización en tiempo real y exportación con un solo clic.

- soporte multiusuarioPermite que varias personas se conecten al mismo tiempo, cada una con su propio espacio de diálogo.

- interfaz multilingüe: Soporta chino, inglés y otros idiomas, operación más amigable.

Utilizar la ayuda

kun-lab es una herramienta de diálogo de inteligencia artificial con multitud de funciones, que se ejecuta en Ollama, es fácil de manejar y adecuada para uso local. A continuación encontrará una descripción detallada del proceso de instalación, las funciones principales y los pasos iniciales para ayudar a los usuarios a dominarla rápidamente.

Instalar kun-lab

kun-lab proporciona tanto la aplicación de escritorio como el despliegue del código fuente. Actualmente, la aplicación de escritorio solo es compatible con Windows, y el despliegue del código fuente es compatible con Windows, macOS y Linux.

Modo 1: Aplicación de escritorio (recomendado)

- Visite la página de publicación de GitHub (https://github.com/bahamutww/kun-lab/releases).

- Descargue el paquete de instalación adecuado para su sistema:

- Ventanas:

.exeDocumentación. - macOS:

.dmgDocumentación (apoyo futuro). - Linux:

.AppImagetal vez.debDocumentación (apoyo futuro).

- Ventanas:

- Haga doble clic en el paquete de instalación y siga las instrucciones para completar la instalación.

- Tras la instalación, haga clic en el icono del escritorio para ejecutar kun-lab sin configuración adicional.

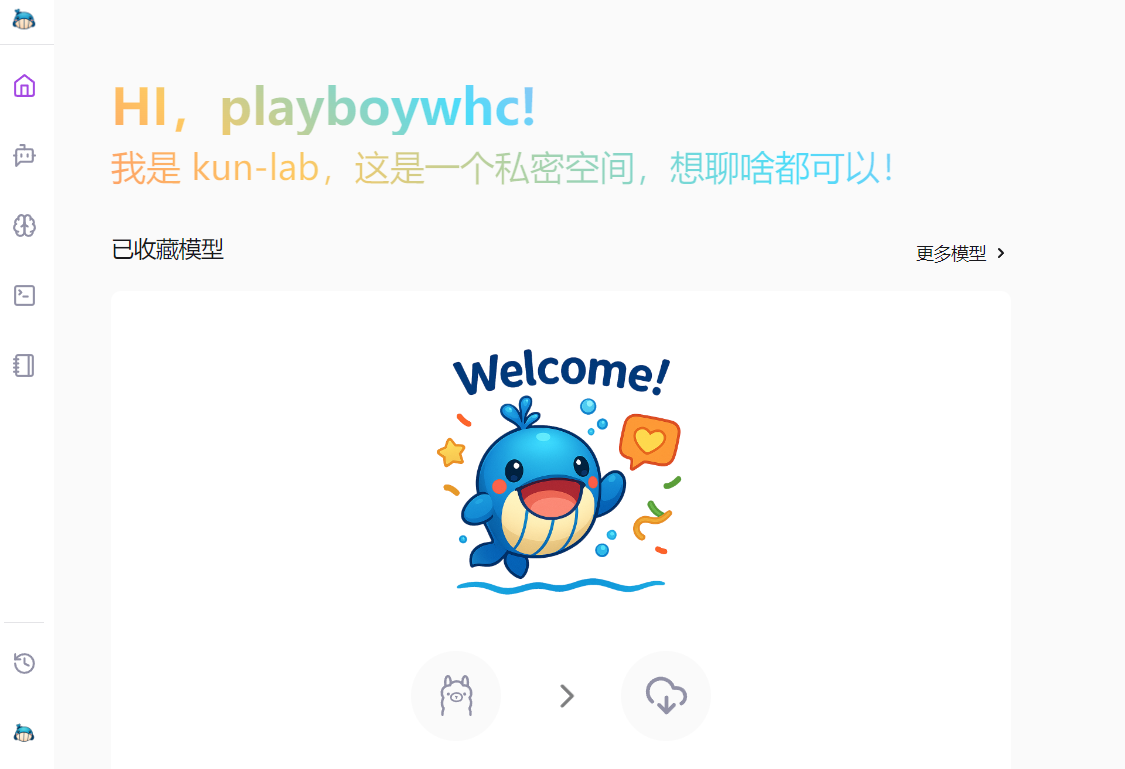

- Una vez iniciada, selecciona el idioma (chino por defecto) y entra en la interfaz principal.

Método 2: Implantación del código fuente

Si quieres personalizar o desarrollar, tienes que instalar el entorno y ejecutar el código. A continuación se detallan los pasos a seguir:

- Preparar el entorno::

- Asegúrese de que el sistema es Windows, macOS o Linux.

- Instale Python 3.10 o posterior (descargar: https://www.python.org).

- Instale Node.js 20.16.0 o posterior (descarga: https://nodejs.org).

- Instale Ollama e inicie el servicio (referencia: https://ollama.com).

- almacén de clones::

git clone https://github.com/bahamutww/kun-lab.git cd kun-lab - Creación de un entorno virtual::

python -m venv venv .\venv\Scripts\activate # Windows # source venv/bin/activate # macOS/Linux - Instalación de dependencias de back-end::

cd backend pip install -r requirements.txt - Instalación de las dependencias del front-end::

cd frontend npm install - Configuración de variables de entorno::

cp .env.example .env- Abrir con un editor de texto

.envmodifique la configuración (por ejemplo, el número de puerto) según sea necesario.

- Abrir con un editor de texto

- lanzar una aplicación::

python run_dev.py - Abra su navegador y visite http://localhost:5173 para empezar.

Función principal Operación

A continuación se describen las principales funciones de kun-lab y los procedimientos específicos de funcionamiento para que los usuarios puedan empezar a utilizarlo fácilmente.

1. Diálogo inteligente

- Iniciar el diálogo::

- Abre kun-lab y haz clic en "Diálogo de chat" o "Nuevo diálogo".

- Seleccione un modelo en la lista de modelos (por defecto aparecen los modelos proporcionados por Ollama).

- Introduzca una pregunta y la IA responderá en tiempo real.

- Búsqueda en Internet::

- Si la pregunta requiere información actualizada, marque la casilla "Activar búsqueda en la web".

- La IA combinará los datos de la página web para responder con una respuesta más completa.

- Gestión de la historia::

- Las conversaciones se guardan automáticamente y pueden consultarse haciendo clic en "Historial" en la barra lateral.

- Un diálogo puede borrarse o exportarse.

- Soporte de código::

- Introduzca una pregunta relacionada con el código y AI mostrará el código en un formato resaltado.

- Compatibilidad con Python, JavaScript y otros lenguajes.

2. Análisis sintáctico de documentos

- Cargar un documento::

- Haga clic en la pantalla Diálogos de documentos.

- Haga clic en el botón "Cargar" y seleccione un archivo PDF, DOC, PPT o TXT.

- Una vez analizado el documento, la IA muestra un resumen del mismo.

- hacer preguntas::

- Introduzca una pregunta relacionada con el documento en el cuadro de diálogo.

- La IA responde basándose en el contenido y facilita la contextualización.

- Buscar contenido::

- Introduzca palabras clave y la IA localizará rápidamente la parte pertinente del documento.

- Haga clic en los resultados para saltar a la ubicación del artículo original.

3. Reconocimiento de imágenes

- Subir una foto::

- Vaya a la página "Diálogo de imágenes".

- Haga clic en "Cargar imagen" y seleccione un archivo JPG, PNG o JPEG.

- La IA reconoce automáticamente escenas o extrae texto.

- diálogo a varias bandas::

- Hacer preguntas basadas en imágenes, como "¿Qué hay en esta imagen?". .

- Después de que la IA haya respondido, puedes seguir haciendo preguntas más profundas.

- Funciones OCR::

- Si la imagen contiene texto, AI lo extraerá y lo mostrará.

- Se puede copiar texto o hacer preguntas basadas en texto.

4. Gestión de modelos

- modelo pull::

- Vaya a la página Biblioteca de modelos.

- Haga clic en "Pull Model".

- Introduzca comandos como

ollama run qwq:32btal vezollama run hf.co/Qwen/QwQ-32B-GGUF:Q2_K. - Espera a que se complete la descarga y el modelo esté listo para su uso.

- Cambiar de modelo::

- En la página de diálogo, haga clic en el menú desplegable Modelo.

- Seleccione el modelo descargado para cambiar inmediatamente.

- Modelos personalizados::

- Haga clic en el botón "Personalizar".

- Introduzca el nombre del modelo y la indicación del sistema (por ejemplo, "Play Maths Teacher").

- Seleccione el modelo base y haga clic en "Crear".

5. Gestión de las señales

- Uso de plantillas::

- Abra la pantalla "Avisos".

- Navegue por las plantillas incorporadas, como "Redactar esquema de artículo" o "Depuración de código".

- Haga clic en la plantilla para aplicarla directamente al diálogo.

- Tacos personalizados::

- Haga clic en "Nueva Cue".

- Introduzca el nombre y el contenido, guárdelo y, a continuación, podrá ordenarlo y gestionarlo.

- Aplicaciones rápidas::

- Durante un diálogo, selecciona la palabra clave y la IA responderá según lo establecido.

6. Notas rápidas

- Creación de notas::

- Haga clic en la página Notas.

- Introduzca contenido en formato Markdown, como un título, una lista o un código.

- Previsualización en tiempo real del efecto en la parte derecha.

- Exportar notas::

- Haz clic en el botón "Exportar" y guarda como

.mdDocumentación. - Se puede compartir o importar en otras herramientas.

- Haz clic en el botón "Exportar" y guarda como

advertencia

- Asegúrese de que el servicio Ollama está en funcionamiento, de lo contrario la función AI no estará disponible.

- Es posible que se tarde un poco en sacar el modelo por primera vez y se recomienda comprobar la conexión a Internet.

- Los datos almacenados localmente ocupan mucho espacio y periódicamente se limpia el historial.

- Si tiene problemas, consulte la página de GitHub

issueso envíe sus comentarios.

Siguiendo estos pasos, podrá instalar y utilizar fácilmente las funciones de kun-lab. Ya se trate de diálogo, análisis sintáctico de documentos o análisis de imágenes, el funcionamiento es intuitivo y cómodo.

escenario de aplicación

- Asistente personal de aprendizaje

Los estudiantes pueden utilizar kun-lab para analizar cursos o libros de texto, hacer preguntas y la IA las responderá en detalle. Sube folletos de matemáticas y la IA te explicará las fórmulas paso a paso. - Herramientas para desarrolladores

Los programadores pueden utilizar kun-lab para depurar código o aprender un nuevo lenguaje. Introduzca un fragmento de código y la IA le ofrecerá sugerencias de optimización y las resaltará. - Documentación

Los profesionales pueden resumir informes rápidamente con la función de análisis sintáctico de documentos. Carga PPT largos, AI extrae los puntos clave y genera notas concisas. - Exploración creativa

Los creadores pueden generar historias o inspiración para el diseño con plantillas de palabras rápidas. Sube bocetos que la IA analiza y sugiere mejoras.

CONTROL DE CALIDAD

- ¿Necesita kun-lab conexión a Internet?

Las funciones principales se ejecutan localmente y no requieren conexión en red. La función de búsqueda en Internet es opcional y debe activarse manualmente. - ¿Qué formatos de documento son compatibles?

Admite archivos PDF, DOC, PPT y TXT, y es posible que se amplíe a más formatos en el futuro. - ¿Cómo añado un nuevo modelo?

En la pantalla Biblioteca de modelos, introduzcaollama runcomando para sacar un modelo Ollama o Cara de Abrazo. - ¿Están seguros los datos?

Todos los datos se almacenan localmente y no se suben a la nube para garantizar la privacidad y la seguridad.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...