KTransformers: motor de rendimiento para la inferencia de grandes modelos: aceleración extrema, potenciación flexible

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 64K 00

Introducción general

KTransformers: Un framework Python de alto rendimiento diseñado para romper el cuello de botella de la inferencia de grandes modelos. KTransformers es más que una simple herramienta de ejecución de modelos, es un conjunto de motor de optimización de rendimiento extremo y plataforma de potenciación de interfaz flexible. KTransformers se dedica a mejorar la eficiencia de la inferencia de grandes modelos desde la base, acelerando significativamente la velocidad de inferencia de modelos y reduciendo el umbral de hardware mediante la optimización avanzada del núcleo, potentes estrategias de paralelismo (multi-GPU, atención dispersa) y otras tecnologías básicas.

Más allá de la simple ejecución de modelos, KTransformers ofrece una gama completa de mejoras de rendimiento y escalabilidad de aplicaciones. No solo obtendrá una interfaz nativa compatible con Transformers para migrar sin problemas sus proyectos existentes, sino que también podrá crear fácilmente aplicaciones compatibles con OpenAI y Ollama para una rápida integración en todo tipo de aplicaciones. También proporcionamos ChatGPT Interfaz web estilizada para experimentar y probar rápidamente los efectos del modelo sin tediosas configuraciones.

KTransformers está diseñado para usuarios que exigen más rendimiento. Tanto si es usted un desarrollador que busca lo último en velocidad de razonamiento, un ingeniero que necesita desplegar eficazmente aplicaciones de modelos de gran tamaño o un usuario que desea experimentar fácilmente modelos de gran tamaño de alto rendimiento de forma local, KTransformers le ofrece un potente soporte para liberar todo el potencial de los modelos de gran tamaño para impulsar aplicaciones innovadoras.

Puntos fuertes:

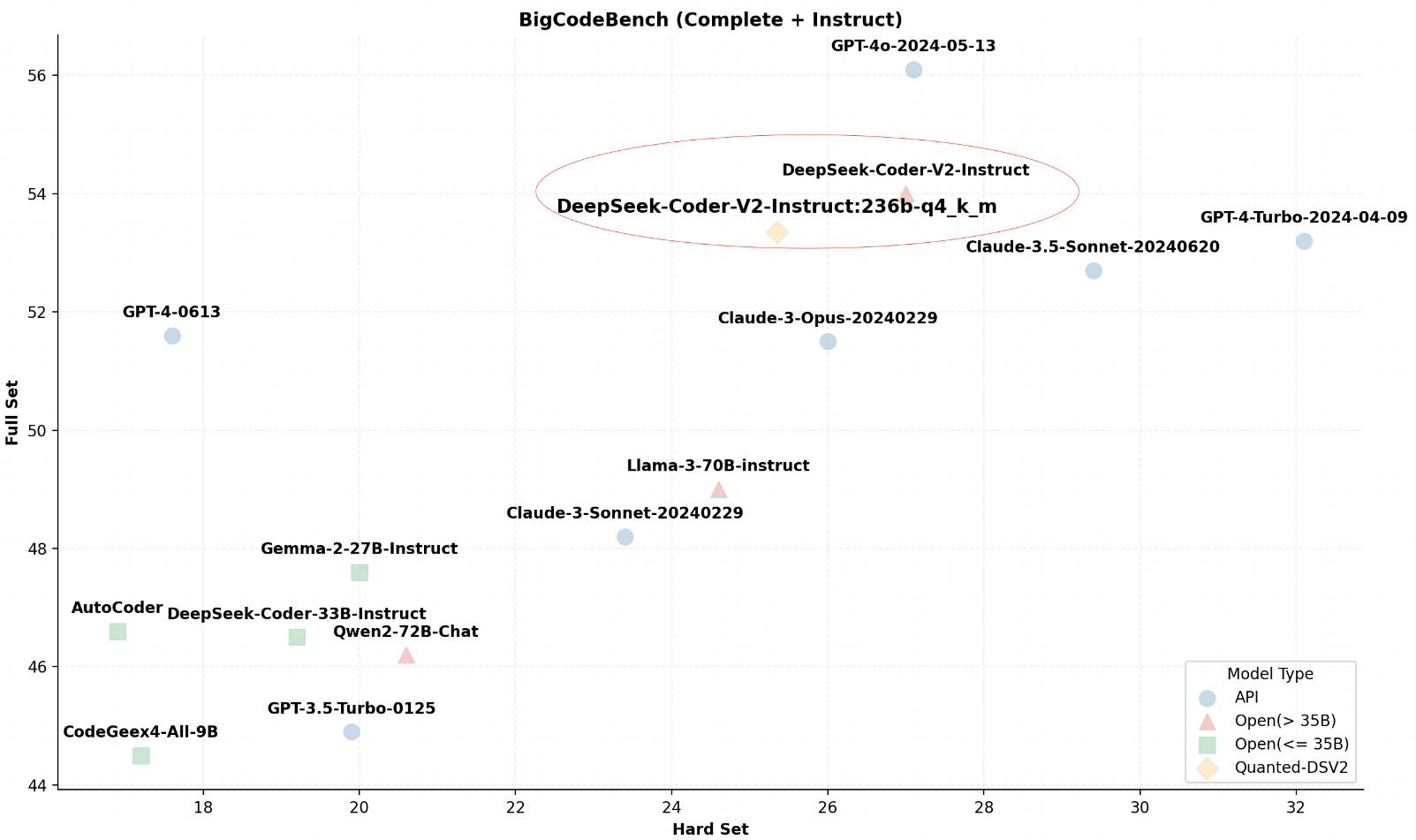

- Rendimiento extremo: Las optimizaciones a nivel de núcleo y las estrategias paralelas aportanRazonamiento un orden de magnitud más rápido.

- Interfaces flexibles: Interfaces compatibles con Transformers, API RESTful e interfaces web.Satisfacen las necesidades de diferentes escenarios de aplicación.

- Ampliamente compatible: Admite varias GPU, varias arquitecturas de CPU y varios macromodelos principales.Admite una amplia gama de opciones de hardware y modelado.

- La facilidad de uso va de la mano de la personalización: existenteComodidad lista para usarTambién disponibleAmplias opciones de configuraciónpara satisfacer las necesidades de optimización en profundidad de los usuarios avanzados.

Lista de funciones

- Transformadores de alto rendimiento Interfaz compatible : proporciona una interfaz totalmente compatible con la biblioteca Transformers.Migre los proyectos existentes a coste cero y disfrute de mejoras de rendimiento al instante..

- Servicios API RESTful flexibles y fáciles de usar : Siguiendo los estándares OpenAI y Ollama.Cree rápidamente servicios API escalablesLos productos de la empresa están diseñados para integrarse fácilmente en diversas aplicaciones y plataformas.

- Interfaz web inmediata al estilo ChatGPT : Proporcionar una interfaz amigable e interactiva.Cero código para experimentar y probar rápidamente el rendimiento del modelopara facilitar la demostración y la validación.

- Motor de cálculo paralelo multi-GPU :: Libera la potencia de varias GPUsmejorando linealmente la velocidad de inferencia y reduciendo drásticamente el tiempo de respuesta.

- Optimización profunda del rendimiento del núcleo Utilización de técnicas avanzadas de optimización de núcleos.Aprovechar el potencial del hardware desde la baselogrando un salto cualitativo en el rendimiento de la inferencia de modelos.

- Marco de atención dispersa inteligente : compatibilidad con el mecanismo de atención dispersa por bloques.Huella de memoria significativamente reduciday admite una descodificación eficiente de la CPU.Superar los cuellos de botella del hardware.

- Amplio soporte ecológico para modelos de gran tamaño Compatible con InternLM, DeepSeek-Coder, etc.Una variedad de modelos de gran tamaño (en expansión continua).Flexibilidad para elegir la mejor solución de modelización.

- Razonamiento local ligero de alto rendimiento Sin necesidad de costosos equipos especializados.Rendimiento de inferencia superior en un entorno de escritorio comúnreduciendo el umbral de uso.

Utilizar la ayuda

montaje

- almacén de clones ::

git clone https://github.com/kvcache-ai/ktransformers.git

cd ktransformers

- Instalación de dependencias ::

pip install -r requirements-local_chat.txt

- Instalación de transformadores K ::

python setup.py install

Primeros pasos

- Modelos de carga ::

from ktransformers import KTransformers

model = KTransformers(model_name="your_model_name")

- Ejemplo de razonamiento ::

input_text = "你好,KTransformers!"

output = model.infer(input_text)

print(output)

- Uso de la API RESTful Inicia el servicio API:

python -m ktransformers.api

Enviar solicitud:

curl -X POST "http://localhost:8000/infer" -d '{"text": "你好,KTransformers!"}'

Funciones avanzadas

- Soporte Multi-GPU Editar el archivo de configuración en el directorio raíz del proyecto

config.yamlespecifica la configuración multi-GPU para mejorar la velocidad de inferencia. - poca capacidad de atención Archivo de configuración en el directorio raíz del proyecto

config.yamlAñade una configuración de atención dispersa para optimizar el uso de la memoria, especialmente en entornos con recursos limitados. - inferencia local Archivo de configuración en el directorio raíz del proyecto

config.yamlEspecifique los parámetros de memoria y memoria de vídeo para una inferencia eficaz en un entorno de escritorio local, compatible con 24 GB de VRAM y 150 GB de DRAM.

Detalles de configuración

- Configuración de varias GPU : Editar archivo de configuración

config.yaml::

gpu:

- id: 0 # GPU 设备索引 0

- id: 1 # GPU 设备索引 1

- Atención dispersa : Añádelo en el archivo de configuración:

attention:

type: sparse

- Ajustes de razonamiento local : Especifique los parámetros de memoria y memoria de vídeo en el archivo de configuración:

memory:

vram: 24GB # 显存限制 (GB),根据实际情况调整

dram: 150GB # 内存限制 (GB),根据实际情况调整© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...