II-Researcher: búsqueda profunda y razonamiento por pasos para responder a preguntas complejas

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 49.2K 00

Introducción general

II-Researcher es una herramienta de investigación de IA de código abierto desarrollada por el equipo Intelligent-Internet y alojada en GitHub, diseñada para la búsqueda profunda y el razonamiento complejo, capaz de responder a preguntas complejas mediante la búsqueda inteligente en la web y el análisis en varios pasos. Lanzado el 27 de marzo de 2025, el proyecto es compatible con múltiples herramientas de búsqueda y rastreo (por ejemplo, Tavily, SerpAPI, Firecrawl) e integra LiteLLM para llamar a diferentes modelos de IA. Los usuarios pueden obtener el código gratuitamente y desplegarlo o modificarlo por sí mismos, lo que resulta idóneo para investigadores, desarrolladores y otras personas que necesiten un procesamiento eficaz de la información. Su núcleo radica en el código abierto, configurable y de funcionamiento asíncrono, proporcionando un apoyo transparente a la investigación.

Lista de funciones

- Búsqueda inteligente en Internet: a través de Tavily y SerpAPI para obtener información precisa.

- Rastreo y extracción de páginas web: Soporta Firecrawl, Browser, BS4 y otras herramientas para extraer contenidos.

- Razonamiento en varios pasos: capacidad para descomponer un problema y razonar paso a paso hasta llegar a una respuesta.

- Modelos configurables: soporte para ajustar los LLM a diferentes tareas (por ejemplo, GPT-4o, DeepSeek).

- Operaciones asíncronas: mejora de la eficacia de la búsqueda y el procesamiento.

- Genere respuestas detalladas: proporcione informes completos con referencias.

- Canalizaciones personalizadas: los usuarios pueden ajustar el proceso de búsqueda y razonamiento.

Utilizar la ayuda

Proceso de instalación

Para utilizar II-Researcher, es necesario instalar y configurar el entorno. A continuación se indican los pasos específicos:

- Clonación del código base

Introduzca el siguiente comando en el terminal para descargar el código:

git clone https://github.com/Intelligent-Internet/ii-researcher.git

cd ii-researcher

- Instalación de dependencias

El proyecto requiere Python 3.7+. Ejecute el siguiente comando para instalar las dependencias:

pip install -e .

- Configuración de variables de entorno

Configure las claves y parámetros API necesarios. Ejemplo:

export OPENAI_API_KEY="your-openai-api-key"

export TAVILY_API_KEY="your-tavily-api-key"

export SEARCH_PROVIDER="tavily"

export SCRAPER_PROVIDER="firecrawl"

Configuración opcional (para compresión o inferencia):

export USE_LLM_COMPRESSOR="TRUE"

export FAST_LLM="gemini-lite"

export STRATEGIC_LLM="gpt-4o"

export R_TEMPERATURE="0.2"

- Ejecución del servidor local de modelos LiteLLM

Instala LiteLLM:

pip install litellm

Creación de archivos de configuración litellm_config.yaml::

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_key: ${OPENAI_API_KEY}

- model_name: r1

litellm_params:

model: deepseek-reasoner

api_key: ${OPENAI_API_KEY}

litellm_settings:

drop_params: true

Inicie el servidor:

litellm --config litellm_config.yaml

Por defecto se ejecuta en el http://localhost:4000.

- Despliegue en Docker (opcional)

Después de configurar las variables de entorno, ejecútelo:

docker compose up --build -d

Dirección de servicio:

- Parte delantera:

http://localhost:3000 - API de backend:

http://localhost:8000 - LiteLLM:

http://localhost:4000

Funciones principales

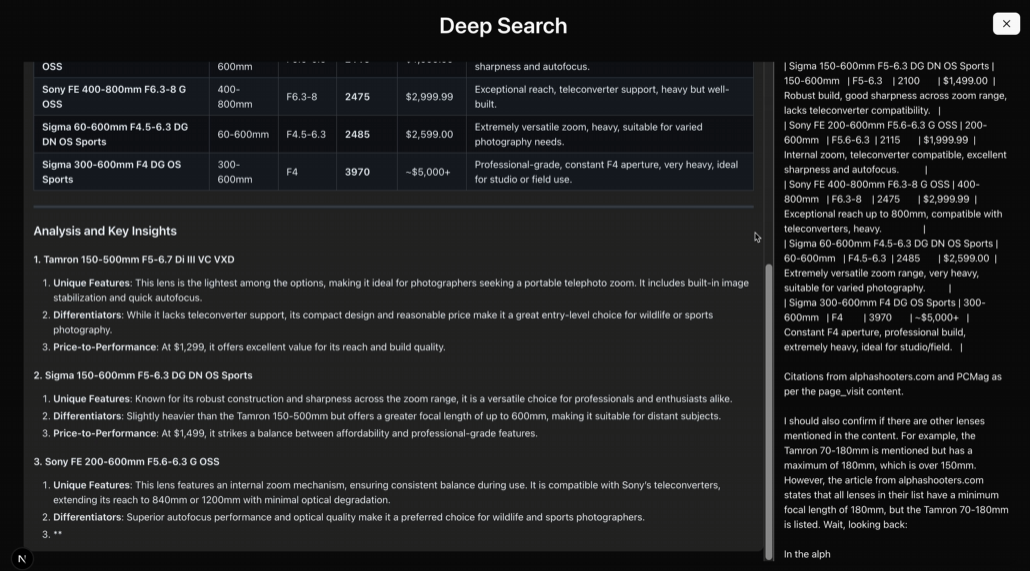

Búsqueda profunda inteligente

- procedimiento::

- Ejecútalo desde la línea de comandos:

python cli.py --question "AI如何改善教育质量?"

- El sistema llama a Tavily o SerpAPI para buscar y devolver resultados.

- Descripción funcional: Admite búsquedas multifuente, adecuadas para problemas complejos.

razonamiento multipaso

- procedimiento::

- Utilizar el modelo de inferencia:

python cli.py --question "AI在教育中的优缺点" --use-reasoning --stream

- El sistema analiza y emite conclusiones paso a paso.

- Descripción funcionalPuede realizar tareas que requieran deducción lógica.

rastreador web

- procedimiento::

- configure

SCRAPER_PROVIDER="firecrawl"y la clave API. - Ejecute una tarea de búsqueda para rastrear automáticamente contenidos web.

- Descripción funcional: Admite múltiples herramientas de rastreo para garantizar un contenido completo.

Uso de la interfaz web

- procedimiento::

- Inicie la API backend:

python api.py

- entrar en

frontendinstale y ejecute el front-end:

npm install

npm run dev

- entrevistas

http://localhost:3000problemas de entrada.

- Descripción funcional: Proporciona una interfaz gráfica para un funcionamiento más intuitivo.

advertencia

- Para acceder a la API se necesita una conexión de red estable.

- Requisitos de hardware: 8 GB de RAM para las funciones básicas, 16 GB o más y GPU recomendada para la inferencia de modelos de gran tamaño.

- Comprobación de registros: compruebe los registros con la función

docker compose logs -fCompruebe el estado de funcionamiento. - Configuración del tiempo de espera: Tiempo de espera de búsqueda por defecto 300 segundos, ajustable

SEARCH_PROCESS_TIMEOUT.

Con estos pasos, los usuarios pueden desplegar y utilizar fácilmente II-Researcher para el proceso completo, desde la búsqueda hasta la inferencia.

escenario de aplicación

- investigación académica

Los investigadores pueden utilizarlo para buscar bibliografía, analizar datos y generar informes. - desarrollo tecnológico

Los desarrolladores pueden crear herramientas de búsqueda personalizadas basadas en el marco. - Ayudas educativas

Los alumnos pueden utilizarlo para organizar la información y responder a preguntas. - análisis del mercado

Las empresas pueden utilizarlo para recopilar información del sector y generar análisis de tendencias.

CONTROL DE CALIDAD

- ¿II-Researcher es gratuito?

Sí, es un proyecto de código abierto y el código es gratuito para los usuarios. - ¿Necesita una base de programación?

Requiere conocimientos básicos de las operaciones con Python, pero la documentación es lo suficientemente detallada como para que los principiantes puedan empezar. - ¿Es compatible con el chino?

Soporte, configure el modelo y la herramienta de búsqueda adecuados para gestionar la tarea china. - ¿Cuáles son los requisitos mínimos de hardware?

8 GB de RAM para ejecutar funciones básicas, más de 16 GB y GPU recomendados para tareas de gran envergadura.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...