De las redes neuronales a la cara abrazada: breve historia de las redes neuronales y el aprendizaje profundo

Base de conocimientos de IAPublicado hace 2 años Círculo de intercambio de inteligencia artificial 51.5K 00

TL;DR Este artículo tiene más de 8200 palabras y se tarda unos 15 minutos en leerlo entero. Este artículo repasa brevemente las últimas aplicaciones de los grandes modelos, desde las máquinas perceptivas hasta el aprendizaje profundo ChatGPT La historia de la

Original: https://hutusi.com/articles/the-history-of-neural-networks

No hay nada que temer en la vida, sólo cosas que comprender.

-- Sra. Curie

I Redes de creencias profundas

En 2006, Jeffrey Hinton, profesor de la Universidad de Toronto (Canadá), investigaba cómo entrenar redes neuronales multicapa, y lleva más de tres décadas trabajando en silencio en el campo de las redes neuronales. Aunque se le considera una figura titánica en este campo, los resultados de sus investigaciones han sido infravalorados por la industria, porque las redes neuronales han sido infravaloradas en la industria de la inteligencia artificial.

Nacido en Londres (Inglaterra), de su familia salieron varios eminentes eruditos, entre ellos George Boole, el lógico que fundó el álgebra de Boole, que era su tatarabuelo. Su abuelo era escritor científico y su padre entomólogo. Hinton era más inteligente que todos los que le rodeaban, pero su camino por la escuela fue un poco cuesta arriba: primero estudió arquitectura en la universidad, luego física, después filosofía y, finalmente, se licenció en Psicología. En 1972, Hinton ingresó en la Universidad de Edimburgo para hacer un doctorado en Redes Neuronales, que en aquella época se consideraba el campo más popular de la industria. En aquella época, las redes neuronales eran despreciadas por la industria, e incluso los supervisores de Hinton pensaban que tenían poca utilidad práctica y ningún futuro. Sin embargo, Hinton no se inmutó y tuvo fe en la investigación de redes neuronales, insistiendo en que podía demostrar el valor de las redes neuronales, en lo que insistió durante más de 30 años.

Hinton sufrió una hernia discal en la columna lumbar cuando era joven y trasladaba un calentador, y desde entonces padece problemas lumbares. En los últimos años, el problema ha empeorado, y la mayor parte del tiempo necesita tumbarse boca arriba para aliviar el dolor, lo que significa que no puede conducir, ni volar, ni siquiera tumbarse en una cama plegable en su oficina cuando se reúne con estudiantes en el laboratorio. El dolor físico del calvario no afectó tanto a Hinton como la indiferencia hacia la investigación académica. Ya en 1969, Minsky, en su libro Perceptual Machines, estableció la ley sobre las máquinas perceptivas multicapa, poniendo un sello de aprobación a la investigación posterior sobre redes neuronales: "No habrá futuro para las máquinas perceptivas multicapa porque nadie en el mundo puede entrenar una máquina perceptiva multicapa lo suficientemente bien, ni siquiera para hacerla capaz de aprender los métodos más simples de funcionamiento." La limitada capacidad de los perceptrones monocapa, que ni siquiera pueden resolver problemas básicos de clasificación como la "heteroscedasticidad", y la falta de métodos de entrenamiento disponibles para los perceptrones multicapa, equivale a decir que la dirección de la investigación en redes neuronales es un callejón sin salida. Las redes neuronales se consideraban una herejía académica en la industria, y nadie creía que pudieran tener éxito. Por ello, los estudiantes se cuidaban de pasar por alto las redes neuronales a la hora de elegir a sus supervisores, y durante un tiempo Sinton ni siquiera pudo reclutar suficientes estudiantes de posgrado.

En 1983, Hinton inventó la máquina de Boltzmann y, más tarde, la máquina de Boltzmann simplificada y restringida se aplicó al aprendizaje automático y se convirtió en la base de la estructura jerárquica de las redes neuronales profundas. En 1986, Hinton propuso el algoritmo de retropropagación de errores (BP) para máquinas perceptivas multicapa, un algoritmo que sentó las bases de lo que se convertiría en el aprendizaje profundo. Hinton inventaba algo nuevo cada cierto tiempo, y se empeñó en escribir más de doscientos artículos relacionados con las redes neuronales, aunque no fueran bien recibidos. En 2006, Hinton había acumulado una rica base teórica y práctica, y esta vez publicó un artículo que cambiaría todo el aprendizaje automático y, de hecho, el mundo entero.

Sinton descubrió que las redes neuronales con múltiples capas ocultas pueden tener la capacidad de extraer automáticamente características para el aprendizaje, lo que resulta más eficaz que el aprendizaje automático tradicional con extracción manual de características. Además, la dificultad de entrenar redes neuronales multicapa puede reducirse mediante el preentrenamiento capa por capa, lo que resuelve el viejo problema del entrenamiento de redes neuronales multicapa. Hinton publicó sus resultados en dos artículos en una época en la que el término red neuronal era rechazado por muchos editores de revistas académicas, e incluso se devolvían algunos títulos de manuscritos porque contenían la palabra "red neuronal". Para no irritar la sensibilidad de estas personas, Hinton adoptó un nuevo nombre y bautizó el modelo como "Deep Belief Network" (Red de Creencia Profunda).

II. Sensores

De hecho, la investigación de la red neuronal se remonta a los años 40. En 1940, Walter Pitts, de 17 años, conoció al profesor Warren McCulloch, de 42, en la Universidad de Illinois en Chicago, y se unió al proyecto de investigación de este último: intentar utilizar redes neuronales para construir un modelo mecánico del cerebro basado en operaciones lógicas. Utilizaron operaciones lógicas para abstraer el modelo de pensamiento del cerebro humano, y propusieron el concepto de "Red Neuronal" (Neural Network), y las neuronas son la unidad de procesamiento de información más pequeña de la red neuronal; y abstrajeron y simplificaron el proceso de trabajo de las neuronas en un modelo de operaciones lógicas muy simple, que más tarde se denominó "M El modelo se denominó "M-P Neuron Model" por las iniciales de sus dos nombres.

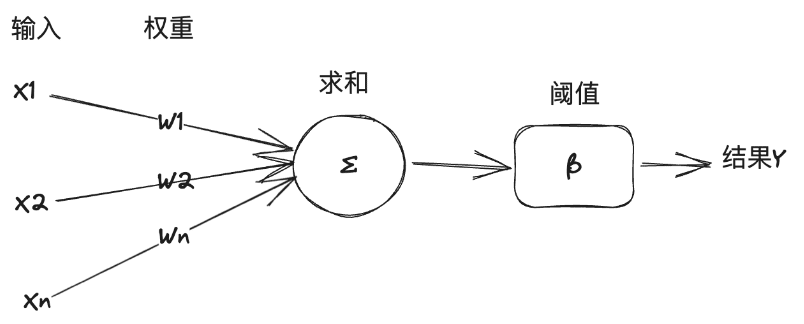

En este modelo, una neurona recibe una serie de señales de entrada de otras neuronas, y la importancia de las señales de entrada varía de una neurona a otra, lo que se representa por el "peso" de la conexión, y la neurona suma todas las entradas de acuerdo con el peso, y compara el resultado con el "Umbral" de la neurona para decidir si emite o no la señal. La neurona suma todas las entradas en función de los pesos y compara el resultado con el "umbral" de la neurona para decidir si emite o no una señal al mundo exterior.

El "modelo M-P" es lo suficientemente simple y directo como para ser modelado por la lógica simbólica, y los expertos en IA lo han utilizado como base para construir modelos de redes neuronales para resolver tareas de aprendizaje automático. He aquí una breve explicación de la relación entre inteligencia artificial, aprendizaje automático y aprendizaje profundo: La inteligencia artificial es el uso de la tecnología informática para alcanzar la inteligencia humana, en el libro de texto general definida como el estudio y la construcción de agentes inteligentes. El agente inteligente es el agente inteligente, o simplemente agente, que resuelve tareas específicas o tareas de propósito general imitando el pensamiento y la cognición humanos. El agente inteligente que resuelve tareas características se conoce como inteligencia artificial débil, o inteligencia artificial estrecha (ANI), mientras que el agente inteligente que resuelve tareas de propósito general se conoce como inteligencia artificial fuerte, o inteligencia artificial de propósito general (AGI). El aprendizaje automático es una rama de la IA que aprende de los datos y mejora los sistemas. El aprendizaje profundo, por su parte, es otra rama del aprendizaje automático, que utiliza técnicas de redes neuronales para el aprendizaje automático.

En 1957, Rosenblatt, profesor de psicología de la Universidad de Cornell, simuló y puso en práctica un modelo de red neuronal, que denominó Perceptrón, en un ordenador IBM. Su planteamiento consistía en reunir un conjunto de neuronas del modelo M-P que pudieran utilizarse para entrenar y realizar algunas tareas de reconocimiento de patrones de visión artificial. En general, el aprendizaje automático tiene dos tipos de tareas: clasificación y regresión. La clasificación es el problema de determinar a qué clase pertenecen los datos, como identificar si una imagen es un gato o un perro, mientras que la regresión es el problema de predecir un dato a partir de otro, como predecir el peso de una persona a partir de su imagen. Los perceptrones resuelven problemas de clasificación lineal. Explícalo con un ejemplo del funcionamiento de las máquinas perceptrón extraído del libro "Las fronteras de la inteligencia":

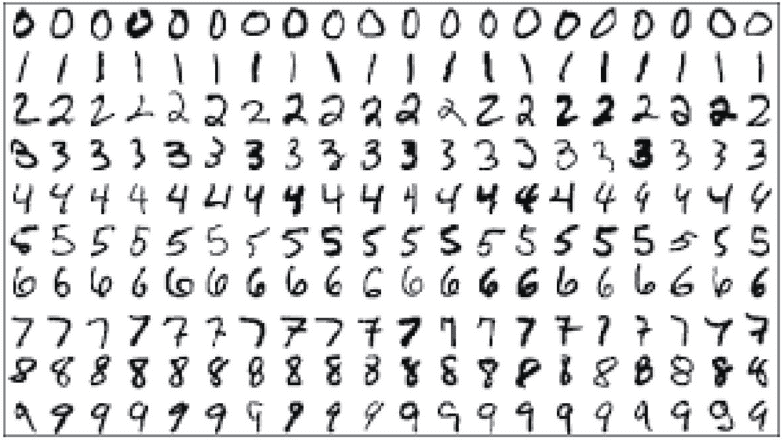

Supongamos que el objetivo de la tarea es reconocer automáticamente números arábigos, los números a reconocer estarán escritos a mano o impresos de diversas formas, los números se almacenarán escaneándolos en un archivo de imagen de 14*14 píxeles de tamaño. En primer lugar, se prepara un conjunto de entrenamiento similar al de la figura siguiente para el aprendizaje automático. El conjunto de entrenamiento es un conjunto de datos que se proporciona especialmente para el aprendizaje por ordenador, no es sólo un conjunto de imágenes y otros datos, sino que se preetiquetará manualmente para indicar a la máquina cuáles son los números representados por los datos de las imágenes.

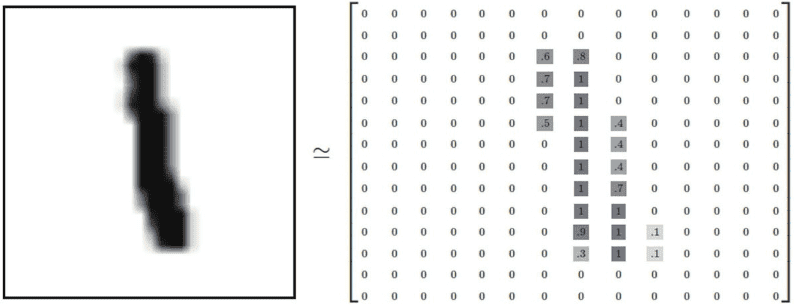

A continuación, tenemos que diseñar una estructura de datos para que la máquina pueda almacenar y procesar estas imágenes. Para una imagen digital en escala de grises de 14*14, los píxeles negros se pueden representar por 1, los blancos por 0, y los píxeles en escala de grises entre el negro y el blanco se representan por un número en coma flotante entre 0-1 dependiendo de su intensidad en escala de grises. Como se muestra en la figura siguiente, esta figura puede convertirse en una matriz tensorial 2D:

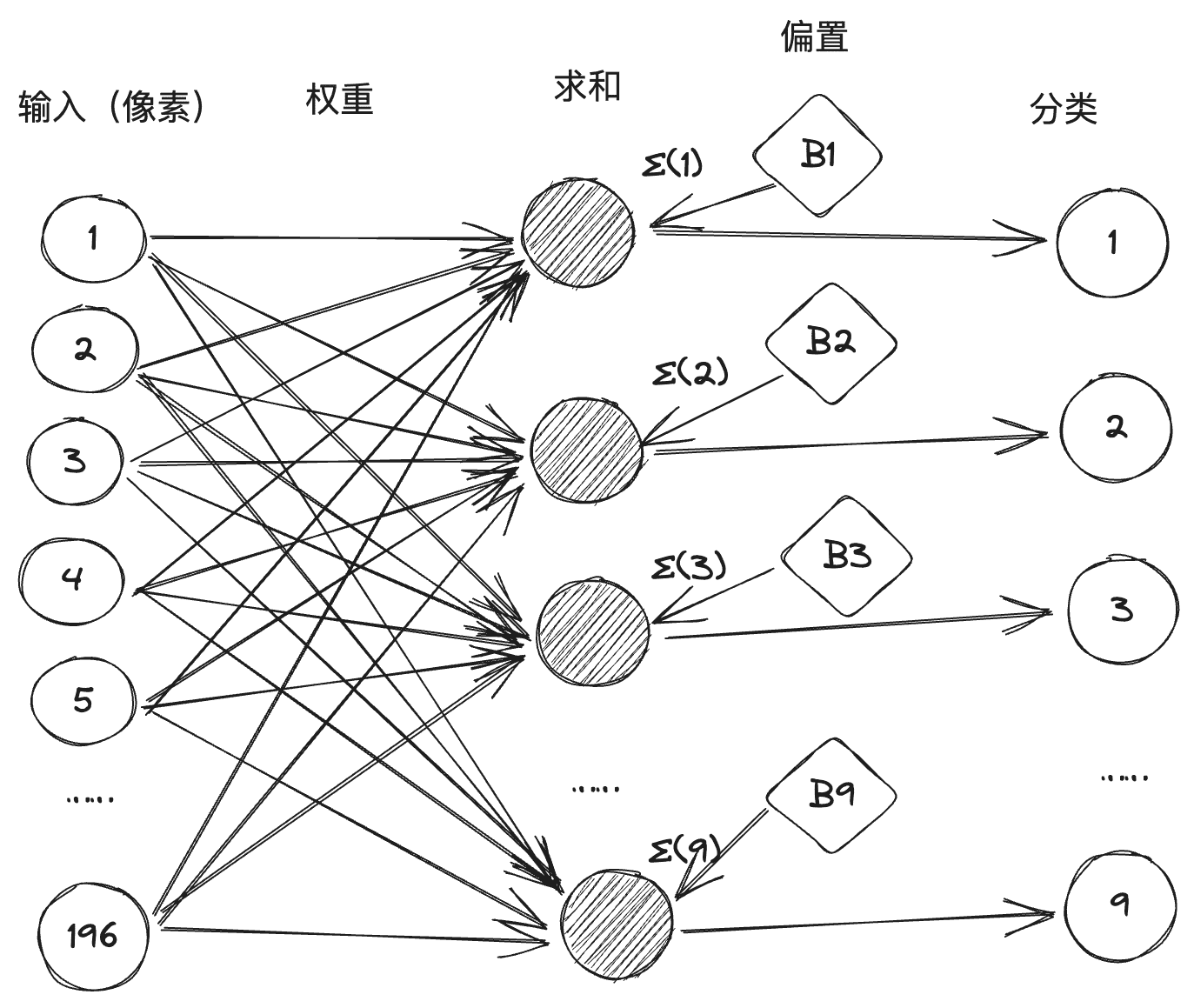

Y la máquina es capaz de reconocer cuáles son los números de la imagen, principalmente encontrando las características de esa imagen que representan un número concreto. A los humanos nos resulta fácil reconocer estos números escritos a mano, pero nos resulta difícil explicar cuáles son esas características. El objetivo del aprendizaje automático es extraer las características de estas imágenes en el conjunto de entrenamiento que representan números y, según el modelo M-P, la forma de extraer las características es elegir ponderar y sumar los valores de los píxeles individuales de la imagen, y calcular el peso de cada píxel correspondiente a cada número basándose en los resultados de la correspondencia entre las imágenes de muestra en el conjunto de entrenamiento y los datos anotados: si un píxel en particular tiene una evidencia muy negativa de que la imagen no pertenece a un número Si un píxel tiene una evidencia muy negativa de que la imagen no pertenece a un determinado número, el peso de ese píxel se establece en un valor negativo para ese número, por el contrario, si un píxel tiene una evidencia muy positiva de que la imagen pertenece a un determinado número, el peso de ese píxel se establece en un valor positivo para ese número. Por ejemplo, para el número "0" el píxel en el punto medio de la imagen no debe tener un píxel negro (1), si aparece entonces la imagen pertenece al número 0 como evidencia negativa, reduce la probabilidad de que la imagen sea el número 0. De este modo, tras el entrenamiento y la calibración del conjunto de datos, la distribución de pesos de cada píxel correspondiente a cada número 0-9 puede obtenerse como 14*14 (=196).

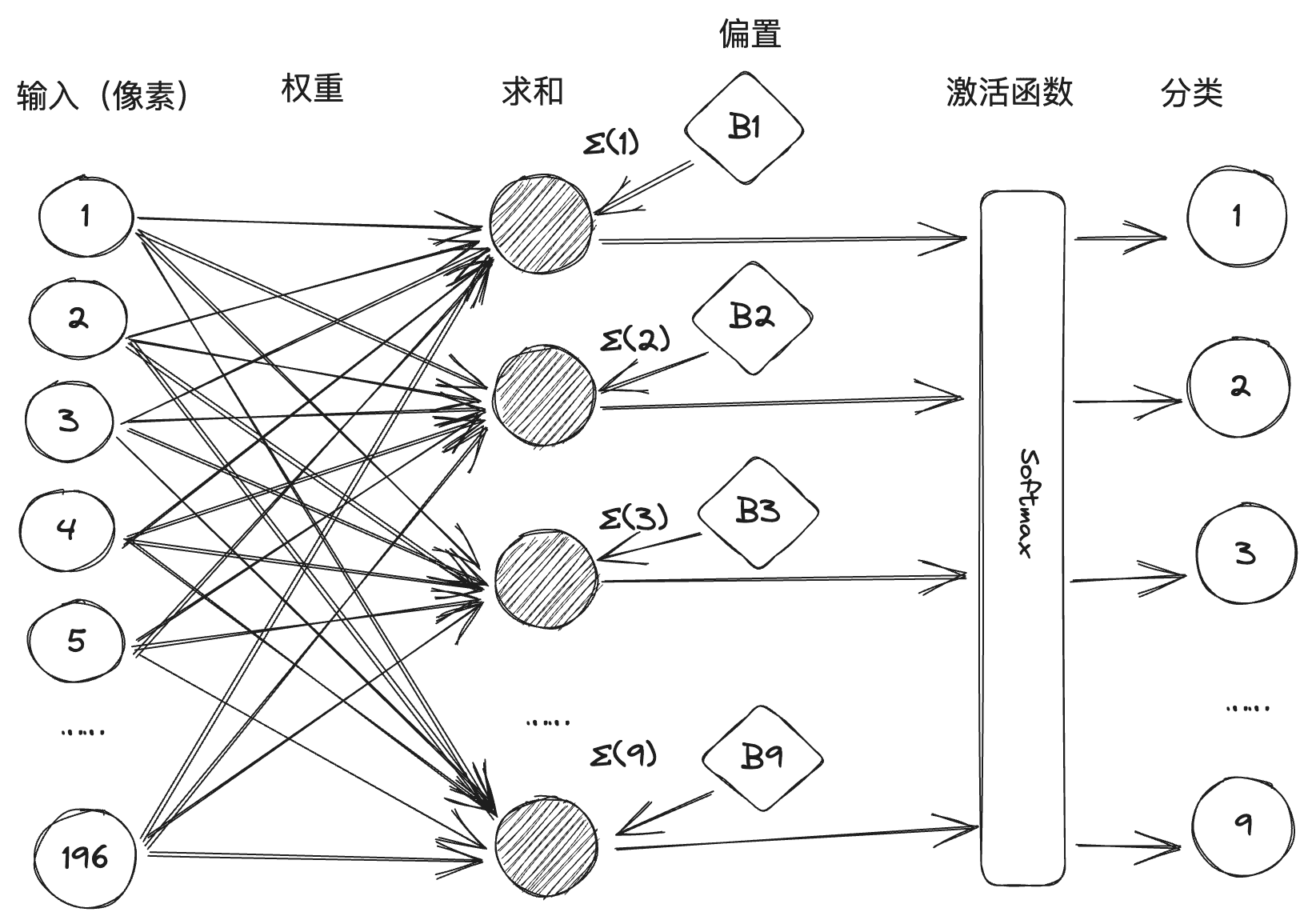

A continuación, convertimos el proceso de clasificación de cada número en una neurona M-P, cada neurona tiene 196 entradas de píxeles, y el valor del peso entre cada entrada y esa neurona se obtiene mediante entrenamiento, de modo que constituye una red neuronal formada por 10 neuronas, 196 entradas y 1.960 líneas de conexión con pesos ante ellas, como se muestra a continuación: (Generalmente, en una red neuronal, el valor umbral se se convierte en un sesgo, llamado uno de los términos de la suma, para simplificar el proceso aritmético).

Sin embargo, en la práctica, existen ambigüedades en algunas fuentes manuscritas que pueden hacer que se activen dos o más neuronas tras la suma ponderada. Por lo tanto, la máquina perceptiva se implementa introduciendo el diseño de la función de activación, como se muestra en la figura siguiente, Softmax es una función de activación, que procesará el valor de la suma para inhibir la clasificación numérica con pequeña probabilidad y mejorar la clasificación numérica con gran probabilidad.

Rosenblatt hizo el primer perceptrón hardware del mundo "Mark-1" dos años más tarde, el perceptrón puede identificar el alfabeto Inglés, pero en ese momento causó una gran sensación. ¡El Departamento de Defensa de EE.UU. y los militares de la Armada también se dio cuenta, y dio una gran cantidad de apoyo financiero, Rosenblatt en la percepción de la confianza de la máquina ha alcanzado su punto máximo, e incluso un reportero le preguntó "no hay percepción de la máquina no puede hacer las cosas", la respuesta de Rosenblatt es "el amor, la esperanza, la desesperación! La respuesta de Rosenblatt fue "amor, esperanza, desesperación". La fama de Rosenblatt creció, y su extravagante personalidad le llevó a granjearse enemigos por doquier, el más famoso de los cuales fue otro gigante de la inteligencia artificial, Marvin Minsky. Minsky fue el organizador de la Conferencia de Dartmouth y uno de los fundadores de la IA. En 1969 publicó su libro Perceptual Machines (Máquinas perceptivas), que identificaba claramente los fallos que existían en las máquinas perceptivas. El primero era una demostración matemática de que las máquinas perceptivas no podían manejar problemas de clasificación no lineales, como la heteroscedasticidad, y el segundo era una demostración de que la complejidad de las máquinas perceptivas multicapa conducía a una expansión espectacular de los datos conectados sin un método de entrenamiento adecuado. Minsky ganó el cuarto premio Turing el año de la publicación del libro, y el inmenso prestigio de su sentencia sobre las máquinas perceptivas sentenció a muerte la investigación sobre redes neuronales. El conexionismo recibió una paliza, y la investigación simbolista se convirtió en la corriente principal de la IA.

Existen dos grandes escuelas de pensamiento en el campo de la inteligencia artificial: el conectivismo y el simbolismo, un poco como la Secta de la Espada y la Secta Qi en las novelas de artes marciales, que han estado compitiendo entre sí durante mucho tiempo. El conectivismo desarrolla la IA modelando el cerebro humano para construir redes neuronales, almacenando el conocimiento en un gran número de conexiones y aprendiendo en función de los datos. El simbolismo, por su parte, cree que el conocimiento y el razonamiento deben representarse mediante símbolos y reglas, es decir, un gran número de definiciones de reglas "si-entonces" para generar decisiones y razonamientos, y desarrolla la IA basándose en reglas y lógica. La primera se representa mediante redes neuronales y la segunda mediante sistemas expertos.

III Aprendizaje profundo

Con el fracaso de la máquina de percepción, la inversión gubernamental en el campo de la IA disminuyó, y la IA entró en su primer periodo invernal. Y en la década de 1980, el simbolismo, representado por los sistemas expertos, se convirtió en la corriente principal de la IA, desencadenando la segunda oleada de la IA, mientras que la investigación en redes neuronales se quedó al margen. Como ya se ha mencionado, sólo hay una persona que aún persiste, y es Geoffrey Hinton.

Basándose en sus predecesores, Sinton inventó sucesivamente la máquina de Boltzmann y el algoritmo de retropropagación de errores. Las contribuciones pioneras de Sinton al campo de las redes neuronales dieron vida al campo, aunque la corriente principal del campo de la inteligencia artificial desde la década de 1980 hasta principios de siglo seguía siendo la base de conocimientos y el análisis estadístico, y las diversas técnicas de redes neuronales empezaron a abrirse paso, con ejemplos representativos como las redes neuronales convolucionales (CNN), las redes de memoria a largo plazo a corto plazo (LSTM), etc. (LSTM), etc. En 2006, Hinton propuso las redes de creencia profunda, que abrieron la era del aprendizaje profundo.

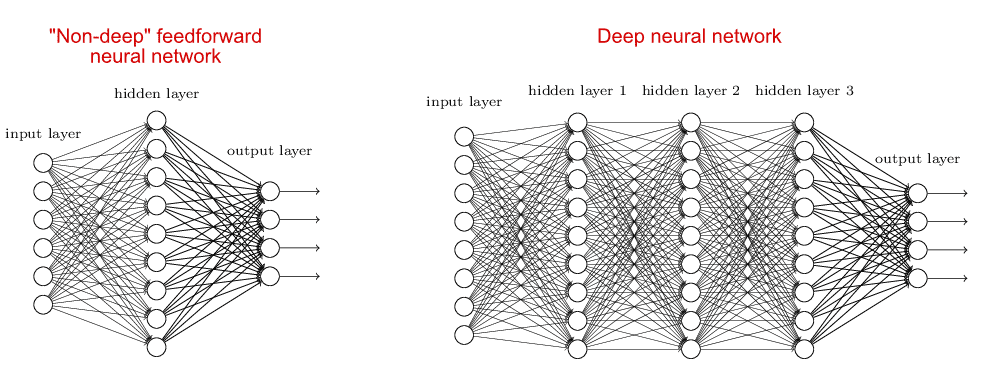

El modelo de red neuronal correspondiente al aprendizaje profundo se denomina red neuronal profunda, que es relativa a las redes neuronales poco profundas. En el caso de las redes neuronales poco profundas, suele haber una sola capa oculta (o capa intermedia), más las capas de entrada y salida, lo que hace un total de tres capas. Las redes neuronales profundas, en cambio, tienen más de una capa oculta, lo que permite comparar los dos tipos de redes neuronales:

La razón por la que la gente se ha centrado en las redes neuronales poco profundas antes que en el aprendizaje profundo es que el aumento del número de capas de la red neuronal conlleva un aumento de la dificultad de entrenamiento; por un lado, no hay suficiente soporte aritmético y, por otro, no existe un buen algoritmo. La red de creencia profunda propuesta por Hinton resuelve este problema de entrenamiento utilizando un algoritmo de retropropagación de errores y preentrenando capa por capa. Después de la red de creencia profunda, la red neuronal profunda se convierte en el modelo dominante del aprendizaje automático, los populares modelos actuales GPT, Llama y otros grandes modelos se construyen a partir de una o más redes neuronales profundas.

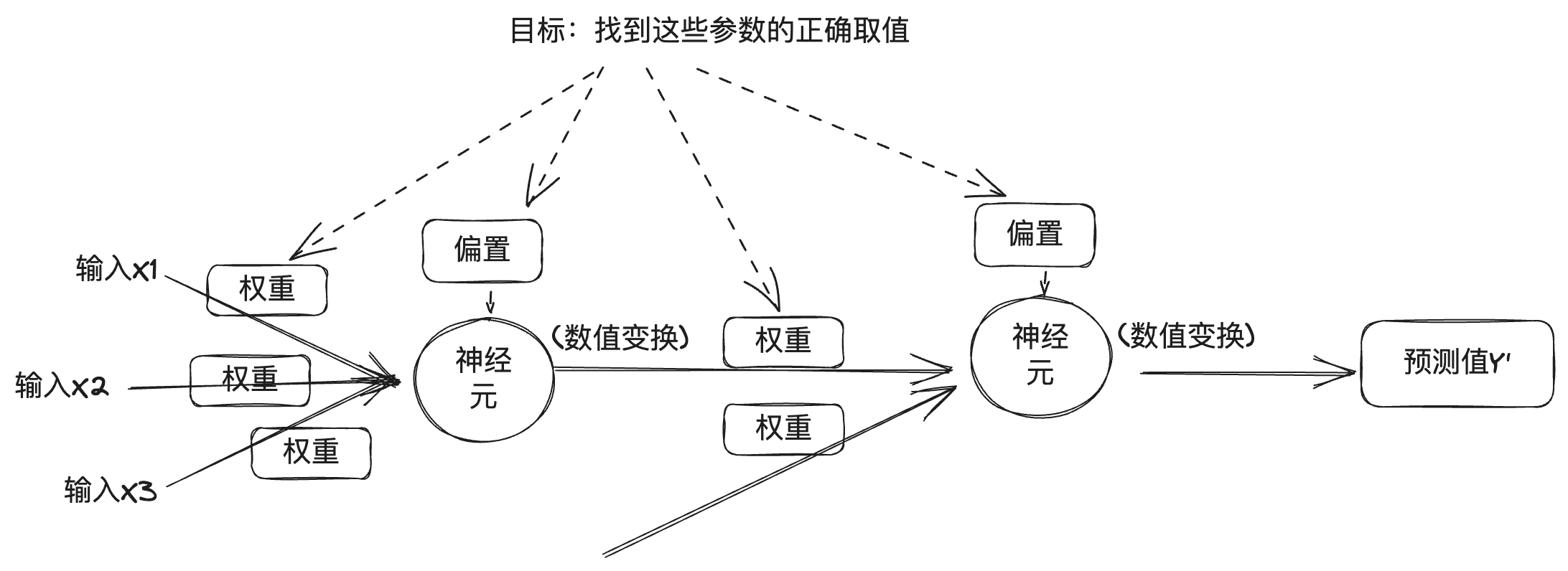

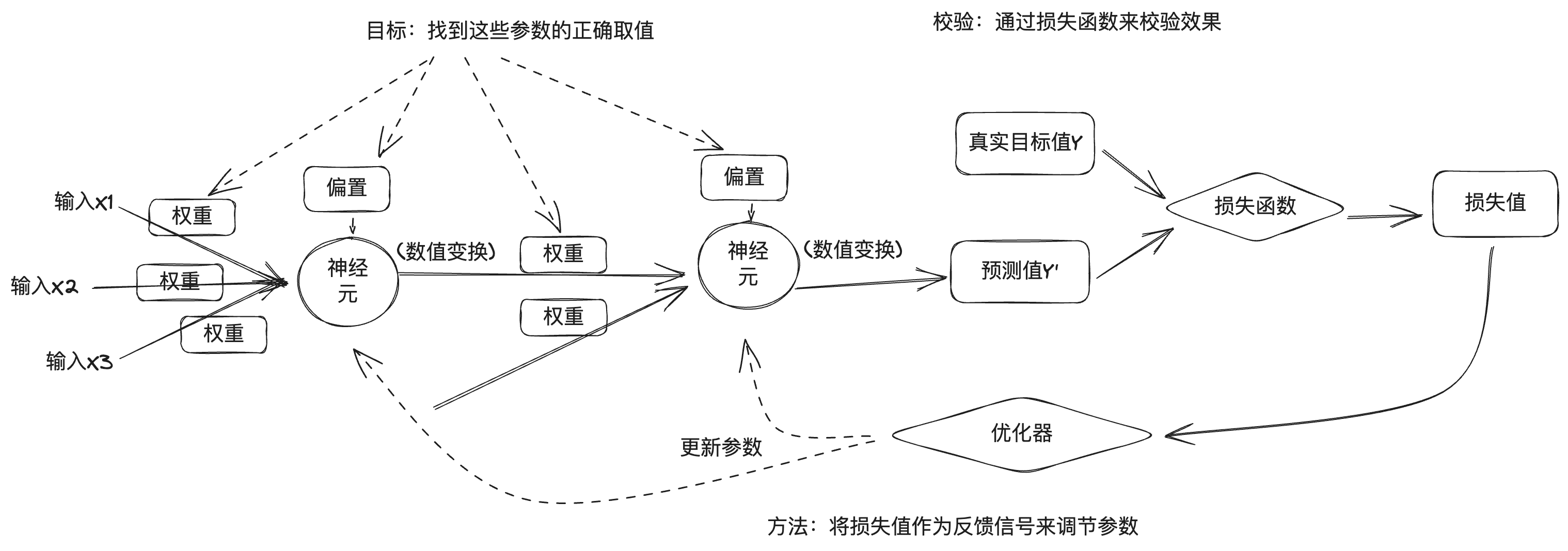

Para la comprensión de las redes neuronales profundas, puede referirse a la introducción del principio de la máquina perceptiva anterior, la red neuronal profunda se considera como una combinación de múltiples neuronas en múltiples capas, de la sección anterior se puede entender, cada capa de la salida está relacionada con el peso, sesgo, y la función de activación, y para la salida de la red neuronal profunda también está relacionado con el número de capas y otros valores numéricos. En las redes neuronales profundas, estos valores se pueden dividir en dos categorías, una es el número de capas, la función de activación, el optimizador, etc., conocido como hiperparámetro, que es establecido por el ingeniero; la otra es el peso y el sesgo, conocido como el parámetro, que se obtiene automáticamente durante el proceso de entrenamiento de las redes neuronales profundas, y para encontrar el parámetro correcto es el propósito del aprendizaje profundo.

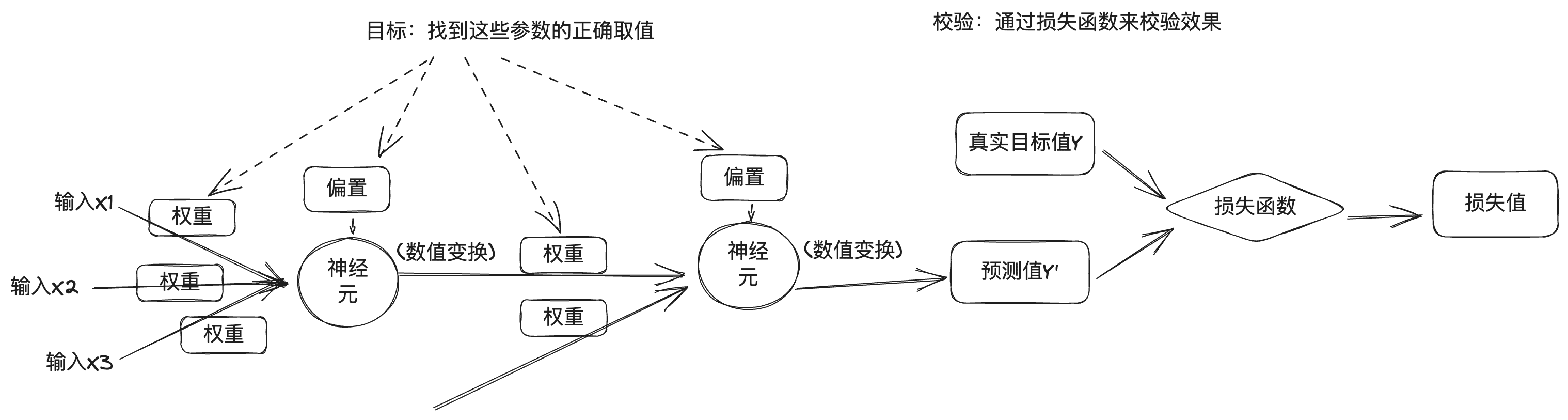

Pero el problema es que una red neuronal profunda contiene un número enorme de parámetros, y modificar un parámetro afectará al comportamiento de los demás, por lo que encontrar los valores correctos de estos parámetros es una tarea difícil. Para encontrar los valores correctos de los parámetros y hacer que la salida del modelo sea precisa, necesitamos una forma de medir la diferencia entre la salida del modelo y la salida deseada. Por lo tanto, el entrenamiento del aprendizaje profundo se mide utilizando una función de pérdida, que también se conoce como función objetivo o función de coste. La función de pérdida indica lo bueno o malo que es el modelo de red neuronal en esta muestra de entrenamiento comparando el valor predicho de la red neuronal profunda con el valor objetivo verdadero para obtener el valor de pérdida.

El enfoque de aprendizaje profundo utiliza los valores de pérdida como señales de retroalimentación para ajustar los parámetros con el fin de reducir los valores de pérdida para la muestra de entrenamiento actual. Este ajuste se consigue mediante un optimizador, que implementa algoritmos de optimización como el descenso de gradiente para actualizar los parámetros de los nodos neuronales de cada capa por retropropagación.

Al principio, los parámetros de la red neuronal se asignarán aleatoriamente, se introducirá un lote de datos de entrenamiento y, tras obtener la salida prevista de la red a través de la capa de entrada y la capa oculta hasta la capa de salida, se calculará el valor de pérdida de acuerdo con la función de pérdida, que es el proceso de propagación hacia delante; a continuación, partiendo de la capa de salida, se calculará el gradiente de los parámetros en sentido inverso a lo largo de cada capa hasta la capa de entrada y se actualizarán los parámetros de la red utilizando el algoritmo de optimización basado en el gradiente, que es el proceso de propagación hacia atrás. . En cada lote de muestras de entrenamiento procesadas por la red neuronal, los parámetros se afinan en la dirección correcta y se reducen los valores de pérdida, lo que constituye el ciclo de entrenamiento. Un número suficiente de ciclos de entrenamiento da como resultado unos parámetros que minimizan la función de pérdida, lo que se traduce en un buen modelo de red neuronal.

Por supuesto, el proceso real de aprendizaje profundo es mucho más complejo que esto, por lo que a continuación se ofrece una breve descripción del proceso general.

Ya en 2012, Hinton llevó a dos de sus estudiantes, Alex Krizhevsky e Ilya Sutskever, a desarrollar la red neuronal AlexNet, que compitió en el concurso de reconocimiento de imágenes ImageNet y ganó el campeonato, con una tasa de precisión muy superior a la del segundo clasificado. Hinton y sus estudiantes fundaron entonces DNNResearch, Inc. para centrarse en las redes neuronales profundas. La empresa no tenía productos ni activos, pero el éxito de AlexNet atrajo a varios gigantes de Internet. en el invierno de 2012, se celebró una subasta secreta en el lago Tahoe, en la frontera entre Estados Unidos y Canadá: el objeto de la subasta era la recién fundada DNNResearch, y los compradores eran Google, Microsoft, DeepMind y Baidu. Al final, mientras Google y Baidu seguían pujando por el precio, Hinton anuló la subasta y optó por vendérsela a Google por 44 millones de dólares.En 2014, Google se embolsó DeepMind.En 2016, AlphaGo, que utiliza una combinación de búsqueda clásica en árbol de Montecarlo y redes neuronales profundas, derrotó a Lee Sedol, y luego, al año siguiente, derrotó al jugador número 1 del ranking mundial de Go, Ke Jie.AlphaGo llevó los límites de la la inteligencia artificial y el aprendizaje profundo.

Cuatro grandes modelos

En 2015, Musk, el director de tecnología de Stripe, Greg Brockman, los consejeros delegados de YC Ventures, Sam Altman e Ilya Sutskever, y otras personas se reunieron en el hotel Resewood de California para hablar de la creación de un laboratorio de IA que contrarrestara el control de la tecnología de IA por parte de las grandes empresas de Internet. A continuación, Greg Brockman reunió a un grupo de investigadores de Google, Microsoft y otras empresas para formar un nuevo laboratorio llamado OpenAI, en el que Greg Brockman, Sam Altman e Ilya Sutskever ejercerían de Presidente, Consejero Delegado y Científico Jefe de OpenAI, respectivamente.

Musk y Sam Altman concibieron OpenAI como una organización sin ánimo de lucro que pondría la tecnología de IA al alcance de todo el mundo para contrarrestar los peligros que plantea el control de la tecnología de IA por parte de las grandes empresas de Internet. Debido a que la tecnología de IA de aprendizaje profundo estaba explotando, nadie podía predecir si la tecnología formaría una amenaza para la humanidad en el futuro, y la apertura podría ser la mejor manera de contrarrestar eso. Y más tarde, en 2019, OpenAI optó por crear una filial rentable para financiar el desarrollo de su tecnología y cerrar el código de su tecnología principal, que era una idea de última hora.

En 2017, los ingenieros de Google publicaron un artículo titulado Attention is all you need (La atención es todo lo que necesitas), en el que se proponía que la Transformador Arquitectura de redes neuronales, que se caracteriza por la introducción de mecanismos de atención humana en las redes neuronales. El reconocimiento de imágenes mencionado anteriormente es un escenario del aprendizaje profundo, en el que los datos de la imagen son datos discretos sin correlación entre ellos. En la vida real, hay otro escenario, que es tratar con datos temporales, como el texto, el contexto del texto está relacionado, así como la voz, el vídeo, etc., son datos temporales. Estos datos ordenados en el tiempo se llama secuencia (secuencia), y la tarea real es a menudo una secuencia en otra secuencia, como la traducción, un párrafo de chino en un párrafo de Inglés, así como robot de preguntas y respuestas, un párrafo de la pregunta en un párrafo de respuestas generadas de forma inteligente, y por lo tanto el uso del convertidor (Transformer), que es también el origen del nombre Transformer. De ahí viene el nombre de Transformador. Como ya se ha mencionado, la excitación de una neurona viene determinada por la suma ponderada de los datos de entrada a los que está conectada, y el peso representa la fuerza de la conexión. En el caso de los datos de series temporales, el peso de cada elemento es diferente, lo que concuerda con nuestra experiencia cotidiana, por ejemplo, fíjese en el siguiente pasaje:

Las investigaciones han demostrado que el orden de los caracteres chinos no siempre afecta a la lectura. Por ejemplo, cuando terminas de leer esta frase, te das cuenta de que todos los caracteres están desordenados.

Esto es cierto no sólo para los caracteres chinos, sino también para otras lenguas humanas como el inglés. Esto se debe a que nuestro cerebro juzgará automáticamente el peso de las palabras en la oración, en la información redundante para captar el foco, que es Atención.Los ingenieros de Google introdujeron el mecanismo de atención en el modelo de red neuronal, utilizado en el procesamiento del lenguaje natural, para que la máquina pueda "entender" la intención del lenguaje humano. Posteriormente, en 2018, OpenAI lanzó GPT-1 basado en la arquitectura Transformer, GPT-2 en 2019, GPT-3 en 2020, y el programa ChatGPT AI Q&A basado en GPT-3.5 a finales de 2022, que es impactante en términos de su capacidad de diálogo, y la IA ha dado un gran paso adelante en la dirección de AGI.

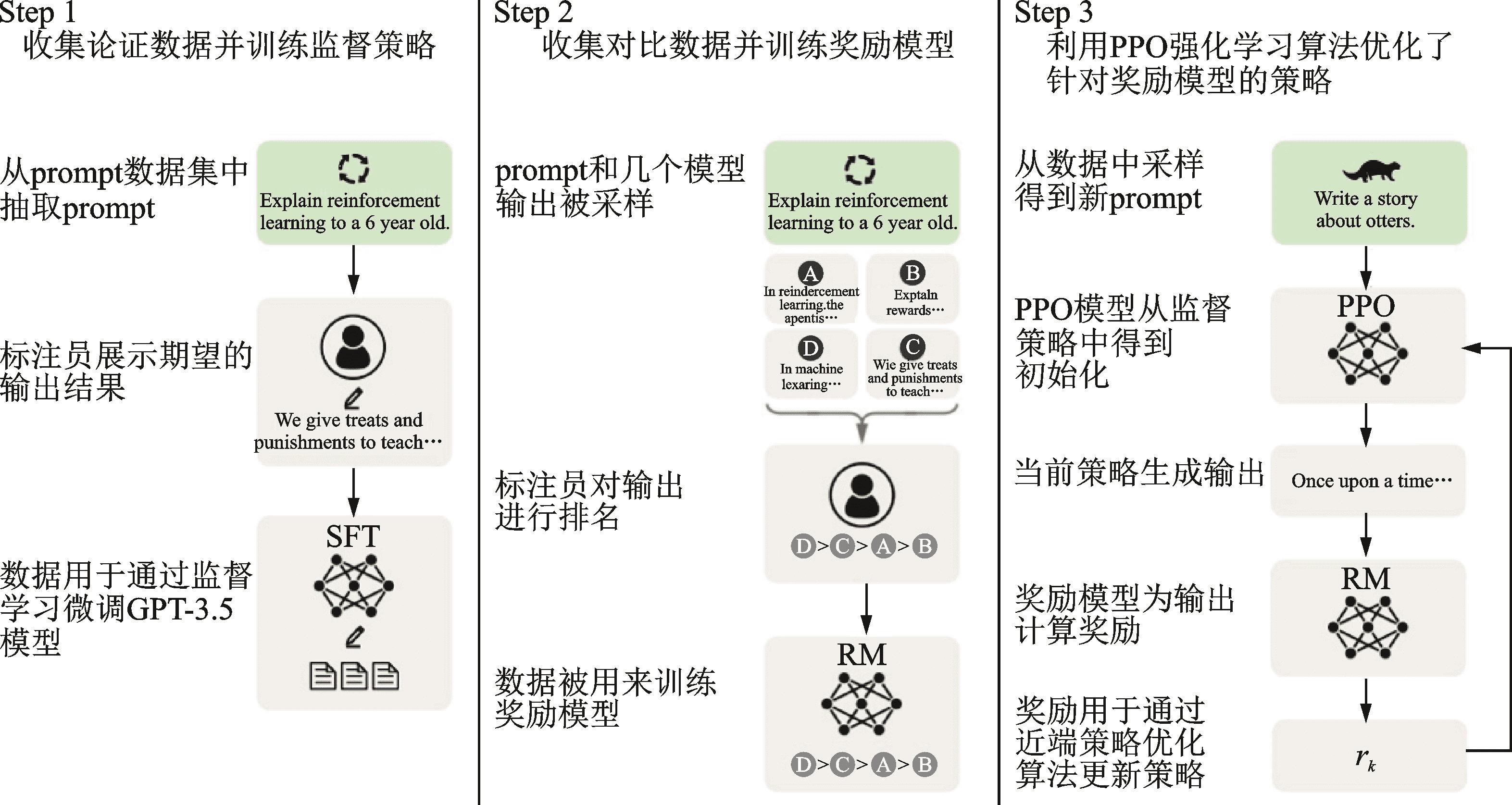

El nombre completo de GPT es Generative Pre-trained Transformer, Generativo indica su capacidad para generar nuevos contenidos, Transformer es su infraestructura, y Pre-trained en el medio indica que su método de entrenamiento es el pre-entrenamiento. ¿Por qué se llama preentrenado? Esto se debe a que, a partir de AlexNet, la gente ha empezado a utilizar datos más grandes y más parámetros en el entrenamiento de redes neuronales para conseguir mejores resultados, y esto significa que el entrenamiento se ha vuelto más costoso en recursos y tiempo. Este coste es un poco elevado para entrenar tareas específicas y es un poco despilfarrador, ya que no se puede compartir con otras redes neuronales. Por eso, la industria ha empezado a adoptar un enfoque de preentrenamiento + ajuste fino para entrenar modelos de redes neuronales, es decir, primero se completa el entrenamiento de un modelo general grande en un conjunto de datos más amplio y luego se completa el ajuste fino del modelo con un conjunto de datos más pequeño para escenarios de tareas específicas.ChatGPT emplea el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF), que es un método para entrenar modelos de redes neuronales. ChatGPT utiliza el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) para el preentrenamiento y el ajuste fino, que se divide en tres pasos: el primero consiste en preentrenar un modelo lingüístico (LM); el segundo, en recopilar datos de preguntas y respuestas y entrenar un modelo de recompensa (RM); y el tercero, en ajustar el modelo lingüístico (LM) con aprendizaje por refuerzo (RL). Este modelo de recompensa contiene retroalimentación humana, por lo que el proceso de entrenamiento se denomina RLHF.

Los usuarios quedan impresionados por la capacidad de múltiples rondas de diálogo además de su precisión durante el uso de ChatGPT. Según la exploración subyacente de las redes neuronales, vemos que cada proceso de inferencia es desde la entrada a través de la ponderación y activación de cada neurona hasta la salida, y no hay capacidad de memoria. Y la razón por la que ChatGPT funciona bien con el diálogo multirronda es porque utiliza la tecnología de Prompt Engineering en la gestión del diálogo.

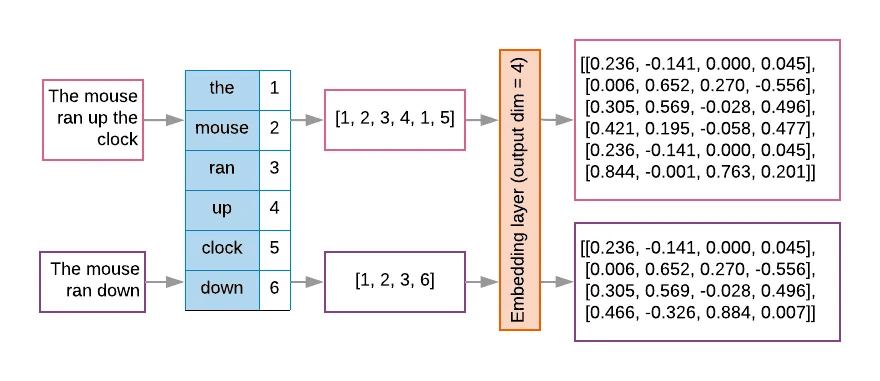

Para los modelos lingüísticos de gran tamaño, como ChatGPT, su entrada es un token después de convertir una cadena de texto, y los modelos de gran tamaño suelen diseñar una ventana de contexto fija para limitar el número de tokens de entrada debido a la eficiencia computacional y las limitaciones de memoria. En primer lugar, el texto será subdividido por el tokenizador y numerado por la tabla de búsqueda, y luego se incrustará en la matriz en un vector espacial de alta dimensión, que es el proceso de vectorización del texto, como se muestra en la siguiente figura.

Debido a las limitaciones en el número de tokens, es necesario utilizar técnicas de ingeniería de prompts para que el modelo más amplio pueda ofrecer información más completa en una ventana de contexto limitada. La ingeniería de prompts utiliza una serie de estrategias para optimizar las entradas del modelo de modo que éste produzca resultados que se ajusten mejor a las expectativas.

Detrás del éxito de ChatGPT está la evolución técnica del gran modelo representado por GPT. OpenAI cree que los esfuerzos vigorosos producen milagros, y ha ampliado continuamente los parámetros de GPT, con GPT-1 teniendo 117 millones de parámetros de modelo, GPT-2 habiendo aumentado a 1,5 billones de parámetros de modelo, GPT-3 llegando a 175 billones, y los parámetros de modelo de GPT-4 supuestamente teniendo 1,8 billones. Más parámetros de modelo significa más potencia de cálculo para apoyar el entrenamiento, por lo que OpenAI resumió la "Ley de Escalado", que establece que el rendimiento de un modelo está relacionado con el tamaño del modelo, el volumen de datos y los recursos computacionales, lo que significa simplemente que cuanto mayor sea el modelo, mayor sea el volumen de datos y mayores sean los recursos computacionales, mejor será el rendimiento del modelo. Rich Sutton, el padre del aprendizaje por refuerzo, expresó una opinión similar en su artículo "la lección amarga" (the Bitter Lesson), revisando el desarrollo de la inteligencia artificial en las últimas décadas, llegó a la conclusión de que a corto plazo, la gente siempre está tratando de mejorar el rendimiento del cuerpo inteligente a través de la construcción del conocimiento, pero a largo plazo, el poderoso poder aritmético es el rey.

La capacidad de los grandes modelos también ha cambiado de cambios cuantitativos a cambios cualitativos, el Jefe Científico de Google Jeff Dean lo llamó "habilidades emergentes" (Capacidades emergentes) de los grandes modelos. El mercado ve esta oportunidad, por un lado, los principales proveedores en la inversión de grandes modelos en la carrera de armamentos, por otro lado, el gran modelo de la ecología de código abierto también está en pleno apogeo.

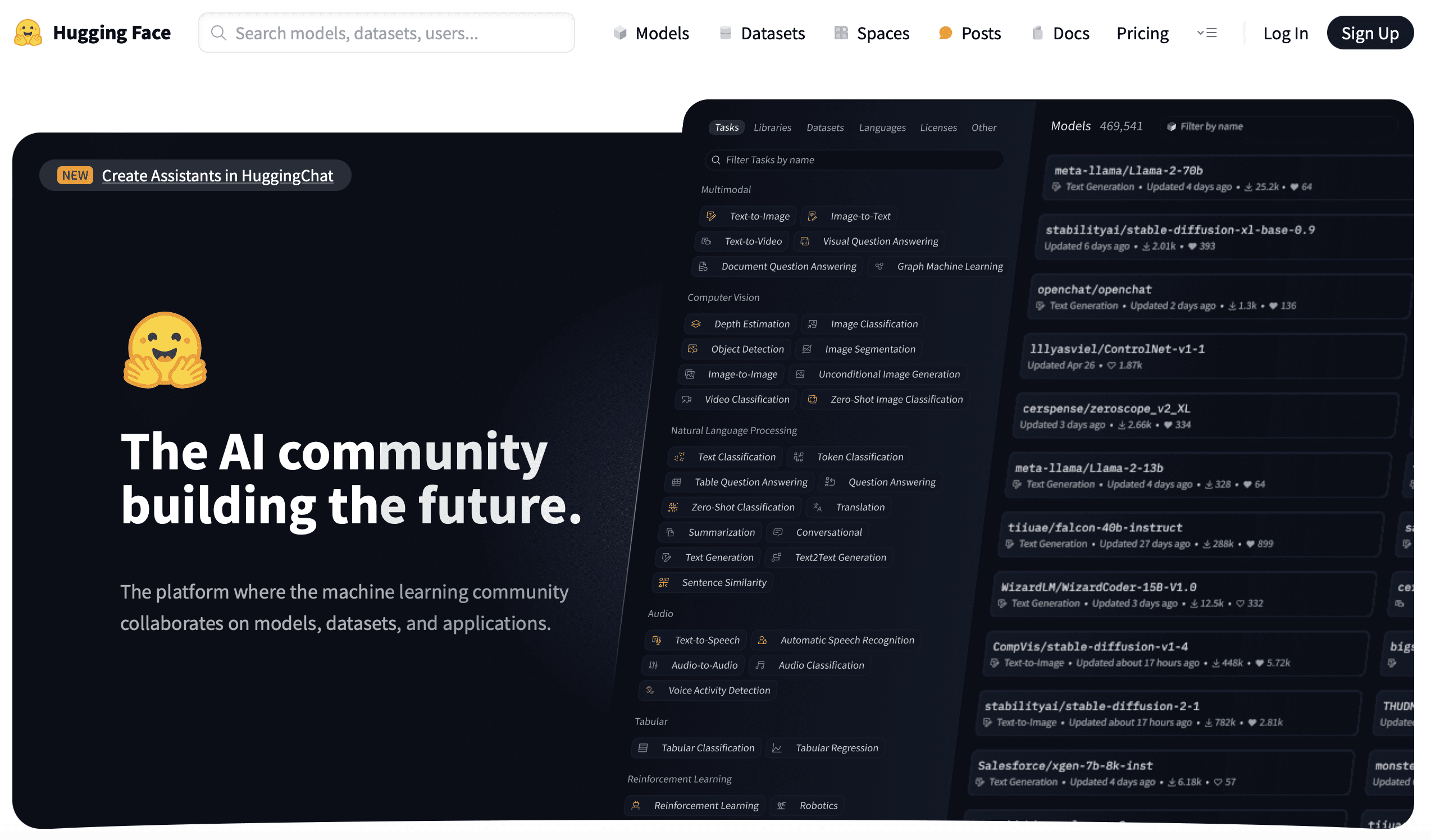

V Cara de abrazo

En 2016, los franceses Clément Delangue, Julien Chaumond y Thomas Wolf fundaron una empresa llamada Hugging Face, con el icono emoji como logotipo. Hugging Face empezó desarrollando chatbots inteligentes para jóvenes, después desarrollaron algunas herramientas de formación de modelos y las pusieron en código abierto en el proceso de formación de modelos. Más tarde, desarrollaron algunas herramientas de entrenamiento de modelos y las pusieron en código abierto en el proceso, y más tarde incluso cambiaron su enfoque a este último, un enfoque aparentemente "poco profesional" que les llevó a una nueva vía y a un papel indispensable en el campo del aprendizaje profundo.

Silicon Valley tiene una gran cantidad de empresas están en el negocio secundario para hacer logros, como Slack originalmente desarrollado juegos, el equipo de la empresa se distribuye en muchos lugares, en el proceso de operación desarrollado una herramienta de comunicación resultados en el incendio accidental, es decir, Slack. y Hugging Face turno también es similar, pero también con el fin de resolver sus propios puntos de dolor, en 2018, Google lanzó el gran modelo BERT, y Hugging Los empleados de Hugging Face utilizaron entonces su conocido marco Pytorch para implementar BERT, llamaron al modelo pytorch-pretrained-bert y lo publicaron en código abierto en GitHub. más tarde, con la ayuda de la comunidad, se introdujo un grupo de modelos como GPT, GPT-2, Transformer-XL, etc., y el proyecto pasó a llamarse El campo del aprendizaje profundo ha sido la competencia entre los dos marcos Pytorch y TensorFlow, y los investigadores a menudo cambian entre los dos marcos con el fin de comparar las ventajas y desventajas de los dos marcos, por lo que el proyecto de código abierto ha añadido la función de cambiar entre los dos marcos, y el nombre del proyecto también fue cambiado a Transformers. Transformers también se ha convertido en el proyecto de más rápido crecimiento en GitHub.

Hugging Face sigue desarrollando y abriendo al público otra serie de herramientas de aprendizaje automático: Datasets, Tokenizer, Diffusers ....... Estas herramientas también normalizan el proceso de desarrollo de la IA. Antes de Hugging Face, puede decirse que el desarrollo de la IA estaba dominado por los investigadores. Antes de Hugging Face, puede decirse que el desarrollo de la IA estaba dominado por investigadores sin un enfoque de ingeniería estandarizado. Hugging Face proporciona un conjunto completo de herramientas de IA y establece un conjunto de normas de facto, lo que también permite a más desarrolladores de IA e incluso a profesionales ajenos a la IA iniciarse rápidamente y entrenar modelos.

Hugging Face lanzó entonces Hugging Face Hub para alojar modelos, conjuntos de datos y aplicaciones de IA basadas en las tecnologías Git y Git LFS, y hasta ahora se han alojado en la plataforma 350.000 modelos, 75.000 conjuntos de datos y 150.000 aplicaciones de IA de muestra. La labor de alojar y abrir modelos y conjuntos de datos, y de establecer un centro mundial de repositorios de código abierto es innovadora y de gran alcance. Mientras que el enfoque de preentrenamiento + puesta a punto mencionado anteriormente facilita el intercambio de recursos de entrenamiento de redes neuronales, el Hugging Face Hub va un paso más allá al permitir a los desarrolladores de IA reutilizar fácilmente los resultados más avanzados del mundo y ampliarlos, haciendo posible la democratización de la IA para que todo el mundo pueda utilizarla y desarrollarla. GitHub, o como dice su eslogan: construyendo la comunidad de IA del futuro. He escrito dos artículos antes, uno de losUn código que cambió el mundoIntroducing Git, un artículo enDe cero a 10.000 millones de dólaresPresentando GitHub, y Git, GitHub, Hugging Face, creo que hay una especie de legado entre ellos, un legado de hacking que está cambiando el mundo para construir el futuro, y esa es una de las cosas que me impulsó a escribir este post.

VI. Posdata

Cuando me acercaba al final de este artículo, vi una charla que Hinton dio recientemente en la Universidad de Oxford. En la charla, Hinton presentó dos grandes escuelas de pensamiento en el campo de la inteligencia artificial, una que Hinton denominó enfoque lógico, o simbolismo, y otra que denominó enfoque biológico, o conexionismo de redes neuronales, que simula el cerebro humano. Y el enfoque biológico resultó ser un claro vencedor sobre el enfoque lógico. Las redes neuronales son modelos diseñados para imitar la comprensión del cerebro humano, y los grandes modelos funcionan y comprenden como el cerebro. Hinton cree que la inteligencia artificial más allá del cerebro humano surgirá en el futuro, y mucho antes de lo que prevemos.

Anexo 1 Cronología de los acontecimientos

En 1943, McCulloch y Pitts publicaron el "Modelo Neuronal M-P", que utilizaba la lógica matemática para explicar y simular las unidades computacionales del cerebro humano, e introdujo el concepto de redes neuronales.

El término "inteligencia artificial" se acuñó por primera vez en la Conferencia de Dartmouth de 1956.

En 1957, Rosenblatt propuso el modelo de "perceptrón" y dos años más tarde consiguió construir el Mark-1, un perceptrón de hardware capaz de reconocer el alfabeto inglés.

En 1969, Minsky publicó Perceptual Machines, y los defectos de las máquinas perceptivas señalados en el libro supusieron un duro golpe para la investigación de las máquinas perceptivas e incluso de las redes neuronales.

En 1983, Hinton inventó la máquina de Boltzmann.

En 1986, Hinton inventó el algoritmo de retropropagación de errores.

En 1989, Yann LeCun inventó la red neuronal convolucional (CNN).

En 2006, Hinton propuso la Red de Creencia Profunda, marcando el comienzo de la era del aprendizaje profundo.

La industria se tomó en serio el aprendizaje profundo en 2012, cuando Hinton y dos de sus estudiantes diseñaron AlexNet para ganar por goleada el concurso ImageNet.

En 2015, DeepMind, empresa adquirida por Google, lanzó AlphaGo, que derrotó a Lee Sedol en 2016 y a Ke Jie en 2017.Se fundó OpenAI.

Hugging Face se fundó en 2016.

En 2017, Google publicó el documento del modelo Transformer.

En 2018, OpenAI lanzó GPT-1 basado en la arquitectura Transformer.Hugging Face lanzó el proyecto Transformers.

En 2019, OpenAI lanza GPT-2.

En 2020, OpenAI lanza GPT-3. Hugging Face lanza Hugging Face Hub.

En 2022, OpenAI lanza ChatGPT.

Anexo 2 Referencias

Libros:

Fronteras de la inteligencia: de las máquinas de Turing a la inteligencia artificial por Zhou Zhiming (Autor) Mechanical Industry Press Octubre de 2018

La revolución del aprendizaje profundo de Cade Metz Shuguang Du CITIC Press Enero de 2023

Aprendizaje profundo en Python (2ª Edición) François Chollet (Autor) Liang Zhang (Traductor) Editorial Popular de Correos y Telecomunicaciones Agosto 2022

Una introducción al aprendizaje profundo: teoría e implementación basada en Python por Yasui Saito (Autor) Yujie Lu (Traductor) Editorial de Correos y Telecomunicaciones del Pueblo 2018

Deep Learning Advanced: Natural Language Processing por Yasuyoshi Saito (Autor) Yujie Lu (Traductor) Editorial Popular de Correos y Telecomunicaciones Octubre de 2020

This is ChatGPT Stephen Wolfram (Autor) WOLFRAM Media Chinese Group (Traductor) People's Posts and Telecommunications Publishing House Julio de 2023

Inteligencia Artificial Generativa por Ding Lei (Autor) CITIC Press Mayo 2023

Explicación del procesamiento del lenguaje natural por Li Fulin (Autor) Tsinghua University Press Abril de 2023

Artículo:

Introducción a las redes neuronales por Yifeng Nguyen

2012, 180 días que cambiaron el destino de la humanidad" Instituto de Investigación Enkawa

Evolución de la familia GPT MetaPost

Transformer - Atención es todo lo que necesitas".

Desarrollo de modelos lingüísticos preformados.

Guía de ingeniería Prompt

ChatGPT detrás del "crédito" - Explicación detallada de la tecnología RLHF.

Desarrollo y aplicación de técnicas de modelización de gran tamaño ChatGPT.

La amarga lección, Rich Sutton.

Entrevista con el director de tecnología de HuggingFace: el auge del código abierto, las historias de las startups y la democratización de la inteligencia artificial".

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...