Groq: proveedor de soluciones de aceleración de inferencia de grandes modelos de IA, interfaz de grandes modelos gratuita y de alta velocidad

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 70.6K 00

Groq Introducción general

Groq, una empresa con sede en Mountain View, California, desarrolló el GroqChip™ y la Language Processing Unit™ (LPU). Conocida por sus unidades de procesamiento tensorial desarrolladas para aplicaciones de IA de baja latencia.

Groq se fundó en 2016 y su nombre se registró oficialmente como marca ese mismo año.El principal producto de Groq es la unidad de procesamiento de lenguaje (LPU), una nueva clase de chips diseñados no para entrenar modelos de IA, sino para ejecutarlos rápidamente.Los sistemas LPU de Groq han abierto el camino para una nueva generación de aceleración de IA, una que está diseñada para procesar datos secuenciales (por ejemplo, ADN, música, código,) lenguaje natural) y superar a las GPU.

Su objetivo es ofrecer soluciones para aplicaciones de IA en tiempo real, con un rendimiento líder en IA en centros de cálculo, caracterizado por la velocidad y la precisión.Groq es compatible con marcos de aprendizaje automático estándar como PyTorch, TensorFlow y ONNX. Además, ofrece el paquete GroqWare™, que incluye herramientas para el desarrollo personalizado y la optimización de cargas de trabajo, como Groq Compiler.

Lista de funciones de Groq

- Procesamiento de aplicaciones de IA en tiempo real

- Compatibilidad con marcos de aprendizaje automático estándar

- Compatibilidad con hardware ligero SaaS y PaaS

- Rendimiento rápido y preciso de la IA

- GroqWare™ Suite para cargas de trabajo optimizadas a medida

- Garantizar un rendimiento de inferencia a gran escala preciso, energéticamente eficiente y repetible

Ayuda Groq

- Los desarrolladores pueden autogestionar el acceso a través de Playground en GroqCloud

- Si actualmente está utilizando la API OpenAI, sólo necesita tres cosas para convertir a Groq: una clave de API Groq, un punto final, un modelo

- Si necesita el razonamiento más rápido a escala de centro de datos, deberíamos hablar

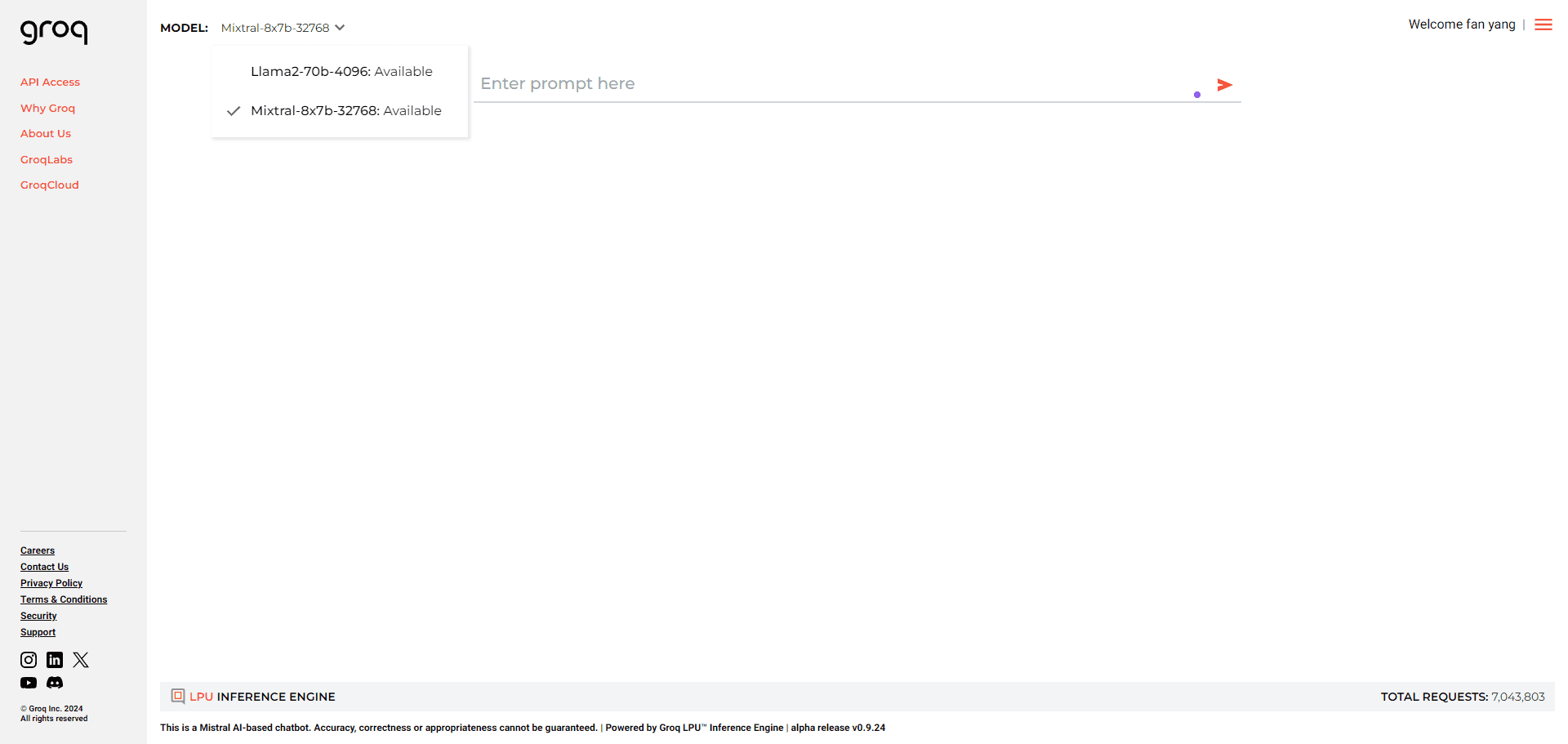

Tú puedes.Pulse aquíSolicite APIKEY gratuitamente y elija el modelo una vez completada la solicitud:

Finalización del chat

| ID | Peticiones por minuto | Solicitudes por día | Fichas por minuto | Fichas por día |

|---|---|---|---|---|

| gemma-7b-it | 30 | 14,400 | 15,000 | 500,000 |

| gemma2-9b-it | 30 | 14,400 | 15,000 | 500,000 |

| llama-3.1-70b-versatile | 30 | 14,400 | 20,000 | 500,000 |

| llama-3.1-8b-instant | 30 | 14,400 | 20,000 | 500,000 |

| llama-3.2-11b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-1b-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-3b-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-90b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-guard-3-8b | 30 | 14,400 | 15,000 | 500,000 |

| llama3-70b-8192 | 30 | 14,400 | 6,000 | 500,000 |

| llama3-8b-8192 | 30 | 14,400 | 30,000 | 500,000 |

| llama3-groq-70b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llama3-groq-8b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llava-v1.5-7b-4096-preview | 30 | 14,400 | 30,000 | (Sin límite) |

| mixtral-8x7b-32768 | 30 | 14,400 | 5,000 | 500,000 |

De voz a texto

| ID | Peticiones por minuto | Solicitudes por día | Segundos de audio por hora | Segundos de audio al día |

|---|---|---|---|---|

| destil-whisper-large-v3-es | 20 | 2,000 | 7,200 | 28,800 |

| whisper-large-v3 | 20 | 2,000 | 7,200 | 28,800 |

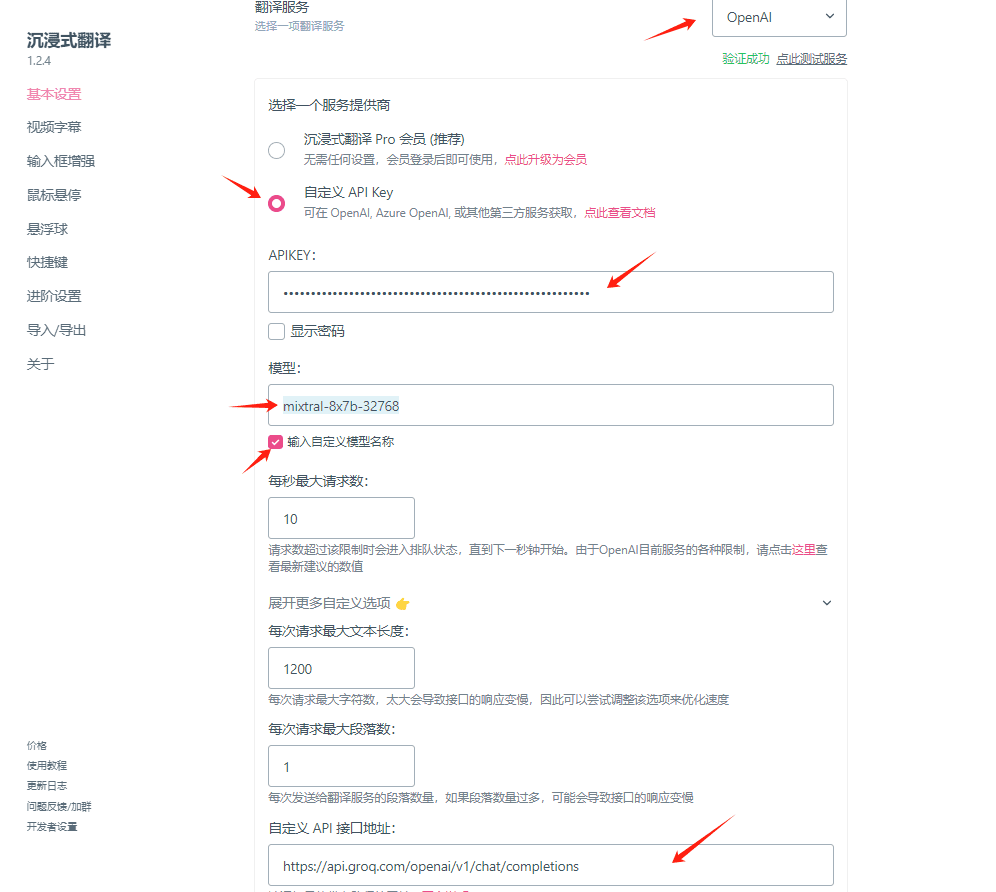

A continuación, tome como ejemplo el formato curl, esta interfaz es compatible con el formato de interfaz OPENAI, así que use su imaginación, siempre y cuando existan interfaces que permitan la personalización de la API OPENAI, así como el uso de Groq.

curl -X POST "https://api.groq.com/openai/v1/chat/completions" \

-H "Authorisation: Bearer $GROQ_API_KEY" \

-H "Content-Type: application/json" \

-d '{"messages": [{"role": "user", "content": "Explain the importance of low latency LLMs"}], "model": "mixtral-8x7b-32768"}'

Ejemplo de uso: Configuración de claves Groq para su uso en el complemento de traducción inmersiva

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...