GPT-Crawler: rastreo automático de contenidos web para generar documentos de bases de conocimiento

Últimos recursos sobre IAActualizado hace 8 meses Círculo de intercambio de inteligencia artificial 50.9K 00

Introducción general

GPT-Crawler es una herramienta de código abierto desarrollada por el equipo BuilderIO y alojada en GitHub. Rastrea el contenido de las páginas introduciendo una o varias URL de sitios web, generando documentos de conocimiento estructurado (output.json) para crear asistentes GPT o AI personalizados. Los usuarios pueden configurar reglas de rastreo, como especificar una URL de inicio y un selector de contenido, y la herramienta extrae automáticamente el texto y lo organiza en archivos. La herramienta es fácil de usar y admite ejecuciones locales, despliegues de contenedores Docker y llamadas a la API, lo que la hace ideal para que los desarrolladores creen rápidamente asistentes de IA propios a partir del contenido de sitios web. De momento, está ganando adeptos en la comunidad tecnológica, popular por su eficacia y su naturaleza de código abierto.

Lista de funciones

- Rastrea el contenido de un sitio web a partir de una o varias URL, generando

output.jsonDocumentación. - Compatibilidad con reglas de rastreo personalizadas, incluidas URL de inicio, patrones de coincidencia de enlaces y selectores CSS.

- Capacidad para manejar páginas web dinámicas y rastrear contenido renderizado del lado del cliente utilizando un navegador sin cabeza.

- Proporciona una interfaz API para iniciar tareas de rastreo mediante solicitudes POST.

- Permite establecer el número máximo de páginas (

maxPagesToCrawl), el tamaño del documento (maxFileSize) y el número de fichas (maxTokens). - Los archivos generados pueden cargarse directamente en OpenAI para crear GPT personalizados o asistentes de IA.

- Soporta la ejecución de contenedores Docker, fácil de desplegar en diferentes entornos.

- Es posible excluir determinados tipos de recursos (por ejemplo, imágenes, vídeos, etc.) para optimizar la eficacia del rastreo.

Utilizar la ayuda

Instalación y funcionamiento (modo local)

GPT-Crawler está basado en desarrollo Node.js, y necesita ser instalado para funcionar. Aquí están los pasos detallados:

- Comprobación del entorno

Asegúrese de que su ordenador tiene instalado Node.js (versión 16 o superior) y npm. ejecute el siguiente comando para confirmarlo:

node -v

npm -v

Si no lo tienes, descárgalo e instálalo desde el sitio web de Node.js.

- proyecto de clonación

Descargue el proyecto localmente escribiendo el comando en el terminal:

git clone https://github.com/BuilderIO/gpt-crawler.git

- Acceso al catálogo

Una vez finalizada la descarga, vaya a la carpeta del proyecto:

cd gpt-crawler

- Instalación de dependencias

Ejecute el siguiente comando para instalar los paquetes necesarios:

npm install

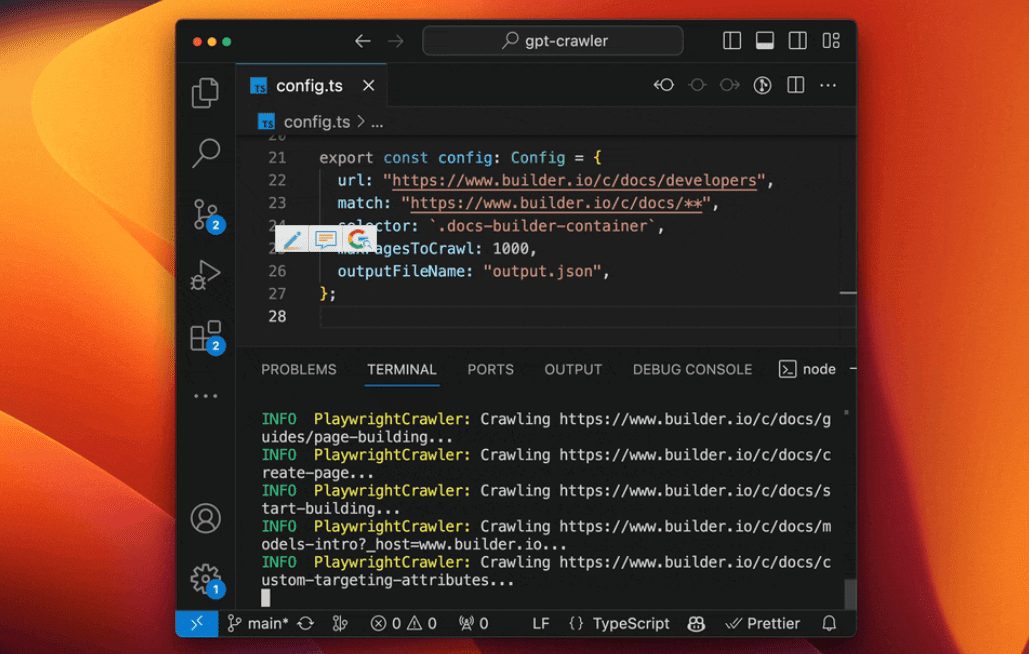

- Configuración del rastreador

espectáculo (una entrada)config.tsmodifique los parámetros de rastreo. Por ejemplo, para rastrear el documento Builder.io:

export const defaultConfig: Config = {

url: "https://www.builder.io/c/docs/developers",

match: "https://www.builder.io/c/docs/**",

selector: ".docs-builder-container",

maxPagesToCrawl: 50,

outputFileName: "output.json"

};

urlDirección de rastreo inicial.matchPatrón de concordancia de enlaces con comodines.selector: Selector CSS para extraer contenido.maxPagesToCrawlNúmero máximo de páginas a rastrear.outputFileNameNombre del archivo de salida.

- Ejecutar el rastreador

Una vez completada la configuración, ejecute el siguiente comando para iniciar el rastreo:

npm start

Al terminar.output.json en el directorio raíz del proyecto.

Modos de funcionamiento alternativos

Uso de contenedores Docker

- Asegúrese de que Docker está instalado (descargado del sitio web de Docker).

- entrar en

containerappCarpeta, Editarconfig.ts. - Ejecute el siguiente comando para construir e iniciar el contenedor:

docker build -t gpt-crawler .

docker run -v $(pwd)/data:/app/data gpt-crawler

- El archivo de salida se genera en

datacarpeta.

Funcionamiento con la API

- Tras instalar las dependencias, inicie el servicio API:

npm run start:server

- El servicio se ejecuta por defecto en el

http://localhost:3000. - Enviar una solicitud POST a

/crawlpor ejemplo:

curl -X POST http://localhost:3000/crawl -H "Content-Type: application/json" -d '{"url":"https://example.com","match":"https://example.com/**","selector":"body","maxPagesToCrawl":10,"outputFileName":"output.json"}'

- accesible

/api-docsConsulte la documentación de la API (basada en Swagger).

Cargar en OpenAI

- Creación de GPT personalizadas

- Abrir ChatGPT.

- Haz clic en tu nombre en la esquina inferior izquierda y selecciona "Mis GPTs".

- Haga clic en "Crear una GPT" > "Configurar" > "Conocimiento".

- cargar

output.jsonDocumentación. - Si el archivo es demasiado grande, el

config.tsestablecermaxFileSizetal vezmaxTokensArchivo dividido.

- Creación de asistentes personalizados

- Abre la plataforma OpenAI.

- Haga clic en "+ Crear" > "Cargar".

- cargar

output.jsonDocumentación.

Funciones

- Rastrear contenido

indicar claramente y con certezaurlresponder cantandoselectorDespués, la herramienta extrae el texto de la página. Por ejemplo..docs-builder-containerCoge sólo el contenido de la región. - Generar archivos

El formato del archivo de salida es:

[{"title": "页面标题", "url": "https://example.com/page", "html": "提取的文本"}, ...]

- Producción optimizada

utilizarresourceExclusionsExcluir los recursos ajenos (p. ej.pngyjpg), lo que reduce el tamaño del archivo.

advertencia

- Se requiere una cuenta de pago OpenAI para crear GPTs personalizados.

- El rastreo web dinámico se basa en navegadores sin cabeza para garantizar la integridad de las dependencias.

- La configuración se puede ajustar para dividir la carga cuando el archivo es demasiado grande.

escenario de aplicación

- Asistente de soporte técnico

Rastrea sitios web de documentación de productos para generar asistentes de IA que ayuden a los usuarios a responder preguntas técnicas. - Herramientas de organización de contenidos

Obtenga artículos de blogs o sitios de noticias para crear una base de conocimientos o un asistente de preguntas y respuestas. - Asistente de educación y formación

Rastree páginas de cursos en línea para generar asistentes de aprendizaje que proporcionen respuestas relacionadas con el curso.

CONTROL DE CALIDAD

- ¿Es posible rastrear varios sitios web?

Can. En elconfig.tsBasta con establecer varias URL y reglas de concordancia en el campo - ¿Y si el archivo es demasiado grande para cargarlo?

establecermaxFileSizetal vezmaxTokensdivide el archivo en varios archivos más pequeños. - ¿Apoyan los sitios web chinos?

Soporte. Mientras el contenido del sitio pueda ser analizado por navegadores sin cabecera, podrá ser rastreado correctamente.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...