FireRedASR: un modelo de código abierto para el reconocimiento multilingüe de voz de alta precisión

Últimos recursos sobre IAPublicado hace 12 meses Círculo de intercambio de inteligencia artificial 88.4K 00

Introducción general

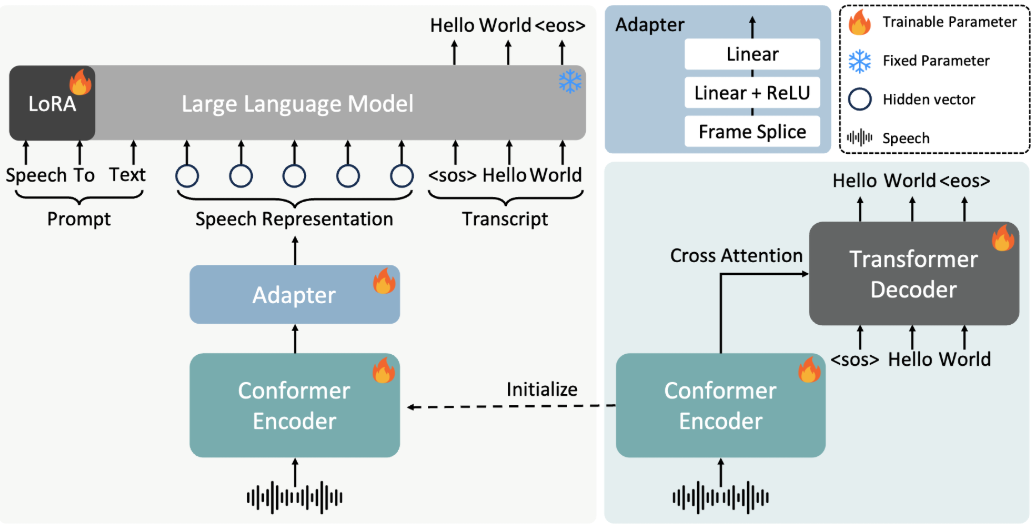

FireRedASR es un modelo de reconocimiento del habla desarrollado y de código abierto por el equipo de Little Red Book FireRed, que se centra en proporcionar un soporte multilingüe de alta precisión para soluciones de reconocimiento automático del habla (ASR). FireRedASR se divide en dos versiones principales: FireRedASR-LLM persigue una precisión extrema y es adecuado para necesidades profesionales; FireRedASR-AED equilibra la eficiencia y el rendimiento y es adecuado para aplicaciones en tiempo real. A partir de 2025, el modelo ha establecido el récord óptimo en la prueba de chino mandarín (CER 3.05%) y ha obtenido buenos resultados en pruebas multiescenario, lo que resulta ampliamente aplicable a asistentes inteligentes, generación de subtítulos de vídeo y otros campos.

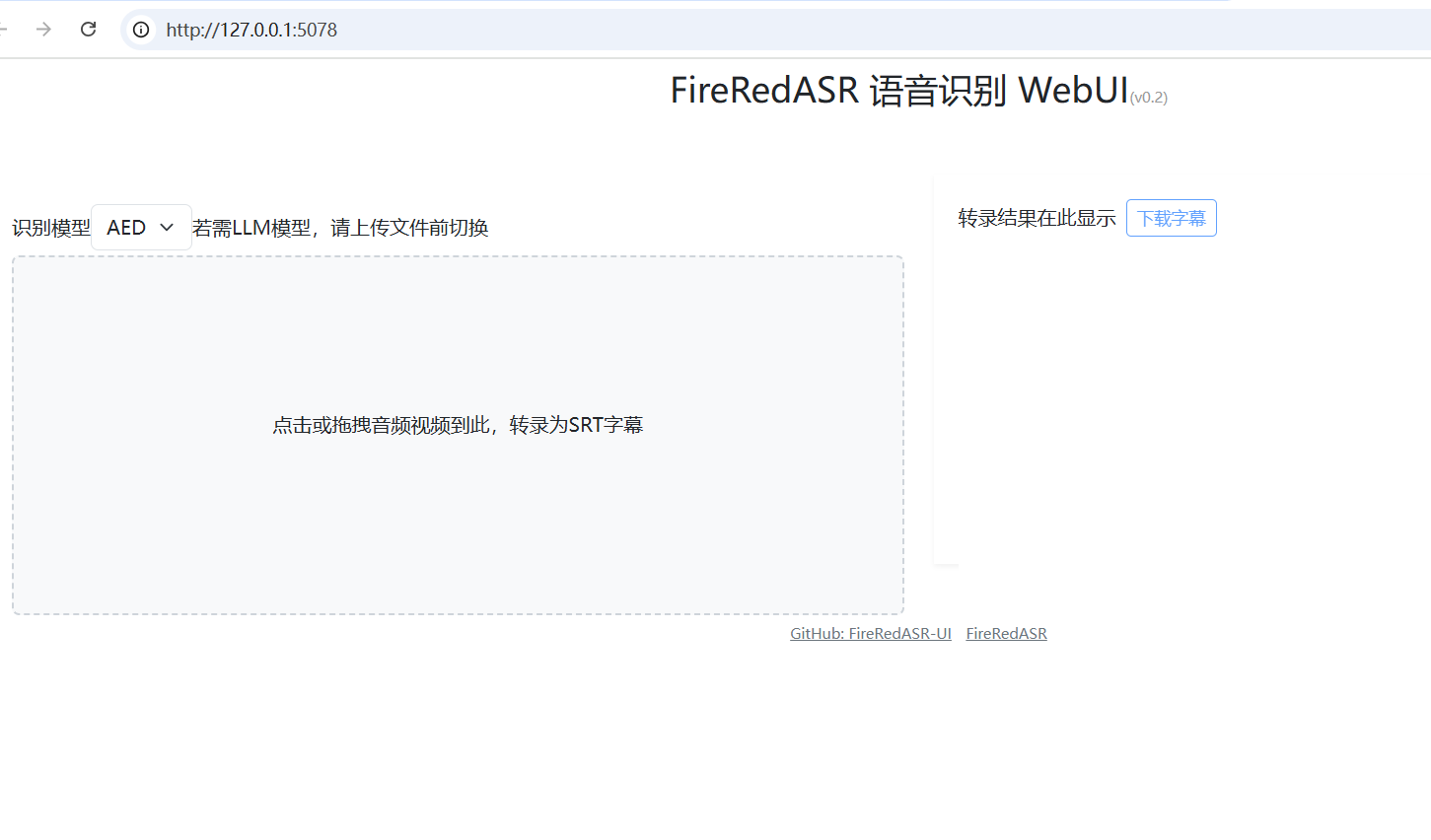

FireRedASR: Instalador de un solo clic WebUI: https://github.com/jianchang512/fireredasr-ui

Lista de funciones

- Admite la conversión de voz a texto en mandarín, dialectos chinos e inglés, con una precisión de reconocimiento líder en el sector.

- Ofrece la función de reconocimiento de letras de canciones, especialmente indicada para el tratamiento de contenidos multimedia.

- Se incluyen dos versiones, FireRedASR-LLM y FireRedASR-AED, para satisfacer las necesidades de inferencia de alta precisión y alta eficiencia, respectivamente.

- Modelos y código de razonamiento de código abierto para apoyar el desarrollo secundario comunitario y las aplicaciones personalizadas.

- Puede manejar una gran variedad de escenarios de entrada de audio, como vídeos cortos, streaming en directo, entrada de voz, etc.

- Admite el procesamiento de audio por lotes, adecuado para tareas de transcripción de datos a gran escala.

Utilizar la ayuda

Proceso de instalación

FireRedASR requiere ciertas configuraciones del entorno de desarrollo para funcionar, a continuación se detallan los pasos de instalación:

1.Clonación del almacén de proyectos

Abra un terminal e introduzca el siguiente comando para clonar el proyecto FireRedASR localmente:

git clone https://github.com/FireRedTeam/FireRedASR.git

Cuando haya terminado, vaya al catálogo de proyectos:

cd FireRedASR

- Creación de un entorno Python

Se recomienda crear un entorno Python separado usando Conda para asegurar el aislamiento de dependencias. Ejecute el siguiente comando:

conda create --name fireredasr python=3.10

Activar el entorno:

conda activate fireredasr

- Instalación de dependencias

El proyecto ofrece unrequirements.txtque contiene todas las dependencias necesarias. El comando de instalación es el siguiente:

pip install -r requirements.txt

Espera a que se complete la instalación, asegúrate de que la red es fluida, puede que necesites una herramienta científica de Internet para acelerar la descarga.

- Descargar modelo preentrenado

- FireRedASR-AED-LDescarga el modelo preentrenado directamente de GitHub o de Hugging Face, introdúcelo en el archivo

pretrained_models/FireRedASR-AED-LCarpeta. - Rojo FuegoASR-LLM-LAdemás de descargar el modelo, también es necesario descargar el modelo Qwen2-7B-Instruct en el archivo

pretrained_modelsy en la carpetaFireRedASR-LLM-Lpara crear enlaces blandos:

ln -s ../Qwen2-7B-Instruct

- Verificar la instalación

Ejecute el siguiente comando para comprobar si la instalación se ha realizado correctamente:

python speech2text.py --help

Si aparece un mensaje de ayuda, el entorno está configurado correctamente.

Cómo utilizarlo

FireRedASR proporciona dos maneras de utilizar la línea de comandos y la API de Python, la siguiente es una descripción detallada de las principales funciones del proceso de operación.

operación desde la línea de comandos

- Transcripción de un solo archivo (modelo DEA)

Utilice FireRedASR-AED-L para procesar archivos de audio (hasta 60 segundos):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_pathEspecifica la ruta del archivo de audio.--asr_type: Selecciona el tipo de modelo, en este caso "aed".--model_dir: Especifica la carpeta del modelo.

La salida se muestra en el terminal, por ejemplo, el contenido del texto transcrito.

- Transcripción de un solo archivo (modelo LLM)

Utilice FireRedASR-LLM-L para procesar audio (hasta 30 segundos):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

El significado del parámetro es el mismo que el anterior, y la salida es texto transcrito.

Operaciones de la API de Python

- Cargar modelo y transcribir

Llame al modelo FireRedASR en un script de Python:

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- from_pretrainedCarga el modelo especificado.

- transcribir: Realiza una tarea de transcripción y devuelve el resultado como una lista de textos.

- Ajuste de los parámetros para optimizar los resultados

- usar_gpu: Establece 1 para usar la aceleración de la GPU, 0 para usar la CPU.

- tamaño_haz: La anchura del haz de búsqueda, cuanto mayor sea mayor será la precisión pero más tiempo consumirá, por defecto 3.

- nbest: Devuelve el número óptimo de resultados, por defecto 1.

Función destacada Operación

- reconocimiento lírico

El FireRedASR-LLM destaca en el reconocimiento de letras. Introduce el audio de la canción (asegúrate de que no dura más de 30 segundos), ejecútalo:python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**Salida como texto de canción con tasas de reconocimiento líderes en el sector. **

- Soporte multilingüe

Para audio dialectal o en inglés, utilice directamente los comandos o API anteriores y el modelo se adaptará automáticamente. Por ejemplo, procesamiento de audio en inglés:model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

advertencia

- Límite de duración del audio: DEA soportado hasta 60 segundos, más allá de los cuales pueden producirse problemas alucinatorios; LLM soportado durante 30 segundos, con comportamiento extralargo indefinido.

- archivo por lotes: Asegúrese de que las longitudes de audio de entrada son similares para evitar la degradación del rendimiento.

- requisitos de hardware: Se recomienda utilizar la GPU para ejecutar modelos grandes, ya que la CPU puede ser más lenta.

Mediante los pasos anteriores, los usuarios pueden empezar a utilizar FireRedASR fácilmente y completar todo el proceso, desde la instalación hasta el uso, que es aplicable a una gran variedad de escenarios de reconocimiento de voz.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...