ER NeRF: construcción de un sistema de síntesis de vídeo para cabezas parlantes de alta fidelidad

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 49.4K 00

Introducción general

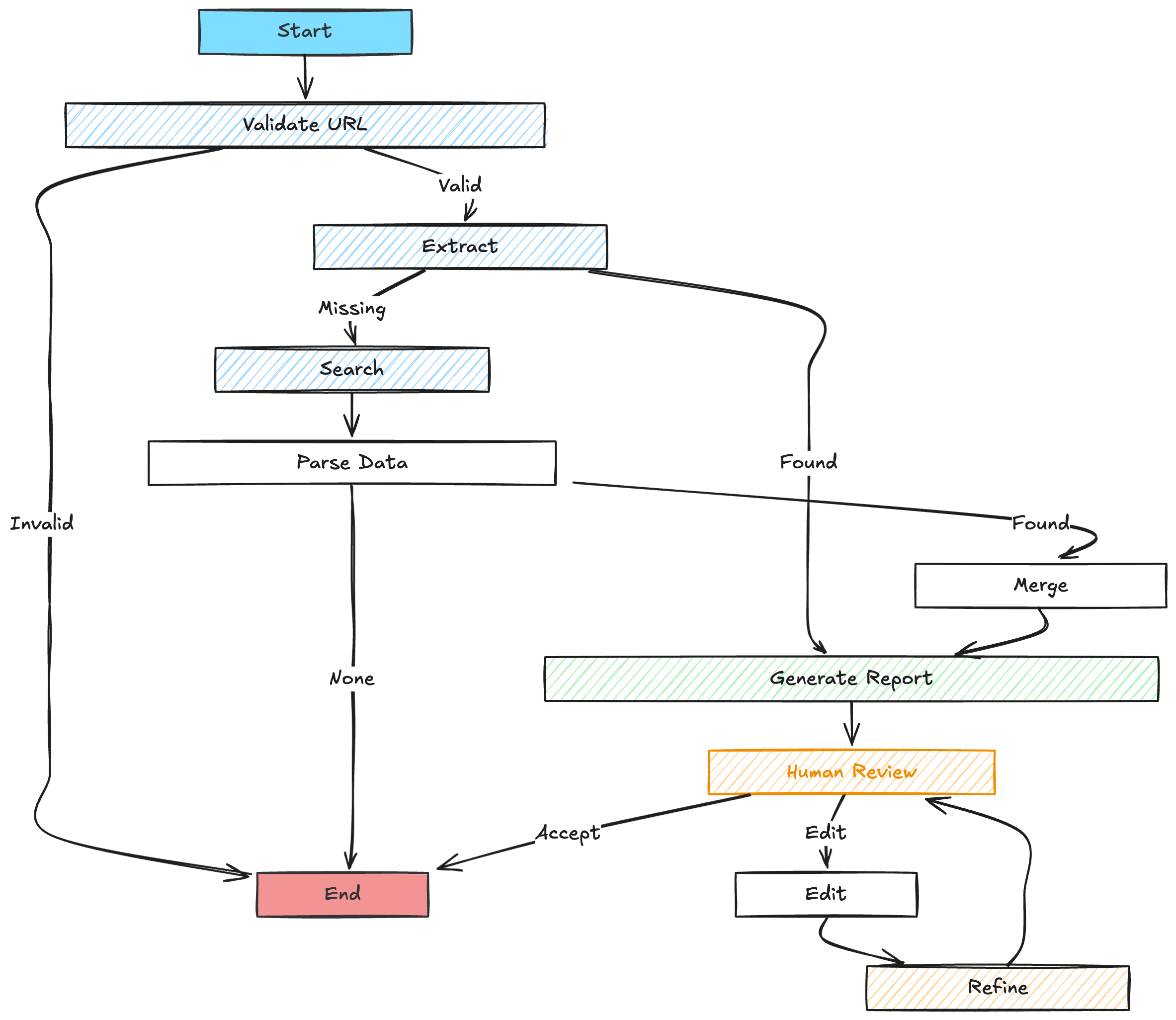

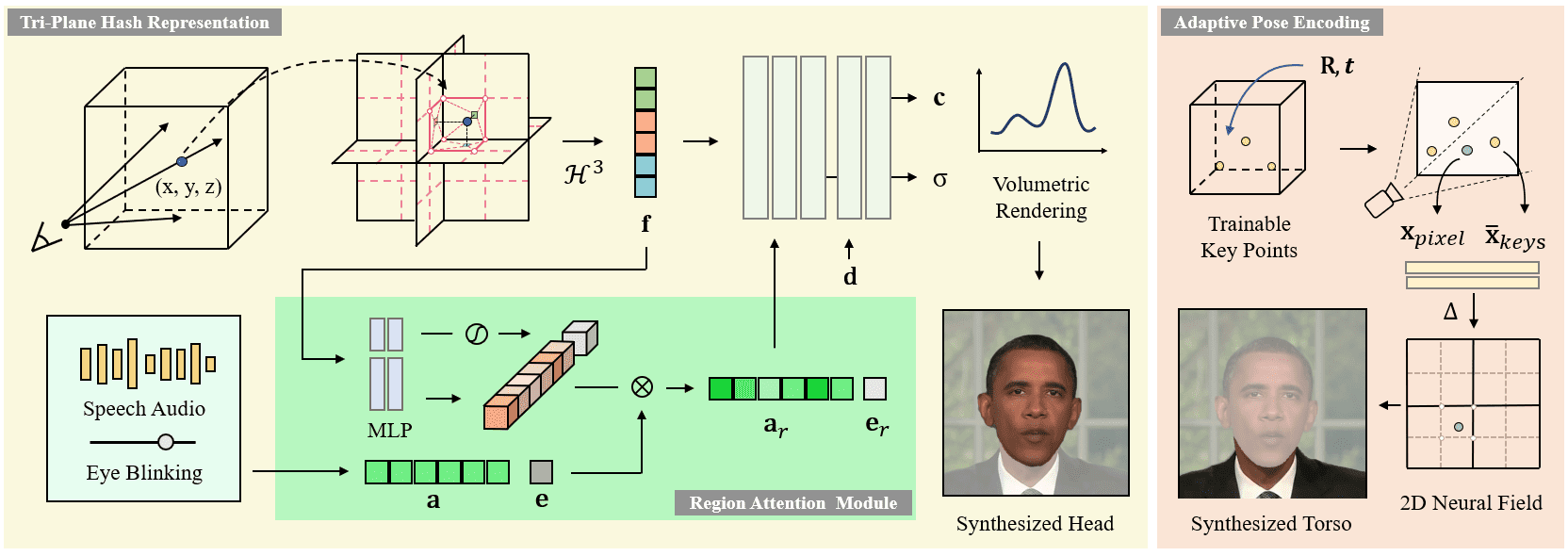

ER-NeRF (Efficient Region-Aware Neural Radiance Fields) es un sistema de síntesis de personajes parlantes de código abierto presentado en ICCV 2023. El proyecto utiliza la técnica Region-Aware Neural Radiance Fields para generar de forma eficiente vídeos de alta fidelidad de personajes parlantes. Las principales características del sistema son un esquema de procesamiento regionalizado que modela la cabeza y el torso del personaje por separado, y una innovadora técnica de descomposición del espacio de audio que permite una sincronización labial más precisa. El proyecto proporciona un código completo de entrenamiento e inferencia, admite vídeos de entrenamiento personalizados y puede utilizar diferentes extractores de características de audio (por ejemplo, DeepSpeech, Wav2Vec, HuBERT, etc.) para procesar la entrada de audio. El sistema consigue mejoras significativas tanto en calidad visual como en eficiencia computacional, proporcionando una importante solución técnica en el campo de la síntesis de caracteres parlantes.

Nuevo proyecto: https://github.com/Fictionarry/TalkingGaussian

Lista de funciones

- Composición en vídeo de alta fidelidad de cabezas parlantes

- Representación neuronal del campo de radiación para la percepción de áreas

- Permite modelar por separado la cabeza y el torso

- Sincronización precisa de los labios

- Soporte para extracción de múltiples características de audio (DeepSpeech/Wav2Vec/HuBERT)

- Soporte de formación en vídeo personalizado

- Generación de animación de personajes basada en audio

- Control suave del movimiento de la cabeza

- Compatibilidad con el movimiento de parpadeo (función AU45)

- Función de optimización del ajuste fino LPIPS

Utilizar la ayuda

1. Configuración medioambiental

Requisitos del entorno operativo del sistema:

- Sistema operativo Ubuntu 18.04

- PyTorch versión 1.12

- CUDA 11.3

Pasos de la instalación:

- Crea un entorno conda:

conda create -n ernerf python=3.10

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

- Instalar dependencias adicionales:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

2. Elaboración de modelos de pretratamiento

Es necesario descargar y preparar los siguientes archivos de modelo:

- Modelo de análisis facial

- Modelo 3DMM de estimación de la actitud de la cabeza

- Modelo Basel Face 2009

3. Personalizar el proceso de formación por vídeo

- Requisitos para la preparación del vídeo:

- Formato: MP4

- Frecuencia de imagen: 25FPS

- Resolución: 512x512 recomendada

- Duración: 1-5 minutos

- Requiere que cada fotograma contenga caracteres parlantes

- Preprocesamiento de datos:

python data_utils/process.py data/<ID>/<ID>.mp4

- Extracción de características de audio (una de tres):

- Extracción de características de DeepSpeech:

python data_utils/deepspeech_features/extract_ds_features.py --input data/<n>.wav

- Extracción de características Wav2Vec:

python data_utils/wav2vec.py --wav data/<n>.wav --save_feats

- Extracción de características HuBERT (recomendada):

python data_utils/hubert.py --wav data/<n>.wav

4. Formación de modelos

El entrenamiento se divide en dos fases: entrenamiento de la cabeza y entrenamiento del tronco:

- Entrenamiento de la cabeza:

python main.py data/obama/ --workspace trial_obama/ -O --iters 100000

python main.py data/obama/ --workspace trial_obama/ -O --iters 125000 --finetune_lips --patch_size 32

- Entrenamiento del torso:

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --head_ckpt <head>.pth --iters 200000

5. Comprobación e inferencia de modelos

- Efectos del modelo de prueba:

# 仅渲染头部

python main.py data/obama/ --workspace trial_obama/ -O --test

# 渲染头部和躯干

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --test

- Razonamiento con audio de destino:

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --test --test_train --aud <audio>.npy

Consejo: Añadir el parámetro --smooth_path reduce las fluctuaciones de la cabeza, pero puede reducir la precisión de la actitud.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...