DragAnything: generación de vídeo basada en silicio para controlar el movimiento de objetos sólidos en imágenes

Últimos recursos sobre IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 45.4K 00

Introducción general

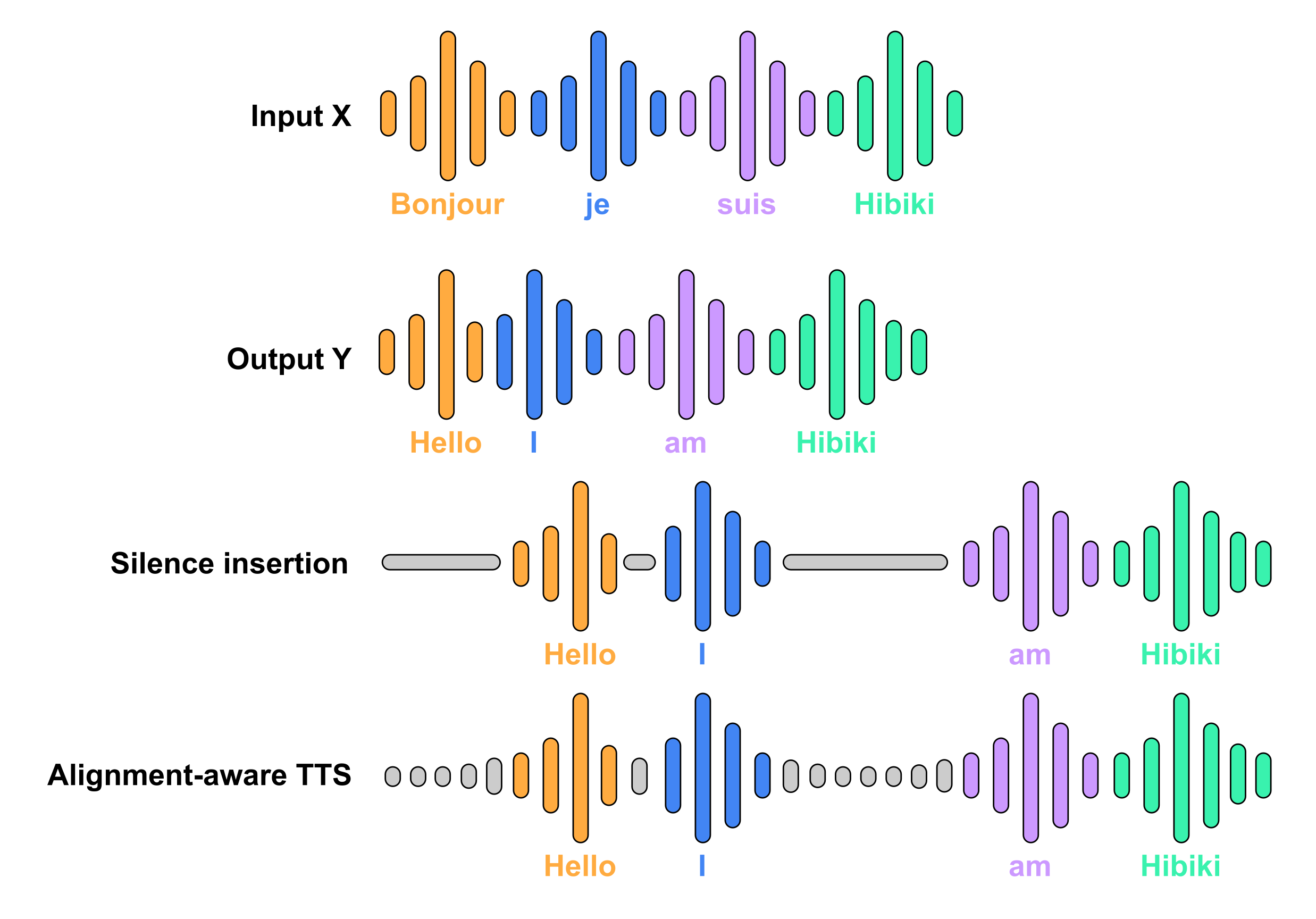

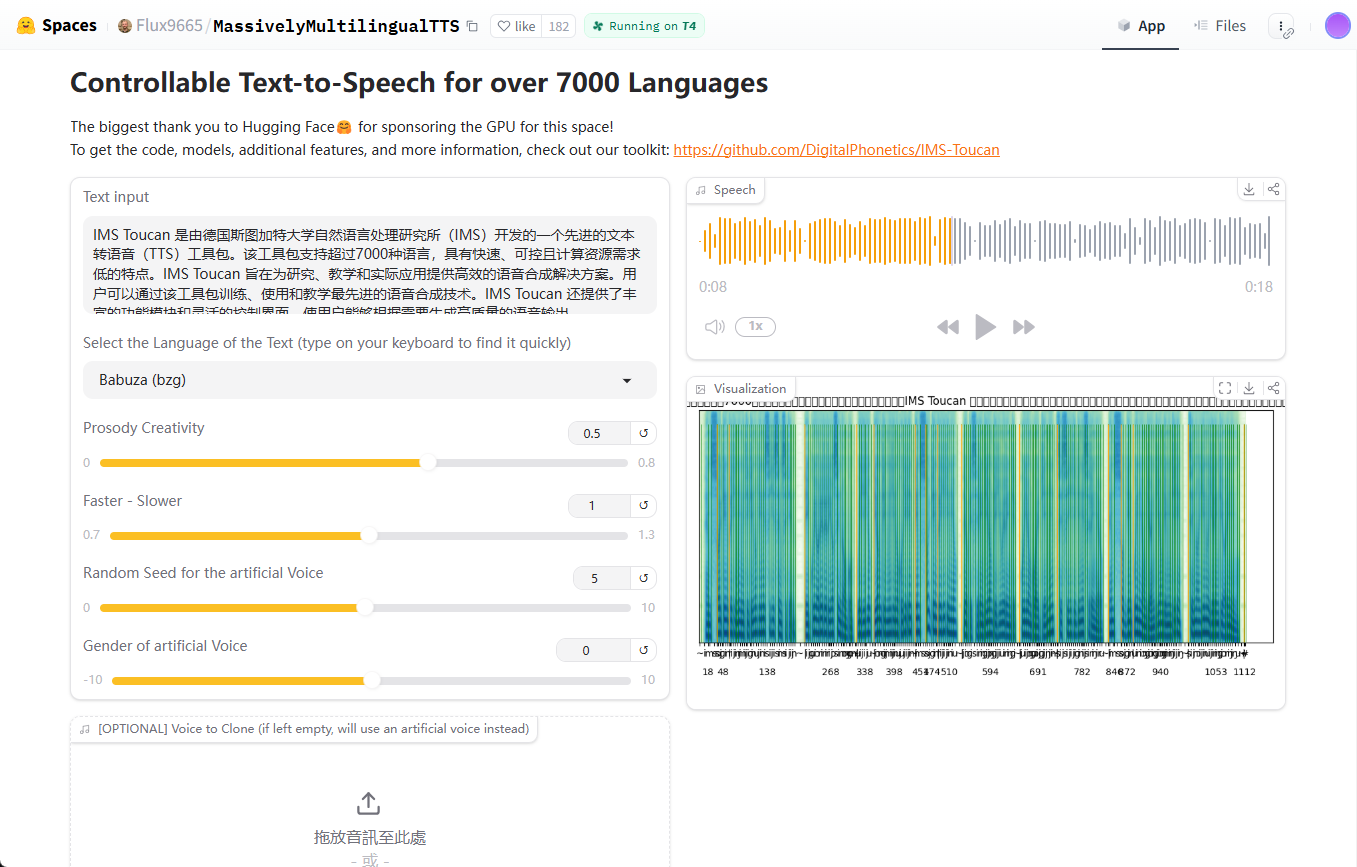

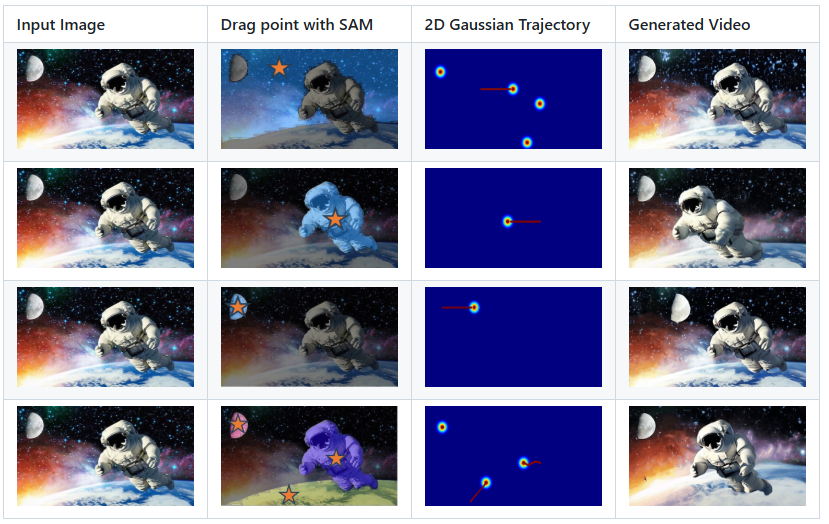

DragAnything es un proyecto de código abierto cuyo objetivo es lograr el control del movimiento de objetos arbitrarios mediante la representación de entidades. Desarrollado por el equipo de Showlab y aceptado por ECCV 2024, DragAnything ofrece una forma sencilla de interactuar con objetos simplemente dibujando una línea de trayectoria para controlar su movimiento. El proyecto admite el control simultáneo del movimiento de varios objetos, incluidos el primer plano, el fondo y el movimiento de la cámara. DragAnything supera a los métodos más avanzados en una serie de métricas, especialmente en el control del movimiento de objetos.

Lista de funciones

- Representación de entidades: utilice la incrustación de campo abierto para representar cualquier objeto.

- Control de trayectoria: el control del movimiento del objeto se consigue trazando líneas de trayectoria.

- Control multiobjeto: admite el control simultáneo del movimiento del primer plano, el fondo y la cámara.

- Demostraciones interactivas: Soporte para demostraciones interactivas utilizando Gradio.

- Admite los conjuntos de datos VIPSeg y Youtube-VOS.

- Alto rendimiento: excelente en FVD, FID y estudios de usuarios.

Utilizar la ayuda

Proceso de instalación

- Clona el código del proyecto:

git clone https://github.com/showlab/DragAnything.git

cd DragAnything

- Crear y activar un entorno Conda:

conda create -n DragAnything python=3.8

conda activate DragAnything

- Instale la dependencia:

pip install -r requirements.txt

- Prepara el conjunto de datos:

- Descargue los conjuntos de datos VIPSeg y Youtube-VOS en

./dataCatálogo.

- Descargue los conjuntos de datos VIPSeg y Youtube-VOS en

Utilización

- Ejecute una demostración interactiva:

python gradio_run.py

Abra su navegador y visite la dirección local proporcionada para empezar con la demostración interactiva.

- Controla el movimiento del objeto:

- Dibuje una línea de trayectoria en la imagen de entrada y seleccione el objeto que desea controlar.

- Ejecute el script para generar el vídeo:

python demo.py --input_image <path_to_image> --trajectory <path_to_trajectory>- El vídeo generado se guardará en el directorio especificado.

- Personaliza la trayectoria del movimiento:

- Utilice la herramienta Co-Track para procesar sus propios archivos de anotación de pistas de movimiento.

- Coloca los archivos procesados en el directorio especificado y ejecuta el script para generar el vídeo.

Funciones principales

- representación física: Represente cualquier objeto mediante la incrustación de campo abierto, sin necesidad de que el usuario anote manualmente el objeto.

- Control de trayectoriaEl usuario puede controlar el movimiento de un objeto simplemente dibujando una línea de trayectoria en la imagen de entrada.

- control multiobjetoPermite controlar el movimiento de varios objetos al mismo tiempo, incluidos el primer plano, el fondo y la cámara.

- Presentación interactiva: A través de la interfaz interactiva que ofrece Gradio, los usuarios pueden ver los efectos del control del movimiento en tiempo real.

- alto rendimiento: Excelente rendimiento en FVD, FID y estudios de usuario, especialmente en el control de movimiento de objetos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...