dots.vlm1 - Small red book hi lab open source multimodal large model

Últimos recursos sobre IAPublicado hace 7 meses Círculo de intercambio de inteligencia artificial 41.2K 00

¿Qué es dots.vlm1?

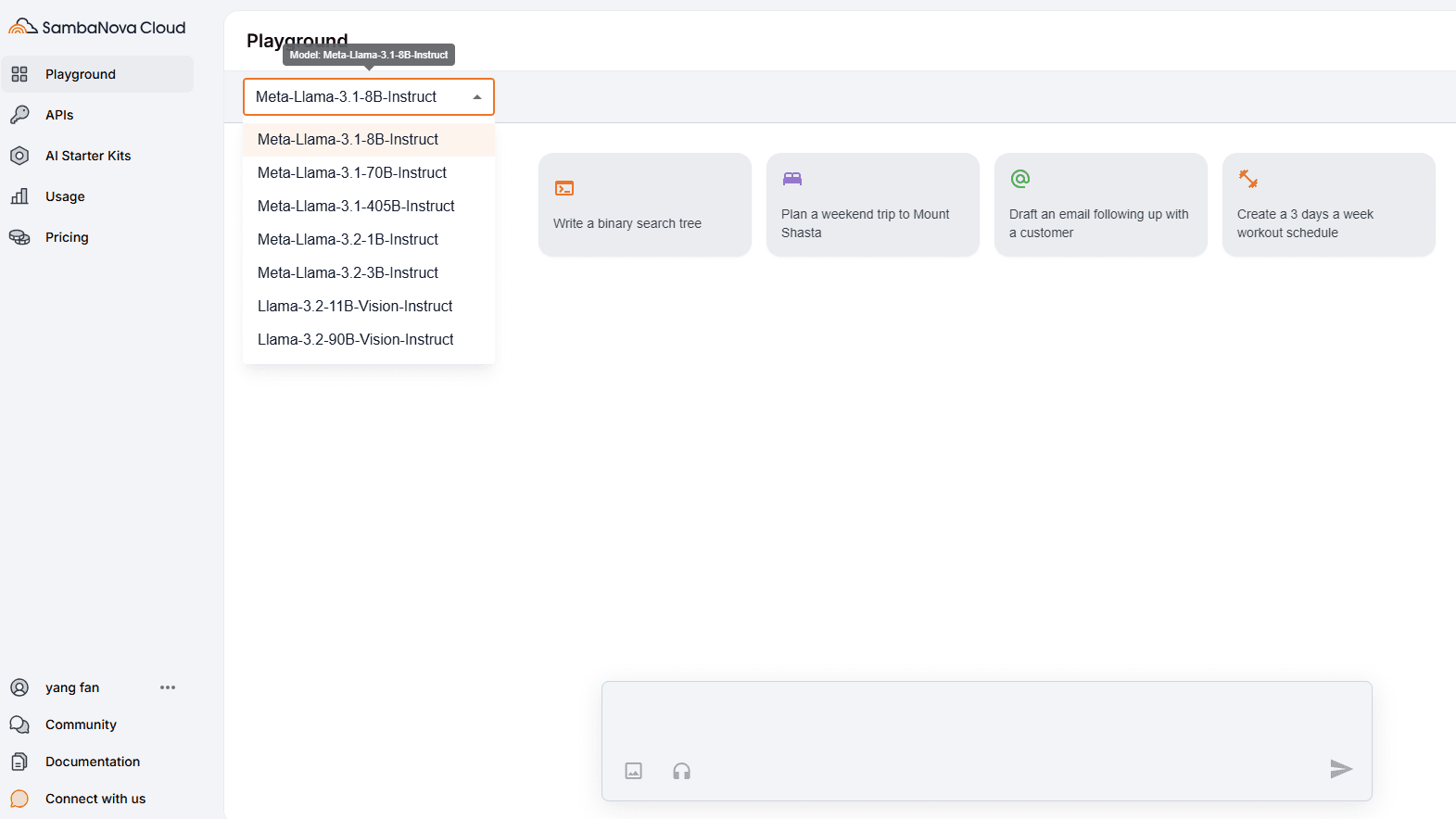

dots.vlm1 es el primer macromodelo multimodal de código abierto del Little Red Book hi lab. Basado en el codificador visual NaViT de 1.200 millones de parámetros entrenado desde cero y el DeepSeek V3 Large Language Model (LLM) con grandes capacidades de percepción visual y razonamiento textual. El codificador visual de dots.vlm1, NaViT, se entrena completamente desde cero, admite resolución dinámica de forma nativa y añade supervisión visual pura a la supervisión textual para mejorar las capacidades perceptivas. Los datos de entrenamiento introducen una variedad de ideas de datos sintéticos para cubrir diversos tipos de imágenes y sus descripciones para mejorar la calidad de los datos.

Principales funciones de dots.vlm1

- Gran comprensión visual: Reconoce y comprende con precisión el contenido de las imágenes, incluidos cuadros complejos, tablas, documentos, gráficos, etc., y admite una resolución dinámica para una amplia gama de tareas visuales.

- Generación y razonamiento eficientes de textos: Basado en DeepSeek V3 LLM, genera descripciones de texto de alta calidad y obtiene buenos resultados en tareas de razonamiento textual como matemáticas y código.

- Tratamiento multimodal de datosEl módulo de procesamiento de datos: admite el procesamiento de datos con entrelazado gráfico y textual, y puede combinar información visual y textual para el razonamiento integrado, lo que resulta adecuado para escenarios de aplicación multimodal.

- Adaptación y ampliación flexiblesEl adaptador MLP conecta el codificador visual con el modelo lingüístico, lo que permite una adaptación y ampliación flexibles a distintas tareas.

- Código abierto y apertura: Proporcionar código fuente abierto completo y modelos para apoyar a los desarrolladores en su investigación y desarrollo de aplicaciones y promover el desarrollo de la tecnología multimodal.

Dirección del proyecto dots.vlm1

- Repositorio GitHub:: https://github.com/rednote-hilab/dots.vlm1

- Biblioteca de modelos de caras abrazadas:: https://huggingface.co/rednote-hilab/dots.vlm1.inst

- Demostración de la experiencia en línea:: https://huggingface.co/spaces/rednote-hilab/dots-vlm1-demo

Principios técnicos de dots.vlm1

- Codificador visual NaViTEl programa dots.vlm1 utiliza NaViT, un codificador visual de 1.200 millones de parámetros entrenado desde cero, no afinado a partir de modelos maduros ya existentes. Soporte nativo para resolución dinámica, capaz de manejar entradas de imágenes de diferentes resoluciones, y supervisión puramente visual añadida a la supervisión textual para mejorar la percepción de imágenes por parte del modelo.

- Formación de datos multimodalesEl modelo adopta diversos datos de entrenamiento multimodales, como imágenes ordinarias, cuadros complejos, tablas, documentos, gráficos, etc., y sus correspondientes descripciones textuales (por ejemplo, Alt Text, Dense Caption, Grounding, etc.). Se introducen ideas de datos sintéticos y datos gráficos-textuales intercalados, como páginas web y PDF, para mejorar la calidad de los datos mediante su reescritura y limpieza, y potenciar la capacidad de comprensión multimodal del modelo.

- Fusión de modelos visuales y lingüísticosdots.vlm1 combina un codificador visual con el DeepSeek V3 Large Language Model (LLM), conectados a través de un adaptador MLP ligero, para permitir la fusión efectiva de información visual y lingüística para apoyar el procesamiento de tareas multimodales.

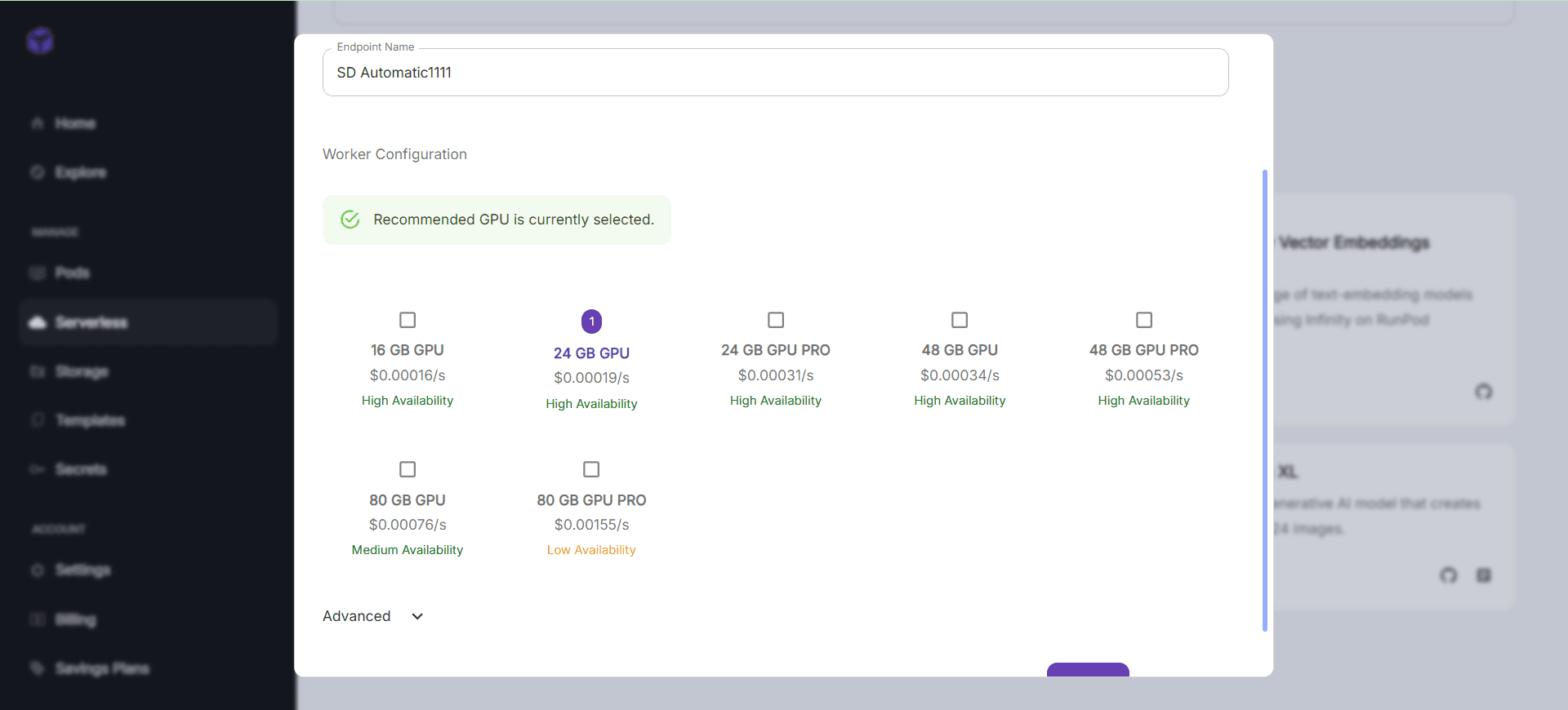

- Proceso de formación en tres fasesEl entrenamiento del modelo se divide en tres etapas: pre-entrenamiento del codificador visual, pre-entrenamiento del VLM y post-entrenamiento del VLM. La capacidad de generalización y de procesamiento de tareas multimodales del modelo se mejora aumentando gradualmente la resolución de la imagen e introduciendo diversos datos de entrenamiento.

Principales ventajas de dots.vlm1

- Codificador visual formado desde ceroUn codificador visual NaViT entrenado completamente desde cero, con soporte nativo de resolución dinámica y supervisión visual pura para elevar el límite superior de la percepción visual.

- Innovación en datos multimodales: La introducción de una variedad de ideas de datos sintéticos para cubrir diversos tipos de imágenes y sus descripciones, así como la reescritura de datos de páginas web utilizando un macromodelo multimodal, mejora significativamente la calidad de los datos de entrenamiento.

- Rendimiento cercano a SOTALograr un rendimiento cercano al de los modelos SOTA de código cerrado en percepción visual y razonamiento, estableciendo un nuevo límite superior de rendimiento para los modelos de lenguaje visual de código abierto.

- Potentes funciones de texto: Se desenvuelve bien en tareas de razonamiento textual, con algunos conocimientos matemáticos y de codificación, sin dejar de ser competitivo en tareas de texto sin formato.

- Diseño de arquitectura flexibleEl adaptador MLP conecta el codificador visual con el modelo lingüístico, lo que permite una adaptación y ampliación flexibles a distintas tareas.

Personas a las que va dirigido dots.vlm1

- Investigadores en inteligencia artificial: Interesado en macromodelado multimodal y le gustaría explorar su aplicación y mejora en el campo del procesamiento de la visión y el lenguaje.

- Desarrolladores e ingenierosLa necesidad de integrar en los proyectos funcionalidades multimodales como el reconocimiento de imágenes, la generación de textos, el razonamiento visual, etc.

- educadorEl modelo puede utilizarse para facilitar la enseñanza y ayudar a los alumnos a comprender y analizar mejor diagramas, documentos y otros contenidos complejos.

- creador de contenidos: La necesidad de generar contenidos gráficos de alta calidad, o de hacer recomendaciones de contenidos y creaciones personalizadas.

- usuario empresarialEn los escenarios empresariales en los que es necesario procesar datos multimodales, como el servicio inteligente de atención al cliente, la recomendación de contenidos, el análisis de datos, etc., se pueden utilizar modelos para mejorar la eficiencia y la eficacia.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...