Dolphin: reconocimiento de lenguas asiáticas y modelización de voz a texto para lenguas asiáticas

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 54.7K 00

Introducción general

Dolphin es un modelo de código abierto desarrollado por DataoceanAI en colaboración con la Universidad de Tsinghua, centrado en el reconocimiento del habla y del lenguaje para las lenguas asiáticas. Es compatible con 40 lenguas de Asia Oriental, Asia Meridional, Sudeste Asiático y Oriente Próximo, así como con 22 dialectos chinos. El modelo se ha entrenado con más de 210.000 horas de datos de audio, combinando conjuntos de datos propios y públicos. Dolphin puede convertir el habla en texto, así como detectar partes del discurso (VAD), segmentar audio y reconocer idiomas (LID). Está diseñado para ser sencillo, y el código y algunos de los modelos están disponibles gratuitamente en GitHub para los desarrolladores.

Lista de funciones

- Admite la conversión de voz a texto en 40 lenguas asiáticas y 22 dialectos chinos.

- Proporciona detección de actividad vocal (VAD) para encontrar segmentos de voz en el audio.

- Soporta división de audio, corta audio largo en pequeños segmentos para procesarlo.

- Implemente la identificación lingüística (LID) para determinar el idioma o dialecto del audio.

- Código fuente abierto y modelos que permiten la modificación y personalización por parte del usuario.

- Existen modelos base y pequeños para adaptarse a las distintas necesidades.

- Utilizar un sistema de etiquetado de dos niveles que distinga entre lenguas y regiones (por ejemplo.

<zh><CN>).

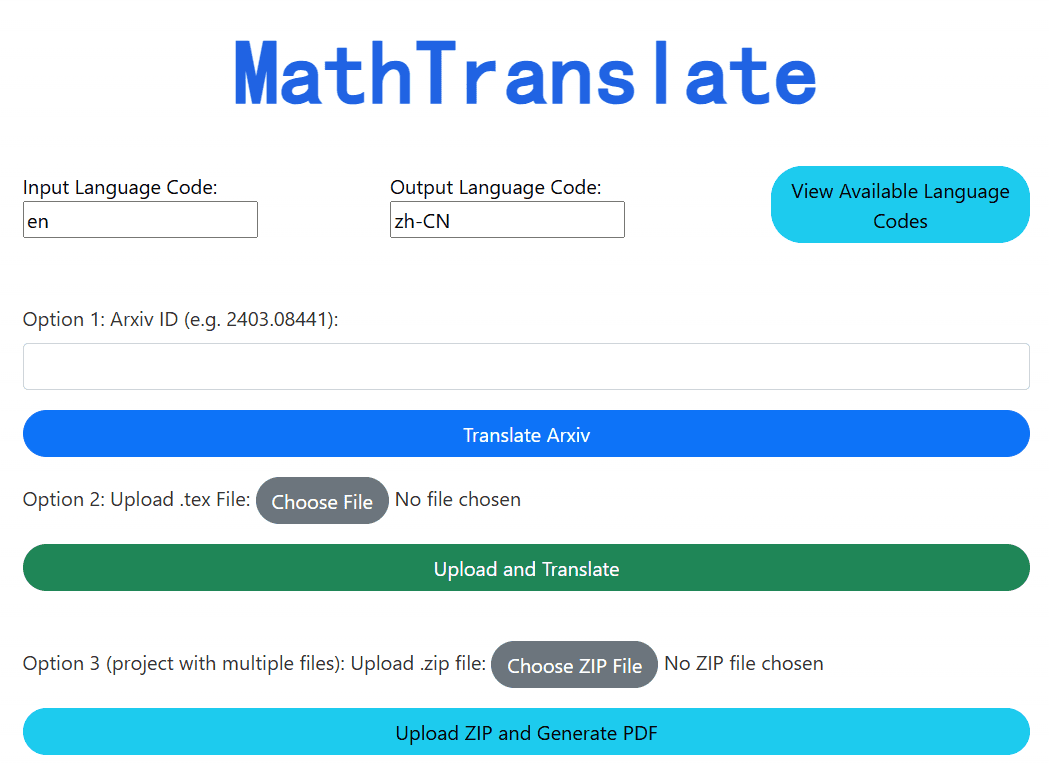

Utilizar la ayuda

El proceso de instalación y uso de Dolphin es sencillo y adecuado para usuarios con conocimientos básicos de programación. A continuación se detallan los pasos.

Proceso de instalación

- Preparar el entorno

Requiere Python 3.8 o superior, y FFmpeg para procesar audio.- Comprobación de Python: En el terminal, escriba

python --versionconfirmando la versión. - Python no está instalado y puede descargarse de python.org.

- Instale FFmpeg: ejecute el comando según su sistema:

- Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg - macOS:

brew install ffmpeg - Ventanas:

choco install ffmpeg

Las herramientas de gestión de paquetes desinstaladas pueden descargarse del sitio web de FFmpeg.

- Ubuntu/Debian:

- Comprobación de Python: En el terminal, escriba

- Instalación de Dolphin

Hay dos maneras:- Instalar con pip

Introdúcelo en el terminal:pip install -U dataoceanai-dolphinEsto instalará la última versión estable.

- Instalación a partir del código fuente

Para utilizar la última versión de desarrollo, consíguela en GitHub:- Almacén de clonación:

git clone https://github.com/DataoceanAI/Dolphin.git - Ir al catálogo:

cd Dolphin - Instalación:

pip install .

- Almacén de clonación:

- Instalar con pip

- Descargar modelos

Dolphin dispone de 4 modelos, actualmente están disponibles para descarga gratuita el modelo base (140M de parámetros) y el pequeño (372M de parámetros).- a través de (un hueco) Cara de abrazo Obtener el archivo del modelo.

- Guardar en la ruta especificada, por ejemplo

/data/models/dolphin/. - El modelo base es más rápido y el modelo pequeño es más preciso.

Utilización

Se admiten operaciones de línea de comandos y Python.

operación desde la línea de comandos

- Voz a texto

Prepare el archivo de audio (por ejemploaudio.wav), introduzca:

dolphin audio.wav

El sistema descarga automáticamente el modelo predeterminado y emite el texto. El audio debe estar en formato WAV y puede convertirse con FFmpeg:

ffmpeg -i input.mp3 output.wav

- Especificación de modelos y trayectorias

Utiliza el modelo pequeño:

dolphin audio.wav --model small --model_dir /data/models/dolphin/

- Especifique el idioma y la región

Reconocimiento del chino mandarín con marcadores de doble capa:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN"

lang_symes el código del idioma, como "zh" (chino).region_symes el prefijo, por ejemplo "CN" (China continental).

Para consultar la lista completa de lenguas, véase idiomas.md.

- Rellenar Audio Corto

Disponible cuando el audio dura menos de 30 segundos--padding_speech trueRelleno:

dolphin audio.wav --model small --model_dir /data/models/dolphin/ --lang_sym "zh" --region_sym "CN" --padding_speech true

Manipulación de código Python

- Carga de audio y modelos

Se ejecuta en Python:

import dolphin

waveform = dolphin.load_audio("audio.wav") # 加载音频

model = dolphin.load_model("small", "/data/models/dolphin/", "cuda") # 加载模型

"cuda"con GPU, sin GPU cambiar a"cpu".

- Reconocimiento ejecutivo

Procesa el audio y lo emite:result = model(waveform) # 转文本 print(result.text) # 显示结果 - Especifique el idioma y la región

Añade parámetros:result = model(waveform, lang_sym="zh", region_sym="CN") print(result.text)

Función destacada Operación

- Detección de actividad vocal (DAV)

Detecta automáticamente los segmentos del habla y los etiqueta con la hora, por ejemplo:0.0-2.5s: 你好 3.0-4.5s: 今天天气很好 - Identificación lingüística (LID)

Determina el idioma de audio, por ejemplo:dolphin audio.wav --model small --model_dir /data/models/dolphin/salida como

<zh>(chino) o<ja>(japonés). - marcado bilingüe

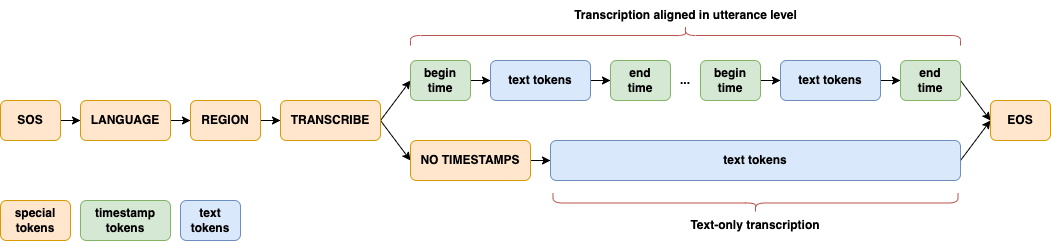

Distinguir entre lenguas y regiones con un etiquetado de dos niveles, por ejemplo.<zh><CN>(en chino mandarín),<zh><TW>(mandarín taiwanés) para mejorar las capacidades de procesamiento de lenguas asiáticas. - arquitectura modelo

La arquitectura CTC-Attention, con E-Branchformer para el codificador y Transformer para el descodificador, está optimizada para las lenguas asiáticas.

escenario de aplicación

- actas

Convierte en texto las grabaciones de conferencias multilingües asiáticas, adecuadas para reuniones internacionales o locales. - estudio dialectal

Analizar las características fonológicas de 22 dialectos chinos y generar datos de investigación. - Desarrollo de dispositivos inteligentes

Integración en dispositivos inteligentes para el control por voz en lenguas asiáticas.

CONTROL DE CALIDAD

- ¿Qué idiomas se admiten?

Compatibilidad con 40 lenguas asiáticas y 22 dialectos chinos, véase idiomas.md. - ¿Necesita una GPU?

No es necesario. La CPU puede funcionar, la GPU (compatible con CUDA) es más rápida. - ¿Cuál es la diferencia entre el modelo básico y el pequeño?

El modelo base es pequeño (140M parámetros) con una tasa de error de 33,31 TP3T; el modelo pequeño es grande (372M parámetros) con una tasa de error de 25,21 TP3T.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...