DeepSeek-VL2: un modelo de lenguaje visual experto para la comprensión multimodal avanzada

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 68.4K 00

Introducción general

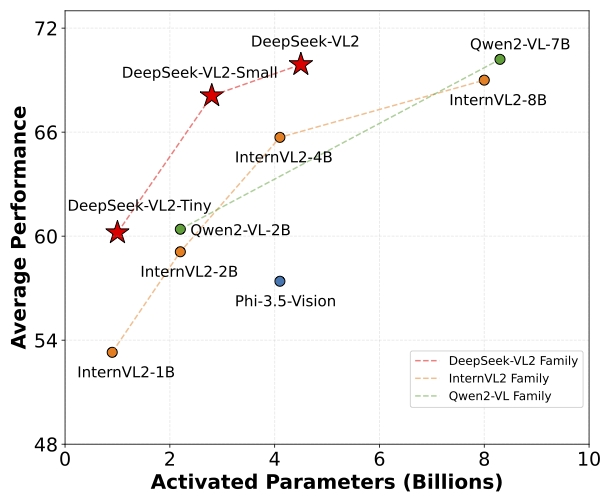

DeepSeek-VL2 es una serie de modelos avanzados de lenguaje visual basados en mezclas de expertos (MoE) que mejoran significativamente el rendimiento de su predecesor, DeepSeek-VL. La familia DeepSeek-VL2 consta de tres variantes: DeepSeek-VL2-Tiny, DeepSeek-VL2-Small y DeepSeek-VL2, que tienen 1.0B, 2.8B y 4.5B parámetros de activación, respectivamente. respectivamente. Los modelos alcanzan un rendimiento comparable o superior al de los modelos densos y MoE de código abierto existentes con un número de parámetros similar o inferior.

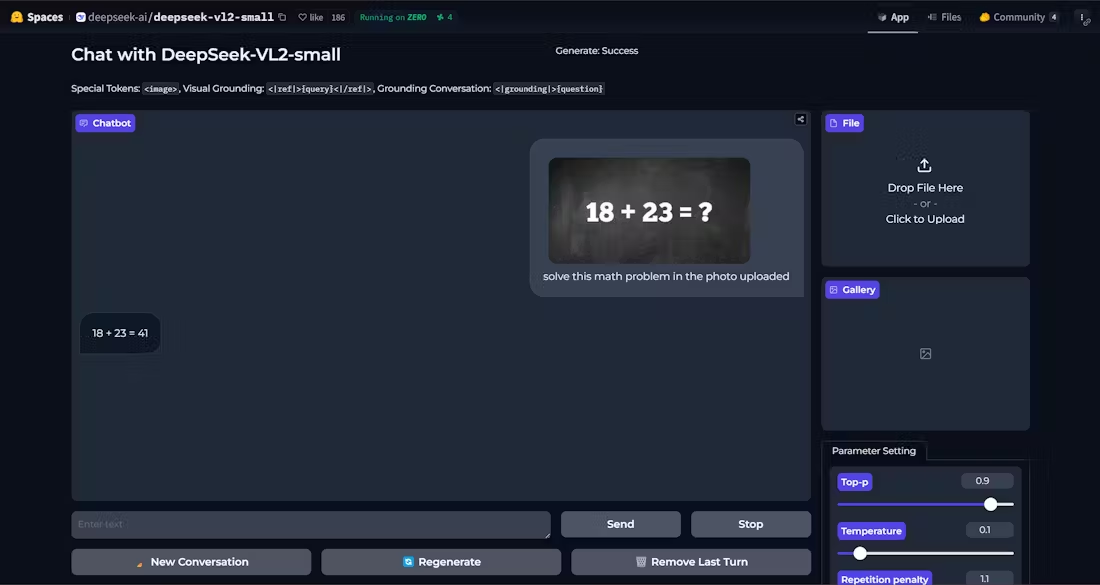

Demostración: https://huggingface.co/spaces/deepseek-ai/deepseek-vl2-small

Lista de funciones

- Preguntas y respuestas visuales: Apoya tareas complejas de preguntas visuales proporcionando respuestas precisas.

- Reconocimiento óptico de caracteres (OCR)Reconocimiento eficaz del contenido textual de las imágenes.

- Comprensión de documentos: Análisis sintáctico y comprensión de la estructura y el contenido de documentos complejos.

- Comprensión de formas: Identifica y procesa datos tabulares para extraer información útil.

- Comprensión gráficaAnalizar e interpretar datos y tendencias en gráficos y diagramas.

- orientación visualLocaliza con precisión el objeto en la imagen.

- Soporte multivarianteLos modelos Tiny, Small y Standard están disponibles para satisfacer diferentes necesidades.

- Alto rendimiento: Reduce el número de parámetros de activación manteniendo un alto rendimiento.

Utilizar la ayuda

Proceso de instalación

- Asegúrese de que la versión de Python es >= 3.8.

- Clonación del repositorio DeepSeek-VL2:

git clone https://github.com/deepseek-ai/DeepSeek-VL2.git

- Vaya al directorio del proyecto e instale las dependencias necesarias:

cd DeepSeek-VL2

pip install -e .

ejemplo de uso

Ejemplo de razonamiento simple

A continuación se muestra un ejemplo de código para una inferencia simple utilizando DeepSeek-VL2:

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl2.models import DeepseekVLV2Processor, DeepseekVLV2ForCausalLM

from deepseek_vl2.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl2-tiny"

vl_chat_processor = DeepseekVLV2Processor.from_pretrained(model_path)

vl_model = DeepseekVLV2ForCausalLM.from_pretrained(model_path)

# 加载图像

images = load_pil_images(["path_to_image.jpg"])

# 推理

inputs = vl_chat_processor(images=images, return_tensors="pt")

outputs = vl_model.generate(**inputs)

print(outputs)

Flujo detallado de funcionamiento de las funciones

- Preguntas y respuestas visuales::

- Modelos de carga y procesadores.

- Introduzca una imagen y una pregunta y el modelo le devolverá la respuesta.

- Reconocimiento óptico de caracteres (OCR)::

- utilizar

DeepseekVLV2ProcessorCargar imagen. - Se recurre al modelo de inferencia para extraer el texto de la imagen.

- utilizar

- Comprensión de documentos::

- Carga la entrada que contiene la imagen del documento.

- El modelo analiza la estructura del documento y devuelve el resultado del análisis.

- Comprensión de formas::

- Introduzca una imagen que contenga el formulario.

- El modelo reconoce la estructura y el contenido del formulario y extrae la información clave.

- Comprensión gráfica::

- Cargar la imagen del gráfico.

- El modelo analiza los datos gráficos, proporcionando interpretación y análisis de tendencias.

- orientación visual::

- Introduzca una descripción y una imagen del objeto de destino.

- El modelo localiza el objeto objetivo en la imagen y devuelve las coordenadas de posición.

Con los pasos anteriores, los usuarios pueden aprovechar al máximo la potencia de DeepSeek-VL2 para completar diversas tareas complejas de lenguaje visual.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...