DeepSeek-RAG-Chatbot: un chatbot DeepSeek RAG de ejecución local

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 52K 00

Introducción general

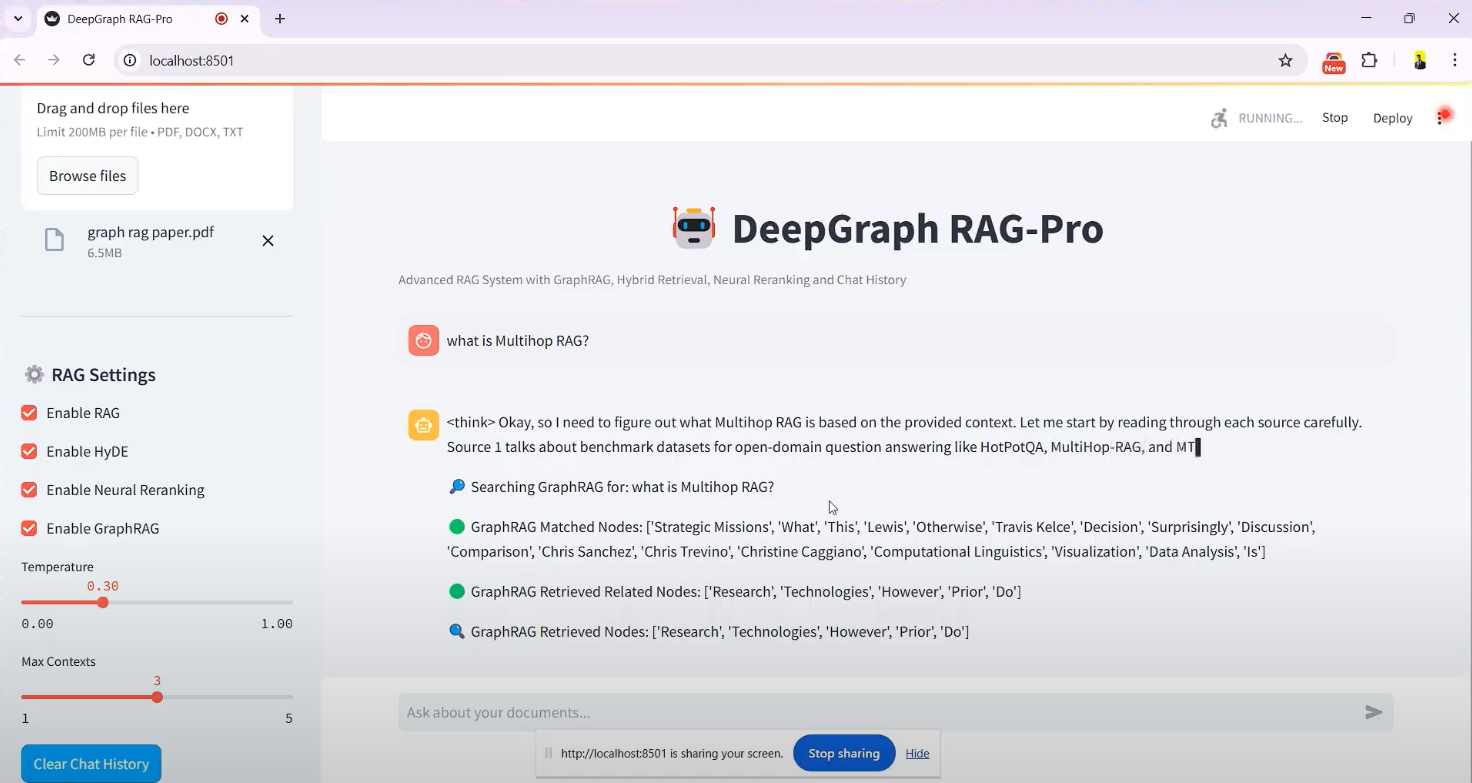

El DeepSeek-RAG-Chatbot es un sistema basado en la DeepSeek Proyecto de chatbot de código abierto basado en el modelo R1, alojado en GitHub, creado por el desarrollador SaiAkhil066. Combina la tecnología Retrieval Augmented Generation (RAG) para ayudar a los usuarios a cargar documentos (por ejemplo, archivos PDF, DOCX o TXT) con el fin de lograr una recuperación eficiente de documentos y preguntas y respuestas inteligentes mediante la ejecución local. El proyecto utiliza funciones avanzadas como la búsqueda híbrida (BM25 + FAISS), la reordenación neuronal y el grafo de conocimiento (GraphRAG) para garantizar la extracción de información contextualmente precisa y relevante de los documentos. Es adecuado para escenarios que requieren protección de la privacidad o uso fuera de línea, como la gestión del conocimiento personal y el procesamiento de documentos empresariales. El proyecto ofrece soporte para Docker y la interfaz Streamlit, que es fácil de instalar y los usuarios pueden empezar a utilizar fácilmente.

Lista de funciones

- Carga y tratamiento de documentosAdmite la carga de archivos en formato PDF, DOCX, TXT, etc., la división automática de documentos y la generación de incrustaciones vectoriales.

- Mecanismo de búsqueda híbridojunto con BM25 y las tecnologías FAISS para recuperar rápidamente el contenido relevante de los documentos.

- Soporte de grafos de conocimiento (GraphRAG): Construye un grafo de conocimiento de los documentos para comprender las relaciones entre entidades y mejorar la precisión contextual de las respuestas.

- reordenación neuronalReordenación de los resultados de búsqueda utilizando un modelo de codificación cruzada para garantizar que la información más relevante se muestre en primer lugar.

- Extensión de consulta (HyDE)Generación de respuestas hipotéticas para ampliar las consultas de los usuarios y mejorar la recuperación.

- Modelos locales: a través de Ollama adyuvante DeepSeek R1 y otros modelos se despliegan localmente para garantizar la privacidad de los datos.

- Transmisión de respuestas en tiempo realSalida en tiempo real: se proporciona una salida en tiempo real para que los usuarios puedan ver los resultados generados al instante.

- Soporte Docker: Simplifique la instalación y el funcionamiento con la implantación en contenedores Docker.

- Interfaz Streamlit: Interfaz gráfica intuitiva que facilita la carga de archivos y el chat interactivo.

Utilizar la ayuda

Proceso de instalación

DeepSeek-RAG-Chatbot es compatible con el funcionamiento local y requiere cierta configuración del entorno. A continuación se detallan los pasos de instalación:

condiciones previas

- sistema operativoWindows, macOS o Linux.

- requisitos de hardwareAl menos 8 GB de RAM (se recomiendan 16 GB) y una tarjeta gráfica compatible con CUDA si se utiliza aceleración por GPU.

- dependencia del softwarePython 3.8+, Git, Docker (opcional).

Paso 1: Clonar el proyecto

- Abre un terminal y ejecuta el siguiente comando para clonar tu repositorio de GitHub:

git clone https://github.com/SaiAkhil066/DeepSeek-RAG-Chatbot.git

- Vaya al catálogo de proyectos:

cd DeepSeek-RAG-Chatbot

Paso 2: Configuración del entorno Python

- Crear un entorno virtual:

python -m venv venv

- Active el entorno virtual:

- Ventanas:

venv\Scripts\activate - macOS/Linux:

source venv/bin/activate

- Actualizar pip e instalar dependencias:

pip install --upgrade pip

pip install -r requirements.txt

Las dependencias incluyen streamlitylangchainyfaiss-gpu(si hay GPU), etc.

Paso 3: Instalar y configurar Ollama

- Descargue e instale Ollama (visite ollama.com para obtener el paquete de instalación).

- Tire del modelo DeepSeek R1 (parámetros por defecto 7B, otras versiones como 1,5B o 32B están disponibles según sea necesario):

ollama pull deepseek-r1:7b

ollama pull nomic-embed-text

- Asegúrese de que el servicio Ollama se está ejecutando y que la dirección de escucha por defecto es

localhost:11434.

Paso 4: (Opcional) Despliegue de Docker

Si no desea configurar su entorno manualmente, puede utilizar Docker:

- Instale Docker (consulte docker.com).

- Ejecútelo en el directorio raíz del proyecto:

docker-compose up

- Docker extrae automáticamente los servicios de Ollama y chatbot, los ejecuta y, a continuación, accede a los servicios de

http://localhost:8501.

Paso 5: Iniciar la aplicación

- Ejecute Streamlit en un entorno virtual:

streamlit run app.py

- El navegador abrirá automáticamente la página

http://localhost:8501Entra en la pantalla de chat.

Funciones operativas

Función 1: Cargar documentos

- Cómo llegar a la interfazUna vez iniciada, la interfaz de Streamlit dispone de una barra lateral "Cargar documentos" en la parte izquierda de la pantalla.

- Seleccionar archivoHaga clic en el botón "Examinar archivos" para seleccionar un archivo local PDF, DOCX o TXT.

- Tramitación de documentosUna vez cargado, el sistema divide automáticamente el documento en trozos más pequeños, genera incrustaciones vectoriales y las almacena en FAISS. El tiempo de procesamiento varía en función del tamaño del archivo y suele oscilar entre unos segundos y unos minutos.

- llamar la atención sobre algo: Aparece un mensaje de confirmación "Procesamiento de archivos completado" en la barra lateral.

Función 2: Interrogar y buscar

- Cuestiones de entrada: Escriba una pregunta en el cuadro de chat en chino o inglés, por ejemplo: "¿Para qué sirve GraphRAG tal y como se menciona en la documentación?". en la documentación.

- proceso de recuperación::

- El sistema utiliza BM25 y FAISS para recuperar fragmentos de documentos relevantes.

- GraphRAG analiza las relaciones de entidad entre fragmentos.

- La reordenación neuronal optimiza el orden de los resultados.

- HyDE amplía la consulta para abarcar contenidos más relevantes.

- Generar respuestasDeepSeek R1 genera respuestas basadas en los resultados de la búsqueda, y las respuestas se emiten en formato streaming y se muestran paso a paso en la interfaz.

- ejemplo típicoSi pregunta "¿Qué es la búsqueda híbrida?" puede responder "La búsqueda híbrida combina BM25 y FAISS, BM25 se encarga de la concordancia de palabras clave y FAISS localiza rápidamente el contenido mediante similitud vectorial".

Función 3: Aplicación del grafo de conocimiento

- Activar GraphRAG: Activado por defecto, no requiere ninguna acción adicional.

- Formular preguntas complejasPor ejemplo: "¿Cuál es la relación de cooperación entre la empresa A y la empresa B?". .

- ResultadosEl sistema no sólo devuelve texto, sino que también proporciona respuestas relacionales basadas en el grafo de conocimiento, por ejemplo, "La empresa A y la empresa B firmaron un acuerdo de cooperación técnica en 2023".

Función 4: Ajuste de modelos y parámetros

- Modelo de sustitución: en

.envModificar en el archivoMODELpor ejemplo adeepseek-r1:1.5b. - optimizar el rendimientoSi el hardware lo admite, instale el

faiss-gpuCon la aceleración de la GPU activada, la velocidad de recuperación puede aumentar hasta 3 veces.

Trucos y consejos

- Soporte multidocumentoEl usuario puede cargar varios archivos al mismo tiempo y el sistema integrará el contenido para responder a las preguntas.

- claridad de los temasPara mejorar la precisión de sus respuestas, sea lo más concreto posible al formular las preguntas y evite las afirmaciones vagas.

- Comprobar registros: Si se encuentra con un error, puede consultar los registros del terminal para solucionar el problema, como que el modelo no se ha descargado o que el puerto está ocupado.

advertencia

- PrivacidadNo se requiere conexión a Internet para el funcionamiento local y los datos no se suben a la nube.

- ocupación de recursos: Los modelos grandes y los cálculos vectoriales de alta dimensión requieren mucha memoria, se recomienda cerrar los programas irrelevantes.

- Actualización del modelo: Funcionamiento regular

ollama pullConsigue la última versión del modelo DeepSeek.

Una vez completados los pasos anteriores, los usuarios pueden interactuar con DeepSeek-RAG-Chatbot a través de sus navegadores y disfrutar de una experiencia eficiente de cuestionamiento de documentos.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...