Deep Searcher: recuperación eficiente de documentos privados de empresas y preguntas y respuestas inteligentes

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 51.2K 00

Introducción general

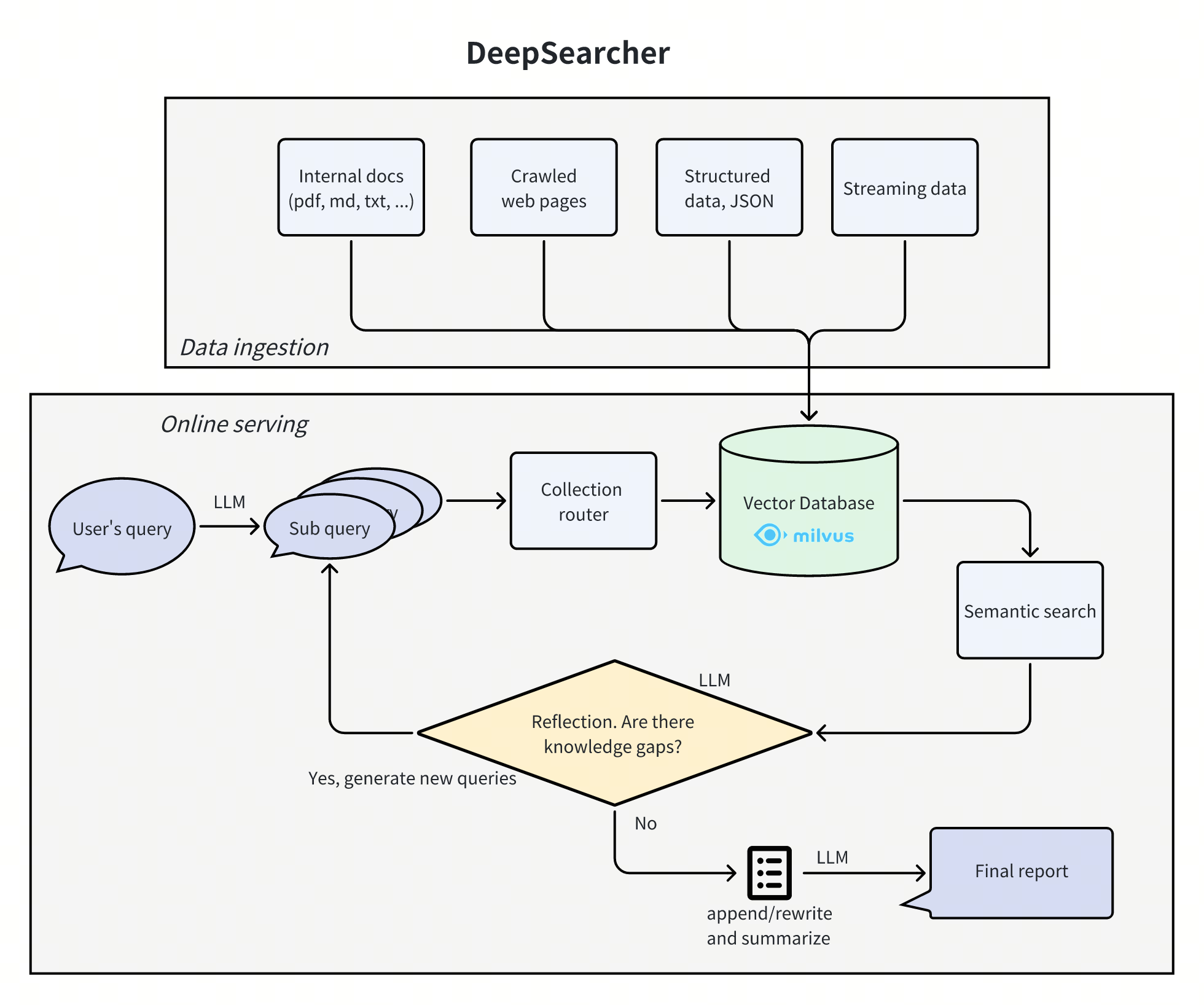

Deep Searcher es una combinación de potentes modelos lingüísticos de gran tamaño (como el DeepSeek y OpenAI) y bases de datos vectoriales (por ejemplo, Milvus) son herramientas diseñadas para buscar, evaluar y razonar a partir de datos privados, proporcionando respuestas muy precisas e informes exhaustivos. El proyecto es adecuado para la gestión del conocimiento empresarial, los sistemas inteligentes de preguntas y respuestas y los escenarios de recuperación de información.Deep Searcher admite una amplia gama de modelos de incrustación y grandes modelos lingüísticos, y es capaz de gestionar bases de datos vectoriales para garantizar una recuperación eficiente y un uso seguro de los datos.

Lista de funciones

- Búsqueda de datos privados: Maximizar el uso de los datos dentro de la empresa y garantizar su seguridad.

- Gestión de bases de datos vectorialesSoporte de bases de datos vectoriales como Milvus, que permite la partición de datos para una recuperación más eficaz.

- Opciones de incrustación flexibles: Compatible con múltiples modelos de incrustación para facilitar la selección de la mejor opción.

- Modelos multilingüesSoporte para grandes modelos como DeepSeek, OpenAI, etc. para preguntas y respuestas inteligentes y generación de contenidos.

- Cargador de documentosLa carga local de archivos está soportada y el rastreo web se añadirá en el futuro.

Utilizar la ayuda

Proceso de instalación

- Almacén de clonación:

git clone https://github.com/zilliztech/deep-searcher.git

- Crear un entorno virtual Python (recomendado):

python3 -m venv .venv

source .venv/bin/activate

- Instale la dependencia:

cd deep-searcher

pip install -e .

- Configuración de LLM o Milvus: Editar

examples/example1.pypara configurar LLM o Milvus según sea necesario. - Prepare los datos y ejecute el ejemplo:

python examples/example1.py

Instrucciones de uso

- Configuración de LLMEn

deepsearcher.configurationutilice el móduloset_provider_configpara configurar el LLM. Por ejemplo, configure el modelo OpenAI:

config.set_provider_config("llm", "OpenAI", {"model": "gpt-4o"})

- Cargar datos locales: Uso

deepsearcher.offline_loadingen el móduloload_from_local_filespara cargar datos locales:

load_from_local_files(paths_or_directory="your_local_path")

- Consultar datos: Uso

deepsearcher.online_queryen el móduloquerySe consultan los métodos:

result = query("Write a report about xxx.")

Flujo detallado de funcionamiento de las funciones

- Búsqueda de datos privados::

- Maximice el uso de los datos en su empresa al tiempo que garantiza su seguridad.

- Los contenidos en línea pueden integrarse cuando se necesiten respuestas más precisas.

- Gestión de bases de datos vectoriales::

- Admite bases de datos vectoriales como Milvus, lo que permite particionar los datos para una recuperación más eficaz.

- En el futuro está prevista la compatibilidad con más bases de datos vectoriales (por ejemplo, FAISS).

- Opciones de incrustación flexibles::

- Compatible con una amplia gama de modelos integrados para facilitar la selección de la mejor solución.

- Modelos multilingües::

- Compatibilidad con grandes modelos como DeepSeek, OpenAI, etc. para la generación inteligente de preguntas y respuestas y contenidos.

- Cargador de documentos::

- Admite la carga local de archivos y en el futuro se añadirá el rastreo web.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...