Cursor ¿Qué modelo de IA es el mejor para su tarea de codificación?

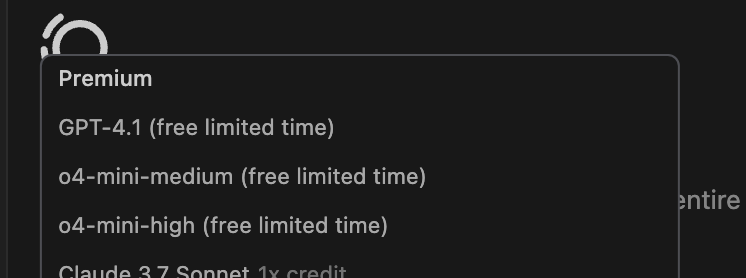

Recientemente, la herramienta de programación asistida por IA Cursor publicó una lista de los principales modelos de IA preferidos por los desarrolladores, y los datos muestran que Claude 3,7 El modelo Sonnet ocupa el primer puesto.

Estos datos oficiales reflejan sin duda la elección de una parte significativa de los desarrolladores. Pero, ¿significa esto que los desarrolladores deberían simplemente hacer de Claude 3.7 Sonnet la opción por defecto? El caso de uso real puede ser más complejo.

Si se observan los hábitos de uso de algunos desarrolladores veteranos, se aprecian diferencias significativas en sus ratios de selección de modelos con respecto a la lista oficial. Por ejemplo, en Cursor, Gemini 2.5 Pro puede llegar a utilizarse hasta 801 TP3T, Claude 3.7 Sonnet supone 101 TP3T, y GPT-3.5 y GPT-4.1 5% cada uno. En otros entornos de línea de comandos o de edición de código (como Roo o Cline y otras herramientas), Grok 3 puede incluso alcanzar una tasa de uso de 90%, con los 10% restantes asignados a la Géminis 2,5 Flash, rara vez se llama a otros modelos.

Detrás de esta diferencia hay una combinación de consideraciones basadas en los requisitos reales de la tarea, la rentabilidad y las características del modelo. A continuación se exponen algunos principios y parámetros de preferencia que merece la pena tener en cuenta a la hora de seleccionar y utilizar estos asistentes de codificación de IA.

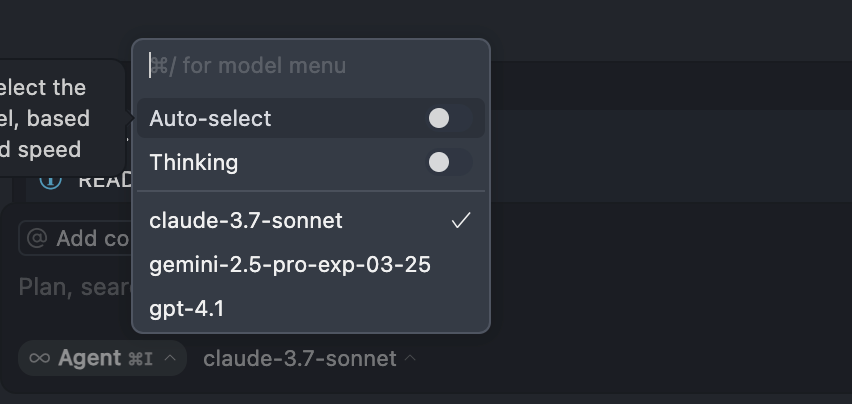

Evita utilizar el modo "Auto".

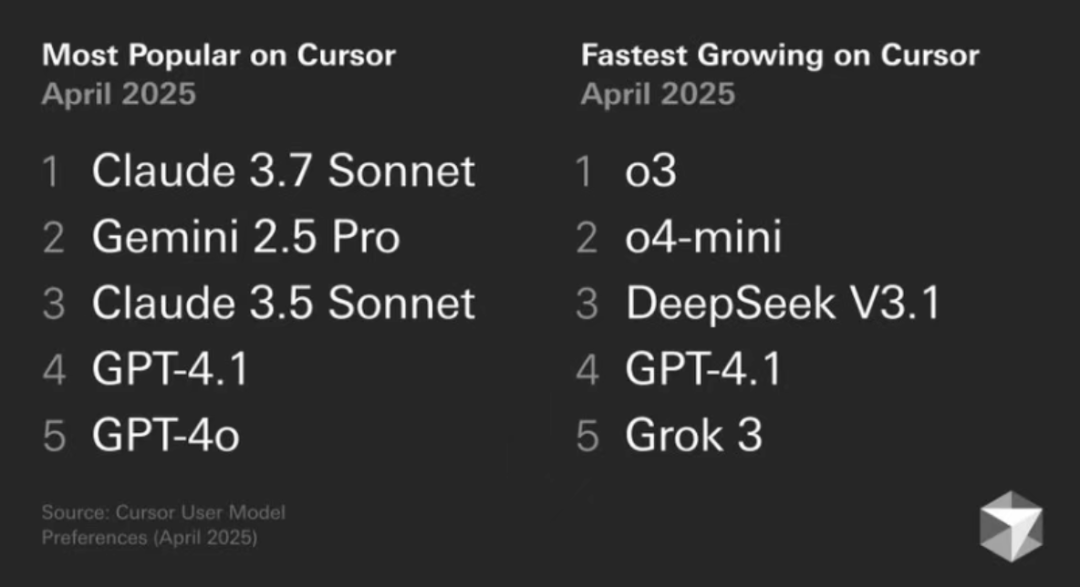

El modo "Auto" de selección de modelos en herramientas como Cursor no es recomendable, principalmente porque el desarrollador pierde el control directo sobre la selección de modelos. Aunque esta función está pensada para equilibrar el consumo de modelos, la potencia y la capacidad de respuesta, la realidad es que suele haber un difícil equilibrio entre los tres: normalmente, más potencia significa mayor consumo o menor velocidad.

En lugar de dejar que el sistema asigne automáticamente a un modelo que puede no ser adecuado para la tarea en cuestión, desperdiciando así recursos (por ejemplo, puntos o número de llamadas), es mejor cambiar manualmente al modelo más apropiado para las necesidades específicas. Por lo tanto, se recomienda desactivar esta opción automática a largo plazo.

Activar el modo "Pensar" (cadena de pensamiento)

La tecnología de cadena de pensamiento es ahora estándar en los mejores modelos de IA. Habilitar la opción de mostrar el "proceso de pensamiento" del modelo (a menudo llamado "Pensamiento" o similar) es fundamental.

La activación de este modo no sólo ayuda a mejorar la capacidad del modelo para resolver problemas complejos, sino que los pasos detallados del pensamiento que muestra también proporcionan a los desarrolladores una visión del funcionamiento del modelo. Esto tiene un doble beneficio: en primer lugar, se puede aprender la estrategia de resolución de problemas del modelo mediante la observación y acumular experiencia en el manejo de tareas similares; en segundo lugar, se puede juzgar rápidamente si la dirección de razonamiento y la solución del modelo son correctas o no, para intervenir y hacer ajustes a tiempo en una fase temprana.

Cambio de modelo según el tipo de tarea

Ningún modelo es perfecto para todas las tareas, y cambiar de modelo dinámicamente es la clave de la eficacia.

Planificación de proyectos a gran escala y preparación del código

Para macrotareas como la planificación de proyectos, la clasificación de bases de código complejas o heredadas y la generación de reglas, Gemini 2.5 Pro o Claude 3.7 Sonnet son las principales opciones. De ellas, Gemini 2.5 Pro tiene una ventaja significativa gracias a su gran ventana contextual, y es especialmente adecuada para manejar proyectos antiguos con múltiples iteraciones y grandes cantidades de código.

El punto fuerte es la capacidad de manejar un gran volumen de información; Gemini 2.5 Pro admite actualmente ventanas contextuales de hasta 1 millón de tokens (los tokens son una unidad de medida de la cantidad de datos textuales), con planes de ampliación a 2 millones de tokens. Esto significa que puede manejar el equivalente a miles de páginas de documentos, bases de código enteras o grandes entradas de datos multimodales que contengan texto, imágenes, audio y vídeo, todo a la vez. Esto significa que puede manejar el equivalente a miles de páginas de documentos o bases de código enteras o grandes entradas de datos multimodales que contengan texto, imágenes, audio y vídeo, todo a la vez. En cambio, otros modelos convencionales, como gpt-4o-mini de OpenAI y Antrópico Claude 3.7 Sonnet ofrece actualmente una ventana contextual de unas 200.000 fichas.

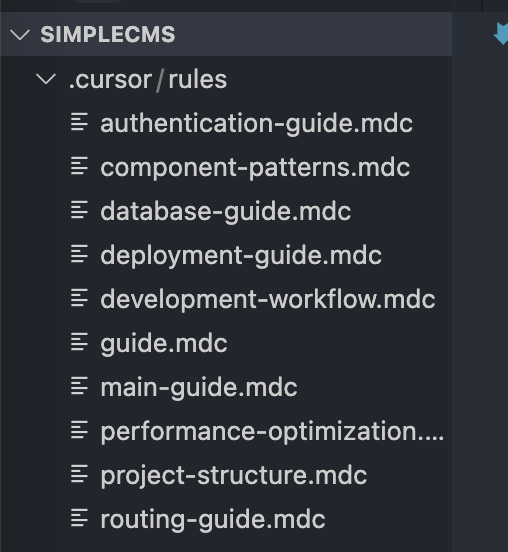

La experiencia ha demostrado que Gemini 2.5 Pro destaca en la generación automática de archivos de documentos (por ejemplo, se supone que el archivo mdc mencionado en el artículo original puede referirse a un documento Markdown o a algún otro formato), con menos casos de aparentes "alucinaciones" (es decir, la generación de contenidos inexactos o sin sentido).

Modificación de archivos individuales y desarrollo modular

Para tareas de menor envergadura, como modificar un único archivo o realizar un desarrollo modular, cambiar a la familia de modelos Claude 3.x Sonnet suele ser una mejor elección.Los modelos Claude son conocidos por su capacidad de respuesta, precisión y generación de código.

En este caso, el desarrollador puede tener que elegir: ¿utilizar la última versión de Claude 3.7 Sonnet o la ligeramente anterior Claude 3.5 Sonnet?

La experiencia de algunos desarrolladores sugiere que Claude 3.5 Sonnet puede parecer más estable y fiable que 3.7 Sonnet en algunos escenarios. En concreto, el modo "pensar" de 3.7 Sonnet puede llevar a veces a un ciclo de cambios iterativos que no logran el resultado deseado tras tratar problemas muy complejos o largas conversaciones. Por lo tanto, aunque Sonnet 3.5 lleva un tiempo en el mercado, sigue siendo una opción muy robusta y fiable para muchos escenarios de desarrollo cotidianos.

Piense en Gemini 2.5 Pro como un planificador estratégico capaz de manejar información a gran escala, mientras que la serie Claude 3.x Sonnet es más como un comando que realiza tareas de codificación específicas y resuelve problemas con rapidez.

Optimización de tareas específicas

- Depuración simple o pequeñas modificaciones: Para tareas sencillas como corregir errores tipográficos y realizar pequeños ajustes en el código, considere la posibilidad de utilizar un modelo de menor coste o más rápido, como GPT-4.1, que puede estar en fase de prueba gratuita o de bajo coste en este momento, e incluso si se cobra en el futuro, se espera que consuma muchos menos puntos que los modelos de gama alta, lo que lo hace rentable para estas "pequeñas correcciones". Es muy rentable para este tipo de tareas de "retoque", y evita el despilfarro de recursos por "matar la gallina para usar el cuchillo".

- Tareas multimodales: La familia de modelos Claude 3.x Sonnet suele funcionar mejor cuando la tarea implica trabajar con imágenes, como generar código para una página web basado en un dibujo de diseño, y los modelos Claude tienen una reconocida fortaleza en la comprensión de elementos visuales y la generación de código para interfaces estéticamente agradables.

Selección del modelo específico de la herramienta (Roo, Cline, etc.)

En algunas herramientas de IA de línea de comandos o plug-ins IDE distintos de Cursor (por ejemplo, Roo y Cline, como se menciona en el artículo original), la selección del modelo puede estar fuertemente influenciada por el coste y la facilidad de uso.

En estos entornos, el uso de Grok 3 podría convertirse en una opción pragmática, sobre todo por su relativamente generosa asignación de uso. x AI ofrece una considerable asignación mensual gratuita para la API Grok 3 (al parecer, cercana a los 150 dólares), lo que resulta muy atractivo para los desarrolladores que necesitan hacer muchas llamadas. Más información en Lanzamiento impactante de Grok 3: ¡el cuerpo de inteligencia de razonamiento explota! La API estrena el "cargo de 5 dólares por 150 dólares" responder cantando OpenAI Codex CLI: OpenAI lanza un asistente de programación de IA en línea de comandos de terminal y otros debates comunitarios. En cambio, utilizar otros modelos de primer nivel puede acarrear rápidamente costes elevados. Aunque la familia de modelos Gemini ofrece un nivel gratuito, suele ir acompañada de una limitación de velocidad y es propensa a provocar errores cuando hay demasiadas solicitudes consecutivas o concurrentes.

Además, para determinadas tareas repetitivas o de codificación por lotes (las siglas MCP pueden referirse a escenarios como "Procesamiento masivo de códigos" o similares), una versión de Gemini Flash que, como su nombre indica, optimiza la capacidad de respuesta al tiempo que conserva una comprensión contextual suficiente, es una opción que merece la pena considerar. Gemini Flash logra un buen equilibrio entre velocidad y precisión cuando se trata de este tipo de tareas por lotes que requieren una respuesta rápida y precisa.

En última instancia, una estrategia eficaz de uso de modelos de IA no consiste en elegir un único modelo, sino en cambiar manualmente de forma dinámica y flexible entre distintos escenarios y herramientas en función de los requisitos de la tarea, los presupuestos de costes y las características del modelo. Por ejemplo, sería inteligente dar prioridad a modelos de alto rendimiento como Claude 3.7 Sonnet o Gemini 2.5 Pro para tareas complejas dentro de la cuota disponible, y cambiar a opciones más rentables como GPT-4.1 o Grok 3 cuando la cuota esté casi agotada o para tareas sencillas.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...