ChatOllama: aplicación local de chat en tiempo real basada en Nuxt 3 y Ollama

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 52.2K 00

Introducción general

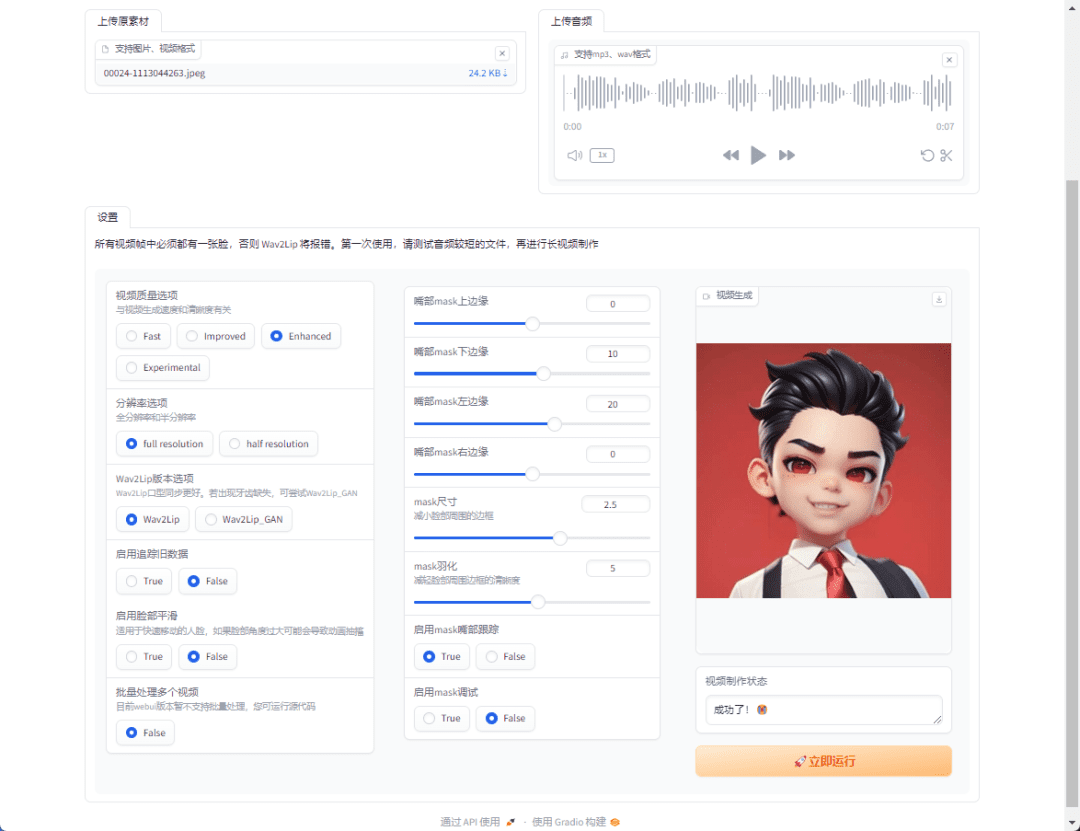

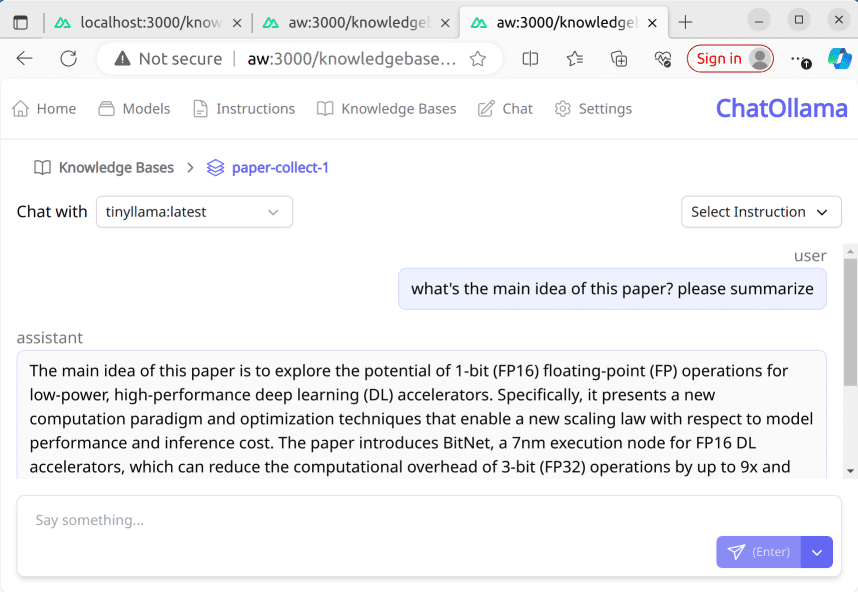

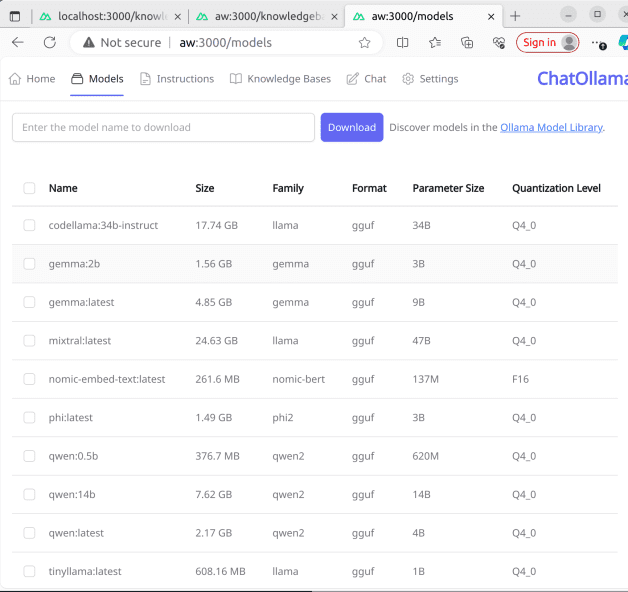

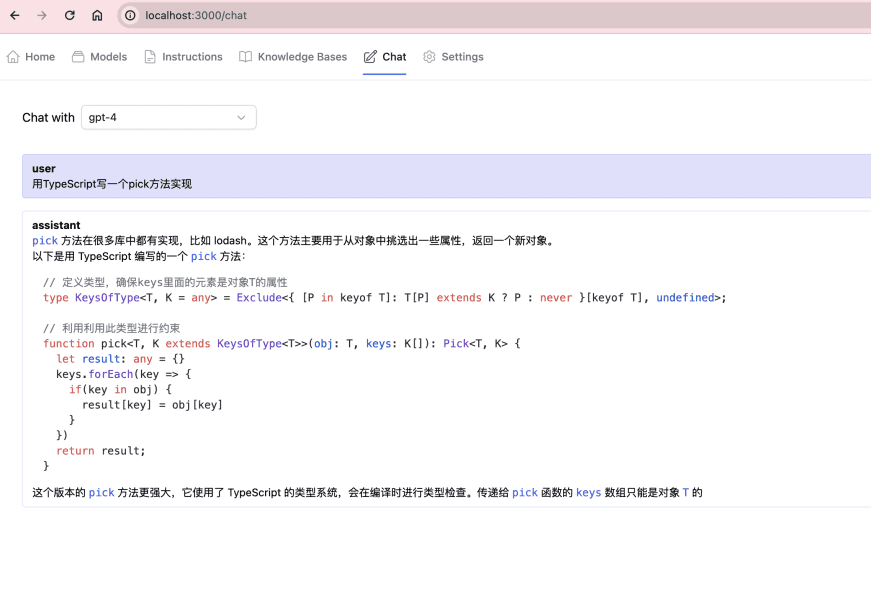

ChatOllama es un proyecto de aplicación de chat en línea de código abierto basado en modelos lingüísticos a gran escala (LLM), que admite numerosos modelos lingüísticos y la gestión de la base de conocimientos. Los usuarios pueden utilizar la plataforma para la gestión de modelos (visualización de listas , descarga , eliminación ) , chatear con modelos y otras funciones . El proyecto utiliza el marco Nuxt 3 y proporciona una guía de configuración detallada y directrices del servidor de desarrollo para los desarrolladores interesados en el desarrollo de chatbot para navegar y contribuir.

Lista de funciones

Gestión de modelos: visualización, descarga y eliminación de listas de modelos.

Capacidad para interactuar con modelos de chat

Apoyo a la modelización multilingüe y a la gestión de la base de conocimientos (base de conocimientos basada en LangChain).

Desarrollado en Nuxt 3 y escrito en Vue y TypeScript.

Utilizar la ayuda

Instale primero las dependencias: npm install, pnpm install, yarn install o bun install

Asegúrese de que tiene un servidor Ollama en ejecución, el entorno local se ejecuta por defecto en http://localhost:11434

Encontrado en http://localhost:3000上启动开发服务器: npm run dev

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...