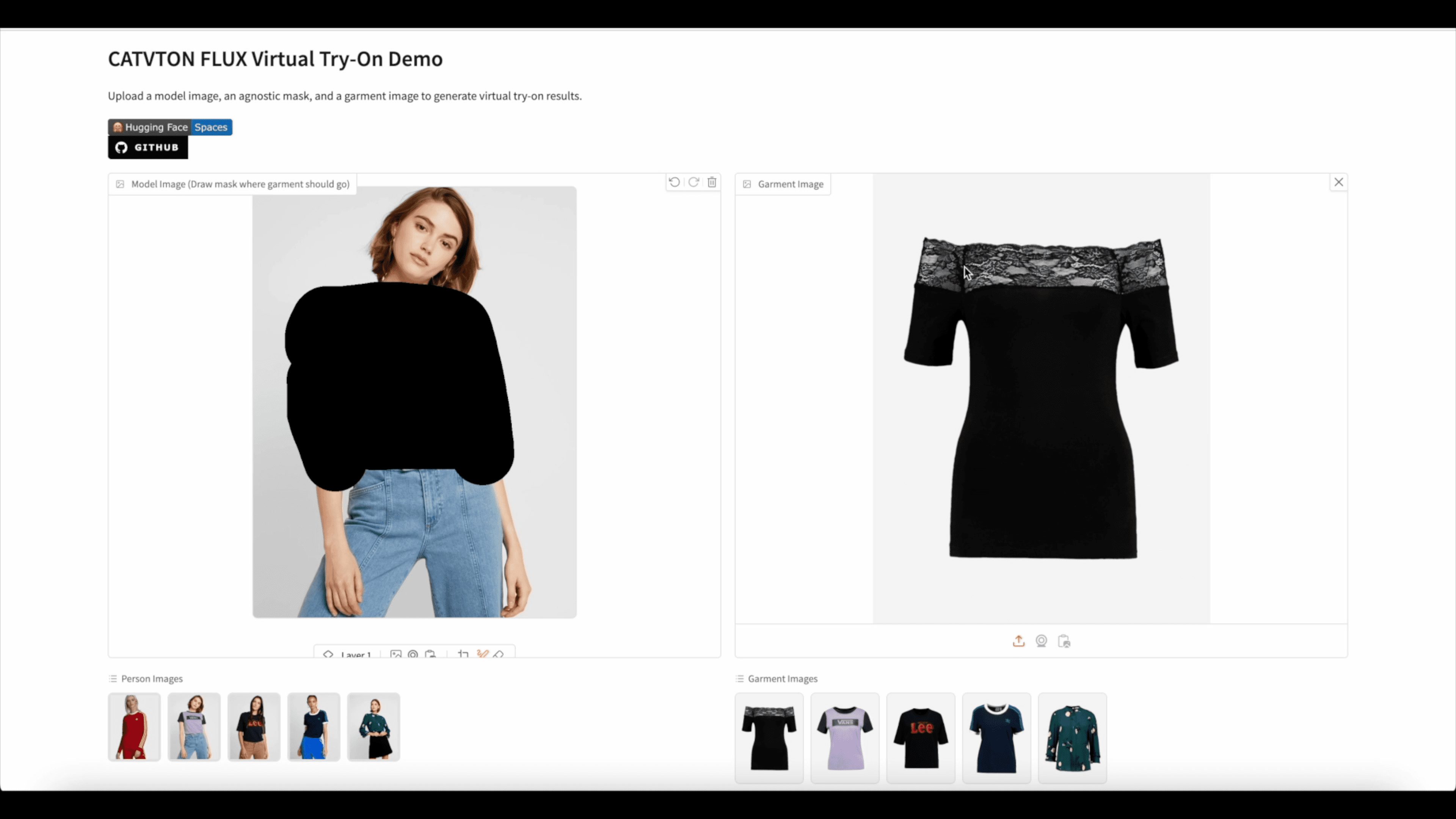

CatVTON-FLUX: combinación de los modelos CATVTON y Flux Fill Repair para esquemas de ajuste virtual

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 50.1K 00

Introducción general

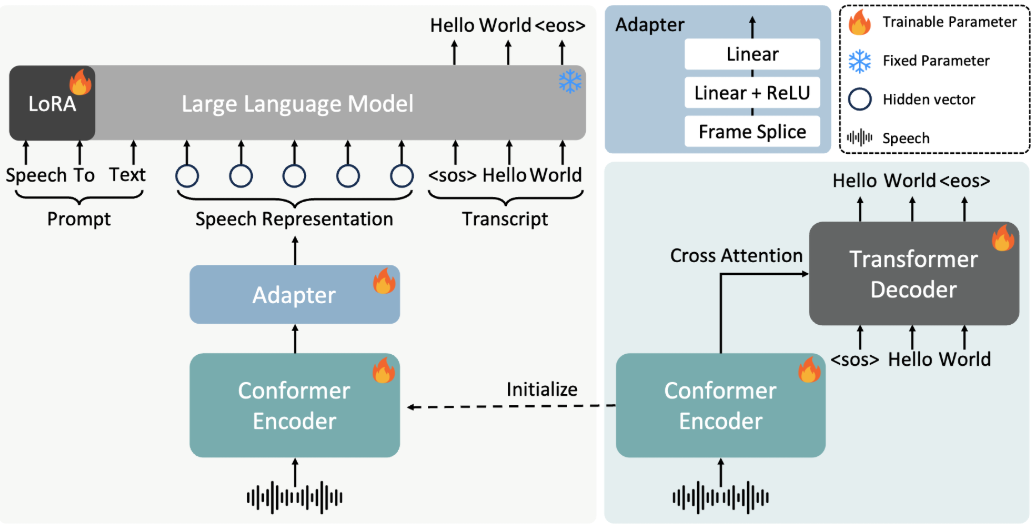

CatVTON-FLUX es una solución avanzada de adaptación virtual que combina CATVTON (La concatenación es todo lo que necesita para la prueba virtual con modelos de difusión) y Flux Modelos de reparación poblados para transferencias de prendas realistas y precisas. Desarrollado por nftblackmagic e inspirado en In-Context LoRA for prompt engineering, el proyecto pretende ofrecer una experiencia de ajuste virtual de alta calidad mediante el uso de técnicas de modelado por difusión y LoRA (In-Context LoRA for prompt engineering). La plataforma permite a los usuarios probarse virtualmente el Hugging Face y experimentar los últimos pesos y mejoras de rendimiento del modelo.

Experiencia en línea: https://huggingface.co/spaces/xiaozaa/catvton-flux-try-on

Lista de funciones

- Pruebas virtuales: transferencias realistas de prendas mediante los modelos CATVTON y Flux.

- Apoyo a las ponderaciones LoRA: se proporcionan ponderaciones LoRA para mejorar el rendimiento del modelo.

- Demostración de Gradio: Demuestre la adaptación virtual a través de la plataforma Gradio.

- Soporte de la Cara Abrazada: Ejecuta CATVTON-FLUX-TRY-ON en la Cara Abrazada.

- Actualización de las ponderaciones del modelo: actualice periódicamente las ponderaciones del modelo para mejorar el rendimiento y el detalle.

Utilizar la ayuda

Proceso de instalación

- Asegúrese de que el entorno de ejecución tiene >= 40GB de VRAM (se recomiendan 80GB de GPU).

- Crear y activar un entorno virtual Python:

conda create -n flux python=3.10

conda activate flux

- Instale las dependencias necesarias:

pip install -r requirements.txt

huggingface-cli login

Proceso de utilización

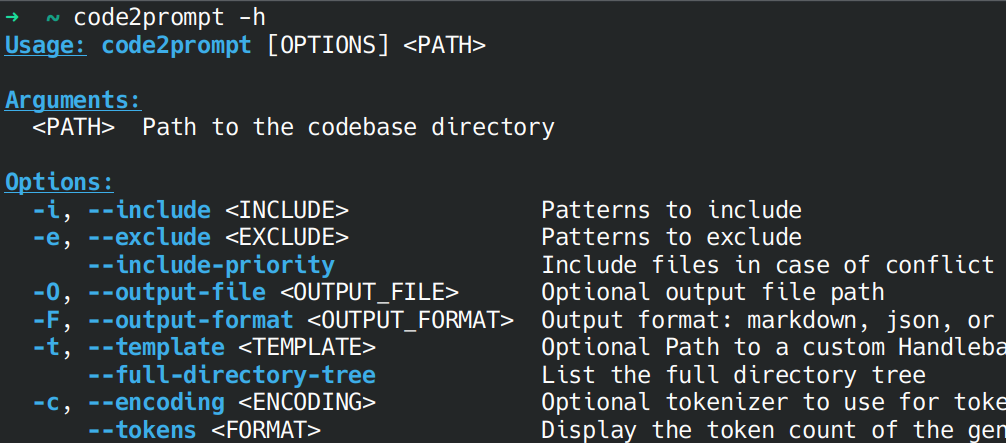

Ejecutar la versión LoRA de la adaptación

- Preparar imágenes de entrada, máscaras e imágenes de ropa.

- Ejecute el siguiente comando para probarlo:

python tryon_inference_lora.py \

--image ./example/person/00008_00.jpg \

--mask ./example/person/00008_00_mask.png \

--garment ./example/garment/00034_00.jpg \

--seed 4096 \

--output_tryon test_lora.png \

--steps 30

Ejecutar una versión de prueba sin LoRA

- Preparar imágenes de entrada, máscaras e imágenes de ropa.

- Ejecute el siguiente comando para probarlo:

python tryon_inference.py \

--image ./example/person/00008_00.jpg \

--mask ./example/person/00008_00_mask.png \

--garment ./example/garment/00034_00.jpg \

--seed 42 \

--output_tryon test.png \

--steps 30

Iniciar la demostración de Gradio

- Ejecute el siguiente comando para iniciar la demo de Gradio con pesos LoRA:

python app.py

- Ejecute el siguiente comando para iniciar la demo de Gradio sin pesos LoRA:

python app_no_lora.py

Procedimiento de funcionamiento detallado

- Preparación de la imagen de entradaAsegúrese de que la imagen de entrada, la máscara y la imagen de la prenda tienen el mismo tamaño, el tamaño recomendado es 576x768.

- Ejecución del comando test-penetrationEl comando Try On: Seleccione la versión LoRA o la versión sin LoRA del comando Try On según sea necesario, ajustando parámetros como la semilla y los pasos para obtener resultados óptimos.

- Ver resultadosLos resultados del ajuste se guardarán en la ruta de salida especificada, y el usuario podrá ver y evaluar los resultados del ajuste.

- Interacción con la interfaz de GradioLa interfaz de Gradio permite a los usuarios cargar sus propias imágenes y prendas para experimentar una prueba virtual en tiempo real.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...