CAG: un método de generación mejorado con caché que es 40 veces más rápido que RAG

Base de conocimientos de IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 34.4K 00

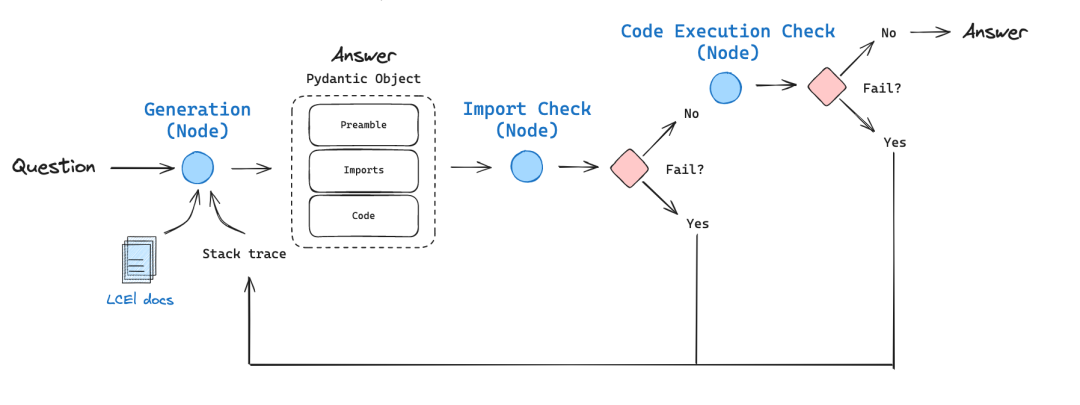

CAG (Cache Augmented Generation), que es 40 veces más rápida que RAG (Retrieval Augmented Generation), revoluciona la adquisición de conocimientos: en lugar de recuperar datos externos en tiempo real, todo el conocimiento se carga previamente en el contexto del modelo. Es como condensar una enorme biblioteca en un juego de herramientas portátil que se puede hojear cuando se necesita, y la implementación de CAG es elegante:

- En primer lugar, el documento se preprocesa para garantizar que encaja en la ventana contextual de LLM.

- A continuación, el contenido procesado se codifica en la caché Clave-Valor

- Por último, esta caché se almacena en la memoria o en el disco duro para poder recuperarla en cualquier momento.

Los resultados son contundentes: en conjuntos de datos de referencia como HotPotQA y SQuAD, CAG no sólo es 40 veces más rápido, sino también significativamente más preciso y coherente. Esto se debe a su capacidad para captar el contexto globalmente, sin problemas de errores de recuperación o datos incompletos.

En términos de aplicaciones prácticas, esta tecnología es prometedora en ámbitos como el diagnóstico médico, el análisis financiero y la atención al cliente. Permite que los sistemas de IA mantengan un alto rendimiento evitando la carga de mantenimiento que suponen las arquitecturas complejas.

Al final, la innovación de CAG es que convierte el "llévatelo" en "llévalo", lo que no sólo mejora la eficiencia, sino que también abre nuevas posibilidades para el despliegue de la IA. Este puede ser el estándar para la próxima generación de arquitecturas de IA.

Referencias:

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] Los LLM de contexto largo luchan con el aprendizaje en contexto largo: https://arxiv.org/pdf/2404.02060v2

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...